全景拼接算法简介

全景图像拼接技术综述与改进

全景图像拼接技术综述与改进概述:全景图像拼接技术是指将多张相互有重叠区域的图像通过某种算法的处理,合成为一张无缝衔接的全景图像的过程。

全景图像拼接技术在虚拟现实、摄影、地理信息系统等领域具有广泛应用。

本文将对全景图像拼接技术的原理、算法以及当前的改进方法进行综述。

一、全景图像拼接技术的原理全景图像拼接技术的实现主要包含以下几个步骤:1. 特征提取与匹配:通过检测图像中的特征点,并计算特征描述子,从而实现不同图像之间的特征匹配。

2. 图像对齐:通过特征点匹配结果,确定图像之间的相对位置关系,并进行图像的配准,使得其能够对齐。

3. 图像融合:将对齐后的图像进行融合,消除拼接边缘的不连续性,实现无缝衔接的全景图像输出。

二、当前的全景图像拼接算法1. 基于特征点的算法:例如SIFT(尺度不变特征变换)和SURF(加速稳健特征)算法,通过提取图像的局部特征点,并进行匹配。

这种算法能够识别出旋转、尺度和视角变化,但对于大尺度图像的拼接效果有限。

2. 基于全局变换的算法:例如全景图像的球面投影映射(Spherical Projection Mapping)算法和全景图像的柱面投影映射(Cylindrical Projection Mapping)算法。

这些算法通过将图像映射为球面或柱面,并进行参数化变换来实现图像的拼接,能够处理大尺度图像,但在局部区域的拼接上可能存在一定的失真。

3. 基于深度学习的算法:近年来,深度学习技术在图像处理领域取得了重大突破。

通过使用深度卷积神经网络,如Pix2Pix和CycleGAN等模型,能够将拼接任务转化为图像到图像的转换问题,取得了较好的拼接效果。

三、全景图像拼接技术的改进方法1. 自动拼接线选取算法:采用自适应拼接线选取算法,根据特征点的分布和拼接图像的几何结构,自动选择合适的拼接线,减少拼接过程中的人工干预,提高拼接效率和准确性。

2. 拼接失真校正算法:解决基于全局变换的算法中局部区域存在的失真问题。

图像的拼接----RANSAC算法

图像的拼接----RANSAC算法⼀、全景拼接的原理1.RANSAC算法介绍RANSAC算法的基本假设是样本中包含正确数据(inliers,可以被模型描述的数据),也包含异常数据(outliers,偏离正常范围很远、⽆法适应数学模型的数据),即数据集中含有噪声。

这些异常数据可能是由于错误的测量、错误的假设、错误的计算等产⽣的。

同时RANSAC也假设,给定⼀组正确的数据,存在可以计算出符合这些数据的模型参数的⽅法。

2.使⽤RANSAC算法来求解单应性矩阵在进⾏图像拼接时,我们⾸先要解决的是找到图像之间的匹配的对应点。

通常我们采⽤SIFT算法来实现特征点的⾃动匹配,SIFT算法的具体内容参照我的上⼀篇博客。

SIFT是具有很强稳健性的描述⼦,⽐起图像块相关的Harris⾓点,它能产⽣更少的错误的匹配,但仍然还是存在错误的对应点。

所以需要⽤RANSAC算法,对SIFT算法产⽣的128维特征描述符进⾏剔除误匹配点。

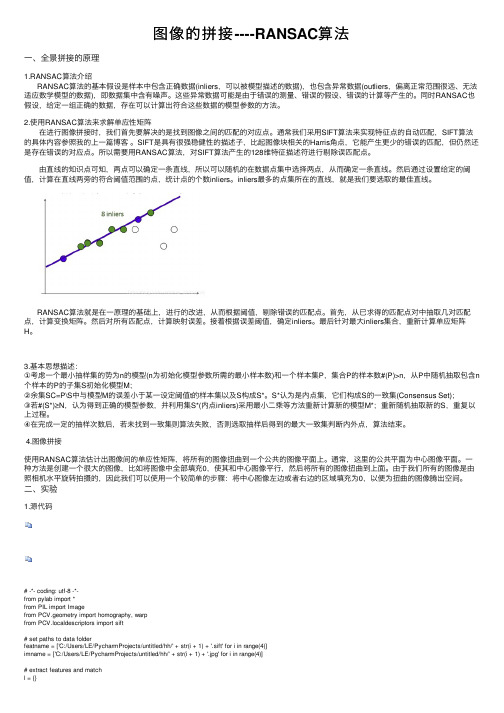

由直线的知识点可知,两点可以确定⼀条直线,所以可以随机的在数据点集中选择两点,从⽽确定⼀条直线。

然后通过设置给定的阈值,计算在直线两旁的符合阈值范围的点,统计点的个数inliers。

inliers最多的点集所在的直线,就是我们要选取的最佳直线。

RANSAC算法就是在⼀原理的基础上,进⾏的改进,从⽽根据阈值,剔除错误的匹配点。

⾸先,从已求得的匹配点对中抽取⼏对匹配点,计算变换矩阵。

然后对所有匹配点,计算映射误差。

接着根据误差阈值,确定inliers。

最后针对最⼤inliers集合,重新计算单应矩阵H。

3.基本思想描述:①考虑⼀个最⼩抽样集的势为n的模型(n为初始化模型参数所需的最⼩样本数)和⼀个样本集P,集合P的样本数#(P)>n,从P中随机抽取包含n 个样本的P的⼦集S初始化模型M;②余集SC=P\S中与模型M的误差⼩于某⼀设定阈值t的样本集以及S构成S*。

S*认为是内点集,它们构成S的⼀致集(Consensus Set);③若#(S*)≥N,认为得到正确的模型参数,并利⽤集S*(内点inliers)采⽤最⼩⼆乘等⽅法重新计算新的模型M*;重新随机抽取新的S,重复以上过程。

360全景拼接方案

360全景拼接方案简介360全景拼接是一种将多张图片拼接为一个全景图的技术。

全景图能够提供用户全方位的视角,使得用户能够沉浸在虚拟现实的环境中。

本文将介绍一种基于计算机视觉的360全景拼接方案,通过使用特征匹配和图像融合算法,实现高质量的全景拼接效果。

基本原理特征匹配全景拼接的第一步是特征匹配。

特征匹配是指找到多张图片中的相同特征点,以便后续的图像对齐和拼接。

常用的特征点提取算法有SIFT(尺度不变特征变换)和SURF(加速稳健特征)。

这些算法可以提取出图像中的关键点,并计算出每个关键点的描述子。

在特征点提取完成后,可以通过计算特征点之间的距离和相似度,使用一些匹配算法(如k-最近邻算法)来找到相同特征点。

匹配算法会根据两幅图像中特征点的相似程度,将它们匹配成对。

图像对齐在特征匹配完成后,下一步是图像对齐。

图像对齐是指将所有图像对准到同一个坐标系中,以便进行后续的拼接处理。

图像对齐可以通过估计图像的变换矩阵来实现,常见的变换矩阵包括平移、旋转和缩放。

常用的图像对齐算法有RANSAC(随机抽样一致性)和LMS(最小均方误差),这些算法可以根据匹配的特征点,计算出变换矩阵,并将图像对齐到同一个坐标系中。

图像融合图像对齐完成后,下一步是图像融合。

图像融合是指将所有对齐后的图像拼接在一起,生成最终的全景图。

常用的图像融合算法有平均融合、线性融合和多重分辨率融合。

在图像融合过程中,需要考虑图像之间的重叠区域的处理,以及消除不同图像之间的亮度差异。

这可以通过调整图像的透明度、亮度和对比度来实现。

实施步骤下面是基于上述原理的360全景拼接方案的实施步骤:1.选择合适的特征提取算法,如SIFT或SURF。

根据实际需求,确定特征点的数量和质量。

2.对每张图片进行特征提取,并计算每个特征点的描述子。

3.使用匹配算法(如k-最近邻算法),找到特征点之间的对应关系。

4.根据匹配结果,计算变换矩阵,将所有图像对齐到同一个坐标系中。

全景图像拼接

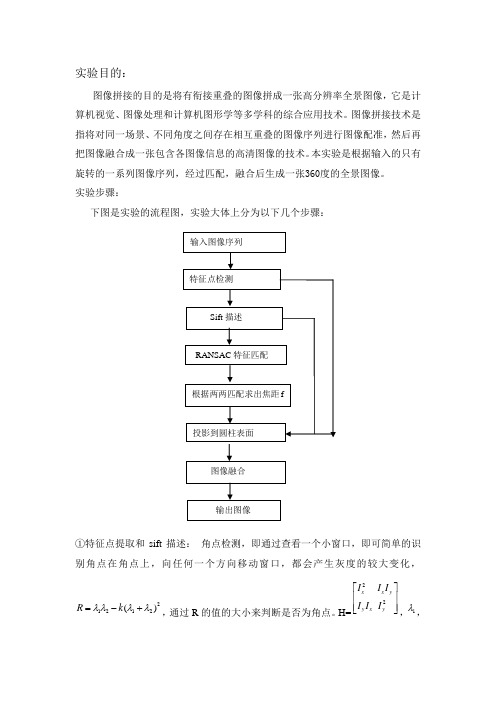

实验目的:图像拼接的目的是将有衔接重叠的图像拼成一张高分辨率全景图像,它是计算机视觉、图像处理和计算机图形学等多学科的综合应用技术。

图像拼接技术是指将对同一场景、不同角度之间存在相互重叠的图像序列进行图像配准,然后再把图像融合成一张包含各图像信息的高清图像的技术。

本实验是根据输入的只有旋转的一系列图像序列,经过匹配,融合后生成一张360度的全景图像。

实验步骤:下图是实验的流程图,实验大体上分为以下几个步骤:①特征点提取和sift 描述: 角点检测,即通过查看一个小窗口,即可简单的识别角点在角点上,向任何一个方向移动窗口,都会产生灰度的较大变化,21212()R k λλλλ=-+,通过R 的值的大小来判断是否为角点。

H=22x x y y x y I I I I I I ⎡⎤⎢⎥⎢⎥⎣⎦,1λ,输入图像序列 特征点检测 Sift 描述RANSAC 特征匹配根据两两匹配求出焦距f投影到圆柱表面图像融合输出图像为矩阵的两个特征值。

实验中的SIFT描述子是对每个角点周围进行4个区域2进行描述,分别是上下左右四个区域,每个方块大小为5*5,然后对每个方块的每个点求其梯度方向。

SIFT方向共有8个方向,将每个点的梯度方向做统计,最后归为8个方向中的一个,得到分别得到sift(k,0),sift(k,1)···sift(k,8),k为方块序列,0-8为方向,共有四个方块,所以生成32维的向量,然后按幅值大小对这32维向量进行排序,并找出最大的作为主方向。

图为角点检测和sift描述后的图②.如果直接根据描述子32维向量进行匹配的话,因为噪声的影响,角点检测的不准确,会导致找出一些错误的匹配对,如何去掉这些错误的匹配呢?RANSAC算法是基于特征的图像配准算法中的典型算法,其优点是:可靠、稳定、精度高,对图像噪声和特征点提取不准确,有强健的承受能力,鲁棒性强,并且具有较好的剔出误匹配点的能力,经常被使用在图像特征匹配中。

Python实现图像全景拼接

Python 实现图像全景拼接⽬标:将数张有重叠部分的图像通过特征点检测,匹配,图像变换拼成⼀幅⽆缝的全景图或⾼分辨率图像在图像拼接中⾸先利⽤SIFT 算法提取图像特征进⽽进⾏特征匹配,继⽽使⽤RANSAC 算法对特征匹配的结果进⾏优化,接着利⽤图像变换结构进⾏图像映射,最终进⾏图像融合。

在图像拼接过程中,运⽤SIFT 局部描述算⼦检测图像中的关键点和特征,SIFT 特征是基于物体上的⼀些局部外观的兴趣点⽽与影像的⼤⼩和旋转⽆关。

对于光线、噪声、些微视⾓改变的容忍度也相当⾼,所以⽤来检测要拼接图像的特征及关键点就很有优势。

⽽接下来即步骤三是找到重叠的图⽚部分,连接所有图⽚之后就可以形成⼀个基本的全景图了。

匹配图⽚最常⽤的⽅式是采⽤RANSAC (RANdom SAmple Consensus, 随机抽样⼀致),⽤此排除掉不符合⼤部分⼏何变换的匹配。

之后利⽤这些匹配的点来估算单应矩阵”(Homography Estimation ),也就是将其中⼀张图像通过关联性和另⼀张匹配。

使⽤的算法:1. 利⽤SIFT ⽅法检测特征点2. 将检测到的特征点进⾏匹配def detectAndDescribe(image):# 将彩⾊图⽚转换成灰度图gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)# 建⽴SIFT ⽣成器descriptor = cv2.xfeatures2d.SIFT_create()# 检测SIFT 特征点,并计算描述⼦(kps, features) = descriptor.detectAndCompute(image, None)# 将结果转换成NumPy 数组kps = np.float32([kp.pt for kp in kps])# 返回特征点集,及对应的描述特征return (kps, features)def matchKeypoints(kpsA, kpsB, featuresA, featuresB, ratio, reprojThresh):# 建⽴暴⼒匹配器matcher = cv2.BFMatcher()# 使⽤KNN 检测来⾃A 、B 图的SIFT 特征匹配对,K=2rawMatches = matcher.knnMatch(featuresA, featuresB, 2)3.将匹配的特征点可视化4. 图像拼接matches = []for m in rawMatches:# 当最近距离跟次近距离的⽐值⼩于ratio 值时,保留此匹配对if len(m) == 2 and m[0].distance < m[1].distance * ratio:# 存储两个点在featuresA, featuresB 中的索引值matches.append((m[0].trainIdx, m[0].queryIdx))# 当筛选后的匹配对⼤于4时,计算视⾓变换矩阵if len(matches) > 4:# 获取匹配对的点坐标ptsA = np.float32([kpsA[i] for (_, i) in matches])ptsB = np.float32([kpsB[i] for (i, _) in matches])# 计算视⾓变换矩阵(H, status) = cv2.findHomography(ptsA, ptsB, cv2.RANSAC, reprojThresh)# 返回结果return (matches, H, status)# 如果匹配对⼩于4时,返回Nonereturn Nonedef drawMatches(imageA, imageB, kpsA, kpsB, matches, status):# 初始化可视化图⽚,将A 、B 图左右连接到⼀起(hA, wA) = imageA.shape[:2](hB, wB) = imageB.shape[:2]vis = np.zeros((max(hA, hB), wA + wB, 3), dtype="uint8")vis[0:hA, 0:wA] = imageAvis[0:hB, wA:] = imageB# 联合遍历,画出匹配对for ((trainIdx, queryIdx), s) in zip(matches, status):# 当点对匹配成功时,画到可视化图上if s == 1:# 画出匹配对ptA = (int(kpsA[queryIdx][0]), int(kpsA[queryIdx][1]))ptB = (int(kpsB[trainIdx][0]) + wA, int(kpsB[trainIdx][1]))cv2.line(vis, ptA, ptB, (0, 255, 0), 1)# 返回可视化结果return visdef stitch(images, ratio=0.75, reprojThresh=4.0,showMatches=False):#获取输⼊图⽚(imageB, imageA) = images#检测A 、B 图⽚的SIFT 关键特征点,并计算特征描述⼦(kpsA, featuresA) = detectAndDescribe(imageA)(kpsB, featuresB) = detectAndDescribe(imageB)# 匹配两张图⽚的所有特征点,返回匹配结果M = matchKeypoints(kpsA, kpsB, featuresA, featuresB, ratio, reprojThresh)# 如果返回结果为空,没有匹配成功的特征点,退出算法if M is None:return None# 否则,提取匹配结果# H是3x3视⾓变换矩阵(matches, H, status) = M# 将图⽚A进⾏视⾓变换,result是变换后图⽚result = cv2.warpPerspective(imageA, H, (imageA.shape[1] + imageB.shape[1], imageA.shape[0])) cv_show('result', result)# 将图⽚B传⼊result图⽚最左端result[0:imageB.shape[0], 0:imageB.shape[1]] = imageBcv_show('result', result)# 检测是否需要显⽰图⽚匹配if showMatches:# ⽣成匹配图⽚vis = drawMatches(imageA, imageB, kpsA, kpsB, matches, status)# 返回结果return (result, vis)# 返回匹配结果return result。

海思 全景拼接 流程及原理

海思全景拼接流程及原理下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by the editor. I hope that after you download them, they can help you solve practical problems. The document can be customized and modified after downloading, please adjust and use it according to actual needs, thank you!In addition, our shop provides you with various types of practical materials, such as educational essays, diary appreciation, sentence excerpts, ancient poems, classic articles, topic composition, work summary, word parsing, copy excerpts, other materials and so on, want to know different data formats and writing methods, please pay attention!海思全景拼接流程及原理全景拼接技术是一种将多幅部分重叠的图像拼接成一幅全景图像的技术。

全景拼接算法简介

全景拼接算法简介罗海风目录1.概述.............................. 错误!未定义书签。

2.主要步骤............................ 错误!未定义书签。

. 图像获取. ........................... 错误! 未定义书签。

鱼眼图像矫正. ......................... 错误!未定义书签。

图片匹配. ........................... 错误!未定义书签。

图片拼接. .......................... 错误!未定义书签。

图像融合. .......................... 错误!未定义书签。

全景图像投射............................ 错误!未定义书签。

3.算法技术点介绍.......................... 错误!未定义书签。

图像获取.............................. 错误!未定义书签。

鱼眼图像矫正. ......................... 错误!未定义书签。

图片匹配.............................. 错误!未定义书签。

与特征无关的匹配方式. .................. 错误!未定义书签。

根据特征进行匹配的方式. ................ 错误!未定义书签。

图片拼接. ........................... 错误!未定义书签。

图像融合. ........................... 错误!未定义书签。

平均叠加法. .................... 错误!未定义书签。

线性法. ...................... 错误!未定义书签。

加权函数法. .................... 错误!未定义书签。

全景图自动拼接算法研究及系统实现

摘要全景图是虚拟现实中一种重要的场景表示方法。

通常获得高质量的全景图需要使用昂贵的专用设备,而且拍摄时需要精确地校准摄像机。

从普通摄像机图像拼接是获得全景图的一种低成本而且比较灵活的方法。

采用普通照相机拍摄的照片可能出现图像扭曲、交叠和倾斜,照片之问可能有一定色差,因此,在图像的拼接和建立全景图方面难度大。

本文中主要是通过对多种图像拼接算法的研究,提出图像拼接改进算法,该算法能够在较宽松的条件下能够较准确地匹配两幅图像,实验证明该算法能够有效地拼接普通相机拍摄的照片,消除图像扭曲、交叠和倾斜对于图像拼接的影响。

同时,在实现柱面全景图时,为了不改变物体在自然界中的几何信息,也进行了柱面投影研究,实现柱面全景图。

最后使用vC++和OpenGL技术实现了图像拼接系统和柱面全景图浏览器,该系统能够自动拼接按照数字排序的序列照片。

柱面全景图浏览器可以通过鼠标和键艋方向键360”浏览全景图。

关键字:图像拼接;全景图:柱面全景图:柱面投影AbstractAsallimagerepresentationofvirtualenviroarnent,panoramahasimportantapplicationsinVirtual—Reality.Generally,togetapanoramawithhighquality,weneedsomespecial,expensiveandcarefullycalibratedequipment.ImageMosaicisaninexpensiveandflexibleapproachtogetpanoramawithasimplehand-heldcamera.Thephotostakenwithahand—heldcamerausuallyhavelargeperspectivedistortion,smalloverlap,brightnessdifference,smallconcentricerrorsandcamerarotations.Thesecharacteristicsmakebothimagealignmentandpanoramabuildingmoredifficultthanusingphotostakenbycamerascalibratedbyspecialequipment.Basedonstudyingmanyimagemosaicalgorithms,wepresentabetteronethatisabletoaccuratelystitchtwosimilarimagesautomaticallywiththelimitationofthephotos.Theresultfromthethevalidityofthealgorithm.Atthesametime,Istudythecylindricalexperimentshowsprojectionalgorithmsandimplementcylindricalpanoramicimage.Atlast.Iimplementanimage—mosaicsystemandapanoramabrowserwithVC++andOpenGL.ThissystemCanstitchaserialofphotosorderedbynumbers.ThepanoramabrowserCallbeenusedtobrowsecylindricalpanoramicimagewithin360。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

全景拼接算法简介罗海风2014.12.11目录1.概述 (1)2.主要步骤 (2)2.1. 图像获取 (2)2.2鱼眼图像矫正 (2)2.3图片匹配 (2)2.4 图片拼接 (2)2.5 图像融合 (2)2.6全景图像投射 (2)3.算法技术点介绍 (3)3.1图像获取 (3)3.2鱼眼图像矫正 (4)3.3图片匹配 (4)3.3.1与特征无关的匹配方式 (4)3.3.2根据特征进行匹配的方式 (5)3.4图片拼接 (5)3.5图像融合 (6)3.5.1 平均叠加法 (6)3.5.2 线性法 (7)3.5.3 加权函数法 (7)3.5.4 多段融合法(多分辨率样条) (7)3.6全景图像投射 (7)3.6.1 柱面全景图 (7)3.6.2 球面全景图 (7)3.6.3 多面体全景图 (8)4.开源图像算法库OPENCV拼接模块 (8)4.1 STITCHING_DETAIL程序运行流程 (8)4.2 STITCHING_DETAIL程序接口介绍 (9)4.3测试效果 (10)5.小结 (10)参考资料 (10)1.概述全景视图是指在一个固定的观察点,能够提供水平方向上方位角360度,垂直方向上180度的自由浏览(简化的全景只能提供水平方向360度的浏览)。

目前市场中的全景摄像机主要分为两种:鱼眼全景摄像机和多镜头全景摄像机。

鱼眼全景摄像机是由单传感器配套特殊的超广角鱼眼镜头,并依赖图像校正技术还原图像的鱼眼全景摄像机。

鱼眼全景摄像机最终生成的全景图像即使经过校正也依然存在一定程度的失真和不自然。

多镜头全景摄像机可以避免鱼眼镜头图像失真的缺点,但是或多或少也会存在融合边缘效果不真实、角度有偏差或分割融合后有"附加"感的缺撼。

本文档中根据目前所查找到的资料,对多镜头全景视图拼接算法原理进行简要的介绍。

2.主要步骤2.1. 图像获取通过相机取得图像。

通常需要根据失真较大的鱼眼镜头和失真较小的窄视角镜头决定算法处理方式。

单镜头和多镜头相机在算法处理上也会有一定差别。

2.2鱼眼图像矫正若相机镜头为鱼眼镜头,则图像需要进行特定的畸变展开处理。

2.3图片匹配根据素材图片中相互重叠的部分估算图片间匹配关系。

主要匹配方式分两种:A.与特征无关的匹配方式。

最常见的即为相关性匹配。

B.根据特征进行匹配的方式。

最常见的即为根据SIFT,SURF等素材图片中局部特征点,匹配相邻图片中的特征点,估算图像间投影变换矩阵。

2.4 图片拼接根据步骤2.3所得图片相互关系,将相邻图片拼接至一起。

2.5 图像融合对拼接得到的全景图进行融合处理。

2.6 全景图像投射将合成后的全景图投射至球面、柱面或立方体上并建立合适的视点,实现全方位的视图浏览。

图1:opencv stitching模块进行图像拼接的处理流程(部分步骤可选)3.算法技术点介绍3.1 图像获取由于鱼眼镜头和常规镜头在生成全景图方面存在很大差异,其校正算法完全不同,因此需分开讨论。

但是校正后的图像进行拼接步骤时的处理方法一定程度上可通用。

A.单常规镜头拍摄多张图片方式(手持)该方式很常见,在目前多种手机上均有相关全景功能。

B.多个常规镜头组成的相机(或单镜头旋转扫描方式)图2:三星2014年发布的360度全景照相机Project Beyond,内置16个摄像头C.鱼眼镜头拍摄图3:理光2013年发布双鱼眼全景相机RICOH THETA3.2鱼眼图像矫正若为鱼眼镜头采集的到的图像,必须对图像进行矫正。

鱼眼镜头图像校正算法通常有两种:一种是球面坐标定位法,一种是经纬映射法。

具体推导过程见参考资料【1】《鱼眼照片生成全景图算法的研究与实现》,矫正效果如下图所示:图4:鱼眼图像及校正后的展开图3.3 图片匹配3.3.1与特征无关的匹配方式与特征无关的匹配方式常见的为相关性匹配,一般都用于没有复杂变换的图像拼接情况下。

该方式计算简单,仅为普通的灰度模板匹配。

具体细节见参考文档【2】《全景图生成技术研究》。

图5:模板匹配法示意图3.3.2根据特征进行匹配的方式基于特征的匹配首先从图像上选取特征信息,然后识别出两幅图像对应的特征信息。

常用的特征信息有特征轮廓,特征曲线,特征点,多采用特征点匹配法。

进行特征点匹配的第一步是提取所有素材图片的局部特征点。

普遍来讲,一张图片所包含的特征点通常就是周围含有较大信息量的点,而仅通过这些富有特征的局部,基本就可以推测出整张图片。

常见的特征点包括SIFT,FAST,SURF等。

图6:SITF特征点检测效果图。

青色内容为检测到的SIFT特征点。

由于特征点由特征向量表示,所以图中每个特征点显示为一个箭头。

形成特征向量之后下一个问题就是如何匹配了。

最基本的方式可以称作“最邻近搜索”(Nearest Neighbour),实际上也就是找在128维空间上直线距离最近的的特征向量,这个求直线距离的方式和2维无异,最近的特征向量也就被认为是互相匹配。

SIFT原作者使用的方式是增加了k-d tree算法来高效率地完成高维度上的最邻近搜索。

特征点匹配效果如下图所示。

图6:SITF特征点匹配效果图3.4图片拼接在以上步骤中得到了图像间的匹配关系,就可以根据这些关系进行图像的拼接了。

按照图像匹配的不同方式,拼接处理也分两大类:A.根据模板匹配的方式,可得到图片见的平移(或者包括缩放)参数,继而根据参数进行图像拼接操作;B.根据特征点匹配的方式,则利用这些匹配的点来估算"单应矩阵" (Homography Estimation),也就是把其中一张通过个关联性和另一张匹配的方法。

单应矩阵H效果如下:通过单应矩阵H,可以将原图像中任意像素点坐标转换为新坐标点,转换后的图像即为适合拼接的结果图像。

下图即为找出符合几何约束的特征点之后,通过单应矩阵来对齐两张图片的内容。

图7:根据特征点进行图像拼接的效果图图8:多张图像拼接效果3.5图像融合图像拼接后,需要对图像重叠部分进行融合处理。

图像融合技术决定了最终图像合成质量,常用的有平均叠加法,线性法,加权法,多段融合法等。

具体见参考文档【2】《全景图生成技术研究》。

3.5.1 平均叠加法平均叠加法是直接对图像进行平均叠加。

这是最简单的融合方法,会出现明显的拼接缝隙。

3.5.2 线性法柱面图像的拼接多采用简单的线性法。

图像映射到柱面坐标下,图像间就是简单的纯平面平移变换,局部对准后,对重叠区域用线性法融合。

该方法适合柱面全景图生成,或者仅具有平移变换的两幅图像融合。

3.5.3 加权函数法加权函数法与线性法类似,也是广泛应用的融合方法之一。

该方法能有效去除边界缝隙,但在拼合区往往出现叠影模糊的现象。

3.5.4 多段融合法(多分辨率样条)多段融合法是目前比较好的融合方法,拼接成的图像既清晰又光滑无缝,能避免缝隙问题和叠影现象。

另外,如果选取好的最佳缝隙线,还能处理有轻微运动物体的图像拼接。

但该方法运算量大是其明显缺陷。

3.6全景图像投射3.6.1 柱面全景图固定视点,使相机在水平面内旋转一周拍摄场景,得到一组具有重叠区域的连续环视图像序列,将这组图像序列无缝拼合,并投影到柱面空间坐标,就得到了衣服柱面全景图。

柱面投影就是讲图像投影到柱面上,它是一种透视投影而非平行投影,通俗的讲就是要活的从投影中心这一点上观察图像在柱面上的成像。

下图表示将三维空间上的点(X,Y,Z)映射到柱面模型上得到对应于柱面模型上的点(x,y,z)的过程。

其中θ为观察视域中心与X轴夹角,h为柱面模型高度,(x,y,z)为(X,Y,Z)在柱面模型上的投影。

图9:柱面全景图生成模型其中,图10:柱面全景图效果图详细的柱面投影模型的推导过程,见参考文档【5】《柱面全景图拼接算法的研究》。

3.6.2 球面全景图球面全景图是通过求取图像映射到球面的参数,将图像映射到球面模型上,然后得到的平面反展开图就是球面全景图或者部分球面全景图。

图11:球面投影变换结果图图12:球面全景图拼接效果3.6.3 多面体全景图以景物中心为固定视点来观察整个场景,并将周围场景的图像记录在以该点为中心的环境映射到多面体上,这样环境映射以多面体全景图像的方式来提高其中心视点的场景描述。

多面体全景图中以立方体最为简单,立方体全景图是由6幅广角为90度的画面组成。

图13:立方体全景图效果4.开源图像算法库OpenCV拼接模块开源图像算法库OpenCV在2.4.0版本后集成了一个全景图拼接模块stitch,其中一个较详细的样例代码stitching_detail.cpp简要介绍如下:4.1 stitching_detail程序运行流程1.命令行调用程序,输入源图像以及程序的参数2.特征点检测,判断是使用surf还是orb,默认是surf。

3.对图像的特征点进行匹配,使用最近邻和次近邻方法,将两个最优的匹配的置信度保存下来。

4.对图像进行排序以及将置信度高的图像保存到同一个集合中,删除置信度比较低的图像间的匹配,得到能正确匹配的图像序列。

这样将置信度高于门限的所有匹配合并到一个集合中。

5.对所有图像进行相机参数粗略估计,然后求出旋转矩阵6.使用光束平均法进一步精准的估计出旋转矩阵。

7.波形校正,水平或者垂直8.拼接9.融合,多频段融合,光照补偿,4.2 stitching_detail程序接口介绍img1 img2 img3 输入图像--preview 以预览模式运行程序,比正常模式要快,但输出图像分辨率低,拼接的分辨率compose_megapix 设置为0.6--try_gpu (yes|no) 是否使用GPU(图形处理器),默认为no/* 运动估计参数*/--work_megapix <--work_megapix <float>> 图像匹配的分辨率大小,图像的面积尺寸变为work_megapix*100000,默认为0.6--features (surf|orb) 选择surf或者orb算法进行特征点计算,默认为surf--match_conf <float> 特征点检测置信等级,最近邻匹配距离与次近邻匹配距离的比值,surf默认为0.65,orb默认为0.3--conf_thresh <float> 两幅图来自同一全景图的置信度,默认为1.0--ba (reproj|ray) 光束平均法的误差函数选择,默认是ray方法--ba_refine_mask (mask) -----------------wave_correct (no|horiz|vert) 波形校验水平,垂直或者没有默认是horiz--save_graph <file_name> 将匹配的图形以点的形式保存到文件中,Nm代表匹配的数量,NI代表正确匹配的数量,C表示置信度/*图像融合参数:*/--warp(plane|cylindrical|spherical|fisheye|stereographic|compressedPlaneA2B1|compressedPlaneA1.5B 1|compressedPlanePortraitA2B1|compressedPlanePortraitA1.5B1|paniniA2B1|paniniA1.5B1|panin iPortraitA2B1|paniniPortraitA1.5B1|mercator|transverseMercator)选择融合的平面,默认是球形--seam_megapix <float> 拼接缝像素的大小默认是0.1 --------------seam (no|voronoi|gc_color|gc_colorgrad) 拼接缝隙估计方法默认是gc_color--compose_megapix <float> 拼接分辨率,默认为-1--expos_comp (no|gain|gain_blocks) 光照补偿方法,默认是gain_blocks--blend (no|feather|multiband) 融合方法,默认是多频段融合--blend_strength <float> 融合强度,0-100.默认是5.--output <result_img> 输出图像的文件名,默认是result,jpg命令使用实例,以及程序运行时的提示:4.3 测试效果图14:usb摄像头拍摄的办公室90度视角的六张图像图15:生成的全景图OpenCV的图像拼接模块效果良好,但是由于考虑到及其缺乏条件的情况,因此算法方面采用了很多很复杂的方法,如待拼接的图像顺序不明,基于特征点的图像匹配,迭代优化估计相机焦距参数等,耗时十分长(此例子中,耗时大约十几分钟)。