基于Kinect深度信息的手势提取与识别研究_邓瑞

基于微软Kinect的手势识别技术研究

基于微软Kinect的手势识别技术研究近年来,随着科技的快速发展,各种智能设备也逐渐普及。

其中,基于微软Kinect的手势识别技术备受关注。

这一技术通过使用Kinect摄像头和深度传感器,可以感知人体的运动姿势和动作,并将其转化为相应的指令,实现对设备的控制。

本文就从技术原理、应用场景及发展趋势等方面进行探讨。

一、技术原理微软Kinect是一款专门用于游戏控制的设备,其核心技术在于3D深度摄像头和红外发射器。

摄像头能够捕捉周围环境的深度信息,而红外发射器则能够检测人体的运动姿势。

其中,深度摄像头通过红外线的反射和接收,可以精确地测量物体距离,将其转化为三维坐标。

而红外发射器则可以发射红外信号,以检测人体在空间中的运动。

基于这一技术,Kinect的手势识别功能应运而生。

通过人体骨架模型的建立和动作捕捉算法,Kinect可以识别人体姿态和动作,并将其转化成计算机能够理解的指令。

例如,向左移动手臂可以控制游戏中的角色向左转动,向前伸手可以控制角色前进等等。

同时,Kinect还支持语音控制和面部表情识别等功能,大大提升了用户的交互体验。

二、应用场景手势识别技术作为一种新兴的交互方式,已经得到了广泛的应用。

除了游戏控制以外,其实际应用场景还包括人机交互、智能家居、虚拟现实等领域。

在人机交互领域,手势识别技术可以被应用于机器人控制、医疗诊断、智能办公等方面。

例如,在智能办公场景中,用户可以通过手势控制电脑的开关、程序的启动以及文档的编辑等操作,提高工作效率。

在智能家居领域,手势识别技术可以被应用于智能家电的控制、家庭安防等方面。

例如,在智能家电方面,用户可以通过手势控制灯光的开关、音响的播放以及电视的切换等操作,提高家居生活的便利程度。

在虚拟现实领域,手势识别技术可以被应用于3D模型设计、游戏控制等方面。

例如,在游戏领域中,用户可以通过手势控制游戏角色的动作和攻击技能,提供更为真实的游戏体验。

三、发展趋势手势识别技术虽然已经取得了很大的进展,但还有很多发展空间。

《2024年基于Kinect的手势识别与机器人控制技术研究》范文

《基于Kinect的手势识别与机器人控制技术研究》篇一一、引言随着人工智能技术的不断发展,人机交互技术已成为研究热点之一。

其中,基于Kinect的手势识别技术因其高精度、高效率、低成本的优点,得到了广泛的应用。

而将手势识别技术应用于机器人控制,则能够进一步拓展人机交互的范畴,提高机器人的智能化水平。

本文将对手势识别技术和机器人控制技术进行深入的研究和探讨,基于Kinect传感器进行实验和分析。

二、Kinect传感器及其应用Kinect是微软公司开发的一款体感设备,具有捕捉人体动作、语音和手势等功能。

在计算机视觉、人机交互、机器人控制等领域有着广泛的应用。

基于Kinect的手势识别技术,可以通过捕捉人体手部动作的信息,实现对手势的准确识别和解析。

同时,Kinect还可以实时监测人体骨骼的位置和运动状态,从而更精确地完成动作捕捉。

三、手势识别技术研究基于Kinect的手势识别技术,主要通过以下步骤实现:首先,利用Kinect传感器捕捉人体的骨骼信息;其次,通过算法对手部骨骼信息进行提取和预处理;然后,利用机器学习算法对手势进行分类和识别;最后,将识别的手势信息转化为计算机可以理解的指令或命令。

在手势识别技术中,机器学习算法的应用至关重要。

常见的机器学习算法包括支持向量机(SVM)、随机森林(Random Forest)、神经网络等。

这些算法可以通过训练大量的手势样本,提高手势识别的准确性和鲁棒性。

此外,深度学习算法在手势识别中也得到了广泛的应用,如卷积神经网络(CNN)等。

四、机器人控制技术研究机器人控制技术是实现人机交互的关键技术之一。

基于Kinect的手势识别技术可以实现对机器人的控制。

在机器人控制中,需要将识别的手势信息转化为机器人的运动指令或动作。

这需要借助于计算机视觉技术和运动规划技术。

计算机视觉技术可以实现对机器人周围环境的感知和识别,从而为机器人的运动规划提供依据。

运动规划技术则可以根据机器人的任务需求和周围环境信息,规划出最优的运动轨迹和动作。

基于Kinect的手势识别算法研究及应用

Digital TV simulation control

割方法¨-及基于人为增加限制的方法(如有些系统要求使用者

0引

言

戴上有色手套∞1)。手势的特征提取是影响手势识别率的关键 因素,目前特征值的选取有很多方法。7J1:选择手掌区域、手掌 中心及手的倾斜度,或提取手掌轮廓区域的几何特征或手掌的 运动轨迹等进行分析识别;在手势识别环节,识别方法可以分为 基于规则的手势识别。9 o和基于机器学习的手势识别¨””1。其 中基于机器学习的手势识别方法通过学习大量的训练样本特征 向量来确定分类器,是一种鲁棒性较高的手势识别方法。目前 手势识别中人手分割与定位主要是从彩色的视频帧图像或静态 图像中提取颜色及形状等信息进行手势的定位与识别,但颜色 特征易受光照变化和人手肤色等因素的影响使得在复杂背景下

trajectories

using Kinect and extracts the

tangent.ande

of

trajectory

as the feature,then employs the improved hidden Markov model to the proposed dynamic hand gestures recognition algorithm

technology.In order

to

improve the performance of Kinect—based hand gesture recognition,we propose the static hand gestures recognition algorithm,which is based

that the

proposed static hand gestures recognition algorithm obtains hi【sher recognition rate.The palm

基于KINECT深度图像信息的手势轨迹识别及应用

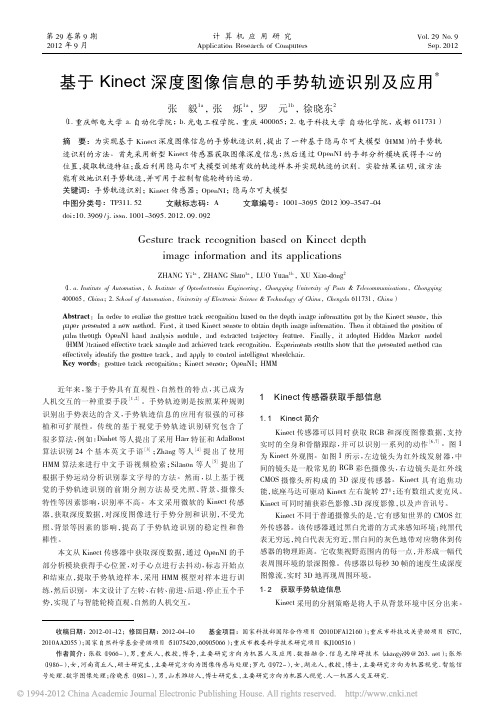

收稿日期:2012-01-12;修回日期:2012-04-10基金项目:国家科技部国际合作项目(2010DFA12160);重庆市科技攻关资助项目(STC ,2010AA2055);国家自然科学基金资助项目(51075420,60905066);重庆市教委科学技术研究项目(KJ100516)作者简介:张毅(1966-),男,重庆人,教授,博导,主要研究方向为机器人及应用、数据融合、信息无障碍技术(zhangyi99@263.net );张烁(1986-),女,河南商丘人,硕士研究生,主要研究方向为图像传感与处理;罗元(1972-),女,湖北人,教授,博士,主要研究方向为机器视觉、智能信号处理、数字图像处理;徐晓东(1981-),男,山东潍坊人,博士研究生,主要研究方向为机器人视觉、人—机器人交互研究.基于Kinect 深度图像信息的手势轨迹识别及应用*张毅1a,张烁1a,罗元1b ,徐晓东2(1.重庆邮电大学a.自动化学院;b.光电工程学院,重庆400065;2.电子科技大学自动化学院,成都611731)摘要:为实现基于Kinect 深度图像信息的手势轨迹识别,提出了一种基于隐马尔可夫模型(HMM )的手势轨迹识别的方法。

首先采用新型Kinect 传感器获取图像深度信息;然后通过OpenNI 的手部分析模块获得手心的位置,提取轨迹特征;最后利用隐马尔可夫模型训练有效的轨迹样本并实现轨迹的识别。

实验结果证明,该方法能有效地识别手势轨迹,并可用于控制智能轮椅的运动。

关键词:手势轨迹识别;Kinect 传感器;OpenNI ;隐马尔可夫模型中图分类号:TP311.52文献标志码:A文章编号:1001-3695(2012)09-3547-04doi :10.3969/j.issn.1001-3695.2012.09.092Gesture track recognition based on Kinect depthimage information and its applicationsZHANG Yi 1a ,ZHANG Shuo 1a ,LUO Yuan 1b ,XU Xiao-dong 2(1.a.Institute of Automation ,b.Institute of Optoelectronics Engineering ,Chongqing University of Posts &Telecommunications ,Chongqing 400065,China ;2.School of Automation ,University of Electronic Science &Technology of China ,Chengdu 611731,China )Abstract :In order to realize the gesture track recognition based on the depth image information got by the Kinect sensor ,this paper presented a new method.First ,it used Kinect sensor to obtain depth image information.Then it obtained the position of palm through OpenNI hand analysis module ,and extracted trajectory feature.Finally ,it adopted Hidden Markov model (HMM )trained effective track sample and achieved track recognition.Experiments results show that the presented method can effectively identify the gesture track ,and apply to control intelligent wheelchair.Key words :gesture track recognition ;Kinect sensor ;OpenNI ;HMM近年来,鉴于手势具有直观性、自然性的特点,其已成为人机交互的一种重要手段[1,2]。

基于Kinect深度图像的指尖检测与手势识别

基于Kinect深度图像的指尖检测与手势识别高晨;张亚军【摘要】Aiming at the problem that hand gesture recognition system based on ordinary camera is susceptible to the different lighting conditions and complex background, a fingertip detection and hand gesture recognition algorithm based on Kinect depth image is proposed. First, we get depth image by Kinect sensor. Then the hand region is extracted by putting the depth of thresholds on hand point detected by using OpenNI library. Fingertip detection based on convex hull and curvature is proposed. After the number of fingertips and the location of fingertips being detected, it calculates a feature vector including the number of fingers, the angles between fingertips and horizontal of the hand, the angles between two consecutive fingers, and the distance between fingertips and hand center point. Finally, a support vector machine(SVM) is applied to identify nine scheduled number hand gesture. Five experimenters are invited to perform 9 different hand gestures in the complex environment, which each gesture is repeated at thirty times and the angle of hand gesture is different every time. The experiment results show that this algorithm can detect the number and location of fingertips, and the recognition rate of nine hand gesture is 97.1% on average. This proposed method uses simple features and has good robustness, also it is real-time.%针对基于普通摄像头的手势识别系统在不同光照条件和复杂环境下易受影响的问题,提出一种基于kinect深度图像进行指尖检测和手势识别的算法.首先利用Kinect传感器获取深度图像,再利用OpenNI手部跟踪器检测出手部的位置,根据手部位置对手势进行深度阈值分割.提出一种结合凸包和曲率检测指尖的算法,检测出指尖数目和位置后,计算出包括指尖和手掌水平方向的夹角、相邻两个指尖夹角以及指尖与掌心的距离的特征向量,最后利用支持向量机(SVM)对预定的9种数字手势进行识别.实验邀请5位实验者在复杂环境下每个手势做30次,每次的手势角度不同,实验结果表明该方法能够准确检测出指尖的数目和位置,9种数字手势平均识别率达到97.1%,该方法使用特征简单,实时性好,有较好的鲁棒性.【期刊名称】《计算机系统应用》【年(卷),期】2017(026)004【总页数】6页(P192-197)【关键词】Kinect传感器;指尖检测;支持向量机;手势识别【作者】高晨;张亚军【作者单位】北京化工大学机电工程学院,北京 100029;北京化工大学机电工程学院,北京 100029【正文语种】中文不同于以往的鼠标、键盘等交互设备, 手势作为一种新的人机交互方式, 不需要直接接触, 这种人机交互方式更接近人与人之间的交流. 手势识别系统可以通过摄像头获取包含手势的图像信息, 根据图像信息解释手势的含义, 成熟的手势识别系统已经开始应用于很多领域, 如体感游戏, 智能电视, 医疗设备, 手语识别和机器人控制等[1-3].采用普通摄像头获取图像信息进行手势识别容易受到光照和背景的影响, 针对此问题, 文献[4]通过给使用者佩带有颜色的手套来分割手势. 但是当背景有和手套颜色一样的物体时, 仍会影响手势的分割, 并且文献[4]使用的普通摄像头在光线不足的情况无法检测到手势. 而微软推出的Kinect摄像头可以同时获取彩色图像和深度图像信息, 利用深度图像进行手势识别可以避免光照和环境的影响.近几年基于Kinect的指尖检测和手势识别已经有相关的研究, 文献[5]采用三维手势模型, 将手部分成21个不同的部分, 然后使用支持向量机(SVM)做分类器识别常用的手语. 但是其模型复杂, 运算量大, 实时性较差. 文献[6]和[7]都采用深度阈值分割手势区域,默认手势区域是距离摄像头最近的, 但是当手掌和手臂垂直的情况下就会将手臂也分割出来, 降低手势识别的准确率. 文献[8]使用距离直方图来识别手势, 而文献[9]综合了距离特征和曲率特征使用多级支持向量机来识别手势. 文献[10]通过从深度图像中分割手部区域, 并建立表观特征, 再用决策树识别手势. 文献[8-10]使用的特征都较复杂, 需要的计算量较大.针对上述问题本文提出一种把指尖数目, 手部方向, 掌心和指尖距离以及指尖相对于手部水平方向夹角作为特征向量, 再通过支持向量机的方法进行手势识别的算法, 如图1所示.主要的工作步骤如下:Step 1. 检测到手部区域, 将手部区域从复杂背景中分割出来;Step 2. 根据分割出来的手势区域, 计算出手掌掌心、手部水平方向, 再结合凸包和曲率检测指尖, 最后计算出指尖相对于手部水平方向的夹角, 相邻指尖之间的夹角和指尖与掌心的距离;Step3. 最后采集9种预设数字手势样本, 用支持向量机方法训练识别手势. Kinect摄像头可以同时获取深度图像和RGB彩色图像, 并且支持骨骼跟踪和动作识别. Kinect一共有三个摄像头, 左边镜头为红外线发射器, 中间镜头是一般常见的RGB 彩色摄像头, 右边镜头是由红外线CMOS 摄像头所构成的 3D 深度传感器. 根据深度传感器可以获取摄像头一定范围内物体与摄像头的距离.2.1 基于OpenNI的手势检测通过开源库OpenNI可以检测到挥手、前推和举起三种预设手势动作并获得手部掌心的坐标. 本文采用识别效果较好的前推动作和挥手动作, 手部对着Kinect摄像头前推或者挥手时, 即可检测到手部区域,并且给出掌心的粗略坐标, 识别效果如图2所示. 距离摄像头越近的点灰度值越大, 离摄像头远的点灰度值越小, 红色的点为识别出来的掌心位置, 从图2可以发现OpenNI给出的掌心位置不准确, 本文将根据手部轮廓的最大内切圆重新计算掌心坐标.2.2 基于深度阈值的手势分割Kinect获取到的深度数据为16位, 若使用不带用户ID的方式存储深度值, 则16位中的低12位为深度值, 即最大值为4096, 其代表4.096m. 通过OpenNI获得的粗略掌心坐标包括二维坐标和深度值, 本文采用双深度阈值方法分割手势区域, 对掌心深度d在加减阈值T范围内的像素按照式(1)进行二值化, 公式如下所示:式(1)中d为掌心的深度值, T为手掌厚度的深度阈值, H(x, y)为分割后手部深度图像中点(x, y)所对应的像素值, D(x, y)为深度图像中点(x, y)所对应的深度值.为了避免手臂和手腕的干扰, 取距离掌心长宽一定的矩形作为包含手势的感兴区域, 分割效果如图3所示, 从图3(b)中可以看到经过式(1)分割出的手部区域, 其边缘存在锯齿, 会对之后的指尖检测造成干扰,针对此问题, 本文采用中值滤波和形态学开闭运算对其进行去除噪声处理, 使手部边缘平滑, 效果如图3(c)所示.3.1 手部边缘检测为了获取手部轮廓的特征, 本文采用Canny边缘检测算法, 边缘检测即检测出图像亮度变化大的区域, Canny 边缘检测算法是对信噪比和定位之乘积的最优化逼近算子, 用来计算图像边缘的梯度幅度和相位值,选取合理幅度阈值来确定边缘点[11]. 从抑制噪声方面来讲, Canny边缘检测子不容易受到噪声的干扰, 而相同尺度下LOG算子却容易受到噪声的干扰, 抑制噪声的能力要弱一些. 此外, 由于Canny边缘检测算子采用两种不同的阈值分别检测强边缘和弱边缘, 并且当弱边缘和强边缘相连时, 只将弱边缘包含在输出图像中, 故而Canny算子更容易检测出真正的弱边缘, 因此本文采用Canny边缘检测来提取手部轮廓. 检测效果如图4所示.3.2 计算手掌掌心位置通过OpenNI获得的手掌掌心坐标不够准确, 本文通过计算手部轮廓的最大内切圆来确定手掌掌心坐标和掌心圆半径. 首先计算手部轮廓内每个点到轮廓边界距离的最小值, 找出其中最大距离值所对应的点即为掌心点, 距离即掌心圆半径. 这个过程计算量会很大, 影响手势识别的实时性, 因此本文不计算感兴区间内的所有点, 而是每隔N个点计算一个点, 经过实验验证当N=4时可以保证速度和准确性. 求出的掌心圆如图5所示.3.3 计算手部水平方向为了计算指尖的相对位置, 要先计算手部水平方向, 如图6所示, xh为手部水平方向, α为手部水平方向和x轴方向的夹角, θ为手部主轴和x轴方向的夹角, 这两个夹角可以根据文献[12]中提出的方法, 利用图像中心矩计算, 公式如下所示:式(2)中θ为手部主轴和水平方向的夹角, α为手部水平方向和x轴水平方向的夹角, (2,0)mu和(0,2)mu为图像的二阶中心矩.3.4 指尖检测3.4.1 凸包结合曲率检测指尖算法本文采用凸包算法与曲率检测算法相结合的算法, 可以精确的获得指尖的位置, 首先求出包围手部轮廓的最小外接圆, 然后利用OpenCV计算机视觉开源库中函数convexHull和convexityDefects求出包含手部轮廓的凸包和凸缺陷, 手部轮廓的凸包和凸缺陷模型如图7所示, A、B、C等为手部轮廓的凸缺陷, 凸缺陷包括起始点Ps、终止点Pe、缺陷上距离轮廓凸包最远的点pd, 凸包缺陷深度Id. 根据指尖的几何特征, 指尖点应该满足的条件如下所示:1) 凸缺陷深度应该大于掌心圆半径, 但小于手部轮廓最小外接圆半径, 即ra<Id<rb.2) 凸缺陷起始点和终止点的夹角应小于90°, 即θα<90o.3) 指尖点附近最小曲率值应小于60°, 即θk<60o.检测指尖时首先将满足上述条件(1)和(2)的凸缺陷的起始点和终止点保存到点集Ap中, 并且删除重复和距离过近的点, 然后以点集Ap中的点Pi为原点, 在手部轮廓中各取Pi之前和之后的10个点, 计算这20个点的K曲率, 即向量(Ai(j), Ai(j-k))与(Ai(j), Ai(j+k))之间的夹角, 若点Pi的K曲率值小于60°并且是20个点中K曲率值最小的点, 则其为指尖点. 本文算法相比较于传统的K曲率检测指尖运算量小, 只需要计算凸缺陷起始点和终止点极其附近的20个点的K曲率, 同时有效地排除了两个手指指尖的凹点, 通过实验验证当K取值30时效果最好.上述三个条件虽然能较好的满足基本的指尖检测, 但是也存在一些不足, 如只有一个指尖时, 是没有凸缺陷满足条件1)和2), 此时我们把凸缺陷起始点和终止点夹角并且凸缺陷深度Id大于阈值Td的凸缺陷起始点和终止点存储到点集Ap中, 然后通过上述方法计算点集Ap中点的K曲率通过条件3)来检测指尖. 3.4.2计算指尖点与手部水平方向夹角在获得了掌心圆、手部方向, 指尖坐标等特征之后, 接下来计算指尖点和手部水平方向的夹角, 以及相邻两个指尖与掌心的夹角. 如图8所示, 分别计算每个指尖与手部水平方向的夹角α[i](i=0, 1, 2, 3, 4),在计算相邻两个指尖和掌心形成的夹角β[i](i=0, 1, 2, 3), 最后计算每个指尖和掌心指尖的距离D[i](i=0, 1, 2, 3, 4), 最后把计算得到的结果保存到特征向量数组中, 如式(4)所示:式(4)中fV储存特征向量的数组, N为指尖数目, []iα为每个指尖和手部水平方向的夹角, []iβ为相邻两个指尖的夹角, D[]i为每个指尖与掌心的距离.在得到手部特征向量之后, 要设计分类器根据每种手势的特征对手势进行分类. 本文采用支持向量机作为分类器, 支持向量机具有能有效发现目标函数的全局最优解, 最大化决策边界等特点13. 在解决线性问题中, SVM 能直接在该空间中划分出分割平面, 但在实际问题中更多的是非线性的问题, 支持向量机首先在低维空间中完成计算, 然后通过核函数将输入空间映射到高维特征空间, 最终在高维特征空间中构造出最优分离超平面, 从而把平面上本身不好分的非线性数据分开, 常用的核函数包括多项式核函数、径向基(RBF)核函数和 Sigmoid 核函数. 本文采用径向基函数, 因为其模型简单, 参数相对较少, 可以有效的把非线性问题转换为线性问题, 并经过实验验证径向基核函数的效果最好.为了验证本文提出方法的可靠性和准确性, 本文使用内存8G, CPU为Intel(R)*************************的笔记本作为处理平台, 使用微软Kinect一代摄像头采集图像, 通过使用开源库OpenNI、Opencv进行编程, 编程环境为VS2015, 实验包括指尖检测和手势识别两个部分, 实验过程中光照环境不稳定, 实验者与Kinect摄像头距离约为1m.5.1 指尖检测实验分析本文分别对指尖数目为0到5的六种情况进行测试, 测试过程中, 指尖的方向不断变化, 测试结果如图9所示. 然后将每种指尖数目的视频序列保存1000帧, 每隔5帧提取1帧, 共提取200帧, 统计出检测结果如表1所示.通过图9和表1可以看出, 本文提出的结合凸包和曲率检测指尖的算法平均准确率可以达到97.9%,在手部运动的过程中能准确的检测出指尖的位置和数目, 可以有效排除手腕处的干扰点, 针对不同方向的指尖都可以准确检测出来, 具有较好的鲁棒性. 同时可以看出1个手指和三个手指的误判比其他的多, 因为三个手指的情况较多, 在手指没伸直的情况下, 容易造成误判, 而一个手指则因为无法使用凸包和曲率结合算法, 容易受手腕干扰, 不同光照下的检测效果如图10所示.5.1 数字手势识别实验为了验证本文提出的手势识别算法, 本实验针对如图11所示的9种数字手势进行识别, 实验前先构建训练样本数据库, 邀请5位实验者针对每个手势做10次, 要求每个手势的角度不同, 总共采集450张样本图像, 然后对样本图像进行训练, 计算每张样本图像对应的特征向量并保存结果. 训练完成之后, 为了验证算法的鲁棒性, 再邀请另外的5个人实时检测手势, 每个手势做30次, 即测试样本图像共1350张, 每种手势的识别率如表2所示.从图11和表2可以看出, 用指尖与掌心的距离、指尖与手部水平方向的夹角以及相邻指尖之间的夹角作为特征向量可以明确的表示出每种手势的特征, 平均手势识别率可以达到97.1%, 其中手势3和手势6误检率最高, 因为手势3不是正对着摄像头时容易因为遮挡而识别错误, 手势6因为在运动过程中小拇指会因为噪声干扰而误判为手势8. 每帧手势识别处理时间平均为0.015秒, 实时性比较好. 本文方法与常用的HOG+SVM、几何特征、模板匹配方法14相比使用的特征简单, 计算量小, 准确率也相差不多.本文通过使用Kinect深度图像信息进行指尖检测和手势识别, 有效地解决了在不同光照条件和复杂背景下指尖检测和手势识别的难题, 提出一种结合凸包和曲率检测指尖算法, 避免传统曲率检测误判点多和凸包检测位置不准确的缺点. 检测出指尖后, 提出一种需要样本少, 方法简单的手势识别算法, 该方法利用指尖与手部水平方向夹角, 相邻指尖夹角以及指尖和掌心距离作为特征向量, 使用支持向量机做分类器.通过实验证明该算法手势识别精度较高, 指尖检测较准确, 能够在不同光照条件和复杂背景下进行检测,鲁棒性较好.但是本文提出的方法在手指并在一起等一些特殊情况无法准确检测出指尖, OpenNI的手部跟踪器效果不是很好, 在有遮挡的情况会跟丢手部区域, 在今后的工作中研究更精确, 鲁棒性更好的跟踪算法.1 孙丽娟,张立材,郭彩龙.基于视觉的手势识别技术.计算机技术与发展,2008,18(10):214–216.2 易靖国,程江华,库锡树.视觉手势识别综述.计算机科学, 2016,43(6A):103–108.3 李勇,高文,姚鸿勋.基于颜色手套的中国手指语字母的动静态识别.计算机工程与应用,2002,17:55–58.4 Lamberti L, Camastra F. Real-time hand gesture recognition using a color glove. Springer Proc. of the 16th International Conference on Image Analysis and Processing, 2011, 6978(1): 365–373.5 Keskin C, Kirac F, et al. Real time hand pose estimation using depth sensors. IEEE International Conference on Computer Vision Workshops, 2011, 28(5): 1228–1234.6 王艳,张奇志.基于Kinect深度信息的手势识别.北京信息科技大学学报,2013,28(1): 22–26.7 邓瑞,周玲玲,应忍冬.基于Kinect深度信息的手势提取与识别研究.计算机应用研究,2013,30(4):1263–1265.8 Ren Z, Yuan J, Zhang Z. Robust hand gesture recognition based on finger earth mover’s distance with a commodity depth cam era. Proc. of ACM Conference on Multimedia. 2011. 1093–1096.9 Domini F, Donadeo M, Marin G. Hand gesture recognition with depth data. ARTEMIS ’13 Proc. of the 4th ACM/IEEE International Workshop on Analysis and Retrieval of Tracked Events and Motion in Imagery Stream. 2013. 9–1610 曹雏清,李瑞峰,赵立军.基于深度图像技术的手势识别方法.计算机工程,2012,38(8):16–18.11 薛丽霞,李涛,王佐成.一种自适应的Canny边缘检测算法.计算机应用研究,2012,27(9):3588–3590.12 Liao SX, Pawlak M. Image Analysis by Moments. The University of Manitoba Winnipeg, 1993.13 祁亨年.支持向量机及其应用研究综述.计算机工程,2004, 30(10):6–9.14 刘淑萍,刘羽,淤俊,汪增福.结合手指检测的HOG特征的分层静态手势识别.中国图像图形学报,2015,20(6):781–788.。

《基于深度学习的手势识别算法研究》范文

《基于深度学习的手势识别算法研究》篇一一、引言随着人工智能和机器学习技术的不断发展,手势识别技术在多个领域中扮演着越来越重要的角色。

无论是智能机器人控制、人机交互、虚拟现实还是游戏娱乐等领域,都需要精确、高效的手势识别技术。

而基于深度学习算法的手势识别技术,以其强大的特征提取能力和模式识别能力,逐渐成为研究的热点。

本文旨在研究基于深度学习的手势识别算法,以期为相关领域的研究和应用提供理论支持和技术参考。

二、相关研究背景及现状在传统的手势识别方法中,主要通过提取人手和手指的几何特征或物理特征来进行识别。

然而,这些方法在面对复杂多变的手势时,往往难以达到理想的识别效果。

近年来,随着深度学习技术的发展,越来越多的研究者开始将深度学习算法应用于手势识别领域。

目前,基于深度学习的手势识别算法主要采用卷积神经网络(CNN)和循环神经网络(RNN)等模型。

其中,CNN模型在图像处理和特征提取方面具有强大的能力,而RNN模型则可以有效地处理时序数据。

这些深度学习模型在手势识别的特征提取、模式分类等方面均取得了显著的成果。

然而,如何在复杂的背景下有效地提取手势特征,以及如何设计更为高效的手势识别算法仍是需要深入研究的问题。

三、基于深度学习的手势识别算法研究(一)算法原理及模型构建本文提出了一种基于深度学习的手势识别算法。

该算法采用卷积神经网络模型进行特征提取和模式分类。

首先,通过构建一个多层次的卷积神经网络模型,对手势图像进行特征提取。

其次,将提取的特征输入到全连接层进行分类。

最后,通过损失函数优化模型参数,实现手势的准确识别。

(二)算法实现过程及技术难点在算法实现过程中,我们采用了多种技术手段以提高手势识别的准确性和鲁棒性。

首先,我们通过数据增强技术对训练数据进行扩充,以增加模型的泛化能力。

其次,我们采用了多种不同的卷积核和激活函数来提取手势图像的多种特征。

此外,我们还通过优化模型的损失函数和参数调整来提高模型的性能。

基于Kinect深度信息的手势提取与识别研究

s h o w t h a t t h e a v e r a g e r e c o g n i t i o n r a t e o f t h i s s c h e me i s 9 5 % ,a n d t h e s c h e me ma k e s h i g h p r e c i s i o n w i t h s i mp l e d e v i c e a n d

9 5 %, 使 用设备 简单 且精度 较 高 , 鲁棒 性较好 。 关键 词 :手势识 别 ; 深度 信 息 ; 三 维点云 ; 人机 交互 ;支持 向量 机

中图分 类 号 :T P 3 9 1 . 4 1 文 献标 志码 :A 文章 编号 :1 0 0 1 — 3 6 9 5 ( 2 0 1 3 ) 0 4 — 1 2 6 3 . 0 3

邓 瑞, 周玲玲 , 应忍冬

( 上海 交通 大 学 电子信 息 与 电气工程 学 院 , 上海 2 0 0 2 4 0 )

摘 要 :针 对基 于视 觉 的手 势识 别技 术 对环境 背景要 求较 高的 问题 , 提 出了一 种使 用深度 信 息进行 手微 软 K i n e c t 摄 像 头进行 手势 深度 图的采 集 , 再 将 深度 图转换 为三 维 点云 , 根 据 深 度信 息过 滤来提 取手 势数 据 。对手 势数据 进行 方 向校 正后 统 计手 势 数据 中深 度信 息 的 区 间分 布特 征 并 输入 到 支持 向量 机进 行训 练 , 从 而实现 了对数 字手 势 1~5的手势 识 别。 实验 结果证 明 , 该手 势识 别方案 的 平均 识 别 率达到

第3 0卷 第 4期 2 0 1 3年 4月

计 算 机 应 用 研 究

基于Kinect传感器深度信息的动态手势识别

第 4期

厦 门大 学 学报 ( 自然 科 学版 )

J o u r n a l o f Xi a me n Un i v e r s i t y( Na t u r a l S c i e n c e )

Vo 1 . 5 2 No . 4

2 0 1 3年 7月

模型空 间里的点分类 到该空 间里某个 子集 的过 程 ; 而动 态手势识别 就是 把这 些 点组 成 的轨 迹分 类 到某 个 子集 的过程 , 由于涉及 时 间及 空 间上 下文 , 在 进行 建 模 时通

势; 文 献[ 5 ] 提 出用 S UR F剪 裁手 势 , 并 通 过简 单 的 前

常显示 为一条动作 轨迹 , 这种识 别难度 大但 更具 有实用

性. 现有 的动态手 势识 别 技术 可 以分 归 3类 : 基 于 隐 马 尔可 夫 模 型 ( HMM) 的 识 别 ] , 基 于 动 态 时 间 规 整 ( D TW) 的识 别 以 及 基 于 压 缩 时 间 轴 的 识 别 l - 3 ] . 基 于

激光散斑 获取深度 信息 , 不受环 境 的光 照变 化和 复杂 背 景的影 响 , 以此来进行 手势跟踪 与识别.

处理( 手势 跟踪 、 手势 分 割 、 特征提取等) ; 二 是 手 势 运 动轨迹 提取 和分 类. 例如文 献[ 2 ] 提 出采用 三维 坐标 系

利用手 势重 心 的 中心位 置 进 行 轨迹 提 取 和 分类 , 识 别

J u 1 .2 o 1 3

基 于 Ki n e c t 传 感 器 深 度 信 息 的 动 态 手 势 识 别

陶丽君 , 李 翠 华 , 张希婧 , 李 胜睿

( 厦 门大 学 信 息 科 学 与 技 术 学 院 , 福建 厦门 3 6 1 0 0 5 )

《2024年基于Kinect的手势识别与机器人控制技术研究》范文

《基于Kinect的手势识别与机器人控制技术研究》篇一一、引言随着科技的进步和人工智能的不断发展,人机交互的方式也日趋多样化和智能化。

Kinect作为一种重要的传感器技术,其应用领域不断扩大,尤其是在手势识别与机器人控制方面具有广泛的应用前景。

本文旨在研究基于Kinect的手势识别技术及其在机器人控制领域的应用,为未来的智能人机交互提供理论基础和技术支持。

二、Kinect技术概述Kinect是一种由微软开发的深度传感器技术,广泛应用于游戏、娱乐、科研等领域。

它能够捕捉人体的运动和姿态,具有高精度、高效率、低成本等优点。

Kinect技术通过捕捉人体骨骼运动信息,实现对人体动作的精确识别和跟踪。

三、基于Kinect的手势识别技术研究1. 手势识别的基本原理基于Kinect的手势识别主要依靠对人体骨骼信息的捕捉和分析。

通过Kinect传感器捕捉到的骨骼数据,可以分析出手部关节的位置和运动轨迹,进而实现对手势的识别。

2. 手势识别的关键技术(1)数据预处理:对捕捉到的骨骼数据进行滤波、去噪等处理,以提高数据的准确性和可靠性。

(2)特征提取:通过对手部关节位置、运动轨迹等特征进行提取,形成手势的特征向量。

(3)模式识别:利用机器学习、深度学习等算法,对特征向量进行分类和识别,实现对不同手势的区分。

四、手势识别在机器人控制领域的应用研究1. 机器人控制的需求与挑战随着机器人技术的不断发展,其在工业、医疗、军事等领域的应用越来越广泛。

然而,如何实现人机协同、高效地控制机器人一直是研究的难点。

手势识别作为一种自然、直观的人机交互方式,为解决这一问题提供了可能。

2. 手势识别在机器人控制中的应用方案(1)手势命令的识别与解析:通过手势识别技术,将用户的手势转化为机器人的命令或动作。

例如,通过挥手、指向等手势,实现机器人的启动、停止、移动等功能。

(2)手势与机器人协同操作:通过对手势的精确识别和解析,实现人与机器人的协同操作。

《2024年基于Kinect的手势识别与机器人控制技术研究》范文

《基于Kinect的手势识别与机器人控制技术研究》篇一一、引言随着人工智能技术的不断发展,人机交互技术已成为研究热点之一。

其中,基于Kinect的手势识别技术因其高精度、实时性和自然性等特点,在人机交互领域具有广泛的应用前景。

同时,机器人控制技术也在不断进步,为机器人与人类更加自然、智能地交互提供了可能。

因此,本研究将探讨基于Kinect的手势识别与机器人控制技术的结合,以实现更高效、便捷的人机交互体验。

二、Kinect手势识别技术Kinect是一种由微软开发的三维动作捕捉和语音识别系统,能够实时捕捉人体动作和语音信息。

基于Kinect的手势识别技术通过捕捉人体手势信息,对不同手势进行分类和识别,从而实现人机交互。

2.1 Kinect手势数据采集在Kinect手势识别过程中,首先需要采集手势数据。

Kinect 通过红外线传感器和深度相机等设备,实时捕捉人体动作信息,包括骨骼点信息、颜色信息等。

这些数据将被用于后续的手势识别和处理。

2.2 手势特征提取与分类在手势特征提取方面,可以通过分析骨骼点信息、颜色信息等特征,提取出手势的关键特征。

然后,利用机器学习算法对不同手势进行分类和识别。

常用的机器学习算法包括支持向量机、神经网络等。

2.3 手势识别的应用场景基于Kinect的手势识别技术可以应用于多个领域,如游戏控制、智能家居、虚拟现实等。

在游戏控制中,玩家可以通过手势控制游戏角色,实现更加自然、便捷的操作体验。

在智能家居中,用户可以通过手势控制家居设备的开关、调节等操作。

在虚拟现实中,手势识别技术可以实现更加自然、真实的交互体验。

三、机器人控制技术机器人控制技术是实现机器人与人类自然、智能交互的关键技术。

通过机器人控制技术,可以实现机器人的自主导航、语音识别、手势识别等功能。

3.1 机器人控制系统的架构机器人控制系统通常由传感器、控制器和执行器等部分组成。

传感器用于获取环境信息和机器人自身的状态信息,控制器根据传感器信息做出决策并控制执行器执行相应的动作。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

[7 ]

本文设计的特征提取方法基于手势点云的 Z 轴坐标值即 深度值的区间, 通过统计 Z 轴连续区间的对应空间中点的数 量来计算手势的特征。这种手势分析方法完全基于深度信息 Y 平面上的点分布, 进行, 不考虑 X这就要求进行识别的手势 在 Z 方向上有辨析度。本文挑选了用手势表示数字 1 ~ 5 这 5 Y 平面和 YZ 平面投影 个手势进行分析, 其相应提取的点云 X3 所示。 如图 2 、

识别的研究方案。采用了微软 Kinect 摄像头进行手势深度 图 的 采集, 再将 深度 图转换 为 三维点云, 根据 深度信 息过滤来提取手势数据。对手势数据进行方向校正后统 计 手势 数据中 深度信息的 区间分布特征并输 入 到支持 向量机进行训练, 从而实现了对数字手势 1 ~ 5 的手势识别。实验结果证明, 该手势识别方案的 平均 识别 率达到 95% , 使用设备简单且精度较高, 鲁棒性较好。 关键词: 手势识别; 深度信息; 三维点云; 人机交互; 支持向量机 中图分类号: TP391. 41 文献标志码: A 文章编号: 1001-3695 ( 2013 ) 04-1263-03 doi: 10. 3969 / j. issn. 1001-3695. 2013. 04. 083

[2)

对手势方向进行校正, 就是对手势点云进行坐标旋转变 Y 平面平行。设拟合平面旋转至 换, 使其拟合平面旋转至与 XY 平面平行时需要绕 Y 轴逆时针旋转的夹角为 φ1 , 与 X绕X 轴逆时针旋转的夹角为 φ2 , 则有

φ1 = arctan φ2

其中: s = 0. 0021 。 1. 2 基于距离的分割 为方便数据的处理, 将深度图的实际距离数据转换为三维 点云进行后续的处理。640 × 480 像素的深度图数据转换为点 云后共有 307 200 个点, 如果使用全部数据进行处理会比较耗 费时间。基于之前的假设, 手部数据距离摄像头不超过 1 m, 故首先对所有的点进行一个基于距离的深度过滤, 去除深度距 离大于 100 cm 的数据。 对深度过滤后的点进行遍历, 比较得到与原点距离最小 的点的集合 。 若点集合的内容大于 1 , 可能是最近点附近的 若干点距离相同造成的 。 若这些点的距离过远, 则判定为提 。 则得到的最近点为要提取的手 取时发生错误 若提取正确, 势中的一点 。 1. 3 用最近邻法则进行手部提取 根据最近邻法则, 已确定分类的点附近的点集也属于同一 [9 ] 。用最近邻法则进行手部提取, 即以此与原点距离

[3 ]

。 肤色检测法根

据肤色在颜色空间分布的特点将图像转换到相应的颜色空间 进行阈值分离。使用肤色检测法可以直接从图像中分离出肤 色的区域, 但目前的技术主要存在以下问题: 容易受到复杂背 景和复杂光照条件影响, 不能与脸部等与肤色相近的位置重 叠, 不能穿戴非肤色的手套等

[4 ]

。

收稿日期: 2012-08-01 ; 修回日期: 2012-09-24 作者简介: 邓瑞( 1988-) , 女, 山东聊城人, 硕士研究生, 主要研究方向为模式识别、 信号处理( xelless@ 163. com ) ; 周玲玲( 1965-) , 女, 副教授, 主要研究方向为模式识别 、 嵌入式系统; 应忍冬 ( 1975-) , 男, 副教授, 主要研究方向为模式识别、 系统可靠性.

2

手势分析

1

手势提取

本文设计的手势提取和识别算法用于 3D 虚拟场景的视 频会议系统, 为了符合系统要求且使手部特征点较多, 假设 Kinect 摄像头与人手之间的距离在 1 m 以内, 且手的位置距离摄 规定手势的手心面向摄像头, 指尖向上, 手势 像头最近。此外, 平面与摄像头平面之间的夹角小于 45° 。 1. 1 像素位置转换为实际位置 用 Kinect 获得的深度数据是以像素为单位记录的, 默认为 640 × 480 像素。在进行手势识别时需要根据实际距离的大小进 行距离判定, 故首先要把以像素为单位的数据转换成以实际距 Y 平面尺寸为 w × 离为单位的数据。设 Kinect 拍摄的深度图 Xh, 则其对应实际距离坐标如图 1 所示, 其中原点为摄像头位置。 Kinect 返回的深度值不是实际距离, 而是一个相对数据。 设 Kinect 返回的某一点深度值为 d raw , 根据 Kinect 的校准过 程, 可求得相应的实际距离深度值为 其中: K = 0 . 1236 m,O = 0 . 037 m。 j, d ) 的点的 根据实际距离深度值, 可求得像素位置为( i, [8 ] y, z) , 实际位置( x, 其转换式为

[5 ]

计算机的输入, 相比传统的键盘、 鼠标等具有自然、 直观、 易于 学习等优点。早期的手势识别主要使用数据手套等传感器设 备采集手部关节数据的方法进行手势提取, 同时使用神经网络 进行关节数据的分析从而获得手势意义, 但机械手套一般价格 昂贵且使用时有较多限制 式

[2 ] [1 ]

。

2010 年微软推出了用于 Xbox 360 的体感外设 3D 摄像机 Kinect, 使用结构光编码技术获取拍摄图像的深度信息 。 Kinect 的摄像部分包括一个 RGB 摄像头、 一个红外摄像头和一 个红外发射器。红外发射器可以发出近红外激光, 当激光照射 称为激光散 到粗糙物体时会形成具有高度随机性的衍射斑点, 斑。激光散斑会随着成像物体的距离不同而变换图案, 当激光 散斑照射到整个空间时即对空间进行了标记 。 红外摄像头则 接收空间标记, 传递至 Kinect 内部的 PS1080 Soc 图像处理器 芯片。图像处理器通过分析散斑图案获得的空间距离生成深 度影像, 并使用 USB2. 0 协议传输至 PC 端。相比 TOF 摄像机, Kinect 价格低廉, 拍摄分辨率可达像素级, 而且由于使用了图 不需要 PC 端额外的计算量, 可以使 PC 端以较 像处理器芯片, 低的配置达到实时性的要求 。 Kinect 的这些特性使其成为了人体识别领域的热门工具 。 基于 Kinect 的手势识别通常使用 Kinect 获取深度图, 然后使用 微软提供的 Kinect SDK 进行人体骨架识别从而获得手势位置

d = K tan( d raw / 2842 . 5 + 1 . 1863 ) - O

( 1)

2. 1

方向校正

w × ( d - 10 ) × s × ( i- w 2 ) h h y=( j- × ( d - 10 ) × s 2 ) x= z=d

基于深度信息的手势分析要求获得的手势在空间方向上尽 Y平 可能统一, 而手势采集的时候不能保证手势平面总是与 X面平行, 故在进行分析前要对提取的手势点云进行方向校正。 首先用最小二乘法进行平面拟合 b, c) 。 量为( a,

· 1264·

及动作意义

[6 ]

计 算 机 应 用 研 究

第 30 卷

, 或根据深度信息过滤提取出手势部分深度图, [7 ] 再将其转换为平面图, 使用 2D 手势识别的方式进行识别 。 但这两种方法都有一定的缺陷: 前者使用 Kinect SDK 时必须 而后 要在摄像头全身可见的条件下才能进行较为准确的识别, 者将带有 3D 信息的深度图转换为平面图进行处理会造成深 且 2D 手势识别易受手指遮挡等问题影响 。 本 度信息的浪费, 没有使用 2D 手势识别 文使用了 Kinect 作为手势采集的工具, 的方法, 而是将深度图转换为三维点云, 利用深度信息进行手 势提取和识别分析, 相比于 2D 手势识别有更多的优势 。

Gesture extraction and recognition research based on Kinect depth data

DENG Rui,ZHOU Lingling,YING Rendong

( College of Electronic Information & Electrical Engineering,Shanghai Jiaotong University,Shanghai 200240 ,China)

Abstract: Aiming at the problem that gesture recognition technology based on vision required a lot on environment and background,this paper presented a gesture extraction and recognition scheme based on depth data. It utilized Microsoft Kinect to capture gesture depth map,converted the depth map to 3D point cloud, and then used depth map filter to obtain gesture data. After direction adjustment for the gesture,calculated and imported the interval distribution feature of gesture depth information to support vector machine for training,thus implementing gesture recognition for number gesture 1 to 5. Experimental results show that the average recognition rate of this scheme is 95% ,and the scheme makes high precision with simple device and good robustness. Key words: gesture recognition; depth data; 3D point cloud; humancomputer interaction; support vector machine