迁移学习研究进展_庄福振

软件学报ISSN 1000-9825, CODEN RUXUEW E-mail: jos@https://www.360docs.net/doc/1c18404856.html, Journal of Software,2015,26(1):26-39 [doi: 10.13328/https://www.360docs.net/doc/1c18404856.html,ki.jos.004631] https://www.360docs.net/doc/1c18404856.html, ?中国科学院软件研究所版权所有. Tel: +86-10-62562563

*

迁移学习研究进展

庄福振, 罗平, 何清, 史忠植

(中国科学院智能信息处理重点实验室(中国科学院计算技术研究所),北京100190)

通讯作者: 庄福振, E-mail: zhuangfz@https://www.360docs.net/doc/1c18404856.html,

摘要: 近年来,迁移学习已经引起了广泛的关注和研究.迁移学习是运用已存有的知识对不同但相关领域问题进行求解的一种新的机器学习方法.它放宽了传统机器学习中的两个基本假设:(1) 用于学习的训练样本与新的测试样本满足独立同分布的条件;(2) 必须有足够可利用的训练样本才能学习得到一个好的分类模型.目的是迁移已有的知识来解决目标领域中仅有少量有标签样本数据甚至没有的学习问题.对迁移学习算法的研究以及相关理论研究的进展进行了综述,并介绍了在该领域所做的研究工作,特别是利用生成模型在概念层面建立迁移学习模型.最后介绍了迁移学习在文本分类、协同过滤等方面的应用工作,并指出了迁移学习下一步可能的研究方向.

关键词: 迁移学习;相关领域;独立同分布;生成模型;概念学习

中图法分类号: TP181

中文引用格式: 庄福振,罗平,何清,史忠植.迁移学习研究进展.软件学报,2015,26(1):26-39.https://www.360docs.net/doc/1c18404856.html,/1000-9825/ 4631.htm

英文引用格式: Zhuang FZ, Luo P, He Q, Shi ZZ. Survey on transfer learning research. Ruan Jian Xue Bao/Journal of Software, 2015,26(1):26-39 (in Chinese).https://www.360docs.net/doc/1c18404856.html,/1000-9825/4631.htm

Survey on Transfer Learning Research

ZHUANG Fu-Zhen, LUO Ping, HE Qing, SHI Zhong-Zhi

(Key Laboratory of Intelligent Information Processing of Chinese Academy of Sciences, Institute of Computing Technology, The Chinese Academy of Sciences, Beijing 100190, China)

Abstract: In recent years, transfer learning has provoked vast amount of attention and research. Transfer learning is a new machine learning method that applies the knowledge from related but different domains to target domains. It relaxes the two basic assumptions in traditional machine learning: (1) the training (also referred as source domain) and test data (also referred target domain) follow the independent and identically distributed (i.i.d.) condition; (2) there are enough labeled samples to learn a good classification model, aiming to solve the problems that there are few or even not any labeled data in target domains. This paper surveys the research progress of transfer learning and introduces its own works, especially the ones in building transfer learning models by applying generative model on the concept level. Finally, the paper introduces the applications of transfer learning, such as text classification and collaborative filtering, and further suggests the future research direction of transfer learning.

Key words: transfer learning; related domain; independent and identical distribution; generative model; concept learning 随着社会发展的信息化和网络化,人们在日常生活和工作中无时无刻不在获取信息,分析信息,并以此作为决策的依据.在一定程度上,信息的拥有量已经成为决定和制约人类社会发展的重要因素.想要高效、准确地寻找到所需的信息,信息分类是必不可少的第一步.通过分类,信息可以得到有效的组织管理,有利于快速、准确地

*基金项目: 国家自然科学基金(61473273, 61473274, 61175052, 61203297); 国家高技术研究发展计划(863)(2014AA015105, 2013AA01A606, 2012AA011003)

收稿时间:2014-02-21; 修改时间: 2014-03-31; 定稿时间: 2014-05-22; jos在线出版时间: 2014-07-14

CNKI网络优先出版: 2014-07-14 16:04, https://www.360docs.net/doc/1c18404856.html,/kcms/doi/10.13328/https://www.360docs.net/doc/1c18404856.html,ki.jos.004631.html

庄福振等:迁移学习研究进展27

定位信息.分类学习问题,是机器学习中一种重要的学习方法,目前已经得到广泛的研究与发展.

在传统分类学习中,为了保证训练得到的分类模型具有准确性和高可靠性,都有两个基本的假设:(1) 用于学习的训练样本与新的测试样本满足独立同分布的条件;(2) 必须有足够可利用的训练样本才能学习得到一个好的分类模型.但是,在实际应用中我们发现,这两个条件往往无法满足.首先,随着时间的推移,原先可利用的有标签的样本数据可能变得不可用,与新来的测试样本的分布产生语义、分布上的缺口.比如,股票数据就是很有时效性的数据,利用上月份的训练样本学习得到的模型并不能很好地预测本月份的新样本.另外,有标签的样本数据往往很匮乏,而且很难获得.在Web数据挖掘领域,新数据不断涌现,已有的训练样本已经不足以训练得到一个可靠的分类模型,而标注大量的样本又非常费时费力,而且由于人的主观因素容易出错,这就引起了机器学习中另外一个重要问题,如何利用少量的有标签训练样本或者源领域数据,建立一个可靠的模型对目标领域数据进行预测(源领域数据和目标领域数据可以不具有相同的数据分布).He等人[1]指出数据分类首先要解决训练集样本抽样问题,如何抽到具有代表性的样本集作为训练集是一个值得研究的重要问题.文献[1]提出极小样本集抽样方法用于基于超曲面分类算法,该方法可感知非结构化数据的分布,并以极小样本集作为代表子集.该文还指出了极小样本集有多少种表达方式,给出了样本缺失情况下准确率的精确估计.文献[1]表明,在实际中保证训练得到的分类模型具有高准确性和可靠性的两个基本假设并不是每种算法都能做到的,因此研究迁移学习变得非常重要.

近年来,迁移学习已经引起了广泛的关注和研究[2-18].根据维基百科的定义**,迁移学习是运用已存有的知识对不同但相关领域问题进行求解的一种新的机器学习方法.它放宽了传统机器学习中的两个基本假设,目的是迁移已有的知识来解决目标领域中仅有少量有标签样本数据甚至没有的学习问题.迁移学习广泛存在于人类的活动中,两个不同的领域共享的因素越多,迁移学习就越容易,否则就越困难,甚至出现“负迁移”[19,20]的情况,产生副作用.比如:一个人要是学会了骑自行车,那他就很容易学会开摩托车;一个人要是熟悉五子棋,也可以轻松地将知识迁移到学习围棋中.但是有时候看起来很相似的事情,却有可能产生“负迁移”现象.比如,学会骑自行车的人来学习三轮车反而不适应,因为这两种车型的重心位置不同[21,22].近几年来,已经有相当多的研究者投入到迁移学习领域中,每年在机器学习和数据挖掘的顶级会议中都有关于迁移学习的文章发表,比如,ICML, SIGKDD,NIPS,ICDM以及CIKM等.下面针对迁移学习研究展开系统的综述,特别是从迁移学习采用的技术角度进行介绍.

1 迁移学习算法研究进展

针对源领域和目标领域样本是否标注以及任务是否相同[13],可以把以往迁移学习工作划分为归纳迁移学习、直推式迁移学习以及无监督迁移学习等.而按照迁移学习方法采用的技术划分,又可以把迁移学习方法大体上分为:i) 基于特征选择的迁移学习算法研究;ii) 基于特征映射的迁移学习算法研究;iii) 基于权重的迁移学习算法研究.本文主要从这两条线对迁移学习的工作进行总结和综述.

1.1 按源领域和目标领域样本是否标注以及任务是否相同划分

Pan和Yang[13]针对源领域和目标领域样本是否标注及任务是否相同或是否单一对迁移学习进行了划分.

根据源领域和目标领域中是否有标签样本可将迁移学习划分为3类:目标领域中有少量标注样本的归纳迁移学习(inductive transfer learning)[23],只有源领域中有标签样本的直推式迁移学习(transductive transfer learning)[4],以及源领域和目标领域都没有标签样本的无监督迁移学习[24,25].另外,还根据源领域中是否有标签样本把归纳迁移学习划分成多任务学习、自学习.Pan和Yang[13]还给出了传统机器学习与各种迁移学习情形之间的关系,以及各种情形下,源领域与目标领域是否相同、源领域与目标领域的任务是否相同.迁移学习是和传统学习相对应的一大类学习方式,传统学习处理源领域和目标领域相同且源领域和目标领域的任务是相同的学习,迁移学习处理除此情形之外的学习,包括:源领域和目标领域的任务相关但不同的归纳迁移学习[6,12,26-31];

** https://www.360docs.net/doc/1c18404856.html,/wiki/Transfer_learning

28 Journal of Software软件学报V ol.26, No.1, January 2015

源领域和目标领域相关但不相同而源领域和目标领域的任务相同的直推式迁移学习(transductive transfer learning)[3,7,32-36].无监督迁移学习与归纳迁移学习类似,不过,无监督迁移学习主要处理源领域和目标领域中都没有标签数据的问题[24,37].Pan和Yang还根据训练样本和测试样本是否来自于同一个领域,把直推式迁移学习划分为样本选择偏差、协方差偏移和领域自适应学习这些相关的子领域.

1.2 按采用的技术划分

近10年来,很多学者对迁移学习展开了广泛的研究,而且很多集中在算法研究上,即采用不同的技术对迁移学习算法展开研究.因此,下面首先介绍与迁移学习极其相关的半监督学习方法,然后再对采用各种技术的迁移学习工作进行介绍.

1.2.1 半监督学习方法

在传统的监督学习中,学习算法通过对大量有标签的训练样本进行学习,从而建立模型用于预测标记新来的没有标签的测试样本.但是随着信息技术、互联网以及存储技术的快速发展,数据量随之呈指数级增长.人们能够比较容易地收集大量的没有标签的数据,但要获取大量有标签的数据则较为困难,因为这可能需要耗费大量的人力物力.例如,在生物学中进行数据分类,得到一个训练样本的标签往往需要大量的、长时间的、昂贵的实验;在进行Web网页推荐时,用户也不愿意花费大量的时间来标记哪些网页是他感兴趣的,因此有标签的网页很少.实际上,在真实世界中通常存在大量的无标签的数据,而有标签的数据则较少.这就需要一种机器学习技术能够利用大量的无标签样本数据以及少量有标签的训练样本进行学习,以提高分类任务的准确率.

按照Zhou等人在文献[38]中的阐述,目前能够利用少量有标签数据和大量没有标签样本数据的技术有3类:半监督学习(semi-supervised learning)、直推式学习(transductive learning)和主动学习(active learning).这些学习方法都通过大量的无标签样本来辅助少量有标签样本的学习,但它们在思想上又有些不同.半监督学习指的是学习算法在学习过程中无需人工干预,基于自身对无标签数据加以利用.而直推式学习与半监督学习一样也无需人工干预,所不同的是,直推式学习假设无标签的数据就是最终要用来测试的数据,学习的目的就是在这些数据上取得最佳泛化能力.相对应地,半监督学习在学习时并不知道最终的测试用例是什么.因此,半监督学习考虑的是一个“开放的世界”,即在学习中不知道测试样本是什么,而直推式学习考虑的则是一个“封闭世界”,要测试的样本数据已参与到学习过程中.如果抛开是否对未知样本进行预测,直推式学习可以归结为半监督学习的一种特例.主动学习与半监督学习、直推式学习最大的区别在于它的学习过程需要人工干预,就是在学习过程中通过反馈尽可能地找到那些包含信息量大的样本来辅助少量有标签样本的学习.在传统机器学习中,这3种方法已经得到了广泛应用[39-44].多视角学习(multi-view learning)也是半监督学习一个很重要的学习任务.Yarowsky[45]和Blum等人[46]认为数据的多视角表示方式可以提高半监督分类学习算法的性能.更进一步地,文献[47-49]用PAC(probability approximately correct)理论分析了联合训练(co-training)在无标签数据上错误率的上界.

近年来也有很多研究者把这些技术应用到迁移学习领域.文献[22]对主动迁移学习模型进行了研究.Shi等人[50]提出了一种跨领域的主动迁移学习方法,通过似然偏置的大小来选择领域外(out-of domain)有标签的样本.那些能够正确预测领域内(in-domain)数据且高似然偏置的有标签样本被利用,而那些低偏置的样本则通过主动学习进行选择.Liao等人[6]提出了一种方法,即估计源领域中的每个样本与目标领域中少量标签数据之间的不匹配程度,并把该信息应用到逻辑回归中.Zhuang等人[17]综合半监督学习的3种正则化技术,流形正则化[51]、熵正则化[52]以及期望正则化[53],提出基于混合正则化的迁移学习方法.该方法首先从源领域训练得到一个分类器,然后通过混合正则化在目标领域数据上进行优化.

自学习(self-taught learning)[24,54]也是一种利用大量无标签数据来提高给定分类聚类任务性能的方法,自学习被应用于迁移学习中,因为它不要求无标签数据的分布与目标领域中的数据分布相同.Raina等人[54]提出了一种自学习的方法,它利用稀疏编码技术对无标签的样本数据构造高层特征,然后少量有标签的数据以及目标领域无标签的样本数据都由这些简洁的高层特征表示.实验结果表明,这种方法可以极大地提高分类任务的准确率.

庄福振等:迁移学习研究进展29

1.2.2 基于特征选择方法

基于特征选择的迁移学习方法是识别出源领域与目标领域中共有的特征表示,然后利用这些特征进行知识迁移[4,55,56].Jiang等人[55]认为,与样本类别高度相关的那些特征应该在训练得到的模型中被赋予更高的权重,因此他们在领域适应问题中提出了一种两阶段的特征选择框架.第1阶段首先选出所有领域(包括源领域和目标领域)共有的特征来训练一个通用的分类器;然后从目标领域无标签样本中选择特有特征来对通用分类器进行精化从而得到适合于目标领域数据的分类器.Dai等人[4]提出了一种基于联合聚类(co-clustering)的预测领域外文档的分类方法CoCC,该方法通过对类别和特征进行同步聚类,实现知识与类别标签的迁移.CoCC算法的关键思想是识别出领域内(也称为目标领域)与领域外(也称为源领域)数据共有的部分,即共有的词特征.然后类别信息以及知识通过这些共有的词特征从源领域传到目标领域.Fang等人[57]利用迁移学习对跨网络中的协作分类进行研究,试图从源网络将共同的隐性结构特征迁移到目标网络.该算法通过构造源网络和目标网络的标签传播矩阵来发现这些隐性特征.Wei等人[23]提出一种借用长文本帮助短文本分类的迁移学习方法.他们首先把目标领域数据中的Tag作为关键词从搜索引擎检索最相关的网页,然后利用隐性语义分析方法抽取语义关键词.第三,建立无向图,Tag作为节点,通过拉普拉斯特征映射,每个节点被表示到低维空间.这样,短文本可以转化为新的特征表示.最后通过最小化样本与特征表示之间的互信息,可以得到正确的短文本分类器.

1.2.3 基于特征映射方法

基于特征映射的迁移学习方法是把各个领域的数据从原始高维特征空间映射到低维特征空间,在该低维空间下,源领域数据与目标领域数据拥有相同的分布[3,58-61].这样就可以利用低维空间表示的有标签的源领域样本数据训练分类器,对目标测试数据进行预测.该方法与特征选择的区别在于,这些映射得到的特征不在原始的特征当中,是全新的特征.

Pan等人[58]提出了一种新的维度降低迁移学习方法,他通过最小化源领域数据与目标领域数据在隐性语义空间上的最大均值偏差(maximun mean discrepancy),从而求解得到降维后的特征空间.在该隐性空间上,不同的领域具有相同或者非常接近的数据分布,因此就可以直接利用监督学习算法训练模型对目标领域数据进行预测.Gu等人[62]探讨了多个聚类任务的学习(这些聚类任务是相关的),提出了一种寻找共享特征子空间的框架.在该子空间中,各个领域的数据共享聚类中心,而且他们还把该框架推广到直推式迁移分类学习.Blitzer等人[3]提出了一种结构对应学习算法(structural corresponding learning,简称SCL),该算法把领域特有的特征映射到所有领域共享的“轴”特征,然后就在这个“轴”特征下进行训练学习.SCL算法已被用到词性标注[3]以及情感分析[63]中.类似的工作还有文献[64]等.

Kan等人[65]提出一种新的目标化源领域数据的领域适应性方法,用于人脸识别.该方法首先将目标领域数据和源领域数据映射到一个共享的子空间,在该子空间中,源领域数据由目标领域数据线性表示,而且保持稀疏重构特性以及领域本身的结构.当求出线性表示系数以后,源领域数据可以由目标领域数据重新线性表示,最后利用监督模型进行学习分类.Shao等人[66]讨论一种迁移学习方法用于视觉分类,该方法映射源领域和目标领域数据到一个泛化子空间,其中目标领域数据可以被表示为一些源数据的组合.通过在迁移过程中加入低秩约束,来保持源领域和目标领域的结构.Yeh等人[67]提出一种新的领域适应性方法以解决跨领域模式识别问题.他们使用典型相关分析方法(CCA)得到相关子空间作为所有领域数据的联合表示,并提出核典型相关分析方法(KCCA)以处理非线性相关子空间的情况.特别地,他们提出一种新的带有相关性正则化的支持向量机方法,可以在分类器设计中加入领域适应性能力,从而进行领域适应性模式分类.Wang等人[68]挖掘词特征上的概念进行知识迁移,用于跨语言网页分类.他们的工作基于以下观测:不同领域可能采用不同的词特征来表示同一个概念,那么就可以利用独立于领域的概念作为知识迁移的桥梁.Long等人[69]进一步提出双重迁移学习方法,进一步考虑词特征概念的分类,分成两种不同的概念,即不同领域采用不同词特征的概念和不同领域也采用相同词特征的概念.

1.2.4 基于权重方法

在迁移学习中,有标签的源领域数据的分布与无标签的目标领域数据的分布是不一样的,因此那些有标签

30 Journal of Software 软件学报 V ol.26, No.1, January 2015 的样本数据并不一定是全部有用的.如何侧重选择那些对目标领域分类有利的训练样本?这就是基于实例的迁移学习所要解决的问题.基于实例的迁移学习通过度量有标签的训练样本与无标签的测试样本之间的相似度来重新分配源领域中样本的采样权重.相似度大的,即对训练目标模型有利的训练样本被加大权重,否则权重被削弱.Jiang 等人[26]提出了一种实例权重框架来解决自然语言处理任务下的领域适应问题.他们首先从分布的角度分析了产生领域适应问题的原因,主要有两方面:实例的不同分布以及分类函数的不同分布.因此他们提出了一个最小化分布差异性的风险函数,来解决领域适应性问题.Dai 等人[12]将Boosting 学习算法扩展到迁移学习中,提出了TrAdaBoost 算法.在每次迭代中改变样本被采样的权重,即在迭代中源领域中的样本权重被减弱,而有利于模型训练的目标领域中的样本权重被加强.他们还利用PAC 理论分析证明了该算法的有效性.下面简要介绍TrAdaBoost 算法.

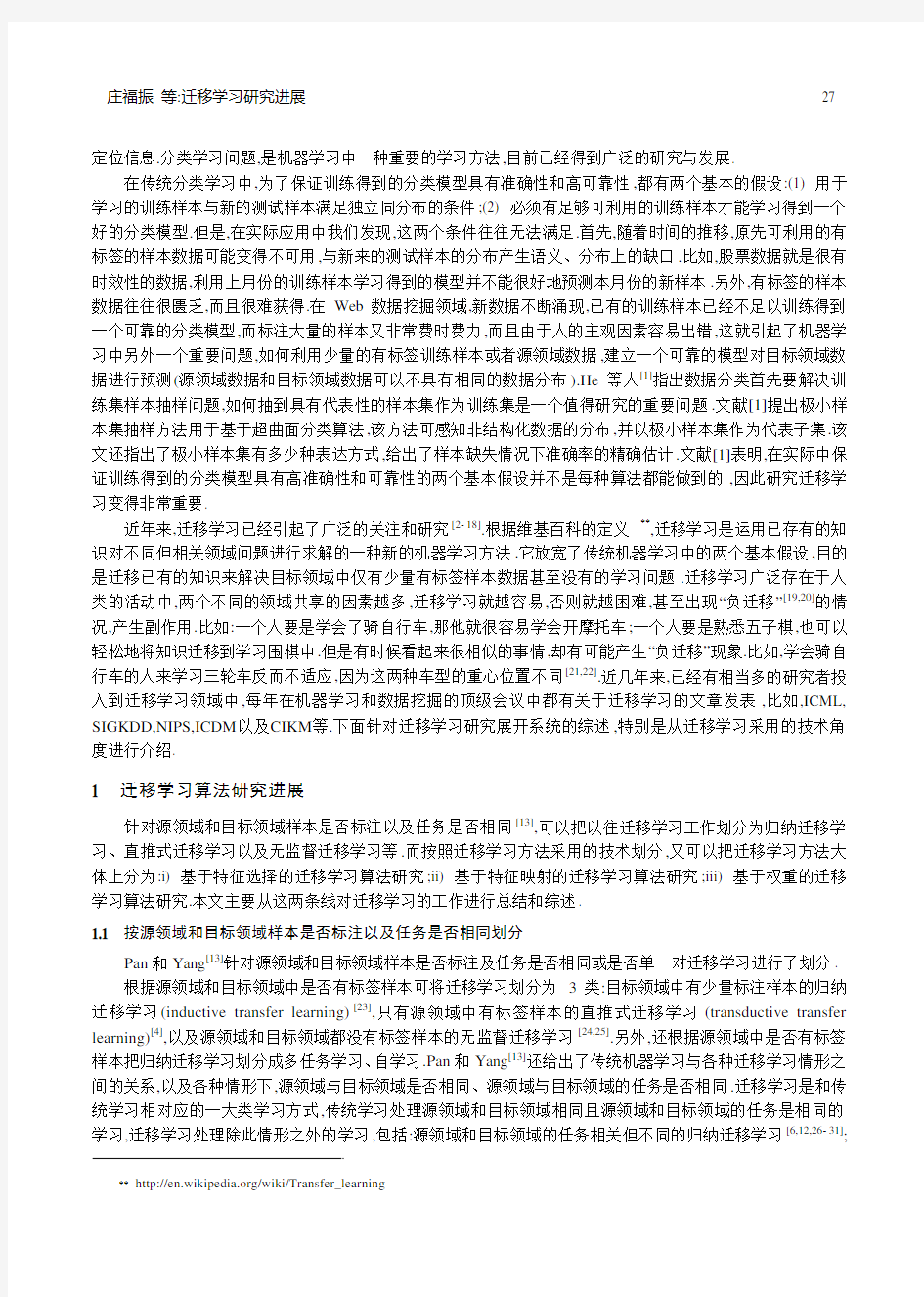

用于迁移学习任务中的源领域数据与目标领域数据虽然分布不同,但却是相关的.也就是说,辅助的源领域中的训练样本存在一部分比较适合用来学习一个有效的分类模型,并且对目标测试样本是适用的.于是TrAdaBoost 算法的目标就是从辅助的源数据中找出那些适合测试数据的实例,并把这些实例迁移到目标领域中少量有标签样本的学习中去.该算法的关键思想是利用Boosting 的技术过滤掉源领域数据中那些与目标领域中少量有标签样本最不像的样本数据.其中,Boosting 技术用来建立一种自动调整权重机制,于是重要的源领域样本数据权重增加,不重要的源领域样本数据权重减小.在TrAdaBoost 中,AdaBoost [70]被用在目标领域中少量有标签的样本中,以保证分类模型在目标领域数据上的准确性;而Hedge(β)[70]被用在源领域数据上,用于自动调节源领域数据的重要度.一个直观TrAdaBoost 的例子如图1所示.另外,对参数加权组合的工作,如文献[71].

分类学习是非常困难的

带圆圈的“+”和“-”),则可能可以

根据辅助数据估计出分类面分类结果,

例如图中虚线圆圈的“-”就被分错源训练数据的权重,同时减小误分类的目标训练数据的权重,使得分类面朝

正确的方向移动

Fig.1 An intuitive example about the idea of TrAdaBoost [12]

图1 关于TrAdaBoost 算法思想的一个直观示例[12]

根据是否从多个源领域数据学习,迁移学习算法又可以分为单个源领域以及多个源领域的迁移学习. Ben-David 等人[2]分析了领域数据的表示,并提出了一个很好的模型,该模型不仅最小化分类模型在训练数据上的泛化误差,而且最小化源领域与目标领域之间的不同性.Ling 等人[72]提出了一种新的光谱分类算法,该算法通

庄福振等:迁移学习研究进展31

过优化一个目标函数来寻找源领域中的监督信息与目标领域的本质结构之间的最大一致性.Zhuang等人[17]综合半监督学习中的几种正则化准则,提出了基于混合正则化准则的迁移学习框架.Mahmud等人[53,73]从算法信息论的角度来研究迁移学习,该方法度量了不同任务之间的相关性,然后决定多少信息可以做迁移以及如何迁移这些信息.Xing等人[7]提出了一种直推式迁移学习方法,该方法首先开发利用所有数据集(包括源领域数据和目标领域数据)上的几何分布结构,然后再利用目标领域上的流形结构.针对多源领域学习问题,Gao等人[74]提出了一种多模型局部结构映射方案,实际上是对不同源领域训练得到的模型赋予不同的投票权重,而该权重是由预测样本本身的局部分布结构决定的.Gao等人[75]解决了不同模型的一致性问题.这两个多源领域学习的工作很好地处理了多个模型的集成问题.为了更加深入地挖掘、开发各个源领域数据的内部结构或者数据分布,Luo和Zhuang等人[14,18]提出了一致性正则化框架,在这个框架下,局部的子分类器不仅考虑了在源领域上的可利用的局部数据,而且考虑了这些由源领域知识得到的子分类器在目标领域上的预测的一致性.Duan等人[15]将由源领域训练得到的模型作为辅助分类器.

2 迁移学习相关理论研究

从理论层面上看,迁移学习问题研究以下问题:第一,什么条件下从源领域数据训练出的分类器能够在目标领域表现出优异的分类性能,即什么条件下可进行迁移?第二,给定无标注目标领域,或者有少量的标记数据,如何在训练过程中与大量有标记的源数据结合使得测试时的误差最小,即迁移学习算法的研究.目前对迁移学习理论研究比较多的主要是在领域适应性方面.

关于领域适应性问题的理论分析最早是在文献[2]中提出的.该文基于VC维对领域适应性问题给出了推广性的界.该文最有价值的贡献在于定义了分布之间的距离,此距离与领域适应性有关.在此基础上,对有限VC 维情况,可用文献[76]中提出的方法,从有限个样本估计适应推广能力.但当VC维不是有限的情况下会有什么样的结论该文并未给出研究,需要进一步探讨.另外,不同的领域分布之间的距离会得出不同精度的误差估计,由此可以通过研究各具特色的距离以解决领域适应性问题,从而适应不同应用场合的需要.Ben-David还通过实验指出SCL(structural correspondence learning)[3]方法确实能够达到在A距离最小的同时间隔损失最低,从而提高目标领域上的学习性能.Ben-David等人[2]分析了领域数据的表示,并提出了一个很好的模型,该模型不仅最小化分类模型在训练数据上的泛化误差,而且最小化源领域与目标领域之间的不同性.这项工作后续研究的阶段性成果发表在文献[36],该文从源数据加权组合获得模型,并给出在特定的经验风险最小化的情形下的误差率.最新的成果发表在2010年的MACHINE LEARNING杂志上[77].该文研究了在什么条件下一个分类器能在目标领域很好地完成分类任务,还研究了给定目标领域少量的已标注的样本,如何在训练过程中把它们与大量的已标注的源数据相结合,以实现目标误差最小.

Mansour指出,对任意给定的目标函数,存在一个对源假设的领域加权分布组合使得损失至多为给定的值[78].他还对于任意的目标分布,给出了基于源领域和目标领域之间的Rényi散度的领域推广误差[79].更为精确的推广误差上界估计应用到回归和一般的损益函数,并提出通过加权实现经验分布能够更好地反映目标领域分布[80].文献[81]提出一种新的框架来分析典型的领域适应性类型学习过程的理论性质,即将多个源领域和单个目标领域的学习问题结合考虑.该文使用积分概率度量来测量两个域的分布之间的差异,同时与H-散度和差异距离进行了比较.并且,针对多领域分别开发了Hoeffding型、Bennett和McMiarmid型偏差不等式,然后给出了对称不等式.接下来,又利用以上不等式分别获得基于统一熵数的Hoeffding型和Bennett型泛化边界.此外,文献[81]还提出了一种基于Rademacher复杂度的泛化边界.最后,分析了渐近收敛性和学习过程的收敛速度.尽管已经进行了一些理论尝试,但还远远不够,对迁移学习有效性的理论研究还有待进一步深入.

下面介绍我们利用生成模型在迁移学习方面所做的工作.

3 基于生成模型的迁移学习方法

目前很多迁移学习算法都是基于判别模型的学习算法[13,58-60],判别算法是根据给定源领域数据X,直接训

32 Journal of Software软件学报V ol.26, No.1, January 2015

练得到判别模型P(Y|X).由于源领域与目标领域数据分布不一致,判别模型未考虑联合概率P(X,Y),因此有时不能得到很好的预测结果.区别于判别模型,生成模型先计算得到联合概率P(X,Y),然后再计算P(Y|X).这样,生成模型提供了一种很好的机制,可对源领域和目标领域数据不同分布进行建模,从而实现源领域与目标领域之间的知识迁移以提高算法的性能[68,82-84].文献[82]还对为什么采用生成模型进行迁移学习算法研究进行了讨论.由于生成模型对联合概率进行建模,具有更强的领域间不同数据分布的建模能力,所以更适合于迁移学习.

在迁移学习文本分类中,源领域数据与目标领域数据在原始词特征上分布不一致,也就是说,它们可能会采用不同的词特征来表示同一个语义概念.但我们发现,不同的领域数据,其词特征聚类(又称词特征概念)与文档类别(又称文档聚类、文档概念)之间的关联关系可能是一样的.比如,表示词特征概念“Computer Science”的词有‘hardware’,‘software’,‘program’,‘programmer’,‘disks’以及‘rom’等,但是这些词在不同的领域中可能频率相差很大.在关于硬件公司的新闻网页中,‘hardware’,‘disks’以及‘rom’可能是高频词.相反地,在关于软件公司的新闻网页中,‘software’,‘program’,以及‘programmer’更可能是高频词.因此不同的领域表示同一个概念的词特征差异很大,这就会导致用原始特征训练得到的分类器可能是不可靠的.如果我们能够找出各个领域的词特征概念,并用它们来预测样本的类别,那么就会比直接用原始特征要更可靠和有效.

从上面的例子可以看出,一个网页无论来自于哪一个领域,只要其包含特征概念“Computer Science”,那么该网页就是属于计算机相关的文档类.我们把表示词特征概念的词,定义为词概念外延,把词特征概念与文档类别之间的关系定义为词概念内涵,文档类别中包含的具体文档定义为文档类别外延.Zhuang等人[82]研究基于生成模型的挖掘多领域之间共性与特性的跨领域分类方法,对有效挖掘词特征聚类与文档类别关联关系进行了深入研究.其主要思想如图2所示,图中y表示词特种概念,z表示文档类别(或文档聚类),c表示领域标签,w和d 分别表示词和文档.

Distinction

Fig.2 The commonatity and distinction among different domains

图2 不同领域之间的共性和特性

庄福振等:迁移学习研究进展33

图2中,每个大矩形框中又包含两个小的矩形框,分别为各个领域词特征概念的外延和文档概念的外延.领域的特性包括所有的外延,而领域的共性则是它们共享的词特征概念与文档概念之间的联合概率分布,如图中的八边形所示.实际上,源领域中的数据是有标记的,即源领域中文档概念的外延已知,可以作为整个模型的监督信息,如图中的实心圆圈所示.这些监督信息通过领域之间的共性实现知识的迁移,领域的共性起到桥的作用,最后实现对目标领域数据的分类预测.实验结果表明,该算法具有较强的迁移学习能力,可以处理迁移学习比较难的分类问题.

表1给出了该算法挖掘出来的词特征概念的部分结果,可以看到,词特征概念“Space Science”在不同的领域中采用不同的关键词进行表示.他们还对基于判别模型和基于生成模型的迁移学习算法进行了初步的探讨,认为基于生成模型的方法可以有效地对源领域与目标领域之间的不同性进行建模,可能更适合做迁移学习.

以往的工作[68,82]假设源领域和目标领域共享相同的概念集,但是除了共享概念以外,不同领域可能还包含自己独特的概念.Zhuang等人[84]对不同领域的概念进行了深入的分析,把概念分成3类:一致性概念、相似概念以及领域特有的概念.他们提出了一般的概率统计模型来挖掘这3种概念,并开发了一种EM算法进行求解.大量的实验结果表明,所提出的模型优于所比较的迁移学习算法.

Table 1 The word concepts output by the proposed method in Ref.[82]

表1文献[82]提出方法挖掘的词特征概念

Associated with concept: space science Domain 1

rocket, esa, assist, frank, af, thu, helsinki, ron, atlantic, jet, observer, satellite, venus, sei,

min, ir, russia, stars, star, ray

Domain 2

relay, km, rat, pixel, command, elements, arc, acceleration, nasa, earth, fuse, ground,

bulletin, pub, anonymous, faq, unix, cit, ir, amplifier

Domain 3

from, earth, science, word, pictures, years, center, data, national, dale, nasa, gif, reports,

mil, planet, field, jpl, ron, smith, unix

Domain 4

service, archive, unit, magnetic, thousands, technology, information, arc, keys, faq,

probes, ir, available, gov, embedded, tens, data, system, unix, mil

Associated with concept: computer

science Domain 1

hardware, engines, ibm, project, soviet, software, program

Domain 2

legally, schemes, protected, bytes, mq, disks, patch, registers, machine, pirates, install,

card, rom, screen, protection, disk, ram, tape, mb, copy

Domain 3

discomfort, friend, normal, self, tests, programmer, steve, state, program, lab, you, your,

jon, my, headache, trial, she, pain, page, trials

Domain 4

wcs, cipher, scheme, brute, user, file, encryption, message, serial, decryption, crypto, keys,

cryptosystems, skipjack, plaintext, secure, key, encrypted, nsa, des

Associated with concept:

car Domain 1

saves, power, was, at, disappointment, al, europeans, will, ny, north, their, they, deal, best,

year, sports, cs, new, series, gm

Domain 2

paint, ride, buying, bmw, engine, car, Honda

Domain 3

or, value, they, wade, good, car, better, best, three, performance, more, runner, than,

average, dl, extra, base, cs, al, year

Domain 4

dealer, camry, saab, engine, eliot, requests, mazda, liter, mustang, diesel, wagon, nissan,

mileage, byte, saturn, toyota, si, cars, car, db

*Domain 1:rec.sport.hockey vs. sci.space, Domain 2: rec.motorcycles vs. sci.electronics

Domain 3:rec.sport.baseball vs. sci.med, Domain 4: rec.autos vs. sci.crypt

4 迁移学习应用研究

目前,迁移学习典型的应用方面的研究主要包含有文本分类、文本聚类、情感分类、图像分类、协同过滤、基于传感器的定位估计、人工智能规划等.

在文本处理领域已有大量的迁移学习工作[4,5,18,24,56,62,69,83,85].Dai等人[4]提出联合聚类方法,同时对文档以及词特征进行聚类,通过不同领域共享相同的词特征进行知识迁移.他们还提出迁移贝叶斯分类器[5],首先估计源领域数据的数据分布,然后不断修正使其适应于目标领域数据.Zhuang等人[56]在概念层面上对文本进行处理,提出挖掘文档概念与词特征概念的迁移学习方法.在此基础上Long等人[69]提出了双重迁移模型,进一步对概念进行划分,提高算法分类准确率.Gu等人[62]提出共享子空间的多任务聚类方法,并应用于迁移分类中.文献[63,86,87]等对情感分类进行了研究,Li等人[86]利用独立于领域的带有情感倾向的词先验以及领域相关的无标签数据,来提高情感分类的准确率.Pan等人[87]提出一种新的谱特征对齐方法,以独立于领域的词特征为桥梁,把

34 Journal of Software软件学报V ol.26, No.1, January 2015

来自不同领域的领域特有词特征对齐到一个聚类中.这样,这些聚类可以降低领域特有的词的缺口,从而提高目标领域上的准确率.

在图像处理方面,Dai等人[16]提出一种翻译迁移学习方法,借助文本数据来辅助图像聚类.Raina等人[54]提出一种新的从无标签数据进行自学习的方法,该方法利用系数编码技术从大量的无标签数据上构造高层特征,以提高图像分类性能.Zhu等人[88]研究了一种异构迁移学习方法,利用图像上的Tag标签信息作为文本与图像之间知识迁移的桥梁,从而提高图像数据上的分类效果.在图像分类方面的工作还有文献[59]等.

在协同过滤方面的工作有文献[75,89-92]等,Wang等人提出特征子空间的迁移学习方法来克服协同过滤中的稀疏问题,即从辅助数据中学习得到的用户特征子空间被迁移到目标领域中.Pan等人[90]研究了协同过滤中带有不确定评分的迁移学习算法,即在优化目标矩阵分解中考虑不确定评分的辅助数据作为限制.Cao等人[92]提出基于项目潜在特征共享策略的链接预测模型,性能上比单个任务的学习有所提升.

香港科技大学Qiang Yang实验室还做了一系列的室内定位的迁移学习方面的工作[13,58,93].Wang等人[93]的工作基于这样的观测,即使不同楼层的信号差别非常大,但是不同楼层的设计是相似的,因此可以把不同楼层的数据嵌入到一些共同的低维流形,这样可以通过这些流形把标签从标记样本传播到无标记样本.Zheng等人[94]提出一种新的多任务学习,对室内定位系统的多个设备进行同时学习,并假设各个设备在隐性空间上的假设是相似的.另外,在智能规划方面,Zhou等人[95]提出一种新的迁移学习框架TRAMP,将迁移学习用于人工智能规划中的动作模型获取.该方法首先建立源领域与目标领域之间的结构映射来迁移知识,然后从Web搜索中开发额外的知识来从源领域中连接和迁移知识.在排序以及度量学习方面的工作有文献[61,96,97]等.传统的视觉重排序已经不能很好地提高基于文本的视频搜索,因为低层次的视觉特征与高层次的语义概念有很大的缺口.Tian 等人[61]提出一种新的维度降低工具,可以有效地编码用户的标记信息(标记信息由交互得到)来提高检索结果.Geng等人[97]介绍了一种领域适应性度量学习方法.在可再生核希尔伯特空间中,该方法在常规度量学习中引入依赖于数据的正则化项,来解决源领域与目标领域之间的分布不同性.

总之,越来越多的迁移学习工作被应用到各种应用中,也在研究上取得了非常显著的效果.但在目前大数据背景下,已有的算法还不能满足实际的应用需求,处理的数据量还比较小,而且算法复杂度也比较高.下一步的研究应更关注于高效算法的设计上,以做到确实满足实际需要.

5 未来研究方向

本文系统地给出了迁移学习算法以及相关理论的研究进展状况.迁移学习作为一个新兴的研究领域,还很年轻,主要研究仍集中在算法方面,因此值得我们进一步展开和深入.

迁移学习最早来源于教育心理学,这里借用美国心理学家Judd***提出的“类化说”学习迁移理论来讨论目前机器学习领域迁移学习研究还存在的3个问题.首先,Judd认为在先期学习A中获得的东西,之所以能迁移到后期学习B中,是因为在学习A时获得了一般原理,这种原理可以部分或全部运用于A,B之中.根据这一理论,两个学习活动之间存在的共同要素,是产生迁移的必要前提.这也就是说,想从源领域中学习知识并运用到目标领域中,必须保证源领域与目标领域有共同的知识,那么如何度量这两个领域的相似性与共同性,是问题之一.第二,Judd的研究表明,知识的迁移是存在的,只要一个人对他的经验、知识进行了概括,那么从一种情境到另一种情境的迁移是可能的.知识概括化的水平越高,迁移的范围和可能性越大.把该原则运用到课堂上,同样的教材采用不同的教学方法,产生的迁移效果是不一样的,即可能产生积极迁移也可能产生相反的作用.即同样的教材内容,由于教学方法不同,而使教学效果大为悬殊,迁移的效应也大不相同.所以针对不同的学习问题,研究有效的迁移学习算法也是另一个重要问题.第三,根据Judd的泛化理论,重要的是在讲授教材时要鼓励学生对核心的基本概念进行抽象或概括.抽象与概括的学习方法是最重要的方法,在学习时对知识进行思维加工,区别本质的和非本质的属性,偶然的和必然的联系,舍弃那些偶然的、非本质的东西,牢牢把握那些必然的本质的东西.这种

*** https://www.360docs.net/doc/1c18404856.html,/subview/226455/11107073.htm

庄福振等:迁移学习研究进展35

学习方法能使学生的认识从低级的感性阶段上升到高级的理性阶段,从而实现更广泛、更成功的正向迁移.也就是说在迁移学习的过程中,应该避免把非本质的、偶然的知识,当成本质的(领域共享的)、必然的知识,实现正迁移.所以,如何实现正迁移,避免负迁移也是迁移学习的一个重要研究问题.

针对以上讨论分析,我们认为后续研究有以下几个可能的方向.第一,针对领域相似性、共同性的度量,目前还没有深入的研究成果,那么首要任务就是研究准确的度量方法.第二,在算法研究方面,不同的应用,迁移学习算法的需求有所不同.目前很多研究工作主要集中在迁移学习分类算法方面,其他方面的应用算法有待进一步研究,比如情感分类、强化学习、排序学习、度量学习,人工智能规划等.第三,关于迁移学习算法有效性的理论研究还很缺乏,研究可迁移学习条件,获取实现正迁移的本质属性,避免负迁移,也是方向之一.最后,在大数据环境下,研究高效的迁移学习算法尤为重要.目前的研究主要仍集中在研究领域,数据量小而且测试数据非常标准,应把研究的算法瞄准实际应用数据,以顺应目前大数据挖掘研究浪潮.

References:

[1] He Q, Zhao XR, Shi ZZ. Minimal consistent subset for hyper surface classification method. Int’l Journal of Pattern Recognition and

Artificial Intelligence, 2008,22(1):95-108. [doi: 10.1142/S0218001408006132]

[2] Ben-David S, Blitzer J, Crammer K, Pereira F. Analysis of representations for domain adaptation. In: Platt JC, Koller D, Singer Y,

Roweis ST, eds. Proc. of the Advances in Neural Information Processing Systems 19. Cambridge: MIT Press, 2007. 137-144. [3] Blitzer J, McDonald R, Pereira F. Domain adaptation with structural correspondence learning. In: Jurafsky D, Gaussier E, eds. Proc.

of the Int’l Conf. on Empirical Methods in Natural Language Processing. Stroudsburg PA: ACL, 2006. 120-128.

[4] Dai WY, Xue GR, Yang Q, Yu Y. Co-Clustering based classification for out-of-domain documents. In: Proc. of the 13th ACM Int’l

Conf. on Knowledge Discovery and Data Mining. New York: ACM Press, 2007. 210-219. [doi: 10.1145/1281192.1281218]

[5] Dai WY, Xue GR, Yang Q, Yu Y. Transferring naive Bayes classifiers for text classification. In: Proc. of the 22nd Conf. on

Artificial Intelligence. AAAI Press, 2007. 540-545.

[6] Liao XJ, Xue Y, Carin L. Logistic regression with an auxiliary data source. In: Proc. of the 22nd Int’l Conf. on Machine Learning.

San Francisco: Morgan Kaufmann Publishers, 2005. 505-512. [doi: 10.1145/1102351.1102415]

[7] Xing DK, Dai WY, Xue GR, Yu Y. Bridged refinement for transfer learning. In: Proc. of the 11th European Conf. on Practice of

Knowledge Discovery in Databases. Berlin: Springer-Verlag, 2007. 324-335. [doi: 10.1007/978-3-540-74976-9_31]

[8] Mahmud MMH. On universal transfer learning. In: Proc. of the 18th Int’l Conf. on Algorithmic Learning Theory. Sendai, 2007.

135-149. [doi: 10.1007/978-3-540-75225-7_14]

[9] Samarth S, Sylvian R. Cross domain knowledge transfer using structured representations. In: Proc. of the 21st Conf. on Artificial

Intelligence. AAAI Press, 2006. 506-511.

[10] B el N, Koster CHA, Villegas M. Cross-Lingual text categorization. In: Proc. of the European Conf. on Digital Libraries. Berlin:

Springer-Verlag, 2003. 126-139. [doi: 10.1007/978-3-540-45175-4_13]

[11] Zhai CX, Velivelli A, Yu B. A cross-collection mixture model for comparative text mining. In: Proc. of the 10th ACM SIGKDD

Int’l Conf. on Knowledge Discovery and Data Mining. New York: ACM, 2004. 743-748. [doi: 10.1145/1014052.1014150]

[12] Dai WY, Yang Q, Xue GR, Yu Y. Boosting for transfer learning. In: Proc. of the 24th Int’l Conf. on Machine Learning. San

Francisco: Morgan Kaufmann Publishers, 2007. 193-200. [doi: 10.1145/1273496.1273521]

[13] Pan SJ, Yang Q. A survey on transfer learning. IEEE Trans. on Data Engineering, 2010,22(10):1345-1359. [doi: 10.1109/TKDE.

2009.191]

[14] Luo P, Zhuang FZ, Xiong H, Xiong YH, He Q. Transfer learning from multiple source domains via consensus regularization. In:

Proc. of the 17th ACM Conf. on Information and Knowledge Management. New York: ACM Press, 2008. 103-112. [doi: 10.1145/ 1458082.1458099]

[15] Duan LX, Tsang IW, Xu D, Chua TS. Domain adaptation from multiple sources via auxiliary classifiers. In: Proc. of the 26th

Annual Int’l Conf. on Machine Learning. New York: ACM, 2009. 289-296. [doi: 10.1145/1553374.1553411]

[16] Dai WY, Chen YQ, Xue GR, Yang Q, Yu Y. Translated learning: Transfer learning across different feature spaces. In: Koller D,

Schuurmans D, Bengio Y, Bottou L, eds. Proc. of the Advances in Neural Information Processing Systems 20. Cambridge: MIT Press, 2008. 353-360.

36 Journal of Software软件学报V ol.26, No.1, January 2015

[17] Z huang FZ, Luo P, He Q, Shi ZZ. Inductive transfer learning for unlabeled target-domain via hybrid regularization. Chinese

Science Bulletin, 2009,54(14):2470-2478. [doi: 10.1007/s11434-009-0171-x]

[18] Z huang FZ, Luo P, Xiong H, Xiong YH, He Q, Shi ZZ. Cross-Domain learning from multiple sources: A consensus regularization

perspective. IEEE Trans. on Knowledge And Data Engineering, 2010,22(12):1664-1678. [doi: 10.1109/TKDE.2009.205]

[19] R osenstein MT, Marx Z, Kaelbling LP. To transfer or not to transfer. In: Proc. of the Neural Information Processing Systems 2005

Workshop on Inductive Transfer: 10 Years Later. Cambridge: MIT Press, 2005.

[20] D ai WY, Jin O, Xue GR, Yang Q, Yu Y. Eigen transfer: A unified framework for transfer learning. In: Proc. of the 24th Int’l Conf.

on Machine Learning. San Francisco: Morgan Kaufmann Publishers, 2009. 193-200. [doi: 10.1145/1553374.1553399]

[21] Dai WY. Instance-Based and feature-based transfer learning [MS. Thesis]. Shanghai: Shanghai Jiaotong University, 2008. 1-55 (in

Chinese with English abstract).

[22] S hi XX. Research and application of active transfer learning models [MS. Thesis]. Guangzhou: Sun Yat-Sen University, 2009.

1-69 (in Chinese with English abstract).

[23] W ei FM, Zhang JP, Chu Y, Yang J. FSFP: Transfer learning from long texts to the short. Applied Mathematics & Information

Sciences, 2014,8(4):2033-2044. [doi: 10.12785/amis/080462]

[24] Dai WY, Yang Q, Xue GR, Yu Y. Self-Taught clustering. In: Proc. of the 24th Int’l Conf. on Machine Learning. San Francisco:

Morgan Kaufmann Publishers, 2008. 200-207. [doi: 10.1145/1390156.1390182]

[25] Samanta S, Tirumarai SA, Das S. Cross-Domain clustering performed by transfer of knowledge across domains. In: Proc. of the

2013 IEEE 4th National Conf. on Computer Vision, Pattern Recognition, Image Processing and Graphics (NCVPRIPG). 2013. 1-4.

[doi: 10.1109/NCVPRIPG.2013.6776213]

[26] Jiang J, Zhai CX. Instance weighting for domain adaptation in NLP. In: Carroll JA, van den Bosch A, Zaenen A, eds. Proc. of the

45th Annual Meeting of the Association for Computational Linguistics. Stroudsburg PA: Association for Computational Linguistics, 2007. 264-271.

[27] Lee SI, Chatalbashev V, Vickrey D, Koller D. Learning a meta-level prior for feature relevance from multiple related tasks. In:

Proc. of the 24th Int’l Conf. on Machine Learning. New York: ACM, 2007. 489-496. [doi: 10.1145/1273496.1273558]

[28] W ang C, Mahadevan S. Manifold alignment using procrustes analysis. In: Proc. of the 25th Int’l Conf. on Machine Learning. New

York: ACM, 2008. 1120-1127. [doi: 10.1145/1390156.1390297]

[29] Lawrence ND, Platt JC. Learning to learn with the informative vector machine. In: Proc. of the 21st Int’l Conf. on Machine

Learning. New York: ACM, 2004. 65-72. [doi: 10.1145/1015330.1015382]

[30] S chwaighofer A, Tresp V, Yu K. Learning Gaussian process kernels via hierarchical Bayes. In: Proc. of the Advances in Neural

Information Processing Systems 17. Cambridge: MIT Press, 2005. 1209-1216.

[31] Evgeniou T, Pontil M. Regularized multi-task learning. In: Proc. of the 10th ACM SIGKDD Int’l Conf. on Knowledge Discovery

and Data Mining. New York: ACM, 2004. 109-117. [doi: 10.1145/1014052.1014067]

[32] Zadrozny B. Learning and evaluating classifiers under sample selection bias. In: Proc. of the 21st Int’l Conf. on Machine Learning.

New York: ACM, 2004. 114-121. [doi: 10.1145/1015330.1015425]

[33] Huang JY, Smola AJ, Gretton A, Borgwardt KM. Correcting sample selection bias by unlabeled data. In: Platt JC, Koller D, Singer

Y, Roweis ST, eds. Proc. of the Advances in Neural Information Processing Systems 19. Cambridge: MIT Press, 2007. 601-608. [34] Fan W, Davidson I, Zadrozny B, Yu PS. An improved categorization of classifier’s sensitivity on sample selection bias. In: Proc. of

the 5th Int’l Conf. on Data Mining. Los Vaqueros: IEEE Computer Society, 2005. 605-608. [doi: 10.1109/ICDM.2005.24]

[35] Ando RK, Zhang T. A high-performance semi-supervised learning method for text chunking. In: Proc. of the 43rd Annual Meeting

on Association for Computational Linguistics. Stroudsburg, 2005. 1-9. [doi: 10.3115/1219840.1219841]

[36] Blitzer J, Crammer K, Kulesza A, Pereira F, Wortman J. Learning bounds for domain adaptation. In: Koller D, Schuurmans D,

Bengio Y, Bottou L, eds. Proc. of the Advances in Neural Information Processing Systems 20. Cambridge: MIT Press, 2008.

129-136.

[37] Wang Z, Song YQ, Zhang CS. Transferred dimensionality reduction. In: Proc. of the European Conf. on Machine Learning and

Knowledge Discovery in Databases. Berlin, Heidelberg: Springer-Verlag, 2008. 550-565. [doi: 10.1007/978-3-540-87481-2_36] [38] Zhou ZH. Learning with unlabeled data and its application to image retrival. In: Proc. of the 9th Pacific Rim Int’l Conf. on

Artificial Intelligence. Berlin: Springer-Verlag, 2006. 5-10. [doi: 10.1007/978-3-540-36668-3_3]

[39] Zhu XJ. Semi-Supervised learning literature survey [Ph.D. Thesis]. Madison: Department of Computer Sciences, University of

Wisconsin, 2005.

庄福振等:迁移学习研究进展37

[40] Joachims T. Transductive inference for text classification using support vector machines. In: Buford JF, Stevens SM, Bulterman

DCA, Jeffay K, Zhang HJ, eds. Proc. of the 16th Int’l Conf. on Multimedia. Augsburg, New York: ACM Press, 1999. 200-209. [41] Joachims T. Transductive learning via spectral graph partitioning. In: Rowe LA, Vin HM, Plagemann T, Shenoy PJ, Smith JR, eds.

Proc. of the 16th Int’l Conf. on Multimedia. Augsburg, New York: ACM Press, 2003. 290-297.

[42] Tong S, Chang E. Support vector machine active learning for image retrieval. In: Proc. of the 9th ACM Int’l Conf. on Multimedia.

New York: ACM Press, 2001. 107-118. [doi: 10.1145/500141.500159]

[43] Cohn D, Atlas L, Ladner R. Improving generalization with active learning. Machine Learning, 1994,15(2):201-221.

[44] Sindhwani V, Niyogi P. A co-regularized approach to semi-supervised learning with multiple views. In: De Raedt L, Wrobel S, eds.

Proc. of the ICML Workshop on Learning with Multiple Views. San Francisco: Morgan Kaufmann Publishers, 2005. 74-79. [45] Yarowsky D. Unsupervised word sense disambiguation rivaling supervised methods. In: Proc. of the 33rd Annual Meeting on

Association for Computational Linguistics. Stroudsburg: Association for Computational Linguistics, 1995. 189-196. [doi: 10.3115/ 981658.981684]

[46] Blum MT. Combining labeled and unlabeled data with co-training. In: Bartlett PL, Mansour Y, eds. Proc. of the 11th Annual Conf.

on Computational Learning Theory. New York, 1998. 92-100.

[47] Dasgupta S, Littman ML, Mcalleste D. PAC generalization bounds for co-training. In: Proc. of the Advances in Neural Information

Processing Systems 13. Cambridge: MIT Press, 2001. 375-382.

[48] Abney A. Bootstrapping. In: Proc. of the 40th Annual Meeting of the Association for Computational Linguistics. Stroudsburg:

Association for Computational Linguistics, 2002. 360-367.

[49] Abney A. Understanding the Yarowsky algorithm. Journal of Computational Linguistics, 2004. 365-395. [doi: 10.1162/08912010

41850876]

[50] Shi XX, Fan W, Ren JT. Actively transfer domain knowledge. In: Proc. of the European Conf. on Machine Learning and

Knowledge Discovery in DataBases. Berlin: Springer-Verlag, 2008. 342-357. [doi: 10.1007/978-3-540-87481-2_23]

[51] Belkin M, Niyogi P, Sindhwani V. Manifold regularization: A geometric framework for learning from labeled and unlabeled

examples. Journal of Machine Learning Research, 2007,(7):2399-2434.

[52] Grandvalet Y, Bengio Y. Semi-Supervised learning by entropy minimization. In: Proc. of the Advances in Neural Information

Processing Systems 17. Cambridge: MIT Press, 2005. 529-536.

[53] Mann GS, McCallum A. Simple, robust, scalable semi-supervised learning via expectation regularization. In: Proc. of the 24th Int’l

Conf. on Machine Learning. San Francisco: Morgan Kaufmann Publishers, 2007. 593-600. [doi: 10.1145/1273496.1273571] [54] Raina R, Battle A, Lee H, Packer B, Ng AY. Self-Taught learning: Transfer learning from unlabeled data. In: Proc. of the 24th Int’l

Conf. on Machine Learning. San Francisco: Morgan Kaufmann Publishers, 2007. 759-766. [doi: 10.1145/1273496.1273592] [55] J iang J, Zhai CX. A two-stage approach to domain adaptation for statistical classifiers. In: Proc. of the 16th ACM Conf. on

Information and Knowledge Management. New York: ACM Press, 2007. 401-410. [doi: 10.1145/1321440.1321498]

[56] Z huang FZ, Luo P, Xiong H, He Q, Xiong YH. Exploiting associations between word clusters and document classes for

cross-domain text categorization. In: Proc. of the 10th SIAM Conf. on Data Ming. Philadelphia: SIAM Press, 2010. 13-24. [doi: 10.

1002/sam.10099]

[57] F ang M, Yin J, Zhu XQ. Transfer learning across networks for collective classification. In: Proc. of the 2013 IEEE 13th Int’l Conf.

on Data Mining. 2013. 161-170. [doi: 10.1109/ICDM.2013.116]

[58] Pan SJ, Kwok JT, Yang Q. Transfer learning via dimensionality reduction. In: Fox D, Gomes CP, eds. Proc. of the 23rd Conf. on

Artificial Intelligence. Chicago: AAAI Press, 2008. 677-682.

[59] S i S, Tao DC, Chan KP. Evolutionary cross-domain discriminative hessian eigenmaps. IEEE Trans. on Image Processing, 2010,

19(4):1075-1086. [doi: 10.1109/TIP.2009.2035867]

[60] Si S, Tao DC, Geng B. Bregman divergence-based regularization for transfer subspace learning. IEEE Trans. on Knowledge and

Data Engineering, 2010,22(7):919-942. [doi: 10.1109/TKDE.2009.126]

[61] Tian X, Tao D, Rui Y. Sparse transfer learning for interactive video search reranking. ACM Trans. on Multimedia Computing,

Communications, and Applications (TOMCCAP), 2012,8(3):26:1-19. [doi: 10.1145/2240136.2240139]

[62] Gu QQ, Zhou J. Learning the shared subspace for multi-task clustering and transductive transfer classification. In: Proc. of the 9th

Int’l Conf. on Data Mining. Los Vaqueros: IEEE Computer Society, 2009. 159-168. [doi: 10.1109/ICDM.2009.32]

38 Journal of Software软件学报V ol.26, No.1, January 2015

[63] Blitzer J, Dredze M, Pereira F. Biographies, Bollywood, Boom-boxes and Blenders: Domain adaptation for sentiment classification.

In: Carroll JA, van den Bosch A, Zaenen A, eds. Proc. of the 45th Annual Meeting of the Association for Computational Linguistics. Stroudsburg: ACL, 2007. 440-447.

[64] X ie SH, Fan W, Peng J, Verscheure O, Ren JT. Latent space domain transfer between high dimensional overlapping distributions.

In: Proc. of the ACM Conf. on World Wide Web. New York: ACM Press, 2009. 91-100. [doi: 10.1145/1526709.1526723]

[65] Kan MN, Wu JT, Shan SG, Chen XL. Domain adaptation for face recognition: Targetize source domain bridged by common

subspace. Int’l Journal of Computer Vision, 2013. 1-16. [doi: 10.1007/s11263-013-0693-1]

[66] Shao M, Kit D, Fu Y. Generalized transfer subspace learning through low-rank constraint. Int’l Journal of Computer Vision, 2014.

1-20. [doi: 10.1007/s11263-014-0696-6]

[67] Yeh Y, Huang C, Wang Y. Heterogeneous domain adaptation and classification by exploiting the correlation subspace. IEEE Trans.

on Image Processing, 2013. 2009-2018. [doi: 10.1109/TIP.2014.2310992]

[68] Wang H, Huang H, Nie FP, Ding C. Cross-Language Web page classification via dual knowledge transfer using nonnegative matrix

tri-factorization. In: Proc. of the 34th Int’l ACM SIGIR Conf. on Research and Development in Information Retrieval. ACM, 2011.

933-942. [doi: 10.1145/2009916.2010041]

[69] Long MS, Wang JM, Ding GG, Cheng W, Zhang X, Wang W. Dual transfer learning. In: Proc. of the SDM. California: SIAM,

2012. 540-551.

[70] F reund Y, Schapire RE. A decision-theoretic generalization of on-line learning and an application to boosting. Journal of Computer

and System Sciences, 1997,55(1):119-139. [doi: 10.1006/jcss.1997.1504]

[71] D redze M, Kulesza A, Crammer K. Multi-Domain learning by confidence-weighted parameter combination. Journal of Machine

Learning, 2010,79(1-2):123-149. [doi: 10.1007/s10994-010-5169-8]

[72] L ing X, Dai WY, Xue GR, Yang Q, Yu Y. Spectral domain-transfer learning. In: Proc. of 14th ACM Int’l Conf. on Knowledge

Discovery and Data Mining. New York: ACM Press, 2008. 488-496. [doi: 10.1145/1401890.1401951]

[73] M ahmud MMH, Ray S. Transfer learning using Kolmogorov complexity: Basic theory and empirical evaluations. In: Platt JC,

Koller D, Singer Y, Roweis ST, eds. Proc. of the Advances in Neural Information Processing Systems. Cambridge: MIT Press, 2007. 985-992.

[74] G ao J, Fan W, Jiang J, Han JW. Knowledge transfer via multiple model local structure mapping. In: Proc. of the 13th ACM Int’l

Conf. on Knowledge Discovery and Data Mining. New York: ACM Press, 2008. 283-291. [doi: 10.1145/1401890.1401928]

[75] G ao J, Fan W, Sun YZ, Han JW. Heterogeneous source consensus learning via decision propagation and negotiation. In: Proc. of

the 13th ACM Int’l Conf. on Knowledge Discovery and Data Mining. New York: ACM Press, 2009. 339-348. [doi: 10.1145/ 1557019.1557061]

[76] K ifer D, Ben-David S, Gehrke J. Detecting change in data streams. In: Nascimento MA, ?zsu MT, Kossmann D, Miller RJ,

Blakeley JA, Schiefer KB, eds. Proc. of the 30th Int’l Conf. on Very Large Data Bases. Toronto: VLDB Endowment, 2004.

180-191.

[77] B en-David S, Blitzer J, Crammer K, Kulesza A, Pereira F, Vaughan JW. A theory of learning from different domains. Journal of

Machine Learning, 2010,79(1-2):151-175. [doi: 10.1007/s10994-010-5169-8]

[78] Mansour Y, Mohri M, Rostamizadeh A. Domain adaptation with multiple sources. In: Koller D, Schuurmans D, Bengio Y, Bottou

L, eds. Proc. of the Advances in Neural Information Processing Systems 20. Cambridge: MIT Press, 2008. 1-8.

[79] Mansour Y, Mohri M, Rostamizadeh A. Multiple source adaptation and the Rényi divergence. In: Bilmes J, Ng AY, eds. Proc. of

the 25th Conf. on Uncertainty in Artificial Intelligence. Arlington: AUAI Press, 2009. 367-374.

[80] M ansour Y, Mohri M, Rostamizadeh A. Domain adaptation: Learning bounds and algorithms. In: Proc. of the 22nd Annual Conf.

on Learning Theory. San Francisco: Morgan Kaufmann Publishers, 2009.

[81] Z hang C, Zhang L, Fan W, Ye JP. Generalization bounds for representative domain adaptation. arXiv preprint arXiv: 1401.0376,

2014. 1-40.

[82] Zhuang FZ, Luo P, Shen ZY, He Q, Xiong YH, Shi ZZ, Xiong H. Collaborative DUAL-PLSA: Mining distinction and commonality

across multiple domains for text classification. In: Proc. of the 19th ACM Int’l Conf. on Information and Knowledge Management.

ACM, 2010. 359-368. [doi: 10.1145/1871437.1871486]

[83] Xue GR, Dai WY, Yang Q, Yu Y. Topic-Bridged PLSA for cross-domain text classification. In: Proc. of the 31st Annual Int’l

ACM SIGIR Conf. on Research and Development in Information Retrieval. New York: ACM, 2008. 627-634. [doi: 10.1145/ 1390334.1390441]

庄福振等:迁移学习研究进展39

[84] Zhuang FZ, Luo P, Yin PF, He Q, Shi ZZ. Concept learning for cross-domain text classification: A general probabilistic framework.

In: Rossi F, ed. Proc. of the 23rd Int’l Joint Conf. on Artificial Intelligence. AAAI Press, 2013. 1960-1966.

[85] Yang P, Gao W. Information-Theoretic multi-view domain adaptation: A theoretical and empirical study. Journal of Artificial

Intelligence Research, 2014,49:501-525.

[86] Li T, Zhang Y, Sindhwani V. A non-negative matrix tri-factorization approach to sentiment classification with lexical prior

knowledge. In: Su KY, Su J, Wiebe J, eds. Proc. of the Joint Conf. of the 47th Annual Meeting of the ACL and the 4th Int’l Joint Conf. on Natural Language Processing of the AFNLP. Singapore: Association for Computational Linguistics, 2009. 244-252. [87] Pan SJ, Ni X, Sun JT, Yang Q, Chen Z. Cross-Domain sentiment classification via spectral feature alignment. In: ACM Proc. of the

19th Int’l Conf. on World Wide Web. 2010. 751-760. [doi: 10.1145/1772690.1772767]

[88] Zhu Y, Chen Y, Lu Z, Pan SJ, Xue GR, Yu Y, Yang Q. Heterogeneous transfer learning for image classification. In: Burgard W,

Roth D, eds. Proc. of the AAAI. AAAI Press, 2011. 1304-1309.

[89] Wang J, Ke L. Feature subspace transfer for collaborative filtering. Neurocomputing, 2014,136:1-6. [doi: 10.1016/j.neucom.2014.

01.035]

[90] Pan W, Xiang EW, Yang Q. Transfer learning in collaborative filtering with uncertain ratings. In: Hoffmann J, Selman B, eds. Proc.

of the AAAI. AAAI Press, 2012. 662-668.

[91] Li B, Zhu XQ, Yang Q. Transfer learning problems in collaborative filtering and link prediction. In: Zhou ZH, Yang Q, eds.

Machine Learning and Its Applications 2011. Beijing: Tsinghua University Press, 2011. 33-50 (in Chinese).

[92] Cao B, Liu NN, Yang Q. Transfer learning for collective link prediction in multiple heterogeneous domains. In: Fürnkranz J,

Joachims T, eds. Proc. of the 27th Int’l Conf. on Machine Learning. Omnipress, 2010. 159-166.

[93] Wang HY, Zheng VW, Zhao J, Yang Q. Indoor localization in multi-floor environments with reduced effort. In: Proc. of the 2010

IEEE Int’l Conf. on Pervasive Computing and Communications (PerCom). 2010. 244-252. [doi: 10.1109/PERCOM.2010.5466971] [94] Zheng VW, Pan SJ, Yang Q, Pan JJ. Transferring multi-device localization models using latent multi-task learning. In: Fox D,

Gomes CP, eds. Proc. of the AAAI. AAAI Press, 2008. 1427-1432.

[95] Zhuo HH, Yang Q. Action-Model acquisition for planning via transfer learning. Artificial Intelligence, 2014,212:80-103. [doi: 10.

1016/j.artint.2014.03.004]

[96] Bai J, Zhou K, Xue GR, Zha HY, Sun G, Tseng B, Zheng ZH, Chang Y. Multi-Task learning for learning to rand in Web search. In:

Cheung DWL, Song IY, Chu WW, Hu XH, Lin JJ, eds. Proc. of the 18th ACM Conf. on Information and Knowledge Management.

New York: ACM Press, 2009. 1549-1552.

[97] Geng B, Tao D, Xu C. DAML: Domain adaptation metric learning. IEEE Trans. on Image Processing, 2011,20(10):2980-2989.

[doi: 10.1109/TIP.2011.2134107]

附中文参考文献:

[21] 戴文渊.基于实例和特征的迁移学习算法研究[硕士学位论文].上海:上海交通大学,2008.1-55.

[22] 施潇潇.主动迁移学习模型的研究与应用[硕士学位论文].广州:中山大学,2009.1-69

[91] 李斌,朱兴全,杨强.协同过滤与链接预测的迁移学习问题.见:周志华,杨强,编.机器学习及其应用2011.北京:清华大学出版社,

2011.33-50.

庄福振(1983-),男,博士,副研究员,CCF 会员,主要研究领域为迁移学习,数据挖掘,机器学习.

何清(1965-),男,博士,研究员,博士生导师,CCF高级会员,主要研究领域为机器学习,数据挖掘,基于云计算的海量数据挖掘.

罗平(1979-),男,博士,副研究员,CCF会员,主要研究领域为迁移学习,推荐系统,数据挖掘,机器学习.

史忠植(1941-),男,研究员,博士生导师, CCF会士,主要研究领域为人工智能.

促进学习迁移的策略研究

促进学习迁移的策略研究 王文静 (北京师范大学基础教育课程研究中心,北京 100875) Ξ 〔摘 要〕 对促进学习迁移的策略研究是学习迁移研究领域中关注的焦点,影响学习迁移的因素很 多,主要有:相关性、相似性、概念或事物的关键特征和学生原有学习的程度等等。本文基于对以上影响学习迁移的要素分析,提出了促进学习迁移的多种有效策略。〔关键词〕 学习迁移;策略;相关性;相似性;联结〔中图分类号〕G 442 〔文献标识码〕A 〔文章编号〕100228064(2004)022******* 对学习迁移的研究伴随着学习活动的产生始终为教育心理学界所关注,国内外众多的研究者从不同的理论视角对学习迁移进行了一系列理论与实践研究,并提出了观点各异的学习迁移理论,当代认知心理学对人类学习和认知加工过程进行的科学研究,不仅阐明了学习迁移发生的内在机制,而且更加关注教育、教学中的实践问题研究,加强促进学生有效迁移的策略研究使“为迁移而教”的追求成为当前学习迁移研究领域的一大趋势。然而,作为一线的教育实践工作者们,他们更关注的是如何在教学实践中获取有效的策略和经验,并实现促进有效学习迁移的期望和预期,本文拟将在对学习迁移的涵义和影响学习迁移的要素进行简要分析的基础上,对促进学习迁移的策略进行研究探讨。 一、学习迁移的涵义分析 现代心理学家一般认为,迁移是一种学习对另一种学习的影响。这种影响既包括积极的促进作用(即正迁移),也包括消极的干扰作用(即负迁移);既可以是前面的学习影响后来的学习(即顺向迁移),也可以是后来的学习影响前面的学习(即逆向迁移)[1]。也有学者认为,迁移是过去的学习经验对现在学习过程的影响;或者是现在的学习对学生将来学习的影响[2]。随着当代认知心理学的研究和发展,人们对学习迁移理论的研究也随之不断变化与更新,如当前的建构主义学派关注“情境”与“建构”在学习迁移中的作用,并认为:学习迁移是新颖情境中的重构,进而对学习迁移理论做了一些新的诠释。 二、影响学习迁移的要素分析 学习迁移是解决问题、创造思维以及一些高级心理加工过程、发明和艺术创造等所必须的核心能力,是学生完整的学习过程中必不可少的重要组成部分和期望出现的现象。因此,在学校学习背景下,人们普遍认为,无论在学生的课程中、课堂教学中和学习环境中都会发生迁移。新近的研究表明,迁移更多地由学生当前所处的情境引起,而不是学生自发完成的过程。事实上,无论古今的教育工作者们致力于对学习迁移的研究始终伴有这样的一种信念与追求,他们希望学生们的所有学习都能够实现迁移,在一门课的学习中,能把一个问题向另一问题迁移;在学校学习中,则是把一个年级所学的东西向另一年级迁移,甚至会实现从学校到家庭以及从学校到工作场所、到社会生活的迁移[3]。因此,从迁移发生的机制来对影响学习迁移的因素进行分析是非常必要的。影响学习迁移的因素很多,概括来说主要有如下几个:相关性、相似性、概念或事物的关键特征和学生原有学习的程度等。我们简要分析如下: 1.相关性。相关性可以是两个或多个情境之间、事件之间、活动之间的相关,也可以是情感与学习内容之间的相关。研究表明,正是因为这些相关,拓展了大脑保存信息的能力,在大脑的神经元之间形成新的联结,进而对新学习的内容进行编码,促进学习迁移产生,而当情感特别是积极的情感和学习联系到一起时,相关性的作用会更加明显。早期格式塔心理学家曾经在他们的迁移理论 Ξ 〔收稿日期〕2004-02-10〔作者简介〕王文静(19682),女,山东临沂人,教育部北京师范大学基础教育课程研究中心,博士,研究方向:教学理论及学习理论。 2004年4月第20卷 第2期教 育 科 学 Education Science Apr.,2004 Vol.20 No.2

第六章 学习的迁移与学习策略总结

第六章学习的迁移与学习策略 【教学目的】通过教学,使学生掌握迁移的基本含义与分类、学习迁移的理论、迁移与教学的关系;通过教学,掌握学习策略的含义、特征与分类,掌握各种策略的基本成分及其含义 【教学重点】学习迁移理论;学习策略的结构 【教学方法】讲授法与提问法 【教学时数】6课时 第一节学习迁移概述 一、学习迁移的含义 学习迁移也称训练迁移,指一种学习对另一种学习的影响.或习得的经验对完成其他活动的影响。 学习迁移具有普遍性,我们常说举一反三、触类旁通、闻一知十是典型的学习迁移形式。各种经验内部及其不同经验之间相互影响,通过迁移,各种经验得以沟通,经验结构得以整合。 二、迁移的种类 (一)正迁移与负迁移 根据迁移的性质不同,即迁移的影响效果不同而划分。学习迁移分为正迁移和负迁移。正迁移指一种学习对另一种学习起到积极的促进作用。负迁移指两种学习之间的相互干扰、阻碍。介于正、负迁移两者之间的一种迁移状态可称为零迁移。 (二)水平迁移与垂壹迁移 根据迁移内容的不同抽象与概括水平而划分。学习迁移分为水平迁移和垂直迁移。水平迁移也称横向迁移,是指处于同一概括水平的经验之间的相互影响。 垂直迁移又称纵向迁移,指处于不同概括水平的经验之间的相互影响。具体讲,是具有较高的概括水平的上位经验与具有较低的概括水平的下位经验之间的相互影响。垂直迁移表现在两个方面,一是自下而上的迁移,二是自上而下的迁移。 (三)一般迁移与具体迁移 根据迁移内容的不同而划分。学习迁移分为普遍迁移和具体迁移。一般迁移也称普遍迁移、非特殊迁移,是将一种学习中习得的一般原理、方法、策略和态度等迁移到另一种学习中去。 具体迁移也称为特殊迁移,指一种学习中习得的具体的、特殊的经验直接迁移到另一种学习中去,或经过某种要素的重新组合,以迁移到新情境中去。 (四)同化性迁移、顺应迁移与重组性迁移 根据迁移过程中所需的内在心理机制的不同而划分。学习迁移分为同化性迁移、顺应性迁移和重组性迁移。同化性迁移是指不改变原有的认知结构,直接将原有的认知经验应用到本质特征相同的一类事物中去。原有认知结构在迁移过程中不发生实质性的改变.只是得到某种充实。平时我们所讲的举一反三、闻一知十等都属于同化性迁移。

2学习动机学习迁移学习策略

贰学习动机学习迁移学习策略 1.了解学习动机的功能,理解动机理论,掌握激发与培养中学生学习动机的方法。 2.了解学习迁移的分类,理解形式训练说、共同要素说、概括化理论、关系转换理论、认 知结构迁移理论,掌握有效促进学习迁移的措施。 3.了解学习策略的分类,掌握认知策略、元认知策略和资源管理策略。 第二节学习动机 一、学习动机概述 (一)什么是学习动机 学习动机是指激发、维持个体的学习行为,并使行为指向一定的学习目标的内部心理过程或内部动力。 学习动机的产生依赖于学习需要和诱因两大因素。学习需要是个体在学习活动中感到一种缺失、不平衡力求获得满足的内部状态,诱因是指能够满足个体某种需要的外部条件或刺激物。 (二)学习动机的种类 从不同角度出发,可以把学习动机分成不同的类型。 根据动机起作用的时间长短,可把学习动机分为近景动机和远景动机; 根据动机的关注范围,可以分为普遍型学习动机和偏重型学习动机; 根据动机的社会意义,可以分为高尚的学习动机和低下的学习动机; 根据动机的来源方向,可以分为内部动机和外部动机。 (三)学习动机的功能 学习动机在人类学习行为中起着发动、指引和维持的功能,学习动机是影响学习目标和成效的重要因素。 1.发动功能 动机是在需要刺激下直接推动人进行活动以达到目的的内部动力,他是引起活动的直接机制。当学生对某些知识产生强烈需求和学习动机时,这种动机就会唤醒学生进入学习的情

绪状态,引起学习行为。学习动机还能够强化学生的学习准备状态,激活相关背景知识,扩充学习内容和知识贯通,提高学习效率。 2.指引功能 动机使人的活动具有选择性。具有某种动机的学生会给自己设定目标,并使自己的学习行为朝向这些目标。动机越强烈,人的行动目标也越明确,学生学习的方向性也就越坚定。 3.维持功能 学习动机能够提高学生学习的努力程度和意志力。学习动机有助于学生的感知力、注意力、记忆力、想象力等智力因素的提高,同时对于影响学生的非智力因素,如学习热情、勤奋刻苦、坚忍不懈、善于合作等都有很大的促进和帮助。 二、学习动机理论 (一)强化动机理论 强化动机理论是行为主义范式下的动机理论。行为主义心理学家认为,学习动机的产生来自于外部刺激。人的学习行为取决于相关刺激是否因为强化而建立了稳固的联系。所谓强化,是指使个体行为频率出现的可能性增加的结果。强化可以引发和维持学生的学习行为,因此,不必在强化之外去寻求学生学习行为的原因,强化理论足以解释个体行为的原因即动机。 学生产生学习行为倾向即动机,是因为学生先前的某种行为受到强化,使该行为和某种刺激因为强化而建立牢固的联结,如家长的赞许、老师的表扬、社会的肯定等,因此学生就具有了某种行为倾向。过去受到强化的行为比没有受到强化的行为或者比受到惩罚的行为更易于重复出现。如果学生因为学习得到了强化,他就会有继续学习的动机。相反,一些学生不愿学习,缺乏学习动机,则是因为他们先前的学习行为没有得到强化或是受到惩罚。 (二)成就动机理论 成就动机是个体从事自己认为重要的有价值的工作,并努力获得成功的动机。成就动机理论是麦克兰德和阿特金森在默瑞的成就需要概念基础上形成的。阿特金森于1963提出了成就动机模型。他认为接近成就目标的趋势是由三个因素决定的:成就需要或渴望成功的动机,成功地完成任务的可能性,成功的诱因值,这些成分是一种相乘的关系,即力求成功(避免失败)=需要期待诱因。 成就动机的强度由力求成功与避免失败两方面共同决定,即成就动机=力求成功—避免失败。阿特金森还进一步区分了成就动机的两种不同倾向:力求成功的需要和避免失败的需要,与此相关的就有力求成功者和避免失败者。力求成功者更倾向于追求成功以及由成功带来的积极体验;避免失败者则更倾向于避免失败以及由失败而带来的消极感受。力求成功者往往将目标定为获得成功,他们会倾向于选择有挑战性的任务。避免失败者会倾向于选择非常容易或非常困难的任务。因为容易的任务可以减少失败的可能性,而困难的任务即使失败

简述学习动机和学习迁移理论及其应用

简述学习动机和学习迁移理论及其应用程青阳 1110451042 计算机科学与技术系软件二班 摘要:随着社会的不断进步,人才需求面临前所未有的压力,与此同时,社会各界对人才的质量考察有明显注重趋势,因此各高校对待人才的培养也非常重视,高校在人才培养方面注重德智体全面发展,而不是停留在一味的灌输知识层面上,但是现实是残酷的,不少大学生没有认识到学习的重要性,没有意识到大学的学习比高中更复杂,更有难度,大学的学习需要学生自己的独立和自觉能力,学习动机的强弱对大学生的人生轨迹有着不可忽视的影响,什么样的学习动机才是正确的学习动机?如何激发和保持学生的学习动机?学习迁移理论如何在教学以及其他领域的应用?本文在接下来将予以介绍。 关键词:学习动机学习迁移教学模式 当前,许许多多教育学家,心理学家甚至其他领域的专家学者无不在各自的领域潜心研究自己的课题,希望能有一天实现突破,在有关学生教育课题上的研究也大有人在,他们有的在基层学校里教学,希望通过亲身感受从学生的反应上获得有价值的信息,也有一些人,

他们没有到学校里与学生面对面,而是选择了在自己的书房翻阅各种国内外关于学习动机的理论书籍,然后期待从中获得有价值的线索,我们或许不能对此提出错误的判断,认为这种方式不可取,也许他们真的能够发现什么。什么是动机?大学生学习动机的现状及其存在的问题如何?处理大学生学习动机偏差问题的策略是怎样的?学习迁移理论的应用在哪方面?我将针对这几个问题在以下几个方面予以介绍和说明。 一什么是学习动机 学习动机是推动学生进行学习活动的内在原因,是激励、指引学生学习的强大动力。学习动机指的是学习活动的推动力,又称"学习的动力"。它并不是某种单一的结构。学生的学习活动是由各种不同的动力因素组成的整个系统所引起的。其心理因素包括:学习的需要,对学习的必要性的认识及信念;学习兴趣、爱好或习惯等。从事学习活动,除要有学习的需要外,还要有满足这种需要的学习目标。由于学习目标指引着学习的方向,可把它称为学习的诱因。学习目标同学生的需要一起,成为学习动机的重要构成因素。【1】 动机是激发人们对某件事情采取行动的心理诱因,人们在做一件事情之前会有一段时间用来考虑,也同样存在一种物质促使人们去做一件事,这种物质是行动的使然,它的存在直接或间接导

运用知识迁移法

运用知识迁移法,引导学生掌握学法 窦静 叶圣陶先生曾说过“教是为了不教”,这句话既道出了教学的目的,又道出了学生掌握方法后能自主获取知识,去寻求发展。二十一世纪是人才竞争的世纪,人才竞争归根到底就是教育的竞争。素质教育是当今教育改革的趋势,引导学生自主学习是素质教育的精髓,课堂教育是实施素质教育的“主渠道”。因此,引导学生自主学习应贯穿于小学教学过程之中。所谓“自主学习”是指在教学过程中,学生在学习时表现出的自觉性、积极性、独立性特征的总和。是从事创造性学习活动的一种心理能动状态。现代教育的特征充分展现人的自主性,追求人的全面发展。 强化知识的概括归纳,建立知识网络结构,为学生的自主探索提供可行性前提。指导学生掌握正确的学习方法,是学生获取知识的金钥匙,是小学生自主发展的关键。不懂方法,自主学习、自主发展只能成为空谈。在课堂教学中应注重观察、操作、比较、迁移、解题、思维等方法进行指导。 所谓知识迁移法就是利用新旧知识间的联系,启发学生进行新旧知识对照,由旧知识去思考、领会新知识,学会学习的方法。首先教师要创造真正意识上的让学生参与尝试的机会,创设自主探索的情境,建立自主探索动机的最佳心理。如我在教学《年月日》,先让学生观察事先准备好的年历,让学生通过观察发现四年一闰的规律找出判断平年闰年的方法,让学生自己想办法,就给全体学生留有思考的空间,他们会从不同角度,用不同方法得出结论的,这样才能真正发挥学生的主体作用。 其次,教师要有意识的设置新旧知识之间的矛盾,使“自主学习”一触即发,促使学生自主探索动机的形成。比如,我在教学《商的近似数》时,利用去超市的故事创设情境,激起了人民币的最小单位是“分”和所付的钱数以元为单位有4位小数,让学生联系自己的生活实际,促使学生积极主动地去探索新知,自然的引导学生探索出怎样去求商的近似数的方法。第三,教师要提供让全体学生参与的时机。上课初始应当在做好铺垫,让学生在新旧知识的连接点处尝试解答新知识,使所有学生能够跳一跳摘到果子,享受成功的喜悦,继而以更饱满的热情参与下面的学习。避免由少数学生的活动代替多数学生活动。在教学中,能让全体学生动手、动口的就不让部分人代替,能让多数人动口、动手的就不让少数人或个别人代替。要使全体学生都能有效地参与学习过程,开动脑筋,在原有知识的基础上进行自主探究,从而掌握新知识。 数学的各个组成部分不是孤立存在,而是互相联系,互为因果的。课堂教学中学生的思维过程就是揭示和建立新旧知识联系的过程。任何自主探索都必须有起点,有依托,不能切断知识之间的内存与联系。通过引思、回顾、概括、归纳旧知,形成程序性知识,建立良好的知识网络结构,从而大面积、高效率的解法席位活动,从而使自主探索成为可能。 在我的数学课堂教学中尽量为学生创设主动参与的机会,提供主动发展的空间,引导学生从已有的旧知出发,主动参与学习过程,从而落实学生的主体地位,促进学生的主动发展,使学生的数学素质得到提高。 经过一段时间的实验,我所任教的班级课堂气氛活跃,学生都能积极主动地调动自己已有的旧知去主动进行学习。特别是一些学习上本来有一定困难的学生,运用知识迁移法,在课堂上有了成功的体验,品尝到了学习的快乐,学习成绩有了明显的提高。 当然,课题实验中,有成功的经验,也存在一些不足之处:运用知识迁移法进行教学,有利于学生将零散的数学知识联系在一起,形成网络性知识结构,但在学生对知识的综合运用能力方面,显然仍有不足之处,这也是我进行课题实验下一步继续探索的主要方面。

培养学生的迁移能力

培养学生的迁移能力 知识的迁移指的是一种学习对另一种学习的影响。知识的迁移能力也就是学生能否将学到的知识技能成功地迁移到新的情境、新的课题时所体现出的一种素质和能力。其实质就是触类旁通,举一反三,就是把学到的某些原理知识应用到学习新的知识或解决问题的活动中去,也就是实现知识的迁移。在科学课堂教学中如何促进学生的知识迁移能力的培养? 一、利用学生已有的知识结构,以促进知识迁移 根据迁移规律,学生掌握基础知识和基本技能的牢固程度是实现迁移的重要因素之一。先前的学习越扎实、雄厚,就越容易产生迁移,效果也越显著。进行有意义的学习,提高对所学知识的理解程度,为知识的迁移、应用奠定基础和准备。如果没有对知识的透彻和贯通性理解是无法实现知识迁移的。 1.温故而习新,促使知识的纵向迁移 在教学中,只要教师善于引导学生把新旧知识联系起来,促使其同化,将新问题与知识结构、新知与旧知、未知与已知相“链接”,利用所构建的知识结构去“同化”这个新问题,就能建立新的认知结构,从而使知识实现从“故”到“新”的纵向迁移,并且使“故”也得到巩固。 在欧姆定律的教学中,这一节是电学部分的重点之一,让学生自己设计与探究欧姆定律的实验有一定的困难。利用学生已有认知结构里的有关“控制变量法”的知识情节,把新旧知识联系起来启发学生。如压力的作用效果与哪些因素有关的实验,因为压强和压力与受力面积都有关系,所以在研究时,是先保持压力F 不变,通过演示实验而得出P 与S 的关系,然后保持受力面积不变,通过实验再研究P 和F 的关系,从而得出结论,最后综合得出:P=F/S。应当指出,这里运用的研究方法就是控制变量法。也就是说,若研究的物理量与多个物理量有联系时,就把其中的一个或几个物理量先控制起来,使它保持不变,从而把所研究的问题首先转化为一个物理量与单个物理量之间的关系问题。这样使被研究的问题由复杂变简单,容易发现联系,最后将各个联系综合起来得到所需结论。控制变量法是研究多变量问题的有力武器,所有多变量问题原则上都可用控制变量法来研究、求解。通过以上的实验比较分析,对“控制变量法”更进一步理解,学生认知结构里的新知识引起同化,更有利于探究欧姆定律,促使学生对新知识欧姆定律的理解和掌握。 在液体压强、电功、焦耳定律等教学中,都可以采用“控制变量法”的知识迁移启发学生,都获得很好的效果。 2.举一反三,触类旁通,促使知识的横向迁移 举一反三,触类旁通,实际上就是学习者通过思维,运用已有的知识技能,找到与要解决的问题关联,从而把当前的问题纳入已有的知识系统,从而解决了问题,也就是知识的实际应用。 如在讲“二氧化碳的实验室制取”一节时,选用制二氧化碳的发生装置及收集装置时,找到与已有的认知结构相关联(即氧气、氢气的制取装置及收集装置的选取原则相关联)。把新课题同化到学生已构建的“制取装置及收集装置的选取”认知结构中,这个结构中易于找到解决的途径和方法。从而达到“教是为了达到不需要教”的目的。 二、创设情境,进行意义建构,促进知识的迁移 建构主义认为,学习总是与一定的社会生活的背景即“情境”相联系的,在实际生活情境下进行学习,可以激发学生的联想思维,使学习者能利用自己原有认知结构中的有关经验,去同化和索引当前学习到的新知识,从而在新旧知识之间建立起联系,并赋予新知识以某种意义,促进知识的迁移。 在课堂讲授中,从学生熟悉的身边的问题和现象入手,结合学生的生活实际,创设生活情景具有生动性、直观性,引导他们发现问题,展开探究。有利于激发学生的联想思维,促进知识的迁移。

学习迁移理论概述

学习迁移理论概述 2.1 迁移理论研究的历史溯源 早在我国古代,人们就注意到了迁移现象。春秋时期的教育家、思想家孔子就曾提出“举一反三”,“温故而知新”等教学思想,他还要求学生“由此及彼”。但直到二百多年前才有人提出一个系统的迁移理论——形式训练说。形式训练说的基础是官能心理学。官能心理学认为,人的心是由意志、记忆、思维、推理等官能组成。心的各种官能相对独立,各司其责。各种官能可以像肌肉一样,通过练习来增强能力。而且,一种官能改进了,其他所有官能也会在无形中得以加强。形式训练说把迁移看作是通过对各种官能分别训练来实现的。1890年美国心理学家詹姆士(W. James)开始了最早的迁移研究。他和他的四个助手以自己为被试,用两份难易度和份量相仿的材料来考察前一种学习是否影响后一种材料的学习。虽然他们的研究结果因被试人数太少而带有偶然性,但此实验开启了迁移研究的先河。 1903年,桑代克(Thorndike)对注意、记忆和知觉辨别等进行了一系列实验后,提出了“相同元素说”。其主要思想为:迁移就是将先前学习任务中获得的特定行为应用于新的任务中。两项学习任务间之所以有迁移,是因为他们之间有共同的元素,也就是有共同的刺激——反应联结。迁移能力的获得只能通过大量的训练和练习使这些联结得以加强。迁移也即相同联结的转移。相同元素说后来被吴伟士修改为共同要素说,意即只有两种学习情境存在共同成分时,一种因素才能影响另一种因素。这一学说是一种机械的迁移观,只能解释机械的具体的特殊迁移,难以揭示人类复杂的学习迁移的实质。 贾德在1908年设计了水下击靶实验研究迁移,结果发现学习者在学习过程中获得的原理和原则是迁移发生的主要原因。他强调前后两种学习包含的共同原理原则及学习者对这种原理原则的概括是迁移产生的两个条件,因此,学习者对原理掌握得越好,越有可能在新的情境中产生迁移。贾德的概括化理论突破了桑代克相同要素的局限,第一个将相同要素的范围上升到更抽象的原理原则,同时把学习者对学习情境的共同原理原则的概括作为迁移的基本条件,从而扩大了迁移研究的范围。 格式塔心理学家进一步发展了概括化理论,苛勒根据“小鸡觅食”实验的结果提出了关系转换说。他认为学生顿悟两种学习情境中原理原则之间的关系,特别是手段-目的间的关系是实现迁移的根本条件,其实质就是指两种学习情景中存在某种相似的关系,这是迁移的前提条件,而学习者对两种学习情景的共同关系的顿悟是迁移的关键和根本。 此外,鲁宾斯坦提出了分析概括说。他认为学习迁移在于通过综合分析,揭示出两个课题之间本质上相同或相似的条件,从而产生对解决方法的概括,因而综合分析及其在此基础上的概括是学习迁移产生的真正本质。 这些学说虽然强调的是迁移的各个侧面,但都离不开概括在学习迁移中的作用。早期的迁移理论从不同方面揭示了迁移的某些规律,对今天的迁移研究仍然有重要的参考价值。主要表现在:1)学习情境因素方面。早期迁移研究的一个共同特点是强调前后两种学习材料的相似性是迁移产生的条件。桑代克强调两种材料外显的、具体的、元素的相似。苛勒和贾德则强调两种材料内隐的、深层的、整体的相似,即原理、原则和关系的相似。形式训练说强调前后两种学习所要求参与的

解题迁移策略

迁移策略在高三物理一轮复习中的应用探微 卢湾高级中学王金铎 高三物理一轮复习,是高中物理学习的最高层次,是高一、高二物理学习的拓展与延伸。由于第一轮复习,将让学生构建比较完整的知识与能力体系,所以,这个阶段对高中物理的学习起着十分重要的作用。高三物理一轮复习一般采取知识梳理的方式进行,以知识为载体,通过物理基本方法的归纳,形成综合处理物理问题的能力。该过程的知识目标定位是:通过对高中所学物理知识的系统梳理,清晰认识高中物理每个知识点的确切含义,加深知识点间的横向联系,形成比较完备的知识网络,提升对基本物理知识、原理和规律的认识;能力目标是:在进行知识梳理的同时,培养同学的物理思维能力、实验能力、应用数学解决物理问题的能力及科学探究能力,从而提升综合处理物理实际问题的能力;在情感目标上:通过对物理基本知识和技能的复习,进一步激发热爱物理的激情,在处理物理问题的过程中,领悟和形成严谨的科学态度和求实的科学精神,不断提升科学的思维品质。 一、对高三物理教学的思考 由于一轮复习的时间紧、任务重,对学生的思维要求高,所以一轮复习是高三复习中的重要组成部分。在传统的复习过程中,教师和同学都会在一轮复习中花费大量的时间,并且增大课堂的容量和训练、考核的频数,试图提升复习的效率。在对复习效果的诊断和反馈中,我们发现,增加课堂容量和训练、测试的频数对单元知识的巩固和强化确实起到了应有的作用,可以使单元或章节的教学达到预期的目标。然而在后继的二、三轮复习过程中,有时总感到已复习的内容学生遗忘率较高、已归纳和使用过的方法再使用率低的现象,这不得不引起教学中的深思。 实际上,现代的考试和命题是以能力立意进行的,就是说是在确定了考核能力要求的前提下,选择知识载体进行试题的命制,以达到预期的考核效果。所以知识的组合度、交叉度等都是在能力立意命题的背景下,必然形成的试卷组合形式。这样,如果不能形成知识的前后联系、方法的前后贯通,即使单元知识的复习效果再好,单元内容的掌握程度再深,在处理实际问题时,仍会显得能力的欠缺。 究其原因,可能是多方面的。除了部分同学在单元复习中,没有真正“过关”以外,在复习过程,没有注意知识、方法的前后联系,不能将已复习的内容在新的情景中,进行有效的迁移也会是其中的重要原因。笔者在多年的高三物理教学过程中,思考和分析了高三物理教学过程中,学生知识的形成和应用特征,尝试和采取了物理复习中的迁移策略,不断加深物理知识和方法的前后联系,把已复习内容作为后继复习的阶梯,在滚动复习、螺旋式上升中提升学生的物理能力,收到了良好的复习效果。 二、对物理迁移的基本认识 新旧学习的相互影响就是学习的迁移。 1.对迁移的基本认识 除了本能活动以外,人类的大部分活动、知识和经验,都是通过学习而获得的。那么有限的学习为什么能使人类拥有以不变应万变的智慧呢?这时因为人类在学习过程中利用了迁移。无数实践证明,人们在新的学习过程中,总会受到先前的知识、经验、技能、态度以

(战略管理)传统与可转移阿尔法策略

传统与可转移阿尔法策略 :产生阿尔法的方式主要有两类,一类是某些类别资产自身就能够提供阿尔法,另一类是通过资产组合提炼出阿尔法。固定收益资产属于第一种,而通过衍生品与基金、股票、商品等的组合构成的策略则为第二类。第二类方法与对冲基金的很多策略类似 一、传统阿尔法策略 阿尔法的概念来自于二十世纪中叶,经过学者的统计,当时约75%的股票型基金经理构建的投资组合无法跑赢根据市值大小构建的简单组合或是指数。不少学者将此现象归因于市场的有效性,也就是由于金融市场聚集了众多的投资者,这些投资者时刻紧盯着市场,一旦市场出现套利机会,他们就会迅速做出行动以使市场恢复均衡。在一个有效的金融市场,任何寻找超额收益的努力都是徒劳的,投资者只能获得基准收益率。 随着后半世纪衍生品的诞生,不少基金取得了令人眩目的收益率,这说明通过积极的投资管理是可以获得超额收益率的。高收益率基金的诞生使得投资者不再满足于消极投资策略带来的回报,投资者希望能够获取超越基准指数的收益率。阿尔法就是高于经β调整后的预期收益率的超额收益率。虽然一些资产类别本身就具备阿尔法,或者说这个基金的管理者具有卓越的管理能力,这种能力能够持续地产生阿尔法。 计算阿尔法需要用到CAPM模型,它是由William Sharpe在其著作《投资组合理论与资本市场》中提出,它指出了投资者在市场中交易面临系统性风险和非系统性风险。传统阿尔法策略是在基金经理建立了β部位的头寸后,通过衍生品对冲β部位的风险,从而获得正的阿尔法收益。 二、提供正阿尔法收益的策略 产生阿尔法的方式主要有两类,一类是某些类别资产自身就能够提供阿尔法,另一类是通过资产组合提炼出阿尔法。固定收益资产属于第一种,而通过衍生品与基金、股票、商品等的组合构成的策略则为第二类。第二类方法与对冲基金的很多策略类似,我们接下来简单介绍一下海外对冲基金的情况。 随着经济繁荣增长,金融市场和投资者的复杂性随之变化,为满足市场投资者的需求,金融工具和金融产品创新在过去20年里发展迅速。在多样化的金融产品中,另类投资(Altemative Investmenis)加入到传统的投资类别中,扩大了投资者选择的范围。广义来讲,另类投资是指有别于传统投资方式如股票债券投资为主的共同基金的另类投资方式,它充分运用了金融市场的复杂性,包含积极的投资方式和复杂的投资管理策略。针对投资者风险收益需求,通过利用实物商品和衍生商品之间的机会,以及融资杠杆放大收益的作用进行动态投资,多方面满足投资者提高收益的需要。另类投资世界中包括:风险投资、私人股权、杠杆投资、房地产投资以及本研究涉及的对冲基金。20世纪80年代以来,国际金融市场创新不断,除传统投资工具:股票和债券以外,各类衍生品诸如远期、期货、掉期、期权发展起来,场内市场发展远远低于场外市场的交易规模。这为各种各样的对冲基金交易策略提供了丰富的工具。对冲基金可以同时利用金融和非金融(商品)市场,并且可以在这些市场采用多头、空头、价差掉期、信用掉期和期权

学生知识迁移能力的培养

学生知识迁移能力的培养 迁移贯穿在人一生中各种形式的教育学习中,因此“为迁移而教”已成为今天教育心理学家的共识。要想了解如何培养学生的迁移能力,我们就要先知道哪些因素影响了学生的迁移,这样才能“对症下药”。在现代信息社会中,知识信息大量涌现,而且翻新很快,这就要求学生的学习能够做到举一反三,闻一知十。但迁移的发生不是自动的,它还需要具备一定的条件。首先学习材料之间的共同因素。两种学习之间要产生迁移,关键在于发现它们之间的一致性或相似性。学习对象之间的相同要素越多,迁移的量也就越大。如学生学了“going”的“ing”会拼“morning”、“playing”,因为最后一音节(或字尾)总是拼作“ing”.再次对学习材料的理解程度。现代认知理论主张有意义学习,这种学习和机械学习不同,它强调理解对于知识的保持和应用的作用。一般来说,真正理解了的东西,不论它如何改变,人们总能认识它。因此,理解程度直接影响到有关知识的应用和迁移。在有意义学习中,同化论的核心也是解决理解问题。通过对知识之间上下位关系的认识,学生在认知结构的适当地方找到其位置,从而达到理解。同化论的这种观点可

以用来帮助我们引导学生加深对所学内容的认识水平,这有助于学生所学知识的广泛迁移。最后知识经验的概括水平。知识经验的概括水平是影响知识迁移的重要因素之一。正是由于这一点,在教育实际中我们十分强调基本原理、基本概念的学习,这些原理、概念抽象程度高,适应范围广泛,迁移效果明显,学生掌握之后可以用来解决大量的类似或同类问题。学生对觉得的知识经验进行概括,就能反映同类事物、问题的共同特点和规律性的联系,因而,对具体事物、问题的联系就越普遍。概括的程度越高,就越有利于学习迁移的发生。要实现对知识经验的概括就阳要加强学习中理解的作用,只有理解才能实现对知识经验的概括,理解的的越深入,概括的程度就越高,就越有利于新知识的掌握、问题的解决和知识的运用。同时老师的指导和教学对学生概括的水平和概括能力的提高起着重要作用。 一、加强基本概念、原理、原则和科学规律的教学。 从教育与发展的角度看,既要使学生掌握科学知识,又要促进学生在各种新情境、新条件下活学活用已学的知识,能够举一反三、触类旁通,达到灵活迁

学习迁移理论的实质和应用

迁移理论与汉字教学小议 摘要:关于学习迁移理论的研究,时至今日已有300多年的历史了。伴随着心理学的不断发展,作为一个重要学习理论,或者说是学习的条件论,围绕迁移这一概念,各个学派都根据自身的理论立场,对迁移进行了不同角度的诠释。我们可以看到,几乎所有的理论都是围绕迁移产生的条件而进行研究的。而对于迁移整体论的研究寥寥无几。本文尝试在已有研究的基础上,针对比较典型的几个迁移理论提出我们的一些看法,并在此基础上提出我们对迁移的整体把握。同时结合对外汉语教学的实际,研究迁移理论的实践价值之所在。 关键词:迁移整体论汉字教学 1、引论 “国内外许多相关知名学者和语言心理学家对于学习迁移理论的研究已经有近300 年的历史。”1如所周知,历史上比较著名的迁移理论学说有“形式训练说、相同要素说、概括说、关系转换说、学习定势理论”。但是,我们发现以上这些学说都是围绕“迁移如何产生这一问题”而展开的讨论。对于“迁移”本身是什么,并没有作出明确的回答。当然,对于一个概念的解释可以有不同的渠道,而看似最为简单的往往是最难做到的。可以说整个人文科学之中,大家所烦恼的就是对于概念的解释或是界定。我们收集了一些关于“迁移”的描述“一个人将以前在学习或问题解决时获得的经验及知识应用于新情景时即为迁移” 2,“学习迁移的实质是原有知识在新的学习情景中的运用”3,“一般地说,学习的迁移(transfer of learning)可以简单的定义为,一种学习对另一种学习的影响……”4,“在一种情景中技能、知识和理解的获得或态度的形成对另一种情境中技能、知识和理解的获得态度的形成的影响。(詹姆斯)”5,“个人在学习中获取的各种信息,不仅应该长期保存,而且还应该用到不同的场景中去,这就涉及到迁移问题。”6总结以上关于“迁移”的各种描述,可以概括为如李红先生所讲的“一种学习对另一种学习的影响……”,我们可以看到上面的描述多少有些将学习的过程与结果相混淆的弊端。我们认为“迁移”是学习的过程,而非结果。学习的结果应该是对一个新知识、技能等的具体应用。但是由于“迁移”是一个复杂的隐性过程,我们不可能直接观察到,为了确定“迁移”存在与否,只能借助“迁移”的外显来衡量。例如;我们说一个人是否学好一个技能要看他学了以后是否会用,如果会用就是“迁移”成功。如果不会用就是“迁移”失败。我们觉得无论成功与失败,只要有学习发生就会有“迁移”出现。一个人没有学好一项技能不等于他没有学习。但是我们在评价学习的成果时,总是以成败论英雄。而这个成败在今天更多的表现是对分数、名校的追捧。在大家都在大呼“素质教育”的今天,这不是自相矛盾的吗?我们并不否认学习成果的重要,我 1刘晓莉:“迁移理论及其应用”,河南师范大学学报(哲学社会科学版),2002年第3期。 2[美]约翰·桑切克:《教育心理学》,第318页。 3皮连生:《教育心理学》,第261页。 4李红:《21世纪心理学系列教材教学心理学》,第255页。 5李红:《21世纪心理学系列教材教学心理学》,第255页。

高等教育心理学考试要点第六章学习迁移及其促进重点试题解析

高等教育心理学考试要点第六章学习迁移及其促进重点试题解析 一、选择题 1.学过高等数学后有利于初等数学的进一步理解和掌握,这属于( )。A.顺向正迁移 B.逆向正迁移 C.顺向负迁移 D.逆向负迁移2.已经获得的知识、动作技能、情感和态度等对新的学习的影响称为学习的( )。 A.迁移 B.动机 C.策略 D.技巧 3.以下不是影响迁移的客观因素的是( )。 A.教师指导 B.学习材料特性 C.媒体 D.认知结构 4.根据迁移内容不同进行划分,可以分为( )。 A.水平迁移与垂直迁移 B.正迁移与负迁移 C.一般迁移与具体迁移 D.同化性迁移、顺应迁移与同组迁移 8.由于先前活动而形成的心理的一种特殊准备状态称为( )。 A.迁移 B.变式 C.定势 D.原型启发 9.“举一反三”和“触类旁通”所说的是( )。 A.纵向迁移 B.侧向迁移 C.特殊迁移 D.学会学习 1O.由处于同一概括水平的经验之间的相互影响而发生的迁移称为( )。A.顺向迁移 B.逆向迁移 C.水平迁移 D.垂直迁移

11.产生式迁移理论证实了( )。 A.学习可以自动迁移,而不必有学习者的有意识注意 B.桑代克的共同的“S—R”成分可以导致迁移 C.熟练的基本技能可以自动迁移 D.策略学习可以自动迁移 12.在现代迁移理论中,提出认知结构迁移理论的是( )。 A.桑代克 B.贾德 C.奥苏伯尔 D.安德森 13.哈洛用恒河猴作学习定势实验。猴子通过训练与学习,迁移表现是( )。A.通过多次尝试,学会了辨别目的物 B.通过尝试学会了解决辨别问题 C.在后继学习中,解决相似问题速度提高 D.通过经验积累,解决新的不同类型问题的时间大大缩短 D.定势迁移的影响表现为促进和阻碍。 16.桑代克在迁移研究中的最大贡献是( )。 A.发现了迁移的心理机制 B.最早进行迁移实验研究 C.否定了普遍迁移的说法 D.用实验事实否定了形式训练说 17.皮亚杰认为,儿童思维发展到一定逻辑抽象水平以后,这种思维形式适用于任何具体领域。从迁移的理论来看,这种观念与( )接近。

关于知识的迁移能力的培养(讲座一)

关于知识的迁移能力的培养(讲座一) 府谷二中八年级物理组薛波 知识的迁移指的是一种学习对另一种学习的影响。知识的迁移能力也就是学生能否将学到的知识技能成功地迁移到新的情境、新的课题时所体现出的一种素质和能力。其实质就是触类旁通,举一反三,就是把学到的某些原理知识应用到学习新的知识或解决问题的活动中去,也就是实现知识的迁移。在科学课堂教学中如何促进学生的知识迁移能力的培养? 一、利用学生已有的知识结构,以促进知识迁移 根据迁移规律,学生掌握基础知识和基本技能的牢固程度是实现迁移的重要因素之一。先前的学习越扎实、雄厚,就越容易产生迁移,效果也越显著。进行有意义的学习,提高对所学知识的理解程度,为知识的迁移、应用奠定基础和准备。如果没有对知识的透彻和贯通性理解是无法实现知识迁移的。 1.温故而习新,促使知识的纵向迁移 在教学中,只要教师善于引导学生把新旧知识联系起来,促使其同化,将新问题与知识结构、新知与旧知、未知与已知相“链接”,利用所构建的知识结构去“同化”这个新问题,就能建立新的认知结构,从而使知识实现从“故”到“新”的纵向迁移,并且使“故”也得到巩固。 在欧姆定律的教学中,这一节是电学部分的重点之一,让学生自己设计与探究欧姆定律的实验有一定的困难。利用学生已有认知

结构里的有关“控制变量法”的知识情节,把新旧知识联系起来启发学生。如压力的作用效果与哪些因素有关的实验,因为压强和压力与受力面积都有关系,所以在研究时,是先保持压力 F 不变,通过演示实验而得出P 与S 的关系,然后保持受力面积不变,通过实验再研究P 和F 的关系,从而得出结论,最后综合得出:P=F/S。应当指出,这里运用的研究方法就是控制变量法。也就是说,若研究的物理量与多个物理量有联系时,就把其中的一个或几个物理量先控制起来,使它保持不变,从而把所研究的问题首先转化为一个物理量与单个物理量之间的关系问题。这样使被研究的问题由复杂变简单,容易发现联系,最后将各个联系综合起来得到所需结论。控制变量法是研究多变量问题的有力武器,所有多变量问题原则上都可用控制变量法来研究、求解。通过以上的实验比较分析,对“控制变量法”更进一步理解,学生认知结构里的新知识引起同化,更有利于探究欧姆定律,促使学生对新知识欧姆定律的理解和掌握。 在液体压强、电功、焦耳定律等教学中,都可以采用“控制变量法”的知识迁移启发学生,都获得很好的效果。 2.举一反三,触类旁通,促使知识的横向迁移 举一反三,触类旁通,实际上就是学习者通过思维,运用已有的知识技能,找到与要解决的问题关联,从而把当前的问题纳入已有的知识系统,从而解决了问题,也就是知识的实际应用。 二、创设情境,进行意义建构,促进知识的迁移 建构主义认为,学习总是与一定的社会生活的背景即“情

教育心理学第五章学习的迁移

第五章学习的迁移 1、学习迁移概述 学习迁移的概念:心理学家定义为“一种学习对另一种学习的影响”。也就是已获得的知识、技能、学习方法或学习态度对学习新知识、新金额跟和解决新问题所产生 的一种影响;或者说是将学得的经验有变化地运用于另一情境。 学习迁移的类型:一、根据迁移的性质划分,分为正迁移与负迁移 (正迁移指一种迁移的获得对另一种学习起促进作用;负迁移是指一种经 验的获得对另一种学习起干扰或阻碍作用) 二、根据迁移的方向划分,分为水平迁移(横向迁移)和垂直迁移(纵向 迁移) 顺向迁移逆向迁移自上而下的迁移自下而上的迁移 (先行学习与后继学习的影响的划分) (水平迁移是指学习的知识或技能等在相同水平上的迁移,是处于同一层 次(抽象与概括程度相同)的学习间的相互影响,学习内容之间是并列的, 即在难度和复杂程度上大致属于同一水平的学习之间的迁移;垂直迁移主 要指处于不同层次(概括与抽象的程度不同)的各种学习间的相互影响, 即上位的较高层次的经验与下位的较低层次的经验之间的相互影响。) 三、根据迁移的内容划分,分为一般迁移(普通迁移)和具体迁移(特 殊迁移) 一般迁移指一种学习中所习得的一般原理、原则和态度对另一种具体内容学习的影响,即将原理原则和概念具体化,运用到具体的事例中。具 体迁移指学习之间发生迁移时,学习者原有经验的组成要素没有发生变 化,即抽象的结构没有变化,只是将一种学习中习得经验的组成要素重新 组合并用于另一种学习之中。 特殊迁移的范围仅限于有限的情景中,不如一般迁移广泛。 四、根据迁移发生的学习情境不同,分为远迁移和近迁移 个体能将所学的经验迁移到与原来学习情景极不相似的其他情景中时,即产生了远迁移;近迁移即把所学的经验迁移到与原来的学习情境比 较相似的情境中。

知识迁移的理论条件和促进迁移的方式

知识迁移的理论条件和促进迁移的方式 早期的迁移理论主要有:形式训练说,共同因素说,概括化理论以及关系理论。 形式训练说是一种古老的迁移理论,来自于官能心理学。它认为人类的心理是由不同的官能形成的,通过对人的心理官能进行训练,可以使该官能的能力得到提高,从而促进迁移。共同因素说是由教育心理学家桑代克和吴伟士指出,强调各种学习之间具有共同成分或共同因素,才会产生迁移。 概括化理论由心理学家贾德(C.H. Judd)提出,认为学习者在两种活动中概括它们之间的共同原理是迁移的关键,两种学习之间的共同因素是迁移的必要条件之一。 关系理论由格式塔心理学家苟勒提出,认为迁移是由于学习者突然领悟两种学习之间所存在的关系的结果。这一理论实际上是对概括理论的一种补充。 现代认知心理学家都十分重视认知结构的重要性,认为认知结构的形成是产生广泛迁移的根本。布鲁纳认为学科基本结构的学习有助于迁移。 建构主义的理论学派,认为迁移实际上就是认知结构在新条件下的重新建构。为了促使学生在新条件下应用知识的能力,建构主义者们提出了一些教学理论,如抛锚式教学、认知学徒式教学以及认知灵活性理论等。教学时要让学生在各种实际情境中从多种角度反复应用知识。 2.迁移的种类 迁移的种类按其效果来分,可分为正迁移和负迁移。如果一种学习对另一种学习起促进作用,即为正迁移。两种学习间干扰作用则是负迁移;按迁移的顺序划分,可分为顺向迁移和逆向迁移。学习英语句法结构,有时也会受到汉语句法结构的影响而产生顺向负迁移。例如,在翻译“我们明天去上学。”的句子时,有的学生错误地译成: We tomorrow go to school.“读书破万卷,下笔如有神。”则是说明了大量的阅读,能促进写作能力的提高,也就是说阅读学习对写作能力提高产生顺向正迁移,此种说法同样适用于英语学习。 三、促进知识迁移的方法 迁移是普遍存在的现象,但迁移的发生却不是自动的,它需要我们创设条件,采取有效的方法,才能更好地促进学生所学知识的迁移,从而提高记忆与学习效率,发展学生综合语言能力。 1.创设多种促进知识的迁移条件 (1)在英语教学中,教师应在学习新知识之前提供给学生引导性知识,其目的是为新的学习内容提供联系点或者促进对新知识与旧知识的辨别。例如,在讲解过去进行时的时候,教师要引导学生先复习现在进行时,通过比较,分析两种时态的异同后,学生对过去进行时掌握就比较容易。 (2)理解程度直接影响到有关知识的运用与迁移。如果教师在讲解知识内容时,能充分利用奥苏伯尔的“不断分化”和“综合贯通”两个原则,可以帮助我们引导学生深化对所学内容的理解,提高对所学内容的认识水平,使学生在学到丰富知识的同时,形成合理而牢固的认知结构,促进知识迁移。 (3)知识经验的概括水平也是影响知识迁移的重要因素之一。因此,在英语教学中,要注重基本概念的学习和掌握。例如,英语语法知识讲解,这些概念抽象程度高。因为知识越抽象,其潜在的应用范围(逻辑处延)就越大,适用范围就越广泛,迁移效果就越明显。 (4)定势也称心向,也是影响知识迁移的条件。定势的作用有双重性。对知识迁移的影响可能是积极的,也可能是消极的。例如,学生在翻译“他们在教室”句子时,受汉语的负