最新神经网络试卷(A卷)(含答案)

20 08 –20 09 学年第 一 学期 考试方式: 开卷[ ] 闭卷[√]

课程名称: 神经网络

使用班级: 计算机科学与技术(医学智能方向)06 班级: 学号: 姓名: 一、单项选择题(每空2分,共30分)

1. 人工神经网络的激活函数主要有三种形式,下面(A )对应的是非线性转移函数, ( B )对应的是对应的是域值函数,( C )分段线性函数。

()()1

01)f())f )0

1e 1, 1f , 11

)f 0

1, 1v A v B v C v v v v v v D v v ≥?=

=?

-<+?≥??

=-<<=??-≤-?

()

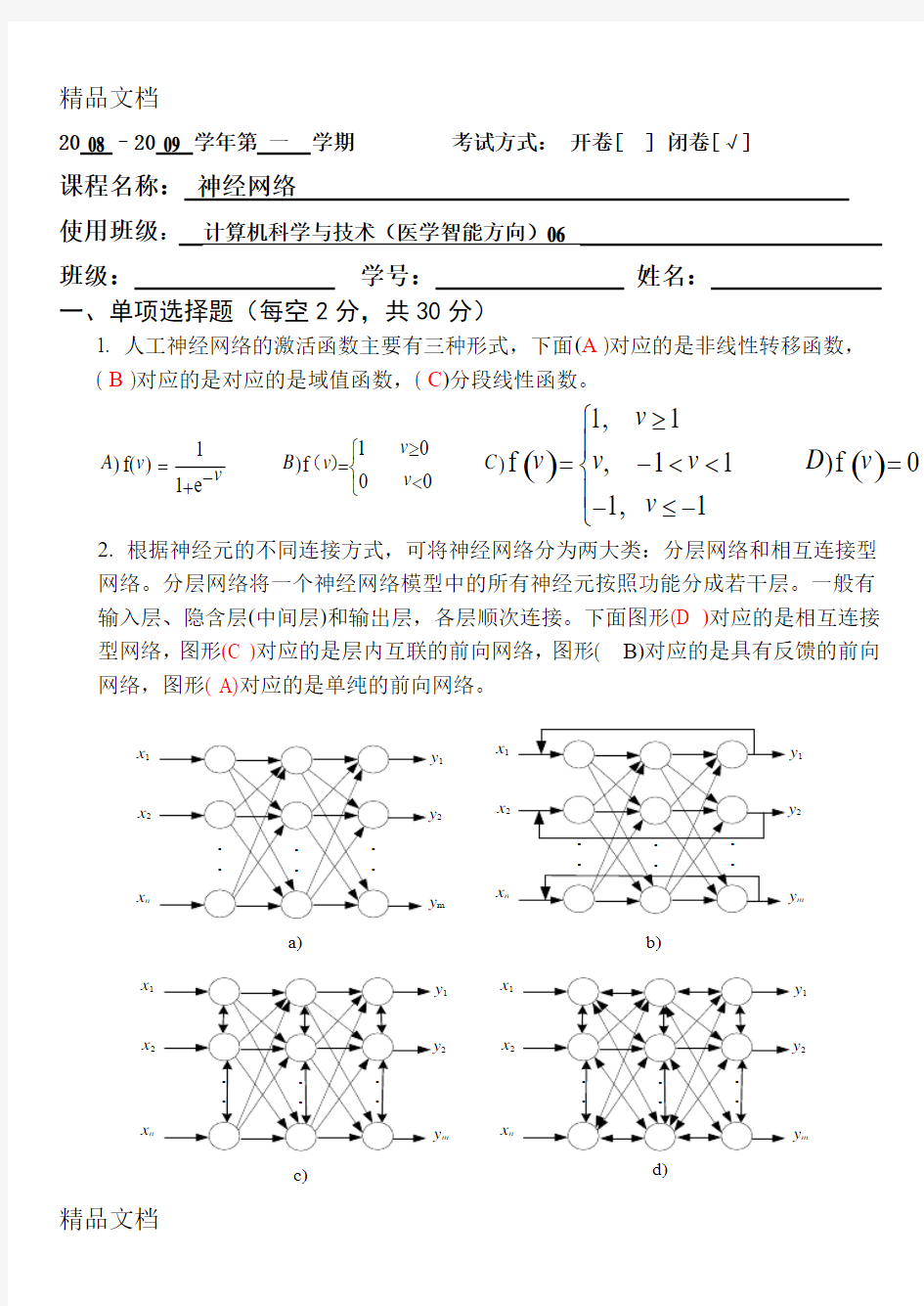

2. 根据神经元的不同连接方式,可将神经网络分为两大类:分层网络和相互连接型网络。分层网络将一个神经网络模型中的所有神经元按照功能分成若干层。一般有输入层、隐含层(中间层)和输出层,各层顺次连接。下面图形(D )对应的是相互连接型网络,图形(C )对应的是层内互联的前向网络,图形( B)对应的是具有反馈的前向网络,图形( A)对应的是单纯的前向网络。

x 1x 2

x n

12

m

x 1x 2

x n

12

m

x 1x 2

x n

12

m

x 1x 2

x n

12

m

a)

b)

c)

d)

3. 在MATLAB中,下面的(○3)命令可以使用得下次绘制的图和已经绘制的图将

不在同一张图上。

A) hold on(设置在同一张图绘制多条曲线)B) figure (下次的图和已绘制的不在同一张图上)C) plot D) hold off(取消在同一张图绘制多条曲线)

3.下面是一段有关向量运算的MATLAB代码:

>>y= [3 7 11 5];

>>y(3) = 2

运算后的输出结果是(○8)

A) 3 2 11 5 B) 3 7 2 5C) 2 7 11 5 D) 3 7 11 2

4. 下面是一段有关矩阵运算的MATLAB代码:

>>A = [1 2 3 4; 5 6 7 8; 9 10 11 12];

>>B = A(2,1:3)取出矩阵A中第二行第一个到第三个构成矩阵B

若A(2,3)=5将矩阵第二行第三列的元素置为5

A=[A B’]将B转置后,再以列向量并入A

A(:,2)=[]删除第二列:代表删除列A([1,4],:)=[]删除第一和第四行:代表删除行A=[A;4,3,2,1]加入第四行

那么运算后的输出结果是(○9)

A) 5 7 8 B) 5 6 8 C) 5 6 7D) 6 7 8

5.下面对MATLAB中的plot(x,y,s)函数叙说正确的是(○10)

A) 绘制以x、y为横纵坐标的连线图(plot(x,y)) B绘制多条不同色彩的连线图(plot(x,y))

C) 默认的绘图颜色为蓝色D) 如果s=’r+’,则表示由红色的+号绘制图形

6. 如果现在要对一组数据进行分类,我们不知道这些数据最终能分成几类,那么应

该选择(○11)来处理这些数据最适合。

A) BP神经网络B)RBF神经网络

C) SOM神经网络D)ELMAN神经网络

4. 如果现在要对一组数据进行分类,我们已经知道这些数据最终能分成几类,那么

应该选择(○4)来处理这些数据最适合。

A) RBF神经网络B) SOM神经网络

C) BP神经网络D) ELMAN神经网络

7.一个只有单权值的神经网络,其误差函数为

A) 增大 B) 减少

C) 可能增大也可能减少 D) 不变

8. 单层感知器,它最大的缺点是只能解决线性可分的分类模式问题,要增强网络的

分类能力唯一的方法是采用多层网络结构,与单层感知器相比较,下面(○

13)不是多层网络所特有的特点。

A) 神经元的数目可以达到很大 B) 含有一层或多层隐单元 C) 激活函数采用可微的函数 D) 具有独特的学习算法

9. 标准BP 算法采用的是最速梯度下降法修正权值,该算法存在与输入样本的顺序有关、收敛速度缓慢、易陷入局部极小等缺陷,为了克服算法中的不足,研究者们

提出了许多改进算法,其中(○

14)算法与其它三个算法的原理不一样。 A) 附加动量的改进算法 B) 使用拟牛顿法的改进算法 C) 采用自适应调整参数的改进算法 D) 使用弹性方法的改进算法

10. 标准BP 算法采用的是最速梯度下降法修正权值,该算法存在与输入样本的顺序有关、收敛速度缓慢、易陷入局部极小等缺陷,为了克服算法中的不足,研究者们提出了许多

改进算法,其中(○

15)算法与其它三个算法的原理不一样。 A) 基于共轭梯度法的改进算法 B) 附加动量的改进算法

C) 使用拟牛顿法的改进算法 D) 基于Levenberg-Marquardt 法的改进算法

10. nnToolKit 神经网络工具包中的函数可以在MATLAB 环境下独立运行,也可打包成

COM 对象被其它语言调用,但是不能被(○

15) A) Visual Basic B) Visual C++ C) C D) C++ Builder

二、填空题(每空2分,共20分)

1. 人工神经网络(Artificial Neural Networks ,ANNs ),也简称为神经网络(NNs ),是模拟 生物神经网络进行信息处理的一种数学模型,以对大脑的生理研究成果为基础,其目的在于模拟大脑的某些机理与机制,实现一些特定的功能。

2. 人工神经元模型可以看成是由3种基本元素组成一个连接,一个加法器,一个激

活函数

图一

ho

3. 神经网络的学习也称为训练,指的是神经网络在受到外部环境的刺激下调整神经

网络的参数,使神经网络以一种新的方式对外部环境做出反应的一个过程。神经网络的学习方式可分为有导师学习,无导师学习,再励学习

4. 神经网络的基本属性反映了神经网络特点,它主要有并行分布式处理、非线性

处理和具有自学习功能等。

1. 人工神经网络从生物神经网络发展而来,一个神经元就是一个神经细胞,在人类大脑皮层中大约有100亿个神经元。神经元是基本的信息处理单元。生物神经元主要由细胞体,树突,轴突,突触组成。

2.学习算法是指针对学习问题的明确规则,学习类型是由参数变化发生的形式决定的,不同的学习算法对神经元的权值调整的表达式是不同的。人工神经网络常用的算法有Hebb学习算法&学习算法,随机学习算法,竞争学习算法等。

三、综合题(其中第1题20分,第2题20分,第三题10分,共50分)

1、构建一个有两个输入一个输出的单层感知器,实现对表一中的数据进行分类,设感知器的阈值为0.6,初始权值均为0.1,学习率为0.6,误差值要求为0,感知器的激活函数为硬限幅函数,计算权值w1与w2。

表一

x1x2 d

0 0 0

0 1 0

1 0 0

1 1 1

2、构建一个BP神经网络(网络结构见图二)完成对表二中的数据分类,设初始连接权值全部为0.5,阈值为0,学习率为0.5,输入层到隐含层,隐含层到输出值的激活函数为单极SIGMOID函数,要求误差e为0.1,当输入样本(1,1,0)时,计算BP算法执行

2、本课程中学习了许多不同结构的神经网络,请您就BP 神经网络、RBF 神经网络和 SOM 神经网络三种神经网络说明它们各自的特点,并就它们的特点各给出一个实际应 用中的例子。

BP:1使用sigmoid ()函数作为激活函数,输入的可见区域大2学习速率快3具有自学能力,例子:遥感适应模式识别

RBF :1学习速率快2输入定向区域小(径向基函数)3适用解决分类问题。例子四声自动识别

SOM :1快速性(天隐含层)(双层结构,输入输出映射)2无监督性3可视化效果

适用:解决模式分类和识别方面的应用。例子:颜色图像分割

X

基于深度卷积神经网络的图像分类

SHANGHAI JIAO TONG UNIVERSITY 论文题目:基于卷积神经网络的自然图像分类技术研究 姓名: 高小宁 专业:控制科学与工程

基于卷积神经网络的自然图像分类技术研究 摘要:卷积神经网络已在图像分类领域取得了很好的效果,但其网络结构及参数的选择对图像分类的效果和效率有较大的影响。为改善卷积网络的图像分类性能,本文对卷积神经网络模型进行了详细的理论分析,并通过大量的对比实验,得出了影响卷积网络性能的因素。结合理论分析及对比实验,本文设计了一个卷积层数为8层的深度卷积网络,并结合Batch Normalization、dropout等方法,在CIFAR-10数据集上取得了%的分类精度,有效地提高了卷积神经网络的分类效果。 关键词:卷积神经网络,图像分类,Batch Normalization,Dropout Research on Natural Image Classification Based on Convolution Neural Network Abstract: Convolution neural network has achieved very good results in image classification, but its network structure and the choice of parameters have a greater impact on image classification efficiency and efficiency. In order to improve the image classification performance of the convolution network, a convolutional neural network model is analyzed in detail, and a large number of contrastive experiments are conducted to get the factors that influence the performance of the convolution network. Combining the theory analysis and contrast experiment, a convolution layer depth convolution network with 8 layers is designed. Combined with Batch Normalization and dropout, % classification accuracy is achieved on CIFAR-10 dataset. Which improves the classification effect of convolution neural network. Key Words: Convolution neural network(CNN), image classification, Batch Normalization, Dropout

人工智能期末试题及答案完整版

xx学校 2012—2013学年度第二学期期末试卷 考试课程:《人工智能》考核类型:考试A卷 考试形式:开卷出卷教师: 考试专业:考试班级: 一单项选择题(每小题2分,共10分) 1.首次提出“人工智能”是在(D )年 A.1946 B.1960 C.1916 D.1956 2. 人工智能应用研究的两个最重要最广泛领域为:B A.专家系统、自动规划 B. 专家系统、机器学习 C. 机器学习、智能控制 D. 机器学习、自然语言理解 3. 下列不是知识表示法的是 A 。 A:计算机表示法B:“与/或”图表示法 C:状态空间表示法D:产生式规则表示法 4. 下列关于不确定性知识描述错误的是 C 。 A:不确定性知识是不可以精确表示的 B:专家知识通常属于不确定性知识 C:不确定性知识是经过处理过的知识 D:不确定性知识的事实与结论的关系不是简单的“是”或“不是”。 5. 下图是一个迷宫,S0是入口,S g是出口,把入口作为初始节点,出口作为目标节点,通道作为分支,画出从入口S0出发,寻找出口Sg的状态树。根据深度优先搜索方法搜索的路径是 C 。 A:s0-s4-s5-s6-s9-sg B:s0-s4-s1-s2-s3-s6-s9-sg C:s0-s4-s1-s2-s3-s5-s6-s8-s9-sg D:s0-s4-s7-s5-s6-s9-sg 二填空题(每空2分,共20分) 1.目前人工智能的主要学派有三家:符号主义、进化主义和连接主义。 2. 问题的状态空间包含三种说明的集合,初始状态集合S 、操作符集合F以及目标

状态集合G 。 3、启发式搜索中,利用一些线索来帮助足迹选择搜索方向,这些线索称为启发式(Heuristic)信息。 4、计算智能是人工智能研究的新内容,涉及神经计算、模糊计算和进化计算等。 5、不确定性推理主要有两种不确定性,即关于结论的不确定性和关于证据的不确 定性。 三名称解释(每词4分,共20分) 人工智能专家系统遗传算法机器学习数据挖掘 答:(1)人工智能 人工智能(Artificial Intelligence) ,英文缩写为AI。它是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。人工智能是计算机科学的一个分支,它企图了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器,该领域的研究包括机器人、语言识别、图像识别、自然语言处理和专家系统等 (2)专家系统 专家系统是一个含有大量的某个领域专家水平的知识与经验智能计算机程序系统,能够利用人类专家的知识和解决问题的方法来处理该领域问题.简而言之,专家系统是一种模拟人类专家解决领域问题的计算机程序系统 (3)遗传算法 遗传算法是一种以“电子束搜索”特点抑制搜索空间的计算量爆炸的搜索方法,它能以解空间的多点充分搜索,运用基因算法,反复交叉,以突变方式的操作,模拟事物内部多样性和对环境变化的高度适应性,其特点是操作性强,并能同时避免陷入局部极小点,使问题快速地全局收敛,是一类能将多个信息全局利用的自律分散系统。运用遗传算法(GA)等进化方法制成的可进化硬件(EHW),可产生超出现有模型的技术综合及设计者能力的新颖电路,特别是GA独特的全局优化性能,使其自学习、自适应、自组织、自进化能力获得更充分的发挥,为在无人空间场所进行自动综合、扩展大规模并行处理(MPP)以及实时、灵活地配置、调用基于EPGA的函数级EHW,解决多维空间中不确定性的复杂问题开通了航向 (4)机器学习 机器学习(Machine Learning)是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。它是人工智能的核心,是使计算机具有智能的根本途径,其应用遍及人工智能的各个领域,它主要使用归纳、综合而不是演绎 (5)数据挖掘 数据挖掘是指从数据集合中自动抽取隐藏在数据中的那些有用信息的非平凡过程,这些信息的表现形式为:规则、概念、规律及模式等。它可帮助决策者分析历史数据及当前数据,并从中发现隐藏的关系和模式,进而预测未来可能发生的行为。数据挖掘的

08第八章___神经网络的参数优化设计方法

1 第8章 神经网络的参数优化设计 在神经网络的泛化方法中,研究最多的是前馈神经网络的结构优化设计方法(剪枝算法、构造算法及进化算法等,我们将在以后各章讨论)。除了结构设计,其余前馈神经网络的泛化方法还有主动学习、最优停止法、在数据中插入噪声、神经网络集成及提示学习方法等,由于这些方法中神经网络的结构是固定的,因此神经网络性能是通过参数优化改善的,我们称这些方法为神经网络的参数优化设计方法。本章介绍最主要的参数优化设计方法,并给出了每种方法的算法实现和仿真例子。 8.1 主动学习 8.1.1 原理 按照学习机器对训练样本的处理方式,可将学习方式分为两类:被动学习方式和主动学习方式。被动学习是常用的学习方式,常被称为“从样本中学习” (Learning from samples ),该方式被动地接受训练样本,并通过学习从这些样本中提取尽可能多的信息。与被动学习相反,主动学习属于更高层次的、具有潜意识的学习。主动学习对训练样本的选择是主动的,通常通过对输入区域加以限制,有目的地在冗余信息较少的输入区域进行采样,并选择最有利于提高学习机器性能的样本来训练分类器,从而提高了整个训练样本集的质量。由上一章的讨论,训练样本质量对神经网络的泛化能力有极大影响,甚至超过网络结构对泛化能力的影响。因此采用主动学习方法,是改进神经网络泛化能力的一个重要方法。 主动学习机制大部分用于分类或概念学习[Baum1991,HwCh1990,SeOp1992]。在单概念学习中,Mitchell[Mitch1982]关于版本空间(Version Space)的论述有着较大的影响。下面,我们先简要介绍一下这一理论。 如果X 为一线性空间,概念c 定义为X 中点的集合。对目标概念t ,训练样本可写为()()x x t ,,其中X ∈x 为样本输入,()x t 为对x 的分类。如果t ∈x ,则()1=x t ,称()()x x t ,为t 的正样本;如果t ?x ,则()0=x t ,此时称()()x x t ,为t 的负样本。显然,对线性空间内的任何两个可分概念1c 和2c ,如果()()x x 1,c 是1c 的正样本(负样本),则()()x x 11,c ?必然是2c 的负样本(正样本),即任意两个可分概念的正负样本之间可以互相转换。如果某概念c 对x 的分类与目标概念对其的分类()x t 相等,即()()x x t c =,

人工智能习题&答案-第4章-计算智能1-神经计算-模糊计算

第四章计算智能(1):神经计算模糊计算4-1 计算智能的含义是什么?它涉及哪些研究分支? 贝兹德克认为计算智能取决于制造者提供的数值数据,而不依赖于知识。计算智能是智力的低层认知。 主要的研究领域为神经计算,模糊计算,进化计算,人工生命。 4-2 试述计算智能(CI)、人工智能(AI)和生物智能(BI)的关系。 计算智能是智力的低层认知,主要取决于数值数据而不依赖于知识。人工智能是在计算智能的基础上引入知识而产生的智力中层认知。生物智能,尤其是人类智能,则是最高层的智能。即CI包含AI包含BI 4-3 人工神经网络为什么具有诱人的发展前景和潜在的广泛应用领域? 人工神经网络具有如下至关重要的特性: (1) 并行分布处理 适于实时和动态处理 (2)非线性映射 给处理非线性问题带来新的希望 (3) 通过训练进行学习 一个经过适当训练的神经网络具有归纳全部数据的能力,能够解决那些由数学模型或描述规则难以处理的问题 (4) 适应与集成 神经网络的强适应和信息融合能力使得它可以同时输入大量不同的控制信号,实现信息集成和融合,适于复杂,大规模和多变量系统 (5) 硬件实现 一些超大规模集成是电路实现硬件已经问世,使得神经网络成为具有快速和大规模处理能力的网络。 4-4 简述生物神经元及人工神经网络的结构和主要学习算法。

生物神经元 大多数神经元由一个细胞体(cell body或soma)和突(process)两部分组成。突分两类,即轴突(axon)和树突(dendrite),轴突是个突出部分,长度可达1m,把本神经元的输出发送至其它相连接的神经元。树突也是突出部分,但一般较短,且分枝很多,与其它神经元的轴突相连,以接收来自其它神经元的生物信号。 轴突的末端与树突进行信号传递的界面称为突触(synapse),通过突触向其它神经元发送信息。对某些突触的刺激促使神经元触发(fire)。只有神经元所有输入的总效应达到阈值电平,它才能开始工作。此时,神经元就产生一个全强度的输出窄脉冲,从细胞体经轴突进入轴突分枝。这时的神经元就称为被触发。突触把经过一个神经元轴突的脉冲转化为下一个神经元的兴奋或抑制。学习就发生在突触附近。 每个人脑大约含有10^11-10^12个神经元,每一神经元又约有10^3-10^4个突触。神经元通过突触形成的网络,传递神经元间的兴奋与抑制。大脑的全部神经元构成极其复杂的拓扑网络群体,用于实现记忆与思维。 人工神经网络的结构 人工神经网络由神经元模型构成。每个神经元具有单一输出,并且能够与其它神经元连接,存在许多输出连接方法,每种连接方法对应于一个连接权系数。 人工神经网络的结构分为2类, (1)递归(反馈)网络 有些神经元的输出被反馈至同层或前层神经元。信号能够从正向和反向流通。Hopfield网络,Elmman网络和Jordan网络是代表。 (2) 前馈网络 具有递阶分层结构,由一些同层神经元间不存在互连的层级组成。从输入层至输出层的信号通过单向连接流通,神经元从一层连接至下一层,不存在同层神经元之间的连接。多层感知器(MLP),学习矢量量化网络(LVQ),小脑模型连接控制网络(CMAC)和数据处理方法网络(GMDH)是代表。 人工神经网络的主要学习算法 (1) 指导式(有师)学习 根据期望和实际的网络输出之间的差来调整神经元连接的强度或权。包括Delta规则,广义Delta规则,反向传播算法及LVQ算法。 (2) 非指导(无导师)学习 训练过程中,神经网络能自动地适应连接权,以便按相似特征把输入模式分组聚集。包括

《神经网络》试题

《神经网络》试题 (2004年5月9日) 张翼王利伟 一、填空 1.人工神经元网络(ANN)是由大量神经元通过极其丰富和完善 的连接而构成的自适应非线形动力学系统。 2.神经元(即神经细胞)是由细胞体、树突、轴突和突触四 部分构成。 3.大量神经元相互连接组成的ANN将显示出人脑的分布存储和容 错性、大规模并行处理、自学习、自组织和自适应性、复杂的非线形动态系统、处理复杂、不确定问题。 4.ANN发展大体可为早期阶段、过度期、新高潮、热潮。 5.神经元的动作特征主要包括空间性相加,时间性相加,阈值 作用,不应期,疲劳和可塑性。 6.神经元与输入信号结合的两种有代表的结合方式是粗结合和 密结合。 7.1943年由美国心理学家McCulloch和数学家Pitts提出的形式神经 元数学模型简称为MP 模型,它规定了神经元之间的联系方式只 有兴奋、抑制联系两种。 8.目前,神经网络模型按照网络的结构可分为前馈型和反馈型, 按照学习方式可分为有导师和无导师学习。 9.神经网络工作过程主要由学习期和工作期两个阶段组成。 10.反馈网络历经状态转移,直到它可能找到一个平衡状态,这个平

衡状态称为 吸引子 。 二、问答题 1.简述Hebb 学习规则。 Hebb 学习规则假定:当两个细胞同时兴奋时,它们之间的连接强度应该增强,这条规则与“条件反射”学说一致。 在ANN 中Hebb 算法最简单可描述为:如果一个处理单元从另一处理单元接受输入激励信号,而且如果两者都处于高激励电平,那么处理单元间加权就应当增强。用数学来表示,就是两节点的连接权将根据两节点的激励电平的乘积来改变,即 ()()i i n ij n ij ij x y ηωωω=-=?+1 其中()n ij ω表示第(n+1)是第(n+1)次调节后,从节点j 到节点i 的连接权值;η为学习速率参数;x j 为节点j 的输出,并输入到节点i ;i y 为节点i 的输出。 2、简述自组织特征映射网络的算法。 自组织特征映射网络的算法分以下几步: (1) 权连接初始化 就是说开始时,对所有从输入节点到输出节点的连接权值都赋以随机的小数。时间设置t=0。 (2) 网络输入模式为 ),,,(21n b x x x =X (3) 对X k 计算X k 与全部输出节点所连接权向量T j W 的距离

基于神经网络的优化计算实验报告

人工智能实验报告 实验六基于神经网络的优化计算实验 一、实验目的: 掌握连续Hopfield神经网络的结构和运行机制,理解连续Hopfield神经网络用于优化计算的基本原理,掌握连续Hopfield神经网络用于优化计算的一般步骤。 二、实验原理 连续Hopfield神经网络的能量函数的极小化过程表示了该神经网络从初始状态到稳定状态的一个演化过程。如果将约束优化问题的目标函数与连续Hopfield神经网络的能量函数对应起来,并把约束优化问题的解映射到连续Hopfield神经网络的一个稳定状态,那么当连续Hopfield神经网络的能量函数经演化达到最小值时,此时的连续Hopfield神经网络的稳定状态就对应于约束优化问题的最优解。 三、实验条件: VC++6.0。 四、实验内容: 1、参考求解TSP问题的连续Hopfield神经网络源代码,给出15个城市和20个城市的求解结果(包括最短路径和最佳路线),分析连续Hopfield神经网络求解不同规模TSP问题的算法性能。 2、对于同一个TSP问题(例如15个城市的TSP问题),设置不同的网络参数,分析不同参数对算法结果的影响。 3、上交源代码。

五、实验报告要求: 1、画出连续Hopfield神经网络求解TSP问题的流程图。 2、根据实验内容,给出相应结果及分析。 (1)15个城市(测试文件TSP15.TXT)

tsp15.txt 最短路程371 最佳路线 →→→→→→→→→→→→→→→1914861351534712210111 (2)20个城市(测试文件TSP20.TXT) tsp20.txt 最短路程349 最佳路线 →→→→→→→→→→→→→→→→→→→→→141618971315111735124289191610201 3、总结连续Hopfield神经网络和遗传算法用于TSP问题求解时的优缺点。 遗传算法易出现早熟收敛和收敛性差的缺点。 Hopfield算法对高速计算特别有效,但网络不稳定。 用Hopfield解TSP问题效果并不理想。相对前面的遗传算法解TSP 性能有相当大差距。

人工神经网络复习题

《神经网络原理》 一、填空题 1、从系统的观点讲,人工神经元网络是由大量神经元通过极其丰富和完善的连接而构成的自适应、非线性、动力学系统。 2、神经网络的基本特性有拓扑性、学习性和稳定收敛性。 3、神经网络按结构可分为前馈网络和反馈网络,按性能可分为离散型和连续型,按学习方式可分为有导师和无导师。 4、神经网络研究的发展大致经过了四个阶段。 5、网络稳定性指从t=0时刻初态开始,到t时刻后v(t+△t)=v(t),(t>0),称网络稳定。 6、联想的形式有两种,它们分是自联想和异联想。 7、存储容量指网络稳定点的个数,提高存储容量的途径一是改进网络的拓扑结构,二是改进学习方法。 8、非稳定吸引子有两种状态,一是有限环状态,二是混沌状态。 9、神经元分兴奋性神经元和抑制性神经元。 10、汉明距离指两个向量中对应元素不同的个数。 二、简答题 1、人工神经元网络的特点? 答:(1)、信息分布存储和容错性。 (2)、大规模并行协同处理。 (3)、自学习、自组织和自适应。 (4)、人工神经元网络是大量的神经元的集体行为,表现为复杂

的非线性动力学特性。 (5)人式神经元网络具有不适合高精度计算、学习算法和网络设计没有统一标准等局限性。 2、单个神经元的动作特征有哪些? 答:单个神经元的动作特征有:(1)、空间相加性;(2)、时间相加性;(3)、阈值作用;(4)、不应期;(5)、可塑性;(6)疲劳。 3、怎样描述动力学系统? 答:对于离散时间系统,用一组一阶差分方程来描述: X(t+1)=F[X(t)]; 对于连续时间系统,用一阶微分方程来描述: dU(t)/dt=F[U(t)]。 4、F(x)与x 的关系如下图,试述它们分别有几个平衡状态,是否为稳定的平衡状态? 答:在图(1)中,有两个平衡状态a 、b ,其中,在a 点曲线斜率|F ’(X)|>1,为非稳定平稳状态;在b 点曲线斜率|F ’(X)|<1,为稳定平稳状态。 在图(2)中,有一个平稳状态a ,且在该点曲线斜率|F ’(X)|>1,为非稳定平稳状态。

基于深度卷积神经网络的人脸识别研究

基于深度卷积神经网络的人脸识别研究 深度卷积神经网络主要应用包括语音识别、图像处理、自然语言处理等。本文就当前大环境下研究了卷积神经网络模型在静态环境下人脸识别领域的应用。卷积神经网络模型需要设计一个可行的网络模型,将大量的人脸训练数据集加载到网络模型中,然后进行自动训练,这样就可以得到很好的识别率。把训练好的模型保存下来,那么这个模型就是一个端到端的人脸特征提取器。该方法虽然操作简单,但是需要根据训练数据集设计合理的网络结构,而且最难的关键点是超参数的调整和优化算法的设计。因此本文结合残差网络和融合网络构建了两个与计算资源和数据资源相匹配的网络模型,并通过反复调整超参数和调试优化器使其在训练集上能够收敛,最终还取得较好的识别率。 本文的主要研宄内容和创新点如下: 1.介绍了卷积神经网络的基础理论知识。先从传统人工神经网络的模型结构、前向和反向传播算法进行了详细的分析;然后过渡到卷积神经网络的相关理论,对其重要组成部分如卷积层、激励层、池化层和全连接层进行了具体的阐述;最后对卷积神经网络训练时的一些注意事项进行了说明。 人工神经元是构成人工神经网络的基本计算单元,单个神经元的模型结构如下图所示。

其中,b X W b x w Z T+ = + =∑1 1 1 ) ( ) ( , z f x h h w = x x x x x e e e e z z f e z z f - - - + - = = + = = ) tanh( ) ( 1 1 ) ( ) (σ 卷积神经网路的基本结构

简单的池化过程: 2.对深度学习框架TensorFlow的系统架构和编程模型作了一些说明,并对人脸数据进行预处理,包括人脸检测、数据增强、图像标准化和人脸中心损失。

基于神经网络的专家系统

基于神经网络的专家系统 摘要:人工神经网络与专家系统,作为人工智能应用的两大分支,在实际应用中都有许多成功的范例,但作为单个系统来讲,二者都存在很大的局限性。主要是专家系统知识获取的“瓶颈问题”和神经网络知识表达的“黑箱结构”。为解决这个问题,本文提出将专家系统与神经网络技术集成,达到优势互补的目的。利用神经网络优良的自组织、自学习和自适应能力来解决令家系统知识获取的困难,同时用专家系统良好的解释机能来弥补神经网络中知识表达的缺陷。论文提出了基于神经网络专家系统的结构模型,知识表示方式以及推理机制等。 关键词:专家系统;神经网络;系统集成; 0 引言 专家系统(Expert System)是一种设计用来对人类专家的问题求解能力建模的计算机程序。专家系统是一个智能计算机程序,其内部含有大量的某个领域专家水平的知识和经验,能够利用人类专家的知识和解决问题的方法来处理该领域问题。一个专家系统应具有以下三个基本特征:启发性——不仅能使用逻辑性知识还能使用启发性知识;透明性——能向用户解释它们的推理过程,还能回答用户的一些问题;灵活性——系统中的知识应便于修改和扩充;推理性——系统中的知识必然是一个漫长的测试,修改和完善过程。专家系统是基于知识的系统。它由如图1所示的5个基本的部分组成[1,2,3]。 知识库存储从专家那里得到的特定领域的知识,这些知识包括逻辑性的知识和启发性知识两类。数据库用于存放专家系统运行过程中所需要和产生的信息。推理机的作用是按照一定的控制策略,根据用户提出的问题和输入的有关数据或信息,按专家的意图选择利用知识库的知识,并进行推理,以得到问题的解答,它是专家系统的核心部分。人机接口部分的功能是解释系统的结论,回答用户的问题,它是连接用户与专家系统之间的桥梁。知识的获取是为修改知识库原有的知识和扩充知识提供的手段。 1 传统专家系统存在的问题 传统专家系统是基于知识的处理的系统,将领域知识整理后形式化为一系列系统所能接受并能存储的形式,利用其进行推理实现问题的求解。尽管与人类专家相比,专家系统具有很大的优越性。但是,随着专家系统应用的日益广泛及所处理问题的难度和复杂度的不断扩大和提高,专家系统在某些方面已不能满足是实际工作中的需求,具体体现在以下一个方面[1,2]:(1)知识获取的“瓶颈”问题。(2)知识获取的“窄台阶”。(3)缺乏联想功能、推理能力弱。(4)智能水平低、更谈不上创造性的知识。(5)系统层次少。(6)实用性差。 2 神经网络与传统专家系统的集成 神经网络是基于输入\输出的一种直觉性反射,适用于进行浅层次的经验推理,其特点是通过数值计算实现推理;专家系统是基于知识匹配的逻辑推理,是深层次的符号推理。将两者科学的结合形成神经网络专家系统,可以取长补短。根据侧重点的不同,神经网络与专家系统的集成有三种模式[2]:(1)神经网络支持专家系统。以传统的专家系统为主,以神经网络的有关技术为辅。 (2)专家系统支持神经网络。以神经网络的有关技术为核心,建立相应领域的专家系统,采用专家系统的相关技术完成解释等方面的工作。 (3)协同式的神经网络专家系统。针对大的复杂问题,将其分解为若干子问题,针对每个子问题的特点,选择用神经网络或专家系统加以实现,在神经网络和专家系统之间建立一种耦合关系。

《人工神经网络原理与应用》试题

1 / 1 《人工神经网络原理与应用》试题 试论述神经网络的典型结构,常用的作用函数以及各类神经网络的基本作用,举例说明拟定结论。 试论述BP 算法的基本思想,讨论BP 基本算法的优缺点,以及改进算法的思路和方法。以BP 网络求解XOR 问题为例,说明BP 网络隐含层单元个数与收敛速度,计算时间之间的关系。要求给出计算结果的比较表格,以及相应的计算程序(.m 或者.c )试论述神经网络系统建模的几种基本方法。利用BP 网络对以下非线性系统进行辨识。 非线性系统 )(5.1) 1()(1)1()()1(22k u k y k y k y k y k y +-++-=+ 首先利用[-1,1]区间的随机信号u(k),样本点500,输入到上述系统,产生y(k), 用于训练BP 网络;网络测试,利用u(k)=sin(2*pi*k/10)+1/5*sin(2*pi*k/100),测试点300~500,输入到上述系统,产生y(k),检验BP 网络建模效果要求给出程序流程,matlab 程序否则c 程序,训练样本输入输出图形,检验结果的输入输出曲线。 试列举神经网络PID 控制器的几种基本形式,给出相应的原理框图。 试论述连续Hopfield 网络的工作原理,讨论网络状态变化稳定的条件。 谈谈学习神经网络课程后的心得体会,你准备如何在你的硕士(博士)课题中应用神经网络理论和知识解决问题(给出一到两个例)。《人工神经网络原理与应用》试题 试论述神经网络的典型结构,常用的作用函数以及各类神经网络的基本作用,举例说明拟定结论。 试论述BP 算法的基本思想,讨论BP 基本算法的优缺点,以及改进算法的思路和方法。以BP 网络求解XOR 问题为例,说明BP 网络隐含层单元个数与收敛速度,计算时间之间的关系。要求给出计算结果的比较表格,以及相应的计算程序(.m 或者.c )试论述神经网络系统建模的几种基本方法。利用BP 网络对以下非线性系统进行辨识。 非线性系统 )(5.1) 1()(1)1()()1(22k u k y k y k y k y k y +-++-=+ 首先利用[-1,1]区间的随机信号u(k), 样本点500,输入到上述系统,产生y(k), 用于训练BP 网络;网络测试,利用u(k)=sin(2*pi*k/10)+1/5*sin(2*pi*k/100),测试点300~500,输入到上述系统,产生y(k),检验BP 网络建模效果要求给出程序流程,matlab 程序否则c 程序,训练样本输入输出图形,检验结果的输入输出曲线。 试列举神经网络PID 控制器的几种基本形式,给出相应的原理框图。 试论述连续Hopfield 网络的工作原理,讨论网络状态变化稳定的条件。 谈谈学习神经网络课程后的心得体会,你准备如何在你的硕士(博士)课题中应用神经网络理论和知识解决问题(给出一到两个例)。

卷积神经网络CNN原理、改进及应用

一、简介 卷积神经网络(Convolutional Neural Networks,简称CNN)是近年发展起来,并引起广泛重视的一种高效的识别方法。 1962年,Hubel和Wiesel在研究猫脑皮层中用于局部敏感和方向选择的神经元时发现其独特的局部互连网络结构可以有效地降低反馈神经网络的复杂性,继而提出了卷积神经网络[1](Convolutional Neural Networks-简称CNN)7863。现在,CNN已经成为众多科学领域的研究热点之一,特别是在模式分类领域,由于该网络避免了对图像的复杂前期预处理,可以直接输入原始图像,因而得到了更为广泛的应用。 Fukushima在1980年基于神经元间的局部连通性和图像的层次组织转换,为解决模式识别问题,提出的新识别机(Neocognitron)是卷积神经网络的第一个实现网络[2]。他指出,当在不同位置应用具有相同参数的神经元作为前一层的patches时,能够实现平移不变性1296。随着1986年BP算法以及T-C问题[3](即权值共享和池化)9508的提出,LeCun和其合作者遵循这一想法,使用误差梯度(the error gradient)设计和训练卷积神经网络,在一些模式识别任务中获得了最先进的性能[4][5]。在1998年,他们建立了一个多层人工神经网络,被称为LeNet-5[5],用于手写数字分类,这是第一个正式的卷积神经网络模型3579。类似于一般的神经网络,LeNet-5有多层,利用BP算法来训练参数。它可以获得原始图像的有效表示,使得直接从原始像素(几乎不经过预处理)中识别视觉模式成为可能。然而,由于当时大型训练数据和计算能力的缺乏,使得LeNet-5在面对更复杂的问题时,如大规模图像和视频分类,不能表现出良好的性能。 因此,在接下来近十年的时间里,卷积神经网络的相关研究趋于停滞,原因有两个:一是研究人员意识到多层神经网络在进行BP训练时的计算量极其之大,当时的硬件计算能力完全不可能实现;二是包括SVM在内的浅层机器学习算法也渐渐开始暂露头脚。直到2006年,Hinton终于一鸣惊人,在《科学》上发表文章,使得CNN再度觉醒,并取得长足发展。随后,更多的科研工作者对该网络进行了改进。其中,值得注意的是Krizhevsky等人提出的一个经典的CNN架构,相对于图像分类任务之前的方法,在性能方面表现出了显著的改善2674。他们方法的整体架构,即AlexNet[9](也叫ImageNet),与LeNet-5相似,但具有更深的结构。它包括8个学习层(5个卷积与池化层和3个全连接层),前边的几层划分到2个GPU上,(和ImageNet是同一个)并且它在卷积层使用ReLU作为非线性激活函数,在全连接层使用Dropout减少过拟合。该深度网络在ImageNet 大赛上夺冠,进一步掀起了CNN学习热潮。 一般地,CNN包括两种基本的计算,其一为特征提取,每个神经元的输入与前一层的局部接受域相连,并提取该局部的特征。一旦该局部特征被提取后,它与其它特征间的位置关系也随之确定下来;其二是特征映射,网络的每个计算层由多个特征映射组成,每个特征映射是一个平面,平面上所有神经元的权值相等。特征映射结构采用影响函数核小的sigmoid函数作为卷积网络的激活函数,使得特征映射具有位移不变性。此外,由于一个映射面上的神经元共享权值,因而减少了网络自由参数的个数。这两种操作形成了CNN的卷积层。此外,卷积神经网络中的每一个卷积层都紧跟着一个用来求局部平均与二次提取的计算层,即池化层,这种特有的两次特征提取结构减小了特征分辨率。

基于神经网络专家系统的研究与应用

摘要 现代化的建设需要信息技术的支持,专家系统是一种智能化的信息技术,它的应用改变了过去社会各领域生产基层领导者决策的盲目性和主观性,缓解了我国各领域技术推广人员不足的矛盾,促进了社会的持续发展。但传统专家系统只能处理显性的表面的知识,存在推理能力弱,智能水平低等缺点,所以本文引入了神经网络技术来克服传统专家系统的不足,来试图解决专家系统中存在的关系复杂、边界模糊等难于用规则或数学模型严格描述的问题。本文采用神经网络进行大部分的知识获取及推理功能,将网络输出结果转换成专家系统推理机能接受的形式,由专家系统的推理机得到问题的最后结果。最后,根据论文中的理论建造了棉铃虫害预测的专家系统,能够准确预测棉铃虫的发病程度,并能给用户提出防治建议及措施。有力地说明了本论文中所建造的专家系统在一定程度上解决了传统专家系统在知识获取上的“瓶颈”问题,实现了神经网络的并行推理,神经网络在专家系统中的应用具有较好的发展前景。 关键词神经网络专家系统推理机面向对象知识获取

Abstract Modern construction needs the support of IT, expert system is the IT of a kind of intelligence, its application has changed past social each field production subjectivity and the blindness of grass-roots leader decision-making, have alleviated the contradiction that each field technical popularization of our country has insufficient people, the continued development that has promoted society. But traditional expert system can only handle the surface of dominance knowledge, existence has weak inference ability, intelligent level is low, so this paper has led into artificial neural network technology to surmount the deficiency of traditional expert system, attempt the relation that solution has in expert system complex, boundary is fuzzy etc. are hard to describe strictly with regular or mathematics model. This paper carries out the most of knowledge with neural network to get and infer function , changes network output as a result into expert system, inference function the form of accepting , the inference machine from expert system gets the final result of problem. Finally, have built the expert system of the cotton bell forecast of insect pest according to the theory in this thesis, can accurate forecast cotton bell insect become sick degree, and can make prevention suggestion and measure to user. Have proved on certain degree the expert system built using this tool have solved traditional expert system in knowledge the problem of " bottleneck " that gotten , the parallel inference that has realized neural network, Neural network in expert system application has the better prospect for development. Key words Neural network Expert system Reasoning engine Object-orientation Knowledge acquisition

(完整版)卷积神经网络CNN原理、改进及应用

卷积神经网络(CNN) 一、简介 卷积神经网络(Convolutional Neural Networks,简称CNN)是近年发展起来,并引起广泛重视的一种高效的识别方法。 1962年,Hubel和Wiesel在研究猫脑皮层中用于局部敏感和方向选择的神经元时发现其独特的局部互连网络结构可以有效地降低反馈神经网络的复杂性,继而提出了卷积神经网络[1](Convolutional Neural Networks-简称CNN)7863。现在,CNN已经成为众多科学领域的研究热点之一,特别是在模式分类领域,由于该网络避免了对图像的复杂前期预处理,可以直接输入原始图像,因而得到了更为广泛的应用。 Fukushima在1980年基于神经元间的局部连通性和图像的层次组织转换,为解决模式识别问题,提出的新识别机(Neocognitron)是卷积神经网络的第一个实现网络[2]。他指出,当在不同位置应用具有相同参数的神经元作为前一层的patches时,能够实现平移不变性1296。随着1986年BP算法以及T-C问题[3](即权值共享和池化)9508的提出,LeCun和其合作者遵循这一想法,使用误差梯度(the error gradient)设计和训练卷积神经网络,在一些模式识别任务中获得了最先进的性能[4][5]。在1998年,他们建立了一个多层人工神经网络,被称为LeNet-5[5],用于手写数字分类,这是第一个正式的卷积神经网

络模型3579。类似于一般的神经网络,LeNet-5有多层,利用BP算法来训练参数。它可以获得原始图像的有效表示,使得直接从原始像素(几乎不经过预处理)中识别视觉模式成为可能。然而,由于当时大型训练数据和计算能力的缺乏,使得LeNet-5在面对更复杂的问题时,如大规模图像和视频分类,不能表现出良好的性能。 因此,在接下来近十年的时间里,卷积神经网络的相关研究趋于停滞,原因有两个:一是研究人员意识到多层神经网络在进行BP训练时的计算量极其之大,当时的硬件计算能力完全不可能实现;二是包括SVM在内的浅层机器学习算法也渐渐开始暂露头脚。直到2006年,Hinton终于一鸣惊人,在《科学》上发表文章,使得CNN再度觉醒,并取得长足发展。随后,更多的科研工作者对该网络进行了改进。其中,值得注意的是Krizhevsky等人提出的一个经典的CNN架构,相对于图像分类任务之前的方法,在性能方面表现出了显著的改善2674。他们方法的整体架构,即AlexNet[9](也叫ImageNet),与LeNet-5相似,但具有更深的结构。它包括8个学习层(5个卷积与池化层和3个全连接层),前边的几层划分到2个GPU上,(和ImageNet 是同一个)并且它在卷积层使用ReLU作为非线性激活函数,在全连接层使用Dropout减少过拟合。该深度网络在ImageNet大赛上夺冠,进一步掀起了CNN学习热潮。 一般地,CNN包括两种基本的计算,其一为特征提取,每个神经元的输入与前一层的局部接受域相连,并提取该局部的特征。一旦该

基于深度卷积神经网络的图像分类

Equation Chapter 1 Section 1 令狐采学 SHANGHAI JIAO TONG UNIVERSITY 论文题目:基于卷积神经网络的自然图像分类技术研究 姓名: 高小宁 专业:控制科学与工程

基于卷积神经网络的自然图像分类技术研究 摘要:卷积神经网络已在图像分类领域取得了很好的效果,但其网络结构及参数的选择对图像分类的效果和效率有较年夜的影响。为改良卷积网络的图像分类性能,本文对卷积神经网络模型进行了详细的理论阐发,并通过年夜量的比较实验,得出了影响卷积网络性能的因素。结合理论阐发及比较实验,本文设计了一个卷积层数为8层的深度卷积网络,并结合Batch Normalization、dropout等办法,在CIFAR10数据集上取得了88.1%的分类精度,有效地提高了卷积神经网络的分类效果。 关键词:卷积神经网络,图像分类,Batch Normalization,Dropout Research on Natural Image Classification Based on Convolution Neural Network Abstract: Convolution neural network has achieved very good results in image classification, but its network structure and the choice of parameters have a greater impact on image classification efficiency and efficiency. In order to improve the image classification performance of the convolution network, a convolutional neural network model is analyzed in detail, and a large number of contrastive experiments are conducted to get the factors that influence the performance of the convolution network. Combining the theory analysis and contrast experiment, a convolution layer depth convolution network with 8 layers is designed. Combined with Batch Normalization and dropout, 88.1% classification accuracy is achieved on CIFAR10 dataset. Which improves the classification effect of convolution neural network. Key Words:Convolution neural network(CNN), image classification, Batch Normalization,Dropout 目录 基于卷积神经网络的自然图像分类技术研究- 1 - 1引言-2- 2卷积神经网络的模型阐发-3- 2.1网络基本拓扑结构- 3 - 2.2卷积和池化- 4 - 2.3激活函数- 5 - 2.4 Softmax分类器与价格函数- 6 - 2.5学习算法- 7 - 2.6 Dropout- 9 - 2.7 Batch Normalization- 10 - 3模型设计与实验阐发-10- 3.1 CIFAR10数据集- 10 - 3.2 模型设计- 11 -