R语言-缺失值处理 - cloudtj

R语言-缺失值处理5 - cloudtj - 博客园R语言:缺失值处理

前言

刚接触缺失数据研究的读者可能会被各式各样的方法和言论弄得眼花缭乱。该领域经典的读本是Little和Rubin的Statistical Analysis with Missing Data, Second Edition(2002)一书。其他比较优秀的专著还有Allison的Missing Data(2001)、Schafer和Graham的"Missing Data: Our View of the State of the Art"(2002),以及Schlomer、Bauman和Card的"Best Practices for Missing Data Management in Counseling Psychology"(2010)。

一个完整的处理方法通常包含以下几个步骤:

(1) 识别缺失数据;

(2) 检查导致数据缺失的原因;

(3) 删除包含缺失值的实例或用合理的数值代替(插补)缺失值。

但遗憾的是,仅有识别缺失数据是最清晰明确的步骤。知道数据为何缺失依赖于你对数据生成过程的理解,而决定如何处理缺失值则需要判断哪种方法的结果最为可靠和精确。

统计学家通常将缺失数据分为三类。它们都用概率术语进行描述,但思想都非常直观。我们将用sleep研究中对做梦时长的测量(有12个动物有缺失值)来依次阐述三种类型。

(1) 完全随机缺失若某变量的缺失数据与其他任何观测或未观测变量都不相关,则数据为完全随机缺失(MCAR)。若12个动物的做梦时长值缺失不是由于系统原因,那么可认为数据是MCAR。注意,如果每个有缺失值的变量都是MCAR,那么可以将数据完整的实例看做是对更大数据集的一个简单随机抽样。

(2) 随机缺失若某变量上的缺失数据与其他观测变量相关,与它自己的未观测值不相关,则数据为随机缺失(MAR)。例如,体重较小的动物更可能有做梦时长的缺失值(可能因为较小的动物较难观察),“缺失”与动物的做梦时长无关,那么该数据就可以认为是MAR。此时,一旦你控制了体重变量,做梦时长数据的缺失与出现将是随机的。

(3) 非随机缺失若缺失数据不属于MCAR或MAR,则数据为非随机缺失(NMAR)。例如,做梦时长越短的动物也更可能有做梦数据的缺失(可能由于难以测量时长较短的事件),那么数据可认为是NMAR。大部分处理缺失数据的方法都假定数据是MCAR或MAR。此时,你可以忽略缺失数据的生成机制,并且(在替换或删除缺失数据后)可以直接对感兴趣的关系进行建模。当数据是NMAR 时,想对它进行恰当地分析比较困难,你既要对感兴趣的关系进行建模,还要对缺失值的生成机制进行建模。

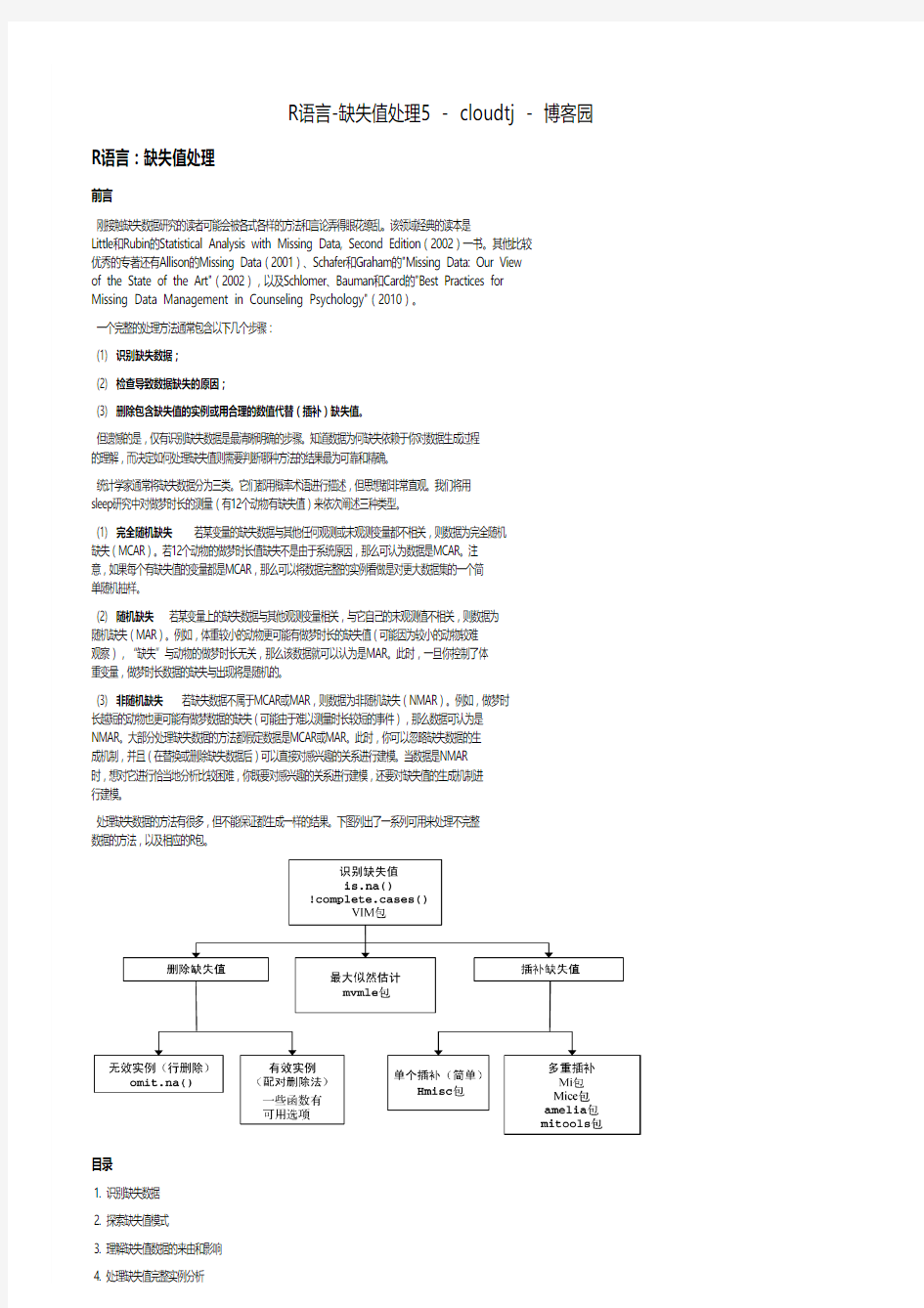

处理缺失数据的方法有很多,但不能保证都生成一样的结果。下图列出了一系列可用来处理不完整数据的方法,以及相应的R包。

目录

1. 识别缺失数据

2. 探索缺失值模式

3. 理解缺失值数据的来由和影响

4. 处理缺失值完整实例分析

5. 处理缺失值的其他方法

主要程序包

install.packages(c("VIM","mice")) library(VIM) library(mice)

1. 识别缺失数据

首先,我们回顾一下前节的内容并地一步拓展。R使用NA(不可得)代表缺失值,NaN(不是一个数)代表不可能的值。另外,符号Inf和-Inf分别代表正无穷和负无穷。函数is.na()、is.nan()和is.infinite()可分别用来识别缺失值、不可能值和无穷值。每个返回结果都是TRUE或FALSE。表15-1给出了一些示例。

这些函数返回的对象与其自身参数的个数相同。若每个元素的类型检验通过,则由TRUE替换,否则用FALSE替换。例如,令y <- c(1, 2, 3, NA),则is.na(y)返回向量c(FALSE, FALSE, FALSE,TRUE)。

函数complete.cases()可用来识别矩阵或数据框中没有缺失值的行。若每行都包含完整的实例,则返回TRUE的逻辑向量;若每行有一个或多个缺失值,则返回FALSE。

对于识别缺失值,有两点需要牢记。第一点,complete.cases()函数仅将NA和NaN识别为缺失值,无穷值(Inf和-Inf)被当做有效值。第二点,必须使用与本章中类似的缺失值函数来识别R数据对象中的缺失值。像myvar == NA这样的逻辑比较无法实现。

NA:代表缺失值; NaN:代表不可能的值; Inf:代表正无穷; -Inf:代表负无穷。 is.na():识别缺失值; is.nan():识别不可能值; is.infinite():无穷值。 is.na()、is.nan()和is.infinte()函数的返回值示例

2. 探索缺失值模式

在决定如何处理缺失数据前,了解哪些变量有缺失值、数目有多少、是什么组合形式等信息非常有用。本节中,我们将介绍探索缺失值模式的图表及相关方法。最后,如果知道了数据为何缺失,这将为后续深入研究提供许多启示。

2.1 列表显示缺失值

你已经学习了一些识别缺失值的基本方法。比如使用complete.cases()函数列出完整的实例,或者相反,列出含一个或多个缺失值的实例。但随着数据集的增大,该方法就逐渐丧失了吸引力。此时你可以转向其他R函数。

mice包中的md.pattern()函数可生成一个以矩阵或数据框形式展示缺失值模式的表格。将函数应用到sleep数据集,可得到:

> library(mice) > data(sleep,package="VIM") > md.pattern(sleep) Body Wgt BrainWgt Pred Exp Danger Sleep Span Gest Dream NonD 42111111111102111111011113 1111111011191111111100221111101110211111110011221111101100311111110100300000444121438

表中1和0显示了缺失值模式,0表示变量的列中有缺失值,1则表示没有缺失值。第一行表述了“无缺失值”的模式(所有元素都为1)。第二行表述了“除了Span之外无缺失值”的模式。第一列表示各缺失值模式的实例个数,最后一列表示各模式中有缺失值的变量的个数。此处可以看到,有42个

实例没有缺失值,仅2个实例缺失了Span。9个实例同时缺失了NonD和Dream的值。数据集包含了总共(42 × 0) + (2 × 1) + … + (1 × 3) = 38个缺失值。最后一行给出了每个变量中缺失值的数目。

2.2 图形探究缺失数据

虽然md.pattern()函数的表格输出非常简洁,但我通常觉得用图形展示模式更为清晰。VIM包提供了大量能可视化数据集中缺失值模式的函数,本节我们将学习其中几个:aggr()、matrixplot()和scattMiss()。aggr()函数不仅绘制每个变量的缺失值数,还绘制每个变量组合的缺失值数。

2.2.1 例1:使用函数aggr()函数绘图。

library("VIM") aggr(sleep,prop=FALSE,numbers=TRUE) aggr(sleep, prop = TRUE, numb ers = TRUE)

上述代码的结果见下图。

(VIM包将会打开GUI界面,你可以关闭它;本章我们使用代码完成所有的工作。)可以看到,变量NonD有最大的缺失值数(14),有2个哺乳动物缺失了NonD、Dream和Sleep的评分。42个动物没有缺失值。

代码aggr(sleep, prop = TRUE, numbers = TRUE)将生成相同的图形,但用比例代替了计数。选项numbers = FALSE(默认)删去数值型标签。

2.2.2 例2:使用函数matrixplot()函数绘图。

matrixplot(sleep)

matrixplot()函数可生成展示每个实例数据的图形。matrixplot(sleep)的图形见下图。

此处,数值型数据被重新转换到[0, 1]区间,并用灰度来表示大小:浅色表示值小,深色表示值大。默认缺失值为红色。

该图形可以进行交互,单击一列将会按其对应的变量重排矩阵。图中的行便按BodyWgt降序排列。通过矩阵图,你可以看出某些变量的缺失值模式是否与其他变量的真实值有关联。此图中可以看到,无缺失值的睡眠变量(Dream、NonD和Sleep)对应着较小的体重(BodyWgt)或脑重(BrainWgt)。

2.2.3 例3:使用函数marginplot()函数绘图。

marginplot()函数可生成一幅散点图,在图形边界展示两个变量的缺失值信息。以做梦时长与哺乳动物妊娠期时长的关系为例,来看下列代码:它的生成图形见下图。参数pch和col为可选项,控制着绘图符号和使用的颜色。

library("VIM") marginplot(sleep[c("Gest","Dream")],pch=c(20),col=c("darkgray"," red","blue"))

图形的主体是Gest和Dream(两变量数据都完整)的散点图。左边界的箱线图展示的是包含(深灰色)与不包含(红色)Gest值的Dream变量分布。注意,在灰度图上红色是更深的阴影。四个红色的点代表着缺失了Gest得分的Dream值。在底部边界上,Gest和Dream间的关系反过来了。可以看到,妊娠期和做梦时长呈负相关,缺失妊娠期数据时动物的做梦时长一般更长。两个变量均有缺失值的观测个数在两边界交叉处(左下角)用蓝色输出。VIM包有许多图形可以帮助你理解缺失数据在数据集中的模式,包括用散点图、箱线图、直方图、散点图矩阵、平行坐标图、轴须图和气泡图来展示缺失值的信息,因此这个包很值得探索。

2.3 用相关性探索缺失值

影子矩阵:用指示变量替代数据集中的数据(1表示缺失,0表示存在),这样生成的矩阵有时称作影子矩阵。

求这些指示变量间和它们与初始(可观测)变量间的相关性,有且于观察哪些变量常一起缺失,以及分析变量“缺失”与其他变量间的关系。

head(sleep) str(sleep) x<-as.data.frame(abs(is.na(sleep))) head(sleep,n=5) head(x,n=5) y<-x[which(sd(x)>0)] cor(y) cor(sleep,y,use="https://www.360docs.net/doc/f44768700.html,plete.o bs")

3. 理解缺失值数据的来由和影响

识别缺失数据的数目、分布和模式有两个目的:

(1)分析生成缺失数据的潜在机制;

(2)评价缺失数据对回答实质性问题的影响。

即:

(1)缺失数据的比例有多大?

(2)缺失数据是否集中在少数几个变量上,抑或广泛存在?

(3)缺失是随机产生的吗?

(4)缺失数据间的相关性或与可观测数据间的相关性,是否可以表明产生缺失值的机制呢?

若缺失数据集中在几个相对不太重要的变量上,则可以删除这些变量,然后再进行正常的数据分析;

若有一小部分数据随机分布在整个数据集中(MCAR),则可以分析数据完整的实例,这样仍可得到可靠有效的结果;

若以假定数据是MCAR或MAR,则可以应用多重插补法来获得有铲的结论。

若数据是NMAR,则需要借助专门的方法,收集新数据,或加入一个相对更容易、更有收益的行业。

4. 处理缺失值完整实例分析

4.1 行删除

函数complete.cases()、na.omit()可用来存储没有缺失值的数据框或矩阵形式的实例(行):

# code1 newdata<-mydata[complete.cases(mydata),] newdata<-na.omit(mydata) # code2 options(digits=1) cor(na.omit(sleep)) cor(sleep,use="complete.ob s") fit<-lm(Dream~Span+Gest,data=na.omit(sleep)) summary(fit)

4.2 多重插补

多重插补(MI)是一种基于重复模拟的处理缺失值的方法。

MI从一个包含缺失值的数据集中生成一组完整的数据集。每个模拟数据集中,缺失数据将使用蒙特卡洛方法来填补。

此时,标准的统计方法便可应用到每个模拟的数据集上,通过组合输出结果给出估计的结果,以及引入缺失值时的置信敬意。

可用到的包Amelia、mice和mi包

mice() 函数首先从一个包含缺失数据的数据框开始,然后返回一个包含多个完整数据集的对象。每个完整数据集都是通过对原始数据框中的缺失数据进行插而生成的。

with() 函数可依次对每个完整数据集应用统计模型

pool() 函数将这些单独的分析结果整合为一组结果。

最终模型的标准误和p值都将准确地反映出由于缺失值和多重插补而产生的不确定性。

基于mice包的分析通常符合以下分析过程:

# 示例说明code library(mice) imp<-mice(mydata,m) fit<-with(imp,analysis) pooled<-pool(fit) summary(pooled) # mydata是一个饮食缺失值的矩阵或数据框; # imp是一个包含m个插补数据集的列表对象,同时还含有完成插补过程的信息,默认的m=5 # analysis是一个表达式对象,用来设定应用于m个插补的统计分析方法。方法包括做线回归模型的lm()函数、做广义线性模型的glm()函数、做广义可加模型的gam()、及做负二项模型的nbrm()函数。# fit是一个包含m个单独统计分析结果的列表对象; # poo led是一个包含这m个统计分析平均结果的列表对象。

具体例子实现过程

> library(mice) > data(sleep,package="VIM") > imp <- mice(sleep,seed=1234) iter imp variable 11 NonD Dream Sleep Span Gest 12 NonD Dream Sleep Span Gest 13 NonD Dream Sleep Span Gest 14 NonD Dream Sleep Span Gest 15 NonD Dream Sleep Span Gest 21 NonD Dream Sleep Span Ge st 22 NonD Dream Sleep Span Gest 23 NonD Dream Sleep Span Gest 24 NonD Dream Sleep Span Gest 25 NonD Dream Sleep Span Gest 31 NonD Dream Sleep Span Gest 32 NonD Dream Sleep Span Gest 33 NonD Dream Sleep Span Gest 34 NonD Dream Sleep Span Gest 35 NonD Dream Sleep Span Gest 41 NonD Dream Sleep Span Gest 42 NonD Dream Sleep Span Ge st 43 NonD Dream Sleep Span Gest 44 NonD Dream Sleep Span Gest 45 NonD Dream Sleep Span Gest 51 NonD Dream Sleep Span Gest 52 NonD Dream Sleep Span Gest 53 NonD Dream Sleep Span Gest 54 NonD Dream Sleep Span Gest 55 NonD Dream Sleep Span Gest > fit <- with(imp,lm(Dream ~Span+Gest)) > pooled <- pool(fit) > summary(pooled) est se t df Pr(>|t|) lo 95 hi 95 nmis fmi lambda (Intercept) 2.5460.25510.0521e-1 32.0353.057 NA 0.090.05 Span -0.0050.012-0.4527e-01-0.0290.02040.090.05 G est -0.0040.001-2.7561e-02-0.007-0.00140.050.02 > imp Multiply imputed data set Call: mice(data = sleep, seed = 1234) Number of multiple imputations: 5 Missing cells per column: BodyWgt BrainWgt NonD Dream Sleep Span Gest Pred Exp Danger 001412444000 Imputation methods: Bod yWgt BrainWgt NonD Dream Sleep Span Gest Pred Exp Danger """""pmm""pmm""pmm""pmm""pmm""""""" VisitSequence: NonD Dream Sleep Span Gest 34567 PredictorMatrix: BodyWgt BrainWgt NonD Dream Sleep S pan Gest Pred Exp Danger BodyWgt 0000000000 BrainWgt 0000000000 No nD 1101111111 Dream 1110111111 Sleep 1111011111 Spa n 1111101111 Gest 1111110111 Pred 0000000000 Exp 0000000000 Danger 0000000000 Random generator seed value: 1234 > imp$imp$Dream 1234511.00.50.50.50.332.62.11.51.81.343.43.13.41.23.4140.

30.50.50.31.2241.81.33.60.95.6262.33.12.02.62.1301.20.33.42.62.3313.40.50.61.00.5470.51.

51.52.23.4530.30.50.50.50.6550.50.92.62.72.4621.02.10.53.93.6 > > > # 利用com plete()函数可观察m个插补数据集中的任意一个,格式为:complete(imp,action=#) > # eg: > > dataset3<-complete(imp,action=3) > dataset3 BodyWgt BrainWgt NonD Dream S leep Span Gest Pred Exp Danger 17e+036e+0320.533964535321e+007e+0062.0844231333e+004e +01111.512146011149e-016e+00133.41622552353e+035e+0321.846962435461e+012e+0290.710271804 4472e-023e-01163.920193511182e+022e+0251.063039245493e+003e+01113.6142863121105e+014e+02 81.41050230111114e-016e+00111.5127112544125e+024e+0230.7430281555136e-012e+0082.71018462 12142e+024e+0230.5340365555157e-021e+0062.184********e+002e+0190.095028222178e-014e+0074 .111642222182e-015e+00101.21110120222191e+002e+0151.363428121206e+018e+01126.11872111121 5e+027e+02110.31128400555223e+011e+0230.5420148555231e-011e+00113.414416312242e+024e+028 3.61239252141258e+013e+0251.5641310131264e+011e+02112.0131663111271e-014e+00103.41492851 3281e+006e+0070.88868534295e+027e+0220.8346336555301e+022e+0273.41122100111314e+016e+013 0.641633354325e-031e-0181.49322524331e-022e-01182.0202450111346e+011e+0361.9810026711135 1e-013e+0082.4111330211361e+008e+0082.811445313372e-024e-01121.313319413385e-023e-01112. 013230413392e+006e+00145.619512211404e+001e+01143.1176120211412e+025e+0281.0824440555425 e-012e+01151.81712140222431e+011e+02100.91120170444442e+001e+01121.8141317212452e+022e+0 261.9827115444462e+001e+0180.981831555474e+004e+01111.5121463222483e-012e+00112.61352131 3494e+005e+0172.4101052111507e+002e+0281.21029164232518e-011e+0160.977225222524e+002e+01 50.556225323531e+011e+0220.5317150555546e+012e+0230.6420151555551e+001e+0182.61113902225 66e-021e+0082.2104100312579e-013e+00112.313460212582e+001e+0150.558200313591e-012e+00132 .616246322604e+006e+01100.61024210434614e+004e+00136.619314211624e+002e+01180.5191338311

Matlab笔记——数据预处理——剔除异常值及平滑处理

012. 数据预处理(1)——剔除异常值及平滑处理测量数据在其采集与传输过程中,由于环境干扰或人为因素有可能造成个别数据不切合实际或丢失,这种数据称为异常值。为了恢复数据的客观真实性以便将来得到更好的分析结果,有必要先对原始数据(1)剔除异常值; 另外,无论是人工观测的数据还是由数据采集系统获取的数据,都不可避免叠加上“噪声”干扰(反映在曲线图形上就是一些“毛刺和尖峰”)。为了提高数据的质量,必须对数据进行(2)平滑处理(去噪声干扰); (一)剔除异常值。 注:若是有空缺值,或导入Matlab数据显示为“NaN”(非数),需要①忽略整条空缺值数据,或者②填上空缺值。 填空缺值的方法,通常有两种:A. 使用样本平均值填充;B. 使用判定树或贝叶斯分类等方法推导最可能的值填充(略)。 一、基本思想: 规定一个置信水平,确定一个置信限度,凡是超过该限度的误差,就认为它是异常值,从而予以剔除。

二、常用方法:拉依达方法、肖维勒方法、一阶差分法。 注意:这些方法都是假设数据依正态分布为前提的。 1. 拉依达方法(非等置信概率) 如果某测量值与平均值之差大于标准偏差的三倍,则予以剔除。 3x i x x S -> 其中,11n i i x x n ==∑为样本均值,1 2 2 11()1n x i i S x x n =?? ??? =--∑为样本的标准偏差。 注:适合大样本数据,建议测量次数≥50次。 代码实例(略)。 2. 肖维勒方法(等置信概率) 在 n 次测量结果中,如果某误差可能出现的次数小于半次时,就予以剔除。 这实质上是规定了置信概率为1-1/2n ,根据这一置信概率,可计算出肖维勒系数,也可从表中查出,当要求不很严格时,还可按下列近似公式计算: 10.4ln()n n ω=+

数据中异常值的处理方法_总

数据中异常值的检测与处理方法 一、数据中的异常值 各种类型的异常值: 数据输入错误:数据收集,记录或输入过程中出现的人为错误可能导致数据异常。例如:一个客户的年收入是$ 100,000。数据输入运算符偶然会在图中增加一个零。现在收入是100万美元,是现在的10倍。显然,与其他人口相比,这将是异常值。 测量误差:这是最常见的异常值来源。这是在使用的测量仪器出现故障时引起的。例如:有10台称重机。其中9个是正确的,1个是错误的。 有问题的机器上的人测量的重量将比组中其他人的更高/更低。在错误的机器上测量的重量可能导致异常值。 实验错误:异常值的另一个原因是实验错误。举例来说:在七名跑步者的100米短跑中,一名跑步者错过了专注于“出发”的信号,导致他迟到。 因此,这导致跑步者的跑步时间比其他跑步者多。他的总运行时间可能是一个离群值。 故意的异常值:这在涉及敏感数据的自我报告的度量中通常被发现。例如:青少年通常会假报他们消耗的酒精量。只有一小部分会报告实际价值。 这里的实际值可能看起来像异常值,因为其余的青少年正在假报消费量。 数据处理错误:当我们进行数据挖掘时,我们从多个来源提取数据。某些操作或提取错误可能会导致数据集中的异常值。 抽样错误:例如,我们必须测量运动员的身高。错误地,我们在样本中包括一些篮球运动员。这个包含可能会导致数据集中的异常值。 自然异常值:当异常值不是人为的(由于错误),这是一个自然的异常值。例如:保险公司的前50名理财顾问的表现远远高于其他人。令人惊讶的是,这不是由于任何错误。因此,进行任何数据挖掘时,我们会分别处理这个细分的数据。

在以上的异常值类型中,对于房地产数据,可能出现的异常值类型主 要有:(1)数据输入错误,例如房产经纪人在发布房源信息时由于输入错误,而导致房价、面积等相关信息的异常;在数据的提取过程中也可能会出现异常值,比如在提取出售二手房单价时,遇到“1室7800元/m 2”,提取其中的数字结果为“17800”,这样就造成了该条案例的单价远远异常于同一小区的其他房源价格,如果没有去掉这个异常值,将会导致整个小区的房屋单价均值偏高,与实际不符。(2)故意的异常值,可能会存在一些人,为了吸引别人来电询问房源,故意把价格压低,比如房屋单价为1元等等;(3)自然异常值。房价中也会有一些实际就是比普通住宅价格高很多的真实价格,这个就需要根据实际请况进行判断,或在有需求时单独分析。 二、数据中异常值的检测 各种类型的异常值检测: 1、四分位数展布法 方法[1]:大于下四分位数加倍四分位距或小于上四分位数减倍。 把数据按照从小到大排序,其中25%为下四分位用FL 表示,75%处为上四分位用FU 表示。 计算展布为:L U F F F d -=,展布(间距)为上四分位数减去下四分位数。 最小估计值(下截断点):F L d F 5.1- 最大估计值(上截断点):F U d F 5.1+ 数据集中任意数用X 表示,F U F L d F X d F 5.15.1+<<-, 上面的参数不是绝对的,而是根据经验,但是效果很好。计算的是中度异常,参数等于3时,计算的是极度异常。我们把异常值定义为小于下截断点,或者大于上截断点的数据称为异常值。

回归中缺失值处理方法

在《SPSS统计分析方法及应用》一书中,对时间序列数据缺失处理给出了几种解决方法,可以供我们设计的时候参考: 新生成一个由用户命名的序列,选择处理缺失值的替代方法,单击Change按钮。替代方法有以下几种: ①Series mean:表示用整个序列的均值作为替代值。 ②Mean of nearby points:表示利用邻近点的均值作为替代值。对此用Span of nearby points框指定数据段。在Number后输入数值k,以表示缺失值为中心,前后分别选取k个数据点。这样填补的值就是由这2k个数的平均数。也可以选择All,作用同Series mean选项。 “附(邻)近点的跨度”:系统默认的是2,即缺失值上下两个观察值作为范围。

若选择“全部”,即将所有的观察值作为临近点。 ③Median of nearby points:表示利用邻近点的中位数作为替代值。数据指定方法同上。 ④Linear interpolation:为线性插值法,表示利用缺失值前后两时点数据的某种线性组合进行填补,是一种加权平均。 线性插值法应用线性插值法填补缺失值。用该列数据缺失值前一个数据和后一个数据建立插值直线,然后用缺失点在线性插值函数的函数值填充该缺失值。如果前后值有一个缺失,则得不到缺失值的替换值。 ⑤Linear trend at point:为线性趋势值法,表示利用回归拟合线的拟合值作为替代值。 缺失点处的线性趋势法应用缺失值所在的整个序列建立线性回归方程,然后用该回归方程在缺失点的预测值填充缺失值。 *注意:如果序列的第一个和最后一个数据为缺失值,只能利用序列均值和线性趋势值法处理,其他方法不适用。

qc检验异常值处理标准操作规程.doc

QC检验异常值处理标准操作规程 1目的 本程序规定了QC所涉及的各检验项目出现检验结果异常情况的处理原则和管理办法。通过实施本程序,对产品检验结果异常情况进行规范管理。 2 管理程序 1) 检验结果异常的处理原则 凡出现下列情况均属异常,必须填写《检验异常值发生的初期调查报告书》见附表一异常值:指在药品生产的试验检验中,相当于下面a~e的任何一个的所有测定值。 a 超出《药品生产批准、公定书,以及公司内部标准书中所规定的标准》的检验结果 b 虽然符合2.1的标准,但超过管理范围的检验结果。 c 在重复测定次数n=2以上的计量试验中,偏离检验标准规格幅度的1/2以上的最 大,最小的各试验结果。 d 检测以及验证等中,超出“期待结果”的试验结果 e 在长期稳定性试验中,超出质量标准时,或者特别做出的试验实施方案中,超出上 面所规定的规格的试验结果。 2) 管理范围:仅在最终成品检验的定量检验中设定。指和检验标准规格不同,为根据 日常的检验结果成品质量的偏差如下所示,作为范围数据化的值。考虑规格值和分析的精确度,难以设定管理范围的计量仪器除外。 3) 检验分析责任者:具有质量管理方面丰富的知识,在品质总责任者的领导下进行总管分析实施人的人员。 4)对照品:指过去没有发现异常的批留样中,最新的批次。用于初期调查。 5)再分析:供试品溶液,标准溶液的第二次分析(包括从同样的试验用标准溶液中的 稀释) 6) 复验:从同样的容器中准备的样品,作为初次检验的追加检验。 3 产生异常值时的处理 分析实施人要充分理解试验操作中对测定值造成较大影响的点。用于检验的装置都要进行校验。作为检验方法规定了系统符合性试验时,必须实施。

心理学研究中缺失值处理方法比较

Advances in Psychology 心理学进展, 2019, 9(11), 1843-1849 Published Online November 2019 in Hans. https://www.360docs.net/doc/f44768700.html,/journal/ap https://https://www.360docs.net/doc/f44768700.html,/10.12677/ap.2019.911222 Comparison of Methods for Processing Missing Values in Psychological Research An Wang Hangzhou College of Preschool Teacher Education of Zhejiang Normal University, Hangzhou Zhejiang Received: Oct. 9th, 2019; accepted: Oct. 31st, 2019; published: Nov. 7th, 2019 Abstract Missing data is a common but difficult problem to deal with. This paper briefly introduces several mechanisms of missing data and some general methods to deal with missing data. And the charac-teristics of all kinds of missing data processing method and the suitable conditions are compared. Keywords Missing Value, Missing Mechanism, Filling Methods 心理学研究中缺失值处理方法比较 王安 浙江师范大学杭州幼儿师范学院,浙江杭州 收稿日期:2019年10月9日;录用日期:2019年10月31日;发布日期:2019年11月7日 摘要 数据缺失是一个常见但难以处理的问题。文章简要介绍了数据缺失的几种机制,以及处理缺失数据的一般性方法,并对各种缺失数据的处理方法的特点及适用情况进行了比较。 关键词 缺失值,缺失机制,填补方法

回归中缺失值处理方法

回归中缺失值处理方法文稿归稿存档编号:[KKUY-KKIO69-OTM243-OLUI129-G00I-FDQS58-

在《SPSS统计分析方法及应用》一书中,对时间序列数据缺失处理给出了几种解决方法,可以供我们设计的时候参考: 新生成一个由用户命名的序列,选择处理缺失值的替代方法,单击Change按钮。替代方法有以下几种: ①Series mean:表示用整个序列的均值作为替代值。 ②Mean of nearby points:表示利用邻近点的均值作为替代值。对此用Span of nearby points框指定数据段。在Number后输入数值k,以表示缺失值为中心,前后分别选取k个数据点。这样填补的值就是由这2k 个数的平均数。也可以选择All,作用同Series mean选项。 “附(邻)近点的跨度”:系统默认的是2,即缺失值上下两个观察值作为范围。若选择“全部”,即将所有的观察值作为临近点。 ③Median of nearby points:表示利用邻近点的中位数作为替代值。数据指定方法同上。 ④Linear interpolation:为线性插值法,表示利用缺失值前后两时点数据的某种线性组合进行填补,是一种加权平均。 线性插值法应用线性插值法填补缺失值。用该列数据缺失值前一个数据和后一个数据建立插值直线,然后用缺失点在线性插值函数的函数值填充该缺失值。如果前后值有一个缺失,则得不到缺失值的替换值。 ⑤Linear trend at point:为线性趋势值法,表示利用回归拟合线的拟合值作为替代值。 缺失点处的线性趋势法应用缺失值所在的整个序列建立线性回归方程,然后用该回归方程在缺失点的预测值填充缺失值。

spss缺失值处理

spss数据录入时缺失值怎么处理 录入的时候可以直接省略不录入 分析的时候也一般剔除这样的样本。但也有替换的方法,一般有: 均值替换法(mean imputation),即用其他个案中该变量观测值的平均数对缺失的数据进行替换,但这种方法会产生有偏估计,所以并不被推崇。 个别替换法(single imputation)通常也被叫做回归替换法(regression imputation),在该个案的其他变量值都是通过回归估计得到的情况下,这种 方法用缺失数据的条件期望值对它进行替换。这虽然是一个无偏估计,但是却倾向于低估标准差和其他未知性质的测量值,而且这一问题会随着缺失信息的增多而变得更加严重。 多重替代法(multiple imputation)(Rubin, 1977) 。 ?它从相似情况中或根据后来在可观测的数据上得到的缺省数据的分布情况给每个缺省数据赋予一个模拟值。结合这种方法,研究者可以比较容易地,在不舍弃任何数据的情况下对缺失数据的未知性质进行推断(Little and Rubin,1987; ubin,1987, 1996)。 (一)个案剔除法(Listwise Deletion) 最常见、最简单的处理缺失数据的方法是用个案剔除法(listwise deletion),也是很多统计软件(如SPSS和SAS)默认的缺失值处理方法。在这种方法中如果任何一个变量含有缺失数据的话,就把相对应的个案从分析中剔除。如果缺失值所占比例比较小的话,这一方法十分有效。至于具体多大的缺失比例算是“小”比例,专家们意见也存在较大的差距。有学者认为应在5%以下,也有学者认为20%以下即可。然而,这种方法却有很大的局限性。它是以减少样本量来换取信息的完备,会造成资源的大量浪费,丢弃了大量隐藏在这些对象中的信息。在样本量较小的情况下,删除少量对象就足以严重影响到数据的客观性和结果的正确性。因此,当缺失数据所占比例较大,特别是当缺数据非随机分布时,这种方法可能导致数据发生偏离,从而得出错误的结论。 (二)均值替换法(Mean Imputation) 在变量十分重要而所缺失的数据量又较为庞大的时候,个案剔除法就遇到了困难,因为许多有用的数据也同时被剔除。围绕着这一问题,研究者尝试了各种各样的办法。其中的一个方法是均值替换法(mean imputation)。我们将变量的属性分为数值型和非数值型来分别进行处理。如果缺失值是数值型的,就根据该变量在其他所有对象的取值的平均值来填充该缺失的变量值;如果缺失值是非数值型的,就根据统计学中的众数原理,用该变量在其他所有对象的取值次数最多的值来补齐该缺失的变量值。但这种方法会产生有偏估计,所以并不被推崇。均值替换法也是一种简便、快速的缺失数据处理方法。使用均值替换法插补缺失数据,对该变量的均值估计不会产生影响。但这种方法是建立在完全随机缺失(MCAR)的假设之上的,而且会造成变量的方差和标准差变小。 (三)热卡填充法(Hotdecking)

缺失值处理

缺失值 1. is.na 确实值位置判断 注意: 缺失值被认为是不可比较的,即便是与缺失值自身的比较。这意味着无法使用比较运算 符来检测缺失值是否存在。例如,逻辑测试myvar == NA的结果永远不会为TRUE。作为替代,你只能使用处理缺失值的函数(如本节中所述的那些)来识别出R数据对象中的缺失值。 2. na.omit() 删除不完整观测 manyNAs library(DMwR) manyNAs(data, nORp = 0.2) Arguments data A data frame with the data set. nORp A number controlling when a row is considered to have too many NA values (defaults to 0.2, i.e. 20% of the columns). If no rows satisfy the constraint indicated by the user, a

warning is generated. 按照比例判断缺失. 3. knnImputation K 近邻填补 library(DMwR) knnImputation(data, k = 10, scale = T, meth = "weighAvg", distData = NULL) ? 1 ? 2 Arguments Arguments data A data frame with the data set k The number of nearest neighbours to use (defaults to 10) scale Boolean setting if the data should be scale before finding the nearest neighbours (defaults to T) meth String indicating the method used to calculate the value to fill in each NA. Available values are ‘median’ or ‘weighAvg’ (the default). distData Optionally you may sepecify here a data frame containing the data set that should be used to find the neighbours. This is usefull when filling in NA values on a test set, where you should use only information from the training set. This defaults to NULL, which means that the neighbours will be searched in data Details This function uses the k-nearest neighbours to fill in the unknown (NA) values in a data set. For each case with any NA value it will search for its k most similar cases and use the values of these cases to fill in the unknowns.

几种常见的缺失数据插补方法

几种常见的缺失数据插补方法 (一)个案剔除法(Listwise Deletion) 最常见、最简单的处理缺失数据的方法是用个案剔除法(listwise deletion),也是很多统计软件(如SPSS和SAS)默认的缺失值处理方法。在这种方法中如果任何一个变量含有缺失数据的话,就把相对应的个案从分析中剔除。如果缺失值所占比例比较小的话,这一方法十分有效。至于具体多大的缺失比例算是“小”比例,专家们意见也存在较大的差距。有学者认为应在5%以下,也有学者认为20%以下即可。然而,这种方法却有很大的局限性。它是以减少样本量来换取信息的完备,会造成资源的大量浪费,丢弃了大量隐藏在这些对象中的信息。在样本量较小的情况下,删除少量对象就足以严重影响到数据的客观性和结果的正确性。因此,当缺失数据所占比例较大,特别是当缺数据非随机分布时,这种方法可能导致数据发生偏离,从而得出错误的结论。 (二)均值替换法(Mean Imputation) 在变量十分重要而所缺失的数据量又较为庞大的时候,个案剔除法就遇到了困难,因为许多有用的数据也同时被剔除。围绕着这一问题,研究者尝试了各种各样的办法。其中的一个方法是均值替换法(mean imputation)。我们将变量的属性分为数值型和非数值型来分别进行处理。如果缺失值是数值型的,就根据该变量在其他所有对象的取值的平均值来填充该缺失的变量值;如果缺失值是非数值型的,就根据统计学中的众数原理,用该变量在其他所有对象的取值次数最多的值来补齐该缺失的变量值。但这种方法会产生有偏估计,所以并不被推崇。均值替换法也是一种简便、快速的缺失数据处理方法。使用均值替换法插补缺失数据,对该变量的均值估计不会产生影响。但这种方法是建立在完全随机缺失(MCAR)的假设之上的,而且会造成变量的方差和标准差变小。 (三)热卡填充法(Hotdecking)

试验数据异常值的检验及剔除方法

目录 摘要......................................................................... I 关键词...................................................................... I 1引言 (1) 2异常值的判别方法 (1) 检验(3S)准则 (1) 狄克松(Dixon)准则 (2) 格拉布斯(Grubbs)准则 (2) 指数分布时异常值检验 (3) 莱茵达准则(PanTa) (3) 肖维勒准则(Chauvenet) (4) 3 实验异常数据的处理 (4) 4 结束语 (5) 参考文献 (6)

试验数据异常值的检验及剔除方法 摘要:在实验中不可避免会存在一些异常数据,而异常数据的存在会掩盖研究对象的变化规律和对分析结果产生重要的影响,异常值的检验与正确处理是保证原始数据可靠性、平均值与标准差计算准确性的前提.本文简述判别测量值异常的几种统计学方法,并利用DPS软件检验及剔除实验数据中异常值,此方法简单、直观、快捷,适合实验者用于实验的数据处理和分析. 关键词:异常值检验;异常值剔除;DPS;测量数据

1 引言 在实验中,由于测量产生误差,从而导致个别数据出现异常,往往导致结果产生较大的误差,即出现数据的异常.而异常数据的出现会掩盖实验数据的变化规律,以致使研究对象变化规律异常,得出错误结论.因此,正确分析并剔除异常值有助于提高实验精度. 判别实验数据中异常值的步骤是先要检验和分析原始数据的记录、操作方法、实验条件等过程,找出异常值出现的原因并予以剔除. 利用计算机剔除异常值的方法许多专家做了详细的文献[1] 报告.如王鑫,吴先球,用Origin 剔除线形拟合中实验数据的异常值;严昌顺.用计算机快速剔除含粗大误差的“环值”;运用了统计学中各种判别异常值的准则,各种准则的优劣程度将体现在下文. 2 异常值的判别方法 判别异常值的准则很多,常用的有t 检验(3S )准则、狄克松(Dixon )准则、格拉布斯(Grubbs )准则等准则.下面将一一简要介绍. 2.1 检验(3S )准则 t 检验准则又称罗曼诺夫斯基准则,它是按t 分布的实际误差分布范围来判别异常值,对重复测量次数较少的情况比较合理. 基本思想:首先剔除一个可疑值,然后安t 分布来检验被剔除的值是否为异常值. 设样本数据为123,,n x x x x ,若认j x 为可疑值.计算余下1n -个数据平均值 1n x -及标准差1n s - ,即2 111,1,1n n i n i i j x x s n --=≠=-∑. 然后,按t 分布来判别被剔除的值j x 是否为异常值. 若1(,)n j x x kn a -->,则j x 为异常值,应予剔除,否则为正常值,应予以保留.其中:a 为显著水平;n 数据个数;(,)k n a 为检验系数,可通过查表得到.

大数据缺失值处理

这些缺失值不仅意味着信息空白,更重要的是它会影响后续数据挖掘和统计 分析等工作的进行。一般对缺失值处理的方法包括删除不完整记录、当作特殊值处理或者插补空值。显然,插补的方法不管从量上还是质上,对数据的处理结果都要好于前两种。目前国内外已提出了很多有关缺失值填充的方法。尽管这些方法在各自的应用环境下都得到了很好的效果,但仍然存在一些不足。比如,一些模型像决策树需要指定类属性与条件属性,这样的模型每处理一个属性就要训练一次模型,效率很低。其次,很多算法对高维数据的处理能力有限,引入无用的变量不仅影响执行效率,而且会干扰最终填充效果。第三、在没有真值作为对比的情况下,无法评价不同属性的填充效果。最后,很多算法只适用于小数据集,远远无法满足目前对大量数据的处理要求。为解决上述问题,本文给出了一个基于贝叶斯网和概率推理的填充方法。与常用的贝叶斯网构建算法不同,本文针对缺失值填充这一特定的应用前提,从挖掘属性相关性入手构建网络。建立贝叶斯网时不设定任何目标属性,由影响最大的属性作为根。这一过程不需要用户对数据有太多了解,完全由算法自动完成。根据贝叶斯网自身的条件独立性假设可以分解对多维联合概率的求解,降低在处理高维数据时的复杂度。填充值根据概率推理结果得到。推理产生的概率信息能够反映填充值的不确定程度,即概率越小,准确率越低,反之,准确率越高。这就为评价填充质量提供了一个参考。为使算法适用于混合属性集,本文在贝叶斯网中加入了对连续属性的处理,所有属性的填充均在一个模型下完成。针对大数据集,应用并行技术来解决效率问题。本文给出了算法在Map-Reduce 中的实现。实验部分分别验证了贝叶斯网构建算法和概率推理算法的有效性并对比分析了整个填充算法的准确率;并行处理部分给出了并行效率并分析了影响并行性能的因素。

异常值处理

data下拉菜单里有define variable properties,把变量选到右边的框里,点continue,在新窗口中有变量在样本中的所有取值,要定义某个值是异常值,就把相应的missing框勾上就ok 啦~~~然后再处理数据时这些值就已经被剔除,不参与分析了~~~ 使用箱型图Boxplot...发现异常值,然后把大于等于最小异常值或小于等于最大异常值的值 用Data主菜单里的Cases Select子菜单里的条件设置按钮,就可以自动剔除异常值。 spss里有个功能,好像是绘图吧。绘制Box plot图的。Box plot,可译成箱线图,由一个矩形箱和几条线段组合而成。针对一个数据批,其箱线图的绘制一般由以下几个步骤:第一、画数轴,度量单位大小和数据批的单位一致,起点比最小值稍小,长度比该数据批的全距稍长。 第二、画一个矩形盒,两端边的位置分别对应数据批的上下四分位数(Q1 和Q3)。在矩形盒内部中位数(X m)位置画一条线段为中位线。 第三、在Q3+1.5IQR(四分位距)和Q1-1.5IQR处画两条与中位线一样的线段,这两条线段为异常值截断点,称其为内限;在F+3IQR和F-3IQR处画两条线段,称其为外限。处于内限以外位置的点表示的数据都是异常值,其中在内限与外限之间的异常值为温和的异常值(mild outliers),在外限以外的为极端的异常值(extreme outliers)。 第四、从矩形盒两端边向外各画一条线段直到不是异常值的最远点,表示该批数据正常值的分布区间。 第五、用“〇”标出温和的异常值,用“*”标出极端的异常值。相同值的数据点并列标出在同一数据线位置上,不同值的数据点标在不同数据线位置上。至此一批数据的箱线图便绘出了。统计软件绘制的箱线图一般没有标出内限和外限。箱线图示例可见下图。 我常用一下方法: 1、可以通过“分析”下“描述统计“下“频率”的”绘制“直方图”,看图发现频数出现最少的值,就可能是异常值,但还要看距离其它情况的程度。 2、可通过“分析”下的“描述统计”下的“探索”下的“绘制”选项的“叶茎图”,看个案偏离箱体边缘(上端、下端)的距离是箱体的几倍,“○”代表在1.5-3倍之间(离群点),“*”代表超过3倍(极端离群点)。 3、可以通过“分析”下“描述统计“下“描述”下的选项“将标准化存为变量Z”,选择相应的变量,“确定”。将生成新变量,如果值超过2,肯定是异常值。

(完整word版)造成数据缺失的原因

造成数据缺失的原因 在各种实用的数据库中,属性值缺失的情况经常发全甚至是不可避免的。因此,在大多数情况下,信息系统是不完备的,或 者说存在某种程度的不完备。造成数据缺失的原因是多方面的,主要可能有以下几种: 1)有些信息暂时无法获取。例如在医疗数据库中,并非所有病人的所有临床检验结果都能在给定的时间内得到,就致使一部 分属性值空缺出来。又如在申请表数据中,对某些问题的反映依赖于对其他问题的回答。 2)有些信息是被遗漏的。可能是因为输入时认为不重要、忘记填写了或对数据理解错误而遗漏,也可能是由于数据采集设备 的故障、存储介质的故障、传输媒体的故障、一些人为因素等原因而丢失了。 3)有些对象的某个或某些属性是不可用的。也就是说,对于这个对象来说,该属性值是不存在的,如一个未婚者的配偶姓名 、一个儿童的固定收入状况等。 4)有些信息(被认为)是不重要的。如一个属性的取值与给定语境是无关的,或训练数据库的设计者并不在乎某个属性的取 值(称为dont-care value)。 5)获取这些信息的代价太大。 6)系统实时性能要求较高,即要求得到这些信息前迅速做出判断或决策。 处理数据缺失的机制 在对缺失数据进行处理前,了解数据缺失的机制和形式是十分必要的。将数据集中不含缺失值的变量(属性)称为完全变量

,数据集中含有缺失值的变量称为不完全变量,Little 和Rubin定义了以下三种不同的数据缺失机制: 1)完全随机缺失(Missing Completely at Random,MCAR)。数据的缺失与不完全变量以及完全变量都是无关的。 2)随机缺失(Missing at Random,MAR)。数据的缺失仅仅依赖于完全变量。 3)非随机、不可忽略缺失(Not Missing at Random,NMAR,or nonignorable)。不完全变量中数据的缺失依赖于不完全变量 本身,这种缺失是不可忽略的。 空值语义 对于某个对象的属性值未知的情况,我们称它在该属性的取值为空值(null value)。空值的来源有许多种,因此现实世界中 的空值语义也比较复杂。总的说来,可以把空值分成以下三类: 1)不存在型空值。即无法填入的值,或称对象在该属性上无法取值,如一个未婚者的配偶姓名等。 2)存在型空值。即对象在该属性上取值是存在的,但暂时无法知道。一旦对象在该属性上的实际值被确知以后,人们就可以用 相应的实际值来取代原来的空值,使信息趋于完全。存在型空值是不确定性的一种表征,该类空值的实际值在当前是未知的。但它 有确定性的一面,诸如它的实际值确实存在,总是落在一个人们可以确定的区间内。一般情况下,空值是指存在型空值。 3)占位型空值。即无法确定是不存在型空值还是存在型空值,这要随着时间的推移才能够清楚,是最不确定的一类。这种空值

缺失值的处理方法

缺失值的处理方法 对于缺失值的处理,从总体上来说分为删除存在缺失值的个案和缺失值插补。对于主观数据,人将影响数据的真实性,存在缺失值的样本的其他属性的真实值不能保证,那么依赖于这些属性值的插补也是不可靠的,所以对于主观数据一般不推荐插补的方法。插补主要是针对客观数据,它的可靠性有保证。 1.删除含有缺失值的个案 主要有简单删除法和权重法。简单删除法是对缺失值进行处理的最原始方法。它将存在缺失值的个案删除。如果数据缺失问题可以通过简单的删除小部分样本来达到目标,那么这个方法是最有效的。当缺失值的类型为非完全随机缺失的时候,可以通过对完整的数据加权来减小偏差。把数据不完全的个案标记后,将完整的数据个案赋予不同的权重,个案的权重可以通过logistic或probit回归求得。如果解释变量中存在对权重估计起决定行因素的变量,那么这种方法可以有效减小偏差。如果解释变量和权重并不相关,它并不能减小偏差。对于存在多个属性缺失的情况,就需要对不同属性的缺失组合赋不同的权重,这将大大增加计算的难度,降低预测的准确性,这时权重法并不理想。 2.可能值插补缺失值 它的思想来源是以最可能的值来插补缺失值比全部删除不完全样本所 产生的信息丢失要少。在数据挖掘中,面对的通常是大型的数据库,它的属性有几十个甚至几百个,因为一个属性值的缺失而放弃大量的其他属性值,这种删除是对信息的极大浪费,所以产生了以可能值对缺失值进行插补的思想与方法。常用的有如下几种方法。 (1)均值插补。数据的属性分为定距型和非定距型。如果缺失值是定距型的,就以该属性存在值的平均值来插补缺失的值;如果缺失值是非定距型的,就根据统计学中的众数原理,用该属性的众数(即出现频率最高的值) 来补齐缺失的值。 (2)利用同类均值插补。同均值插补的方法都属于单值插补,不同的是,它用层次聚类模型预测缺失变量的类型,再以该类型的均值插补。假设X= (X1,X2…Xp)为信息完全的变量,Y为存在缺失值的变量,那么首先对X或其子集行聚类,然后按缺失个案所属类来插补不同类的均值。如果在以后统计分析中还需以引入的解释变量和Y做分析,那么这种插补方法将在模型中引入自相关,给分析造成障碍。 (3)极大似然估计(Max Likelihood ,ML)。在缺失类型为随机缺失的条件下,假设模型对于完整的样本是正确的,那么通过观测数据的边际分布可以对未知参数进行极大似然估计(Little and Rubin)。这种方法也被称为忽略缺失值的极大似然估计,对于极大似然的参数估计实际中常采用的计算方法是期望值最大化(Expectation Maximization,EM)。该方法比删除

缺失值处理方法比较研究

352 《商场现代化》2007年5月(下旬刊)总第504 期 缺失值是指粗糙数据中由于缺少信息而造成的数据的聚类,分组,删失或截断。它指的是现有数据集中某个或某些属性的值是不完全的。数据挖掘所面对的数据不是特地为某个挖掘目的收集的,所以可能与分析相关的属性并未收集(或某段时间以后才开始收集),这类属性的缺失不能用缺失值的处理方法进行处理,因为它们未提供任何不完全数据的信息,它和缺失某些属性的值有着本质的区别。 一、缺失值产生的原因 缺失值的产生的原因多种多样,主要分为机械原因和人为原因。机械原因是由于机械原因导致的数据收集或保存的失败造成的数据缺失,比如数据存储的失败,存储器损坏,机械故障导致某段时间数据未能收集(对于定时数据采集而言)。人为原因是由于人的主观失误、历史局限或有意隐瞒造成的数据缺失,比如,在市场调查中被访人拒绝透露相关问题的答案,或者回答的问题是无效的,数据录入人员失误漏录了数据。 二、缺失值的类型 缺失值从缺失的分布来讲可以分为完全随机缺失,随机缺失和完全非随机缺失。完全随机缺失(missing completely at random,MCAR)指的是数据的缺失是随机的,数据的缺失不依赖于任何不完全变量或完全变量。随机缺失(missing at random,MAR)指的是数据的缺失不是完全随机的,即该类数据的缺失依赖于其他完全变量。完全非随机缺失(missing not at random,MNAR)指的是数据的缺失依赖于不完全变量自身。 从缺失值的所属属性上讲,如果所有的缺失值都是同一属性,那么这种缺失成为单值缺失,如果缺失值属于不同的属性,称为任意缺失。另外对于时间序列类的数据,可能存在随着时间的缺失,这种缺失称为单调缺失。 三、缺失值的处理方法对于缺失值的处理,从总体上来说分为删除存在缺失值的个案和缺失值插补。对于主观数据,人将影响数据的真实性,存在缺失值的样本的其他属性的真实值不能保证,那么依赖于这些属性值的插补也是不可靠的,所以对于主观数据一般不推荐插补的方法。插补主要是针对客观数据,它的可靠性有保证。 1.删除含有缺失值的个案主要有简单删除法和权重法。简单删除法是对缺失值进行处理的最原始方法。它将存在缺失值的个案删除。如果数据缺失问题可以通过简单的删除小部分样本来达到目标,那么这个方法是最有效的。当缺失值的类型为非完全随机缺失的时候,可以通过对完整的数据加权来减小偏差。把数据不完全的个案标记后,将完整的数据个案赋予不同的权重,个案的权重可以通过logistic或 probit回归求得。如果解释变量中存在对权重估计起决定行因素的 变量,那么这种方法可以有效减小偏差。如果解释变量和权重并不相关,它并不能减小偏差。对于存在多个属性缺失的情况,就需要对不同属性的缺失组合赋不同的权重,这将大大增加计算的难度,降低预测的准确性,这时权重法并不理想。 2.可能值插补缺失值 它的思想来源是以最可能的值来插补缺失值比全部删除不完全样本所产生的信息丢失要少。在数据挖掘中,面对的通常是大型的数据库,它的属性有几十个甚至几百个,因为一个属性值的缺失而放弃大量的其他属性值,这种删除是对信息的极大浪费,所以产生了以可能值对缺失值进行插补的思想与方法。常用的有如下几种方法。 (1)均值插补。数据的属性分为定距型和非定距型。如果缺失值是定距型的,就以该属性存在值的平均值来插补缺失的值;如果缺失值是非定距型的,就根据统计学中的众数原理,用该属性的众数(即出现频率最高的值)来补齐缺失的值。 (2)利用同类均值插补。同均值插补的方法都属于单值插补,不同的是,它用层次聚类模型预测缺失变量的类型,再以该类型的均值插补。假设X=(X1,X2…Xp)为信息完全的变量,Y为存在缺失值的变量,那么首先对X或其子集行聚类,然后按缺失个案所属类来插补不同类的均值。如果在以后统计分析中还需以引入的解释变量和Y做分析,那么这种插补方法将在模型中引入自相关,给分析造成障碍。 (3)极大似然估计(Max Likelihood ,ML)。在缺失类型为随机缺失的条件下,假设模型对于完整的样本是正确的,那么通过观测数据的边际分布可以对未知参数进行极大似然估计(Littleand Rubin)。这种方法也被称为忽略缺失值的极大似然估计,对于极大似然的参数估计实际中常采用的计算方法是期望值最大化(Expectation Maximization,EM)。该方法比删除个案和单值插补更有吸引力,它一个重要前提:适用于大样本。有效样本的数量足够以保证ML估计值是渐近无偏的并服从正态分布。但是这种方法可能会陷入局部极值,收敛速度也不是很快,并且计算很复杂。 (4)多重插补(Multiple Imputation,MI)。多值插补的思想来源于贝叶斯估计,认为待插补的值是随机的,它的值来自于已观测到的值。具体实践上通常是估计出待插补的值,然后再加上不同的噪声,形成多组可选插补值。根据某种选择依据,选取最合适的插补值。 多重插补方法分为三个步骤:①为每个空值产生一套可能的插补值,这些值反映了无响应模型的不确定性;每个值都可以被用来插补数据集中的缺失值,产生若干个完整数据集合。②每个 缺失值处理方法比较研究 [摘 要] 在数据收集过程中,由于各种原因可能造成数据集包括有噪声、不完整,甚至不一致的数据。这些问题将严重影响数据挖掘的质量和结果的稳健性,因此,对数据挖掘的对象进行预处理就显得尤为重要。数据的预处理分为数据清洗、数据集成、数据转换和数据消减。缺失值的处理是数据的清洗的第一步。对缺失值的处理有多种方法,本文将主要分析多重插补的方法。 [关键词] 缺失值 插补 多重插补胡红晓 河北医科大学图书馆 谢 佳 韩 冰 西南财经大学统计学院

数据预处理之剔除异常值及平滑处理

数据预处理——剔除异常值及平滑处理 测量数据在其采集与传输过程中,由于环境干扰或人为因素有可能造成个别数据不切合实际或丢失,这种数据称为异常值。为了恢复数据的客观真实性以便将来得到更好的分析结果,有必要先对原始数据剔除异常值。 另外,无论是人工观测的数据还是由数据采集系统获取的数据,都不可避免叠加上“噪声”干扰(反映在曲线图形上就是一些“毛刺和尖峰”)。为了提高数据的质量,必须对数据进行平滑处理(去噪声干扰)。 (一)剔除异常值。 注:若是有空缺值,或导入Matlab 数据显示为“NaN ”(非数),需要忽略整条空缺值数据,或者填上空缺值。 填空缺值的方法,通常有两种:A. 使用样本平均值填充;B. 使用判定树或贝叶斯分类等方法推导最可能的值填充(略)。 一、基本思想: 规定一个置信水平,确定一个置信限度,凡是超过该限度的误差,就认为它是异常值,从而予以剔除。 二、常用方法:拉依达方法、肖维勒方法、一阶差分法。 注意:这些方法都是假设数据依正态分布为前提的。 1. 拉依达方法(非等置信概率) 如果某测量值与平均值之差大于标准偏差的三倍,则予以剔除。 3x i x x S ->

其中,11 n i i x x n ==∑为样本均值,1 2 211()1n x i i S x x n =?? ??? =--∑为样本的标准偏差。 注:适合大样本数据,建议测量次数≥50次。 代码实例(略)。 2. 肖维勒方法(等置信概率) 在 n 次测量结果中,如果某误差可能出现的次数小于半次时,就予以剔除。 这实质上是规定了置信概率为1-1/2n ,根据这一置信概率,可计算出肖维勒系数,也可从表中查出,当要求不很严格时,还可按下列近似公式计算: 10.4ln()n n ω=+ Tab1. 肖维勒系数表 如果某测量值与平均值之差的绝对值大于标准偏差与肖维勒系数之积,则该测量值被剔除。 n x i x x S ω-> 例1. 利用肖维勒方法对下列数据的异常值(2.5000)进行剔除: 1.5034 1.5062 1.5034 1.5024 1.4985 2.5000 1.5007

数据缺失处理方法

关于数据缺失问题的总结 造成数据缺失的原因 在各种实用的数据库中,属性值缺失的情况经常发全甚至是不可避免的。因此,在大多数情况下,信息系统是不完备的,或者说存在某种程度的不完备。造成数据缺失的原因是多方面的,主要可能有以下几种: 1)有些信息暂时无法获取。例如在医疗数据库中,并非所有病人的所有临床检验结果都能在给定的时间内得到,就致使一部分属性值空缺出来。又如在申请表数据中,对某些问题的反映依赖于对其他问题的回答。 2)有些信息是被遗漏的。可能是因为输入时认为不重要、忘记填写了或对数据理解错误而遗漏,也可能是由于数据采集设备的故障、存储介质的故障、传输媒体的故障、一些人为因素等原因而丢失了。 3)有些对象的某个或某些属性是不可用的。也就是说,对于这个对象来说,该属性值是不存在的,如一个未婚者的配偶姓名、一个儿童的固定收入状况等。 4)有些信息(被认为)是不重要的。如一个属性的取值与给定语境是无关的,或训练数据库的设计者并不在乎某个属性的取值(称为dont-care value)[37]。 5)获取这些信息的代价太大。 6)系统实时性能要求较高,即要求得到这些信息前迅速做出判断或决策。 2.2.2数据缺失机制 在对缺失数据进行处理前,了解数据缺失的机制和形式是十分必要的。将数据集中不含缺失值的变量(属性)称为完全变量,数据集中含有缺失值的变量称为不完全变量,Little 和 Rubin定义了以下三种不同的数据缺失机制[38]: 1)完全随机缺失(Missing Completely at Random,MCAR)。数据的缺失与不完全变量以及完全变量都是无关的。 2)随机缺失(Missing at Random,MAR)。数据的缺失仅仅依赖于完全变量。 3)非随机、不可忽略缺失(Not Missing at Random,NMAR,or nonignorable)。不完全变量中数据的缺失