vSphere 4系列之十:Cluster配置

vSphere4 Host Profiles配置指南

Host Profiles Configuration创建Host ProfileStep 1: 使用vSphere Client登录vCenter Server.Step 2: Home > Host Profiles主页中选择[Host Profiles]Step 3: Create Porfile∙在[Host Profiles]页面,点击右键。

∙选择[Create Profile]。

Step 4: Select Creation method∙选择Host Profile创建方式o从ESX主机中创建,向导以此为例o导入已有的profile文件∙单击[Next]。

Step 5: Specify Reference Host∙选择列表中的一个主机,此主机的配置信息将被用来创建Host Profile。

∙单击[Next]。

Step 6: Profile Details∙为创建的Host Profile命名。

∙输入此Host Profile的详细描述(可选)。

∙单击[Next]。

Step 7: Ready to Complete the profile∙确认以上选择是否正确。

∙若无误,单击[Finish]。

Step 8: Host Profile创建完成∙在vCenter目录中可以看到已创建的profile。

编辑Host ProfileStep 1: 选中要编辑的Host Profile,右键选择[Edit Profile]Step 2: 显示Profile的子选项在各子选项按需要修改各项参数将Host Profile关联主机并应用到主机上Step 1: 选中要编辑的Host Profile,在图示位置中选择中[Attach Host/Cluster]Step 2: Attach Host/Cluster∙在左栏中选择Host或Cluster,点击Attach,则选中的主机或集群会加入到右栏中。

集群的配置步骤

集群的配置步骤一、搭建集群环境的准备工作在开始配置集群之前,我们需要先进行一些准备工作。

首先,确保所有服务器都已经正确连接到网络,并且能够相互通信。

其次,确保每台服务器上已经安装了操作系统,并且操作系统版本一致。

最后,确保每台服务器上已经安装了必要的软件和工具,例如SSH、Java等。

二、创建集群的主节点1.选择一台服务器作为集群的主节点,将其IP地址记录下来。

2.登录到主节点服务器上,安装并配置集群管理软件,例如Hadoop、Kubernetes等。

3.根据集群管理软件的要求,配置主节点的相关参数,例如集群名称、端口号等。

4.启动集群管理软件,确保主节点能够正常运行。

三、添加集群的工作节点1.选择一台或多台服务器作为集群的工作节点,将其IP地址记录下来。

2.登录到工作节点服务器上,安装并配置集群管理软件,确保与主节点的版本一致。

3.根据集群管理软件的要求,配置工作节点的相关参数,例如主节点的IP地址、端口号等。

4.启动集群管理软件,确保工作节点能够正常连接到主节点。

四、测试集群的连接和通信1.在主节点服务器上,使用集群管理软件提供的命令行工具,测试与工作节点的连接和通信。

例如,可以使用Hadoop的hdfs命令测试与工作节点的文件系统的连接。

2.确保主节点能够正确访问工作节点的资源,并且能够将任务分配给工作节点进行处理。

五、配置集群的资源管理1.根据集群管理软件的要求,配置集群的资源管理策略。

例如,可以设置工作节点的CPU和内存的分配比例,以及任务的调度算法等。

2.确保集群能够合理分配资源,并且能够根据需要动态调整资源的分配。

六、监控和管理集群1.安装并配置集群的监控和管理工具,例如Ganglia、Zabbix等。

2.确保监控和管理工具能够正常运行,并能够及时发现和处理集群中的故障和问题。

3.定期对集群进行巡检和维护,确保集群的稳定和可靠性。

七、优化集群的性能1.根据实际情况,对集群的各项参数进行调优,以提高集群的性能和效率。

(图文)关于vSAN的配置要求和配置简介

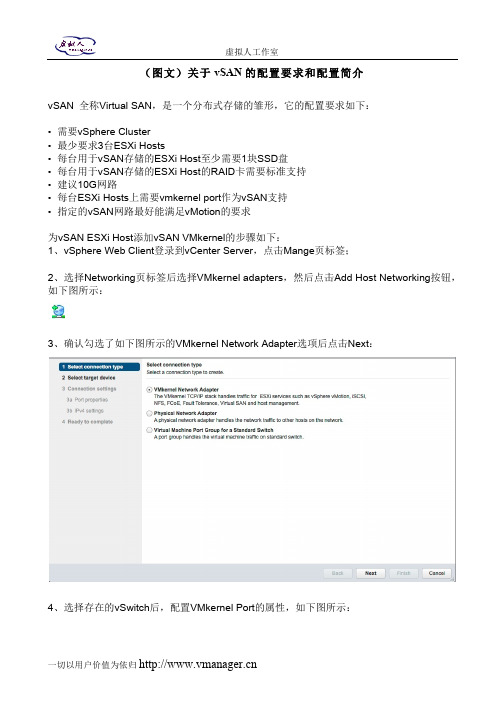

(图文)关于vSAN的配置要求和配置简介vSAN 全称Virtual SAN,是一个分布式存储的雏形,它的配置要求如下:• 需要vSphere Cluster• 最少要求3台ESXi Hosts• 每台用于vSAN存储的ESXi Host至少需要1块SSD盘• 每台用于vSAN存储的ESXi Host的RAID卡需要标准支持• 建议10G网路• 每台ESXi Hosts上需要vmkernel port作为vSAN支持• 指定的vSAN网路最好能满足vMotion的要求为vSAN ESXi Host添加vSAN VMkernel的步骤如下:1、vSphere Web Client登录到vCenter Server,点击Mange页标签;2、选择Networking页标签后选择VMkernel adapters,然后点击Add Host Networking按钮,如下图所示:3、确认勾选了如下图所示的VMkernel Network Adapter选项后点击Next:4、选择存在的vSwitch后,配置VMkernel Port的属性,如下图所示:5、输入VMkernel Port的名字,例如本例中的VSANVMK,输入VLAN ID(如有必要),勾选Virtual SAN traffic,然后点击Next,之后配置IPv4的设定后点击Next,然后点击Finish;6、确认这个For vSAN的VMkernel Port成功创建后,在每台ESXi Host上重复前面的动作,如下图所示:7、之后,还需要确认存储部分的配置,注意,至少需要1块SSD盘和1块普通盘。

首先vSphere Web Client登录到vCenter Server之后,点击Manage > Storage > Storage Devices,在DriveType里看看有木有SSD,如下图所示:在vSphere vSAN Cluster的所有ESXi Hosts上重复这个动作,完成这个配置;8、接着,就是要配置VMware vSAN Cluster,参照如下图所示,创建一个新得vSphere Cluster,但是别选择任何选项:9、创建好之后,将所有ESXi Hosts添加到这个创建好的Cluster里面,比较简单,点击如下图所示的Move Hosts into Cluster…选项:10、当ESXi Hosts都添加到vSAN Cluster之后,就可以点编辑Cluster,点击Manage,然后点击Settings选项下面Virtual SAN里的General选项,点击Edit,然后勾选Turn on Virtual SAN。

vSphere虚拟化资源池推荐配置

虚拟化资源池及虚拟机推荐配置1.CPU推荐配置对于CPU的使用,VMware并没有严格的限定,可根据实际需求进行CPU的分配,但为了保证虚拟机的性能及系统的稳定性,请首要保证两个原则:a)单台物理主机之上的CPU平均使用率不超过70%,峰值使用率不超过80%b)CPU超分比例,物理CPU核数与虚拟机CPU核数在1:5的比例左右较为合适除主要遵守这两个原则外,可根据实际情况按照下面的推荐配置来为虚拟机分配CPU资源:●根据所承载的guest os及应用来配置CPUWindows 2008 R2 2vCPUsLinux 6.x 2vCPUs●如没有特殊要求,建议为虚拟机平均分配所使用的物理CPU,例:分配4个vCPUs,使用2颗2核的性能要比1颗4核的高。

有些特殊应用会要求一定的CPU数量,可根据实际情况进行调整2.内存推荐配置同CPU资源分配一样,为了保证虚拟机性能及系统的稳定性,请首要保证两个原则:a)单台物理主机之上的内存平均使用率不超过70%,峰值使用率不超过80%b)内存不建议进行超分使用,超分内存会使用物理存储作为交换空间,降低虚拟机的性能。

如应用对内存没有特殊要求,可以按照CPU与内存1:2(GB)的比例进行内存的分配,如:虚拟机配置4vCPUs,则内存分配8GB3.存储推荐配置●单台物理主机的存储路径不要超过其上限1024●单台物理主机的存储LUN数量不超过256●每个LUN上的虚拟机数量15-20个为最佳,保证IOPS●每个LUN如果没有特殊要求,建议大小为2-4TB●每个LUN至少保证20%的冗余空间●虚拟机的存储可根据guest os和实际业务要求进行划分,●Windows 2008 R2 系统盘20-40GB●Linux 6.x 系统盘(root、boot及swap)20GB。

VMware vSphere 简介(中文)

VMware vSphere 简介ESX 4.0ESXi 4.0vCenter Server 4.0ZH_CN-000102-00VMware vSphere 简介2 VMware, Inc.您可以在 VMware 的网站上找到最新的技术文档,网址为/cn/support/VMware 网站还提供了最新的产品更新。

如果您对本文档有任何意见和建议,请将您的反馈提交到:**********************©2009 VMware, Inc. 保留所有权利。

本产品受美国和国际版权及知识产权法的保护。

VMware 产品受一项或多项专利保护,有关专利详情,请访问 /go/patents 。

VMware 、VMware “箱状”徽标及设计、Virtual SMP 和 VMotion 都是 VMware, Inc. 在美国和/或其他法律辖区的注册商标或商标。

此处提到的所有其他商标和名称分别是其各自公司的商标。

VMware, Inc.3401 Hillview Ave.Palo Alto, CA 目录关于本文档5VMware vSphere 简介7VMware vSphere 组件8vSphere 数据中心的物理拓扑9虚拟数据中心架构11网络架构16存储架构17VMware vCenter Server20其他资源25词汇表27索引41VMware, Inc. 3VMware vSphere 简介4 VMware, Inc.关于本文档《VMware vSphere 简介》提供有关 VMware® vSphere 的特性和功能的信息。

《VMware vSphere 简介》涵盖了 ESX、ESXi 和 vCenter Server。

目标读者本信息专供不熟悉 VMware vSphere 的组件和功能的用户使用。

本信息的目标读者为熟悉虚拟机技术和数据中心操作且具有丰富经验的 Windows 或 Linux 系统管理员。

VCP认证 第00部分 VMware vSphere 4.0 产品概览

虚拟机可扩展性及功能

New Virtual Hardware — ESX/ESXi 4.0 introduces a new generation of virtual hardware (virtual hardware version 7) which adds significant new features including:

VI4 - Mod 0 - Slide 11

虚拟机的VMDirectPath 虚拟机的

VMDirectPath for Virtual Machines — VMDirectPath I/O device access is primarily targeted to those applications that can benefit from direct access by the guest operating system to the I/O devices.

Supported on Intel Nehalem platform and up to two passthrough devices

VI4 - Mod 0 - Slide 12

存储优化

Thin Provisioning — VMware thin provisioning enables virtual machines to utilize storage space on an as-needed basis, further reducing the cost of storage for virtual environments.

VI4 - Mod 0 - Slide 7

虚拟机的硬件

New Virtual Hardware

Hardware version 7 is the default for new ESX/ESXi 4.0 VMs VM’s running ESX 2.x/3.x continue to run Enable hot add for Memory and CPU VM needs to be powered off to enable Supported in some Guest OS’s VM’s with virtual hardware version 7 features are not compatible with ESX/ESXi releases prior to 4.0

SMP与Cluster的比较

一、SMP1、SMP概述SMP的全称是"对称多处理"(Symmetrical Multi-Processing)技术,是指在一个计算机上汇集了一组处理器(多CPU),各CPU之间共享内存子系统以及总线结构。

它是相对非对称多处理技术而言的、应用十分广泛的并行技术。

在这种架构中,一台电脑不再由单个CPU组成,而同时由多个处理器运行操作系统的单一复本,并共享内存和一台计算机的其他资源。

虽然同时使用多个CPU,但是从管理的角度来看,它们的表现就像一台单机一样。

系统将任务队列对称地分布于多个CPU之上,从而极大地提高了整个系统的数据处理能力。

所有的处理器都可以平等地访问内存、I/O和外部中断。

在对称多处理系统中,系统资源被系统中所有CPU共享,工作负载能够均匀地分配到所有可用处理器之上。

2、SMP配置要组建SMP系统,首先最关键的一点就是需要合适的CPU相配合。

要实现SMP功能,我们使用的CPU必须具备以下要求:1、CPU内部必须内置APIC(Advanced Programmable Interrupt Controllers)单元。

Intel 多处理规范的核心就是高级可编程中断控制器(Advanced Programmable Interrupt Controllers--APICs)的使用。

CPU通过彼此发送中断来完成它们之间的通信。

通过给中断附加动作(actions),不同的CPU可以在某种程度上彼此进行控制。

每个CPU有自己的APIC(成为那个CPU的本地APIC),并且还有一个I/O APIC来处理由I/O设备引起的中断,这个I/O APIC是安装在主板上的,但每个CPU上的APIC则不可或缺,否则将无法处理多CPU之间的中断协调。

2、相同的产品型号,同样类型的CPU核心。

例如,虽然Athlon和Pentium III各自都内置有APIC单元,想要让它们一起建立SMP系统是不可能的,当然,即使是Celeron和Pentium III,那样的可能性也为0,甚至Coppermine核心的Pentium III和Tualatin的Pentium III也不能建立SMP系统--这是因为他们的运行指令不完全相同,APIC中断协调差异也很大。

vSphere集群配置一例

vSphere集群配置一例(HP C7000+DELL EQlogic+HUAWEI 6700)本案例为ESXi集群的一个例子,由“刀片服务器+IPSAN万兆存储+万兆核心交换机 ”组成。

这里的刀片服务器为HP C7000,IPSAN万兆存储为DELL EQlogic,万兆存储交换机为华为S6700。

说明:该文档只会描述案例的整个架构,以及如何实现等,不会涉及详细的配置说明,如需了解请网上自行搜索相关设备的教程,具体内容如下:一、案例概述该案例主要搭建一套小型的私有云中心,以给需要计算资源的单位提供相应的服务。

将硬件资源(刀片服务器、存储等)通过VMware的虚拟化软件来实现。

二、系统拓扑图三、设备清单1、刀片服务器两台HP C7000刀片机箱,每机箱配置8个刀片服务器及四个VC模块,具体如下:(1)HP C70000刀箱 * 2(2)BL420c刀片 * 8 (每刀片配置两颗CPU、128G内存、4个10GB以太网卡)(3)HP Virtual Connect FlexFabric 10Gb/24-port Module模块 * 4 (4)其它(OA管理模块、电源、风扇等)2、DELL EQlogic存储存储共配置了6个盘柜,三个为高速盘柜(PS6110XV,双控制器、8G缓存、24× 600GB 15Krpm SAS热插拨硬盘),三个为低速盘柜(PS6110E,双控制器、8G缓存、24× 3TB 7.2Krpm NL-SAS热插拨硬盘)(1)DELL EQLogic PS6110XV * 3(2)DELL EQLogic PS6110E * 33、华为S6700万兆交换机共配置了两台,具体如下(1)华为 S6700-48-EI * 2 (配置48个万兆SFP接口、支持三层交换)4、虚拟化软件VMware虚拟化软件采用的VMware vSphere 5.0 Enterprise,32个CPU授权(16个刀片,每刀片2个CPU)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

vSphere 4系列之十:Cluster配置

一、什么是vSphere Cluster

Cluster就是把所有的ESX/ESXi组织起来,形成一个大的资源池,所有的虚拟机可在池中的任意主机上自由移动,并且Cluster可做到快速扩容和HA故障冗余;所以Cluster是服务器虚拟化通往数据中心的必备功能。

二、vSphere Cluster提供了哪些功能

1. DRS:分布式资源调度,用于动态调整Cluster中ESX主机负载,自动把负载较重的主机上的虚拟机通过VMotion迁移到负载较轻的主机上,最终达到整个Cluster中的主机资源消耗平衡;

2. HA:高可用性,用于意外故障切换,当监控到Cluster中有主机意外故障时,会自动在其他主机上启动故障主机上之前承载的虚拟机;

3. DPM:分布式电源管理,用于在负载较轻时,把虚拟机动态“集中”到Cluster中的少部分主机上,然后把其他ESX/ESXi主机待机,以节省电力消耗,等负载较大时,再重新唤醒之前待机的主机;

三、vSphere Cluster配置

1. 配置前准备

1.1. 共享存储要求:要组建Cluster,共享存储是必须的,FC SAN、iSCSI SAN和NAS这三种类型共享存储都支持;存储的配置可参考之前的博文:vSphere 4系列之八:Storage配置

1.2. DNS解析要求:Cluster中所有ESX/ESXi主机,以及vCenter Server都要能相互解析,在组建Cluster 时请使用Hostnme或FQDN名,这是VMware官方推荐的;虽然之前有见过直接使用ip地址也可以组建Cluster,但是配置中出问题的几率较大,个人不推荐;具体配置中可使用以下2个方法实现:

1.2.1. 为ESX/ESXi和vCenter配置DNS服务器,ESX/ESXi的配置界面如下:

1.2.2. 为ESX/ESXi添加hosts记录,具体步骤如下:使用root账户登录ESX,使用vi编辑hosts文件,如下:vi /etc/hosts

敲击“i”键,进入编辑模式,把你Cluster中的所有主机和vCenter按下列格式输入:

ip地址 FQDN名 hostname

192.168.1.50 esx40

输入完毕,敲击“Esc”键推出编辑模式,然后敲入“:”,输入“wq”保存并推出;

有人可能要问,ESXi怎么修改hosts文件?其实esxi有个隐藏的的命令行界面,可以在控制台界面(按ALT+F1)下强制输入unsupport进入,进入后其它操作方式和ESX相同;

1.3. ESX/ESXi网络要求:

1.3.1. 所有ESX/ESXi的管理网络应该为一个子网,VMotion为一个单独的子网,如果使用iSCSI或NAS,则存储网络也应该为一个单独的子网,然后虚拟机网络可按需求再单独划分几个子网,当然这是比较理想的划分,实际环境可能所有网络都在一个子网,也是可以的;网络配置可参考之前博文:vSphere 4系列之六:Standard vSwitch

1.3.

2. 所有ESX/ESXi上的网络标签要一致,包括虚拟机网络,管理网络,存储网络,VMotion网络;

1.3.3. 要为ESX/ESXi配置默认网关,这个比较重要,在配置了HA后,默认Cluster中的主机会通过管理网络定时发送心跳信号,以确认是否有主机故障,如果一台主机无法探测到其他ESX主机,那他就会探测默认网关地址,以确认自己是否隔离或是对方故障;默认网关配置如下:

1.3.4. 要为管理网络配置至少2块冗余网卡,否则在配置好的Cluster摘要里会有警告提醒;

1.4. CPU兼容性要求:Cluster中的所有ESX/ESXi主机最好是同一型号或同一系列CPU,这主要是DRS依赖的VMotion有CPU兼容性要求,详细参考:vSphere 4系列之九:VMotion和Storage VMotion ;

2. vSphter Cluster配置步骤

只要先前的准备工作都做好了,配置Cluster还是很简单的;下面把配置截图贴出来:

右击,新建Cluster

键入Cluster名字,并选择是否启用HA和DRS

配置DRS相关选项,选择DRS自动级别,一般保持默认即可;如果虚拟机“漂移”太频繁,则可以把滑块往左拉,或者改为半自动

设定电源管理(DPM),默认为关闭状态;为了响应节能减碳,可以设定为自动,这样在晚上资源使用率较低时,系统可以关闭几台ESX,等第二天早上业务繁忙时再唤醒相关ESX主机;这里有一点提示:你的物理网卡要支持远程唤醒(这不废话,几乎所有服务器网卡都支持)或服务器支持IPMI/iLO等高级电源管理模块;

以下示例网卡支持网路唤醒

可通过在主机上手动待机然后再启动,测试远程唤醒功能

OK,我们返回到群集继续配置HA,如下:

启用主机监控:此选项决定HA是否有效,如果做一些网络方面维护,可临时取消HA监控,以免发生不必要的故障切换;

接入控制:确认群集中的Free资源不满足故障切换容量时,是否还允许新的虚拟机启动;

接入控制策略:设定故障冗余容量,一般N+1冗余保持默认即可;

虚拟机重启优先级:设定发生HA时虚拟机重新启动时的默认优先级(可以在虚拟机级别单独更改);

主机隔离响应:这个在管理网络和虚拟机网络都为单网卡时,可设定为保持开机;如果所有网络都有网卡冗余配置,请设定为关机;

注:主机隔离发生在主机本身活着,但其管理网路连接中断的情况下;

设定虚拟机监控选项:如果启用,则虚拟机本身down机、蓝屏或检测不到信号,HA会自动重新启动之

设定EVC模式:如果群集中的ESX主机CPU型号不同,则需要开启,具体启用什么级别,可参考之前博文vSphere 4系列之九:VMotion和Storage VMotion

设定交换文件位置,保持默认

完成Cluster创建

拖动现有的ESX主机到Cluster中

在任务栏查看添加进度

把所有主机添加完毕,查看群集无警告图示或错误log就大功告成。