hadoop-session-cs246

hadoop面试题总结

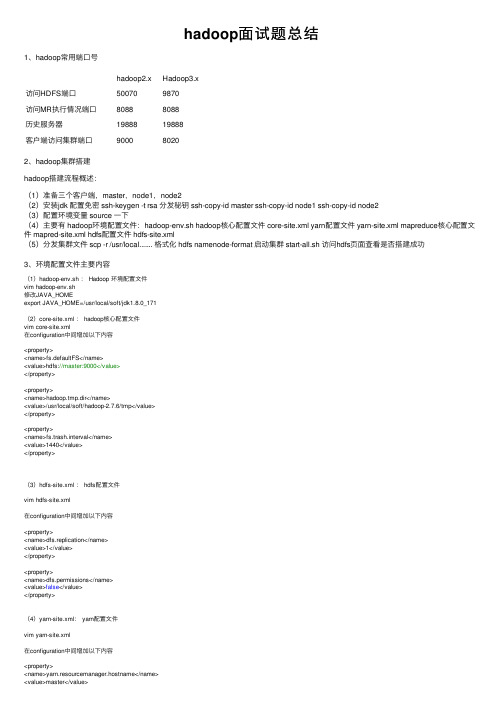

hadoop⾯试题总结1、hadoop常⽤端⼝号hadoop2.x Hadoop3.x访问HDFS端⼝50070 9870访问MR执⾏情况端⼝8088 8088历史服务器19888 19888客户端访问集群端⼝9000 80202、hadoop集群搭建hadoop搭建流程概述:(1)准备三个客户端,master,node1,node2(2)安装jdk 配置免密 ssh-keygen -t rsa 分发秘钥 ssh-copy-id master ssh-copy-id node1 ssh-copy-id node2(3)配置环境变量 source ⼀下(4)主要有 hadoop环境配置⽂件:hadoop-env.sh hadoop核⼼配置⽂件 core-site.xml yarn配置⽂件 yarn-site.xml mapreduce核⼼配置⽂件 mapred-site.xml hdfs配置⽂件 hdfs-site.xml(5)分发集群⽂件 scp -r /usr/local....... 格式化 hdfs namenode-format 启动集群 start-all.sh 访问hdfs页⾯查看是否搭建成功3、环境配置⽂件主要内容(1)hadoop-env.sh : Hadoop 环境配置⽂件vim hadoop-env.sh修改JAVA_HOMEexport JAVA_HOME=/usr/local/soft/jdk1.8.0_171(2)core-site.xml : hadoop核⼼配置⽂件vim core-site.xml在configuration中间增加以下内容<property><name>fs.defaultFS</name><value>hdfs://master:9000</value></property><property><name>hadoop.tmp.dir</name><value>/usr/local/soft/hadoop-2.7.6/tmp</value></property><property><name>fs.trash.interval</name><value>1440</value></property>(3)hdfs-site.xml : hdfs配置⽂件vim hdfs-site.xml在configuration中间增加以下内容<property><name>dfs.replication</name><value>1</value></property><property><name>dfs.permissions</name><value>false</value></property>(4)yarn-site.xml: yarn配置⽂件vim yarn-site.xml在configuration中间增加以下内容<property><name>yarn.resourcemanager.hostname</name><value>master</value></property><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.log-aggregation-enable</name><value>true</value></property><property><name>yarn.log-aggregation.retain-seconds</name><value>604800</value></property><property><name>yarn.nodemanager.resource.memory-mb</name><value>20480</value></property><property><name>yarn.scheduler.minimum-allocation-mb</name><value>2048</value></property><property><name>yarn.nodemanager.vmem-pmem-ratio</name><value>2.1</value></property>(5)mapred-site.xml: mapreduce配置⽂件重命名mv mapred-site.xml.template mapred-site.xmlvim mapred-site.xml在configuration中间增加以下内容<property><name></name><value>yarn</value></property><property><name>mapreduce.jobhistory.address</name><value>master:10020</value></property><property><name>mapreduce.jobhistory.webapp.address</name><value>master:19888</value></property>3、hdfs读写流程写流程:1)客户端向namenode请求上传⽂件,namenode检查⽬标⽂件是否已存在,⽗⽬录是否存在。

《大数据技术原理与操作应用》第6章习题答案

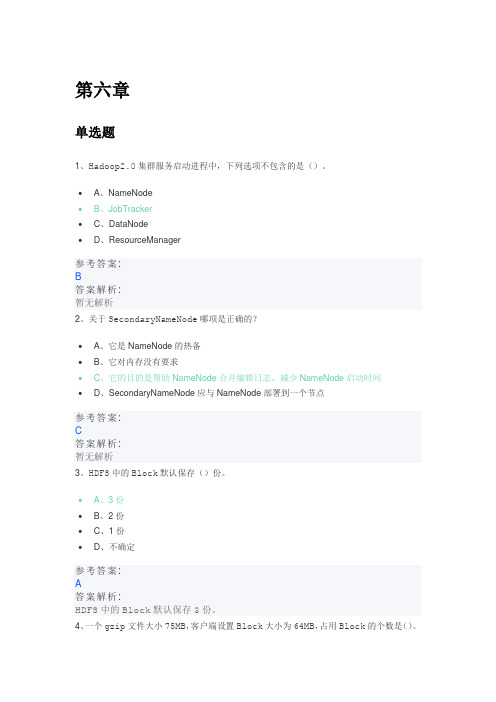

第六章单选题1、Hadoop2.0集群服务启动进程中,下列选项不包含的是()。

•A、NameNode•B、JobTracker•C、DataNode•D、ResourceManager参考答案:B答案解析:暂无解析2、关于SecondaryNameNode哪项是正确的?•A、它是NameNode的热备•B、它对内存没有要求•C、它的目的是帮助NameNode合并编辑日志,减少NameNode启动时间•D、SecondaryNameNode应与NameNode部署到一个节点参考答案:C答案解析:暂无解析3、HDFS中的Block默认保存()份。

•A、3份•B、2份•C、1份•D、不确定参考答案:A答案解析:HDFS中的Block默认保存3份。

4、一个gzip文件大小75MB,客户端设置Block大小为64MB,占用Block的个数是()。

•A、1•B、2•C、3•D、4参考答案:B答案解析:暂无解析5、下列选项中,Hadoop2.x版本独有的进程是()。

•A、JobTracker•B、TaskTracker•C、NodeManager•D、NameNode参考答案:C答案解析:暂无解析6、下列哪项通常是集群的最主要的性能瓶颈?•A、CPU•B、网络•C、磁盘•D、内存参考答案:C答案解析:暂无解析判断题1、NameNode的Web UI端口是50030,它通过jetty启动的Web服务。

•对•错参考答案:错答案解析:端口号为500702、NodeManager会定时的向ResourceManager汇报所在节点的资源使用情况,并接受处理来自ApplicationMaster的容器启动、停止等各种请求•对•错3、Hadoop HA是集群中启动两台或两台以上机器充当NameNode,避免一台NameNode 节点发生故障导致整个集群不可用的情况。

•对•错参考答案:对答案解析:Hadoop HA是集群中启动两台或两台以上机器充当NameNode,避免一台NameN ode节点发生故障导致整个集群不可用的情况。

Hadoop集群配置与数据处理入门

Hadoop集群配置与数据处理入门1. 引言Hadoop是一个开源的分布式计算框架,被广泛应用于大规模数据处理和存储。

在本文中,我们将介绍Hadoop集群的配置和数据处理的基本概念与入门知识。

2. Hadoop集群配置2.1 硬件要求架设Hadoop集群需要一定的硬件资源支持。

通常,集群中包含主节点和若干个从节点。

主节点负责整个集群的管理,而从节点负责执行具体的计算任务。

在硬件要求方面,主节点需要具备较高的计算能力和存储空间。

从节点需要具备较低的计算能力和存储空间,但数量较多。

此外,网络带宽也是一个关键因素。

较高的网络带宽可以加快数据的传输速度,提升集群的效率。

2.2 软件要求Hadoop运行在Java虚拟机上,所以首先需要确保每台主机都安装了适当版本的Java。

其次,需要安装Hadoop分发版本,如Apache Hadoop或Cloudera等。

针对集群管理,可以选择安装Hadoop的主节点管理工具,如Apache Ambari或Cloudera Manager。

这些工具可以帮助用户轻松管理集群的配置和状态。

2.3 配置文件Hadoop集群部署需要配置多个文件。

其中,最重要的是核心配置文件core-site.xml、hdfs-site.xml和yarn-site.xml。

core-site.xml配置Hadoop的核心参数,如文件系统和输入输出配置等;hdfs-site.xml用于配置Hadoop分布式文件系统;yarn-site.xml配置Hadoop资源管理器和任务调度器相关的参数。

3. 数据处理入门3.1 数据存储与处理Hadoop的核心之一是分布式文件系统(HDFS),它是Hadoop集群的文件系统,能够在集群中存储海量数据。

用户可以通过Hadoop的命令行工具或API进行文件的读取、写入和删除操作。

3.2 数据处理模型MapReduce是Hadoop的编程模型。

它将大规模的数据集拆分成小的数据块,并分配给集群中的多个计算节点进行并行处理。

hadoop命令及使用方法

hadoop命令及使用方法Hadoop是一个分布式计算框架,用于存储和处理大规模数据集。

下面是一些常用的Hadoop命令及其使用方法:1. hdfs命令:- hdfs dfs -ls <路径>:列出指定路径下的文件和目录。

- hdfs dfs -mkdir <路径>:创建一个新的目录。

- hdfs dfs -copyFromLocal <本地路径> <HDFS路径>:将本地文件复制到HDFS 上。

- hdfs dfs -copyToLocal <HDFS路径> <本地路径>:将HDFS上的文件复制到本地。

- hdfs dfs -cat <文件路径>:显示HDFS上的文件内容。

2. mapred命令:- mapred job -list:列出当前正在运行的MapReduce作业。

- mapred job -kill <job_id>:终止指定的MapReduce作业。

3. yarn命令:- yarn application -list:列出当前正在运行的应用程序。

- yarn application -kill <application_id>:终止指定的应用程序。

4. hadoop fs命令(与hdfs dfs命令功能相似):- hadoop fs -ls <路径>:列出指定路径下的文件和目录。

- hadoop fs -cat <文件路径>:显示HDFS上的文件内容。

- hadoop fs -mkdir <路径>:创建一个新的目录。

- hadoop fs -put <本地文件路径> <HDFS路径>:将本地文件复制到HDFS上。

- hadoop fs -get <HDFS路径> <本地文件路径>:将HDFS上的文件复制到本地。

【大数据】Hadoop常用启动命令

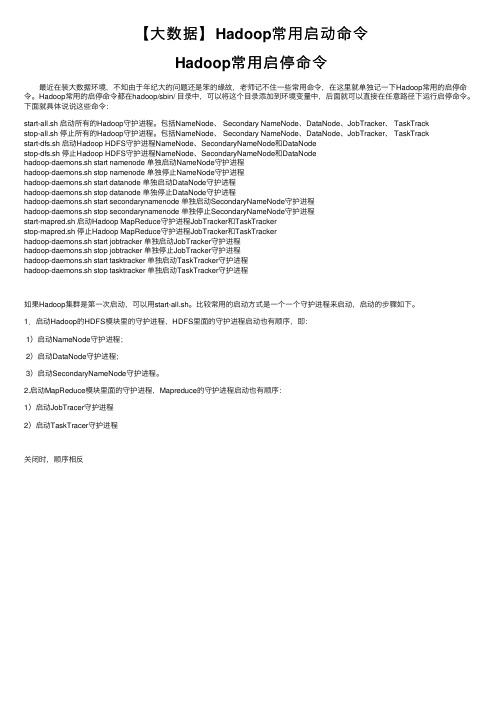

【⼤数据】Hadoop常⽤启动命令Hadoop常⽤启停命令 最近在装⼤数据环境,不知由于年纪⼤的问题还是笨的缘故,⽼师记不住⼀些常⽤命令,在这⾥就单独记⼀下Hadoop常⽤的启停命令。

Hadoop常⽤的启停命令都在hadoop/sbin/ ⽬录中,可以将这个⽬录添加到环境变量中,后⾯就可以直接在任意路径下运⾏启停命令。

下⾯就具体说说这些命令:start-all.sh 启动所有的Hadoop守护进程。

包括NameNode、 Secondary NameNode、DataNode、JobTracker、 TaskTrackstop-all.sh 停⽌所有的Hadoop守护进程。

包括NameNode、 Secondary NameNode、DataNode、JobTracker、 TaskTrackstart-dfs.sh 启动Hadoop HDFS守护进程NameNode、SecondaryNameNode和DataNodestop-dfs.sh 停⽌Hadoop HDFS守护进程NameNode、SecondaryNameNode和DataNodehadoop-daemons.sh start namenode 单独启动NameNode守护进程hadoop-daemons.sh stop namenode 单独停⽌NameNode守护进程hadoop-daemons.sh start datanode 单独启动DataNode守护进程hadoop-daemons.sh stop datanode 单独停⽌DataNode守护进程hadoop-daemons.sh start secondarynamenode 单独启动SecondaryNameNode守护进程hadoop-daemons.sh stop secondarynamenode 单独停⽌SecondaryNameNode守护进程start-mapred.sh 启动Hadoop MapReduce守护进程JobTracker和TaskTrackerstop-mapred.sh 停⽌Hadoop MapReduce守护进程JobTracker和TaskTrackerhadoop-daemons.sh start jobtracker 单独启动JobTracker守护进程hadoop-daemons.sh stop jobtracker 单独停⽌JobTracker守护进程hadoop-daemons.sh start tasktracker 单独启动TaskTracker守护进程hadoop-daemons.sh stop tasktracker 单独启动TaskTracker守护进程如果Hadoop集群是第⼀次启动,可以⽤start-all.sh。

Python Hadoop的使用方法和技巧

Python Hadoop的使用方法和技巧随着数据存储量的不断增加,处理大规模数据已经成为了重要的课题。

为了解决这一问题,Hadoop逐渐成为了大数据处理领域的重要工具之一。

Python是一种流行的编程语言,也被广泛用于大数据处理。

如何在Python中使用Hadoop,并获得最佳效果呢?本文将就此问题进行探讨。

Hadoop概述Hadoop是一种大数据处理架构,包含两个核心组件:HDFS和MapReduce。

HDFS是一个具有高容错性的分布式文件系统,可以在不同节点之间分配文件存储。

而MapReduce是一种并行处理框架,能够对大规模数据进行分析和处理。

Hadoop的分布式特性和强大的处理能力,使其成为了大规模数据处理的首选工具之一。

Python概述Python是一种高级编程语言,易于学习,丰富的库和模块使其适合于各种任务,包括数据处理。

其语法简单、直观、易于理解,非常灵活,可用于各种数据处理任务。

Python还可以与其他大型工具和框架集成,如Hadoop。

Python Hadoop远程操作技巧Python与Hadoop集成主要通过Hadoop Streaming实现,它允许使用标准输入和输出流作为MapReduce任务的输入和输出端点。

Hadoop Streaming默认情况下使用基于Java的MapReduce实现。

Python代码可以通过标准输入或标准输出传递数据,Hadoop Streaming将负责确保其在分布式环境中正确地执行。

以下是Python与Hadoop的操作技巧和步骤:1.准备MapReduce任务首先,需要准备一个MapReduce任务。

在Python中,可以使用其他Python库来创建MapReduce程序。

例如,可以使用mrjob库来定义和运行MapReduce任务。

2.Streaming命令streaming命令是一种将MapReduce作业提交到Hadoop集群的方法。

尚硅谷大数据技术之 Hadoop(生产调优手册)说明书

尚硅谷大数据技术之Hadoop(生产调优手册)(作者:尚硅谷大数据研发部)版本:V3.3第1章HDFS—核心参数1.1 NameNode内存生产配置1)NameNode内存计算每个文件块大概占用150byte,一台服务器128G内存为例,能存储多少文件块呢?128 * 1024 * 1024 * 1024 / 150Byte ≈9.1亿G MB KB Byte2)Hadoop2.x系列,配置NameNode内存NameNode内存默认2000m,如果服务器内存4G,NameNode内存可以配置3g。

在hadoop-env.sh文件中配置如下。

HADOOP_NAMENODE_OPTS=-Xmx3072m3)Hadoop3.x系列,配置NameNode内存(1)hadoop-env.sh中描述Hadoop的内存是动态分配的# The maximum amount of heap to use (Java -Xmx). If no unit # is provided, it will be converted to MB. Daemons will# prefer any Xmx setting in their respective _OPT variable.# There is no default; the JVM will autoscale based upon machine # memory size.# export HADOOP_HEAPSIZE_MAX=# The minimum amount of heap to use (Java -Xms). If no unit # is provided, it will be converted to MB. Daemons will# prefer any Xms setting in their respective _OPT variable.# There is no default; the JVM will autoscale based upon machine # memory size.# export HADOOP_HEAPSIZE_MIN=HADOOP_NAMENODE_OPTS=-Xmx102400m(2)查看NameNode占用内存[atguigu@hadoop102 ~]$ jps3088 NodeManager2611 NameNode3271 JobHistoryServer2744 DataNode3579 Jps[atguigu@hadoop102 ~]$ jmap -heap 2611Heap Configuration:MaxHeapSize = 1031798784 (984.0MB)(3)查看DataNode占用内存[atguigu@hadoop102 ~]$ jmap -heap 2744Heap Configuration:MaxHeapSize = 1031798784 (984.0MB)查看发现hadoop102上的NameNode和DataNode占用内存都是自动分配的,且相等。

hadoop大数据技术基础 python版

Hadoop大数据技术基础 python版随着互联网技术的不断发展和数据量的爆炸式增长,大数据技术成为了当前互联网行业的热门话题之一。

Hadoop作为一种开源的大数据处理评台,其在大数据领域的应用日益广泛。

而Python作为一种简洁、易读、易学的编程语言,也在大数据分析与处理中扮演着不可或缺的角色。

本文将介绍Hadoop大数据技术的基础知识,并结合Python编程语言,分析其在大数据处理中的应用。

一、Hadoop大数据技术基础1. Hadoop简介Hadoop是一种用于存储和处理大规模数据的开源框架,它主要包括Hadoop分布式文件系统(HDFS)和MapReduce计算框架。

Hadoop分布式文件系统用于存储大规模数据,而MapReduce计算框架则用于分布式数据处理。

2. Hadoop生态系统除了HDFS和MapReduce之外,Hadoop生态系统还包括了许多其他组件,例如HBase、Hive、Pig、ZooKeeper等。

这些组件形成了一个完整的大数据处理评台,能够满足各种不同的大数据处理需求。

3. Hadoop集群Hadoop通过在多台服务器上构建集群来实现数据的存储和处理。

集群中的各个计算节点共同参与数据的存储和计算,从而实现了大规模数据的分布式处理。

二、Python在Hadoop大数据处理中的应用1. Hadoop StreamingHadoop Streaming是Hadoop提供的一个用于在MapReduce中使用任意编程语言的工具。

通过Hadoop Streaming,用户可以借助Python编写Map和Reduce的程序,从而实现对大规模数据的处理和分析。

2. Hadoop连接Python除了Hadoop Streaming外,Python还可以通过Hadoop提供的第三方库和接口来连接Hadoop集群,实现对Hadoop集群中数据的读取、存储和计算。

这为Python程序员在大数据处理领域提供了更多的可能性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

WordCount Example

import java.io.IOException; import java.util.*; import org.apache.hadoop.fs.Path; import org.apache.hadoop.io.*; import org.apache.hadoop.mapred.*;

public class WordCount{ public static class Map extends MapReduceBase implements Mapper<LongWritable, Text, Text, IntWritable> { … } public static class Reduce extends MapReduceBase implements Reducer<Text, IntWritable, Text, InWritable> { … }

public void map(LongWritable key, Text value, OutputCollector<Text, IntWritable> output, Reporter reporter) throws IOException{ String line = value.toString(); StringTokenizertokenizer = new StringTokenizer(line); while(tokenizer.hasMoreTokens()){ word.set(tokenizer.nextToken()); output.collect(word, one); } } }

TIP: For cache coherency, define your intermediate values outside loops. Because Writable objects are mutable, this avoids unnecessary garbage collection

WordCount Example

public static class Map extends MapReduceBase implements Mapper<LongWritable, Text, Text, IntWritable>{ private final static IntWritable one = private Text word = new Text(); new IntWritable(1);

CS246 TA Session: Hadoop Tutorial

Peyman kazemian 1/11/2011

Hadoop Terminology

• Job: a full program – an execution of a Mapper and Reducer across data set • Task: An execution of a mapper or reducer on a slice of data • Task Attempt: A particular instance of an attempt to execute a task on a machine

Installing Map Reduce

• Please follow the instructions here: /class/cs246/cs246-11mmds/hw_files/hadoop_install.pdf Tip: Don’t forget to run ssh daemon (Linux) or activate sharing via ssh (Mac OS X: settings --> sharing). Also remember to open your firewall on port 22.

References

Slides credited to: • /videos/programming_with_hadoop • /wp-content/uploads/2010/01/4ProgrammingWithHadoop.pdf • http://arifn.web.id/blog/2010/01/23/hadoop-in-netbeans.html • /hadoop/mac.html

Writing Map Reduce code on Hadoop

• Need to implement a ‘Map’ and ‘Reduce’ class. They should have ‘map’ and ‘reduce’ methods respectively.

void map(WritableComparable key, Writable value, OutputCollectoroutput, Reporter reporter) Void reduce( WritableComparable key, Iteratorvalues, OutputCollectoroutput, Reporter reporter)

Writing Map Reduce code on Hadoop

• We use Eclipse to write the code. 1) Create a new java project. 2) Add hadoop-version-core.jar as external archive to your project. 3) Write your source code in a .java file 4) Export JAR file. (File->Export and select JAR file. Then choose the entire project directory to export)

WordCount Example

public static class Reduce extends MapReduceBase implements Reducer<Text, IntWritable, Text, IntWritable>{ public void reduce(Text key, Iterator<IntWritable> values, OutputCollector<Text, IntWritable> output, Reporter reporter) throws IOException{ int sum = 0; while (values.hasNext()){ sum += values.next().get(); } output.collect(key, new IntWritable(sum)); } }

Hadoop Map Reduce at High Level

Hadoop Map Reduce at High Level

• Master node runs JobTracker instance, which accepts Job requests from clients • TaskTracker instances run on slave nodes • TaskTracker forks separate Java process for task instances • MapReduce programs are contained in a Java JAR file. Running a MapReduce job places these files into the HDFS and notifies TaskTrackers where to retrieve the relevant program code • Data is already in HDFS.

public static void main(String[]args) throws IOEe

public static void main(String[]args) throws IOException{ JobConf conf = new JobConf(WordCount.class); conf.setJobName("wordcount"); conf.setOutputKeyClass(Text.class); conf.setOutputValueClass(IntWritable.class); conf.setMapperClass(Map.class); conf.setReducerClass(Reduce.class); conf.setInputFormat(TextInputFormat.class); conf.setOutputFormat(TextOutputFormat.class); FileInputFormat.setInputPaths(conf, new Path(args[0])); FileOutputFormat.setOutputPath(conf, new Path(args[1])); try{ JobClient.runJob(conf); }catch(IOExceptione){ System.err.println(e.getMessage()); } }

CAUTION: values.next() returns the reference to the same object everytime it is called. So if you want to store the reducer input values, you need to copy it yourself.

What is Writeable?

• Hadoop defines its own “box” classes forstrings (Text), integers (IntWritable), etc. • All values are instances of Writable • All keys are instances ofWritableComparable because they need to be compared. • Writable objects are mutable.