南开大学20秋学期《网络爬虫与信息提取》在线作业答案资料

20春学期(1709、1803、1809、1903、1909、2003)《网络爬虫与信息提取》在线作业答卷

20春学期(1709、1803、1809、1903、1909、2003)《网络爬虫与信息提取》在线作业

试卷总分:100 得分:100

一、单选题(共20 道试题,共40 分)

1.要使用Python来操作UI Automator从而控制手机,需要安装一个第三方库()

A.uiautomator

B.ui_automator

C.pyautomator

D.automator

答案:A

2.使用UI Automatorr让屏幕向左滚动的操作是得到相应控件后使用命令()

A.scroll.left

B.scroll.horiz.left

C.scroll.horiz.forward

D.scroll.forward

答案:C

3.Python中Object={'obj_1':'1','obj_2':'2'},则Objcet是()

A.集合

B.字典

C.列表

D.元组

答案:B

4.如果使用Python的数据结构来做类比的话,MongoDB中库相当于一个大字典,大字典里面的每一个键值对都对应了一个集合,Key为(),Value就是一个集合。

A.集合的名字

B.集合

C.文档

D.字典

答案:A

5.以下表示请求正常处理的HTTP状态码为

A.500

B.404

C.301

D.200

答案:D

6.Redis是一个开源的使用()语言编写

A.Python

B.JAVA

C.C++

D.ANSI C。

南开20秋学期《网络爬虫与信息提取》在线作业答案06830

(单选题)1: Redis若要进入交互环境,需要打开终端输入()

A: redis-cli

B: redis

C: redis-cmd

D: redis-start

正确答案: A

(单选题)2: 使用UI Automatorr根据坐标来滑动桌面的操作是得到相应控件后使用命令() A: swipe

B: move

C: scroll

D: fly

正确答案: A

(单选题)3: Python中Object={'obj_1':'1','obj_2':'2'},则Objcet.get('boj_3','3')是()

A: 1

B: 2

C: 3

D: 无输出

正确答案: C

(单选题)4: Python中若定义object="12345",则print(object[::-1])输出()

A: 1

B: 5

C: 54321

D: 程序报错

正确答案: C

(单选题)5: 在Scrapy的目录下,哪个文件负责定义需要爬取的数据?()

A: spiders文件夹

B: item.py

C: pipeline.py

D: settings.py

正确答案: B

(单选题)6: Python中Object=(1, 2, 3, 4, 5),则Objcet是()

A: 列表

B: 元组

C: 字典

D: 集合

正确答案: B

(单选题)7: 如果很多爬虫同时对一个网站全速爬取,那么其实就是对网站进行了()攻击。

[南开大学]21春学期《网络爬虫与信息提取》在线作业-(资料答案)1

![[南开大学]21春学期《网络爬虫与信息提取》在线作业-(资料答案)1](https://img.taocdn.com/s3/m/cb4f9f8725c52cc58ad6be25.png)

[南开大学]21春学期《网络爬虫与信息提取》在线作业试卷总分:100 得分:100一、单选题 (共 20 道试题,共 40 分)1.下列说法错误的是()<A>项.小程序的请求极其简单,基本上没有验证信息<B>项.用Python来请求小程序的后台接口从而获取数据,比请求异步加载网页的后台接口要复杂很多。

<C>项.如果目标网站有微信小程序,那么一定要优先调查能否通过小程序的接口来抓取数据。

<D>项.小程序的反爬虫能力比网页版的低很多。

使用小程序的接口来爬数据,能极大提高爬虫的开发效率。

[-标准答案-]:B2.()是一个传递信息的通道。

它负责将爬取博文列表页获取到的信息传递给负责爬取正文页的方法中。

<A>项.meta<B>项.head<C>项.header<D>项.body[-标准答案-]:A3.启动MongoDB使用命令mongod --() usr/local/etc/mongo<D>项.conf<A>项.config<B>项.install<C>项.start<D>项.begin[-标准答案-]:A4.HTTP常用状态码表明服务器不允许访问那个资源的是()<A>项.500<B>项.503<C>项.403<D>项.405[-标准答案-]:C5.Python正则表达式模块的findall方法如果没有匹配到结果,则返回结果为()<A>项.空<B>项.空列表<C>项.空元组<D>项.不返回[-标准答案-]:B6.Scrapy中使用Xpath获得的结果调用了.extract方法,结果以()形式生成<A>项.列表<B>项.元组<C>项.字典<D>项.集合[-标准答案-]:A7.在Scrapy的目录下,哪个文件负责数据抓取以后的处理工作?()<A>项.spiders文件夹<B>项.item.py<C>项.pipelin<E>项.py<D>项.settings.py[-标准答案-]:C8.Python在Windows路径字符串左引号的左边加()符号来避免反斜杠问题<A>项.s<B>项.c<C>项.d<D>项.r[-标准答案-]:D9.python中可以用来将图片中的文字转换为文本的第三方类库是<A>项.lxml<B>项.requests<C>项.beautifulsoup<D>项.pytesseract[-标准答案-]:D10.在Linux中哪个命令是添加权限的()<A>项.chmod<B>项.sudo<C>项.cp<D>项.mkdir[-标准答案-]:A11.使用python定制mitmproxy,下面的语句请求的是()。

南开大学智慧树知到“计算机科学与技术”《网络爬虫与信息提取》网课测试题答案1

南开大学智慧树知到“计算机科学与技术”《网络爬虫与信息提取》网课测试题答案(图片大小可自由调整)第1卷一.综合考核(共15题)1.使用xpath方法的返回类型是()。

A.列表B.元组C.字典D.集合2.以下哪些方法属于Python写CSV文件的方法?()A.writeheadersB.writeheaderC.writerrowsD.writerow3.在Linux中哪个命令是添加权限的()A.chmodB.sudoC.cpD.mkdir4.使用BeautifulSoup对象后可以使用()来查找内容A.find_allB.findC.searchD.search_all5.Python中跳过本次循环应用关键字()A.breakB.continueC.exitD.return 6.Redis中往集合中读数据,使用关键字()A.popB.spopC.lpopD.range7.如果通过爬虫抓取某公司网站的公开数据,分析以后发现这个公司业绩非常好。

于是将数据或者分析结果出售给某基金公司,从而获得销售收入。

这是合法的。

()A.正确B.错误8.Python中定义函数关键字为()。

A.defB.defineC.funcD.function9.requests中get请求方法的使用为requests.get('网址', data=data)。

()T.对F.错10.device.sleep()方法是使用UI Automatorr关闭屏幕的命令。

()A.正确B.错误11.Python中列表可以用()方法在末尾添加元素。

A.addB.appendC.plusD.+12.chrome开发者工具没法对数据进行搜索。

如果想知道一个特定的异步加载内容来自哪个请求,必须在“Network”选项卡里面一个请求一个请求地进行查看。

()T.对F.错13.Python中()容器有推导式。

A.列表B.元组C.字典D.集合14.在Windows中下若要运行Redis可以运行redis-server/usr/local/etc/redis.conf。

南开大学智慧树知到“计算机科学与技术”《网络爬虫与信息提取》网课测试题答案5

南开大学智慧树知到“计算机科学与技术”《网络爬虫与信息提取》网课测试题答案(图片大小可自由调整)第1卷一.综合考核(共15题)1.Python中直接对浮点数进行计算有print(0.1+0.2),则结果为0.3。

()A.正确B.错误2.请问按哪个键可以打开Chrome自带的开发者工具()A.F10B.F1C.F11D.F123.Python正则表达式模块的findall方法提取内容包含多个,则返回结果的列表中会包含()A.列表B.元组C.字典D.集合4.PyMongo中的查找方法的参数是哪种数据结构()A.列表B.元组C.字典D.集合5.爬虫登录需要识别验证码可以先把程序关闭,肉眼识别以后再重新运行。

()A.正确B.错误6.Python中有哪些实现多线程方法?()A.multiprocess.dummyB.threading.ThreadC.processD.PyMongoDB7.UI Automator Viewer与Python uiautomator可以同时使用。

()A.正确B.错误8.Redis插入数据都是插入到列表右侧,因此读取数据也是从右侧读取。

()T.对F.错9.HTTP常用状态码表明表明服务器本身发生错误的有()A.403B.404C.500D.50310.当爬虫创建好了之后,可以使用"scrapy()"命令运行爬虫。

A.startupB.starwarC.drawlD.crawl11.下面Python代码输出为:()def default_para_without_trap(para=[],value=0):if not para:para=[]para.append(value)return para print(‘第一步:{}’.format(default_para_trap(value=100))) print(‘第二步:{}’.format(default_para_trap(value=50)))A.第一步:[100]第二步:[100,50]B.第一步:[100]第二步:[50]C.第一步:[100]第二步:[]D.第一步:[100]第二步:[100]12.在配置ios使用Charles的操作中,正确的有()A.对于苹果设备,首先要保证计算机和苹果设备联在同一个Wi-Fi上B.选择“HTTP代理”下面的“手动”选项卡,在“服务器”处输入计算机的IP地址,在“端口”处输入8888C.输入完成代理以后按下苹果设备的Home键,设置就会自动保存D.安装完成证书以后,在设置中打开“关于本机”,找到最下面的“证书信任设置”,并在里面启动对Charles证书的完全信任13.Redis是()数据库A.关系数据库B.键值数据库C.列存数据库D.图数据库14.Python中若定义object=“12345”,则print(object[::-1])输出()。

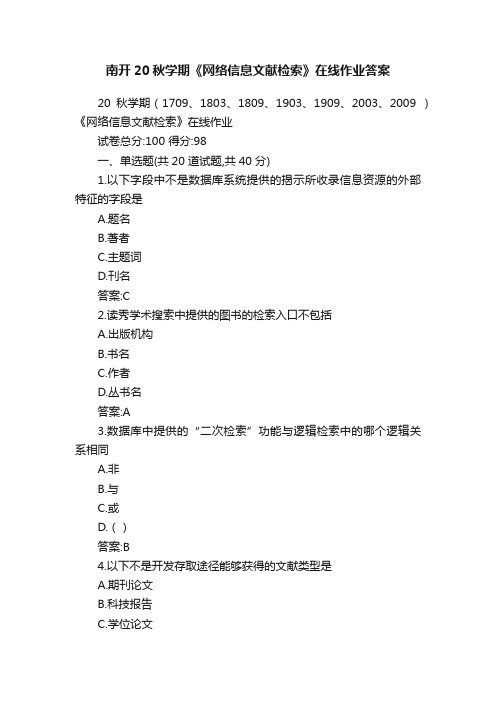

南开20秋学期《网络信息文献检索》在线作业答案

南开20秋学期《网络信息文献检索》在线作业答案20秋学期(1709、1803、1809、1903、1909、2003、2009 )《网络信息文献检索》在线作业试卷总分:100 得分:98一、单选题(共20 道试题,共40 分)1.以下字段中不是数据库系统提供的揭示所收录信息资源的外部特征的字段是A.题名B.著者C.主题词D.刊名答案:C2.读秀学术搜索中提供的图书的检索入口不包括A.出版机构B.书名C.作者D.丛书名答案:A3.数据库中提供的“二次检索”功能与逻辑检索中的哪个逻辑关系相同A.非B.与C.或D.()答案:B4.以下不是开发存取途径能够获得的文献类型是A.期刊论文B.科技报告C.学位论文D.报纸答案:D5.要了解某篇论文的社会影响力,哪种检索方式能最直接表达所要检索内容的含义A.引文检索B.专业检索C.简单检索D.限制检索答案:A6.使用百度搜索时,下面哪个逻辑运算符能实现逻辑“或”。

A.︱(前后无空格)B.︱(前后空格)C.︱(前有空格)D.︱(后有空格)答案:B7.在进行研究课题初步选题的阶段,搜集信息资源时较好的检索途径是A.分类途径B.题名途径C.主题途径D.号码途径答案:C8.GB3469-83《文献类型与文献载体代码》的规定以单字母方式标识各种参考文献类型,下面这条文献属于哪种文献类型?()刘少奇.论共产党员的修养(修订2版)[M].北京:人民出版社,1962,(76页).A.图书B.会议文献C.专利文献D.学位论文答案:A9.网络信息资源检索中利用的书名、著者、出版机构、译者、发表时间等内容,我们称其为信息资源的A.内部特征B.详细信息C.外部特征D.检索途径答案:C10.在数据库中获得检索结果后,首先不应该进行的工作是A.分析检索结果质量B.查看文献聚类信息C.调整检索策略D.查看全文答案:D11.与布尔逻辑检索功能相同的截词检索方式是A.后截断B.中截断C.两端截断D.前截断答案:B12.百度中下面()逻辑“非”,即搜索结果要求不包含某些特定信息A.纳米技术陶瓷B.网络-局域网C.非典︱SARS。

南开大学20秋学期《网络爬虫与信息提取》在线作业答案资料1

[南开大学]20秋学期《网络爬虫与信息提取》在线作业提示:请认真学习本资料,并完成课程复习!!100一、单选题 (共 20 道试题,共 40 分)1.Redis若要进入交互环境,需要打开终端输入()A.redis-cliB.redisC.redis-cmdD.redis-start[本题参考选择是]:A2.使用UI Automatorr根据坐标来滑动桌面的操作是得到相应控件后使用命令()A.swipeB.moveC.scrollD.fly[本题参考选择是]:A3.Python中Object={'obj_1':'1','obj_2':'2'},则Objcet.get('boj_3','3')是()A.1B.2C.3D.无输出[本题参考选择是]:C4.Python中若定义object="12345",则print(object[::-1])输出()A.1B.5C.54321D.程序报错[本题参考选择是]:C5.在Scrapy的目录下,哪个文件负责定义需要爬取的数据?()A.spiders文件夹B.item.pyC.pipeline.pyD.settings.py[本题参考选择是]:B6.Python中Object=(1, 2, 3, 4, 5),则Objcet是()A.列表B.元组C.字典D.集合[本题参考选择是]:B7.如果很多爬虫同时对一个网站全速爬取,那么其实就是对网站进行了()攻击A.XSSB.DOSC.DDOSD.跨域[本题参考选择是]:C8.当爬虫创建好了之后,可以使用"scrapy()" 命令运行爬虫。

A.startupB.starwarC.drawlD.crawl[本题参考选择是]:D9.Redis是()数据库A.关系数据库B.键值数据库C.列存数据库D.图数据库[本题参考选择是]:B10.Scrapy中使用Xpath获得的结果调用了.extract方法,结果以()形式生成A.列表B.元组C.字典D.集合[本题参考选择是]:A11.使用UI Automator打开微信的操作是获取相应图标后使用命令()A.touchB.clickC.pushD.hover[本题参考选择是]:B12.使用xpath方法的返回类型是()A.列表B.元组C.字典D.集合[本题参考选择是]:A。

【南开】《网络爬虫与信息提取》20春期末考核答卷(标准答案)

《网络爬虫与信息提取》20春期末考核-00001试卷总分:100 得分100一、单选题 (共 20 道试题,共 40 分)1.如果使用Python的数据结构来做类比的话,MongoDB中文档相当于一个()A.列表B.元组C.字典D.集合答案:C2.使用UI Automatorr输入文字的操作是得到相应控件后使用命令()A.settextB.setC.set_textD.text答案:C3.在Scrapy的目录下,哪个文件负责存放爬虫文件?()A.spiders文件夹B.item.pyC.pipeline.pyD.settings.py答案:A4.HTTP常用状态码表明服务器正忙的是()A.500B.503C.403D.404答案:B5.如果很多爬虫同时对一个网站全速爬取,那么其实就是对网站进行了()攻击A.XSSB.DOSC.DDOSD.跨域答案:C6.使用UI Automatorr判断元素是否存在的操作是得到相应控件后使用命令()A.existB.existsC.isnullD.contains答案:B7.带上通过Chrome浏览器从评论页面复制而来的()再发起请求,可以减少爬虫被网站封锁的概率A.CookieB.HtmlC.HeadersD.CSS答案:C8.Redis中查看一个列表长度,使用关键字()A.lenB.lengthC.llenD.count答案:C9.使用Xpath获取文本使用()A.textB.text()C.contentD.content()答案:B10.使用python定制mitmproxy,下面的语句请求的是()。

{req.headers["User-Agent"]}A.headersB.文本内容C.目标网站er-agent答案:D11.Python中Object={1, 2, 3, 4, 5},则Objcet是()A.列表B.元组C.字典D.集合答案:D12.在Scrapy的目录下,哪个文件负责存放爬虫的各种配置信息?()A.spiders文件夹B.item.pyC.pipeline.pyD.settings.py答案:D13.Redis是一个开源的使用()语言编写A.ANSI CB.C++C.JAVAD.Python答案:A14.某些网站在发起Ajax请求时会携带()字符串用于身份验证A.TokenB.CookieC.ReqTimeD.sum答案:A15.使用UI Automatorr点亮屏幕的操作是得到相应控件后使用命令()A.wakeupB.lightC.brightD.sleep答案:A16.Chrome的开发者工具中哪个选项可以查找到cookiesA.ElementsB.SourcesworkD.Peformance答案:C17.Scrapy中使用Xpath获得的结果调用了.extract方法,结果以()形式生成A.列表B.元组C.字典D.集合答案:A18.以下哪个命令是创建文件夹命令()A.curlB.tar -zxvfC.mkdirD.cp答案:C19.可以通过()绕过网站登录。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

[南开大学]20秋学期《网络爬虫与信息提取》在线作业

提示:请认真学习本资料,并完成课程复习!!100

一、单选题 (共 20 道试题,共 40 分)

1.当爬虫创建好了之后,可以使用"scrapy()" 命令运行爬虫。

A.startup

B.starwar

C.drawl

D.crawl

[本题参考选择是]:D

2.以下哪个命令是复制文件或者文件夹命令()

A.curl

B.tar -zxvf

C.mkdir

D.cp

[本题参考选择是]:D

3.Python中哪种容器一旦生成就不能修改

A.列表

B.元组

C.字典

D.集合

[本题参考选择是]:B

4.在Scrapy的目录下,哪个文件负责定义需要爬取的数据?()

A.spiders文件夹

B.item.py

C.pipeline.py

D.settings.py

[本题参考选择是]:B

5.使用UI Automatorr根据坐标来滑动桌面的操作是得到相应控件后使用命令()

A.swipe

B.move

C.scroll

D.fly

[本题参考选择是]:A

6.xpath中extract方法返回值类型是()

A.列表

B.元组

C.字典

D.集合

[本题参考选择是]:A

7.以下哪个命令是linux下解压缩命令()

A.curl

B.tar -zxvf

C.mkdir

D.cp

[本题参考选择是]:B

8.Python中定义函数关键字为()

A.def

B.define

C.func

D.function

[本题参考选择是]:A

9.下列说法错误的是()

A.小程序的请求极其简单,基本上没有验证信息

B.用Python来请求小程序的后台接口从而获取数据,比请求异步加载网页的后台接口要复杂很多。

C.如果目标网站有微信小程序,那么一定要优先调查能否通过小程序的接口来抓取数据。

D.小程序的反爬虫能力比网页版的低很多。

使用小程序的接口来爬数据,能极大提高爬虫的开发效率。

[本题参考选择是]:B

10.当需要把Python里面的数据发送给网页时,应先将其转换成()

A.Json字符串

B.GET

C.POST

D.Request

[本题参考选择是]:A

11.Redis中从集合中查看有多少个值,用关键字()

A.scard

B.card

C.count

D.distinct

[本题参考选择是]:A

12.Python中把集合转换为列表需要使用##函数

A.set

B.list

C.convert。