人工神经网络Matlab实现代码

在Matlab中实现神经网络的方法与实例

在Matlab中实现神经网络的方法与实例神经网络是一种模拟人类大脑神经系统的计算模型,它能够通过学习数据的模式和关联性来解决各种问题。

在计算机科学和人工智能领域,神经网络被广泛应用于图像识别、自然语言处理、预测等任务。

而Matlab作为一种功能强大的科学计算软件,提供了一套完善的工具箱,可以方便地实现神经网络的建模和训练。

本文将介绍在Matlab中实现神经网络的方法与实例。

首先,我们会简要介绍神经网络的基本原理和结构,然后详细讲解在Matlab中如何创建并训练神经网络模型,最后通过几个实例展示神经网络在不同领域的应用。

一、神经网络的原理和结构神经网络模型由神经元和它们之间的连接构成。

每个神经元接收输入信号,并通过权重和偏置进行加权计算,然后使用激活函数对结果进行非线性变换。

这样,神经网络就能够模拟复杂的非线性关系。

常见的神经网络结构包括前馈神经网络(Feedforward Neural Network)和循环神经网络(Recurrent Neural Network)。

前馈神经网络是最基本的结构,信号只能向前传递,输出不对网络进行反馈;而循环神经网络具有反馈连接,可以对自身的输出进行再处理,适用于序列数据的建模。

神经网络的训练是通过最小化损失函数来优化模型的参数。

常用的训练算法包括梯度下降法和反向传播算法。

其中,梯度下降法通过计算损失函数对参数的梯度来更新参数;反向传播算法是梯度下降法在神经网络中的具体应用,通过反向计算梯度来更新网络的权重和偏置。

二、在Matlab中创建神经网络模型在Matlab中,可以通过Neural Network Toolbox来创建和训练神经网络模型。

首先,我们需要定义神经网络的结构,包括输入层、隐藏层和输出层的神经元数量,以及每个神经元之间的连接权重。

例如,我们可以创建一个三层的前馈神经网络模型:```matlabnet = feedforwardnet([10 8]);```其中,`[10 8]`表示隐藏层的神经元数量分别为10和8。

神经网络算法matlab

神经网络算法matlab神经网络算法是一种基于大脑神经元行为的计算模型,通过模拟神经元之间的相互连接和信息传递来实现智能的数据处理和学习能力。

Matlab是一种专门用于科学计算和算法开发的高级编程语言,在神经网络领域也有广泛的应用。

本文将介绍神经网络算法在Matlab中的实现方法。

首先,为了使用神经网络算法,首先需要安装Matlab并确保正确配置了相应的神经网络工具箱。

Matlab的神经网络工具箱提供了一系列用于构建、训练和测试神经网络模型的函数和工具。

在Matlab中,可以使用`feedforwardnet`函数来创建一个前馈神经网络。

这个函数可以指定网络的架构,包括神经元的数量、层数和激活函数等。

例如,下面的代码创建一个具有一个隐藏层和一个输出层的前馈神经网络:net = feedforwardnet([10]);```接下来,需要准备训练数据和目标数据。

在Matlab中,可以使用`mat2vec`函数将训练数据和目标数据转换为神经网络所需的格式。

然后,可以使用`train`函数将训练数据和目标数据输入到神经网络中进行训练。

例如,下面的代码将训练一个前馈神经网络来拟合一组数据:input = [1 2 3 4 5];target = [2 4 6 8 10];data = mat2vec(input, target);net = train(net, data.input, data.target);```在训练完成后,可以使用`sim`函数来对新的输入数据进行预测。

例如,下面的代码使用训练好的神经网络对新的输入数据进行预测:input_test = [6 7 8 9 10];output = sim(net, input_test);```除了前馈神经网络,Matlab还支持其他类型的神经网络模型,例如循环神经网络和自适应神经网络。

对于循环神经网络,可以使用`cascadeforwardnet`函数来创建一个具有循环连接的神经网络。

matlab通用神经网络代码,matlab通用神经网络代码

matlab通⽤神经⽹络代码,matlab通⽤神经⽹络代码%通⽤感应器神经⽹络。

P=[-0.5 -0.5 0.3 -0.1 -40;-0.5 0.5 -0.5 1 50];%输⼊向量T=[1 1 0 0 1];%期望输出plotpv(P,T);%描绘输⼊点图像net=newp([-40 1;-1 50],1);%⽣成⽹络,其中参数分别为输⼊向量的范围和神经元感应器数量hold onlinehandle=plotpc(net.iw{1},net.b{1});net.adaptparam.passes=3;for a=1:25%训练次数[net,Y,E]=adapt(net,P,T);linehandle=plotpc(net.iw{1},net.b{1},linehandle);drawnow;end%通⽤newlin程序%通⽤线性⽹络进⾏预测time=0:0.025:5;T=sin(time*4*pi);Q=length(T);P=zeros(5,Q);%P中存储信号T的前5(可变,根据需要⽽定)次值,作为⽹络输⼊。

P(1,2:Q)=T(1,1:(Q-1));P(2,3:Q)=T(1,1:(Q-2));P(3,4:Q)=T(1,1:(Q-3));P(4,5:Q)=T(1,1:(Q-4));P(5,6:Q)=T(1,1:(Q-5));plot(time,T)%绘制信号T曲线xlabel('时间');ylabel('⽬标信号');title('待预测信号');net=newlind(P,T);%根据输⼊和期望输出直接⽣成线性⽹络a=sim(net,P);%⽹络测试figure(2)plot(time,a,time,T,'+')xlabel('时间');ylabel('输出-⽬标+');title('输出信号和⽬标信号');e=T-a;figure(3)plot(time,e)hold onplot([min(time) max(time)],[0 0],'r:')%可⽤plot(x,zeros(size(x)),'r:')代替hold offxlabel('时间');ylabel('误差');title('误差信号');%通⽤BP神经⽹络P=[-1 -1 2 2;0 5 0 5];t=[-1 -1 1 1];net=newff(minmax(P),[3,1],{'tansig','purelin'},'traingd');%输⼊参数依次为:'样本P范围',[各层神经元数⽬],{各层传递函数},'训练函数'%训练函数traingd--梯度下降法,有7个训练参数.%训练函数traingdm--有动量的梯度下降法,附加1个训练参数mc(动量因⼦,缺省为0.9)%训练函数traingda--有⾃适应lr的梯度下降法,附加3个训练参数:lr_inc(学习率增长⽐,缺省为1.05;% lr_dec(学习率下降⽐,缺省为0.7);max_perf_inc(表现函数增加最⼤⽐,缺省为1.04)%训练函数traingdx--有动量的梯度下降法中赋以⾃适应lr的⽅法,附加traingdm和traingda的4个附加参数%训练函数trainrp--弹性梯度下降法,可以消除输⼊数值很⼤或很⼩时的误差,附加4个训练参数:% delt_inc(权值变化增加量,缺省为1.2);delt_dec(权值变化减⼩量,缺省为0.5);% delta0(初始权值变化,缺省为0.07);deltamax(权值变化最⼤值,缺省为50.0)% 适合⼤型⽹络%训练函数traincgf--Fletcher-Reeves共轭梯度法;训练函数traincgp--Polak-Ribiere共轭梯度法;%训练函数traincgb--Powell-Beale共轭梯度法%共轭梯度法占⽤存储空间⼩,附加1训练参数searchFcn(⼀维线性搜索⽅法,缺省为srchcha);缺少1个训练参数lr %训练函数trainscg--量化共轭梯度法,与其他共轭梯度法相⽐,节约时间.适合⼤型⽹络% 附加2个训练参数:sigma(因为⼆次求导对权值调整的影响参数,缺省为5.0e-5);% lambda(Hessian阵不确定性调节参数,缺省为5.0e-7)% 缺少1个训练参数:lr%训练函数trainbfg--BFGS拟⽜顿回退法,收敛速度快,但需要更多内存,与共轭梯度法训练参数相同,适合⼩⽹络%训练函数trainoss--⼀步正割的BP训练法,解决了BFGS消耗内存的问题,与共轭梯度法训练参数相同%训练函数trainlm--Levenberg-Marquardt训练法,⽤于内存充⾜的中⼩型⽹络net=init(net);net.trainparam.epochs=300; %最⼤训练次数(前缺省为10,⾃trainrp后,缺省为100)net.trainparam.lr=0.05; %学习率(缺省为0.01)net.trainparam.show=50; %限时训练迭代过程(NaN表⽰不显⽰,缺省为25)net.trainparam.goal=1e-5; %训练要求精度(缺省为0)%net.trainparam.max_fail 最⼤失败次数(缺省为5)%net.trainparam.min_grad 最⼩梯度要求(前缺省为1e-10,⾃trainrp后,缺省为1e-6)%net.trainparam.time 最⼤训练时间(缺省为inf)[net,tr]=train(net,P,t); %⽹络训练a=sim(net,P) %⽹络仿真%通⽤径向基函数⽹络—— %其在逼近能⼒,分类能⼒,学习速度⽅⾯均优于BP神经⽹络 %在径向基⽹络中,径向基层的散步常数是spread的选取是关键 %spread越⼤,需要的神经元越少,但精度会相应下降,spread的缺省值为1 %可以通过net=newrbe(P,T,spread)⽣成⽹络,且误差为0 %可以通过net=newrb(P,T,goal,spread)⽣成⽹络,神经元由1开始增加,直到达到训练精度或神经元数⽬最多为⽌ %GRNN⽹络,迅速⽣成⼴义回归神经⽹络(GRNN) P=[4 5 6]; T=[1.5 3.6 6.7]; net=newgrnn(P,T); %仿真验证 p=4.5; v=sim(net,p) %PNN⽹络,概率神经⽹络 P=[0 0 ;1 1;0 3;1 4;3 1;4 1;4 3]'; Tc=[1 1 2 2 3 3 3]; %将期望输出通过ind2vec()转换,并设计、验证⽹络 T=ind2vec(Tc); net=newpnn(P,T); Y=sim(net,P); Yc=vec2ind(Y) %尝试⽤其他的输⼊向量验证⽹络 P2=[1 4;0 1;5 2]'; Y=sim(net,P2);Yc=vec2ind(Y) %应⽤newrb()函数构建径向基⽹络,对⼀系列数据点进⾏函数逼近 P=-1:0.1:1; T=[-0.9602 -0.5770 -0.0729 0.3771 0.6405 0.6600 0.4609... 0.1336 -0.2013 -0.4344 -0.500 -0.3930 -0.1647 -0.0988... 0.3072 0.3960 0.3449 0.1816 -0.0312 -0.2189 -0.3201]; %绘制训练⽤样本的数据点 plot(P,T,'r*'); title('训练样本'); xlabel('输⼊向量P'); ylabel('⽬标向量T'); %设计⼀个径向基函数⽹络,⽹络有两层,隐层为径向基神经元,输出层为线性神经元 %绘制隐层神经元径向基传递函数的曲线 p=-3:.1:3;a=radbas(p); plot(p,a) title('径向基传递函数') xlabel('输⼊向量p') %隐层神经元的权值、阈值与径向基函数的位置和宽度有关,只要隐层神经元数⽬、权值、阈值正确,可逼近任意函数 %例如 a2=radbas(p-1.5); a3=radbas(p+2); a4=a+a2*1.5+a3*0.5;plot(p,a,'b',p,a2,'g',p,a3,'r',p,a4,'m--') title('径向基传递函数权值之和') xlabel('输⼊p'); ylabel('输出a'); %应⽤newrb()函数构建径向基⽹络的时候,可以预先设定均⽅差精度eg以及散布常数sc eg=0.02; sc=1; %其值的选取与最终⽹络的效果有很⼤关系,过⼩造成过适性,过⼤造成重叠性 net=newrb(P,T,eg,sc); %⽹络测试 plot(P,T,'*') xlabel('输⼊'); X=-1:.01:1; Y=sim(net,X); hold on plot(X,Y); hold off legend('⽬标','输出') %应⽤grnn进⾏函数逼近 P=[1 2 3 4 5 6 7 8]; T=[0 1 2 3 2 1 2 1]; plot(P,T,'.','markersize',30) axis([0 9 -1 4]) title('待逼近函数') xlabel('P') ylabel('T') %⽹络设计 %对于离散数据点,散布常数spread选取⽐输⼊向量之间的距离稍⼩⼀些spread=0.7; net=newgrnn(P,T,spread); %⽹络测试 A=sim(net,P); hold on outputline=plot(P,A,'o','markersize',10,'color',[1 0 0]); title('检测⽹络') xlabel('P') ylabel('T和A') %应⽤pnn进⾏变量的分类 P=[1 2;2 2;1 1]; %输⼊向量 Tc=[1 2 3]; %P对应的三个期望输出 %绘制出输⼊向量及其相对应的类别 plot(P(1,:),P(2,:),'.','markersize',30) for i=1:3 text(P(1,i)+0.1,P(2,i),sprintf('class%g',Tc(i))) end axis([0 3 0 3]); title('三向量及其类别') xlabel('P(1,:)') ylabel('P(2,:)') %⽹络设计 T=ind2vec(Tc); spread=1;net=newgrnn(P,T,speard); %⽹络测试 A=sim(net,P); Ac=vec2ind(A); %绘制输⼊向量及其相应的⽹络输出plot(P(1,:),P(2,:),'.','markersize',30) for i=1:3 text(P(1,i)+0.1,P(2,i),sprintf('class %g',Ac(i))) end axis([0 3 0 3]); title('⽹络测试结果') xlabel('P(1,:)') ylabel('P(2,:)')。

matlab ann源代码 -回复

matlab ann源代码-回复MATLAB(全称MATrix LABoratory)是一种面向科学和工程计算的高级编程语言和环境,由MathWorks开发。

它是一种在数值计算领域应用广泛的工具,可以进行矩阵运算、数据可视化、绘图、图像处理、信号处理、控制系统设计等多种科学计算任务。

本文将以MATLAB ANN源代码为主题,探讨人工神经网络(Artificial Neural Network,简称ANN)在MATLAB中的实现方法。

ANN是一种模仿人脑神经系统结构和功能的数学模型,广泛应用于机器学习和模式识别等领域。

它由一个或多个神经元组成的神经元网络构成,通过学习过程自动调整网络参数以实现目标任务。

使用MATLAB中的ANN源代码,可以方便地构建和训练神经网络模型。

首先,我们需要准备数据集。

在MATLAB中,可以使用内置的样本数据集或自己创建数据集。

例如,可以使用MATLAB提供的“cancer_dataset”数据集,该数据集包含肿瘤的特征和对应的类别标签。

接下来,我们需要选择合适的ANN模型架构。

ANN模型的架构包括输入层、隐藏层和输出层的神经元数目,以及激活函数类型等。

在MATLAB 中,可以使用“patternnet”函数创建一个多层前向神经网络模型,该函数具有丰富的参数选项。

我们可以通过以下代码创建并配置ANN模型:matlabnet = patternnet(hiddenSizes); 创建神经网络模型net.divideParam.trainRatio = 0.7; 设置训练集比例net.divideParam.valRatio = 0.15; 设置验证集比例net.divideParam.testRatio = 0.15; 设置测试集比例其中,“hiddenSizes”参数表示隐藏层的神经元数目。

我们还可以使用“trainFcn”参数选择合适的训练算法,例如“trainlm”(Levenberg-Marquardt算法)或“traingda”(改进的梯度下降算法)等。

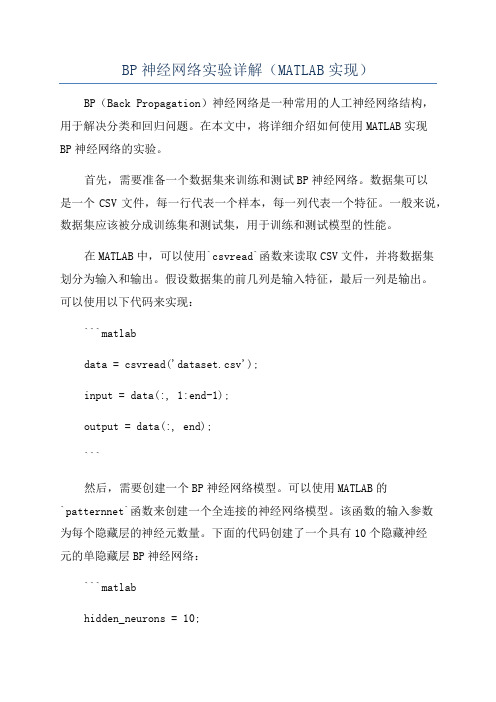

BP神经网络实验详解(MATLAB实现)

BP神经网络实验详解(MATLAB实现)BP(Back Propagation)神经网络是一种常用的人工神经网络结构,用于解决分类和回归问题。

在本文中,将详细介绍如何使用MATLAB实现BP神经网络的实验。

首先,需要准备一个数据集来训练和测试BP神经网络。

数据集可以是一个CSV文件,每一行代表一个样本,每一列代表一个特征。

一般来说,数据集应该被分成训练集和测试集,用于训练和测试模型的性能。

在MATLAB中,可以使用`csvread`函数来读取CSV文件,并将数据集划分为输入和输出。

假设数据集的前几列是输入特征,最后一列是输出。

可以使用以下代码来实现:```matlabdata = csvread('dataset.csv');input = data(:, 1:end-1);output = data(:, end);```然后,需要创建一个BP神经网络模型。

可以使用MATLAB的`patternnet`函数来创建一个全连接的神经网络模型。

该函数的输入参数为每个隐藏层的神经元数量。

下面的代码创建了一个具有10个隐藏神经元的单隐藏层BP神经网络:```matlabhidden_neurons = 10;net = patternnet(hidden_neurons);```接下来,需要对BP神经网络进行训练。

可以使用`train`函数来训练模型。

该函数的输入参数包括训练集的输入和输出,以及其他可选参数,如最大训练次数和停止条件。

下面的代码展示了如何使用`train`函数来训练模型:```matlabnet = train(net, input_train, output_train);```训练完成后,可以使用训练好的BP神经网络进行预测。

可以使用`net`模型的`sim`函数来进行预测。

下面的代码展示了如何使用`sim`函数预测测试集的输出:```matlaboutput_pred = sim(net, input_test);```最后,可以使用各种性能指标来评估预测的准确性。

基于MATLAB的BP人工神经网络设计

基于MATLAB的BP人工神经网络设计目录

一、介绍1

1.1研究背景1

1.2BP神经网络1

二、BP神经网络的设计3

2.1BP神经网络模型原理3

2.2BP神经网络模型参数5

2.3权重偏置矩阵更新方法6

三、MATLAB实现BP神经网络8

3.1MATLAB软件环境8

3.2代码实现8

3.3实验结果10

四、结论及展望12

一、介绍

1.1研究背景

人工神经网络(ANNs)被归类为一种模拟生物神经网络的模型,具有高度学习能力和自适应性,用于解决有关模式识别、拟合曲线、识别图像、辨识声音、推理、预测等问题。

在这些任务中,Backpropagation (BP)神

经网络是应用最广泛的神经网络结构。

BP神经网络是一种反向传播的多

层前馈神经网络,它的结构简单、计算方法有效,可以学习训练集的特征,在测试集上取得较好的精度。

1.2BP神经网络

BP神经网络(或叫反向传播网络,BP网络)是一种多层前馈神经网络,它是由对神经网络训练的单步算法“反向传播算法”δ开发的。

BP神经

网络由输入层、隐层和输出层构成,它将被调节的参数及权值分配给每个

网络层,以调整网络性能的训练过程。

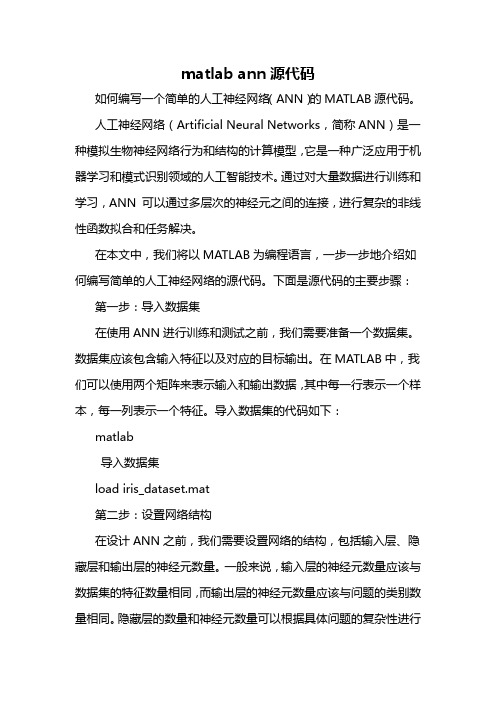

matlab ann源代码

matlab ann源代码如何编写一个简单的人工神经网络(ANN)的MATLAB源代码。

人工神经网络(Artificial Neural Networks,简称ANN)是一种模拟生物神经网络行为和结构的计算模型,它是一种广泛应用于机器学习和模式识别领域的人工智能技术。

通过对大量数据进行训练和学习,ANN 可以通过多层次的神经元之间的连接,进行复杂的非线性函数拟合和任务解决。

在本文中,我们将以MATLAB为编程语言,一步一步地介绍如何编写简单的人工神经网络的源代码。

下面是源代码的主要步骤:第一步:导入数据集在使用ANN进行训练和测试之前,我们需要准备一个数据集。

数据集应该包含输入特征以及对应的目标输出。

在MATLAB中,我们可以使用两个矩阵来表示输入和输出数据,其中每一行表示一个样本,每一列表示一个特征。

导入数据集的代码如下:matlab导入数据集load iris_dataset.mat第二步:设置网络结构在设计ANN之前,我们需要设置网络的结构,包括输入层、隐藏层和输出层的神经元数量。

一般来说,输入层的神经元数量应该与数据集的特征数量相同,而输出层的神经元数量应该与问题的类别数量相同。

隐藏层的数量和神经元数量可以根据具体问题的复杂性进行调整。

设置网络结构的代码如下:matlab设置网络结构input_size = size(inputs,2);output_size = size(targets,2);hidden_size = 10; 设置隐藏层神经元数量第三步:初始化权重和偏置在ANN中,神经元之间的连接强度由权重和偏置决定。

我们需要为所有神经元之间的连接,以及每个神经元的偏置,随机初始化一个初始值。

初始化权重和偏置的代码如下:matlab初始化权重和偏置W1 = rand(input_size,hidden_size); 初始化输入层到隐藏层的权重b1 = rand(1,hidden_size); 初始化隐藏层的偏置W2 = rand(hidden_size,output_size); 初始化隐藏层到输出层的权重b2 = rand(1,output_size); 初始化输出层的偏置第四步:定义激活函数激活函数是ANN中非线性转换的关键。

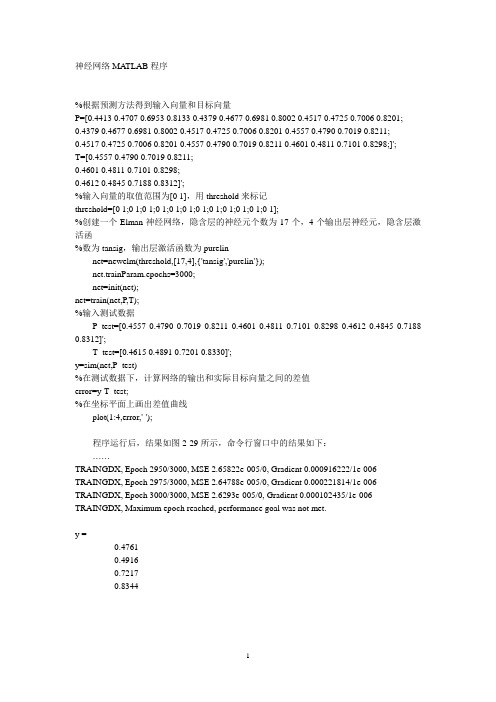

人工神经网络matlab程序

神经网络MATLAB程序%根据预测方法得到输入向量和目标向量P=[0.4413 0.4707 0.6953 0.8133 0.4379 0.4677 0.6981 0.8002 0.4517 0.4725 0.7006 0.8201;0.4379 0.4677 0.6981 0.8002 0.4517 0.4725 0.7006 0.8201 0.4557 0.4790 0.7019 0.8211;0.4517 0.4725 0.7006 0.8201 0.4557 0.4790 0.7019 0.8211 0.4601 0.4811 0.7101 0.8298;]';T=[0.4557 0.4790 0.7019 0.8211;0.4601 0.4811 0.7101 0.8298;0.4612 0.4845 0.7188 0.8312]';%输入向量的取值范围为[0 1],用threshold来标记threshold=[0 1;0 1;0 1;0 1;0 1;0 1;0 1;0 1;0 1;0 1;0 1;0 1];%创建一个Elman神经网络,隐含层的神经元个数为17个,4个输出层神经元,隐含层激活函%数为tansig,输出层激活函数为purelinnet=newelm(threshold,[17,4],{'tansig','purelin'});net.trainParam.epochs=3000;net=init(net);net=train(net,P,T);%输入测试数据P_test=[0.4557 0.4790 0.7019 0.8211 0.4601 0.4811 0.7101 0.8298 0.4612 0.4845 0.7188 0.8312]';T_test=[0.4615 0.4891 0.7201 0.8330]';y=sim(net,P_test)%在测试数据下,计算网络的输出和实际目标向量之间的差值error=y-T_test;%在坐标平面上画出差值曲线plot(1:4,error,'-');程序运行后,结果如图2-29所示,命令行窗口中的结果如下:……TRAINGDX, Epoch 2950/3000, MSE 2.65822e-005/0, Gradient 0.000916222/1e-006 TRAINGDX, Epoch 2975/3000, MSE 2.64788e-005/0, Gradient 0.000221814/1e-006 TRAINGDX, Epoch 3000/3000, MSE 2.6293e-005/0, Gradient 0.000102435/1e-006 TRAINGDX, Maximum epoch reached, performance goal was not met.y =0.47610.49160.72170.8344Hopfield%数字1的点阵表示one=[-1 -1 -1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1 -1 -1 -1 1 1 1 1 -1 -1 -1];%数字2的点阵表示two=[1 1 1 1 1 1 1 1 -1 -1 1 1 1 1 1 1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 1 1 -1 -1 1 1 1 1 1 1 1 1 -1 -1 1 1 1 1 1 1 1 1 -1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 1 1 1 1 1 1 1 1 -1 -1 1 1 1 1 1 1 1 1 -1 -1];%设定网络的目标向量T=[one;two]';%创建一个Hopfield神经网络net=newhop(T);%给定一个受噪声污染的数字2的点阵,所谓噪声是指数字点阵中某些本应为1的方块变成了-1no2={[1 1 1 -1 1 1 -1 1 -1 -1 1 1 1 1 1 1 1 1 -1 -1 -1 1 -1 1 -1 -1 1 1 -1 -1 -1 -1 1 -1 1 -1 1 1 -1 -1 1 1 1 1 1 1 1 1 -1 -1 1 1 1 1 1 1 1 1 -1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 1 1 1 -1 1 1 1 1 -1 -1 1 1 -1 1 1 1 1 1 -1 -1]'};%对网络进行仿真,网络的仿真步数为5tu2 =sim(net,{1,5},{},no2)%输出仿真结果向量矩阵中的第3列向量,并将其转置tu2{3}'程序运行后,在命令行窗口得到下面的结果:ans =Columns 1 through 211 1 1 1 1 1 1 1 -1 -1 1 1 1 1 1 1 1 1 -1 -1 -1Columns 22 through 42-1 -1 -1 -1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 1 1 -1 -1 1 1Columns 43 through 631 1 1 1 1 1 -1 -1 1 1 1 1 1 1 1 1 -1 -1 1 1 -1Columns 64 through 84-1 -1 -1 -1 -1 -1 -1 1 1 -1 -1 -1 -1 -1 -1 -1 -1 1 1 1 1Columns 85 through 1001 1 1 1 -1 -1 1 1 1 1 1 1 1 1 -1 -1由结果可以看出所得到的点阵与数字2的正常点阵是一致的,表明网络可以从受到污染的数字2的点阵中识别出数字2,证明网络是有效的。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

以下是用Matlab中的m语言编写的BP神经网络代码,实现的是一个正弦函数的拟合过程,包括了初始化、BP算法、绘制曲线等过程,可以将代码放到一个M文件中运行,以下是代码:

defaultpoints=20; %%%%%%%%%隐含层节点数

inputpoints=1; %%%%%%%%%输入层节点数

outputpoints=1; %%%%%%%%%输出层节点数

Testerror=zeros(1,100);%%%%每个测试点的误差记录

a=zeros(1,inputpoints);%%%%输入层节点值

y=zeros(1,outputpoints);%%%样本节点输出值

w=zeros(inputpoints,defaultpoints);%%%%%输入层和隐含层权值

%初始化权重很重要,比如用rand函数初始化则效果非常不确定,不如用zeros初始化

v=zeros(defaultpoints,outputpoints);%%%%隐含层和输出层权值

bin=rand(1,defaultpoints);%%%%%隐含层输入

bout=rand(1,defaultpoints);%%%%隐含层输出

base1=0*ones(1,defaultpoints);%隐含层阈值,初始化为0

cin=rand(1,outputpoints);%%%%%%输出层输入

cout=rand(1,outputpoints);%%%%%输出层输出

base2=0*rand(1,outputpoints);%%输出层阈值

error=zeros(1,outputpoints);%%%拟合误差

errors=0;error_sum=0; %%%误差累加和

error_rate_cin=rand(defaultpoints,outputpoints);%%误差对输出层节点权值的导数

error_rate_bin=rand(inputpoints,defaultpoints);%%%误差对输入层节点权值的导数

alfa=0.5; %%%% alfa 是隐含层和输出层权值-误差变化率的系数,影响很大

belt=0.5; %%%% belt 是隐含层和输入层权值-误差变化率的系数,影响较小

gama=5; %%%% gama 是误差放大倍数,可以影响跟随速度和拟合精度,当gama大于2时误差变大,容易震荡

%%%%规律100个隐含节点,当alfa *gama =1.5时,效果好,其他值误差变大,belt基本不影响效果

%%%%规律200个隐含节点,当alfa *gama =0.7时,效果好,其他值误差变大,belt基本不影响效果,最小误差和100个隐含点一样

%%%%规律50个隐含节点,当alfa *gama =3时,效果好,其他值误差变大,belt基本不影响效果,最小误差和100个隐含点一样

trainingROUND=200;% 训练次数,有时训练几十次比训练几百次上千次效果要好很多sampleNUM=361; % 样本点数

x1=zeros(sampleNUM,inputpoints); %样本输入矩阵

y1=zeros(sampleNUM,outputpoints); %样本输出矩阵

x2=zeros(sampleNUM,inputpoints); %测试输入矩阵

y2=zeros(sampleNUM,outputpoints); %测试输出矩阵

observeOUT=zeros(sampleNUM,outputpoints); %%拟合输出监测点矩阵

i=0;j=0;k=0; %%%%其中j是在一个训练周期中的样本点序号,不可引用i=0;h=0;o=0; %%%%输入层序号,隐含层序号,输出层序号

x=0:0.2*pi:2*pi; %%%%步长

for j=1:9 %%%%%%这里给样本输入和输出赋值,应根据具体应用来设定x1(j,1)=x(j);

y1(j,1)=sin(x1(j,1));

end

x=0:2*pi/361:2*pi;

for j=1:361

x2(j,1)=x(j);

y2(j,1)=sin(x2(j,1));

end

for o=1:outputpoints

y1(:,o)=(y1(:,o)-min(y1(:,o)))/(max(y1(:,o))-min(y1(:,o)));

%归一化,使得输出范围落到[0,1]区间上,当激活函数为对数S型时适用y2(:,o)=(y2(:,o)-min(y2(:,o)))/(max(y2(:,o))-min(y2(:,o)));

end

for i=1:inputpoints

x1(:,i)=(x1(:,i)-min(x1(:,i)))/(max(x1(:,i))-min(x1(:,i)));

%输入数据归一化范围要和输出数据的范围相同,[0,1]

x2(:,i)=(x2(:,i)-min(x2(:,i)))/(max(x2(:,i))-min(x2(:,i)));

end

sampleNUM=9;

for mmm=1:trainingROUND %训练开始,100次

error_sum=0;

if mmm==trainingROUND

sampleNUM=361;

end

for j=1:sampleNUM %%%%%每次训练一个样本点

for i=1:inputpoints %%%%%样本输入层赋值

a(i)=x1(j,i);

end

for o=1:outputpoints %%%%%样本输出层赋值

y(o)=y1(j,o);

end

if mmm==trainingROUND

for i=1:inputpoints %%%%%样本输入层赋值

a(i)=x2(j,i);

end

for o=1:outputpoints %%%%%样本输出层赋值

y(o)=y2(j,o);

end

end

for h=1:defaultpoints

bin(h)=0;

for i=1:inputpoints

bin(h)=bin(h)+a(i)*w(i,h);

end

bin(h)=bin(h)-base1(h);

bout(h)=1/(1+exp(-bin(h)));%%%%%%隐含层激励函数为对数激励

end

temp_error=0;

for o=1:outputpoints

cin(o)=0;

for h=1:defaultpoints

cin(o)=cin(o)+bout(h)*v(h,o);

end

cin(o)=cin(o)-base2(o);

cout(o)=1/(1+exp(-cin(o))); %%%%%%输出层激励函数为对数激励

observeOUT(j,o)=cout(o);

error(o)=y(o)-cout(o);

temp_error=temp_error+error(o)*error(o);%%%%%记录实际误差,不应该乘伽玛系数error(o)=gama*error(o);

end

Testerror(j)=temp_error;

error_sum=error_sum+Testerror(j);

for o=1:outputpoints

error_rate_cin(o)=error(o)*cout(o)*(1-cout(o));

end

for h=1:defaultpoints

error_rate_bin(h)=0;

for o=1:outputpoints

error_rate_bin(h)= error_rate_bin(h)+error_rate_cin(o)*v(h,o);

end

error_rate_bin(h)=error_rate_bin(h)*bout(h)*(1-bout(h));

end

for h=1:defaultpoints

base1(h)=base1(h)-5*error_rate_bin(h)*bin(h);

%%%%base1变化不影响最小误差,但是可以抑制由于过多训练产生的发散效果for o=1:outputpoints

v(h,o)=v(h,o)+alfa*error_rate_cin(o)*bout(h); % 可能要改,正负号?

% base1(i)=base1(i)+0.01*alfa*error(i);

end

for i=1:inputpoints

w(i,h)=w(i,h)+belt*error_rate_bin(h)*a(i); % 可能要改,正负号?

%base2=base2+0.01*belt*out_error;

end

end

end

%%%%%%%%一轮训练结束

if(error_sum<0.01)

%%%%error_sum中记录一轮训练中所有样本的所有输出和拟合输出值差值平方和break;

end

end %//训练结束

figure

plot(x(1:sampleNUM),Testerror(1:sampleNUM),'r+')

hold on

plot(x(1:sampleNUM),y2(1:sampleNUM,1),'*')

hold on

plot(x(1:sampleNUM),observeOUT(1:sampleNUM,1),'o')

hold on

ylabel(num2str(mmm));

xlabel(num2str(error_sum));。