Hadoop的MapReduce执行过程2

简述mapreduce的工作流程

简述mapreduce的工作流程

MapReduce是一种分布式数据处理模型,它由Google提出,用于处理海量的数据。

它由map和reduce两个阶段组成,是一种函数式编程模型。

MapReduce的工作流程如下:

1. Map阶段:

该阶段是分割数据的过程,它将大量的数据分隔成小块,并将每个数据块分发到不同的机器上进行处理;

2. Reduce阶段:

该阶段是合并数据的过程,它将map阶段产生的数据块组织成一个完整的结果。

3. JobTracker:

该阶段是调度map和reduce阶段的阶段。

它将map和reduce阶段按照用户给定的参数调度到不同的机器上执行。

4. TaskTracker:

该阶段是运行map和reduce阶段的阶段,它根据jobtracker调度的参数,在不同的机器上执行map和reduce阶段的任务。

5. HDFS:

HDFS是运行mapreduce任务所必须的Hadoop分布式文件系统,它可以把大量的数据存储在不同的机器上,以便mapreduce能更有效地处理数据。

6. Output:

mapreduce最后的输出是由reduce阶段产生的,它是mapreduce 处理的最终结果。

简述mapreduce的运行流程

简述mapreduce的运行流程MapReduce是一种用于在大规模数据集上并行计算的模型,它由Google 公司提出并应用于分布式计算领域。

MapReduce的核心思想是将计算任务拆分为多个阶段,并在多台计算机上进行并行计算,从而提高计算效率。

本文将从MapReduce的基本概念开始,逐步解释其运行流程。

一、MapReduce概述MapReduce模型将计算任务分为两个阶段:Map(映射)和Reduce(归约)。

Map阶段将输入数据集划分为多个子集,并为每个子集生成一组键-值对。

Reduce阶段将相同键的键-值对进行归约操作,生成最终结果。

在MapReduce中,计算任务的执行由一个主节点(称为JobTracker)和多个工作节点(称为TaskTracker)协同完成。

二、任务提交阶段1.生成任务:用户向计算集群提交一个MapReduce任务,并指定输入数据集的路径、Map函数、Reduce函数等信息。

提交任务后,JobTracker 为该任务生成一个唯一的任务ID,并将任务添加到待处理任务列表中。

2.任务划分:JobTracker根据输入数据的大小和计算资源的可用情况,将任务划分为若干个MapTask和ReduceTask,并将它们分配给相应的TaskTracker进行处理。

3.任务分配:JobTracker根据与各个TaskTracker之间的网络延迟和负载情况等因素,将MapTask和ReduceTask分配给合适的TaskTracker。

任务分配过程相对复杂,需要考虑多个因素,以实现负载均衡和最大化计算资源的利用率。

三、Map阶段1.数据划分:每个Map任务在启动时,首先从数据源中读取输入数据集。

输入数据集通常被划分为多个等大小的数据块,每个数据块由单独的Map 任务处理。

2.Map函数执行:每个Map任务将输入数据块作为输入,并根据用户定义的Map函数对数据进行处理。

Map函数将输入数据转换为一组键-值对,并将它们输出到本地磁盘上的临时输出文件中。

简述mapreduce数据处理流程

简述mapreduce数据处理流程MapReduce是一种用于大规模数据处理的编程模型,它由Google 首次提出,并且在开源项目Apache Hadoop中得到了广泛应用。

它的核心思想是将数据处理任务分为两个阶段:Map阶段和Reduce阶段。

下面将简述MapReduce的数据处理流程,并对其进行拓展。

1. 输入数据切片:在MapReduce任务开始之前,输入数据会被分割成多个小的数据块,每个数据块称为一个输入数据切片。

这样做的目的是为了能够并行地处理这些数据块,提高处理效率。

2. Map阶段:在Map阶段,每个输入数据切片会被传递给一个Map任务进行处理。

每个Map任务都会执行用户自定义的Map函数,该函数将输入数据切片转化为<key, value>对的集合。

Map函数可以根据具体需求进行数据筛选、转换、过滤等操作,并将处理结果输出为<key, value>对。

3. Shuffle阶段:在Map阶段结束后,Map任务的输出结果会通过网络传输到Reduce任务所在的节点。

这个过程称为Shuffle,其目的是将具有相同key的<key, value>对传递给同一个Reduce任务进行处理。

4. Sort阶段:在Shuffle阶段结束后,Map任务的输出结果会按照key值进行排序。

这样做的目的是为了方便Reduce任务进行后续的处理操作。

5. Reduce阶段:在Reduce阶段,每个Reduce任务会执行用户自定义的Reduce函数,该函数将具有相同key的<key, value>对进行合并、计算、汇总等操作,并将处理结果输出为最终的结果。

6. 输出结果:最后,所有Reduce任务的输出结果会被整合成一个最终的结果,并存储到指定的位置,供后续的分析和使用。

除了上述的基本流程,MapReduce还具有一些拓展的功能和特性,例如:- Combiner函数:在Map阶段的输出结果传递给Reduce阶段之前,可以使用Combiner函数进行局部汇总操作,以减少数据传输量和提高处理效率。

MapReduce的工作机制演示课件

统计词频的例子

4

1.2MapReduce 的用途

在Google,MapReduce用在非常广泛的应用程 序中,如分布grep,分布排序,web访问日志 分析,反向索引构建,文档聚类,机器学习, 基于统计的机器翻译。 值得注意的是,MapReduce实现以后,它被 用来重新生成Google的整个索引。 总来的说MapReduce是用于大规模数据的并 行处理。

12

2.2 作业运行机制

任务的分配:

7.TaskTracker定期发送 “心跳”给JobTracker.

“心跳”告知 JobTracker它是否存活, 同时也充当两者之间 的消息通道。

Jobtracker为tasktracker 选择任务之前,必须 先选定任务所在的作 业。

选择map任务时, jobtracker会考虑 tasktracker的网络位置, 选在一个距离其输入 分片最近的tasktracker

4.调用Jobtracker的 submitjob()方法来通 知Jobtracker作业准备

11

2.2 作业运行机制

作业的初始化:

5.创建一个表示正在 运行作业的对象—— 封装任务和记录信息, 以便跟踪任务的状态 和进程 6.获取已经计算好的 输入分片信息,为每 一个分片创建一个 map任务(reduce任务 的个数由用户配置), 将任务放入任务列表

5

1.3 MapReduce 作业和任务

MapReduce 作业( Job )是指客户端需要执 行的一个工作单元(它包括输入数据、 MapReduce程序和配置信息)。 Hadoop将作业分成若干个小任务(Task)来 执行,其中包括两类任务:map任务和reduce 任务。

6

7.1mapreduce的工作机制任务流程执行步骤

7.1mapreduce的⼯作机制任务流程执⾏步骤1.1 Mapreduce任务流程Mapreduce是⼤量数据并发处理的编程模型,主要包括下⾯五个实体,客户端将作业⽂件复制到分布式⽂件系统,向资源管理器提交mapreduce作业,资源管理器向节点管理器分配容器资源,节点管理器启动application Master,application master启动另外⼀个节点管理器,向资源管理器申请容器资源,⽤来运⾏作业任务。

客户端提交mapreduce作业资源管理器管理分配资源节点管理器启动、管理、监视集群中的container容器⼯作Application Master每个程序对应⼀个AM,负责程序的任务调度,本⾝也是运⾏在NM的Container中分布式⽂件系统存储作业⽂件mapreduce流程图mapreduce的⼯作流程(1)客户端调⽤Job实例的Submit()或者waitForCompletion()⽅法提交作业;(2)客户端向ResourceManage请求分配⼀个Application ID,客户端会对程序的输出路径进⾏检查,如果没有问题,进⾏作业输⼊分⽚的计算。

(3)将作业运⾏所需要的资源拷贝到HDFS中,包括jar包、配置⽂件和计算出来的输⼊分⽚信息等;(4)调⽤ResourceManage的submitApplication⽅法将作业提交到ResourceManage;(5) ResourceManage收到submitApplication⽅法的调⽤之后会命令⼀个NM启动⼀个Container,.在该NodeManage的Container上启动管理该作业的ApplicationMaster进程;(6) .AM对作业进⾏初始化操作,并将会接收作业的处理和完成情况报告;(7) AM从HDFS中获得输⼊数据的分⽚信息;根据分⽚信息确定要启动的map任务数,reduce任务数则根据mapreduce.job.reduces属性或者Job实例的setNumReduceTasks⽅法来决定。

hadoop mapreduce的工作流程

hadoop mapreduce的工作流程

Hadoop MapReduce是Hadoop中最为核心的计算框架之一,支持海量数据的分布式计算。

它利用Map和Reduce两个过程将计算任务分解为很多小任务,然后并行执行,最终合并结果。

Hadoop MapReduce的工作流程:

1. Map阶段

Map阶段是对数据的处理和过滤,首先将原始数据分为若干小块,每个小块的大小由配置文件中的一些参数来决定。

然后,需要编写一个map函数,将每个小块中的数据进行处理和过滤,生成一些中间结果。

2. Shuffle阶段

Shuffle阶段是将Map阶段生成的中间结果按照key分组,也就是将相同key的中间结果分为一组,并将它们发送到同一个Reduce任务

中去处理。

3. Reduce阶段

Reduce阶段是对Shuffle阶段产生的中间结果进行聚合和计算,得到最终的结果。

在Reduce阶段,需要编写一个reduce函数,将同一个key的所有值聚合起来,最终得到这个key对应的计算结果。

在这个阶段中,可以进行各种汇总操作,如求和、求平均值等。

总结:

Hadoop MapReduce的工作流程是Map-Shuffle-Reduce,其核心思想是将大计算任务分解为许多小任务并行执行,最终将结果合并。

Map阶段处理原始数据,Shuffle阶段将中间结果按照key分组,Reduce阶段聚合和计算结果。

这种分布式计算架构大大提高了计算性能和效率,适用于处理大数据量的计算任务。

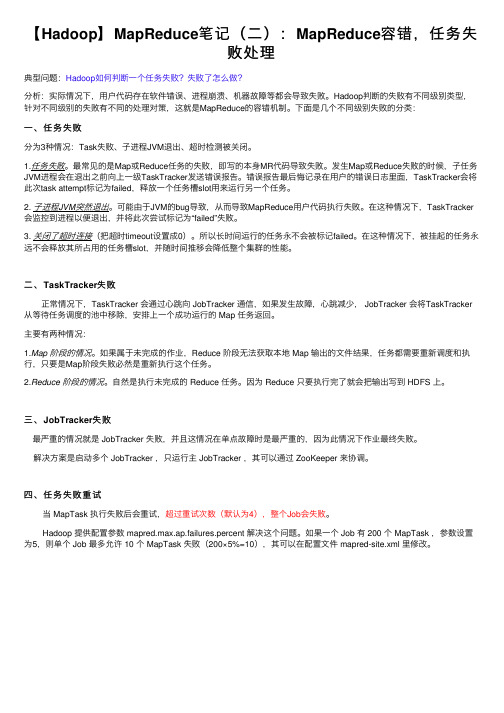

【Hadoop】MapReduce笔记(二):MapReduce容错,任务失败处理

【Hadoop】MapReduce笔记(⼆):MapReduce容错,任务失败处理典型问题:Hadoop如何判断⼀个任务失败?失败了怎么做?分析:实际情况下,⽤户代码存在软件错误、进程崩溃、机器故障等都会导致失败。

Hadoop判断的失败有不同级别类型,针对不同级别的失败有不同的处理对策,这就是MapReduce的容错机制。

下⾯是⼏个不同级别失败的分类:⼀、任务失败分为3种情况:Task失败、⼦进程JVM退出、超时检测被关闭。

1.任务失败。

最常见的是Map或Reduce任务的失败,即写的本⾝MR代码导致失败。

发⽣Map或Reduce失败的时候,⼦任务JVM进程会在退出之前向上⼀级TaskTracker发送错误报告。

错误报告最后悔记录在⽤户的错误⽇志⾥⾯,TaskTracker会将此次task attempt标记为failed,释放⼀个任务槽slot⽤来运⾏另⼀个任务。

2. ⼦进程JVM突然退出。

可能由于JVM的bug导致,从⽽导致MapReduce⽤户代码执⾏失败。

在这种情况下,TaskTracker 会监控到进程以便退出,并将此次尝试标记为“failed”失败。

3. 关闭了超时连接(把超时timeout设置成0)。

所以长时间运⾏的任务永不会被标记failed。

在这种情况下,被挂起的任务永远不会释放其所占⽤的任务槽slot,并随时间推移会降低整个集群的性能。

⼆、TaskTracker失败正常情况下,TaskTracker 会通过⼼跳向 JobTracker 通信,如果发⽣故障,⼼跳减少, JobTracker 会将TaskTracker 从等待任务调度的池中移除,安排上⼀个成功运⾏的 Map 任务返回。

主要有两种情况:1.Map 阶段的情况。

如果属于未完成的作业,Reduce 阶段⽆法获取本地 Map 输出的⽂件结果,任务都需要重新调度和执⾏,只要是Map阶段失败必然是重新执⾏这个任务。

2.Reduce 阶段的情况。

如何运行一个MapReduce程序

如何运行一个Map/Reduce程序1.执行以下命令启动HDFS和MapReduce:start-all.sh2.用JPS命令检查一下是否正常启动:jps3.显示如图所示各进程信息,则说明HDFS和MapReduce都已正常启动。

图1.1 启动HDFS和MapReduce4.打开Eclipe,可以通过图形界面在目录/usr/local/eclipse下双击应用程序,也可以通过linux命令的方式:cd /usr/local/eclipse和./eclipse图1.2 选择工作空间目录图1.3 Eclipse打开界面5.在菜单栏依次点击Windows→Open Perspective→Other,选择“Map/Reduce”,点击“OK”图1.4图1.5 选择“Map/Reduce”6.进行完上述步骤后,在eclipse的左边一栏,会出现一个蓝色的大象标志。

图1.6 蓝色大象标志7.点击蓝色大象标志会出现如下图所示的界面。

图1.78.点击右下角的蓝色大象的标志,新建“new hadoop location”,定义hadoop 的位置,用于运行MapReduce应用,点击完成“Finish”。

图1.8图1.9注:图1.9中host一栏可以填“localhost”,也可以填linux虚拟机的IP地址(通过“ifconfig -a”命令查看)。

本来我填的是“localhost”,结果DFS连接不上本机,然后我改成了IP地址,就可以连接上了。

本来localhost就是本机,这里大家可以先用localhost,不行再填ip 地址。

9.点击Windows→Preferences图1.1011.选择Hadoop Map/Reduce→选择Hadoop的安装目录,点击“Apply”,点击“OK”。

图 1.1112.新建一个Map/Reduce工程,依次单击File→New→Project图1.12 新建一个Map/Reduce工程13.选择Map/Reduce下的“Map/Reduce Project ” ,点击“Next ”图 1.1314.填写你要建立的工程名称,点击“Next”,再点击“Finish”。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2、编写M ap-Reduce 程序

编写M ap-Reduce 程序,一般需要实现两个函数:mapper 中的m ap 函数和r educer 中的r educe 函数。

一般遵循以下格式:

对于上面的例子,则实现的m apper 如下:

实现的r educer 如下:

欲运行上面实现的Mapper 和Reduce,则需要生成一个Map-Reduce 得任务(Job),即初始化J ob 的过程,其基本包括以下三部分:

•输入的数据,也即需要处理的数据

•Map-Reduce 程序,也即上面实现的M apper 和R educer

•此任务的配置项J obConf

reduce task

@..Hadoop 有两类的节点控制job 的运行:J obTracker

下图大概描述了M ap-Reduce 的J ob 运行的基本原理:

下面我们讨论J obConf,其有很多的项可以进行配置:•setInputFormat:设置m ap 的输入格式,默认为T extInputFormat,key 为L ongWritable, value 为T ext

•setNumMapTasks:设置m ap 任务的个数,此设置通常不起作用,map 任务的个数取决于输入的数据所能分成的i nput split 的个数•setMapperClass:设置M apper,默认为I dentityMapper •setMapRunnerClass:设置M apRunner, map task 是由M apRunner 运行的,默认为 MapRunnable,其功能为读取 input split 的一个个record,依次调用M apper 的m ap 函数

•setMapOutputKeyClass 和setMapOutputValueClass:设置Mapper 的输出的k ey-value 对的格式

•setOutputKeyClass 和s etOutputValueClass:设置R educer 的输出的key-value 对的格式

•setPartitionerClass 和s etNumReduceTasks:设置P artitioner,默认为 HashPartitioner,其根据 key 的 hash 值来决定进入哪个partition,每个partition 被一个reduce task 处理,所以partition 的个数等于r educe task 的个数

•setReducerClass:设置R educer,默认为I dentityReducer •setOutputFormat:设置任务的输出格式,默认为T extOutputFormat •FileInputFormat.addInputPath:设置输入文件的路径,可以使一个文件,一个路径,一个通配符。

可以被调用多次添加多个路径

•FileOutputFormat.setOutputPath:设置输出文件的路径,在job 运行前此路径不应该存在当然不用所有的都设置,由上面的例子,可以编写Map-Reduce 程序如下:

请看hadoop的mapreduce执行过程3……。