Towards Comprehensive 3D Proteome Imaging of the Mouse Brain by Voxelation Integrated with

Clifford代数空间上的三维多模医学图像配准

r e g i s t e r e d S O t h a t t h e me d i c a l c h a r a c t e r i s t i c s o f t a r g e t t i s s u e c a n b e a n a l y z e d mo r e c o mp l e t e l y a n d a c c u r a t e l y . On t h e b a s i s

以3D_影像融合技术引导腔内治疗主动脉疾病研究进展

Research progresses of 3D image fusion technology for guiding endovascular treatments of aortic lesionsXU Taifu1, HOU Peiyong2*(1.Interventional Room,2.Department of Vascular Surgery, the Fourth AffiliatedHospital of Guangxi Medical University, Liuzhou 545005, China)[Abstract]3D image fusion technology can fuse image data before and during interventional treatments with mediator of cone-beam CT and guide interventional operations,which might significantly improve the success rate of interventional treatment of aortic lesions and reduce radiation exposure,iodine contrast agent dosage and operation time,etc.The research progresses of 3D image fusion technology for guiding endovascular treatment of aortic lesions were reviewed in this article.[Keywords]aortic diseases; image fusion; imaging, three-dimensional; endovascular aneurysm repairDOI:10.13929/j.issn.1672-8475.2024.01.012以3D影像融合技术引导腔内治疗主动脉疾病研究进展许太福1,侯培勇2*(1.广西医科大学第四附属医院介入治疗室,2.血管外科,广西柳州 545005)[摘要]3D影像融合技术是以锥形束CT为介导将介入治疗前和治疗中的影像数据融合并以之引导介入操作,可显著提高腔内介入治疗主动脉疾病成功率,减少辐射暴露和碘对比剂用量并缩短治疗时间等。

三维目标群及动态表面的重建和跟踪中期报告

三维目标群及动态表面的重建和跟踪中期报告一、研究背景三维重建和跟踪是计算机视觉和计算机图形学领域的重要研究方向之一。

在许多应用领域中,如机器人导航、三维模型生成、虚拟现实、医疗影像分析等,都需要对三维目标群体和其动态表面进行重建和跟踪。

本研究致力于提出新的算法和方法来解决三维目标群体和动态表面的重建和跟踪问题。

二、研究进展通过对相关文献的综述,我们发现三维重建和跟踪方面已经在很多方面取得了一定的成果,但仍存在以下问题:1. 多目标的重建和跟踪:目前大多数算法只针对单个目标进行重建和跟踪,对于多个目标的重建和跟踪仍面临很大的挑战。

2. 动态表面的重建和跟踪:动态表面往往不规则、复杂,对于其精准的重建和跟踪需要更加先进的算法和方法。

3. 数据噪声的影响:在实际应用场景中,数据常常存在噪声和不完整性,如何有效地去除噪声和处理不完整数据,对于精准重建和跟踪十分关键。

基于以上问题,我们提出了以下研究计划:1. 多目标的重建和跟踪:我们将使用深度学习等先进技术来进行多目标的重建和跟踪。

通过提取目标的特征,在不同时间和视角下进行目标的匹配和跟踪。

2. 动态表面的重建和跟踪:我们将尝试使用基于深度学习的方法来对动态表面进行建模和跟踪。

通过学习动态表面的形态和运动,实现高精度的重建和跟踪。

3. 数据噪声的影响:我们将研究如何利用机器学习等方法来对噪声进行去除和数据补全,提高重建和跟踪的精度和效率。

三、研究计划本研究将在接下来的半年内开展以下研究工作:1. 通过深度学习等技术研究多目标的重建和跟踪算法。

2. 探究利用深度学习算法进行动态表面的重建和跟踪。

3. 研究利用机器学习等方法进行数据噪声的去除和数据补全,提高重建和跟踪的精度和效率。

4. 验证新算法和方法的效果,并与现有算法和方法进行比较和分析。

四、研究成果我们希望通过本研究,能够提出一些新的算法和方法来解决三维目标群体和动态表面的重建和跟踪问题。

最终,我们将撰写一份关于三维目标群体和动态表面的重建和跟踪的研究论文,并提交给相关国际学术期刊和会议。

基于 3D 人脸重建的光照、姿态不变人脸识别

ISSN 1000-9825, CODEN RUXUEW E-mail: jos@Journal of Software, Vol.17, No.3, March 2006, pp.525−534 DOI: 10.1360/jos170525 Tel/Fax: +86-10-62562563© 2006 by Journal of Softwar e. All rights reserved.∗基于3D人脸重建的光照、姿态不变人脸识别柴秀娟1+, 山世光2, 卿来云2, 陈熙霖2, 高文1,21(哈尔滨工业大学计算机学院,黑龙江哈尔滨 150001)2(中国科学院计算技术研究所 ICT-ISVISION面像识别联合实验室,北京 100080)Pose and Illumination Invariant Face Recognition Based on 3D Face ReconstructionCHAI Xiu-Juan1+, SHAN Shi-Guang2, QING Lai-Yun2, CHEN Xi-Lin2, GAO Wen1,21(Department of Computer Science and Technology, Harbin Institute of Technology, Harbin 150001, China)2(ICT-ISVISION Joint R&D Laboratory for Face Recognition, Institute of Computer Technology, The Chinese Academy of Sciences,Beijing 100080, China)+ Corresponding author: Phn: +86-10-58858300 ext 314, Fax: +86-10-58858301, E-mail: xjchai@, /Chai XJ, Shan SG, Qing LY, Chen XL, Gao W. Pose and illumination invariant face recognition based on 3Dface reconstruction. Journal of Software, 2006,17(3):525−534. /1000-9825/17/525.htmAbstract: Pose and illumination changings from picture to picture are two main barriers toward full automaticface recognition. In this paper, a novel method to handle both pose and lighting conditions simultaneously isproposed, which calibrates the pose and lighting to a predefined reference condition through an illuminationinvariant 3D face reconstruction. First, some located facial landmarks and a priori statistical deformable 3D modelare used to recover an elaborate 3D shape. Based on the recovered 3D shape, the “texture image” calibrated to astandard illumination is generated by spherical harmonics ratio image and finally the illumination independent 3Dface is reconstructed completely. The proposed method combines the strength of statistical deformable model todescribe the shape information and the compact representations of the illumination in spherical frequency space,and handles both the pose and illumination variation simultaneously. This algorithm can be used to synthesizevirtual views of a given face image and enhance the performance of face recognition. Experimental results on CMUPIE database show that this method can significantly improve the accuracy of the existing face recognition methodwhen pose and illumination are inconsistent between gallery and probe sets.Key words: face recognition; 3D face reconstruction; statistic deformable model; spherical harmonic; ratio image摘 要: 待匹配人脸图像与库存原型图像之间姿态和光照的差异是自动人脸识别的两个主要瓶颈问题,已有的解决方法往往只能单独处理二者之一,而不能同时处理光照和姿态问题.提出了一种对人脸图像中的姿态和光照变化同时进行校正处理的方法,即通过光照不变的3D人脸重建过程,将姿态和光照都校正到预先定义的标准条件下.首先,利用先验的统计变形模型,结合人脸图像上的一些关键点来恢复较为精细的人脸3D形状.基于此重建的3D形∗ Supported by the National Natural Science Foundation of China under Grant No.60332010 (国家自然科学基金); the “100 TalentsProgram” of the CAS (中国科学院百人计划); the Shanghai Municipal Sciences and Technology Committee of China under GrantNo.03DZ15013 (上海市科委项目); the ISVISION Technologies Co., Ltd (银晨智能识别科技有限公司资金资助)Received 2005-05-16; Accepted 2005-07-11526 Journal of Software软件学报 V ol.17, No.3, March 2006状,进而通过球面谐波商图像的方法估计输入图像的光照属性并提取输入图像的光照无关的纹理信息,从而将光照无关的3D人脸完全重构出来,生成输入人脸图像在标准姿态和光照条件下的虚拟视图,用于最终的分类识别,实现了对光照和姿态问题的同时处理.在CMU PIE数据库上的实验结果表明,此方法可以在很大程度上提高现有人脸识别方法对于原型集合(gallery)和测试集合中图像在姿态和光照不一致情况下识别结果的正确性.关键词: 人脸识别;3D人脸重建;统计变形模型;球面谐波;商图像中图法分类号: TP393文献标识码: A人脸识别技术在安全、金融、法律、人机交互等领域具有广阔的应用前景,因此得到了研究人员的广泛关注.经过近40年的发展,对于均匀光照下的中性表情的正面人脸图像其识别率已经很高[1].然而在一些更复杂的情况下,现有多数系统的识别性能受姿态和光照变化的影响特别大.这是因为当人脸的姿态或光照发生变化时,人脸图像的外观也会随之发生很大变化,所以通常使用的基于2D外观的方法在这种情况下就会失效.尽管也有一些基于2D的方法(如基于多视图的方法[2])可以在一定程度上解决姿态或者光照的变化问题,但我们认为基于3D信息来改善2D图像外观的方法是解决姿态、光照变化问题的最本质的方法.在研究的早期阶段,无论是针对姿态问题,还是光照问题,基于人脸图像外观低维子空间描述的方法都是主要的思路.Eigenfaces[2]和Fisherfaces[3]根据统计学习得到经验的人脸低维的姿态或光照空间.这类方法易于实现,精度较高.但是当测试图像和训练图像集合的成像条件不太相似时,其性能下降得非常严重.由Gross等人提出的Fisher Light-Fields算法[4]通过估计gallery或者测试图像对应的头部的特征光场,并将特征光场系数作为特征集合来进行最终的识别.将此工作进一步扩展,Zhou提出了一种Illuminating Light Field方法[5],其中,Lambertian反射模型被用于控制光照的变化,该方法对新的光照条件比Fisher Light Field具有更强的泛化能力.然而,该算法需要多个姿态以及多种光照条件下的多幅训练图像进行建模,这对多数实际应用而言是难以满足的.姿态和光照的变化对人脸图像的影响说到底是与人脸的3D结构有关的,假设人脸的3D形状、表面反射率已知或者可以估计,那么姿态和光照问题就可以更容易地解决.因此,一些基于模型的方法试图从人脸图像中将人脸内在属性(3D形状和表面反射率)和外在成像条件(光照条件、绘制条件、摄像机参数等)分离开来,从而可以消除外在成像条件的影响而仅利用内在本质属性实现准确的分类识别.其中最著名的方法包括光照锥、对称SFS和3D形变模型方法.Georghiades提出了光照锥(illumination cone)方法[6]来解决光照变化和姿态变化下的人脸识别.该方法能够根据给定的多幅(不少于3幅)相同姿态、不同光照条件的输入图像,估计出输入人脸的3D信息.其本质上是传统的光度立体视觉(photometric stereo)方法的一个变种,通过SVD迭代估计光照、人脸3D形状、表面点反射率,并最终利用人脸3D形状分布的先验知识(如对称性、鼻子为最近点等)作为约束求解人脸的3D形状.通常这种方法至少需要每个目标不同光照条件下的7幅图像,这对于大多数应用来说都太过苛刻,因此难以实用.与光照锥利用光度立体视觉方法不同,Zhao则提出了采用从影调恢复形状(shape from shading,简称SFS)方法进行人脸3D形状重建的思路,在传统SFS方法的基础上,利用了人脸的对称性先验知识,提出了SSFS方法(symmetric SFS)[7].该方法只需要一幅输入人脸图像即可,但它需要通过其他方法估计输入图像的光照情况以及精确的对称轴信息,这都增加了该方法在实用上的困难.迄今为止,最成功的姿态和光照不变的人脸识别是3D变形模型方法(3D morphable model)[8].该方法通过主成分分析对人脸的3D形状和纹理(表面反射率)分别进行统计建模,在此基础上建立了包含形状、纹理统计参数、Phone模型参数、光照参数、摄像机内外参数、绘制参数等在内的复杂成像模型,最终采用基于合成的分析(analysis-by-synthesis)技术通过优化算法估计这些参数,得到输入人脸的3D形状和纹理统计参数用于最终的分类识别.这种变形方法已经用于FRVT2002[1]中.遗憾的是,该方法需要求解一个涉及几百个参数的复杂连续优化问题,迭代优化过程耗费了大量的计算时间,整个拟合过程在一台2GHzP4处理器的工作站上,大约需要4.5分钟.这对于多数实用系统而言是难以忍受的.基于上述分析,我们认为3D变形模型中采用的统计建模方法是利用人脸先验3D信息的最佳方式,所以本柴秀娟等:基于3D人脸重建的光照、姿态不变人脸识别527文也采用了类似的建模方法,不同的是,为了避免3D形变模型中过分复杂的参数优化过程,我们没有采用稠密的统计模型,而仅仅采用了一个稀疏的关键特征点统计模型;同时也没有采用复杂的成像模型,而是采用了更为方便、实用的球面谐波商图像方法来处理光照估计和光照影响消除问题.这些措施极大地降低了算法的计算复杂度,使得整个处理过程可以在1秒内完成(P4 3.2G CPU的机器上).当然,与3D形变模型相比,本文算法重建的人脸3D信息的精度会有较大的差距,但需要注意的是,我们的目标是实现对姿态、光照变化不敏感的人脸识别,并非精确的3D重建,而多数准正面人脸识别系统都对较小的光照、姿态变化有一定的容忍能力,因此,本文在算法精度和速度方面进行折衷是合理的,本文的实验也表明了这一点.本文第1节详细的描述我们提出的姿态和光照不变的人脸识别方法,第1.1节介绍基于3D稀疏变形模型的3D形状重构算法.第1.2节对基于球面谐波商图像的光照不变的纹理生成方法进行描述.本文算法的一些合成结果以及对姿态和光照不变的人脸识别实验结果在第2节给出.最后给出本文的结论.1 姿态和光照不变的人脸识别本文提出的光照、姿态不变的人脸识别系统的整体框架如图1所示.首先,对于给定的任意一幅人脸图像进行人脸检测和眼睛中心的定位,根据基于视图的子空间方法得到粗略的姿态类别,然后采用ASM或者ESL算法[9]标定给定人脸图像的稀疏的关键特征点.基于3D稀疏变形模型,结合人脸图像的2D形状信息,重建对应于输入图像人脸的3D形状.借助于重建得到的特定人的3D形状,根据球面谐波商图像方法,将由输入人脸图像重新打光到预先定义的参考光照条件下,从而生成光照不变的纹理图像,即实现了参考光照条件下的3D人脸重建.进行了姿态和光照校正之后的人脸图像即可作为一般正面人脸识别系统的输入,与库存人脸图像进行匹配,得到识别结果.因此,我们的算法也可以看作是任何人脸识别系统的预处理步骤.reconstructionOriginal textureextraction texture generationFig.1 The framework of pose and illumination calibration for face recognition图1 用于人脸识别的姿态和光照校正的流程图下面,我们对上面所述框架中的两个关键问题分别进行描述,即基于3D稀疏变形模型的3D人脸形状重建和基于球面谐波商图像的光照不变的纹理生成.1.1 基于单幅图像的3D人脸形状重构由单幅人脸图像恢复出此特定人的3D结构是解决姿态问题的最直观、最本质的方法.然而,在没有任何假设的前提下,从单幅人脸图像恢复3D形状是一个病态的问题.文献[10]中明确指出,重建3D人脸所需图像的最小数目是3.为克服需要多幅图像才能重建3D人脸形状这一困难,我们对3D人脸数据集合中的形状向量进行主成分分析(principle component analysis,简称PCA),建立统计变形模型.此模型即包含了人脸类的3D形状的先528Journal of Software 软件学报 V ol.17, No.3, March 2006验知识.1.1.1 创建稀疏统计模型 本文采用USF Human ID 3-D 数据库中的100个激光扫描的3D 人脸作为训练集合创建统计变形模型[11].所有这些人脸都被标准化到一个统一的标准的方向和位置.人脸的形状由75 972个顶点表示,为简化计算,均匀下采样到8 955个顶点.在本文算法中,对形状和纹理按照不同的策略分开处理.我们认为,人脸的姿态只与一些关键特征点的位置有关,而与图像的亮度无关.通过将形状和纹理分开处理,避免了复杂的优化过程,节省了计算时间.下面,首先介绍稀疏统计模型的建立过程.我们将人脸的n 个顶点的X ,Y ,Z 坐标串接起来,组成形状向量来描述人脸的3D 形状:n T n n n Z Y X Z Y X 3111),,,...,,,(ℜ∈=S .假设用于训练的3D 人脸的数目是m ,每个3D 人脸向量可以描述为S i ,其中i =1,…,m .这些形状向量都已经在尺度上进行了配准,则任意一个新的3D 人脸形状向量S 都可表示为训练样本形状向量的线性组合形式,即∑==mi w 1i i S S .考虑到所有的人脸形状在整体上都是相似的,只是不同的人脸形状之间存在一些小的差别.由于PCA 适合于捕获同类向量主成分方向上的变化,并能够滤去各种测量噪声,因此,我们采用PCA 对训练集合中的3D 形状进行建模.通过对协方差矩阵的特征值进行降序排列,按序选择前)1(−≤m d 个对应最大特征值的形状特征向量,共同构成投影矩阵P ,即形成统计变形模型: P αS S += (1) 其中S 是平均的形状向量,α是对应于d 维投影矩阵P 的系数向量.当人脸发生姿态旋转时,对上面的等式进行扩展.对于3D 形状中的任意一个顶点D =(x ,y ,z )T ,根据PCA 特性,由式(1)可知此式成立:αRP R R D D D +=.其中,R 是由3个旋转角度表征的3×3维旋转矩阵,D 是S 中对应此顶点的坐标值,P D 是由P 中抽取出的对应顶点D 的3×d 维矩阵.由此可知,对于整个3D 形状向量也同样满足上面的旋转变换.我们引入符号R V 来表示这样的运算操作:对一个3D 形状向量V 按旋转矩阵R 进行旋转变换.同样,P R 表示对P 中的每一列3D 特征向量做同样的旋转变换.因此,将式(1)向多姿态情况扩展,有下面的等式: αP S S R R R += (2)有了这个扩展到多姿态的统计变形模型,则任意姿态下的3D 人脸形状都可以由变换到同姿态下的样本形状的PCA 模型来表示.但是仅仅给定一幅人脸图像,如何利用人脸形状的先验知识来进行3D 形状重建仍然是一个问题.基于此,我们进一步提出了3D 稀疏变形模型(3D SDM).目的是建立输入图像的关键特征点向量和3D 稀疏变形模型之间的对应,从而优化得到3D 稀疏变形模型的系数向量.我们认为此系数向量同样是密集的统计变形模型的系数向量.这样就可以很容易地实现对应于给定人脸的密集3D 形状的重建.与3D 形状表示方法相似,将2D 人脸图像上的k 个关键点的X ,Y 坐标串接起来,表示为I S .每一个2D 的关键点在3D 形状向量上都有且只有一个标号固定的点与其对应.按照这种对应关系,将3D 形状上的对应于2D 关键点的3D 点抽取出来,并同样连接起来表示,标记为S ′.对平均形状和投影矩阵做同样的处理,即形成稀疏的S 和P ′.由此得到3D 变形模型的稀疏版本:αP S S ′+′=′.同样,向多姿态情况进行扩展,即创建得到3D 稀疏变形模型(3D SDM):αP S S R R R )()()(′+′=′.1.1.2 基于SDM 的3D 重建即使有了3D 形状的统计先验知识,仅根据一幅2D 图像恢复其3D 形状仍然很困难.本文的策略是以PCA 由部分重构整体的特性为依据提出的.我们试图根据输入图像的关键点信息以及相应的3D 稀疏变形模型信息,获取PCA 模型的重构系数,最后将优化的系数向量投影到完整的PCA 模型上,以得到对应输入图像人脸的密集柴秀娟 等:基于3D 人脸重建的光照、姿态不变人脸识别 529 的3D 形状向量.我们接下来对稀疏的3D 形状S ′抽取其X ,Y 坐标,形成2D 形状分量,标记为f S ′.由于f S ′可以被认为是3D 形状S 的一部分,因此,下面的等式仍然近似成立:αP S S f f f ′+′=′.这里引入符号f V 来表示在3D 形状V 中按序抽取相应的X ,Y 坐标形成2D 形状向量.f S )(和f P )(′分别表示从稀疏的3D 平均形状S ′和投影矩阵P ′中提取的对应的2D 关键点向量,则符号Rf S )(′就表示从经过旋转矩阵R变换之后的稀疏3D 形状向量S ′中抽取X ,Y 坐标形成的2D 形状向量.因此,任意姿态角度下的3D 形状向量,其对应2D 关键点的稀疏向量的X ,Y 分量串联成的向量可以如下表示: αP S S R f R f R f )()()(′+′=′ (3)我们的目标是通过形状系数向量α来重构完整3D 形状信息,对应于特定人的形状系数向量可如下求解:[][]R f R f R f S S )P α)()((′−′′=+ (4) 其中,+′])[(Rf P 是伪逆转置矩阵,可通过[][]()[]TT))()()()(1R f R f R f R f P P P P ′′′=′−+来计算.此系数向量是根据PCA 的部分向量求得的,我们认为它同时也可作为完整PCA 各分量对应的系数.因此,问题的关键就是根据图像关键特征点向量I S ,计算出向量Rf S )(′.I S 和R f S )(′之间的关系可以表示为T S S Rf +′=])[(c I (5)我们用对应于x ,y ,z 三个坐标轴的旋转角度γβα,,来刻画旋转矩阵R .利用人脸图像上的5个关键特征点及其对应的3D 模型S 上的5个关键的3D 点,其组成的向量分别表示为5−I S 以及5S ′,我们可以通过投影计算得到3个旋转角度参数.用于计算旋转姿态参数的5个特征点是左、右眼中心,鼻尖,左、右嘴角.下面,我们将对此3D 形状重建算法进行详细介绍.迭代优化过程如下:A. 通过对选择的5个关键特征点,在输入人脸图像以及对应的3D 形状上的点之间建立透视投影关系,S I −5=s QRS ′5+(tx ,ty )T 联立方程组,求解计算得到旋转矩阵R 的参数.其中,Q 为2×3的投影矩阵,即⎟⎟⎠⎞⎜⎜⎝⎛=010001Q ,仅获取y x ,方向的信息用来计算.s 是尺度因子,ty tx ,分别是x ,y 方向平移分量. B. 在I S 和Rf S )(′两个向量对应的位移向量T 和尺度变化因子c 通过下面等式计算:尺度因子为()()∑∑==+∇−+∇−=k i i i ki i I i i I i Y X Y Y Y X X X c 122100)()()()(.然后,更新位移向量分量:,)(110∑=−=∇k i i I i X c X k X ∑=−=∇k i i I i Y c Y k Y 10)(1, 位移向量为 T Y X Y X ),...,,,(∇∇∇∇=T .其中,0X ∇和0Y ∇分别是X ∇和Y ∇在前一次迭代计算得到的值,在第1次计算时被设置为A 步骤中求解得到的tx 和ty .I i X 和I i Y 是输入人脸图像中的特征点的坐标值.i X 和i Y 是Rf S )(′中对应的点的x ,y 方向分量值.重复B步骤2~3次即可计算出恰当的位移和尺度因子.C. 利用B 中得到的T 和c ,通过等式(5)更新Rf S )(′.D. 得到了新的Rf S )(′,我们就可以很容易地根据等式(4)来计算形状系数向量α.E. 根据等式αP S S ′+′=′,我们可以重构出对应于特定人的稀疏的3D 人脸形状S ′.F. 重复步骤A~E,直到形状系数向量收敛.530Journal of Software 软件学报 V ol.17, No.3, March 2006最终,由密集的统计变形模型(等式(1)),我们可以重构得到对应于输入人脸的3D 形状.为得到更加精细的3D 形状的解,我们按照给定2D 图像上的特征点的坐标来对3D 形状顶点进行进一步调整.一旦得到了人脸精细的3D 形状信息,再结合此特定人的纹理图像,对姿态的校正就可以简单地通过旋转3D 人脸模型来实现了.1.2 基于球面谐波商图像的光照不变的纹理生成根据上节中恢复得到的3D 形状和姿态参数,人脸区域可以直接从给定的2D 人脸图像中抽取得到.然而,所得到的人脸图像并不是真正的纹理图像,而是随着光照的变化而变化的.虽然生成特定人本质的纹理是很直观的想法,但是本文并不直接恢复纹理信息,而是转而采取去光的策略来消除光照的影响,将提取的人脸区域的光照条件校正到参考光照条件下,即形成光照不变的纹理图像[12].最终,这个标准参考光照下的纹理可以被绘制到3D 人脸形状上,从而重建出完整的与光照无关的3D 人脸.由于反射等式可以被看作是一个卷积,因此很自然地在频域空间来对其进行分析.对于球面谐波,Basri 等人[13]证明了亮度的绝大部分能量都限制在3个低阶的部分,其频域公式为∑∑∑∑∑∑∞=−==−=∞=−=≈==0200),(),(),(),(l l l m l ll m lm lm l l l l m lm lm l lm lm Y L A Y L A Y E E βαβαβαβα (6) 其中,)4π,3π2,π(210===A A A A l [13]是Lambertian 反射的球面谐波系数,lm L 是入射光线的系数,lm Y 是球面谐波函数.给定一幅纹理图像I ,对于每一个像素(x ,y ),下面等式几乎都成立:()),(),,(),(),(y x y x E y x y x I βαρ=.这里,),(y x α和),(y x β可由3D 人脸形状的法线向量计算得到.假设人脸的反照率ρ为常数,lm l A Y E lm =表示谐波图像,E 是lm E 的9×n 维矩阵.其中,n 是纹理图像的像素总数,则光照条件L 的系数就可以通过最小二乘解得: I L E L L−=)(min arg ˆρ (7) 如果我们已经估计得到给定图像的光照条件,就可以很容易地将其重新打光到标准光照下.对图像上(x ,y )处一个确定的点P ,它的法线为),(βα,反照率为),(y x ρ,则原始图像上和光照校正后P 点的亮度分别是:⎪⎪⎭⎪⎪⎬⎫==∑∑∑∑=−==−=2020),(),(),(),(ˆ),(),(l l l m lm can lm l can l ll m lm lm l org Y L A y x y x I Y L A y x y x I βαρβαρ (8) 两种不同光照下的商图像定义为 ∑∑∑∑∑∑∑∑=−==−==−==−====20202020),(ˆ),(),(ˆ),(),(),(),(),(),(l l l m lm lm l l ll m lm can lm l l l l m lm lm l l l lm lm can lm l org can Y L A Y L A Y L A y x Y L A y x y x I y x I y x R βαβαβαρβαρ (9)由于给定图像的光照条件和参考光照条件都是确定的,因此对于给定人来说,参考光照条件相对于原始光照条件下的商图像就已经确定了.进而,基于原图像和商图像,光照校正后的纹理图像可以如下计算得到: ),(),(),(y x I y x R y x I org can ×= (10)得到了精细的3D 形状和去除光照影响的纹理后,我们就实现了根据输入的单幅任意光照下的非正面图像重构出对应于特定人的标准光照条件下的3D 人脸.对于纹理图像上不可见的点,采取插值策略进行填充. 2 实验与分析在这一节,我们通过姿态和光照不变的人脸识别来评价本文提出的姿态和光照校正算法的性能.对于一幅任意光照下的非正面人脸图像,重建它的与光照无关的3D 人脸,即无论输入图像的光照条件如何,最终重构的柴秀娟等:基于3D人脸重建的光照、姿态不变人脸识别5313D人脸对应的纹理都被校正到预先定义的参考光照条件下.姿态的校正是通过将3D人脸旋转到预先定义的标准姿态下实现的.经过校正后的人脸图像被作为一般人脸识别系统的输入来进行识别.2.1 姿态不变的人脸识别实验结果首先,对仅仅是姿态发生变化的情况进行测试,在CMU PIE数据库[14]中对4个姿态子集进行测试,分别是姿态集合05(右转22.5°)、姿态集合29(左转22.5°)、姿态集合37(右转45°)和姿态集合11(左转45°).Gallery中的图像来自姿态集合2,其中都是正面图像.本节仅仅对姿态变化情况进行测试,假设给定的图像其光照条件是均衡的.因此,不必对光照进行特别处理,即用从图像中提取出来的人脸区域来近似标准光照条件下的纹理图像,然后进行3D人脸重建,实现姿态校正.我们采用的人脸识别方法是Gabor PCA 加 LDA方法,其思想与GFC相似[15].训练图像从CAS-PEAL数据库[16]中选取,共300个人,平均每人选择6个姿态图像,10个正面图像.由于CAS-PEAL库采集条件与CMU PIE 库相距甚远,因此,避免了训练图像和测试图像之间条件相似给识别结果带来的影响.在此实验过程中,特征点是手工标定的.对于姿态校正策略进行人脸识别,其最重要的一点就是校正后的视图一定要在外观上与Gallery中的原型视图很相似.我们在图2里给出了一些基于3D人脸重建的姿态校正后的结果,用来进行视觉上的评价.图2中第1行是原始的4个非正面姿态下加了掩模的图像,第2行是对应的姿态校正后的图像,校正视图右侧的一列是来自姿态集合27的gallery图像,用作校正视图的参考.可见,对4个姿态的人脸进行姿态校正,校正后的人脸与Galley中原始正面人脸图像极为相似.并且,在P4 处理器,主频3.2GHz的电脑上,本文的方法进行一次完整的人脸重建只需1秒的时间.与文献[8]中的3D变形模型方法相比,计算复杂度大大降低.3D变形模型方法的一次拟合过程在一台2GHz,P4处理器的工作站上,大约需要4.5分钟[8].我们对这4个姿态子集的图像进行姿态校正,继而进行人脸识别,识别结果在表1中列出.校正之后,在4个姿态集合上的累积识别率比用原始人脸图像进行识别的情况有很大程度上的提高,首选识别率平均达到94.85%.我们还将此结果与特征光场方法(eigen light field)的结果进行了比较.特征光场方法可以用来解决人脸识别中的姿态和光照问题[17].该方法通常采用两种不同的标准化策略,分别是3点标准化和多点标准化.我们的结果与这两种标准化策略的结果进行比较,识别率都有提高(见表1).实验结果表明,基于3D人脸重建的姿态校正方法具有很好的性能.因此,我们认为在计算时间降低的情况下,基于本文方法进行的姿态不变的人脸识别仍然取得了另人满意的识别率.OriginalPose normalization P11 P11P29 P29 P05P05 P37 P37P27 P27Fig.2 The pose normalized images图2 姿态校正的结果由于这里用于3D人脸重建的特征点是手工标定的,而各种多姿态特征点定位方法在定位人脸关键点的过程中都不可避免地存在误差,因此为了衡量本文算法对特征点定位误差的鲁棒性,我们人为地对手工标定的特征点加高斯噪声.基于有高斯误差的特征点定位结果,我们重新进行3D人脸重建、姿态校正以及后续的人脸识别,从而验证定位的误差对使用本文策略进行姿态不变的人脸识别结果的影响.这里为尽量减少其他因素的影响,精确地分析特征点定位误差对识别结果的影响,我们采用简单的计算相关性的方法作为识别的度量.我们还尝试了对手工标定的人脸关键特征点增加5组不同的噪声,其均值为0,方差分别为1.0,1.5,2.0,2.5以及3.0.对特征点定位结果加入高斯噪声的姿态不变人脸识别结果见表 2.我们发现,对特征定位结果增加不同程度的高斯扰动,并没有造成识别结果发生较大的变化.。

caimr计算方法

caimr计算方法CAIMR 计算方法CAIMR(细胞自动化形态学图像重建)是一种用于从细胞图像序列创建三维 (3D) 模型的计算方法。

该方法涉及以下步骤:1. 图像预处理:将细胞图像序列对齐和注册,以补偿样品运动和漂移。

增强图像对比度和信噪比,以提高细胞的可视性。

分割细胞,将其与背景分离。

2. 表面渲染:使用分割的细胞图像,生成细胞表面的网格模型。

优化网格以平滑表面并减少多边形数量。

应用纹理贴图以实现细胞膜的逼真呈现。

3. 体素重建:将细胞表面网格转换为体素,形成细胞的内部表示。

使用算法填充网格内的体素,例如 Marching Cubes 或Poisson 重建。

平滑体素模型以减少锯齿和伪影。

4. 模型分析:计算模型的几何特征,例如体积、表面积和形状系数。

分析细胞形态随时间或处理条件的变化。

识别和量化细胞亚型或异常。

优点:高精度:CAIMR 模型通常高度精确,反映了细胞的真实 3D 形状。

可扩展性:该方法可以应用于大数据集,包括数千个细胞图像。

灵活性:CAIMR 可以处理各种细胞类型和形态。

可视化:3D 模型提供了一个强大的方式来可视化细胞结构和动态变化。

应用:CAIMR 在细胞生物学和生物医学研究中具有广泛的应用,包括:研究细胞形态与功能之间的关系。

检测和表征细胞异常,如癌症或神经退行性疾病。

创建 3D 细胞库,用于药物筛选和治疗开发。

提高对细胞生长、分化和组织形成的理解。

限制:依赖图像质量:CAIMR 模型的精度取决于图像质量和预处理步骤。

计算密集型:此方法可能在处理大型数据集时需要大量计算资源。

假设:CAIMR 模型假设细胞具有固定的拓扑结构,这可能不适用于所有细胞类型。

持续发展:CAIMR 作为一个研究领域正在不断发展,重点在于提高精度、效率和针对更广泛的细胞类型的适用性。

机器学习算法和高性能计算技术正在集成到 CAIMR 方法中,以进一步增强其功能。

三维图形引擎综述

Figure 1. “3I” feature: immersion, interaction, imagination 图 1. “3I”特征:沉浸–交互–想象[1]

Figure 2. The development level of 3D drawing tools 图 2. 三维图形绘制工具开发层次

虚拟现实研究的主要内容包括实时三维图形生成技术、多传感器交互技术和高分辨率现实技术[2]。 其软件技术基础则是三维图形渲染技术。目前三维图形技术的底层图形开发包主要有三类:

(1) 微软公司制定的 Direct3D,并以此衍生出的基于.Net 框架平台的 XNA 技术,以及适用于浏览器 的 Silverlight 技术;

关键词

虚拟现实,三维图形引擎,基本架构,绘制原理

1. 引言

虚拟现实(Virtual Reality,简称 VR,又称为虚拟实景),是一种基于可计算信息的多通道的沉浸式交 互环境,它是以计算机技术为核心,结合其他相关科学技术(如交互技术、人工智能等),生成一个在视、 听、触感等方面与逼真环境高度近似的数字化环境,用户可以借助其他设备与该环境进行交互,从而产 生身临对应真实环境的感受和体验[1] [2]。虚拟现实的研究已经有 20 多年,直到现在,它仍是计算机图 形学三大热门话题之一。它以“3I”的特性(见图 1) (Immersion 沉浸感、Interaction 交互式、Imagination 想象力),应用于各个方向领域,包括公共安全、工业设计、医疗辅助、军事模拟、航空航天、交通规划 和文化教育等,其应用又集中在培训演练、规划设计和展示娱乐三方面。

Abstract

Objective: Virtual Reality is the high-tech advanced technology developed in recent years, calculated using high-speed computer to simulate a virtual three-dimension space. It allows users to have sensory simulation with vision, hearing, touch and so on. Users feel that they are in the area, and can observe all the thing in the three-dimensional space in real time and without limitation. The three-dimensional graphics rendering technology is not only the basis of software technique in virtual reality, but also the core of the three-dimensional graphics engine. In order to make more researchers have a more comprehensive understanding in 3D graphics engine theory, structure and principle, a detailed introduction was reviewed. Method: A large number of 3D engine theory were summarized, classified and compared. This paper introduces the definition of the virtual reality briefly, as well as mainly introducing the research status, basic structure and draw principle of the three-dimensional graphics engine. Result: So far, there are so many 3D engine with many differences, but the basic structure and drawing principle are the same. The change is how to organize the structure of each module. In order to make the engine has maximum performance, we should consider the relationship of each module. Conclusion: The 3D engine technology is the basis of virtual reality, and there are a number of problems we should overcome. Some problems also need further research.

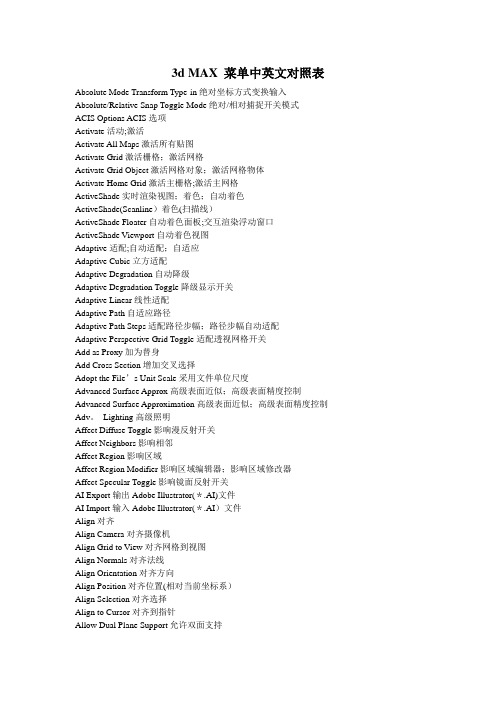

3d MAX 菜单中英文对照表

3d MAX 菜单中英文对照表Absolute Mode Transform Type-in绝对坐标方式变换输入Absolute/Relative Snap Toggle Mode绝对/相对捕捉开关模式ACIS Options ACIS选项Activate活动;激活Activate All Maps激活所有贴图Activate Grid激活栅格;激活网格Activate Grid Object激活网格对象;激活网格物体Activate Home Grid激活主栅格;激活主网格ActiveShade实时渲染视图;着色;自动着色ActiveShade(Scanline)着色(扫描线)ActiveShade Floater自动着色面板;交互渲染浮动窗口ActiveShade Viewport自动着色视图Adaptive适配;自动适配;自适应Adaptive Cubic立方适配Adaptive Degradation自动降级Adaptive Degradation Toggle降级显示开关Adaptive Linear线性适配Adaptive Path自适应路径Adaptive Path Steps适配路径步幅;路径步幅自动适配Adaptive Perspective Grid Toggle适配透视网格开关Add as Proxy加为替身Add Cross Section增加交叉选择Adopt the File’s Unit Scale采用文件单位尺度Advanced Surface Approx高级表面近似;高级表面精度控制Advanced Surface Approximation高级表面近似;高级表面精度控制Adv。

Lighting高级照明Affect Diffuse Toggle影响漫反射开关Affect Neighbors影响相邻Affect Region影响区域Affect Region Modifier影响区域编辑器;影响区域修改器Affect Specular Toggle影响镜面反射开关AI Export输出Adobe Illustrator(*.AI)文件AI Import输入Adobe Illustrator(*.AI)文件Align对齐Align Camera对齐摄像机Align Grid to View对齐网格到视图Align Normals对齐法线Align Orientation对齐方向Align Position对齐位置(相对当前坐标系)Align Selection对齐选择Align to Cursor对齐到指针Allow Dual Plane Support允许双面支持All Class ID全部类别All Commands所有命令All Edge Midpoints全部边界中点;所有边界中心All Face Centers全部三角面中心;所有面中心All Faces所有面All Keys全部关键帧All Tangents全部切线All Transform Keys全部变换关键帧Along Edges沿边缘Along V ertex Normals沿顶点法线Along Visible Edges沿可见的边Alphabetical按字母顺序Always总是www_bitscn_com中国.网管联盟Ambient阴影色;环境反射光Ambient Only只是环境光;阴影区Ambient Only Toggle只是环境光标记American Elm美国榆树Amount数量Amplitude振幅;幅度Analyze World分析世界Anchor锚Angle角度;角度值Angle Snap Toggle角度捕捉开关Animate动画Animated动画Animated Camera/Light Settings摄像机/灯光动画设置Animated Mesh动画网格Animated Object动画物体Animated Objects运动物体;动画物体;动画对象Animated Tracks动画轨迹Animated Tracks Only仅动画轨迹Animation动画Animation Mode Toggle动画模式开关Animation Offset动画偏移Animation Offset Keying动画偏移关键帧Animation Tools动画工具Appearance Preferences外观选项Apply Atmospherics指定大气Apply—Ease Curve指定减缓曲线Apply Inverse Kinematics指定反向运动Apply Mapping指定贴图坐标Apply—Multiplier Curve指定增强曲线Apply To指定到;应用到Apply to All Duplicates指定到全部复本Arc弧;圆弧Arc Rotate弧形旋转;旋转视图;圆形旋转Arc Rotate Selected弧形旋转于所有物体;圆形旋转选择物;选择对象的中心旋转视图Arc Rotate SubObject弧形旋转于次物体;选择次对象的中心旋转视图Arc ShapeArc Subdivision弧细分;圆弧细分Archive文件归档Area区域Array阵列Array Dimensions阵列尺寸;阵列维数Array Transformation阵列变换ASCII Export输出ASCII文件Aspect Ratio纵横比Asset Browser资源浏览器Assign指定Assign Controller分配控制器Assign Float Controller分配浮动控制器Assign Position Controller赋予控制器Assign Random Colors随机指定颜色Assigned Controllers指定控制器At All Vertices在所有的顶点上At Distinct Points在特殊的点上At Face Centers 在面的中心At Point在点上Atmosphere氛围;大气层;大气,空气;环境Atmospheres氛围Attach连接;结合;附加Attach Modifier结合修改器Attach Multiple多项结合控制;多重连接Attach To连接到Attach To RigidBody Modifier连接到刚性体编辑器Attachment连接;附件Attachment Constraint连接约束Attenuation衰减AudioClip音频剪切板AudioFloat浮动音频Audio Position Controller音频位置控制器AudioPosition音频位置Audio Rotation Controller音频旋转控制器AudioRotation音频旋转Audio Scale Controller音频缩放控制器AudioScale音频缩放;声音缩放Auto自动Auto Align Curve Starts自动对齐曲线起始节点Auto Arrange自动排列Auto Arrange Graph Nodes自动排列节点Auto Expand自动扩展Auto Expand Base Objects自动扩展基本物体Auto Expand Children自动扩展子级Auto Expand Materials自动扩展材质Auto Expand Modifiers自动扩展修改器Auto Expand Selected Only自动扩展仅选择的Auto Expand Transforms自动扩展变换Auto Expand XYZ Components自动扩展坐标组成Auto Key自动关键帧Auto-Rename Merged Material自动重命名合并材质Auto Scroll自动滚屏Auto Select自动选择Auto Select Animated自动选择动画Auto Select Position自动选择位置bitsCN#com中国网管联盟Auto Select Rotation自动选择旋转Auto Select Scale自动选择缩放Auto Select XYZ Components自动选择坐标组成Auto—Smooth自动光滑AutoGrid自动网格;自动栅格AutoKey Mode Toggle自动关键帧模式开关Automatic自动Automatic Coarseness自动粗糙Automatic Intensity Calculation自动亮度计算Automatic Reinitialization自动重新载入Automatic Reparam.自动重新参数化Automatic Reparamerization自动重新参数化Automatic Update自动更新Axis轴;轴向;坐标轴Axis Constraints轴向约束Axis Scaling轴向比率Back后视图Back Length后面长度Back Segs后面片段数Back View背视图Back Width后面宽度Backface Cull背面忽略显示;背面除去;背景拣出Backface Cull Toggle背景拣出开关Background背景Background Display Toggle背景显示开关Background Image背景图像Background Lock Toggle背景锁定开关Background Texture Size背景纹理尺寸;背景纹理大小Backgrounds背景Backside ID内表面材质号Backup Time One Unit每单位备份时间Banking倾斜Banyan榕树Banyan tree榕树Base基本;基部;基点;基本色;基色Base/Apex基点/顶点Base Color基准颜色;基本颜色Base Colors基准颜色Base Curve基本曲线Base Elev基准海拔;基本海拔Base Objects导入基于对象的参数,例如半径、高度和线段的数目;基本物体Base Scale基本比率Base Surface基本表面;基础表面Base To Pivot中心点在底部Bevel Profile轮廓倒角Bevel Profile Modifier轮廓倒角编辑器;轮廓倒角修改器Bezier贝塞尔曲线Bezier Color贝塞尔颜色bbs。

纹理物体缺陷的视觉检测算法研究--优秀毕业论文

摘 要

在竞争激烈的工业自动化生产过程中,机器视觉对产品质量的把关起着举足 轻重的作用,机器视觉在缺陷检测技术方面的应用也逐渐普遍起来。与常规的检 测技术相比,自动化的视觉检测系统更加经济、快捷、高效与 安全。纹理物体在 工业生产中广泛存在,像用于半导体装配和封装底板和发光二极管,现代 化电子 系统中的印制电路板,以及纺织行业中的布匹和织物等都可认为是含有纹理特征 的物体。本论文主要致力于纹理物体的缺陷检测技术研究,为纹理物体的自动化 检测提供高效而可靠的检测算法。 纹理是描述图像内容的重要特征,纹理分析也已经被成功的应用与纹理分割 和纹理分类当中。本研究提出了一种基于纹理分析技术和参考比较方式的缺陷检 测算法。这种算法能容忍物体变形引起的图像配准误差,对纹理的影响也具有鲁 棒性。本算法旨在为检测出的缺陷区域提供丰富而重要的物理意义,如缺陷区域 的大小、形状、亮度对比度及空间分布等。同时,在参考图像可行的情况下,本 算法可用于同质纹理物体和非同质纹理物体的检测,对非纹理物体 的检测也可取 得不错的效果。 在整个检测过程中,我们采用了可调控金字塔的纹理分析和重构技术。与传 统的小波纹理分析技术不同,我们在小波域中加入处理物体变形和纹理影响的容 忍度控制算法,来实现容忍物体变形和对纹理影响鲁棒的目的。最后可调控金字 塔的重构保证了缺陷区域物理意义恢复的准确性。实验阶段,我们检测了一系列 具有实际应用价值的图像。实验结果表明 本文提出的纹理物体缺陷检测算法具有 高效性和易于实现性。 关键字: 缺陷检测;纹理;物体变形;可调控金字塔;重构

Keywords: defect detection, texture, object distortion, steerable pyramid, reconstruction

II

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Results

Selected Representatives of the Major Abundance Patterns

Selected Representative Proteins with Complex and Newly Characterized Abundance Patterns

Data analysis: FTICR spectra deisotoping was performed by Horn mass transform using ICR2LS (an in house developed software package available at ). Detection of MS features and matching to the peptides from AMT tag database was done using VIPER software. Ad hoc written Visual Basic, Perl and R scripts were used for statistical filtering of MS feature/peptide matches and robust quantitation of protein abundances.

Methods

Mouse brain tissue samples and voxel samples were prepared from C57BL6 mice at UCLA.

Sample preparation: Brain tissue samples were lysed using hypotonic buffer and trifluoroethanol (TFE) and digested with trypsin. Sample processing for voxel samples was automated and performed on a Beckman Biomek FX liquid handling robot.

We classified 283 proteins into 5 clusters having apparent biases in protein abundance toward specific brain structures. 29 proteins had an increased abundance in the ventromedial area collocating with diecephalon, 59 in the cortex, 17 in the striatum, and 28 in the central part of the section collocating with white matter structures like corpus callosum, fornix and anterior commissure. In addition, 150 patterns were classified as uniform, i.e. without any significant bias in abundance across the slice. Of those protein distributions 68%, 82%, 100%, and 52%, correspondingly, agreed with mRNA distributions from GENSAT and Allen Brain Atlas project providing an evidence for validity of methodology.

Despite high automation comprehensive discovery-based analyses of multiple types of brains that represent different disease models and their progression states is a very challenging task.

Overview

We describe a methodology that combines a voxelation technique [1] with microscale automated sample processing and an LC-FTICR MS-based quantitative proteomic approach [2] for spatial imaging of protein abundances in mouse brain with 1 mm resolution.

As a proof-of-concept trial we applied this methodology for analysis of protein distribution within a coronal slice of a C57BL/6J mouse brain. For accurate quantitation of peptides across the slice we spiked an isotopically labeled reference sample into each voxel sample and used isotopic intensity ratios as accurate measurements of peptide abundances. As a reference sample we used the 18O-labeled tryptic peptides derived from a whole control coronal slice, thus providing a reference for virtually all peptides.

To contribute to 3D-proteome mapping method development we designed an approach that utilizes tissue voxelation and high-throughput quantitative proteomics and tested it on a mouse brain coronal section.

In total, 1028 proteins were identified and quantified using an accurate mass and time (AMT) tag strategy and 2D protein abundance images for these proteins are generated. The 1 mm spatial resolution was sufficient to distinguish major structural components of the brain in this coronal section, i.e., cerebral cortex, striatum, diencephalon, white matter and olfactory tubercles.

Overview of the Approach

Introduction

The immense molecular complexity of the mammalian brain is a significant challenge in applying high-throughput technologies in a discovery-driven fashion. Besides that, an additional challenge is dictated by the importance of taking into account the brain’s complicated anatomy and 3D structure for understanding of its functioning. A few currently ongoing efforts (e.g., Allen Brain Atlas Project and GENSAT) independently aim at comprehensive spatial gene expression characterization of mouse brain using in situ hybridization technology.

a

b

c

Comparison of protein and mRNA distributions for selected genes with characteristic abundance patterns: cortical, ventromedial, striatal, central and uniform. The determined protein relative abundance data are on the left side. On the right side are the mRNA abundance data provided under license by The Allen Institute for Brain Science (). Sagital sections were used when the coronal section data were not available. The arrows on the sagital sections indicate the corresponding position of bregma 0 coronal section.

1Biological Sciences Division and Environmental Molecular Sciences Laboratory, Pacific Northwest National Laboratory, . Box 999, Richland, WA 99352 2Department of Molecular and Medical Pharmacology, UCLA School of Medicine, Los Angeles, CA 90095