solr配置及数据库及文档解析

Solr的原理及使用

Solr的原理及使⽤1.Solr的简介Solr是⼀个独⽴的企业级搜索应⽤服务器,它对外提供类似于Web-service的API接⼝。

⽤户可以通过http请求,向搜索引擎服务器提交⼀定格式的XML⽂件,⽣成索引;也可以通过Http Get操作提出查找请求,并得到XML格式的返回结果。

2.⼯作原理solr是基于Lucence开发的企业级搜索引擎技术,⽽lucence的原理是倒排索引。

那么什么是倒排索引呢?接下来我们就介绍⼀下lucence倒排索引原理。

假设有两篇⽂章1和2:⽂章1的内容为:⽼超在卡⼦门⼯作,我也是。

⽂章2的内容为:⼩超在⿎楼⼯作。

由于lucence是基于关键词索引查询的,那我们⾸先要取得这两篇⽂章的关键词。

如果我们把⽂章看成⼀个字符串,我们需要取得字符串中的所有单词,即分词。

分词时,忽略”在“、”的“之类的没有意义的介词,以及标点符号可以过滤。

我们使⽤Ik Analyzer实现中⽂分词,分词之后结果为:⽂章1:⽂章2:接下来,有了关键词后,我们就可以建⽴倒排索引了。

上⾯的对应关系是:“⽂章号”对“⽂章中所有关键词”。

倒排索引把这个关系倒过来,变成: “关键词”对“拥有该关键词的所有⽂章号”。

通常仅知道关键词在哪些⽂章中出现还不够,我们还需要知道关键词在⽂章中出现次数和出现的位置,通常有两种位置:a.字符位置,即记录该词是⽂章中第⼏个字符(优点是关键词亮显时定位快);b.关键词位置,即记录该词是⽂章中第⼏个关键词(优点是节约索引空间、词组(phase)查询快),lucene中记录的就是这种位置。

加上出现频率和出现位置信息后,我们的索引结构变为:实现时,lucene将上⾯三列分别作为词典⽂件(Term Dictionary)、频率⽂件(frequencies)、位置⽂件 (positions)保存。

其中词典⽂件不仅保存有每个关键词,还保留了指向频率⽂件和位置⽂件的指针,通过指针可以找到该关键字的频率信息和位置信息。

Solr 功能使用

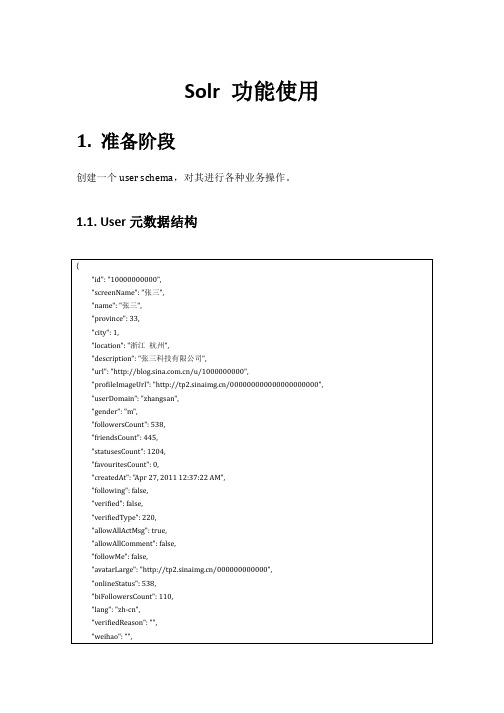

Solr 功能使用1. 准备阶段创建一个user schema,对其进行各种业务操作。

1.1. User元数据结构1.2. Solr schema设计●增加一个copyField text用于文本搜索1.3. 数据导入总共365051条记录,顺便感叹一下耗时,只花了5毫秒:2. 功能使用solr提供了多种语言的sdk,上面导入数据使用的是solrj,以下我就只用使用2.1. 基本查询http://172.16.5.2:8983/solr/user_shard2_replica1/select?q=*:*&wt=json&inden t=true&start=0&row=10&sort=followersCount+desc解释:●查询条件“*:*”,查询所有数据●格式化返回格式json:wt=json&indent=true●从0条开始,返回10条记录:start=0&row=10●按照用户粉丝量倒叙返回:sort=followersCount+desc,“+”号可使用空格代替更多的常用参数:●fq:对查询结果的二次筛选,且会把查询的结果缓存起来,下次同样的查询将直接命中缓存●fl:对返回的结果字段进行限制,例如我只想返回id更丰富的使用规范说明:https:///confluence/display/solr/Query+Syntax+and+Parsing 2.2. 权重查询DisMax以上面的schema为例,假设我需要查询所有“九江”的用户。

地区值是存放在location字段中的,也有可能用户只在location中只存放了“江西”,但是description中有可能存放了和九江相关的介绍,这样这个用户只能说有可能也是九江的,在查询是我希望确定是九江的用户排在前面。

这个时候就可以用到权重这个概念了。

上面的应用场景查询方式:http://172.16.5.2:8983/solr/user_shard2_replica1/select?q=text:%E4%B9%9D %E6%B1%9F&start=0&rows=10&wt=json&indent=true&defType=dismax&qf=l ocation^10+description^3权重查询常用参数:●defType=dismax,属于基本查询的参数,权重查询时必须是dismax●qf:权重设置,例如location^10就是location字段的权重设置,值得大小我理解是相对的,默认不设置的为1●mm:当查询条件(指的是参数个数,而非表达式个数)为多个时,设置返回最少匹配的次数另外还有很多参数,我还没有理解设计意图。

Solr搜索技术应用实战

Solr搜索技术应用实战Solr是一个开源的搜索平台,它基于Apache Lucene构建,提供丰富的API和可扩展性,已经成为了许多开发者选择的搜索引擎。

随着数据量的增加和业务场景的多样化,Solr的应用越来越广泛。

本文将从Solr的实战应用入手,为开发者提供一些技巧和经验。

一、Solr集群搭建Solr的性能和可靠性与硬件配置和部署状态密切相关。

在生产环境中建议使用集群部署,可以分布式处理查询请求,增加搜索并发能力和容错性。

Solr集群中每个节点可以作为独立的搜索服务器,提供相同的搜索服务。

一个完整的Solr集群由多个节点组成,分为SolrCloud和非SolrCloud两种模式,SolrCloud是集群管理的一种模式,在SolrCloud模式下,Solr 集群可以更方便地进行扩容和管理。

以下是SolrCloud集群的简要步骤:1. 准备ZooKeeper,SolrCloud使用ZooKeeper进行集群管理。

2. 启动Solr节点,并与ZooKeeper进行连接。

3. 使用Solr控制台创建集合,集合分片在所有节点之间平均分配。

4. 访问SolrCloud集群的URL,进行搜索等操作。

二、Solr数据导入Solr并不能直接从数据库或文件中获取数据,需要使用数据导入扩展来实现数据导入。

Solr数据导入流程大致如下:1. 配置数据源和数据目标,Solr支持多种数据源,包括数据库、文件、RSS等。

2. 配置数据导入的转换器和分词器,将数据源的数据转化为Solr需要的格式。

3. 配置数据导入的定时策略,Solr可以定时从数据源获取数据并导入。

以下是一个Solr数据导入的示例配置文件:```<dataConfig><dataSource name=\"jdbcDataSource\" type=\"JdbcDataSource\" driver=\"com.mysql.jdbc.Driver\"url=\"jdbc:mysql:\/\/localhost:3306\/test\" user=\"root\" password=\"123456\"\/><document><entity name=\"book\" query=\"SELECT * FROM book\"><field column=\"id\" name=\"id\"\/><field column=\"title\" name=\"title\"\/><field column=\"author\" name=\"author\"\/><field column=\"description\" name=\"description\"\/><\/entity><\/document><\/dataConfig>```以上配置会将MySQL数据库中的book表的所有数据导入Solr,并映射到Solr的id、title、author和description字段中。

ApacheSolr入门教程(初学者之旅)

ApacheSolr⼊门教程(初学者之旅)Apache Solr⼊门教程(初学者之旅)写在前⾯:本⽂涉及solr⼊门的各⽅⾯,建议边思考边实践,相信能帮助你对solr有个清晰全⾯的了解并能简单实⽤。

在Apache Solr初学者教程的这个例⼦中,我们将讨论有关如何安装最新版本的Apache Solr,并告诉你如何配置它。

此外,我们将告诉你如何进⾏使⽤solr的样本数据⽂件索引。

Apache Solr⽀持不同格式,包括各种数据库,PDF⽂件,XML⽂件,CSV⽂件等等。

在这个例⼦中,我们将研究如何从⼀个CSV⽂件索引数据。

⾸选这个例⼦的环境是Windows。

开始Solr安装之前,确保你已经安装了JDK和正确配置JAVA_HOME。

1.为什么选择Apache SolrApache Solr是⼀个功能强⼤的搜索服务器,它⽀持REST风格API。

Solr是基于Lucene的,Lucene ⽀持强⼤的匹配能⼒,如短语,通配符,连接,分组和更多不同的数据类型。

它使⽤ Apache Zookeeper特别针对⾼流量进⾏优化。

Apache Solr提供各式各样的功能,我们列出了部分最主要的功能。

1. 先进的全⽂搜索功能。

2. XML,JSON和HTTP - 基于开放接⼝标准。

3. ⾼度可扩展和容错。

4. 同时⽀持模式和⽆模式配置。

5. 分页搜索和过滤。

6. ⽀持像英语,德语,中国,⽇本,法国和许多主要语⾔7. 丰富的⽂档分析。

2.安装Apache Solr要⾸先让从以下位置下载最新版本的Apache Solr:在撰写本⽂时,可⽤的稳定版本是5.0.0。

Apache Solr经历了从4.XX到5.0.0各种变化了,所以如果你有不同版本的Solr,你需要下载5.xx版本并以此为模板。

⼀旦Solr的zip⽂件下载将它解压缩到⼀个⽂件夹。

提取的⽂件夹看起来像下⾯。

Solr的⽂件夹bin⽂件夹中包含⽤来启动和停⽌服务器的脚本。

solr完整快速搭建版(学习笔记)

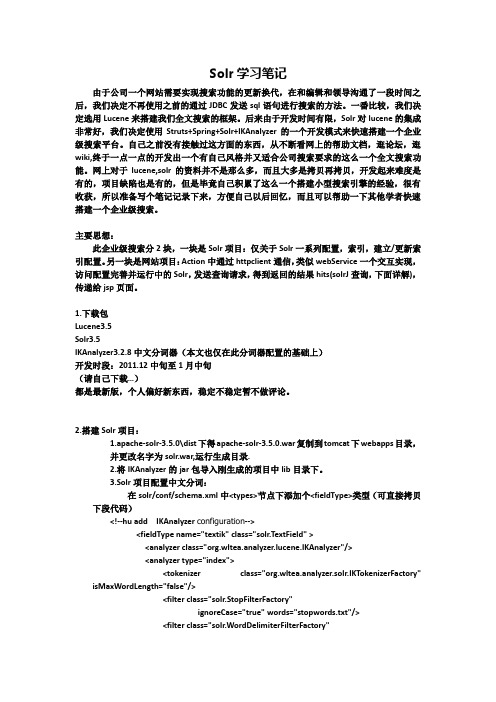

Solr学习笔记由于公司一个网站需要实现搜索功能的更新换代,在和编辑和领导沟通了一段时间之后,我们决定不再使用之前的通过JDBC发送sql语句进行搜索的方法。

一番比较,我们决定选用Lucene来搭建我们全文搜索的框架。

后来由于开发时间有限,Solr对lucene的集成非常好,我们决定使用Struts+Spring+Solr+IKAnalyzer的一个开发模式来快速搭建一个企业级搜索平台。

自己之前没有接触过这方面的东西,从不断看网上的帮助文档,逛论坛,逛wiki,终于一点一点的开发出一个有自己风格并又适合公司搜索要求的这么一个全文搜索功能。

网上对于lucene,solr的资料并不是那么多,而且大多是拷贝再拷贝,开发起来难度是有的,项目缺陷也是有的,但是毕竟自己积累了这么一个搭建小型搜索引擎的经验,很有收获,所以准备写个笔记记录下来,方便自己以后回忆,而且可以帮助一下其他学者快速搭建一个企业级搜索。

主要思想:此企业级搜索分2块,一块是Solr项目:仅关于Solr一系列配置,索引,建立/更新索引配置。

另一块是网站项目:Action中通过httpclient通信,类似webService一个交互实现,访问配置完善并运行中的Solr,发送查询请求,得到返回的结果hits(solrJ查询,下面详解),传递给jsp页面。

1.下载包Lucene3.5Solr3.5IKAnalyzer3.2.8中文分词器(本文也仅在此分词器配置的基础上)开发时段:2011.12中旬至1月中旬(请自己下载…)都是最新版,个人偏好新东西,稳定不稳定暂不做评论。

2.搭建Solr项目:1.apache-solr-3.5.0\dist下得apache-solr-3.5.0.war复制到tomcat下webapps目录,并更改名字为solr.war,运行生成目录.2.将IKAnalyzer的jar包导入刚生成的项目中lib目录下。

3.Solr项目配置中文分词:在solr/conf/schema.xml中<types>节点下添加个<fieldType>类型(可直接拷贝下段代码)<!--hu add IKAnalyzer configuration--><fieldType name="textik" class="solr.TextField" ><analyzer class="org.wltea.analyzer.lucene.IKAnalyzer"/><analyzer type="index"><tokenizer class="org.wltea.analyzer.solr.IKT okenizerFactory"isMaxWordLength="false"/><filter class="solr.StopFilterFactory"ignoreCase="true" words="stopwords.txt"/><filter class="solr.WordDelimiterFilterFactory"generateWordParts="1"generateNumberParts="1"catenateWords="1"catenateNumbers="1"catenateAll="0"splitOnCaseChange="1"/><filter class="solr.LowerCaseFilterFactory"/><filter class="solr.EnglishPorterFilterFactory"protected="protwords.txt"/><filter class="solr.RemoveDuplicatesT okenFilterFactory"/></analyzer><analyzer type="query"><tokenizer class="org.wltea.analyzer.solr.IKT okenizerFactory" isMaxWordLength="false"/><filter class="solr.StopFilterFactory"ignoreCase="true" words="stopwords.txt"/><filter class="solr.WordDelimiterFilterFactory"generateWordParts="1"generateNumberParts="1"catenateWords="1"catenateNumbers="1"catenateAll="0"splitOnCaseChange="1"/><filter class="solr.LowerCaseFilterFactory"/><filter class="solr.EnglishPorterFilterFactory"protected="protwords.txt"/><filter class="solr.RemoveDuplicatesT okenFilterFactory"/></analyzer></fieldType>此配置不过多解释:<analyzer type="query">此处配置type并分成index和query 代表着在索引和查询时候的分词实现,isMaxWordLength表示是以何种分词实现,true,false各代表一种,具体请看IKAnalyzer说明文档。

Solr开发指南

Solr全文检索技术1.Solr介绍 152.Solr安装配置-SolrCore配置 153.Solr安装配置-Solr工程部署 104.Solr安装配置-Solr工程测试 155.Solr安装配置-多SorlCore配置 106.Solr入门--schema 207.Solr入门-安装中文分词器 158.Solr入门-自定义业务系统Field 209.Solr入门-SolrJ介绍1010.Solr入门-SolrJ索引维护 2011.Solr入门-数据导入处理器2012.Solr入门-搜索语法 1013.Solr入门-SolrJ-搜索 2014.Solr案例-需求分析 1015.Solr案例-架构设计 1516.Solr案例-Service 2017.Solr案例-Controller 2018.Solr案例-主体调试 2019.Solr案例-功能完善1【Solr介绍】1.1S olr是什么Solr 是Apache下的一个顶级开源项目,采用Java开发,它是基于Lucene的全文搜索服务。

Solr提供了比Lucene更为丰富的查询语言,同时实现了可配置、可扩展,并对索引、搜索性能进行了优化。

Solr可以独立运行,运行在Jetty、Tomcat等这些Servlet容器中,Solr 索引的实现方法很简单,用 POST 方法向 Solr 服务器发送一个描述 Field 及其内容的 XML 文档,Solr根据xml文档添加、删除、更新索引。

Solr 搜索只需要发送 HTTP GET 请求,然后对 Solr 返回Xml、json等格式的查询结果进行解析,组织页面布局。

Solr不提供构建UI的功能,Solr提供了一个管理界面,通过管理界面可以查询Solr的配置和运行情况。

1.2S olr与Lucene的区别Lucene是一个开放源代码的全文检索引擎工具包,它不是一个完整的全文检索引擎,Lucene提供了完整的查询引擎和索引引擎,目的是为软件开发人员提供一个简单易用的工具包,以方便的在目标系统中实现全文检索的功能,或者以Lucene为基础构建全文检索引擎。

Solr搜索文档说明

Solr使用教程目录一、软件版本 (2)二、安装教程 (2)1、Solr安装教程 (2)2、solr环境搭建 (4)3、业务字段的实际配置 (7)4、dataimport 导入数据库数据 (8)5、solrj的使用 (10)6、电商平台的应用 (14)一、软件版本Solr版本号:solr-5.5.5jdk版本号:jdk1.8以上Tomcat版本号:Tomcat8.0以上二、安装教程1、Solr安装教程1.创建solrhome以及solrcore(mysolrhome、mycore 名字可以任意指定)1.1在指定的目录下新建文件夹solrhome如:D:\mysolrhome1.2将solr-5.5.4\server\solr\solr.xml拷贝至D:\mysolrhome1.3在solrhome下新建文件夹solrcore如D:\mysolrhome\mycore1.4将solr-5.5.4\server\solr\configsets\basic_configs\conf完整目录拷贝至D:\mysolrhome\mycore\下2.部署到Tomcat2.1将solr-5.5.4\server\solr-webapp\webapp 完整目录复制到Apache Tomcat 8.0.27\webapps下并重命名为solr2.2在Apache Tomcat 8.0.27\webapps\solr\WEB-INF下新建classes文件夹2.3将solr-5.5.4/server/resource/log4j.properties 拷贝至上一步创建的classes2.4把solr-5.5.4/server/lib/ext/目录下的所有jar文件复制到Apache Tomcat 8.0.27/webapp/solr/WEB-INF/lib/中3.配置solrcore3.1修改Apache Tomcat 8.0.27-solr\webapps\solr\WEB-INF\web.xml 新增<env-entry>标签,将你的solrhome配置进去。

Solr文档

Solr全文检索服务1企业站内搜索技术选型在一些大型门户网站、电子商务网站等都需要站内搜索功能,使用传统的数据库查询方式实现搜索无法满足一些高级的搜索需求,比如:搜索速度要快、搜索结果按相关度排序、搜索内容格式不固定等,这里就需要使用全文检索技术实现搜索功能。

1.1单独使用Lucene实现单独使用Lucene实现站内搜索需要开发的工作量较大,主要表现在:索引维护、索引性能优化、搜索性能优化等,因此不建议采用。

1.2使用Google或Baidu接口通过第三方搜索引擎提供的接口实现站内搜索,这样和第三方引擎系统依赖紧密,不方便扩展,不建议采用。

1.3使用Solr实现基于Solr实现站内搜索扩展性较好并且可以减少程序员的工作量,因为S olr提供了较为完备的搜索引擎解决方案,因此在门户、论坛等系统中常用此方案。

2什么是Solr什么是SolrSolr是Apache下的一个顶级开源项目,采用Java开发,它是基于Lucene的全文搜索服务器。

Solr提供了比Lucene更为丰富的查询语言,同时实现了可配置、可扩展,并对索引、搜索性能进行了优化。

Solr可以独立运行,运行在Jetty、Tomcat等这些Servlet容器中,Solr索引的实现方法很简单,用 POST 方法向 Solr 服务器发送一个描述 Field及其内容的 XML 文档,Solr根据xml文档添加、删除、更新索引。

Solr搜索只需要发送 HTTP GET 请求,然后对 Solr返回Xml、json等格式的查询结果进行解析,组织页面布局。

Solr不提供构建UI 的功能,Solr提供了一个管理界面,通过管理界面可以查询Solr的配置和运行情况。

Solr与Lucene的区别Lucene是一个开放源代码的全文检索引擎工具包,它不是一个完整的全文检索引擎,Lucene提供了完整的查询引擎和索引引擎,目的是为软件开发人员提供一个简单易用的工具包,以方便的在目标系统中实现全文检索的功能,或者以Lucene为基础构建全文检索引擎。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一、准备数据1.去官网下载最新的solr。

当前最新为4.5版本。

2.准备tomcat7.(下载tomcat7)二、配置solr。

1.将下载的solr4.5解压得到:2.将example\solr-webapp 下的solr.war 放到tomcat的webapp下。

3.启动tomcat 此时报错,solr.war 解压关闭tomcat 删除solr.war4.得到solr 项目5.配置solr_home :将下载的solr包中解压的example/solr 文件夹copy到d:/solr/solr_home(路径可以任意修改)。

6.打开tomcat下的webapp\solr\WEB-INF 下的web.xml,修改添加如下代码:<env-entry><env-entry-name>solr/home</env-entry-name><env-entry-value>D:/solr/solr_home</env-entry-value><env-entry-type>ng.String</env-entry-type></env-entry>7.其中<env-entry-value> 中的值即为第5步中配置的路径。

8.copy 下载包中的example\lib\ext 下的jar包全部放到tomcat 的lib 目录下。

9设置solr/collection/conf/中的solrconfig.xml 中jar包路径,将路径该对就可以了。

10.将C:\app\solr-4.5.0\solr-4.5.0\example\resources下的log4j.properties拷贝到C:\Program Files\Apache Software Foundation\Tomcat 7.0\webapps\solr\WEB-INF\classes下。

11.启动tomcat。

访问看到以下页面说明部署成功。

solr本身对中文分词的处理不是太好,所以中文应用很多时候都需要额外加一个中文分词器对中文进行分词处理,ik-analyzer就是其中一个不错的中文分词器。

一、版本信息solr版本:4.7.0需要ik-analyzer版本:IK Analyzer 2012FF_hf1ik-analyzer下载地址:/p/ik-analyzer/downloads/list二、配置步骤下载压缩解压后得到如下目录结构的文件夹:我们把IKAnalyzer2012FF_u1.jar拷贝到solr服务的solr\WEB-INF\lib下面。

我们把IKAnalyzer.cfg.xml、stopword.dic拷贝到需要使用分词器的core的conf下面,和core的schema.xml文件一个目录。

修改core的schema.xml,在<types></types>配置项间加一段如下配置:[html]view plaincopy1.<fieldType name="text_ik"class="solr.TextField">2.<analyzer class="org.wltea.analyzer.lucene.IKAnalyzer"/>3.</fieldType>我们就多了一种text_ik的field类型了,该类型使用的分词器就是ik-analyzer。

我们在这个core的schema.xml里面配置field类型的时候就可以使用text_ik了。

[html]view plaincopy1.<field name="name"type="text_ik"indexed="true"stored="true"multiValued="false"/>三、中文分词测试[html]view plaincopy1.IKT2.3.text4.raw_bytes5.start6.end7.type8.position9.10.中华人民共和国11.[e4 b8 ad e5 8d 8e e4 ba ba e6 b0 91 e5 85 b1 e5 92 8c e5 9b bd]12.013.7_WORD15.116.17.中华人民18.[e4 b8 ad e5 8d 8e e4 ba ba e6 b0 91]19.020.4_WORD22.223.24.中华25.[e4 b8 ad e5 8d 8e]26.027.2_WORD29.330.31.华人32.[e5 8d 8e e4 ba ba]33.134.3_WORD36.437.38.人民共和国39.[e4 ba ba e6 b0 91 e5 85 b1 e5 92 8c e5 9b bd]40.241.7_WORD43.544.45.人民46.[e4 ba ba e6 b0 91]47.248.4_WORD50.651.52.共和国53.[e5 85 b1 e5 92 8c e5 9b bd]54.455.7_WORD57.758.59.共和60.[e5 85 b1 e5 92 8c]61.462.6_WORD64.865.66.国67.[e5 9b bd]68.669.7_CHAR71.9二、导入Pdf,word索引数据源并不会一定来自于数据库、XML、JSON、CSV这类结构化数据,很多时候也来自于PDF、word、html、word、MP3等这类非结构化数据,从这类非结构化数据创建索引,solr也给我们提供了很好的支持,利用的是apache tika。

下面我们来看看在solr4.7中如何从pdf文件创建索引。

一、配置文件索引库1、新建core(可以与关系型数据库同一个core,收索用“attr_content:下载”)我们新建一个solr的core,用于存储文件型索引,新建core的步骤请参考:/clj198606061111/article/details/212884992、准备jar我们在$solr_home下面新建一个extract文件夹,用于存放solr扩展jar包。

从colr4.7发布包中solr-4.7.0\dist拷贝solr-cell-4.7.0.jar到新建的extract文件夹下。

拷贝solr4.7发布包solr-4.7.0\contrib\extraction\lib下所有jar包到extract文件夹下。

3、配置solrconfig.xml添加请求解析配置:[html]view plaincopy1.<requestHandler name="/update/extract"class="solr.extraction.ExtractingRequestHandler">2.<lst name="defaults">3.<str name="fmap.content">text</str>4.<str name="lowernames">true</str>5.<str name="uprefix">attr_</str>6.<str name="captureAttr">true</str>7.</lst>8.</requestHandler>指定依赖包位置:注意,这个相对位置不是相对于配置文件所在文件夹位置,而是相对core主目录的。

比如我的配置文件在solr_home\core1\conf,但是我的jar包在solr_home\ extract那么我的相对路径就是../extract而不是../../extract。

[html]view plaincopy1.<lib dir="../extract"regex=".*\.jar"/>4、配置schema.xml4.1配置索引字段的类型,也就是field类型。

其中text_general类型我们用到2个txt文件(stopwords.txt、synonyms.txt),这2个txt 文件在发布包示例core里面有位置在:solr-4.7.0\example\solr\collection1\conf,复制这2个txt文件到新建的$solr_home的那个新建的core下面的conf目录下,和schema.xml一个位置。

[html]view plaincopy1.<types>2.<fieldType name="long"class="solr.TrieLongField"precisionStep="0"positionIncrementGap="0"/>3.<fieldtype name="string"class="solr.StrField"sortMissingLast="true"omitNorms="true"/>4.<fieldType name="text_general"class="solr.TextField"positionIncrementGap="100">5.<analyzer type="index">6.<tokenizer class="solr.StandardTokenizerFactory"/>7.<filter class="solr.StopFilterFactory"ignoreCase="true"words="stopwords.txt"/>8.<filter class="solr.LowerCaseFilterFactory"/>9.</analyzer>10.<analyzer type="query">11.<tokenizer class="solr.StandardTokenizerFactory"/>12.<filter class="solr.StopFilterFactory"ignoreCase="true"words="stopwords.txt"/>13.<filter class="solr.SynonymFilterFactory"synonyms="synonyms.txt"ignoreCase="true"expand="true"/>14.<filter class="solr.LowerCaseFilterFactory"/>15.</analyzer>16.</fieldType>17.</types>4.2配置索引字段,也就是field其中有个动态类型字段,attr_*,这个是什么意思呢。