设计一个Tomcat访问日志分析工具

Java日志收集与分析:使用Logstash、Elasticsearch和Kibana进行日志处理

Java日志收集与分析:使用Logstash、Elasticsearch和Kibana进行日志处理引言:在现代软件开发中,日志记录是一项至关重要的任务。

通过记录应用程序的运行时信息和错误,我们可以更好地了解应用程序的行为和性能。

然而,随着应用程序规模的增长,日志数据量也越来越庞大,如何高效地收集、存储和分析这些日志数据成为了一个挑战。

本文将介绍如何使用Logstash、Elasticsearch和Kibana这三个开源工具来进行Java日志的收集和分析。

一、Logstash简介Logstash是一个开源的数据收集引擎,它可以从各种来源(如日志文件、消息队列、数据库等)收集数据,并将其转换为统一的格式,最后输出到指定的目的地。

Logstash具有强大的过滤和转换功能,可以对数据进行各种操作,如解析结构化日志、过滤无关信息、添加额外的字段等。

二、Elasticsearch简介Elasticsearch是一个分布式的实时搜索和分析引擎,它可以快速地存储、搜索和分析大量的数据。

Elasticsearch使用倒排索引的方式来存储数据,使得数据的搜索和分析变得非常高效。

它支持全文搜索、聚合分析、地理位置搜索等功能,非常适合用于日志数据的存储和分析。

三、Kibana简介Kibana是一个基于Elasticsearch的开源数据可视化工具,它可以通过简单的配置和操作来创建各种图表和仪表盘,帮助用户更直观地理解和分析数据。

Kibana支持多种图表类型,如柱状图、折线图、饼图等,还可以对数据进行过滤、聚合、排序等操作,使得数据的可视化分析变得非常方便。

四、日志收集与处理流程1. 安装和配置Logstash首先,我们需要在服务器上安装和配置Logstash。

通过编辑Logstash的配置文件,我们可以指定要收集的日志文件路径、日志格式、过滤规则等。

同时,我们还可以配置Logstash的输出插件,将处理后的日志数据发送到Elasticsearch进行存储。

tomcataccess日志详解

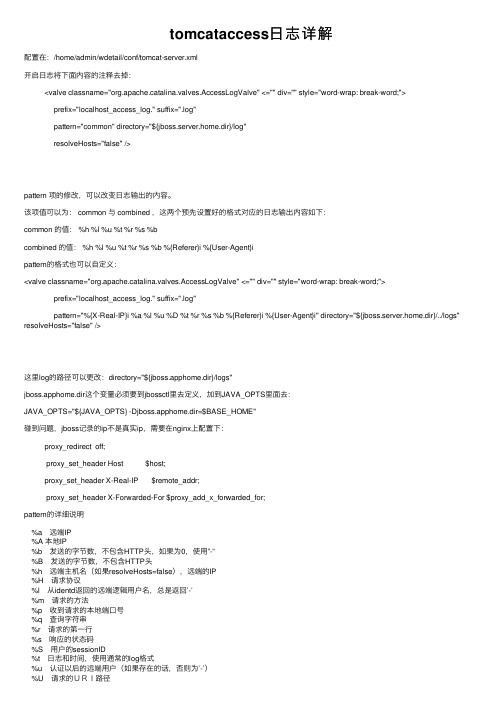

tomcataccess⽇志详解配置在:/home/admin/wdetail/conf/tomcat-server.xml开启⽇志将下⾯内容的注释去掉:<valve classname="org.apache.catalina.valves.AccessLogValve" <="" div="" style="word-wrap: break-word;">prefix="localhost_access_log." suffix=".log"pattern="common" directory="${jboss.server.home.dir}/log"resolveHosts="false" />pattern 项的修改,可以改变⽇志输出的内容。

该项值可以为: common 与 combined ,这两个预先设置好的格式对应的⽇志输出内容如下:common 的值: %h %l %u %t %r %s %bcombined 的值: %h %l %u %t %r %s %b %{Referer}i %{User-Agent}ipattern的格式也可以⾃定义:<valve classname="org.apache.catalina.valves.AccessLogValve" <="" div="" style="word-wrap: break-word;">prefix="localhost_access_log." suffix=".log"pattern="%{X-Real-IP}i %a %l %u %D %t %r %s %b %{Referer}i %{User-Agent}i" directory="${jboss.server.home.dir}/../logs" resolveHosts="false" />这⾥log的路径可以更改:directory="${jboss.apphome.dir}/logs"jboss.apphome.dir这个变量必须要到jbossctl⾥去定义,加到JAVA_OPTS⾥⾯去:JAVA_OPTS="${JAVA_OPTS} -Djboss.apphome.dir=$BASE_HOME"碰到问题,jboss记录的ip不是真实ip,需要在nginx上配置下:proxy_redirect off;proxy_set_header Host $host;proxy_set_header X-Real-IP $remote_addr;proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;pattern的详细说明%a 远端IP%A 本地IP%b 发送的字节数,不包含HTTP头,如果为0,使⽤”-”%B 发送的字节数,不包含HTTP头%h 远端主机名(如果resolveHosts=false),远端的IP%H 请求协议%l 从identd返回的远端逻辑⽤户名,总是返回’-’%m 请求的⽅法%p 收到请求的本地端⼝号%q 查询字符串%r 请求的第⼀⾏%s 响应的状态码%S ⽤户的sessionID%t ⽇志和时间,使⽤通常的log格式%u 认证以后的远端⽤户(如果存在的话,否则为’-’)%U 请求的URI路径%v 本地服务器的名称%D 处理请求的时间,以毫秒为单位%T 处理请求的时间,以秒为单位参数/选项说明:className: 实现的java类名,必须设置成org.apache.catalina.valves.AccessLogValve;directory: 存放⽇志⽂件的⽬录;pattern: 需要记录的⽇志信息的格式布局,如果是”common”或者”combined”,说明是使⽤的标准记录格式,也有⾃定义的格式,下⾯会详细说明;prefix: ⽇志⽂件名的前缀,如果没有指定,缺省值是”access_log.;(要注意后⾯有个⼩点);resolveHosts: 将远端主机的IP通过DNS查询转换成主机名,设为true。

自动删除tomcat服务日志的方法

自动删除tomcat服务日志的方法自动删除Tomcat服务日志的方法Tomcat是一个流行的Java Web应用程序服务器,它可以在Windows、Linux和其他操作系统上运行。

Tomcat服务器日志是记录Tomcat服务器运行状态的重要文件,但是随着时间的推移,日志文件会变得越来越大,占用大量磁盘空间。

为了避免这种情况,我们可以使用自动删除Tomcat服务日志的方法。

方法一:使用LogrotateLogrotate是一个Linux系统中的日志文件管理工具,它可以自动轮换、压缩和删除日志文件。

我们可以使用Logrotate来管理Tomcat服务器日志文件。

1. 安装Logrotate在Linux系统中,我们可以使用以下命令安装Logrotate:```sudo apt-get install logrotate```2. 创建Logrotate配置文件在/etc/logrotate.d/目录下创建一个名为tomcat的配置文件,内容如下:```/var/log/tomcat/*.log {dailyrotate 7compressmissingoknotifemptycreate 640 tomcat admsharedscriptspostrotate/etc/init.d/tomcat restart > /dev/nullendscript}```上述配置文件中,daily表示每天轮换一次日志文件,rotate 7表示保留7个日志文件,compress表示压缩日志文件,missingok表示如果日志文件不存在则忽略,notifempty表示如果日志文件为空则忽略,create 640 tomcat adm表示创建新的日志文件时设置权限为640,属主为tomcat,属组为adm,sharedscripts表示在所有日志文件轮换之后执行一次脚本,postrotate和endscript之间的命令表示在轮换日志文件之后重启Tomcat服务器。

服务器日志管理及分析工具推荐

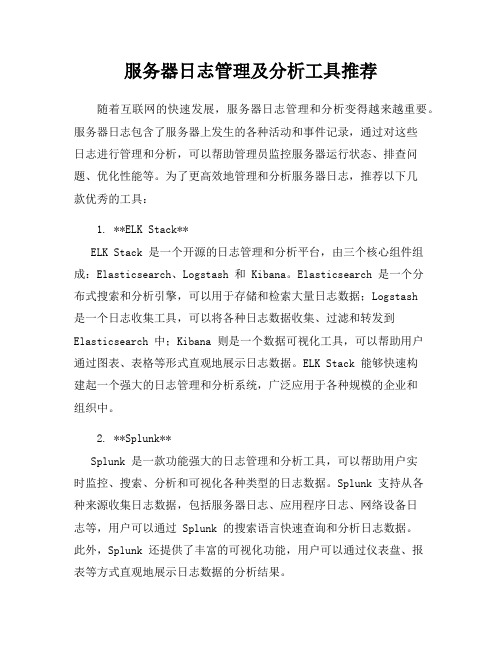

服务器日志管理及分析工具推荐随着互联网的快速发展,服务器日志管理和分析变得越来越重要。

服务器日志包含了服务器上发生的各种活动和事件记录,通过对这些日志进行管理和分析,可以帮助管理员监控服务器运行状态、排查问题、优化性能等。

为了更高效地管理和分析服务器日志,推荐以下几款优秀的工具:1. **ELK Stack**ELK Stack 是一个开源的日志管理和分析平台,由三个核心组件组成:Elasticsearch、Logstash 和 Kibana。

Elasticsearch 是一个分布式搜索和分析引擎,可以用于存储和检索大量日志数据;Logstash是一个日志收集工具,可以将各种日志数据收集、过滤和转发到Elasticsearch 中;Kibana 则是一个数据可视化工具,可以帮助用户通过图表、表格等形式直观地展示日志数据。

ELK Stack 能够快速构建起一个强大的日志管理和分析系统,广泛应用于各种规模的企业和组织中。

2. **Splunk**Splunk 是一款功能强大的日志管理和分析工具,可以帮助用户实时监控、搜索、分析和可视化各种类型的日志数据。

Splunk 支持从各种来源收集日志数据,包括服务器日志、应用程序日志、网络设备日志等,用户可以通过 Splunk 的搜索语言快速查询和分析日志数据。

此外,Splunk 还提供了丰富的可视化功能,用户可以通过仪表盘、报表等方式直观地展示日志数据的分析结果。

3. **Graylog**Graylog 是一款开源的日志管理平台,提供了日志收集、存储、搜索和分析等功能。

Graylog 支持从各种来源收集日志数据,包括Syslog、GELF、HTTP 等,用户可以通过 Graylog 的搜索功能快速定位和分析特定的日志事件。

此外,Graylog 还提供了警报功能,用户可以设置警报规则,及时发现和响应异常事件。

4. **Fluentd**Fluentd 是一款开源的日志收集工具,支持从各种来源收集日志数据,并将数据转发到不同的目的地,如 Elasticsearch、Kafka、Hadoop 等。

Django框架的微服务监控和日志分析工具推荐

Django框架的微服务监控和日志分析工具推荐Django是一个功能强大且易于使用的Python开发框架,广泛应用于构建大型Web应用程序。

然而,随着应用程序规模的扩大和微服务架构的流行,监控和日志分析变得尤为重要。

本文将介绍一些在Django框架中进行微服务监控和日志分析的工具,并提供推荐。

一、监控工具1. PrometheusPrometheus是一种开源的系统监控和警报工具,特别适用于微服务架构。

它可以通过暴露指标(metrics)的方式对应用程序进行监控。

在Django中,我们可以使用Prometheus客户端库来实现指标的收集和暴露。

借助Prometheus的图形化面板和警报功能,开发人员可以实时监测应用程序的性能和资源使用情况。

2. GrafanaGrafana是一个用于可视化指标数据和日志的开源工具。

它支持多种数据源,包括Prometheus。

在Django中,我们可以将Prometheus收集的指标数据导入Grafana,并使用其强大的查询和图表功能进行可视化展示。

Grafana的仪表盘功能还可以帮助我们实时监控和分析Django 应用程序的运行状态。

3. SentrySentry是一个针对应用程序错误和异常进行实时监控的工具。

它可以捕获应用程序中的异常,并提供详细的错误信息和栈追踪。

在Django中,我们可以通过集成Sentry客户端来捕获和汇报应用程序中的错误。

Sentry还提供了强大的筛选和分类功能,可以帮助开发人员快速定位和解决问题。

二、日志分析工具1. ELK StackELK Stack 是一个开源的日志分析解决方案,由Elasticsearch、Logstash和Kibana组成。

在Django中,我们可以使用Logstash来收集和处理应用程序的日志,然后将其存储在Elasticsearch中。

最后,通过Kibana进行日志可视化和查询分析。

ELK Stack提供了丰富的搜索和过滤功能,能够快速定位特定事件和问题,帮助开发人员更好地了解应用程序的运行情况。

Tomcat 开启访问日志功能(Access Log)

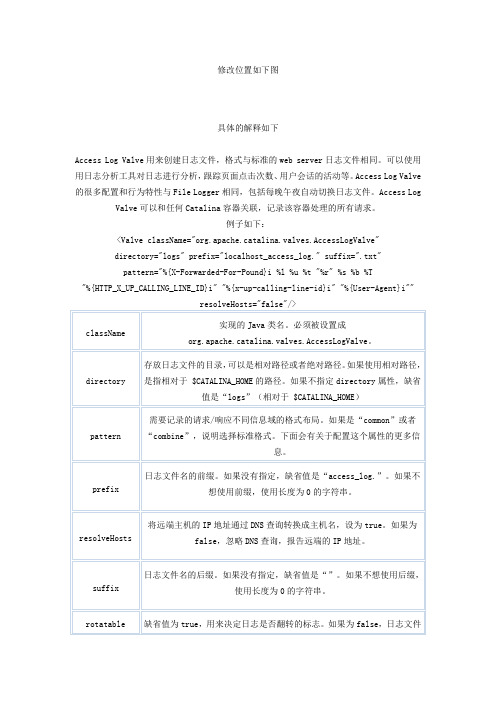

修改位置如下图具体的解释如下Access Log Valve用来创建日志文件,格式与标准的web server日志文件相同。

可以使用用日志分析工具对日志进行分析,跟踪页面点击次数、用户会话的活动等。

Access Log Valve 的很多配置和行为特性与File Logger相同,包括每晚午夜自动切换日志文件。

Access Log Valve可以和任何Catalina容器关联,记录该容器处理的所有请求。

例子如下:<Valve className="org.apache.catalina.valves.AccessLogValve"directory="logs" prefix="localhost_access_log." suffix=".txt"pattern="%{X-Forwarded-For-Pound}i %l %u %t "%r" %s %b %T"%{HTTP_X_UP_CALLING_LINE_ID}i" "%{x-up-calling-line-id}i" "%{User-Agent}i""pattern属性值由字符串常量和pattern标识符加上前缀"%"组合而成。

pattern标识符加上前缀"%",用来代替当前请求/响应中的对应的变量值。

目前支持如下的pattern:∙%a - 远端IP地址∙%A - 本地IP地址∙%b - 发送的字节数,不包括HTTP头,如果为0,使用"-"∙%B - 发送的字节数,不包括HTTP头∙%h - 远端主机名(如果resolveHost=false,远端的IP地址)∙%H - 请求协议∙%l - 从identd返回的远端逻辑用户名(总是返回 '-')∙%m - 请求的方法(GET,POST,等)∙%p - 收到请求的本地端口号∙%q - 查询字符串(如果存在,以 '?'开始)∙%r - 请求的第一行,包含了请求的方法和URI∙%s - 响应的状态码∙%S - 用户的session ID∙%t - 日志和时间,使用通常的Log格式∙%u - 认证以后的远端用户(如果存在的话,否则为'-')∙%U - 请求的URI路径∙%v - 本地服务器的名称∙%D - 处理请求的时间,以毫秒为单位∙%T - 处理请求的时间,以秒为单位运行结果常使用web服务器的朋友大都了解,一般的web server有两部分日志:一是运行中的日志,它主要记录运行的一些信息,尤其是一些异常错误日志信息二是访问日志信息,它记录的访问的时间,IP,访问的资料等相关信息。

tomcat中的logging.properties配置具体分析

tomcat中的logging.properties配置具体分析Tomcat默认使用JULI日志系统Tomcat 日志信息分为两类:一是运行中的日志,它主要记录运行的一些信息,尤其是一些异常错误日志信息。

二是访问日志信息,它记录的访问的时间,IP ,访问的资料等相关信息。

一Cataline引擎的日志文件,文件名catalina.日期.logTomcat下内部代码抛出的日志,文件名localhost.日期.log(jsp 页面内部错误的异常,org.apache.jasper.runtime.HttpJspBase.service类抛出的,日志信息就在该文件!)Tomcat下默认manager应用日志,文件名manager.日期.log 控制台输出的日志,Linux下默认重定向到catalina.out二Access日志(Servlet.xml配置)日志的级别分为如下 7 种:SEVERE (highest value) > WARNING > INFO > CONFIG > FINE > FINER > FINEST (lowest value)Tomcat使用的日志配置文件:$CATALINA_BASE/conf/logging.properties以tomcat-6.0.29为例:#配置tomcat的日志输出方式,这里表示文件输出和控制台输出.handlers = /doc/df17730159.html,.apache.juli.FileHandler, java.util.logging.ConsoleHandler/doc/df17730159.html,.apache.juli.FileHand ler.level = FINE #日志级别例:/doc/df17730159.html,.apache.juli.FileHand ler.level = FINE #设置 catalina 日志的级别为: FINE/doc/df17730159.html,.apache.juli.FileHand ler.level = OFF #禁用 catalina 日志的输出/doc/df17730159.html,.apache.juli.FileHand ler.level = ALL#输出 catalina 所有的日志消息均输出/doc/df17730159.html,.apache.juli.FileHand ler.directory = ${catalina.base}/logs #日志输出目录,此设置表示tomcat日志输出到tomcat\logs目录下/doc/df17730159.html,.apache.juli.FileHand ler.prefix = catalina. #日志输出前缀,后面跟日期信息(yyyy-MM-dd) 注:tomcat_6.0.29输出4种不同的日志:catalina、localhost、manager、host-managerjava.util.logging.ConsoleHandler.level = FINE #控制台日志输出级别java.util.logging.ConsoleHandler.formatter = java.util.logging.SimpleFormatter #控制台日志输出格式化类,Formatter 为格式化 LogRecords 提供支持。

springbootTomcat访问日志

springbootTomcat访问⽇志1.Tomcat设置访问⽇志1 <Host name="localhost" appBase="webapps"2 unpackWARs="true" autoDeploy="true">3 <!--4 <Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs"5 prefix="localhost_access_log." suffix=".txt"6 pattern="%h %l %u %t "%r" %s %b" />7 -->8 <Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs"9 prefix="localhost_access_log." suffix=".txt"10 pattern="%h,%l,%u,%t,%T,"%r",%s,%b,%{Referer}i,"%{User-Agent}i",%{X-Requested-With}i"11 fileDateFormat="yyyy-MM-dd.HH"12 />1314 </Host>2.springboot设置访问⽇志,在properties配置⽂件中添加tomcat⽇志配置1 #内嵌tomcat⽇志2 server.tomcat.accesslog.buffered=true3 server.tomcat.accesslog.directory=/usr/microStorage/tomcatLog4 server.tomcat.accesslog.enabled=true5 #每天保存⼀个6 server.tomcat.accesslog.file-date-format=yyyy-MM-dd7 server.tomcat.accesslog.pattern=%h %l %T %t %r %s %b %{Referer}i %{User-Agent}i8 server.tomcat.accesslog.prefix=access_log9 server.tomcat.accesslog.rename-on-rotate=false10 server.tomcat.accesslog.request-attributes-enabled=false11 server.tomcat.accesslog.rotate=true12 server.tomcat.accesslog.suffix=.log3.⽇志分析,通过正在表达式,将需要分析的信息进⾏正则捕获提取,然后根据需要进⾏相关数据的统计及可视化展⽰ 1public static void parse() throws Exception{2 String path = "D:/logs/localhost_access_log.2018-09-30.11.txt";3 BufferedReader br = new BufferedReader(new InputStreamReader(new FileInputStream(path)));4 String line = null;5 String reg = "^(.+?),(.+?),(.+?),(.+?),(.+?),(\\\".+?\\\"),(.+?),(.+?),(.+?),(\\\".+?\\\"),(.+?),(.+?)$";6 Pattern pattern = pile(reg);7while((line=br.readLine())!=null) {8 System.out.println(line);9 Matcher matcher = pattern.matcher(line);10 matcher.matches();11// pattern="%h,%l,%u,%t,%T,"%r",%s,%b,%{Referer}i,"%{User-Agent}i",%{X-Requested-With}i,%{passport}c"12 System.out.println("ip="+matcher.group(1));13 System.out.println("date="+matcher.group(4));14 System.out.println("cost="+matcher.group(5));15 System.out.println("request="+matcher.group(6));16 System.out.println("status="+matcher.group(7));17 System.out.println("bytes="+matcher.group(8));18 System.out.println("Referer="+matcher.group(9));19 System.out.println("User-Agent="+matcher.group(10));20 System.out.println("X-Requested-With="+matcher.group(11));21 System.out.println("passport="+matcher.group(12));22 System.out.println("------------------------------------");23 }24 br.close();25 }。

tomcat访问日志标准格式

tomcat访问日志标准格式

Tomcat 访问日志的标准格式通常是以下形式:

plain.

<IP 地址> [<日期和时间>] "<请求方法> <请求的URL> <协议>" <状态码> <响应大小>。

其中:

`<IP 地址>` 是客户端的 IP 地址。

`<日期和时间>` 是请求发生的日期和时间。

`<请求方法>` 是客户端使用的 HTTP 请求方法,比如 GET、POST 等。

`<请求的URL>` 是客户端请求的具体 URL 地址。

`<协议>` 是客户端使用的协议,通常是 HTTP/1.1 或

HTTP/2.0。

`<状态码>` 是服务器返回的 HTTP 状态码,用来表示请求的处

理结果。

`<响应大小>` 是服务器返回的响应的大小,通常以字节为单位。

这种格式的访问日志可以帮助管理员进行访问分析、性能监控

和安全审计等工作。

tomcat访问(access)日志配置和记录Post请求参数

tomcat访问(access)⽇志配置和记录Post请求参数⼀、配置与说明tomcat访问⽇志格式配置,在config/server.xml⾥Host标签下加上<Valve className="org.apache.catalina.valves.AccessLogValve" directory="logs"prefix="localhost_access_log." suffix=".txt"pattern="%h %l %u %t "%r" [%{postdata}r] %s %{Referer}i %{User-Agent}i %T %b" />我们在⽇志⽂件中将看到如下⽂本:10.217.14.16 - - [21/Oct/2016:15:48:54 +0800] "POST /updates/related_notice_num.json HTTP/1.0" [channel=App Store&gid=92391918-2173-4A66-8B31-B2FB3F8FB3DF&os=2&plat=2&sver=10.000000&token=MzM1OTc0MjQ1MkB3ZWliby55bXguY29tfHdlaWJvfDQ5ZGFmMjk0YjQ5YWQxMTZiZjBmYWM4ZDdhYzg3ZWQ0&ua=&ver=4.2.1] 200 - AllApp/4.2.1 (iPhone; iOS 10.0.2; Scale/3.00) 0.004 91参数说明:className 官⽅⽂档上说了:This MUST be set toorg.apache.catalina.valves.AccessLogValve to use the default access log valve。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

常使用web服务器的朋友大都了解,一般的web server有两部分日志:

一是运行中的日志,它主要记录运行的一些信息,尤其是一些异常错误日志信息

二是访问日志信息,它记录的访问的时间,IP,访问的资料等相关信息。

现在我来和大家介绍一下利用tomcat产生的访问日志数据,我们能做哪些有效的分析数据?

首先是配置tomcat访问日志数据,默认情况下访问日志没有打开,配置的方式如下:编辑${catalina}/conf/server.xml文件.注:${catalina}是tomcat的安装目录

把以下的注释(<!-- -->)去掉即可。

<!--

<Valve className="org.apache.catalina.valves.AccessLogValve"

directory="logs" prefix="localhost_access_log." suffix=".txt"

pattern="common" resolveHosts="false"/>

-->

其中directory是产生的目录tomcat安装${catalina}作为当前目录

pattern表示日志生产的格式,common是tomcat提供的一个标准设置格式。

其具体的表达式为%h %l %u %t "%r" %s %b

但本人建议采用以下具体的配置,因为标准配置有一些重要的日志数据无法生。

%h %l %u %t "%r" %s %b %T

具体的日志产生样式说明如下(从官方文档中摘录):

* %a - Remote IP address

* %A - Local IP address

* %b - Bytes sent, excluding HTTP headers, or '-' if zero

* %B - Bytes sent, excluding HTTP headers

* %h - Remote host name (or IP address if resolveHosts is false)

* %H - Request protocol

* %l - Remote logical username from identd (always returns '-')

* %m - Request method (GET, POST, etc.)

* %p - Local port on which this request was received

* %q - Query string (prepended with a '?' if it exists)

* %r - First line of the request (method and request URI)

* %s - HTTP status code of the response

* %S - User session ID

* %t - Date and time, in Common Log Format

* %u - Remote user that was authenticated (if any), else '-'

* %U - Requested URL path

* %v - Local server name

* %D - Time taken to process the request, in millis

* %T - Time taken to process the request, in seconds

There is also support to write information from the cookie, incoming header, the Session or something else in the ServletRequest. It is modeled after the apache syntax:

* %{xxx}i for incoming headers

* %{xxx}c for a specific cookie

* %{xxx}r xxx is an attribute in the ServletRequest

* %{xxx}s xxx is an attribute in the HttpSession

现在我们回头再来看一下下面这个配置%h %l %u %t "%r" %s %b %T 生产的访问日志数据,我们可以做哪些事?

先看一下,我们能得到的数据有:

* %h 访问的用户IP地址

* %l 访问逻辑用户名,通常返回'-'

* %u 访问验证用户名,通常返回'-'

* %t 访问日时

* %r 访问的方式(post或者是get),访问的资源和使用的http协议版本

* %s 访问返回的http状态

* %b 访问资源返回的流量

* %T 访问所使用的时间

有了这些数据,我们可以根据时间段做以下的分析处理(图片使用jfreechart工具动态生成):

* 独立IP数统计

* 访问请求数统计

* 访问资料文件数统计

* 访问流量统计

* 访问处理响应时间统计

* 统计所有404错误页面

* 统计所有500错误的页面

* 统计访问最频繁页面

* 统计访问处理时间最久页面

* 统计并发访问频率最高的页面

分析工具包括两大部分,一个是后台解释程序,每天执行一次对后台日志数据进行解析后保存到数据库中。

第二个是显示程序,从数据库中查询数据并生成相应的图表信息。