一种小波神经网络的优化算法

神经网络小波分析技术的研究

神经网络小波分析技术的研究神经网络小波分析技术是近年来发展迅速的一种分析技术。

它是基于小波分析的基础上,利用人工神经网络模型进行数据分析和模型建立的一种方法。

它的应用范围非常广泛,可以用于时间序列分析、图像处理、语音识别、金融风险评估等领域。

下面将从理论和应用两个方面探讨神经网络小波分析技术的研究。

一、理论研究神经网络小波分析技术是一种新的数据处理方法,它的理论基础是小波变换和人工神经网络模型。

在小波分析中,小波函数用于对信号进行分解,将信号分解成不同尺度和频率的小波系数,然后根据小波系数进行重构。

小波分析的优势在于可以同时分析信号的时域和频域信息,适用于处理具有局部特征的非平稳信号。

而在人工神经网络模型中,神经元利用类似于神经系统的方式处理信息,具有分布式处理、全局优化等优势。

神经网络小波分析技术将小波分析和神经网络模型有机地结合起来,用于数据分析和模型建立。

在神经网络小波分析中,先利用小波变换对原始数据进行分解,然后将小波系数作为输入信号传入神经网络中进行处理。

通过不断地迭代训练网络,最终获得满足误差要求的最优网络结构和权值,从而实现数据分析和模型建立。

神经网络小波分析技术在理论方面的研究主要包括网络结构的设计、学习算法的改进、模型评价等方面。

二、应用研究神经网络小波分析技术的应用范围非常广泛,可以应用于时间序列分析、图像处理、语音识别、金融风险评估等众多领域。

以下分别介绍一下神经网络小波分析技术在不同领域的应用。

1、时间序列分析时间序列分析是指对一系列按时间顺序排列的数据进行分析和预测的技术。

神经网络小波分析技术可以利用小波分解提取序列中不同频率成分,然后利用神经网络模型对时间序列进行建模和预测。

神经网络小波分析技术在金融、电力、医学等领域中都得到了广泛的应用。

2、图像处理图像处理是指对数字图像进行处理和分析的技术。

神经网络小波分析技术可用于数字图像压缩、边缘检测、纹理分析等方面。

利用小波变换可以提取图像中的局部特征,利用神经网络模型可以对图像进行分类识别,实现图像处理和分析。

改进人工鱼群算法优化小波神经网络的变压器故障诊断

改进人工鱼群算法优化小波神经网络的变压器故障诊断贾亦敏;史丽萍;严鑫【摘要】针对油浸式变压器故障类型的复杂难辨,结合油中气体分析法,提出一种基于改进人工鱼群算法优化小波神经网络的故障诊断模型.基于经典三层小波神经网络,采用粒子化的人工鱼群算法对小波神经网络输入和输出层的权值、小波神经元的伸缩和平移系数进行修正,通过引入动态反向学习策略实时优化人工鱼分布,迭代后半程采用基于柯西分布的自适应人工鱼视野范围提高算法精度.结果表明,该改进鱼群算法优化的小波神经网络相比标准粒子群算法优化小波神经网络和标准鱼群算法优化小波神经网络,诊断速度更快,准确率更高.【期刊名称】《河南理工大学学报(自然科学版)》【年(卷),期】2019(038)002【总页数】7页(P103-109)【关键词】变压器;故障诊断;小波神经网络;改进人工鱼群算法;粒子群优化算法;动态反向学习策略【作者】贾亦敏;史丽萍;严鑫【作者单位】中国矿业大学电气与动力工程学院,江苏徐州221116;中国矿业大学电气与动力工程学院,江苏徐州221116;国网上海市电力公司市北供电公司,上海200940【正文语种】中文【中图分类】TM4110 引言变压器自19世纪80年代问世以来,一直是电力系统的关键设备之一,受到了广泛关注和研究。

在整个输配电系统中,变压器作为核心组成部分占据着至关重要的地位,其性能的优劣直接影响整个供配电系统的经济效益与安全性。

在实际生产中,能否快速准确诊断或预测变压器已有故障或潜伏性故障,与电网能否安全稳定密切相关[1]。

基于油浸式变压器故障时油中会产生较多气体的油中气体分析法(dissolved gas analysis,DGA)自提出以来,已成为国内外实际应用最广泛的变压器故障诊断方法,该方法主要通过故障气体量与故障类型间数学关系进行判断,经典应用有三比值法与大卫三角法等。

近年来,许多新理论被应用于变压器故障诊断,主要有模糊算法[2]、支持向量机[3]、免疫算法[4]、粗糙集理论等,取得了一定成果。

高精度自适应小波神经网络人工智能方法探索

高精度自适应小波神经网络人工智能方法探索高精度自适应小波神经网络是一种基于小波变换和人工神经网络结合的人工智能方法,广泛应用于信号处理、图像识别、数据分析等领域。

该方法通过将小波变换和神经网络相结合,可以有效地提取数据的特征,较好地解决数据处理中的一些问题,同时具有高效、高精度、自适应等优点。

下面将对该方法进行详细讨论。

一、小波变换小波变换是一种时频分析方法,它可以将信号分解为不同尺度和频率的小波包,并将每个小波包的特征信息提取出来。

小波变换有以下两种类型:1. 连续小波变换(CWT)连续小波变换将信号与一个连续小波进行卷积,得到一系列连续的小波系数,不同的小波系数对应不同的尺度和频率。

离散小波变换将信号分解为不同尺度和频率的离散小波包,通过滤波和下采样操作,最终得到离散小波系数。

二、神经网络神经网络是一种模拟人脑神经元之间相互连接的计算模型,它能够通过学习经验来进行数据处理和分析。

神经网络由多个神经元组成,每个神经元接受来自其他神经元的输入,并根据输入计算输出。

神经网络训练的过程就是不断地调整神经元之间的连接权值,使网络可以更准确地进行预测和分类。

小波神经网络是将小波变换和神经网络相结合的方法,它将小波变换得到的特征作为神经网络的输入,利用神经网络的学习能力来构建模型并进行数据处理和预测。

小波神经网络的主要流程如下:1. 信号分解:将信号进行小波变换,得到多个小波系数。

2. 特征提取:将小波系数作为神经网络的输入,通过神经网络进行特征提取和数据降维。

3. 神经网络训练:利用已知的样本数据训练神经网络模型。

高精度自适应小波神经网络是对小波神经网络进行改进的方法,它通过引入自适应激活函数和粒子群优化算法来提高模型的精度和稳定性。

具体地,该方法将小波系数输入到神经元中,通过自适应激活函数计算输出,并利用粒子群优化算法动态调整神经元之间的连接权值。

优点:1. 可以有效地提取信号的特征,较好地解决信号处理中的一些问题。

神经网络算法的优化方法

神经网络算法的优化方法人工神经网络是一种仿生学的技术,它通过对大量的训练数据进行学习和优化,达到了模拟大脑神经元的效果。

然而,神经网络的训练过程复杂而耗时,需要不断调整网络结构和优化算法,才能获得满意的结果。

本文将介绍神经网络算法的优化方法。

一、神经网络的目标函数神经网络的训练过程就是通过一定的优化算法来最小化目标函数。

在神经网络中,目标函数通常被称为损失函数(loss function),其表示网络预测结果与真实值之间的差距。

常见的损失函数包括均方误差(MSE)、交叉熵(Cross Entropy)等。

均方误差是指预测值与真实值之差的平方和,交叉熵是一种度量两个概率分布之间差异的度量方式。

二、梯度下降优化算法梯度下降是一种常见的优化算法,其基本思想是通过不断地沿着梯度负方向更新网络参数,逐步降低目标函数的值。

具体而言,梯度下降算法按照以下步骤进行:1. 初始化网络参数。

2. 计算目标函数的梯度。

3. 根据梯度值调整网络参数。

4. 重复步骤2和步骤3,直至目标函数足够小,或者达到最大迭代次数。

在实际应用中,梯度下降算法通常会结合一些改进策略,如动量法(Momentum)、自适应学习率(Adaptive Learning Rate)等,以提高算法的收敛速度和稳定性。

三、自适应优化算法随着神经网络应用场景的不断增加,传统的梯度下降算法已经不能满足需求,因此出现了一些自适应优化算法。

3.1 Adam算法Adam算法是一种自适应优化算法,其基于动量法和RMSProp 算法设计。

Adam算法会根据当前梯度值和历史梯度信息来动态调整每个参数的学习率,以适应不同的梯度特征和目标函数形状。

具体而言,Adam算法按照以下步骤进行:1. 初始化参数和动量项。

2. 计算梯度和梯度平方的移动平均值,分别对应一阶矩估计(即动量项)和二阶矩估计(即变量速率)。

3. 根据当前梯度和梯度平方的移动平均值,计算动态学习率。

4. 根据动态学习率更新网络参数。

一种优化神经网络的教与学优化算法

i n g — b a s e d o p t i m i z a t i o n( MT L B O )a l g o r i t h m i s p r o p o s e d t o t r a i n t h e w e i g h t a n d t h r e s h o l d v a l u e o f n e u r a l n e t w o r k . I n

第 8卷第 4期

2 0 1 3 年 8 月 D O I : 1 0 . 3 9 6 9 / j . i s s n . 1 6 7 3 - 4 7 8 5 . 2 0 1 3 0 5 0 2 6

智

能

系

统

学

ቤተ መጻሕፍቲ ባይዱ

报

Vo 1 . 8 N o . 4

Aug .2 01 3

CAAI T r a ns a c t i o n s o n I n t e l l i z e n t S v s t e ms

Ab s t r a c t : I n o r d e r t o i mp r o v e t h e o u t pu t a c c u r a c y o f b a c k pr o p a g a t i o n n e u r a l n e t wo r k,a mo d i ie f d t e a c h i n g — l e a r n-

t h e MT L B O me t h o d,t h e“ T e a c h i n g ’ ’p h a s e a n d“ L e a ni r n g ”p h a s e w e r e mo d i i f e d o n t h e b a s i s o f T L B O a l g o i r t h m,

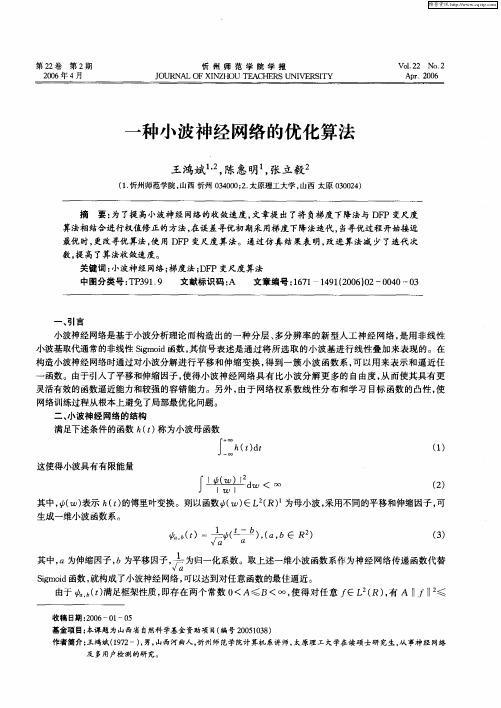

一种小波神经网络的优化算法

( )输出为 g( )我们 的 目的是确定网络参数 。可 t, t,

以通 过 下述误 差能 量 函数 对 网络参 数进 行优 化 。

1 .

E 0 =告[ () () () g t 一f t]

厶

一

() 6

图 l 小波神经 网络结构

算法相结合进行权值修正的方法 , 在误差寻优初期采用梯度下降法迭代 , 当寻优过程开始接近 最优 时, 更改寻优算法, 用 D P变尺度 算法。通过仿真 结果表 明, 使 F 改进算法减 少了迭代次

数, 高了算法收敛速度。 提

关键词 : 小波神经网络; 梯度法; F D P变尺度算法 中图分类号: P 9 . T 3 19 文献标识码 : A 文章编号:6 1 4 12 0 )2 04 —0 17 —19 ( 6 0 — 0 0 3 0

满足下述条件的函数 h t 称为小波母 函数 ()

』 : 三

这使得小波具有有限能量

( 1 )

( 2 )

f

生成一维小波函数系。

,

d <。 ∞ 。

其中, ) ( 表示 h t的傅里叶变换。则以函数 ( ) R) 为母小波 , () ∈L ( 采用不同的平移和伸缩因子 , 可

6

( )=

(

) ( , ,n bE R )

() 3

其中, 以为伸缩因子, 为平移因子, 为归一化系数。 b 告 取上述一维小波函数系作为神经网络传递函数代替

V a

S m i 函数 , i o g d 就构成 了小波神经网络 , 可以达到对任意函数的最佳逼近。

由于 , t满足框架性质 , 6 ) ( 即存在两个常数 0 <A≤B<∞ , 使得对 任意 f R)有 A l厂l ≤ EL ( , -l l

神经网络中的优化算法比较与选择

神经网络中的优化算法比较与选择神经网络是一种模拟人脑思维方式的计算模型,它通过模拟神经元之间的连接和信号传递来实现各种任务。

而神经网络的训练过程中,优化算法的选择对于网络的性能和效果起着至关重要的作用。

本文将对神经网络中常用的优化算法进行比较与选择。

一、梯度下降法梯度下降法是神经网络中最常用的优化算法之一。

其基本思想是通过计算损失函数对于参数的梯度,然后沿着梯度的反方向更新参数,以使损失函数逐渐减小。

梯度下降法具有简单易懂、易于实现的优点,但也存在一些问题。

例如,梯度下降法容易陷入局部最优解,而且在参数空间中搜索的效率较低。

二、随机梯度下降法随机梯度下降法是梯度下降法的一种变种,它在每次迭代时随机选择一个样本进行梯度计算和参数更新。

相比于梯度下降法,随机梯度下降法具有更快的收敛速度和更好的泛化能力。

然而,由于每次迭代只使用一个样本,随机梯度下降法的参数更新存在较大的方差,导致训练过程中的震荡。

三、动量法动量法是一种改进的梯度下降法,它引入了动量项来加速参数更新。

动量项可以理解为模拟物体运动的惯性,使得参数更新时具有一定的“动量”。

动量法的主要优点是能够加速收敛速度,减少震荡。

然而,动量法也存在一些问题,例如可能会导致参数更新过大,难以找到合适的学习率。

四、自适应学习率算法自适应学习率算法是一类根据参数更新情况自动调整学习率的优化算法。

常用的自适应学习率算法有Adagrad、RMSprop和Adam等。

这些算法通过考虑参数的历史梯度信息来调整学习率,从而在训练过程中更好地适应不同的参数更新情况。

自适应学习率算法具有较好的性能和泛化能力,但也存在一些问题,例如对于稀疏数据和大规模网络的适应性较差。

五、其他优化算法除了上述常用的优化算法外,还有一些其他的优化算法值得关注。

例如,L-BFGS算法是一种基于牛顿法的优化算法,它通过近似计算Hessian矩阵的逆来进行参数更新。

L-BFGS算法具有较快的收敛速度和较好的性能,但计算复杂度较高。

深度学习中的神经网络优化算法

深度学习中的神经网络优化算法深度学习是一种人工智能技术,已经被广泛应用于计算机视觉、自然语言处理等领域。

在深度学习中,神经网络是最常用的模型之一。

而神经网络的训练过程,通常需要通过优化算法来不断调整模型参数。

本文将介绍深度学习中常用的神经网络优化算法。

1. 梯度下降法梯度下降法是神经网络训练中最常用的优化算法之一。

它基于每个参数的梯度大小来不断更新参数,直到找到某个局部极小值点。

具体来说,它首先计算代价函数(loss function)对每个参数的偏导数,然后根据负梯度方向不断调整参数。

该方法被广泛应用于深度学习中的监督学习。

2. 随机梯度下降法随机梯度下降法是梯度下降法的一种变体。

它每次只使用随机选择的一部分数据计算梯度,然后更新参数。

该方法的优点在于速度更快,能够更快地找到某个局部极小值点。

但缺点是由于使用随机的数据,参数更新较为不稳定,可能会出现震荡,难以达到全局最优解。

3. 动量法动量法是一种优化梯度下降法的方法。

它通过累积之前的梯度信息,给予当前梯度更大的权重。

该方法可以加速训练过程,减少震荡。

具体来说,动量法引入了一个动量因子,用来指示在当前一步更新之前,过去更新的方向和大小。

4. 自适应学习率算法自适应学习率算法是一种能够自动调整学习率的优化算法。

在深度学习中,学习率是影响训练速度和结果的关键因素之一。

传统的梯度下降方法中,通常需要人工设置学习率,而自适应学习率算法则可以根据梯度大小自动调整学习率。

典型的算法包括AdaGrad、RMSProp和Adam等。

5. 梯度裁剪梯度裁剪是为了解决梯度爆炸和消失的问题而提出的方法。

在深度神经网络中,梯度通常会出现向无穷大或零趋近的情况,导致训练不稳定。

梯度裁剪通过限制每个梯度的绝对值来避免这种问题的出现,以保证网络的稳定和鲁棒性。

总结以上介绍了深度学习中常用的神经网络优化算法,每种算法都有其独特的优点和适用范围。

在实际应用中,通常需要根据具体任务的特点选择恰当的算法。

采用模糊小波基函数神经网络的控制系统及混合优化算法

第26卷第2期 2006年4月动 力 工 程V ol.26N o.2 Apr.2006 文章编号:100026761(2006)022233204采用模糊小波基函数神经网络的控制系统及混合优化算法程启明1, 王勇浩2(1.上海电力学院电力与自动化学院,上海200090;2.上海理工大学光电学院,上海200090)摘 要:提出了一种采用模糊小波基函数神经网络的控制器,该控制器采用小波基函数作为模糊隶属函数,利用神经网络实现模糊推理,并可对隶属函数进行实时调整,从而使控制器具备更强的学习和自适应能力。

还提出了控制器参数的混合学习算法,即先采用混沌算法离线优化,再采用BP 梯度算法在线调整。

对锅炉主蒸汽温度控制的仿真结果表明了此法的可行性和有效性。

图3参6关键词:自动控制技术;模糊神经网络;小波基函数;混合学习算法;主汽温控制;仿真中图分类号:TP273.5 文献标识码:AA Control System Using Fuzzy Wavelet Ba sis FunctionNeural Networks and Hybrid Optimizing AlgorithmCHEN Qi 2ming 1, WANG Yong 2hao2(1.C ollege of P ower and Automation ,Shanghai University of Electric P ower ,Shanghai 200090,China ;2.C ollege of Photoelectricity ,Shanghai University of Science and Engineering ,Shanghai 200090,China )Abstract :A controller ,which makes use of fuzzy wavelet basis function neural netw ork ,is being proposed.Wavelet basis functions are used as fuzzy membership functions together with neural netw orks for realizing fuzzy reas oning as well as for real time adjustment of the membership functions ,to prom ote the controller ’s learning and self 2adaption capability.A hybrid learning alg orithm for the controller ’s parameters is m oreover being proposed ,i.e.in a first step ,chaos optimizing alg orithm is used for off 2line optimization ,followed by on 2line adjustment with BP gradation alg orithm.Simulation results of a boiler ’s fresh steam tem perature control shows the feasibility and effectiveness of the proposed method.Figs 3and refs 6.K eywords :automatic control technique ;fuzzy neural netw ork ;wavelet basis function ;hybrid training alg orithm ;fresh steam tem perature control ;simulation收稿日期:2005210202 修订日期:2005212205基金项目:上海市重点学科建设项目(编号P1303)作者简介:程启明(19652),男,教授,硕士生导师,研究方向为智能控制、电厂自动化等。

一种深度小波过程神经网络及在时变信号分类中的应用

一种深度小波过程神经网络及在时变信号分类中的应用深度小波过程神经网络(Deep wavelet process neural network,DWPN)是一种结合了深度学习和小波变换的新型神经网络模型。

它能够有效地处理信号的时变特性,适用于时变信号分类、预测等任务。

本文将介绍DWPN的结构和工作原理,并探讨其在时变信号分类中的应用。

一、深度小波过程神经网络(DWPN)的结构和工作原理DWPN是一种深度神经网络模型,其核心是小波变换(wavelet transform)和神经网络(neural network)的结合。

小波变换是一种信号处理技术,能够将信号分解为不同频率的子信号,从而实现对信号时频特性的分析。

神经网络是一种模仿人脑神经元网络的计算模型,能够通过学习和训练实现对复杂模式的识别和分类。

DWPN的结构包括多个小波过程层和多个神经网络层,其中小波过程层用于对输入信号进行小波变换和特征提取,神经网络层用于对提取的特征进行分类和预测。

在训练阶段,DWPN通过反向传播算法和梯度下降方法对网络参数进行优化,从而实现对时变信号的分类和预测任务。

二、DWPN在时变信号分类中的应用1. 生物医学信号分类生物医学信号如心电图、脑电图等是一种典型的时变信号,其特征随着时间的变化而变化。

DWPN能够通过学习和训练实现对生物医学信号的自动分类,如心律失常检测、睡眠阶段识别等任务。

2. 金融时间序列预测金融市场的时间序列数据具有复杂的非线性和时变性质,传统的数学模型往往难以准确预测未来的走势。

DWPN能够通过学习历史数据的特征和规律,实现对金融时间序列的预测和分类,如股票价格走势预测、市场波动风险评估等任务。

4. 传感器信号分类传感器网络中产生的信号具有时变的特性,如温度、湿度、压力等信号。

DWPN能够通过学习和训练实现对传感器信号的分类和异常检测,如工业生产过程监测、环境监测等任务。

结语深度小波过程神经网络(DWPN)是一种结合了深度学习和小波变换的新型神经网络模型,能够有效处理信号的时变特性,适用于时变信号分类、预测等任务。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

其中 , a 为伸缩因子 , b 为平移因子 ,

1

a Sigmoid 函数 , 就构成了小波神经网络 , 可以达到对任意函数的最佳逼近 。

为归一化系数 。取上述一维小波函数系作为神经网络传递函数代替

2 由于 ψa , b ( t ) 满足框架性质 , 即存在两个常数 0 < A ≤B < ∞, 使得对任意 f ∈L 2 ( R ) , 有 A ‖f ‖ ≤

n

E (θ( k ) )

( 7) ( 8)

E =

k =1

[ g( t ) ∑

k

- f ( t k) ] ・

5 ( ) g t 5θ

其中 ,λ为学习因子 ( 即迭代步长) 。

( 二) 变尺度算法

θ按照变尺度法修正 , 其公式为 , 当寻优过程开始接近最优时 , 更改寻优算法 , 即采用变尺度算法 。 θ( k + 1) = θ( k ) + λH ( k ) D ( k ) ( 9) 其中 , H ( k ) 为 Hesse 矩阵 , 并且 H ( 0) 取为单位矩阵 。 5 Ek ( 10) D ( k) = 5θ

3. 提高了资金拨付效率和规范化程度 。实行财政集中

123

终用款单位和收款人 。

4. 促进了单位管理意识和水平的提高 。国库集中支付

收付制度 ,主管部门完成支付程序后 ,资金从财政部门账户 到用款单位或收款人账户可在一天完成 。高校提出直接支 付申请时 ,必须按规范的程序和要求做好相关工作 , 克服以 往存在的随意性 。高校发出授权支付的支付令时 ,必须考虑 到整个支付过程对主管部门 、 对财政都是双向透明 、 完整记 录的 ,因而也不敢随意使用资金 。这些都大大加快了资金支 付的效率和速度 ,促进了支付过程的规范化管理 , 方便了最

( 11) ( 12) ( 13)

Δ D ( k + 1) = D ( k + 1 ) - D ( k ) ( 三) 改进算法描述

( 1) 选用合适的小波 ; ( 2) 始化参数 θ, L = 0 , Eol d (θ ) = 0;

( 3) 计算网络输出的误差和 E (θ ) 。如果 E (θ ) ≤ ε, 则网络训练成功 , 结束 ; 否则 , 如果| Eol d (θ ) - E (θ )|

ρ(ρ为误差域值 ,ρ≥ ≤ 0) , 则 L = L + 1 ; 否则 , L = 0 ; ( 4) 如果 L > p ( p ∈Z) , 则表明网络正逼近一极值点 , 转向第 ( 9 ) 步 , 使用 DFP 变尺度算法加速网络的 收敛 ;

( 5) Eol d (θ ) = E (θ ); ( 6) 计算 E (θ ) 的梯度 : ) 5 E (θ = 5 wi ) 5 E (θ = 5 ai ) 5 E (θ = 5 ai t k - bi 其中 : x k = ; ai ( 7) 利用式 ( 7 ) 更新 θ; ( 8) 返回第 ( 3 ) 步 ; ( 9) 利用式 ( 9 ) 更新 θ, 计算 E (θ ) , 迭代直到 E (θ ) ≤

( 6) 判断 E (θ ) < Emax ( 误差最大值) 或达到最大训练步数 , 则停止训练 ; 否则 , 令 E = 0 , 返回第 ( 3) 步 。

由于小波神经网络是一前向网络 , 因此基于 B P 算法的学习算法一般都适用于小波神经网络 , 如动量 法、 梯度法 , 人们采用最多的是各种梯度算法 。但无论哪种梯度法 , 其最大的问题是开始下降快 , 到后来收 敛速度越来越慢 , 甚至达到无法忍受的地步 , 为此本文在迭代初期采用负梯度下降法 , 当接近最优时采用 DFP 变尺度算法加快收敛速度 。 四、 与 DFP 变尺度法相结合的权值修正算法 ( 一) 梯度算法 误差寻优初期 ,θ按照负梯度下降方向修正的公式表示 θ( k + 1) = θ( k ) - λ

) = E (θ

1 2 [ g ( t) - f ( t) ] 2

( 6)

图1 小波神经网络结构

一般通过对式 ( 6) 进行最小化得到网络各参数 , 则学习算法步骤如下 :

( 1) 选用合适的小波 ; ( 2) 初始化参数 θ; ( 3) 计算 E (θ ) 的梯度 ; ( 4) 调整参数 θ; ( 5) 计算误差和 E (θ );

参考文献 :

[ 1 ] Zhang Q H ,Benveniste A. Wavelet networks[J ] . IEEE Transactions on Neural Networks ,1992 ,3( 6) :889 - 898. [2 ] 肖柳青 ,周石鹏 . 实用最优化方法 [ M ] . 上海 : 上海交通大学出版社 ,2000. [3 ] 陈开周 . 最优化计算方法 [ M ] . 西安 : 西安电子科大出版社 ,1987. [4 ] 万建 ,徐德民 ,等 . 一种小波神经网络结构及学习算法研究 [J ] . 系统工程与电子技术 ,2002 ,24 ( 3) :35 - 38. [5 ] 孙小点 ,任雪梅 ,等 . 连续小波神经网络优化结构研究 [J ] . 系统仿真学报 ,2001 ,13 ( 8) :26 - 28.

就有

n

g ( t) =

k =1

∑w ψ(

k

t - b 对于具有 m 个输入的多输入网络 , 式 ( 4) 变为

m n

g ( t) =

k =1

∑

ψ wk

i =1

∑u

ki t i

( i ) ( i ) - bk ak

( 5)

其中 , u ki 表示第 k 个输入样本对的第 i 个元素的权值 。 三、 小波神经网络的学习算法 图 1 所示的网络结构表示小波神经网络有一个输入 层、 一个隐层和一个输出层 。其中 w 1 , w 2 , …, w N 为权 系数 。用 θ表示式 ( 4) 中的所有参数的集合 , 网络输入为 x ( t ) , 输出为 g ( t ) , 我们的目的是确定网络参数 θ。可 以通过下述误差能量函数对网络参数进行优化 。

图2 小波神经网络的逼近效果

( 下转第 123 页)

© 1994-2007 China Academic Journal Electronic Publishing House. All rights reserved.

第 2 期 冯 瑛 : 高校国库集中收付制度改革初探 地保障了财政资金支付的安全和高效 。

第 2 期 王鸿斌 ,陈惠明等 : 一种小波神经网络的优化算法

41

ρ∈ ψ

∑ < ρ, f

>|

2

2 ψa , b ( t ) , 于是 ≤B ‖f ‖ , 这表明使框架 ψa , b ( t ) 中元素的所有线性组合的集合属于 g ( t ) ∈

收稿日期 :2006 - 01 - 05 基金项目 :本课题为山西省自然科学基金资助项目 ( 编号 20051038) 作者简介 :王鸿斌 ( 1972 - ) , 男 , 山西河曲人 , 忻州师范学院计算机系讲师 , 太原理工大学在读硕士研究生 , 从事神经网络 及多用户检测的研究 。

© 1994-2007 China Academic Journal Electronic Publishing House. All rights reserved.

On Ref orm of Collective Receiving and Paying System of National Treasury in Universities and Colleges

N N k =1

[ g( t ) ∑

k k

ψ( x k ) - f ( t k) ] ・ 5 xk 5 at 5 xk 5 bt

k =1 N

[ g( t ∑ [ g( t ∑

( x k) ・ - f ( t k ) ) ] ・w ψ i ′ ( x k) ・ - f ( t k ) ) ] ・w ψ i ′

k

k =1

ε结束 。 五、 结论 πx + sin ( 16 πx ) , x ∈ 利用非线性函数 f ( x ) = sin8 [0 , 013 ] 作为被逼近函数 , 采用 Morlet 小波 , 使用结合 DFP 变尺度算法训练网络 , 通过计算机仿真 , 结果如图 2 所示 。由此可见 , 结合 DFP 变尺度算法的小波神经网络 比一般的小波神经网络具有较好的函数逼近能力 , 避免 了一般神经网络对劣质点计算所浪费的大量时间 , 使得 网络的训练速度明显提高 。 ( 责编 : 贺 霞)

∫ h ( t) d t

- ∞

+∞

( 1)

这使得小波具有有限能量

∫

| ψ( w ) | 2 dw < ∞ | w |

( 2)

其中 ,ψ( w ) 表示 h ( t ) 的傅里叶变换 。则以函数ψ( w ) ∈L 2 ( R ) 1 为母小波 , 采用不同的平移和伸缩因子 , 可 生成一维小波函数系 。 ψa , b ( t ) = 1 ψ( t - b) , ( a , b ∈ R 2 ) ( 3)

© 1994-2007 China Academic Journal Electronic Publishing House. All rights reserved.

忻 州 师 范 学 院 学 报 第 22 卷 42

改革以来 ,各高校都认真按照用款计划申请使用财政资金 , 资金使用的计划性 、 科学性和规范性得到加强 。同时 , 预算 单位通过使用财政管理信息系统 ,在数据收入 、 财务处理 、 数 据上报等方面更为快捷 、 便利 ,高校支出管理也更为细致 ,管 理水平也有新的提高 。

( 责编 : 史 颖)

Vol. 22 No. 2 第 22 卷 第2期 忻 州 师 范 学 院 学 报 Apr. 2006 2006 年 4 月 J OU RNAL OF XINZHOU TEACHERS UN IV ERSIT Y