网络虚拟化-正在进行的网络变革

网络虚拟化与网络功能虚拟化(NFV)技术在网络架构中的应用(九)

网络虚拟化与网络功能虚拟化(NFV)技术在网络架构中的应用近年来,随着云计算和大数据的快速发展,网络架构迎来了重要的变革。

网络虚拟化和网络功能虚拟化(NFV)技术作为这一变革的核心,已经逐渐成为网络架构中的重要组成部分。

本文将探讨网络虚拟化与NFV技术的定义、发展历程以及在网络架构中的应用。

1. 概述随着互联网的普及,网络流量急剧增长,传统的网络架构已经无法满足高性能和高灵活性的需求。

因此,网络虚拟化和NFV技术应运而生。

网络虚拟化是将物理网络划分为多个逻辑网络的技术,其目的是提供更好的资源利用率和灵活性。

而NFV技术则是通过将网络功能转化为软件的形式,实现传统网络设备的虚拟化,从而提升网络部署、维护和管理的效率。

2. 网络虚拟化的发展历程网络虚拟化的发展经历了多个阶段。

早期,物理网络通过分割子网来实现逻辑上的隔离。

随着技术的进步,虚拟局域网(VLAN)成为了一种常见的划分网络的方式。

然而,VLAN的划分仍然受制于物理设备的限制,无法实现真正的资源共享和弹性调配。

随着虚拟化技术的兴起,基于虚拟机的网络虚拟化技术逐渐成为主流。

通过在物理主机上创建多个虚拟机,每个虚拟机可以拥有独立的网络设置,实现了网络资源的隔离和共享。

此外,虚拟机的创建、启动和销毁也变得更加简单和灵活。

3. NFV技术的应用NFV技术的应用范围十分广泛,以下将分别从企业网络和电信网络的角度来探讨其在网络架构中的应用。

首先,对于企业网络来说,传统的网络设备(如路由器和防火墙)通常需要独立部署,且难以实现动态调整和管理。

而采用NFV技术,可以将这些网络功能转化为虚拟设备,统一部署在云端,从而实现了网络功能的弹性调整和集中管理。

此外,通过NFV技术,企业可以实现网络服务的快速部署和灵活扩展,大大提升了网络的可用性和灵活性。

其次,对于电信网络而言,NFV技术的应用同样具有重要意义。

传统的电信网络通常需要大量的专用设备来支持各种网络功能,部署和维护成本较高。

新一代数据中心解决方案的4大优势

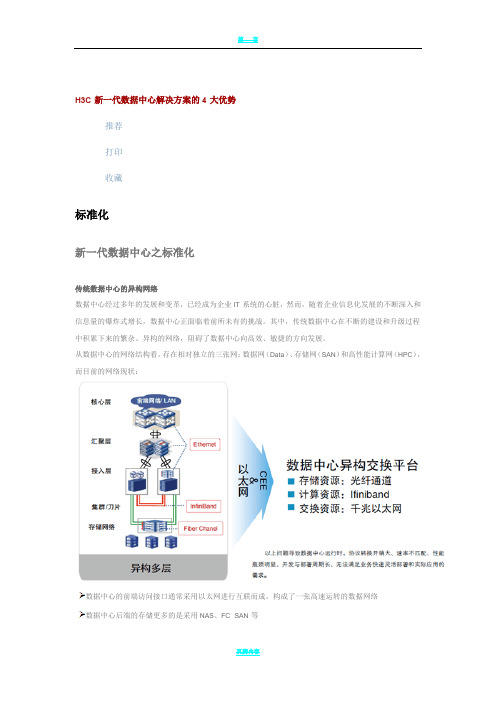

H3C新一代数据中心解决方案的4大优势推荐打印收藏标准化新一代数据中心之标准化传统数据中心的异构网络数据中心经过多年的发展和变革,已经成为企业IT系统的心脏,然而,随着企业信息化发展的不断深入和信息量的爆炸式增长,数据中心正面临着前所未有的挑战。

其中,传统数据中心在不断的建设和升级过程中积累下来的繁杂、异构的网络,阻碍了数据中心向高效、敏捷的方向发展。

从数据中心的网络结构看,存在相对独立的三张网:数据网(Data)、存储网(SAN)和高性能计算网(HPC),而目前的网络现状:数据中心的前端访问接口通常采用以太网进行互联而成,构成了一张高速运转的数据网络数据中心后端的存储更多的是采用NAS、FC SAN等服务器的并行计算则大多采用Infiniband和以太网不同的服务器之间存在操作系统和上层软件异构、接口与数据格式不统一以上问题导致数据中心运行时,协议转换开销大、速率不匹配、性能瓶颈明显、开发与部署周期长、无法满足业务快速灵活部署和实际应用的需求。

标准化之统一交换架构为了便于未来的业务整合和服务提供、简化管理、降低建设成本和运营维护成本,为了解决传统数据中心异构网络带来的种种问题,数据中心的建设应尽量避免异构系统的存在,用一个统一的标准来规划完整的数据中心网络体系。

在业务网络,以太网随着技术的变革一直在向前不断的发展,以满足不断变化的行业和市场的需求。

自1983年以太网开始大规模普及开始,到1995年的以太网网卡被大多数PC所采用,再到快速以太网(100 Mbps ),千兆以太网( 1000 Mbps )以及今天的万兆以太网,和即将推出的40 Gbps和100 Gbps以太网标准。

其经历了从终端到局域网、从局域网到广域网、从广域网到城域网的变革,可以说以太网正凭借其强大的生命力得到了空前的发展和壮大。

在存储领域,自IP存储自诞生以来快速发展,万兆存储更将存储发展带入新纪元。

在超级计算和高性能计算领域,08年6月发布的世界TOP500超级计算机排名显示,285个站点采用以太网连接,占据57%的份额。

FusionCompute网络虚拟化产品介绍

⚫ 管理员可以通过系统Portal,基于虚拟交换机端口组对象,配置报文抑制开关和报 文抑制带宽阈值。

第18页

网络安全策略 - 安全组

⚫ 基于vhost-user技术,vhost在用 户态直接和EVS交互,通过地址偏 移获取DPDK大页地址,性能提升 30%-40%。

⚫ 利用批处理和轮询机制提升报文处 理能力。

⚫ 后续会通过ivshm技术以共享内存 与VM通信,进一步提升性能。

华为分布式交换方案

DVSM

第9页

Virtual Switch Agent

上行链路

分布式虚拟交换机

端口组

端口组

vlan100

vlan200

上行链路

物理网卡

物理网卡

端口组 vlan300

第10页

虚拟交换模型

Mgnt

ISCSI

System Interface

System Interface

Uplink Port Aggr

Uplink Port Aggr

eth0 eth1

eth2 eth3

思考题

1. 在FusionCompute分布式交换机里,虚拟机与外部网络通信依靠的是什么端口?(

)

A. Mgnt

B. 存储接口

C. 上行链路

D. 端口组

2. FusionCompute分布式交换机支持哪几种类型?( )

A. 普通模式

B. SR-IOV直通模式

C. 用户态交换模式

D. 标准模式

VMware NSX网络虚拟化概览

VMware NSX网络虚拟化概览目录序言 (2)1. VMware NSX网络虚拟化解决方案简介 (2)1.1 VMware服务器虚拟化的前世今生 (2)1.2 服务器虚拟化的优势移植到了网络虚拟化 (8)1.3 NSX解决方案概览 (10)1.4 NSX网络虚拟化应用场景 (14)2.当前主流的Overlay隧道技术 (16)2.1 VXLAN技术 (16)2.2 NVGRE技术 (18)2.3 STT技术 (18)2.4 三种Overlay技术的对比和应用场景 (19)2.5 下一代Overlay技术——Geneve (20)3.各厂商的网络虚拟化解决方案 (22)3.1 Cisco ACI解决方案 (22)3.2 在MicrosoftHyper-V中实现网络虚拟化 (24)3.3 JuniperContrail解决方案 (25)3.4 各厂商网络虚拟化解决方案的比较 (26)4.与VMwareNSX相关的认证 (28)4.1 VMware认证体系简介 (28)4.2 与NSX相关的VMware认证与考试 (30)总结 (31)序言网络虚拟化技术诞生后,有不少厂商都推出了所谓的网络虚拟化解决方案。

这些厂商实现“网络虚拟化”的方式各异,有些是自己研发的项目,有些是通过收购,有些是利用开源项目进行再开发。

而VMware NSX网络虚拟化平台的基本架构到底是怎样的,它与别的厂家有哪些不同?这些问题会在本章进行探讨。

1. VMware NSX网络虚拟化解决方案简介尽管VMware NSX网络虚拟化平台是通过收购Nicira而获得的,但是在收购一年多时间之后,NSX才正式发布。

在这一年多时间里,VMware的研发人员与前Nicira的极客们一起通力合作,将VMware服务器虚拟化平台与Nicira网络虚拟化平台进行了融合,我们现在会发现NSX架构和技术细节(尤其是用于vSphere平台的NSX-V),其实与早期的Nicira NVP平台还是有很大区别,它增加了很多VMware的基因在里面。

数据中心网络三大热门技术

数据中心网络三大热门技术这几年,云计算、大数据、虚拟化等新技术让人看得眼花缭乱,所有这些技术都要依托数据中心为基础来得以实现。

俗话说“经济基础决定上层建筑”,数据中心网络是实现这些功能的基础,这些迫使网络技术要进行变革,否则根本无法适应这些新东西,所以数据中心网络技术这几年也得到了迅速发展,各种新技术不断涌现,数据中心里最后的一块封锁基地终于得以开垦,这给数据中心带来了活力。

任何技术的进步都不是一撮而就的,需要经过各种磨练,还会有不同的声音,也会有不少的技术会不断消失,本文就来具体说一说数据中心网络涌现了哪些新技术。

虚拟交换技术虚拟交换技术是指允许在同一台物理设备上执行多种交换功能,或在网络中的多台物理设备上执行单功能交换,虚拟交换技术是多服务网络交换结构中的核心概念。

虚拟交换技术的实质是通过服务器来实现网络交换的部分功能,以此用服务器替代网络交换机的部分网络功能。

这样不仅可以简化网络,还可以降低网络建设的成本,可以将交换机的部分功能下移到服务器上,这种技术也是服务器厂商主推的技术,服务器厂商也是希望通过此技术来获得部分的网络市场,得以进入网络市场。

不过虚拟交换技术还是一个全新的领域,很多服务器厂商都有各的想法,难以形成统一的技术标准。

CISCO和VMware向IETF提交了虚拟交换技术草案VN-Link,CISCO是传统的网络硬件厂商,而VMware是虚拟化软件厂商,所以两者的结合也都各有自己的小算盘,所以这次的草案还是提出了两种解决方案,一种是通过软件实现,而另一种就是通过硬件网卡来实现,CISCO甚至还自己提出了基于硬件的虚拟交换方案。

要知道CISCO也是全球第五大服务器厂商,在服务器领域也很有实力。

CISCO提出了802.1qbb BPE和802.1BR,还有别的服务器厂商也提出了自己的虚拟交换技术,比如;802.1Qbg EVB、EVBA等,服务器厂商毕竟不是专做网络设备的,所以这些虚拟交换技术并未得到更多的响应,尤其是得到了网络厂商的积极反击,这样使得虚拟交换技术成为了实验室技术,至今未能大规模地走进数据中心,虽然绝大部分服务器都支持虚拟交换技术,但并未得到大规模的应用。

网络虚拟化技术的演进与应用

网络虚拟化技术的演进与应用随着信息技术的快速发展和互联网的普及应用,网络技术也不断创新和演进。

网络虚拟化技术作为一种重要的网络技术手段,不仅影响了网络架构的设计和实现,而且对于实际应用具有重要的意义。

一、网络虚拟化技术的定义和历史演进网络虚拟化指的是将一个物理网络分割成多个逻辑上相互隔离的虚拟网络。

它的目的是提供更好的资源利用和网络服务管理,以满足不同用户的需求。

网络虚拟化技术最早起源于计算机虚拟化技术,随着云计算和软件定义网络等概念的兴起,网络虚拟化技术逐渐走向了成熟。

1.1 虚拟局域网(VLAN)1998年,虚拟局域网(VLAN)技术首次提出并得到了广泛应用。

VLAN将一个局域网分隔成多个逻辑上独立的虚拟局域网,不同的虚拟局域网可以根据需要设置不同的网络策略和访问控制。

1.2 虚拟专用网络(VPN)2000年,虚拟专用网络(VPN)技术开始兴起。

VPN通过在公共网络上建立加密隧道,实现对私有网络的访问,提供了更加安全和灵活的远程访问方式。

VPN技术在企业网络中得到广泛应用,提高了网络的可靠性和安全性。

1.3 软件定义网络(SDN)2011年,软件定义网络(SDN)的概念被提出,引起了广泛的关注。

SDN通过将网络控制平面与数据平面分离,使得网络管理人员可以通过集中式的控制器对网络进行管理和配置。

SDN技术的出现极大地简化了网络管理的复杂性,提高了网络的可扩展性和灵活性。

1.4 网络功能虚拟化(NFV)2012年,网络功能虚拟化(NFV)的概念开始提出。

NFV将原本以硬件设备形式存在的网络功能(如防火墙、负载均衡器等)通过软件的方式虚拟化部署在通用服务器上,实现了硬件与功能的分离,提高了网络功能的灵活性和可扩展性。

二、网络虚拟化技术的应用领域网络虚拟化技术在各个领域都得到了广泛应用,特别是在云计算、数据中心和移动网络等方面。

2.1 云计算云计算是现在越来越流行的一种计算模式,而网络虚拟化技术是云计算的重要支撑之一。

VMware NSX网络虚拟化 - NSX电子书-让微分段为您所用·客户案例分享

IlliniCloud 选择了由 VMware 提供支持、以 VMware NSX 为基础构建的软件定义的数据中心。

性,帮助 IlliniCloud 节约了资金。 此外,它还可以使 IlliniCloud 推迟投入硬件资金的时间,因为 VMware NSX 可以在现有的基础架构内使用。

助微分段,FireHost 可以针对租户工作负载调配网络和安

全服务及策略(包括第 2 层和第 3 层的分段和防火墙),

5

提升敏捷性

由于 VMware NSX 以软件形式运作,因此能够更快交付网络和安全服务。

6

JOIN Experience 构建了软件定义的

基础架构,以抢占未来市场

“ JOIN Experience 是一家移动通信市场

网络虚拟化使微分段成为可能

VMware® NSX™ 是适用于软件定义的数据中心的网络虚拟 化平台,可创建独立于底层 IP 网络硬件的虚拟网络。 IT 可以将物理网络视为一个容量传输池。

“网络 hypervisor”与服务器虚拟化模式极为类似,它采 用软件方式重现了第 2 至第 7 层的网络连接服务。 这些服 务可在几秒内组建为任意组合,以生成新的网络配置。 您 能够以编程方式对复杂网络执行创建、调配、拍摄快照、 删除和还原操作。

2

改善安全性

VMware NSX 的微分段可帮助阻止恶意软件在数据中心内扩散。 这也能有效阻止其 扩散到端点。

3

Synergent 改善托管金融服务应用的安全性

三大网络厂商网络虚拟化技术【Cisco-VSS、H3C-IRF2、huawei-CSS】解析

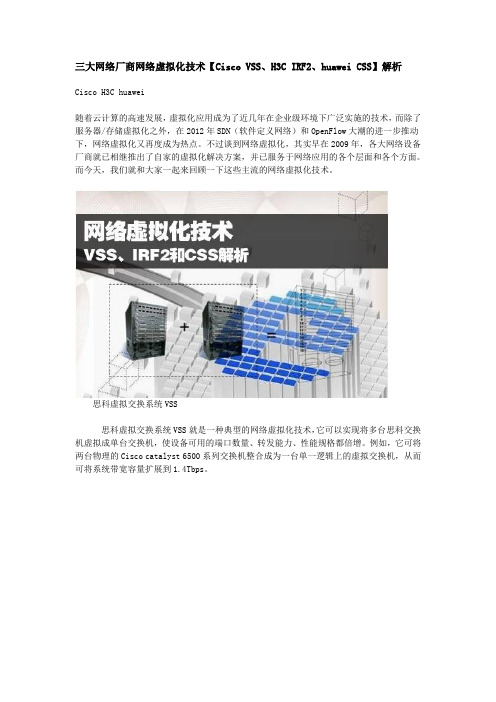

三大网络厂商网络虚拟化技术【Cisco VSS、H3C IRF2、huawei CSS】解析Cisco H3C huawei随着云计算的高速发展,虚拟化应用成为了近几年在企业级环境下广泛实施的技术,而除了服务器/存储虚拟化之外,在2012年SDN(软件定义网络)和OpenFlow大潮的进一步推动下,网络虚拟化又再度成为热点。

不过谈到网络虚拟化,其实早在2009年,各大网络设备厂商就已相继推出了自家的虚拟化解决方案,并已服务于网络应用的各个层面和各个方面。

而今天,我们就和大家一起来回顾一下这些主流的网络虚拟化技术。

思科虚拟交换系统VSS思科虚拟交换系统VSS就是一种典型的网络虚拟化技术,它可以实现将多台思科交换机虚拟成单台交换机,使设备可用的端口数量、转发能力、性能规格都倍增。

例如,它可将两台物理的Cisco catalyst 6500系列交换机整合成为一台单一逻辑上的虚拟交换机,从而可将系统带宽容量扩展到1.4Tbps。

思科虚拟交换系统VSS而想要启用VSS技术,还需要通过一条特殊的链路来绑定两个机架成为一个虚拟的交换系统,这个特殊的链路称之为虚拟交换机链路(Virtual Switch Link,即VSL)。

VSL承载特殊的控制信息并使用一个头部封装每个数据帧穿过这条链路。

虚拟交换机链路VSL在VSS之中,其中一个机箱指定为活跃交换机,另一台被指定为备份交换机。

而所有的控制层面的功能,包括管理(SNMP,Telnet,SSH等),二层协议(BPDU,PDUs,LACP等),三层协议(路由协议等),以及软件数据等,都是由活跃交换机的引擎进行管理。

此外,VSS技术还使用机箱间NSF/SSO作为两台机箱间的主要高可用性机制,当一个虚拟交换机成员发生故障时,网络中无需进行协议重收敛,接入层或核心层交换机将继续转发流量,因为它们只会检测出EtherChannel捆绑中有一个链路故障。

而在传统模式中,一台交换机发生故障就会导致STP/HSRP和路由协议等多个控制协议进行收敛,相比之下,VSS 将多台设备虚拟化成一台设备,协议需要计算量则大为减少。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

网络虚拟化-正在进行的网络变革[编者注:这是一篇来自周伦EMC中国研究院云基础构架实验室高级研究员的文章。

]A revolution has started to free data center networks fromthe tyranny of inflexibility, complexity, vendor stranglehold, and high costs.It’s time to decouple network services from the underlyingphysical hardware.It’s time to never have to think about the network again.It’s time to virtualize the network.摘自nicira主页引子接触网络虚拟化纯属偶然。

作为研究院微博五毛小分队的成员,撰出一条微博是每天的任务。

那天无意中抓取了一条新闻:Xsigo公司推出了业界第一个数据中心网络全虚拟化解决方案。

巧的是Xsigo公司的方案是基于Infiniband技术的,而我最近的项目使我对Infiniband略懂,所以就重点关注了一下。

这一关注不要紧,才发现里面水很深。

不管是传统IT豪强还是网络巨人都对这一领域虎视眈眈,谋篇定局,更有无数的创业者们在此展开深耕。

抱着对技术要略懂的心态,我入水一探究竟。

这篇博文算是对我这次涉水的总结,网络虚拟化发展到现在牵涉的技术非常多,每种技术都可以单独写一篇文章来介绍,限于我的精力和知识水平只能给大家做个整体的简单介绍,不足之处还请各位批评指正。

如果读者对某种技术感兴趣可以搜索相关资料做更详细的了解。

什么是网络虚拟化首先我们需要明确一个问题,什么是网络虚拟化,网络虚拟化简单来讲是指把逻辑网络从底层的物理网络分离开来。

这个概念产生的比较久了,VLAN,VPN,VPLS等都可以归为网络虚拟化的技术。

近年来,云计算的浪潮席卷IT界。

几乎所有的IT基础构架都在朝着云的方向发展。

在云计算的发展中,虚拟化技术一直是重要的推动因素。

作为基础构架,服务器和存储的虚拟化已经发展的有声有色,而同作为基础构架的网络却还是一直沿用老的套路。

在这种环境下,网络确实期待一次变革,使之更加符合云计算和互联网发展的需求。

云计算的大环境下,网络虚拟化的定义没有变,但是其包含的内容却大大增加了。

云计算环境下的网络虚拟化需要解决端到端的问题,笔者将其归纳为三个部分:(一)第一部分是服务器内部。

随着越来越多的服务器被虚拟化,网络已经延伸到Hypervi sor内部,网络通信的端已经从以前的服务器变成了运行在服务器中的虚拟机,数据包从虚拟机的虚拟网卡流出,通过Hypervisor内部的虚拟交换机,在经过服务器的物理网卡流出到上联交换机。

在整个过程中,虚拟交换机,网卡的I/O问题以及虚拟机的网络接入都是研究的重点。

(二)第二部分是服务器到网络的连接。

10Gb以太网和Infiniband等技术的发展使一根连接线上承载的带宽越来越高。

为了简化,通过一种连接技术聚合互联网络和存储网络成为了一个趋势。

(三)第三部分是网络交换,需要将物理网络和逻辑网络有效的分离,满足云计算多租户,按需服务的特性,同时具有高度的扩展性。

下面我就围绕这三个方面来讲述网络虚拟化中的一些主要技术和标准。

服务器内部I/O虚拟化多个虚拟机共享服务器中的物理网卡,需要一种机制既能保证I/O的效率,又要保证多个虚拟机对用物理网卡共享使用。

I/O虚拟化的出现就是为了解决这类问题。

I/O虚拟化包括了从CPU到设备的一揽子解决方案。

从CPU的角度看,要解决虚拟机访问物理网卡等I/O设备的性能问题,能做的就是直接支持虚拟机内存到物理网卡的DMA操作。

Intel的VT-d技术及AMD 的IOMMU技术通过D MARemapping机制来解决这个问题。

DMARemapping机制主要解决了两个问题,一方面为每个VM创建了一个DMA保护域并实现了安全的隔离,另一方面提供一种机制是将虚拟机的GuestPhysical Address翻译为物理机的HostPhysical Address。

从虚拟机对网卡等设备访问角度看,传统虚拟化的方案是虚拟机通过Hypervisor来共享的访问一个物理网卡,Hypervisor需要处理多虚拟机对设备的并发访问和隔离等。

这样Hype rvisor容易行成一个性能瓶颈。

为了提高性能,一种做法是虚拟机绕过Hypervisor直接操作物理网卡,这种做法通常称作PCIpass through,VMware,Xen和KVM都支持这种技术。

但这种做法的问题是虚拟机通常需要独占一个PCI插槽,不是一个完整的解决方案,成本较高且扩展性不足。

另一种做法是设备如网卡直接对上层操作系统或Hypervisor提供虚拟化的功能,一个以太网卡可以对上层软件提供多个独立的虚拟的PCIe设备并提供虚拟通道来实现并发的访问。

这种方法也是业界主流的做法和发展方向,目前已经形成了标准,主要包括SR-IOV(SingleRoot IO Virtualization)和MR-IOV(Multi-RootIO Virtualization)。

这方面的技术在网上已有很好的文章来做介绍,推荐想进一步了解的同学读一读:/a K72XS虚拟接入在传统的服务器虚拟化方案中,从虚拟机的虚拟网卡发出的数据包在经过服务器的物理网卡传送到外部网络的上联交换机后,虚拟机的标识信息被屏蔽掉了,上联交换机只能感知从某个服务器的物理网卡流出的所有流量而无法感知服务器内某个虚拟机的流量,这样就不能从传统网络设备层面来保证QoS和安全隔离。

虚拟接入要解决的问题是要把虚拟机的网络流量纳入传统网络交换设备的管理之中,需要对虚拟机的流量做标识。

在解决虚拟接入的问题时,思科和惠普分别提出了自己的解决方案。

思科的是VN-Tag, 惠普的方案是VEPA(Virt ualEthernet Port Aggregator)。

为了制定下一代网络接入的话语权,思科和惠普这两个巨头在各自的方案上都毫不让步,纷纷将自己的方案提交为标准,分别为802.1Qbh和802.1 Qbg。

关于虚拟接入也有一篇很好的文章来介绍,想深入了解的可以看看:/hGW nOQ网络连接网络连接技术一直都在追求更高的带宽中发展。

比如Infiniband和10Gb以太网。

在传统的企业级数据中心IT构架中,服务器到存储网络和互联网络的连接是异构和分开的。

存储网络用光纤,互联网用以太网线(ISCSI虽然能够在IP层上跑SCSI,但是性能与光纤比还是差的很远)。

数据中心连接技术的发展趋势是用一种连接线将数据中心存储网络和互联网络聚合起来,使服务器可以灵活的配置网络端口,简化IT部署。

以太网上的FCOE技术和I nfiniband技术本身都使这种趋势成为可能。

InfinibandInfiniband技术产生于上个世纪末,是由Compaq、惠普、IBM、戴尔、英特尔、微软和Su n七家公司共同研究发展的高速先进的I/O标准。

最初的命名为SystemI/O,1999年10月,正式改名为InfiniBand。

InfiniBand是一种长缆线的连接方式,具有高速、低延迟的传输特性。

基于InfiniBand技术的网卡的单端口带宽可达20Gbps,最初主要用在高性能计算系统中,近年来随着设备成本的下降,Infiniband也逐渐被用到企业数据中心。

为了发挥Infiniband设备的性能,需要一整套的软件栈来驱动和使用,这其中最著名的就是OFED(OpenFabric s Enterprise Distribution) ,它基于Infiniband设备实现了RDMA(remote direct memoryac cess). RDMA的最主要的特点就是零拷贝和旁路操作系统,数据直接在设备和应用程序内存之间传递,这种传递不需要CPU的干预和上下文切换。

OFED还实现了一系列的其它软件栈:IPoIB(IP over Infiniband), SRP(SCSI RDMA Protocol)等,这就为Infiniband聚合存储网络和互联网络提供了基础。

OFED由OpenFabrics联盟负责开发。

OpenFabrics最初叫做OpenIB,从2006年开始OpenIB在Infiniband之外也开始支持以太网,业务做的大了名字也从OpenIB改为OpenFabrics。

OFED现已经被主流的Linux发行版本支持,并被整合到微软的windowsserver中。

图1 OFED 软件栈FCOE就在大家认为Infiniband就是数据中心连接技术的未来时,10Gb以太网的出现让人看到了其它选择,以太网的发展好像从来未有上限,目前它的性能已经接近Infiniband(详见http: ///en/US/prod/collateral/ps10265/le_32804_pb_hpc10ge.pdf),而从现有网络逐渐升级到10Gb以太网也更易为用户所接受。

FCOE的出现则为数据中心互联网络和存储网络的聚合提供了另一种可能。

FCOE是将光纤信道直接映射到以太网线上,这样光纤信道就成了以太网线上除了互联网网络协议之外的另一种网络协议。

FCOE能够很容易的和传统光纤网络上运行的软件和管理工具相整合,因而能够代替光纤连接存储网络。

虽然出现的晚,但FCOE发展极其迅猛。

与Infiniband技术需要采用全新的链路相比,企业IT们更愿意升级已有的以太网。

在两者性能接近的情况下,采用FCOE方案似乎性价比更高。

网络交换在这一层面上要解决的问题则是要对现有的互联网络进行升级,使之满足新业务的需求,网络虚拟化则是这一变革的重要方向。

在这一方向上目前有两种做法,一种是在原有的基础设施上添加新的协议来解决新的问题;另一种则完全推倒重来,希望设计出一种新的网络交换模型。

当虚拟数据中心开始普及后,虚拟数据中心本身的一些特性带来对网络新的需求。

物理机的位置一般是相对固定的,虚拟化方案的一个很大的特性在于虚拟机可以迁移。

当虚拟机的迁移发生在不同网络,不同数据中心之间时,对网络产生了新的要求,比如需要保证虚拟机的IP在迁移前后不发生改变,需要保证虚拟机内运行在第二层(链路层)的应用程序也在迁移后仍可以跨越网络和数据中心进行通信等等。

在这方面,Cisco连续推出了OTV,LISP 和VXLAN等一系列解决方案。

OTVOTV的全称叫做OverlayTransport Virtualization。

通过扩展链路层网络,它可以使局域网跨越数据中心。

很多应用需要使用广播和本地链路多播。