深入剖析Vplex双活数据中心存储方案

vplexvnx方案

vplexvnx方案第1章IT建设方案说明1.1服务器部分说明数据库服务器采用两台X3850X5服务器,通过ROSEHA实现高可用双机环境。

应用服务器采用3台X3650M4服务器。

1.2存储部分说明新购VNX5100存储,建立统一存储资源环境,用于集中存放核心数据库数据。

采用两台24口交换机(激活16口)构建SAN网络,数据库服务器通过SAN 网络访问VNX5100磁盘阵列,提供高速,安全,稳定的链路环境。

1.3存储高可用说明配置VPLEX存储虚拟化引擎,建立数据中心内部存储高可用架构平台,消除磁盘阵列的单点故障,保证核心数据库业务连续性要求,当出现硬件故障时,无需人为参与切换,高可用平台自动进行调整保证核心业务不会中断。

并且提供动态资源调度,能够灵活的进行管理,提高整体应用平台的弹性。

第2章IT存储系统详细设计2.1存储基础架构图2.2核心存储设计针对客户的需求,推荐使用一台EMC VNX系列统一存储产品作为数据库的核心存储。

VNX是EMC新一代的中端存储产品,它将Celerra (NS) 和 CLARiiON (CX4) 统一到单个产品品牌中,将 Celerra 和 CLARiiON 的所有价值推广到VNX 系列的客户。

它面向要求高级功能、灵活性和可配置性的中端和企业存储环境。

VNX 系列在效率、简洁性和性能上有巨大的进步。

VNX 建议配置如下:VNX5100磁盘阵列:双SAN控制器,8G高速缓存,4个8Gb FC前端口,配置4个6Gb四通道SAS磁盘接口,14块 600GB 15000转SAS硬盘。

配置图形化管理软件Unisphere。

配置说明:使用了600GB 15000转的SAS盘(核心数据库数据),同样类型硬盘做RAID5数据保护,并且配置了hot spare热备盘,提升磁盘阵列的可靠性和安全性;配置容量足以支持客户现有业务发展和数据增长;同时通过8Gb/s FC光纤链路将磁盘阵列两个控制器的FC主机端口分别与两台FC光纤交换机相连,实现磁盘阵列的链路冗余和负载均衡;通过基于WEB的阵列管理软件Unisphere可以在单一WEB管理界面实现存储管理和监控,操作简单易懂。

EMCVPLEX数据中心虚拟化方案

02

方案设计

根据需求分析结果,设计符合客户需 求的虚拟化方案,包括资源分配、网 络设计、安全策略等。

01

03

安装部署

根据设计方案进行虚拟化软件的安装 和硬件资源的配置。

上线运行

将虚拟化系统正式投入使用,并进行 长期的监控和维护。

05

04

系统调试

对安装好的虚拟化系统进行调试,确 保系统的稳定性和性能。

实施效果

通过虚拟化方案的实施,该企业的数据中心性能得到了显著提升,同时降低了运营成本, 提高了服务质量和可靠性。容灾备份方案的实施也确保了数据的安全性和业务的连续性。

06

EMC Vplex未来展望与 总结

Vplex未来发展趋势

扩展性

Vplex继续提供更高的可扩展性,以满足不 断增长的数据需求。

安全

04

EMC Vplex解决方案详 解

Vplex数据中心架构

架构概述:Vplex数据中心架构是一种高 度可扩展的虚拟化平台,旨在提高数据 中心的效率、灵活性和可用性。

多租户支持:Vplex支持多租户隔离,为 不同业务部门提供独立的资源池。

分布式架构:Vplex采用分布式架构,可 扩展至数千个节点,满足大型企业的需 求。

02

数据中心虚拟化概述

什么是数据中心虚拟化?

数据中心虚拟化是一种将物理服务器和基础设施资源抽象成逻辑资源的技术,它 允许在一个物理服务器上运行多个虚拟机,每个虚拟机都有自己的操作系统和应 用程序。

数据中心虚拟化通过软件定义的网络和存储技术,将网络和存储资源划分为可动 态分配的虚拟机,从而提高了服务器的利用率,简化了管理流程,并降低了运营 成本。

纵向扩展:Vplex支持 纵向扩展,通过升级硬 件设备提高单节点的性 能和容量。

EMC VPLEX

用VPLEX构建双活数据中心概要

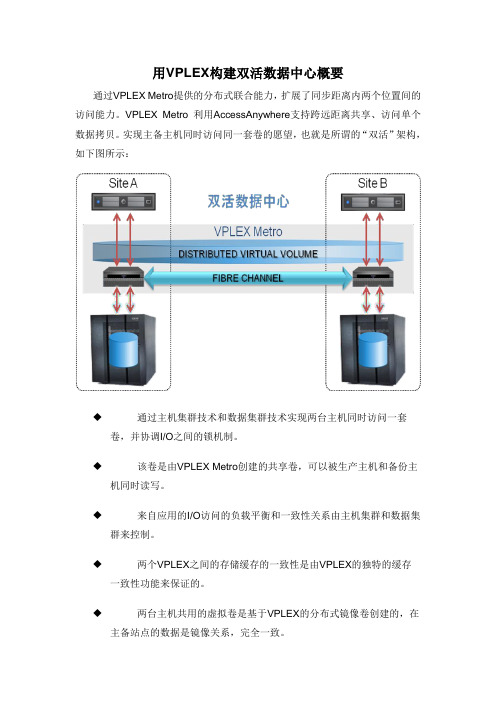

通过VPLEX Metro提供的分布式联合能力,扩展了同步距离内两个位置间的访问能力。

VPLEX Metro 利用AccessAnywhere支持跨远距离共享、访问单个数据拷贝。

实现主备主机同时访问同一套卷的愿望,也就是所谓的“双活”架构,如下图所示:

◆通过主机集群技术和数据集群技术实现两台主机同时访问一套

卷,并协调I/O之间的锁机制。

◆该卷是由VPLEX Metro创建的共享卷,可以被生产主机和备份主

机同时读写。

◆来自应用的I/O访问的负载平衡和一致性关系由主机集群和数据集

群来控制。

◆两个VPLEX之间的存储缓存的一致性是由VPLEX的独特的缓存

一致性功能来保证的。

◆两台主机共用的虚拟卷是基于VPLEX的分布式镜像卷创建的,在

主备站点的数据是镜像关系,完全一致。

在生产主机正常进行读写的同时,备份主机可以接受只读I/O请求,而且从备份主机读出来的数据是实时更新的生产数据。

存储双活方案

存储双活方案1. 背景介绍随着企业和组织对数据的高可用性和容灾性需求增加,存储双活方案逐渐成为一种常见的解决方案。

存储双活方案可以有效地消除单点故障,提供数据的高可用性和业务的连续性。

在本文档中,我们将介绍存储双活方案的概念、原理和常见实现方式。

2. 存储双活方案的概念存储双活方案是一种通过在不同地理位置部署两个或多个存储系统,并通过数据同步和数据复制实现数据的高可用性和容灾性的技术方案。

它可以消除单点故障,并提供数据的实时备份和异地容灾能力,确保业务连续性。

3. 存储双活方案的原理存储双活方案的原理基于数据的同步和复制。

一般来说,存储双活方案包括两个主要组件:活动数据中心和备份数据中心。

活动数据中心负责处理业务请求,并将数据同步到备份数据中心。

备份数据中心则用于备份数据,并在主数据中心故障时接管业务请求。

在存储双活方案中,数据同步是实现数据一致性的关键。

常见的数据同步方式包括同步复制和异步复制。

同步复制是指在数据写入前必须同步到备份数据中心,确保数据的实时一致性。

而异步复制则是数据写入后异步地进行复制,可能会存在一定的数据延迟,但具有更高的性能和容错能力。

4. 存储双活方案的实现方式存储双活方案可以通过不同的技术和架构来实现。

下面介绍几种常见的实现方式:4.1 数据镜像数据镜像是一种常见的存储双活方案实现方式,它通过将活动数据中心的数据实时镜像到备份数据中心,确保数据的高可用性和容灾性。

数据镜像可以通过同步复制或异步复制实现,具体的实现方式可以根据需求和系统的特点进行选择。

4.2 数据切换数据切换是另一种常见的存储双活方案实现方式,它通过将业务请求从活动数据中心切换到备份数据中心,实现业务的连续性。

数据切换可以通过手动切换或自动切换来实现,自动切换通常依赖于监控系统和故障检测机制。

4.3 故障转移故障转移是存储双活方案的一种重要组成部分,它是指在主数据中心故障时自动切换到备份数据中心,以确保业务的连续性。

联想VPLEX双活数据中心解决方案

2015 Lenovo Internal. All rights reserved.

9

通过跨不同位置进行镜像,保持可用 性和无中断访问 高可用性 消除因故障切换 所进行的存储操作

实现跨不同位置对数据的 并发读/写访问 跨远距离 即时和同时访问数据 简化工作流

数据中心迁移

工作负载重新平衡

4个前端8 Gb/s FC端口/Director Engine

6

VPLEX:为客户带来绝佳的业务收益

2015 Lenovo Internal. All rights reserved.

7

成功案例:联宝电子私有云、双活数据中心项目

用户痛点:

1. 2. 3. 4. 7*24小时候不间断工厂,不允许业务中断、数据丢失; 核心MES和SAS ERP系统的存储系统,存在单点故障; 随着工厂产能提高,数据库压力增大,原存储性能不够; 原存储管理复杂,几乎无法监控;

Core Core Core Core

Core Core Core Core

Core Core Core Core

Core Core Core Core

Distributed Cache

Inter-Cluster COM Intra-Cluster COM

Distributed Cache

Inter-Cluster COM Intra-Cluster COM

VPLEX Geo

跨数据中心

同步(5-10ms)

异步(50ms)

VPLEX Local

数据中心内

RecoverPoint

异地恢复与第三方站点保护

延伸

2015 Lenovo Internal. All rights reserved.

vplex 运维及异构存储双活使用实例技术手册

vplex 运维及异构存储双活使用

实例技术手册

Vplex 运维及异构存储双活使用实例技术手册是一份详细介绍 Vplex

集群组件、硬件架构、存储卷、双活技术和逻辑封装流程等内容的文档。

以下是该手册的核心内容:

1. Vplex 集群组件和硬件架构:Vplex 集群组件都会预安装在DellEMC 机架上,其硬件架构的高可用性体现在以下的方面:

引擎:每个引擎都包含两个独立的控制器。

I/O 模块:每个控制器安装了四个 FC I/O 模块,分为两个前

端模块(连接主机)和两个后端模块(连接存储);另外还有两个

I/O 扩展模块,用于控制器间的数据路径和通信。

备用电源:每个引擎由一个 SPS 提供后备电源,在电源故障时

允许进行写缓存,防止数据丢失。

SAN 交换机:配置了两个 SAN 交换机用于集群内部控制器之间

的连接。

UPS:配备了 UPS 以避免短暂断电带来的业务停顿风险。

2. 存储卷:Vplex 的存储卷是通过 claim 存储阵列中的 LUN 生成的。

每个存储卷都可以被映射到一个或多个虚拟卷,只有虚拟卷才可以被

给前端主机访问。

其中有一种 Distributed 的方式,它是由不同集群的 Device 组成的。

3. 双活技术:Vplex 双活技术可以实现在多个站点间同时读写数据,以提高系统的可用性和性能。

同时,它还可以实现容灾和恢复功能,确保数据的完整性和可靠性。

4. 逻辑封装流程:在 VPLEX 存储纳管之后,还需要按照特定的逻辑封装流程来完成。

其中包括创建 extent、创建 device 和创建virtual volume 等步骤。

EMC vplex Isilon DD存储备份双活系统实施方案

2016年3月目录1.项目实施内容 (5)1.1存储系统架构示意图 (6)1.3本项目设备硬件配置 (6)2.存储系统实施基础配置 (7)2.1双活数据中心存储实现模式 (7)2.2光纤通道交换机端口连接表 (8)2.3VPLEX端口作用描述 (9)2.4VPLEX端口的使用 (9)2.5存储设备线路连接描述 (9)2.6存储设备端口命名规则 (10)3.SAN存储规划 (10)3.1存储设备连接线缆数量及种类 (10)3.2存储设备IP地址配置 (11)3.3VPLEX的端口连接配置 (11)4.VPLEX METRO实施步骤 (12)4.1VPLEX前期准备 (12)4.1.1 system volumes (12)4.2S WITCH ZONING (13)4.3B ACKEND STORAGE PROVISIONQ (13)4.4VPLEX INITIAL SETUP (13)4.4.1 Configip address and hostname of VPLEX (13)4.4.1.1 Connect to management server (13)4.4.1.2 entering the VPLEXCLI (14)4.4.1.3 set the management server ipaddress (14)4.4.1.4 change the hostname of VPLEX (14)4.4.1.5 check software version (14)4.4.2 use EZ-setup to initialize the VPLEX1 (15)4.4.2.1 Start EZ-setup (15)4.4.2.2 Configure the first cluster (15)4.4.2.3 Chose the local authentication (15)4.4.2.4 Configure event notification (15)4.4.2.5 Configure send system report to EMC (16)4.4.2.6 Configure performance statistics collector (16)4.4.2.7 Generate the certificate (16)4.4.2.8 Backend storage discovery (17)4.4.2.9 create meta-data volume (17)4.4.2.10 verify if meta-data volume is successfully created (18)4.4.2.11 create meta-data volume backups (18)4.4.2.12 enable FE port (18)4.4.3 use EZ-setup to initialize the VPLEX2 (18)4.4.3.1 Connect to VPLEX2 (18)4.4.3.2 Sychronize the time on the clusters (18)4.4.3.3 Start EZ-setup on cluster2 (19)4.4.3.4 Configure the Meta-data volume and backup of VPLEX2 (19)4.4.3.5 Complete configuration of cluster1 (19)4.4.3.6 Complete configuration of cluster2 (19)4.4.4 Join the clusters (19)4.4.5 Create logging volumes (20)4.5C HECK THE CLUSTER HEALTH (21)4.6VPLEX BACKEND STORAGE CONNECTIVITY VERIFY (21)4.7C LAIM THE DA TA VOLUME (21)5.ISILON的实施步骤 (23)5.1集群初始化 (23)5.2节点加入 (37)5.3系统健康检查 (38)5.4O NE FS升级 (38)5.5安装补丁包 (38)5.6系统微码升级 (38)5.7硬盘微码升级 (38)5.8管理界面登录 (39)5.9保护级别设置 (39)5.10网络设置 (40)5.10.1 内网设置 (41)5.10.2 外网设置 (41)5.11目录认证服务 (41)5.12SMB共享规划 (41)5.13NFS共享规划 (43)6DATADOMAIN配置步骤 (45)6.1D A TA D OMAIN配置之前实施内容 (45)6.2D A TA D OMAIN VTL配置 (46)7存储设备的使用示范 (55)7.1操作流程 (55)7.2操作示例 (56)7.2.1 光纤交换机操作部分 (56)7.2.2 EMC VNX7600操作部分 (59)7.2.3 VPLEX 操作部分 (62)1.项目实施内容XX公司双活数据中心灾备项目采用EMC VPLEX METRO解决方案,实现院区主机房和灾备机房容灾。

EMC_VPlex存储双活建设方案详细

2012年11月

一、

目前XXX市社保已经在使用EMC的存储系统VNX5100,为了进一步保障社保应用的高可用性,提高生产的安全级别,XXX市社保计划对目前的存储系统进行虚拟化整合,并搭建双活存储系统,保证关键业务所使用的存储系统即使有一台存储系统出现故障,也不会出现业务停顿,达到更高的生产安全保障。

VNX 7500还支持LUN的条带化或级联式扩展,以将数据分散到更多的磁盘上;

C.中心机房-存储虚拟化:以EMC VPlex Local作为存储虚拟化;应用系统只需要访问虚拟化存储,而不需要直接管理后端的具体的存储系统;通过存储虚拟化,可以达到两台存储之间双活,可以支持异构的存储系统,对数据进行跨存储的本地及远程保护,统一管理接口和访问接口;

当应用系统读数据时,VPlex采用了AccessAnywhere技术,应用系统只需要就近访问最近的一台存储系统即可,可以大大节省两个数据中心之间的网络传输带宽;

当存储系统故障时,VPlex采用的Active-Active技术,结合服务器的集群文件系统(Cluster File System ),可以保证应用实时切换到容灾中心,而不需要人工操作,保证了业务系统的高可用性,大大缩减了故障切换时间。

当VPlex系统自身出现故障时,由于在Vplex中的设置,VPlex不会修改存储系统LUN的配置信息,即,用户可以将存储系统A或B的LUN直接挂到应用系统,保证应用系统的继续运行,不会产生数据丢失。

2.

VPlex在提供虚拟化的存储访问的同时,还可以方便地对存储容量进行扩展。当一台存储系统出现空间不足的情况时,可以通过VPlex的虚拟卷,将多台存储系统的空间组成一个卷给应用使用。通过这种级联方式,应用系统直接访问VPlex的虚拟卷,而VPlex后端接入的存储系统只是作为VPlex虚拟卷的存储资源池使用,达到资源的更合理分配和优化。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

深入剖析Vplex双活数据中心存储方案

EMC上一代存储双活方案是通过vPlex网关产品实现,具备异构其他厂商存储的能力,将各厂商存储虚拟化为统一的存储池,为上层服务器提供存储资源。

从2010年vPlex 发布以来其的硬件已经更新了VS1、VS2和VS6三代。

2016年推出的VS6硬件引擎间通过40Gb IB互联(替代FC),在性能上相比VS2硬件提升了2倍、时延下降1/3,并支持更多卷数量。

vPlex6.0 (VS6硬件) 也升级OS至GeoSynchrony6.0针对闪存做了优化。

其双活特性就是通过vPlex Metro的Distributed Device(分布式镜像卷)功能实现,并提供跨站点的双活应用。

vPlex Metro由两套vPlex集群构成,每个站点的vPlex设备都有自己专属的本地存储阵列。

通过创建分布式镜像卷为跨设备的镜像卷,可提供双活访问。

两个站点的vPlex集群各有一个卷,两个卷的ID一样。

在组网上,主机同时连接到两站点的vPlex,两站点的vPlex之间通过FC或10Ge连接,后端阵列只与本地的vPlex连接;vPlex之间和vPlex Witness之间均需要IP网络连接。

vPlex Management Console 是 VPLEX 机柜中的 1U 服务器。

此服务器向vPlex 提供GUI管理界面,在双引擎和四引擎配置中,此服务器由UPS 提供备用电源。

接下来,看看vPlex如何接管外部设备的,外部(包含异构存储)存储把LUN映射给vPlex后,在vPlex上呈现为Storage vol,基于Storage Vol在生产Extents,它可以是Storage Vol的部分或全部(每个Storage Vol最多128个),Extents不能跨Storage Vol,再以Raid的形式组织Extents成Dev(Raid支持0,1和拼接);没有被其他Dev组织的Dev称为Top Level Device,在Top Level Device上创建Virtual volumes提供给主机,并支持在线扩展。

最后由主机接口和Virtual Volume组成Storage Views,可以直接映射给主机访问。

从vPlex5.0(VS2硬件)开始,在vPlex产品系列vPlex Local和vPlex Metro中添加了vPlex Geo,从而扩展并增强了vPlex 4.0(VS1硬件)虚拟存储的功能。

vPlex Geo 扩展了vPlex Access Anywhere 存储的覆盖范围,能通过异步通信支持多达 50 ms 的往返时间(RTT)站点间延迟。

vPlex通过 Access Anywhere支持长距离共享、访问和重新定位数据拷贝。

vPlex系统可以包含一个或两个vPlex 群集。

vPlex Local系统包含一个群集,vPlex Metro和vPlex Geo包含两个群集系统组成。

这些群集可提供vPlex Access Anywhere功能。

每个vPlex 群集均包含vPlex Management Console,一个、两个、四

个或八个引擎,每个引擎包含一个备用电源。

vPlex Local用于使用单个vPlex 群集管理数据中心内的数据移动和访问。

支持单、双或四配置(分别包含一个、两个或四个引擎),本地vPlex组成local集群(4引擎8控制器),两站点local集群再组成Metro远程集群(最大8引擎,16控制器),16节点AA集群。

vPlex Metro使用两个vPlex群集且包括独特功能,支持使用直写缓存方式在两个群集之间镜像数据。

vPlex Metro部署中的群集不要求有相同数量的引擎。

例如,

vPlex Metro系统可能由一个带两个引擎的群集和另一个带四个引擎的群集组成。

vPlex Geo用于两个异步远距离节点之间使用 Access Anywhere进行访问。

vPlex Geo分布式卷使用回写缓存支持 Access Anywhere分布式镜像。

如

同 vPlex Metro,vPlex Geo系统也包含两个群集,这些群集无需具有相同数量的引擎。

vPlex Metro 和 vPlex Geo系统可根据需要包括 Witness。

Witness 作为虚拟机部署,且只支持VMware,部署在与两个vPlex群集不同的故障域中(第三方站点)。

在两个vPlex 群集之间进行仲裁,发生站点故障和群集间通信中断时,Witness 用于改善应用程序

可用性。

Witness与vPlex Metro(RTO和RPO为0) 和 vPlex Geo(RTO=0,群集间最大50毫秒的延迟,RPO接近0)配合使用,协调无缝故障切换(区分站点故障或连接故障)作

为 ESX 主机中的虚拟机运行,驻留在两个vPlex群集以外的域中。

通过IP连接到vPlex。

vPlex的关键能力AccessAnywhere是通过分布式一致性缓存技术(Distributed Cache Coherenece)来实现,在集群内及跨区域的另一集群间完成缓存数据的一致性;实现跨主机、跨集群、跨数据中心的访问和在节点之间同步镜像。

vPlex通过把控制器的单个内存系统进行合并以形成分布式缓存。

分布式设计可以跨 vPlex Metro 和Geo系统进行扩展,以提供全局系统的缓存连贯性和一致性。

分布式一致性缓存技术在实现上面,并没有强求所有的Cache都保持统一,而是基于目录形式来跟踪细小的内存块通过锁的粒度来加强扩展能力。

每个引擎的cache分为本地Cache (Cache local)和全局Cache (Cache global);每引擎的本地Cache 只有26GB,其余为全局Cache 。

读的时候先读Local Cache ,如命中直接读取;如在Global中命中,则从对应的引擎Cache中将其读取到Local Cache,再反馈主机;如没有命中,则从本地后端的存储中读取到Local中,并同时修改Local和Global Cache中的信息与索引信息。

写如数据时,vPlex Metro会通过透写方式写到两个站点,待数据写入两地的磁盘阵列后,才会向主机回应写完成。

数据写入后,Cache一致性机制会随即通知Cache页面的变化,并在所有引擎上共享该信息,达到各引擎系统的共享。

由于不同站点的主机可同时读写访问同一个卷,分布式缓存一致性技术保证不同站点的主机访问数据的一致性,这确保了主机访问分布式卷时将始终收到该卷最新的一致数据。

写的时候先判断是否在Local、Global Cache中有对应的旧数据,如没有直接写入Local cache;如有旧数据,先废除旧数据再写入Local;再写入后端存储;然后反馈完成,同时Global Cache中的索引做相应修改。

在vPlex Metro、local中数据写入两个集群下方硬盘即反馈完成;在vPlex GEO中数据写入本地集群的存储、远端内存,即反馈完成。

vPlex Local和Metro都使用直写缓存模式。

在直写缓存中,在虚拟卷收到主机的写请求时,数据将写入到映射卷的后端存储卷。

阵列确认该数据后,vPlex会将确认发送回主机,指示写入成功。

此缓存模式不适用于 vPlex Geo 系统,在该系统中 vPlex群集支持更大RTT 间隔部署。

对于此距离,大多数应用程序不能接受同步直写操作的延迟。

相反vPlex Geo使用回写缓存实现无需同步操作的数据持久性。

在此缓存模式中,vPlex接受主机写入缓存并将镜像数据复制到另一个本地控制器的内存中,然后向主机确认数据。

最后再将数据异步转储到后端存储阵列。

出现电源故障时,vPlex中的缓存保险存储逻辑会将任何未写入的缓存数据存储到本地SSD存储上。

vPlex只提供存储异构虚拟化和镜像两项功能,快照,复制等特性需要添加RecoverPoint实现,所以vPlex的组网方式常常会考虑配合RecoverPoint一起使用。

•采用vPlex实现站点间的双活;vPlex接受到主机写IO之后,同时写入两个数据中心的存储。

此外vPlex内部集成IO分流软件,vPlex将每个主机写IO同步复制到RecoverPoint。

RecoverPoint将每个IO记录下来,采用CDP实现任意时间点恢复。

•实现3DC方案;站点2的RecoverPoint通过异步复制将IO复制到站点3部署的RecoverPoint设备。

本地和异地的RecoverPoint都将每个IO记录下来,实现任意时间点恢复。

•vPlex Metro集群支持最大8引擎16控制器;支持读Cache,联合RecoverPoint 实现支持CDP方案。

简单总结下,vPlex的分布式Cache针对读IO可以加速、提高性能;但是写IO会增加延时。

在IO写入时,vPlex接收主机IO后,需要查询远程vPlex节点是否有读缓存(旧数据),通知该缓存失效,远程vPlex返回确认后,才可写入镜像卷。

RecoverPoint推荐的日志卷配置需要考虑额外容量记录日志,日志卷记录生产卷每个

变化IO,配置容量时要考虑到日志的变化量,网络带宽和稳定性,存储的性能等复杂问题。

在配合RecoverPoint的CDP方案中,主机写操作下来以后,灾备端阵列产生会出现严重IO放大操作。

由于这些原因和网关双活的成本等其他因素,EMC在2015年也推出了基于VMax存储的SRDF/Metro双活功能。