pytorch iris分类

朴素贝叶斯分类数据集

朴素贝叶斯分类数据集

朴素贝叶斯分类是一种基于贝叶斯定理的简单概率分类器。

它假设特征之间是相互独立的(即朴素)。

以下是一个使用朴素贝叶斯分类器的数据集示例:

数据集名称:Iris 数据集

数据集来源:Iris 数据集是一个常用的机器学习数据集,包含了150 个样本,每个样本有4 个特征(花萼长度、花萼宽度、花瓣长度、花瓣宽度)和3 个类别标签(山鸢尾、杂种鸢尾和维吉尼亚鸢尾)。

数据集格式:通常以CSV 格式存储,第一列是标签,后面几列是特征。

数据集示例:

```

标签,花萼长度,花萼宽度,花瓣长度,花瓣宽度

山鸢尾,5.1,3.5,1.4,0.2

杂种鸢尾,4.9,3.0,1.7,0.2

维吉尼亚鸢尾,5.6,3.9,5.1,1.8

...

```

这个数据集可以用Python 的Scikit-learn 库来加载和使用,其中包含了高斯朴素贝叶斯分类器、多项式朴素贝叶斯分类器和伯努利朴素贝叶斯分类器等不同的分类器模型。

例如,使用高斯朴素贝叶斯分类器进行分类的代码示例如下:

```python

from sklearn.datasets import load_iris

from sklearn.naive_bayes import GaussianNB

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 创建高斯朴素贝叶斯分类器对象gnb = GaussianNB()

# 使用训练数据训练分类器gnb.fit(X, y)

# 对测试数据进行预测

y_pred = gnb.predict(X)

```。

iris标准基本介绍

iris标准基本介绍Iris标准基本介绍Iris标准是一种用于机器学习和数据挖掘的开源软件库,它提供了一系列用于数据处理、特征选择、分类、聚类等任务的算法和工具。

Iris标准由Python语言编写,可运行于多个平台上,并且易于使用和扩展。

Iris标准的主要特点包括:1. 多种数据集支持:Iris标准内置了多个常用的数据集,如鸢尾花数据集、波士顿房价数据集等,用户可以直接使用这些数据集进行实验。

2. 多种算法支持:Iris标准支持多种经典的机器学习算法,如KNN、决策树、随机森林等,并且还提供了一些高级算法,如神经网络、支持向量机等。

3. 数据可视化功能:Iris标准提供了多种数据可视化工具,如散点图、箱线图等,方便用户对数据进行分析和展示。

4. 易于扩展:Iris标准是一个开源软件库,用户可以自由地添加新的算法或工具,并且可以与其他Python库进行无缝整合。

使用 Iris 标准进行机器学习任务的步骤如下:1. 导入所需要的数据集:可以使用Iris标准内置的数据集,也可以导入自己的数据集。

2. 数据预处理:包括数据清洗、特征选择、特征缩放等步骤。

3. 划分训练集和测试集:将数据集划分为训练集和测试集,用于模型训练和评估。

4. 选择算法并进行模型训练:根据任务需求选择适当的算法,并使用训练集进行模型训练。

5. 模型评估:使用测试集对模型进行评估,计算模型的准确率、精确率、召回率等指标。

6. 模型优化:根据评估结果对模型进行优化,如调整超参数、增加特征等。

7. 模型应用:使用优化后的模型对新数据进行预测或分类。

总之,Iris标准是一个功能强大且易于使用的机器学习工具,它为从事机器学习和数据挖掘研究的人员提供了便捷而高效的解决方案。

python随机森林分类构建模型及评估

Python随机森林分类模型及评估1. 简介随机森林(Random Forest)是一种集成学习(Ensemble Learning)方法,它通过构建多个决策树并进行投票或取平均值的方式来进行分类或回归任务。

本文将介绍如何使用Python中的随机森林算法构建分类模型,并对模型进行评估。

2. 数据准备在构建模型之前,我们首先需要准备数据。

随机森林可以用于处理各种类型的数据,包括数值型和类别型特征。

通常情况下,我们需要对数据进行预处理,包括特征选择、缺失值填充、标准化等步骤。

在本例中,我们将使用一个名为iris的经典数据集作为示例。

该数据集包含了150个样本,每个样本有4个特征:花萼长度、花萼宽度、花瓣长度和花瓣宽度。

每个样本还有一个类别标签,表示鸢尾花的种类。

首先,我们需要导入必要的库和数据集:import pandas as pdfrom sklearn.datasets import load_iris# 加载iris数据集data = load_iris()df = pd.DataFrame(data.data, columns=data.feature_names)df['target'] = data.target3. 数据探索在构建模型之前,我们需要对数据进行一些基本的探索,以了解数据的分布、特征之间的关系等信息。

# 查看数据前几行df.head()# 查看数据统计信息df.describe()# 查看类别分布df['target'].value_counts()# 可视化特征之间的关系import seaborn as snssns.pairplot(df, hue='target')4. 特征工程在构建随机森林模型之前,我们可能需要进行一些特征工程操作,以提取更有用的特征或减少特征维度。

常见的特征工程方法包括特征选择、特征变换和特征生成等。

实战:Python支持向量机分类

实战:Python支持向量机分类因为Python中的scikit-learn库集成了支持向量机算法,使用方法较为便捷,因此本次实验选择在Python中使用支持向量机进行分类。

本文用的数据集为鸢尾花(Iris)数据集,这是统计学中一个经典的数据集,其中包含了150条鸢尾花相关数据。

它包含在scikit-learn库的datasets模块中。

因此我们调用load_iris函数来加载数据:鸢尾花数据集的部分数据如表3-9所示,共5列,前4列为样本特征,第5列为类别,分别有3种类别Iris-setosa、Iris-versicolor、Iris-virginica。

表3-9 鸢尾花数据集的部分数据从datasets模块中导入的数据为字典形式,包含data、target、frame、target_names、DESCR等键,其中对我们有用的是data、target、target_names三个键。

data中为样本特征,是一个150行4列的array,其中每行为鸢尾花一个的特征;target是一个一维的array,表示的是类别,数据集中已经将其变为0、1、2三种,对应的分别是Iris-setosa、Iris-versicolor和Iris-virginica。

因为数据是预处理过的,因此可直接进行训练,代码如下:train_test_split:随机划分训练集与测试集。

train_data:所要划分的样本特征集。

train_target:所要划分的样本结果。

train_size:样本占比,如果是整数的话就是样本的数量。

random_state:随机数种子。

随机数种子其实就是该组随机数的编号,在需要重复进行试验时,保证得到一组一样的随机数。

比如每次都填1,在其他参数一样的情况下,得到的随机数组是一样的。

但填0或不填,每次都会不一样。

随机数的产生取决于种子,随机数和种子之间的关系遵从以下两个规则:①种子不同,产生不同的随机数;②种子相同,即使实例不同也会产生相同的随机数,代码如下:支持向量机分类器的参数解释如下。

iris原理

iris原理iris原理解析1. 引言欢迎阅读本篇文章,本文将详细解释iris原理。

iris是一种广泛应用于机器学习和模式识别领域的分类算法,它基于模式分类的机制来进行数据分析和预测。

2. iris数据集介绍iris数据集是一种常用的数据集,其中包含了150个采集的鸢尾花样本。

每个样本都包含了四个特征(萼片长度、萼片宽度、花瓣长度、花瓣宽度),以及一个对应的标签(鸢尾花的类别)。

iris数据集广泛应用于机器学习的训练和测试中。

3. 数据预处理为了使iris数据集适合iris算法的训练和预测,我们首先需要进行数据预处理,包括以下几个步骤:•数据清洗:去除无效数据、缺失数据和异常值。

•特征选择:根据实际需求选择合适的特征,这里我们选择了萼片长度和花瓣宽度作为特征。

•数据变换:对数据进行归一化,以便提高算法的性能和稳定性。

4. iris原理iris算法是基于统计学原理的一种分类算法,主要包括以下几个步骤:计算距离对于给定的一个待分类样本,首先需要计算它与训练集中每个样本的距离。

这里我们采用欧氏距离作为距离度量的方式,即通过计算样本之间的特征差的平方和的开方来得到距离数值。

确定领域根据计算得到的距离数值,我们可以确定离待分类样本最近的k 个样本,这些样本将构成算法的“领域”。

判断类别对于确定的k个样本,我们根据它们的类别进行统计。

以多数表决的方式,将待分类样本归为最多的类别。

iris算法的优化为了提高算法的性能和泛化能力,我们可以采用以下优化策略:•调整k值:根据实际需求选择合适的k值,一般通过交叉验证来确定最佳的k值。

•特征权重调整:根据特征的重要程度,为不同的特征赋予不同的权重,以提高算法的灵敏度。

•样本加权:为训练集中的样本赋予不同的权重,以应对样本不平衡问题。

5. 总结本文对iris原理进行了详细解释,包括数据预处理、iris算法的原理和优化策略等内容。

通过灵活运用iris算法,可以实现对iris 数据集的分类和预测,进而应用于更广泛的机器学习和模式识别任务中。

用Python实现支持向量机并处理Iris数据集

⽤Python实现⽀持向量机并处理Iris数据集SVM全称是Support Vector Machine,即⽀持向量机,是⼀种监督式学习算法。

它主要应⽤于分类问题,通过改进代码也可以⽤作回归。

所谓⽀持向量就是距离分隔⾯最近的向量。

⽀持向量机就是要确保这些⽀持向量距离超平⾯尽可能的远以保证模型具有相当的泛化能⼒。

当训练数据线性可分时,通过硬间隔最⼤化,学习⼀个线性分类器,即线性可分⽀持向量机;当训练数据近似线性可分时,通过软间隔最⼤化,也学习⼀个线性分类器,即线性⽀持向量机;当训练数据线性不可分时,通过使⽤核技巧,将低维度的⾮线性问题转化为⾼维度下的线性问题,学习得到⾮线性⽀持向量机。

所谓核技巧就是将低维数据映射到⾼维空间的办法。

如果原始数据是有限维的,那么⼀定存在⼀个⾼维特征空间使样本可分。

⽀持向量机的⼀些证明推导公式不在这⾥说明。

我简单说明⼀下⽀持向量机在Python中的实现。

在Python中sklearn算法包已经实现了所有基本机器学习的算法。

直接from sklearn import svm就可以调⽤该算法。

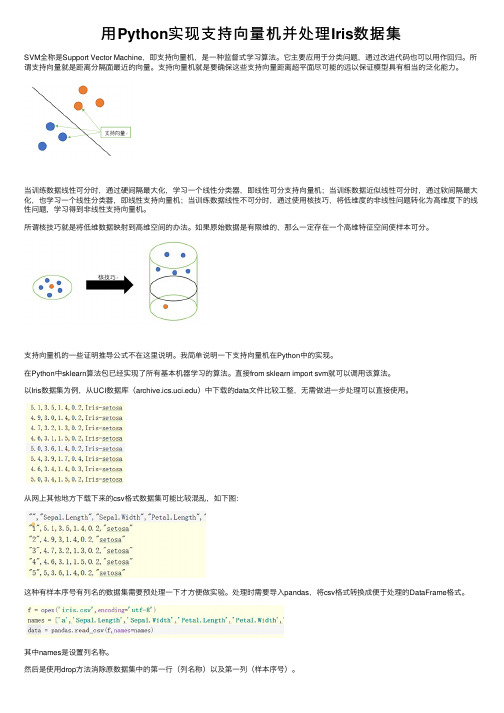

以Iris数据集为例,从UCI数据库()中下载的data⽂件⽐较⼯整,⽆需做进⼀步处理可以直接使⽤。

从⽹上其他地⽅下载下来的csv格式数据集可能⽐较混乱,如下图:这种有样本序号有列名的数据集需要预处理⼀下才⽅便做实验。

处理时需要导⼊pandas,将csv格式转换成便于处理的DataFrame格式。

其中names是设置列名称。

然后是使⽤drop⽅法消除原数据集中的第⼀⾏(列名称)以及第⼀列(样本序号)。

其中('a',axis=1)代表消除的是列名称为a的⼀整列。

(0 ,axis=0)代表消除第0⾏。

最后使⽤to_csv⽅法输出⽂件即可处理完毕。

其中'newiris.csv'是指⽣成⽂件名,sep指的是分割符号(空格为\t),index为⾏索引(即序列号),header为列名称。

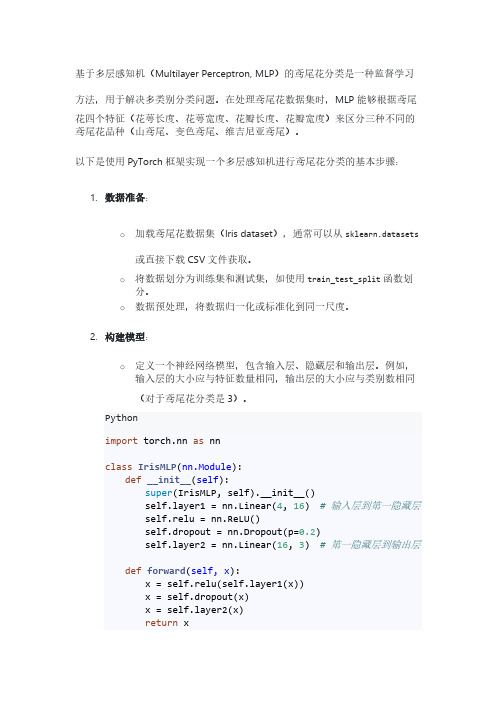

基于多层感知机的鸢尾花分类

基于多层感知机(Multilayer Perceptron, MLP)的鸢尾花分类是一种监督学习方法,用于解决多类别分类问题。

在处理鸢尾花数据集时,MLP能够根据鸢尾花四个特征(花萼长度、花萼宽度、花瓣长度、花瓣宽度)来区分三种不同的鸢尾花品种(山鸢尾、变色鸢尾、维吉尼亚鸢尾)。

以下是使用PyTorch框架实现一个多层感知机进行鸢尾花分类的基本步骤:1.数据准备:o加载鸢尾花数据集(Iris dataset),通常可以从sklearn.datasets 或直接下载CSV文件获取。

o将数据划分为训练集和测试集,如使用train_test_split函数划分。

o数据预处理,将数据归一化或标准化到同一尺度。

2.构建模型:o定义一个神经网络模型,包含输入层、隐藏层和输出层。

例如,输入层的大小应与特征数量相同,输出层的大小应与类别数相同(对于鸢尾花分类是3)。

Pythonimport torch.nn as nnclass IrisMLP(nn.Module):def__init__(self):super(IrisMLP, self).__init__()yer1 = nn.Linear(4, 16) # 输入层到第一隐藏层 self.relu = nn.ReLU()self.dropout = nn.Dropout(p=0.2)yer2 = nn.Linear(16, 3) # 第一隐藏层到输出层def forward(self, x):x = self.relu(yer1(x))x = self.dropout(x)x = yer2(x)return x3.损失函数与优化器设置:o使用合适的多类别损失函数,如交叉熵损失(CrossEntropyLoss)。

Pythoncriterion = nn.CrossEntropyLoss()optimizer = torch.optim.Adam(model.parameters(),lr=0.001)4.训练循环:o遍历训练集样本,执行前向传播得到预测结果,计算损失并反向传播更新权重。

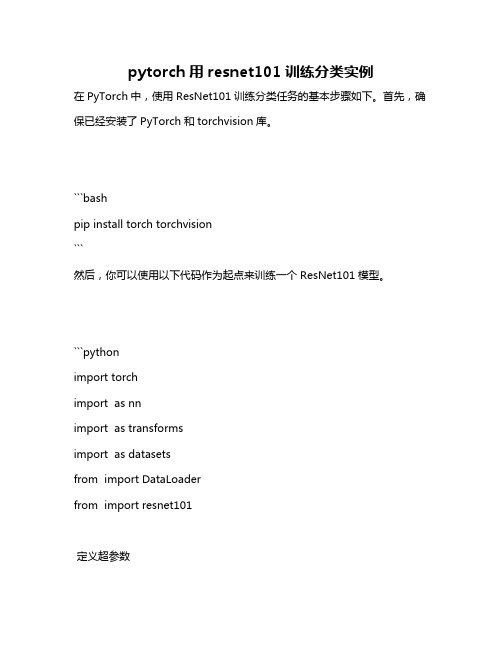

pytorch用resnet101训练分类实例

pytorch用resnet101训练分类实例在PyTorch中,使用ResNet101训练分类任务的基本步骤如下。

首先,确保已经安装了PyTorch和torchvision库。

```bashpip install torch torchvision```然后,你可以使用以下代码作为起点来训练一个ResNet101模型。

```pythonimport torchimport as nnimport as transformsimport as datasetsfrom import DataLoaderfrom import resnet101定义超参数input_size = 2048hidden_size = 1000num_classes = 1000 根据你的数据集类别数量进行更改num_epochs = 25 训练轮数learning_rate = 学习率batch_size = 32 批处理大小数据预处理和加载transform = ([(256),(224),(),(mean=[, , ], std=[, , ])])train_dataset = (root='path_to_your_train_data', transform=transform) 替换为你的训练数据路径train_loader = DataLoader(train_dataset, batch_size=batch_size, shuffle=True)test_dataset = (root='path_to_your_test_data', transform=transform) 替换为你的测试数据路径test_loader = DataLoader(test_dataset, batch_size=batch_size, shuffle=True)加载预训练的ResNet101模型,去除全连接层,然后添加自定义的全连接层model = resnet101(pretrained=True)model = (list(())[:-1]) 去除全连接层_module("fc", (in_features=2048, out_features=num_classes)) 添加自定义的全连接层定义损失函数和优化器criterion = () 使用交叉熵损失函数optimizer = ((), lr=learning_rate) 使用Adam优化器训练模型for epoch in range(num_epochs):for i, (images, labels) in enumerate(train_loader): images的shape 为[batch_size, channels, height, width]outputs = model(images) 前向传播,得到预测结果loss = criterion(outputs, labels) 计算损失值_grad() 清空过去的梯度() 后向传播,计算梯度() 根据梯度更新权重print(f'Epoch [{epoch+1}/{num_epochs}], Step[{i+1}/{len(train_loader)}], Loss: {()}')在测试集上评估模型性能with _grad(): 在测试时不需要计算梯度,所以使用_grad()来关闭梯度计算,提高运行速度。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

pytorch iris分类

您可能是在寻找如何使用PyTorch对Iris数据集进行分类的方法。

然而,代码"iris_multi-classfication.py"并不是实现Iris数据集分类的正确方式。

这是因为该代码片段导入了许多库,但并没有具体实现分类算法。

下面是一个基本的示例,说明如何使用PyTorch对Iris数据集进行多类分类:

首先,我们需要加载数据:

python

复制代码

from sklearn.datasets import load_iris

from torch.utils.data import DataLoader, TensorDataset

# 加载iris数据集

iris = load_iris()

X, y = iris.data, iris.target

然后,我们需要将数据划分为训练集和测试集:

python

复制代码

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

接下来,我们定义我们的神经网络模型。

这里我们使用一个简单的多层感知器(MLP):

python

复制代码

import torch.nn as nn

class MLP(nn.Module):

def __init__(self):

super(MLP, self).__init__()

self.hidden = nn.Linear(4, 10) # 输入层到隐藏层的线性变换,隐藏层大小为10

self.predict = nn.Linear(10, 3) # 隐藏层到输出层的线性变换,输出层大小为3,对应iris的三个分类

def forward(self, x):

x = torch.relu(self.hidden(x)) # 使用ReLU作为激活函数

x = self.predict(x) # 输出层的线性变换

return x

然后,我们需要定义损失函数和优化器:

python

复制代码

import torch.nn.functional as F

from torch import optim

# 定义损失函数,这里使用交叉熵损失函数

criterion = nn.CrossEntropyLoss()

# 定义优化器,这里使用随机梯度下降优化器

optimizer = optim.SGD(model.parameters(), lr=0.01) 接下来,我们训练我们的模型:

python

复制代码

for epoch in range(100): # 循环遍历整个数据集多次,这里我们设定为100次

# 前向传播:计算预测值与真实值之间的损失函数的值

outputs = model(X_train)

loss = criterion(outputs, y_train)

# 反向传播:根据损失函数的值调整模型参数

optimizer.zero_grad() # 清空过去的梯度缓存,否则会重复累积梯度,导致模型训练效果不佳。

每次迭代前都需要清空。

loss.backward() # 计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传

播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值反向传播:计算梯度值 # PyTorch中的`backward()`会自动计算出当前张量的梯度和累计所有的梯度到模型参数中。

这里没有用到`backward()`函数,是因为`loss`是直接从`outputs`中得到的损失,所以直接调用`loss.backward()`即可。

# PyTorch中的`backward()`会自动计算出当前张量的梯度和累计所有的梯度到模型参数中。

这里没有用到`backward()`函数,是因为`loss`是直接从`outputs`中得到的损失,所以直接调用`loss.backward()`即可。

# PyTorch中的`backward()`会自动计算出当前张量的梯度和累计所有的梯度到模型参数中。

这里没有用到`backward()`函数,是因为`loss`是直接从`outputs`中得到的损失,所以直接调用`loss.backward()`即可。

# PyTorch中的`backward()`会自动计算出当前张量的梯度和累计所有的梯度到。