Discuz帖子采集

八爪鱼采集论坛帖子图文攻略

八爪鱼采集软件如何采集论坛帖子的图文攻略

八爪鱼采集器如何采集论坛的帖子及图片的详细操作步骤。

先来看看采集规则市场内的有关论坛方面的采集规则都有哪些?

搜索“论坛”相关的关键词,可以找到Discuz论坛帖子采集和天涯论坛帖子采集两个比较有代表性的论坛类型,当然,如果小伙伴需要采集其他的论坛比如说百度贴吧、晋江文学论坛、新闻论坛等,可以借鉴这两个规则举一反三。

网站也有采集软件相关的视频教程。

以Discuz论坛为例,规则里面只采集了前三页,如果需要修改成采集更多页的话,可以在此处进行修改!

规则中采集的内容为发帖人、帖子标题、帖子内容、查看、回复、发帖内容等字段,小

伙伴们可以根据自己的需要增加或删除字段。

如果需要采集图片则可选择先采集图片的URL 超级链接,再去八爪鱼论坛上下载图片转化工具,将URL批量转换为图片URL。

全部设置完毕之后,点击下一步进入到单机采集调试的环节,来看看采集的成果吧。

天涯帖子采集规则如果要修改,也可以参照上面的方法依次类推。

小伙伴们还可以将八爪鱼采集软件运用到其他类型的论坛上。

CX采集图文教程-手把手教你做DZ采集规则

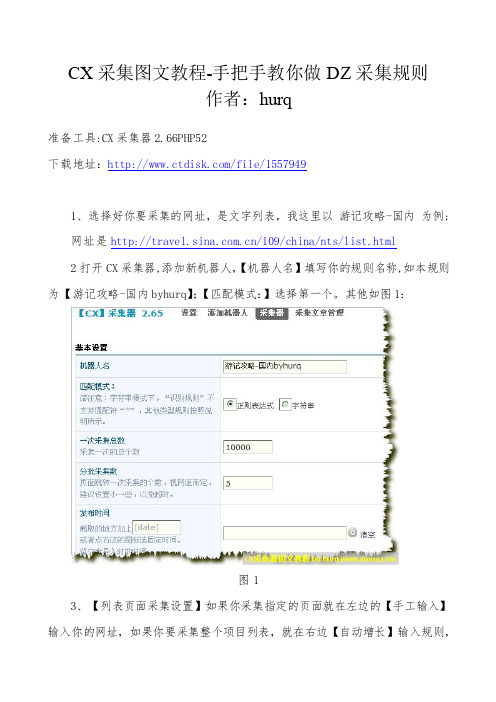

CX采集图文教程-手把手教你做DZ采集规则作者:hurq准备工具:CX采集器2.66PHP52下载地址:/file/15579491、选择好你要采集的网址,是文字列表,我这里以游记攻略-国内为例;网址是/109/china/nts/list.html2打开CX采集器,添加新机器人,【机器人名】填写你的规则名称,如本规则为【游记攻略-国内byhurq】;【匹配模式:】选择第一个。

其他如图1:图13、【列表页面采集设置】如果你采集指定的页面就在左边的【手工输入】输入你的网址,如果你要采集整个项目列表,就在右边【自动增长】输入规则,规则很简单,你打开几页列表,其中变化的数字ID你用[page]替换,本文采用手工输入:如图2。

图24、【开启URL监控模式】开启后以后重复的文章就不会采集,建议设置检测,避免重复;【文章倒序采集】你自己设置;【列表页面编码】你点击程序辅助检测就行了,如果检测的编码和你的网站程序不一样,请填写你检测出来的编码,其他设置如图3;图35、【列表区域识别规则】你打开网页源代码。

找到文章列表所知位置,找到整个列表块的开始和结束代码,记住,开始代码必须是唯一的。

如图4.5.6,代码为“var auto_news = new Array();[list]show_news(1,40);”,写完后点击测试,看看是否成功。

图4图5图66、【文章链接URL识别规则】直接在上面的测试里可以看到代码,找到同类的标记就行了,如图7所示,代码为“","/[url]","”。

点击测试,OK,成功了。

图77、【文章链接URL补充前缀】由于里面的链接都是内链,我们采集来的都要补充前缀,你随便打开一个链接,把采集之前的链接截取就行了,本文的链接为:/其他都可以不写,如图8;图88、【文章标题识别规则】打开一个内容页右击查看源代码,找到标题,取标题前后的代码就行了,记住,前段代码必须唯一。

采集黑马程序员论坛的帖子

任务名称:采集黑马程序员论坛的帖子一、引言黑马程序员论坛是一个知名的IT技术交流平台,涵盖了各种编程语言、开发工具、前沿技术等话题。

本文将介绍如何采集黑马程序员论坛的帖子,并对采集过程中需要考虑的问题进行分析和解决。

二、准备工作1.安装 Python 环境2.安装 Beautiful Soup 库3.安装 requests 库三、黑马程序员论坛的帖子结构分析在采集黑马程序员论坛的帖子之前,我们需要先了解一下帖子的结构。

通常一个帖子包括标题、内容、作者、发布时间等信息。

3.1 帖子标题帖子标题通常位于页面的 h1 标签下,我们可以通过 Beautiful Soup 来提取标题信息。

3.2 帖子内容帖子内容通常位于 div 标签下,我们可以通过 Beautiful Soup 来提取帖子的内容。

3.3 作者信息作者信息可能包括用户名、头像等,我们可以通过页面中的特定标签来获取作者信息。

3.4 发布时间发布时间通常位于帖子内容下方,我们同样可以通过 Beautiful Soup 来获取发布时间信息。

四、采集黑马程序员论坛帖子的方法了解了帖子的结构之后,我们可以开始采集黑马程序员论坛的帖子了。

下面是采集的大致步骤:4.1 发送 HTTP 请求获取页面内容使用 requests 库发送 HTTP GET 请求,获取黑马程序员论坛的页面内容。

4.2 解析页面内容使用 Beautiful Soup 解析页面内容,提取帖子的标题、内容、作者信息、发布时间等。

4.3 存储帖子信息将帖子的信息存储到数据库或本地文件中,以便后续的处理和分析。

五、采集过程中需要注意的问题在采集黑马程序员论坛的帖子时,需要考虑到以下问题:5.1 网络访问限制黑马程序员论坛可能对频繁的网络访问进行了限制,我们需要合理设置访问频率,避免被封禁IP。

5.2 页面结构变化黑马程序员论坛的页面结构可能会随着时间的推移而发生变化,我们需要时刻关注页面结构的变化,并相应地调整采集代码。

Discuz论坛系统采集完美教程!

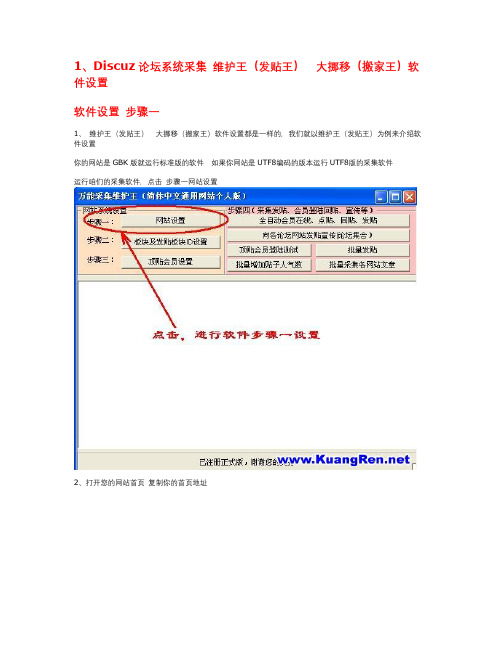

1、Discuz论坛系统采集维护王(发贴王)大挪移(搬家王)软件设置软件设置步骤一1、维护王(发贴王)大挪移(搬家王)软件设置都是一样的,我们就以维护王(发贴王)为例来介绍软件设置你的网站是GBK版就运行标准版的软件如果你网站是UTF8编码的版本运行UTF8版的采集软件运行咱们的采集软件,点击步骤一网站设置2、打开您的网站首页复制你的首页地址3、把首页地址粘贴到软件步骤一里的首页地址位置4、鼠标右键点击您的网站首页里面的登陆————显示一个菜单—————鼠标点击菜单里的属性——————出现一个窗口,复制里面的登陆地址5、把登陆地址粘贴到软件步骤一里的登陆地址位置6、网站类型选择您的网站如果是discuz 7.00 那么,在就下图里面选择No0 Discuz! 7.00 版标准论坛类型7、点击保存设置采集软件将保存步骤一的设置并退出到软件主画面这样软件步骤一就设置完成了,步骤二设置有些麻烦,让我们先跳过,接下来让我们继续设置步骤三软件设置步骤三顶贴会员设置点击步骤三顶贴会员设置(注:这里是设置软件发布文章时的作者,和回复文章时的会员名)您可以使用我们的DISCUZ注册软件在您的DISCUZ论坛上注册一批会员,注册好后,把这批会员放在软件步骤三里但注意一点,您放到软件里的会员必须全部能在您的DISCUZ论坛上能正常登陆,(您可以手工试试看能不能登陆)1、放入在网站注册成功的会员2、每一行一个会员最多可放500个会员3、会员名称和登陆密码之间要空10个以上的空格会员安要求设置好后,点击保存软件自动退回主界面这样步骤三就设置成功了,接下来,让我们继续设置步骤二软件设置步骤二板块及发贴板块ID设置1、鼠标点击步骤二板块及发贴板块ID设置——————将进入软件版块及发贴设置,这里是用来设置,发布文章网址,和回复文章网址用的2、在IE窗口里打开您的论坛首页,您网站有很多论坛版块,把您论坛对应的板块名称及板块地址放入步骤二第一个窗口去注:此为测试,就只放一个版块就OK了。

Discuz SEO(dz论坛搜索引擎优化)手记

#允许一些动态内容的收录,是因为google,live,yahoo和支持一个新的标签属性,可以通过它将链接和权重转移到静态形式的URL上。见:让discuz支持canonical URL tag。

一、禁止SE检索无用页面

1.1 我的robots.txt的设置。主要为了测试各SE的支持情况,用DZ默认的就行*注意:一般情况下,您使用disucz默认的robots.txt文件就可以了。

下面设置主要是为了测试各搜索引擎对robots.txt文件扩展协议的支持和兼容情况。User-agent: *

Allow: /*.html

Allow: /viewthread.php #开放帖子的各种动态形式

Allow: /redirect.php #开放帖子的跳转形式

Allow: /forumdisplay.php #开放列表面的各种动态形式

Allow: /archiver/ #只有放开这个目录,robots开能进入抓取*.html的东西

如此修改之后,对于无权访问的URL、已删除的帖子等提示信息页面,都会返回带有meta robots禁止在页头。因为禁止收录了,过一段时间也会从索引中删除。这样,给SE的都是一些有内容的网页,对于提高权重会有好处。

原来还落下了给archiver加meta robots 补充:2010-3-28

archiver页面的帖子,如果删除了,同样的提示信息也要禁止收录。

Discuz SEO(dz论坛搜索引擎优化)手记

百度贴吧帖子内容采集方法

百度贴吧帖子内容采集方法本文介绍使用八爪鱼采集器简易模式采集百度贴吧帖子内容的方法。

百度贴吧内容采集字段包括:帖子网址,帖子标题,发帖人,本吧等级,帖子内容。

需要采集百度内容的,在网页简易模式界面里点击百度进去之后可以看到所有关于百度的规则信息,我们直接使用就可以的。

百度贴吧帖子内容采集步骤1采集百度知道内容(下图所示)即打开百度贴吧快速采集贴吧的内容。

1、找到百度贴吧快速采集的规则然后点击立即使用百度贴吧帖子内容采集步骤22、下图显示的即为简易模式里面百度知道的规则查看详情:点开可以看到示例网址任务名:自定义任务名,默认为百度贴吧快速采集任务组:给任务划分一个保存任务的组,如果不设置会有一个默认组百度账号:即百度的账号名登陆密码:即百度的账号密码贴吧名称:要采集的贴吧的名字,比如旅游吧采集页数:采集页数,如果不设置会一直采集到最后一条。

示例数据:这个规则采集的所有字段信息百度贴吧帖子内容采集步骤33、规则制作示例例如采集百度贴吧名称为旅游吧的据信息,在设置里如下图所示:任务名:自定义任务名,也可以不设置按照默认的就行任务组:自定义任务组,也可以不设置按照默认的就行登陆名称:即百度的账号名登陆密码:即百度的账号密码贴吧名称:要采集的贴吧的名字,输入“旅游吧”采集页数:采集5页即输入5设置好之后点击保存百度贴吧帖子内容采集步骤4保存之后会出现开始采集的按钮百度贴吧帖子内容采集步骤54、选择开始采集之后系统将会弹出运行任务的界面可以选择启动本地采集(本地执行采集流程)或者启动云采集(由云服务器执行采集流程),这里以启动本地采集为例,我们选择启动本地采集按钮百度贴吧帖子内容采集步骤65、选择本地采集按钮之后,系统将会在本地执行这个采集流程来采集数据,下图为本地采集的效果百度贴吧帖子内容采集步骤76、采集完毕之后选择导出数据按钮即可,这里以导出excel2007为例,选择这个选项之后点击确定百度贴吧帖子内容采集步骤87、然后选择文件存放在电脑上的路径,路径选择好之后选择保存百度贴吧帖子内容采集步骤98、这样数据就被完整的导出到自己的电脑上来了哦百度贴吧帖子内容采集步骤10相关采集教程:豆瓣电影短评采集大众点评评价采集搜狗微信文章采集八爪鱼——70万用户选择的网页数据采集器。

discuz使用手册

discuz使用手册

Discuz使用手册如下:

1. 安装:在电脑上下载安装lamp环境,可以phpstudy,然后安装。

下载discuz,这个要到官方论坛,专门有下载专区。

把discuz的upload复制

到phpstudy的网站目录。

在浏览器地址栏中输入localhost,进行安装就

可以了,都是自动的。

2. 删除回帖:在帖子页面,选中回帖右下方的多选框,点击“管理选项”中的“删除回帖”或者帖子底部的“删除”,输入操作理由,点击提交即可。

3. 移动主题:在版块页面或者帖子页面都可以操作,版块页面可以进行批量主题移动,帖子页面只能移动当前帖子。

操作页面针对移动方式有两个选项:移动主题、移动主题并在原来的版块中保留转向。

移动主题:主题直接被移动到目标版块。

保留转向:主题被移动到目标版块后在当前版块继续保留一个帖子链接,点击该链接则进入被移动到目标版块的帖子。

转向链接的帖子前面会有一个“移动”标志,并且帖子状态为锁定状态。

4. 屏蔽帖子:单帖屏蔽功能是一个超级实用的功能,它可以在版主认为用户发布的某个帖子不符合版规或内容有待商榷时使用。

希望以上信息能帮到您,如有疑问可查阅官网或咨询专业人士。

10个适用于WordPress的RSS采集插件大全

10个适用于WordPress的RSS采集插件大全作为一个强大的博客甚至说CMS内容管理系统,WordPress完全兼容RSS输出和输入。

这就意味着,如果需要,可以通过rss来采集网站信息,当然,鼓励适度而为之,不建议滥用采集。

具体的安装使用方法这里就不一一介绍了,请Google之.1、wordpress自动采集插件-FeedWordPress这个插件用的很不错,主要是读取feed来实现你的博文更新的,并且是以全文的形式。

优点是插件更新升级很及时!建议不要用汉化包,就用英文版WordPress和FeedWordPress原插件!插件下载后需要在后台控制面板激活,并根据需要定制功能。

2、wordpress自动采集插件-Caffeinated Content是一个非常强大的WordPress插件,根据关键词搜索Youtube、Yahoo Answer、Articles、Files 而获取相关内容,可保留原文也可翻译成多个国家语言,并可以定时定量自动发布到你的博客上的插件工具。

功能是十分强大的,只可惜没有针对中文设置几个比较好的信息源头,如果想自行做二次开发,用这个做基础是非常好的选择。

下载解压后上传到plugins根目录下,到后台激活即可,本插件需要注册后方能使用。

3、wordpress自动采集插件-WP-o-Matic是一款效果非常不错的WordPress采集插件,虽然少了自动分类功能,但该插件在各个方面都表现的尚佳,相对于wordpress采集插件Caffeinated Content来说,wp-o-matic是不错的选择,通过RSS完成blog的自动采集。

WP-o-Matic 插件是博客联盟见过的最狠的一个wordpress 采集插件――只需在后台设定Rss 源以及采集的时间,WP-o-Matic就会自动执行。

它甚至可以将对方网站的附件以及图片等都采集,跟国内的cms系统有得一拼,完全无需站长耗心耗力。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Discuz. 论坛帖子采集

建立采集任务

复制要采集的discuz论坛地址

打开八爪鱼采集器,建立采集任务名称点击下一步

在八爪鱼采集器内置浏览器的地址栏中输入要采集的论坛地址,点击跳转,流程设计器中会生成一个“打开网页”步骤,

创建翻页循环

找到论坛中的翻页按钮,右键点击,在弹出的执行框中选择执行,“循环点击下一页”

完成后流程设计器会生成一个翻页循环

创建帖子列表

完成后上述操作后,右键点击第一个帖子,

在跳出的操作框中,选择下图红色方框的选项“创建一个元素列表”

将第一个群组的信息添加到列表中后,点击继续编辑列表

点击第二个群组的信息,同样将其添加到列表中

八爪鱼会将具有相似特征的元素抓取到列表中,

如上图,所有的群组信息被添加到列表,接着点击创建列表完成,

再点击循环,完成群组列表的创建

提取要采集的信息文本

创建列表完成后流程图,如左侧所示,接着我们需要对采集的帖子信息进行抓取,如图点击帖子中的标题,在跳出的执行框中,选择执行”抓取这个元素文本”

抓取到的内容会显示在右上方的操作框中,这里可以修改采集字段的名称,

到这里我们就完成了帖子的信息提取

由于每一页都需要循环采集数据,所以我们需要将这个循环列表拖入到翻页循环里面。

注意:流程是从上网页执行的,所以这个循环列表需要放到点击翻页的前面,否则会漏掉第一页的数据。

最终流程图如下图所示:

点击保存,进入下一个采集步骤

开始采集

选择单机采集,开始QQ的提取

采集完成,有多个导出格式可供选择,可以根据需要点选,采集到的重复数据

八爪鱼采集器会自动识别出来,导出时可以选择是否去重。