自适应模糊神经网络MATLAB代码

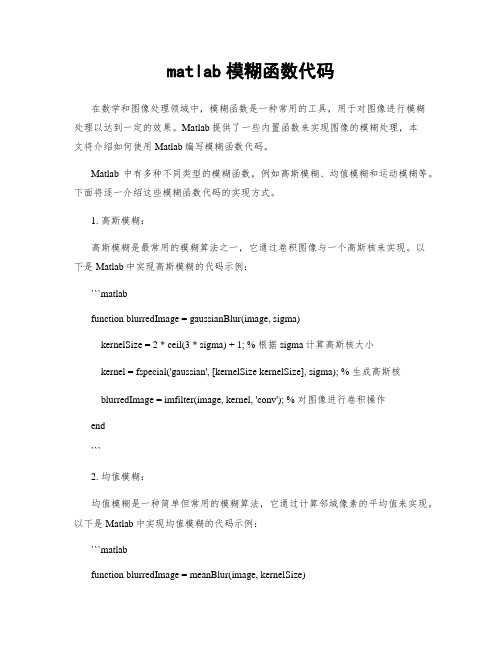

matlab模糊函数代码

matlab模糊函数代码在数学和图像处理领域中,模糊函数是一种常用的工具,用于对图像进行模糊处理以达到一定的效果。

Matlab提供了一些内置函数来实现图像的模糊处理,本文将介绍如何使用Matlab编写模糊函数代码。

Matlab中有多种不同类型的模糊函数,例如高斯模糊、均值模糊和运动模糊等。

下面将逐一介绍这些模糊函数代码的实现方式。

1. 高斯模糊:高斯模糊是最常用的模糊算法之一,它通过卷积图像与一个高斯核来实现。

以下是Matlab中实现高斯模糊的代码示例:```matlabfunction blurredImage = gaussianBlur(image, sigma)kernelSize = 2 * ceil(3 * sigma) + 1; % 根据sigma计算高斯核大小kernel = fspecial('gaussian', [kernelSize kernelSize], sigma); % 生成高斯核blurredImage = imfilter(image, kernel, 'conv'); % 对图像进行卷积操作end```2. 均值模糊:均值模糊是一种简单但常用的模糊算法,它通过计算邻域像素的平均值来实现。

以下是Matlab中实现均值模糊的代码示例:```matlabfunction blurredImage = meanBlur(image, kernelSize)kernel = ones(kernelSize) / (kernelSize^2); % 生成均值核blurredImage = imfilter(image, kernel, 'conv'); % 对图像进行卷积操作end```3. 运动模糊:运动模糊是一种模糊算法,它通过模拟相机快门打开时的移动效果来实现。

以下是Matlab中实现运动模糊的代码示例:```matlabfunction blurredImage = motionBlur(image, angle, distance)PSF = fspecial('motion', distance, angle); % 生成运动模糊核blurredImage = imfilter(image, PSF, 'conv'); % 对图像进行卷积操作end```以上是几种常见的模糊函数的Matlab代码实现。

在Matlab中实现神经网络的方法与实例

在Matlab中实现神经网络的方法与实例神经网络是一种模拟人类大脑神经系统的计算模型,它能够通过学习数据的模式和关联性来解决各种问题。

在计算机科学和人工智能领域,神经网络被广泛应用于图像识别、自然语言处理、预测等任务。

而Matlab作为一种功能强大的科学计算软件,提供了一套完善的工具箱,可以方便地实现神经网络的建模和训练。

本文将介绍在Matlab中实现神经网络的方法与实例。

首先,我们会简要介绍神经网络的基本原理和结构,然后详细讲解在Matlab中如何创建并训练神经网络模型,最后通过几个实例展示神经网络在不同领域的应用。

一、神经网络的原理和结构神经网络模型由神经元和它们之间的连接构成。

每个神经元接收输入信号,并通过权重和偏置进行加权计算,然后使用激活函数对结果进行非线性变换。

这样,神经网络就能够模拟复杂的非线性关系。

常见的神经网络结构包括前馈神经网络(Feedforward Neural Network)和循环神经网络(Recurrent Neural Network)。

前馈神经网络是最基本的结构,信号只能向前传递,输出不对网络进行反馈;而循环神经网络具有反馈连接,可以对自身的输出进行再处理,适用于序列数据的建模。

神经网络的训练是通过最小化损失函数来优化模型的参数。

常用的训练算法包括梯度下降法和反向传播算法。

其中,梯度下降法通过计算损失函数对参数的梯度来更新参数;反向传播算法是梯度下降法在神经网络中的具体应用,通过反向计算梯度来更新网络的权重和偏置。

二、在Matlab中创建神经网络模型在Matlab中,可以通过Neural Network Toolbox来创建和训练神经网络模型。

首先,我们需要定义神经网络的结构,包括输入层、隐藏层和输出层的神经元数量,以及每个神经元之间的连接权重。

例如,我们可以创建一个三层的前馈神经网络模型:```matlabnet = feedforwardnet([10 8]);```其中,`[10 8]`表示隐藏层的神经元数量分别为10和8。

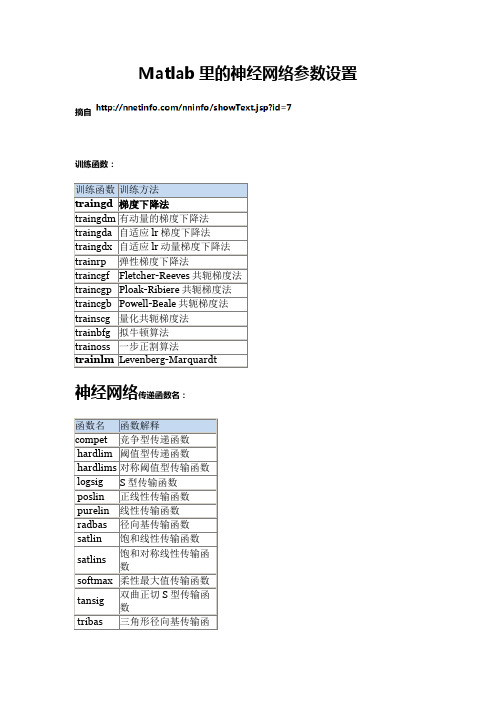

Matlab里的神经网络参数设置

Matlab⾥的神经⽹络参数设置Matlab⾥的神经⽹络参数设置训练函数训练⽅法traingd 梯度下降法traingdm 有动量的梯度下降法traingda ⾃适应lr梯度下降法traingdx ⾃适应lr动量梯度下降法trainrp 弹性梯度下降法traincgf Fletcher-Reeves共轭梯度法traincgp Ploak-Ribiere共轭梯度法traincgb Powell-Beale共轭梯度法trainscg 量化共轭梯度法trainbfg 拟⽜顿算法trainoss ⼀步正割算法trainlm Levenberg-Marquardt传递函数名:函数名函数解释compet 竞争型传递函数hardlim 阈值型传递函数hardlims 对称阈值型传输函数logsig S型传输函数poslin 正线性传输函数purelin 线性传输函数radbas 径向基传输函数satlin 饱和线性传输函数satlins 饱和对称线性传输函数softmax 柔性最⼤值传输函数tansig 双曲正切S型传输函数tribas 三⾓形径向基传输函数训练设置:参数名称解释适⽤⽅法net.trainParam.epochs 最⼤训练次数(缺省为10) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.goal 训练要求精度(缺省为0) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.lr 学习率(缺省为0.01) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.max_fail 最⼤失败次数(缺省为5) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.min_grad 最⼩梯度要求(缺省为1e-10) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.show 显⽰训练迭代过程(NaN表⽰不显⽰,缺省为25) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.time 最⼤训练时间(缺省为inf) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.mc 动量因⼦(缺省0.9) traingdm、traingdxnet.trainParam.lr_inc 学习率lr增长⽐(缺省为1.05) traingda、traingdxnet.trainParam.lr_dec 学习率lr下降⽐(缺省为0.7) traingda、traingdxnet.trainParam.max_perf_inc 表现函数增加最⼤⽐(缺省为1.04) traingda、traingdxnet.trainParam.delt_inc 权值变化增加量(缺省为1.2) trainrpnet.trainParam.delt_dec 权值变化减⼩量(缺省为0.5) trainrpnet.trainParam.delt0 初始权值变化(缺省为0.07) trainrpnet.trainParam.deltamax 权值变化最⼤值(缺省为50.0) trainrpnet.trainParam.searchFcn ⼀维线性搜索⽅法(缺省为srchcha) traincgf、traincgp、traincgb、trainbfg、trainossnet.trainParam.sigma 因为⼆次求导对权值调整的影响参数(缺省值5.0e-5) trainscg/doc/9f16135255.htmlmbda Hessian矩阵不确定性调节参数(缺省为5.0e-7) trainscgnet.trainParam.men_reduc 控制计算机内存/速度的参量,内存较⼤设为1,否则设为2(缺省为1) trainlm net.trainParam.mu 的初始值(缺省为0.001) trainlmnet.trainParam.mu_dec 的减⼩率(缺省为0.1) trainlmnet.trainParam.mu_inc 的增长率(缺省为10) trainlmnet.trainParam.mu_max 的最⼤值(缺省为1e10)。

Matlab里的神经网络参数设置

S型传输函数

poslin

正线性传输函数

purelin

线性传输函数

radbas

径向基传输函数

satlin

饱和线性传输函数

satlins

饱和对称线性传输函数

softmax

柔性最大值传输函数

tansig

双曲正切S型传输函数

tribas

三角形径向基传输函数

elliot2sig

ettrainparamepoch最大训练次数缺省为10traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparamgoal训练要求精度缺省为0traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparamlr学习率缺省为001traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparammaxfail最大失败次数缺省为5traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparammingrad最小梯度要求缺省为1e10traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparamshow显示训练迭代过程nan表示不显示缺省为25traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparamtime最大训练时间缺省为inftraingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparammc动量因子缺省09traingdmtraingdxnettrainparamlrinc学习率lr增长比缺省为105traingdatraingdxnettrainparamlrdec学习率lr下降比缺省为07traingdatraingdxnettrainparammaxper

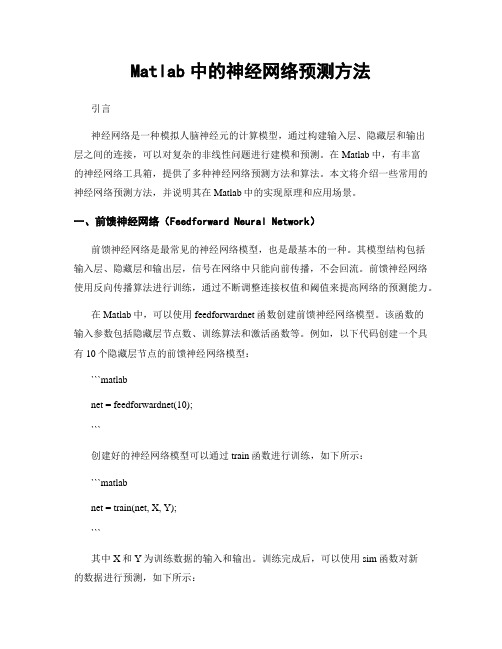

Matlab中的神经网络预测方法

Matlab中的神经网络预测方法引言神经网络是一种模拟人脑神经元的计算模型,通过构建输入层、隐藏层和输出层之间的连接,可以对复杂的非线性问题进行建模和预测。

在Matlab中,有丰富的神经网络工具箱,提供了多种神经网络预测方法和算法。

本文将介绍一些常用的神经网络预测方法,并说明其在Matlab中的实现原理和应用场景。

一、前馈神经网络(Feedforward Neural Network)前馈神经网络是最常见的神经网络模型,也是最基本的一种。

其模型结构包括输入层、隐藏层和输出层,信号在网络中只能向前传播,不会回流。

前馈神经网络使用反向传播算法进行训练,通过不断调整连接权值和阈值来提高网络的预测能力。

在Matlab中,可以使用feedforwardnet函数创建前馈神经网络模型。

该函数的输入参数包括隐藏层节点数、训练算法和激活函数等。

例如,以下代码创建一个具有10个隐藏层节点的前馈神经网络模型:```matlabnet = feedforwardnet(10);```创建好的神经网络模型可以通过train函数进行训练,如下所示:```matlabnet = train(net, X, Y);```其中X和Y为训练数据的输入和输出。

训练完成后,可以使用sim函数对新的数据进行预测,如下所示:```matlabY_pred = sim(net, X_pred);```Y_pred为预测结果,X_pred为待预测的输入数据。

二、递归神经网络(Recurrent Neural Network)递归神经网络是另一种常见的神经网络模型,不同于前馈神经网络,递归神经网络允许信号在网络中进行循环传播,使得模型可以处理序列数据和时间序列数据。

递归神经网络拥有记忆功能,可以通过上一时刻的输出来影响当前时刻的输出。

在Matlab中,可以使用narnet函数创建递归神经网络模型。

该函数的输入参数包括隐藏层节点数、训练算法和激活函数等。

神经网络及深度学习(包含matlab代码)

f ( x)

1 1 e Qx

(2.3)

它反映了神经元的饱和特性。 上式中, Q 为表示神经元非线性的参数, 称增益值(Gain), 也称调节参数。 Q 值越大, S 形曲线越陡峭; 反之, Q 值越小, S 形曲线越平坦; 一般取 Q=1。 (b)双曲正切激励函数,一般取为(-1,1)内连续取值:

神经网络及深度学习

(包含 MATLAB 仿真) 人工神经网络(Artificial Neural Network,即 ANN ) ,作为对人脑最简单的一种抽象和 模拟,是人们模仿人的大脑神经系统信息处理功能的一个智能化系统,是 20 世纪 80 年代 以来人工智能领域兴起的研究热点。 人工神经网络以数学和物理方法以及信息处理的角度对 人脑神经网络进行抽象, 并建立某种简化模型, 旨在模仿人脑结构及其功能的信息处理系统。 人工神经网络最有吸引力的特点就是它的学习能力。因此从 20 世纪 40 年代人工神经 网络萌芽开始, 历经两个高潮期及一个反思期至 1991 年后进入再认识与应用研究期, 涌现 出无数的相关研究理论及成果, 包括理论研究及应用研究。 最富有成果的研究工作是多层网 络 BP 算法,Hopfield 网络模型,自适应共振理论,自组织特征映射理论等。因为其应用价 值, 该研究呈愈演愈烈的趋势, 学者们在多领域中应用人工神经网络模型对问题进行研究优 化解决。 人工神经网络是由多个神经元连接构成,因此欲建立人工神经网络模型必先建立人工 神经元模型,再根据神经元的连接方式及控制方式不同建立不同类型的人工神经网络模型。 一、人工神经元及神经网络 1.1 人工神经元模型 仿生学在科技发展中起着重要作用,人工神经元模型的建立来源于生物神经元结构的 仿生模拟,用来模拟人工神经网络。人们提出的神经元模型有很多,其中最早提出并且影响 较大的是 1943 年心理学家 McCulloch 和数学家 W. Pitts 在分析总结神经元基本特性的基础上 首先提出的 MP 模型。该模型经过不断改进后,形成现在广泛应用的 BP 神经元模型。人工 神经元模型是由人量处理单元厂泛互连而成的网络,是人脑的抽象、简化、模拟,反映人脑 的基本特性。一般来说,作为人工神经元模型应具备三个要素: (1) 具有一组突触或连接,常用 wij 表示神经元 i 和神经元 j 之间的连接强度。 (2) 具有反映生物神经元时空整合功能的输入信号累加器 。 (3) 具有一个激励函数 f 用于限制神经元输出。激励函数将输出信号限制在一个允许 范围内。 一个典型的人工神经元模型如图 1-11-1 所示。

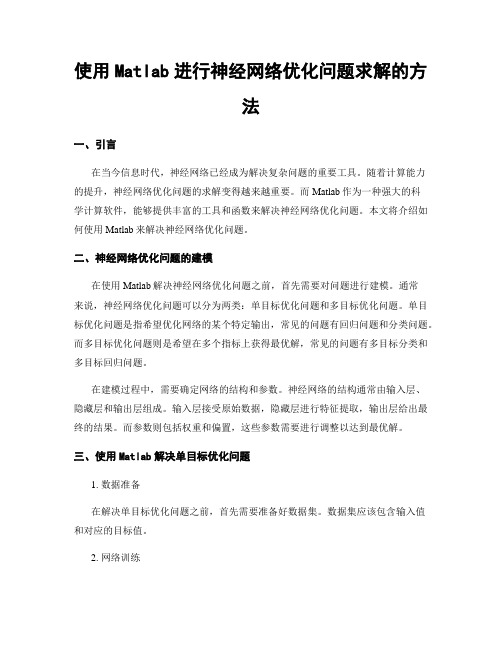

使用Matlab进行神经网络优化问题求解的方法

使用Matlab进行神经网络优化问题求解的方法一、引言在当今信息时代,神经网络已经成为解决复杂问题的重要工具。

随着计算能力的提升,神经网络优化问题的求解变得越来越重要。

而Matlab作为一种强大的科学计算软件,能够提供丰富的工具和函数来解决神经网络优化问题。

本文将介绍如何使用Matlab来解决神经网络优化问题。

二、神经网络优化问题的建模在使用Matlab解决神经网络优化问题之前,首先需要对问题进行建模。

通常来说,神经网络优化问题可以分为两类:单目标优化问题和多目标优化问题。

单目标优化问题是指希望优化网络的某个特定输出,常见的问题有回归问题和分类问题。

而多目标优化问题则是希望在多个指标上获得最优解,常见的问题有多目标分类和多目标回归问题。

在建模过程中,需要确定网络的结构和参数。

神经网络的结构通常由输入层、隐藏层和输出层组成。

输入层接受原始数据,隐藏层进行特征提取,输出层给出最终的结果。

而参数则包括权重和偏置,这些参数需要进行调整以达到最优解。

三、使用Matlab解决单目标优化问题1. 数据准备在解决单目标优化问题之前,首先需要准备好数据集。

数据集应该包含输入值和对应的目标值。

2. 网络训练使用Matlab的神经网络工具箱,可以方便地进行网络训练。

首先,需要创建一个神经网络对象,并设置好网络的结构和参数。

然后,使用训练函数对网络进行训练,常见的训练函数有Levenberg-Marquardt算法和梯度下降算法。

通过训练函数,可以不断调整网络的权重和偏置,直到达到最优解。

3. 网络评估训练完网络后,需要对网络进行评估。

可以使用测试数据集来评估网络的性能,通常采用预测误差、准确率等指标来评估网络的表现。

四、使用Matlab解决多目标优化问题解决多目标优化问题与解决单目标优化问题的方法类似,只是目标变成了多个。

可以使用多种方法来解决多目标优化问题,如加权法、约束法和分级法等。

1. 加权法加权法是一种常用的解决多目标优化问题的方法。

神经网络及深度学习(包含matlab代码).pdf

神经网络及深度学习(包含matlab代码).pdf

神经网络可以使用中间层构建出多层抽象,正如在布尔电路中所做的那样。

如果进行视觉模式识别,那么第1 层的神经元可能学会识别边;第2 层的神经元可以在此基础上学会识别更加复杂的形状,例如三角形或矩形;第3 层将能够识别更加复杂的形状,以此类推。

有了这些多层抽象,深度神经网络似乎可以学习解决复杂的模式识别问题。

正如电路示例所体现的那样,理论研究表明深度神经网络本质上比浅层神经网络更强大。

《深入浅出神经网络与深度学习》PDF+代码分析

《深入浅出神经网络与深度学习》PDF中文,249页;PDF英文,292页;配套代码。

提取码: 6sgh

以技术原理为导向,辅以MNIST 手写数字识别项目示例,介绍神经网络架构、反向传播算法、过拟合解决方案、卷积神经网络等内容,以及如何利用这些知识改进深度学习项目。

学完后,将能够通过编写Python 代码来解决复杂的模式识别问题。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

function [ c, sigma , W_output ] = SOFNN( X, d, Kd )%SOFNN Self-Organizing Fuzzy Neural Networks%Input Parameters% X(r,n) - rth traning data from nth observation% d(n) - the desired output of the network (must be a row vector) % Kd(r) - predefined distance threshold for the rth input%Output Parameters% c(IndexInputVariable,IndexNeuron)% sigma(IndexInputVariable,IndexNeuron)% W_output is a vector%Setting up Parameters for SOFNNSigmaZero=4;delta=0.12;threshold=0.1354;k_sigma=1.12;%For more accurate results uncomment the following%format long;%Implementation of a SOFNN model[size_R,size_N]=size(X);%size_R - the number of input variablesc=[];sigma=[];W_output=[];u=0; % the number of neurons in the structureQ=[];O=[];Psi=[];for n=1:size_Nx=X(:,n);if u==0 % No neuron in the structure?c=x;sigma=SigmaZero*ones(size_R,1);u=1;Psi=GetMePsi(X,c,sigma);[Q,O] = UpdateStructure(X,Psi,d);pT_n=GetMeGreatPsi(x,Psi(n,:))';else[Q,O,pT_n] = UpdateStructureRecursively(X,Psi,Q,O,d,n);end;KeepSpinning=true;while KeepSpinning%Calculate the error and if-part criteriaae=abs(d(n)-pT_n*O); %approximation error[phi,~]=GetMePhi(x,c,sigma);[maxphi,maxindex]=max(phi); % maxindex refers to the neuron's index if ae>deltaif maxphi<threshold%enlarge width[minsigma,minindex]=min(sigma(:,maxindex));sigma(minindex,maxindex)=k_sigma*minsigma;Psi=GetMePsi(X,c,sigma);[Q,O] = UpdateStructure(X,Psi,d);pT_n=GetMeGreatPsi(x,Psi(n,:))';else%Add a new neuron and update structurectemp=[];sigmatemp=[];dist=0;for r=1:size_Rdist=abs(x(r)-c(r,1));distIndex=1;for j=2:uif abs(x(r)-c(r,j))<distdistIndex=j;dist=abs(x(r)-c(r,j));end;end;if dist<=Kd(r)ctemp=[ctemp; c(r,distIndex)];sigmatemp=[sigmatemp ; sigma(r,distIndex)];elsectemp=[ctemp; x(r)];sigmatemp=[sigmatemp ; dist];end;end;c=[c ctemp];sigma=[sigma sigmatemp];Psi=GetMePsi(X,c,sigma);[Q,O] = UpdateStructure(X,Psi,d);KeepSpinning=false;u=u+1;end;elseif maxphi<threshold%enlarge width[minsigma,minindex]=min(sigma(:,maxindex));sigma(minindex,maxindex)=k_sigma*minsigma;Psi=GetMePsi(X,c,sigma);[Q,O] = UpdateStructure(X,Psi,d);pT_n=GetMeGreatPsi(x,Psi(n,:))';else%Do nothing and exit the whileKeepSpinning=false;end;end;end;end;W_output=O;endfunction [Q_next, O_next,pT_n] = UpdateStructureRecursively(X,Psi,Q,O,d,n) %O=O(t-1) O_next=O(t)p_n=GetMeGreatPsi(X(:,n),Psi(n,:));pT_n=p_n';ee=abs(d(n)-pT_n*O); %|e(t)|temp=1+pT_n*Q*p_n;ae=abs(ee/temp);if ee>=aeL=Q*p_n*(temp)^(-1);Q_next=(eye(length(Q))-L*pT_n)*Q;O_next=O + L*ee;elseQ_next=eye(length(Q))*Q;O_next=O;end;endfunction [ Q , O ] = UpdateStructure(X,Psi,d)GreatPsiBig = GetMeGreatPsi(X,Psi);%M=u*(r+1)%n - the number of observations[M,~]=size(GreatPsiBig);%Others Ways of getting Q=[P^T(t)*P(t)]^-1%********************************************************************** ****%opts.SYM = true;%Q = linsolve(GreatPsiBig*GreatPsiBig',eye(M),opts);%%Q = inv(GreatPsiBig*GreatPsiBig');%Q = pinv(GreatPsiBig*GreatPsiBig');%********************************************************************** ****Y=GreatPsiBig\eye(M);Q=GreatPsiBig'\Y;O=Q*GreatPsiBig*d';end%This function works too with x% (X=X and Psi is a Matrix) - Gets you the whole GreatPsi% (X=x and Psi is the row related to x) - Gets you just the column related with the observationfunction [GreatPsi] = GetMeGreatPsi(X,Psi)%Psi - In a row you go through the neurons and in a column you go through number of %observations **** Psi(#obs,IndexNeuron) ****GreatPsi=[];[N,U]=size(Psi);for n=1:Nx=X(:,n);GreatPsiCol=[];for u=1:UGreatPsiCol=[ GreatPsiCol ; Psi(n,u)*[1; x] ];end;GreatPsi=[GreatPsi GreatPsiCol];end;endfunction [phi, SumPhi]=GetMePhi(x,c,sigma)[r,u]=size(c);%u - the number of neurons in the structure%r - the number of input variablesphi=[];SumPhi=0;for j=1:u % moving through the neuronsS=0;for i=1:r % moving through the input variablesS = S + ((x(i) - c(i,j))^2) / (2*sigma(i,j)^2);end;phi = [phi exp(-S)];SumPhi = SumPhi + phi(j); %phi(u)=exp(-S)end;end%This function works too with x, it will give you the row related to xfunction [Psi] = GetMePsi(X,c,sigma)[~,u]=size(c);[~,size_N]=size(X);%u - the number of neurons in the structure%size_N - the number of observationsPsi=[];for n=1:size_N[phi, SumPhi]=GetMePhi(X(:,n),c,sigma);PsiTemp=[];for j=1:u%PsiTemp is a row vector ex: [1 2 3]PsiTemp(j)=phi(j)/SumPhi;end;Psi=[Psi; PsiTemp];%Psi - In a row you go through the neurons and in a column you go through number of %observations **** Psi(#obs,IndexNeuron) ****end;end。