pooleddb的用法

Python数据库读写分离技术

Python数据库读写分离技术Python数据库读写分离技术摘要本论文介绍了Python数据库读写分离技术的概念和实现原理。

通过将数据库的读和写分别部署在不同的服务器或节点上,可以提高系统的可靠性和扩展性。

本文重点讨论了该技术的应用场景、优势以及实现方法,并提出了一些值得注意的问题。

最后,我们通过实例分析的方法验证了该技术的有效性。

关键词:Python、数据库、读写分离、可靠性、扩展性引言数据库作为现代企业信息化过程中最常用的存储与管理涉密信息的技术,其读写性能常常是系统性能的重要瓶颈之一。

为了保障企业信息系统的正常运行,企业需要不断优化数据库技术。

对于大型企业和高并发访问量的系统,数据库读写分离技术是一项非常重要的技术。

数据库读写分离技术是将数据库的读和写分别部署在不同的服务器或节点上,以提高系统的可靠性和扩展性。

Python作为一种高效、灵活、易学易用的编程语言,非常适合用来开发企业级应用,因此,使用Python实现数据库读写分离技术,成为很多企业的首选方案。

本文将重点介绍Python数据库读写分离的实现原理,包括设计思路、应用场景、优势以及实现方法等,以期为广大Python程序员提供一些有益的参考。

1.设计思路在实际生产环境中,高并发访问的情况经常出现。

如果把数据库的所有请求都交给单一的服务器来处理,势必会导致服务器性能的瓶颈,从而影响到整个系统的响应速度。

为了解决这种情况,可以把数据库的读写功能分离到不同的服务器或节点上。

一般情况下,写入操作通常是少量的,但是需要保证100%的数据可靠性,因此很适合放在主服务器上处理。

而读取数据则相对比较频繁,所以可以把读操作放在从属服务器中处理。

通过对数据库读写的分离,主服务器可以快速处理写请求,并对所有从属服务器进行同步和备份,保证数据的一致性和可靠性。

而从属服务器则只需要处理读请求,可以采用多个节点组成一个分布式缓存系统,提高系统的性能和响应速度,降低延迟。

pooleddb的用法

pooleddb的用法

Pooleddb(也称为Pool Databases)是一种用于管理和存储数据的数据库系统。

它通过将数据分布在多个节点上,实现了数据的高可用性和可伸缩性。

下面将介绍一些关于Pooleddb的基本用法和功能。

首先,Pooleddb可以支持多个节点同时访问和管理数据库。

这些节点可以分布在不同的物理服务器上,通过网络连接进行通信。

这种分布式架构使得Pooleddb 可以在数据库节点发生故障时实现自动故障转移,保证数据的可用性。

其次,Pooleddb提供了一种灵活的数据模型,可以轻松地存储和查询各种类型的数据。

它支持事务处理和ACID(原子性、一致性、隔离性和持久性)特性,确保数据的完整性和可靠性。

另外,Pooleddb还提供了多种数据访问接口,包括SQL和NoSQL。

这使得开发人员可以根据自身需求选择合适的接口进行数据操作。

同时,Pooleddb还支持数据分片和数据复制功能,以实现数据的水平扩展和备份。

在实际应用中,Pooleddb可以用于各种场景,如Web应用程序、企业应用、物联网等。

它可以处理大量的并发读写请求,提供高性能和低延迟的数据访问。

同时,Pooleddb还支持数据的在线扩容,可以根据需求动态增加或减少节点,以适应数据量的变化。

总之,Pooleddb是一种功能强大的分布式数据库系统,具有高可用性、可伸缩性和灵活的数据模型。

通过使用Pooleddb,开发人员可以轻松地管理和存储海量数据,实现高性能和可靠的数据访问。

python使用dbutils的PooledDB连接池,操作数据库

python使⽤dbutils的PooledDB连接池,操作数据库1、使⽤dbutils的PooledDB连接池,操作数据库。

这样就不需要每次执⾏sql后都关闭数据库连接,频繁的创建连接,消耗时间2、如果是使⽤⼀个连接⼀直不关闭,多线程下,插⼊超长字符串到数据库,运⾏⼀段时间后很容易出现OperationalError: (2006, ‘MySQL server has gone away’)这个错误。

使⽤PooledDB解决。

# coding=utf-8"""使⽤DBUtils数据库连接池中的连接,操作数据库OperationalError: (2006, ‘MySQL server has gone away’)"""import jsonimport pymysqlimport datetimefrom DBUtils.PooledDB import PooledDBimport pymysqlclass MysqlClient(object):__pool = None;def__init__(self, mincached=10, maxcached=20, maxshared=10, maxconnections=200, blocking=True,maxusage=100, setsession=None, reset=True,host='127.0.0.1', port=3306, db='test',user='root', passwd='123456', charset='utf8mb4'):""":param mincached:连接池中空闲连接的初始数量:param maxcached:连接池中空闲连接的最⼤数量:param maxshared:共享连接的最⼤数量:param maxconnections:创建连接池的最⼤数量:param blocking:超过最⼤连接数量时候的表现,为True等待连接数量下降,为false直接报错处理:param maxusage:单个连接的最⼤重复使⽤次数:param setsession:optional list of SQL commands that may serve to preparethe session, e.g. ["set datestyle to ...", "set time zone ..."]:param reset:how connections should be reset when returned to the pool(False or None to rollback transcations started with begin(),True to always issue a rollback for safety's sake):param host:数据库ip地址:param port:数据库端⼝:param db:库名:param user:⽤户名:param passwd:密码:param charset:字符编码"""if not self.__pool:self.__class__.__pool = PooledDB(pymysql,mincached, maxcached,maxshared, maxconnections, blocking,maxusage, setsession, reset,host=host, port=port, db=db,user=user, passwd=passwd,charset=charset,cursorclass=pymysql.cursors.DictCursor)self._conn = Noneself._cursor = Noneself.__get_conn()def__get_conn(self):self._conn = self.__pool.connection();self._cursor = self._conn.cursor();def close(self):try:self._cursor.close()self._conn.close()except Exception as e:print edef__execute(self, sql, param=()):count = self._cursor.execute(sql, param)print countreturn count@staticmethoddef__dict_datetime_obj_to_str(result_dict):"""把字典⾥⾯的datatime对象转成字符串,使json转换不出错"""if result_dict:result_replace = {k: v.__str__() for k, v in result_dict.items() if isinstance(v, datetime.datetime)}result_dict.update(result_replace)return result_dictdef select_one(self, sql, param=()):"""查询单个结果"""count = self.__execute(sql, param)result = self._cursor.fetchone()""":type result:dict"""result = self.__dict_datetime_obj_to_str(result)return count, resultdef select_many(self, sql, param=()):"""查询多个结果:param sql: qsl语句:param param: sql参数:return: 结果数量和查询结果集"""count = self.__execute(sql, param)result = self._cursor.fetchall()""":type result:list"""[self.__dict_datetime_obj_to_str(row_dict) for row_dict in result]return count, resultdef execute(self, sql, param=()):count = self.__execute(sql, param)return countdef begin(self):"""开启事务"""self._conn.autocommit(0)def end(self, option='commit'):"""结束事务"""if option == 'commit':self._conn.autocommit()else:self._conn.rollback()if__name__ == "__main__":mc = MysqlClient()sql1 = 'SELECT * FROM shiji WHERE id = 1'result1 = mc.select_one(sql1)print json.dumps(result1[1], ensure_ascii=False)sql2 = 'SELECT * FROM shiji WHERE id IN (%s,%s,%s)'param = (2, 3, 4)print json.dumps(mc.select_many(sql2, param)[1], ensure_ascii=False)如果独⽴使⽤pymysql数据库,最好是配合DButils库。

pooleddb的用法

Pooleddb的用法1. 什么是Pooleddb?Pooleddb是一个用于管理分布式数据库的工具。

它是一个开源项目,旨在简化和优化数据库的部署和管理。

Pooleddb提供了一种简单且高效的方式来管理大规模的数据库集群,使得数据库的水平扩展变得更加容易。

2. Pooleddb的特点2.1 分布式架构Pooleddb使用分布式架构,将数据库分散在多个节点上。

每个节点都可以独立地处理查询和事务,从而提高数据库的性能和可伸缩性。

2.2 自动故障恢复Pooleddb具有自动故障恢复的能力。

当某个节点发生故障时,Pooleddb会自动将数据迁移到其他正常节点上,确保数据库的高可用性。

2.3 数据一致性Pooleddb采用分布式一致性算法,确保所有节点上的数据保持一致。

它使用副本机制来存储数据,并使用一致性协议来保证数据的一致性。

2.4 负载均衡Pooleddb通过负载均衡算法将查询请求均匀地分配到不同的节点上,从而提高数据库的性能和吞吐量。

它可以根据节点的负载情况自动调整查询的分配策略。

2.5 扩展性Pooleddb可以很容易地扩展数据库的规模。

只需添加更多的节点,就可以增加数据库的容量和性能。

3. Pooleddb的安装和配置3.1 安装Pooleddb要安装Pooleddb,可以按照以下步骤进行操作:1.下载Pooleddb的安装包。

2.解压安装包到指定的目录。

3.运行安装脚本,按照提示完成安装过程。

3.2 配置Pooleddb安装完成后,需要对Pooleddb进行配置,以便正确地运行数据库集群。

配置文件通常位于安装目录的config文件夹中。

可以根据需要修改配置文件中的参数,以适应特定的环境和需求。

4. Pooleddb的使用4.1 创建数据库要创建一个新的数据库,可以使用Pooleddb提供的命令行工具。

可以使用以下命令创建一个名为”mydb”的数据库:pooleddb create mydb4.2 连接数据库要连接到Pooleddb中的数据库,可以使用以下命令:pooleddb connect mydb4.3 执行查询连接到数据库后,可以执行各种查询操作。

policydb解析

policydb解析全文共四篇示例,供读者参考第一篇示例:PolicyDB是一种用于编程的数据库,它可以帮助开发人员在应用程序中实现访问控制策略。

PolicyDB在很多操作系统中得到应用,比如Linux、UNIX等。

通过PolicyDB,开发人员可以定义不同用户和角色在系统中的权限和访问控制策略,从而保护系统的安全性。

PolicyDB的解析是指系统如何解释和执行通过PolicyDB定义的策略。

这个过程涉及到策略管理、权限校验等方面。

在很多操作系统中,PolicyDB的解析是由内核模块来实现的。

内核模块会解析PolicyDB中定义的策略规则,并根据这些规则来对系统中的用户进行权限控制。

在PolicyDB中,策略规则通常由主体(subject)、对象(object)和动作(action)组成。

主体指的是拥有访问权限的用户或角色,对象指的是要访问的资源,动作指的是用户对资源执行的操作。

通过定义这些规则,开发人员可以灵活地控制不同用户对系统资源的访问权限。

PolicyDB的解析过程通常包括以下几个步骤:1. 策略加载和解析:系统会在启动时加载PolicyDB中定义的策略规则,并解析这些规则,将其存储在内存中以便后续的访问控制操作。

2. 访问控制:当用户发起访问请求时,内核模块会根据PolicyDB 中定义的规则对请求进行访问控制。

如果请求符合规则,则可以执行相应的操作;否则会被拒绝。

3. 策略管理:在系统运行过程中,开发人员可能需要对PolicyDB 中的策略进行修改和更新。

内核模块会提供相应的管理接口,使开发人员能够灵活地管理策略。

4. 日志记录:为了方便系统管理员对系统权限的监控和调整,PolicyDB通常会记录访问控制的日志。

管理员可以通过查看日志来了解系统中用户的访问情况,及时探测异常访问行为。

PolicyDB的解析是系统安全性的重要保障之一。

通过合理地定义策略规则和有效地解析这些规则,可以有效地保护系统资源不受非法访问。

剩余产量模型

平衡渔获量与平均资源生物量及捕捞死亡系数三者之间的关系

上图中,通过原点直线的斜率为F。设对某渔业的捕捞死 亡系数F1(图中OP直线的斜率),若当时的平均资源生物量为 B2,而此时的实际渔获量为SB2,大于所对应的平衡渔获量QB1, 使资源量水平下降而向B1靠拢;若当时资源量水平为B3,则此 时的实际渔获量为RB3,小于其所对应的平衡渔获量QB1 ,资源 量水平上升而向B1靠拢。可见如果逐年均以稳定的F进行捕捞, 则资源群体将会通过自身的再生产起调节作用,使资源量水平 处在该捕捞水平所对应的平衡资源量水平。如果捕捞努力量逐 年变动,则渔业将永远达不到任何平衡点。

表达式。其推导过程与上节所述的相同,具体如下:

Ye

rm

B

( rm B

) B 2或Ye

KB

B

K

2

B

Ye

B F

( B rm

)F 2或Ye

B F

F2

K

Ye

qB

f

( q2B rm

)

f

2或Ye

qB

f

(qf

)2

K

Ye af bf 2 Ye f a bf

fmsy a 2b 和MSY a2 4b

若资源相对的瞬间增长率 1 dB 用f (B)表示,当资源生物量 B dt

极小时,这个函数值最高,但当资源生物量增长到最大值B时, f (B)逐步下降到0 (图6-1,6-2,6-3)。

函数表达式:f (B) 1 dB , f (B)与B成线性关系, B dt

则f (B) r KB,因B B时f (B) 0,得r KB, 故资源生物量的绝对增长率为:f (B) BK(B B) KBB KB2。 可见资源生物量B的绝对增加量与B呈抛物线关系,在B 2 处 得到极值(MSY),而在这条抛物线上的任一点均处在平衡状态。

解决mysql服务器在无操作超时主动断开连接的情况

解决mysql服务器在⽆操作超时主动断开连接的情况我们在使⽤mysql服务的时候,正常情况下,mysql的设置的timeout是8个⼩时(28800秒),也就是说,如果⼀个连接8个⼩时都没有操作,那么mysql会主动的断开连接,当这个连接再次尝试查询的时候就会报个”MySQL server has gone away”的误,但是有时候,由于mysql服务器那边做了⼀些设置,很多情况下会缩短这个连接timeout时长以保证更多的连接可⽤。

有时候设置得⽐较变态,很短,30秒,这样就需要客户端这边做⼀些操作来保证不要让mysql主动来断开。

查看mysql的timeout使⽤客户端⼯具或者Mysql命令⾏⼯具输⼊show global variables like '%timeout%';就会显⽰与timeout相关的属性,这⾥我⽤docker模拟了⼀个测试环境。

mysql> show variables like '%timeout%';+-----------------------------+----------+| Variable_name | Value |+-----------------------------+----------+| connect_timeout | 10 || delayed_insert_timeout | 300 || have_statement_timeout | YES || innodb_flush_log_at_timeout | 1 || innodb_lock_wait_timeout | 50 || innodb_rollback_on_timeout | OFF || interactive_timeout | 30 || lock_wait_timeout | 31536000 || net_read_timeout | 30 || net_write_timeout | 60 || rpl_stop_slave_timeout | 31536000 || slave_net_timeout | 60 || wait_timeout | 30 |+-----------------------------+----------+13 rows in setwait_timeout:服务器关闭⾮交互连接之前等待活动的秒数,就是你在你的项⽬中进⾏程序调⽤interactive_timeout: 服务器关闭交互式连接前等待活动的秒数,就是你在你的本机上打开mysql的客户端,cmd的那种使⽤pymysql进⾏查询我在数据库⾥随便创建了⼀个表,插⼊两条数据mysql> select * from person;+----+------+-----+| id | name | age |+----+------+-----+| 1 | yang | 18 || 2 | fan | 16 |+----+------+-----+2 rows in set我使⽤pymysql这个库对其进⾏查询操作,很简单#coding:utf-8import pymysqldef mytest():connection = pymysql.connect(host='localhost',port=3306,user='root',password='123456',db='mytest',charset='utf8')cursor = connection.cursor()cursor.execute("select * from person")data = cursor.fetchall()cursor.close()for i in data:print(i)cursor.close()connection.close()if __name__ == '__main__':mytest()可以正确的得到结果(1, 'yang', 18)(2, 'fan', 16)连接超时以后的查询上⾯可以正常得到结果是由于当创建好⼀个链接以后,就⽴刻进⾏了查询,此时还没有超过它的超时时间,如果我sleep⼀段时间,看看什么效果。

python3实现mysql数据库连接池的示例代码

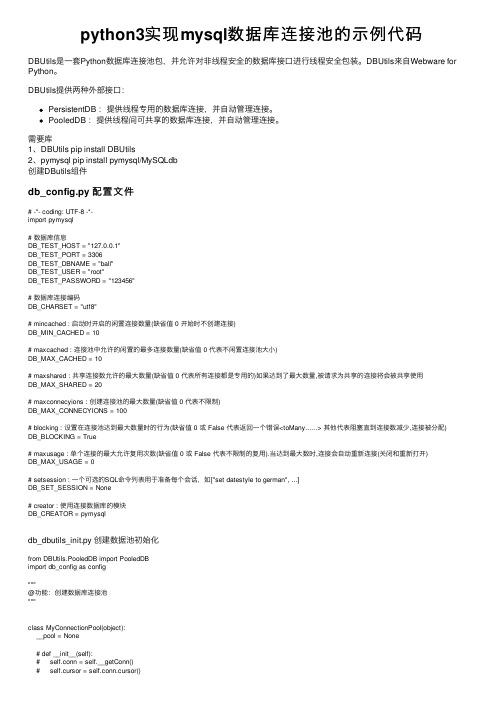

python3实现mysql数据库连接池的⽰例代码DBUtils是⼀套Python数据库连接池包,并允许对⾮线程安全的数据库接⼝进⾏线程安全包装。

DBUtils来⾃Webware for Python。

DBUtils提供两种外部接⼝:PersistentDB :提供线程专⽤的数据库连接,并⾃动管理连接。

PooledDB :提供线程间可共享的数据库连接,并⾃动管理连接。

需要库1、DBUtils pip install DBUtils2、pymysql pip install pymysql/MySQLdb创建DButils组件db_config.py 配置⽂件# -*- coding: UTF-8 -*-import pymysql# 数据库信息DB_TEST_HOST = "127.0.0.1"DB_TEST_PORT = 3306DB_TEST_DBNAME = "ball"DB_TEST_USER = "root"DB_TEST_PASSWORD = "123456"# 数据库连接编码DB_CHARSET = "utf8"# mincached : 启动时开启的闲置连接数量(缺省值 0 开始时不创建连接)DB_MIN_CACHED = 10# maxcached : 连接池中允许的闲置的最多连接数量(缺省值 0 代表不闲置连接池⼤⼩)DB_MAX_CACHED = 10# maxshared : 共享连接数允许的最⼤数量(缺省值 0 代表所有连接都是专⽤的)如果达到了最⼤数量,被请求为共享的连接将会被共享使⽤DB_MAX_SHARED = 20# maxconnecyions : 创建连接池的最⼤数量(缺省值 0 代表不限制)DB_MAX_CONNECYIONS = 100# blocking : 设置在连接池达到最⼤数量时的⾏为(缺省值 0 或 False 代表返回⼀个错误<toMany......> 其他代表阻塞直到连接数减少,连接被分配) DB_BLOCKING = True# maxusage : 单个连接的最⼤允许复⽤次数(缺省值 0 或 False 代表不限制的复⽤).当达到最⼤数时,连接会⾃动重新连接(关闭和重新打开)DB_MAX_USAGE = 0# setsession : ⼀个可选的SQL命令列表⽤于准备每个会话,如["set datestyle to german", ...]DB_SET_SESSION = None# creator : 使⽤连接数据库的模块DB_CREATOR = pymysqldb_dbutils_init.py 创建数据池初始化from DBUtils.PooledDB import PooledDBimport db_config as config"""@功能:创建数据库连接池"""class MyConnectionPool(object):__pool = None# def __init__(self):# self.conn = self.__getConn()# self.cursor = self.conn.cursor()# 创建数据库连接conn和游标cursordef __enter__(self):self.conn = self.__getconn()self.cursor = self.conn.cursor()# 创建数据库连接池def __getconn(self):if self.__pool is None:self.__pool = PooledDB(creator=config.DB_CREATOR,mincached=config.DB_MIN_CACHED,maxcached=config.DB_MAX_CACHED,maxshared=config.DB_MAX_SHARED,maxconnections=config.DB_MAX_CONNECYIONS,blocking=config.DB_BLOCKING,maxusage=config.DB_MAX_USAGE,setsession=config.DB_SET_SESSION,host=config.DB_TEST_HOST,port=config.DB_TEST_PORT,user=config.DB_TEST_USER,passwd=config.DB_TEST_PASSWORD,db=config.DB_TEST_DBNAME,use_unicode=False,charset=config.DB_CHARSET)return self.__pool.connection()# 释放连接池资源def __exit__(self, exc_type, exc_val, exc_tb):self.cursor.close()self.conn.close()# 关闭连接归还给链接池# def close(self):# self.cursor.close()# self.conn.close()# 从连接池中取出⼀个连接def getconn(self):conn = self.__getconn()cursor = conn.cursor()return cursor, conn# 获取连接池,实例化def get_my_connection():return MyConnectionPool()制作mysqlhelper.pyfrom db_dbutils_init import get_my_connection"""执⾏语句查询有结果返回结果没有返回0;增/删/改返回变更数据条数,没有返回0"""class MySqLHelper(object):def __init__(self):self.db = get_my_connection() # 从数据池中获取连接def __new__(cls, *args, **kwargs):if not hasattr(cls, 'inst'): # 单例cls.inst = super(MySqLHelper, cls).__new__(cls, *args, **kwargs)return cls.inst# 封装执⾏命令def execute(self, sql, param=None, autoclose=False):"""【主要判断是否有参数和是否执⾏完就释放连接】:param sql: 字符串类型,sql语句:param param: sql语句中要替换的参数"select %s from tab where id=%s" 其中的%s就是参数 :param autoclose: 是否关闭连接:return: 返回连接conn和游标cursor"""cursor, conn = self.db.getconn() # 从连接池获取连接count = 0try:# count : 为改变的数据条数if param:count = cursor.execute(sql, param)else:count = cursor.execute(sql)mit()if autoclose:self.close(cursor, conn)except Exception as e:passreturn cursor, conn, count# 执⾏多条命令# def executemany(self, lis):# """# :param lis: 是⼀个列表,⾥⾯放的是每个sql的字典'[{"sql":"xxx","param":"xx"}....]' # :return:# """# cursor, conn = self.db.getconn()# try:# for order in lis:# sql = order['sql']# param = order['param']# if param:# cursor.execute(sql, param)# else:# cursor.execute(sql)# mit()# self.close(cursor, conn)# return True# except Exception as e:# print(e)# conn.rollback()# self.close(cursor, conn)# return False# 释放连接def close(self, cursor, conn):"""释放连接归还给连接池"""cursor.close()conn.close()# 查询所有def selectall(self, sql, param=None):try:cursor, conn, count = self.execute(sql, param)res = cursor.fetchall()return resexcept Exception as e:print(e)self.close(cursor, conn)return count# 查询单条def selectone(self, sql, param=None):try:cursor, conn, count = self.execute(sql, param)res = cursor.fetchone()self.close(cursor, conn)return resexcept Exception as e:print("error_msg:", e.args)self.close(cursor, conn)return count# 增加def insertone(self, sql, param):try:cursor, conn, count = self.execute(sql, param)# _id = strowid() # 获取当前插⼊数据的主键id,该id应该为⾃动⽣成为好 mit()self.close(cursor, conn)return count# 防⽌表中没有id返回0# if _id == 0:# return True# return _idexcept Exception as e:print(e)conn.rollback()self.close(cursor, conn)return count# 增加多⾏def insertmany(self, sql, param):""":param sql::param param: 必须是元组或列表[(),()]或((),()):return:"""cursor, conn, count = self.db.getconn()try:cursor.executemany(sql, param)mit()return countexcept Exception as e:print(e)conn.rollback()self.close(cursor, conn)return count# 删除def delete(self, sql, param=None):try:cursor, conn, count = self.execute(sql, param)self.close(cursor, conn)return countexcept Exception as e:print(e)conn.rollback()self.close(cursor, conn)return count# 更新def update(self, sql, param=None):try:cursor, conn, count = self.execute(sql, param)mit()self.close(cursor, conn)return countexcept Exception as e:print(e)conn.rollback()self.close(cursor, conn)return countif __name__ == '__main__':db = MySqLHelper()# # 查询单条# sql1 = 'select * from userinfo where name=%s'# args = 'python'# ret = db.selectone(sql=sql1, param=args)# print(ret) # (None, b'python', b'123456', b'0')# 增加单条# sql2 = 'insert into userinfo (name,password) VALUES (%s,%s)' # ret = db.insertone(sql2, ('old2','22222'))# print(ret)# 增加多条# sql3 = 'insert into userinfo (name,password) VALUES (%s,%s)' # li = li = [# ('分省', '123'),# ('到达','456')# ]# ret = db.insertmany(sql3,li)# print(ret)# 删除# sql4 = 'delete from userinfo WHERE name=%s'# args = 'xxxx'# ret = db.delete(sql4, args)# print(ret)# 更新# sql5 = r'update userinfo set password=%s WHERE name LIKE %s'# args = ('993333993', '%old%')# ret = db.update(sql5, args)# print(ret)python3 实现mysql数据库连接池原理python编程中可以使⽤MySQLdb进⾏数据库的连接及诸如查询/插⼊/更新等操作,但是每次连接mysql数据库请求时,都是独⽴的去请求访问,相当浪费资源,⽽且访问数量达到⼀定数量时,对mysql的性能会产⽣较⼤的影响。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

pooleddb的用法

【实用版】

目录

1.介绍 pooleddb

2.pooleddb 的安装与配置

3.pooleddb 的用法详解

4.pooleddb 的优点与应用场景

5.总结

正文

一、介绍 pooleddb

pooleddb 是一款高性能、轻量级的数据库连接池组件,它支持多种数据库,如 MySQL、Oracle、PostgreSQL 等。

pooleddb 的作用是管理数据库连接,避免频繁创建和销毁连接导致的性能损耗,提高系统的运行效率。

二、pooleddb 的安装与配置

在使用 pooleddb 之前,需要先对其进行安装。

pooleddb 提供了Maven 和 Gradle 两种依赖方式,开发者可以根据自己的项目需求选择相应的依赖。

Maven 依赖方式:

```

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>druid-pool</artifactId>

<version>1.1.10</version>

</dependency>

```

Gradle 依赖方式:

```

implementation "com.alibaba:druid-pool:1.1.10"

```

在项目中引入依赖后,需要对 pooleddb 进行配置。

配置主要包括数

据源、连接池、SQL 语句等方面。

以下是一个简单的配置示例:```java

import com.alibaba.druid.pool.DruidDataSource;

public class PooleddbConfig {

public static DruidDataSource createDataSource() {

DruidDataSource dataSource = new DruidDataSource();

dataSource.setUrl("jdbc:mysql://localhost:3306/test");

dataSource.setUsername("root");

dataSource.setPassword("123456");

dataSource.setDriverClassName("com.mysql.jdbc.Driver");

dataSource.setInitialSize(5);

dataSource.setMinIdle(5);

dataSource.setMaxActive(20);

return dataSource;

}

}

```

三、pooleddb 的用法详解

pooleddb 的用法主要分为以下几个步骤:

1.创建数据源:通过调用 PooleddbConfig 类中的createDataSource() 方法创建一个数据源实例。

2.获取连接:调用数据源实例的 getConnection() 方法获取数据库连接。

3.执行 SQL 语句:使用获取到的连接执行 SQL 语句,进行数据库操作。

4.关闭连接:操作完成后,调用连接实例的 close() 方法关闭连接。

以下是一个简单的使用示例:

```java

import java.sql.Connection;

import java.sql.PreparedStatement;

import java.sql.ResultSet;

import java.sql.SQLException;

public class PooleddbDemo {

public static void main(String[] args) {

DruidDataSource dataSource =

PooleddbConfig.createDataSource();

try (Connection connection =

dataSource.getConnection();

PreparedStatement preparedStatement = connection.prepareStatement("SELECT * FROM test_table");

ResultSet resultSet =

preparedStatement.executeQuery()) {

while (resultSet.next()) {

System.out.println(resultSet.getString("column_name"));

}

} catch (SQLException e) {

e.printStackTrace();

}

}

}

```

四、pooleddb 的优点与应用场景

pooleddb 的优点主要体现在以下几点:

1.提高性能:通过复用数据库连接,避免了频繁创建和销毁连接导致的性能损耗。

2.降低资源消耗:减少数据库连接的创建和销毁,降低了系统资源消耗。

3.配置简单:pooleddb 的配置较为简单,开发者可以快速上手。

4.支持多种数据库:pooleddb 支持多种数据库,如 MySQL、Oracle、PostgreSQL 等。

应用场景:pooleddb 适用于需要频繁进行数据库操作的场景,如数据迁移、批量处理等。

同时,对于连接数有限的数据库,如 Oracle,pooleddb 可以有效解决连接数不足的问题。

五、总结

pooleddb 作为一款高性能、轻量级的数据库连接池组件,在实际应用中具有广泛的应用前景。