搜索引擎网络蜘蛛程序代码

搜索引擎spider爬虫(蜘蛛)原理

搜索引擎spider爬⾍(蜘蛛)原理做SEO的⼈应该要对搜索引擎的基本原理有⼀些了解,从搜索引擎发现⽹址到该页⾯拥有排名,以及后续更新整个过程中,搜索引擎到底是怎么⼯作的?你都需要了解。

对于专业的算法不必进⾏深⼊的研究,但是对于搜索引擎⼯作中的⽣命⼒和算法原理要有个简单的认知,这样才能更有效地开展SEO⼯作,知其然也要知其所以然;当然也有⼀些朋友不懂这些,照样做昨有声有⾊,但是有对搜索引擎⼯作原理,懂总⽐不懂好⼀点。

以往的SEO书藉中对这内容讲解都⽐较简单,希望在些能够尝试结合SEO实际⼯作和现象,更进⼀步剖析⼀下搜索引擎的⼯作原理,其实当你了解了搜索引擎的⼯作流程、策略和基本算法后,就可以在⼀定程序上避免因为不当操作⽽带来的不必要处罚,同也可以快速分析出很多搜索引擎搜索结果异常的原因。

有搜索⾏为的地⽅就有搜索引擎,站内搜索、全⽹搜索、垂直搜索等都⽤到搜索引擎;接下来,本⽂会根据从业认知,讨论⼀下全⽂搜索引擎的基本架构。

百度、⾕歌等综合搜索巨头肯定有着更为复杂的架构和检索技术,但宏观上基本原理都差不多的。

搜索引擎的⼤概架构如图2-1所⽰。

可以分成虚线左右两个部分:⼀部分是主动抓取⽹页进⾏⼀系列处理后建⽴索引,等待⽤户搜索;另⼀部分是分析⽤户搜索意图,展现⽤户所需要的搜索结果。

搜索引擎主动抓取⽹页,并进⾏内容处理、索引部分的流程和机制⼀般如下:1.派出spider按照⼀定策略把⽹页抓回到搜索引擎服务器;2.对抓回的⽹页进⾏链接抽离、内容处理,削除噪声、提取该页主题⽂本内容等;3.对⽹页的⽂本内容进⾏中⽂分词、去除停⽌词等;4.对⽹页内容进⾏分词后判断该页⾯内容与已索引⽹页是否有重复,剔除重复页,对剩余⽹页进⾏倒排索引,然后等待⽤户的检索。

当有⽤户进⾏查询后,搜索引擎⼯作的流程机制⼀般如下:1.先对⽤户所查询的关键词进⾏分词处理,并根据⽤户的地理位置和历史检索特征进⾏⽤户需求分析,以便使⽤地域性搜索结果和个性化搜索结果展⽰⽤户最需要的内容;2.查找缓存中是否有该关键词的查询结果,如果有,有为最快地呈现查询,搜索引擎会根据当下⽤户的各种信息判断其真正需求,对缓存中的结果进⾏微调或直接呈现给⽤户;3.如果⽤户所查询的关键词在缓存中不存在,那么就在索引库中的⽹页进⾏调取排名呈现,并将该关键词和对应的搜索结果加⼊到缓存中;4.⽹页排名是⽤户的搜索词和搜索需求,对索引库中⽹页进⾏相关性、重要性(链接权重分析)和⽤户体验的⾼低进⾏分析所得出的。

百度搜索引擎爬行蜘蛛IP大全及详解

百度搜索引擎爬行蜘蛛IP大全及详解作为一名合格的SEO站长,不仅要具备SEO优化技术,同时还要学会分析网站日志,了解百度搜素引擎的爬行痕迹。

百度搜素引擎的蜘蛛每爬行一次都会留下他的足迹,而这个足迹就是蜘蛛爬行过来的IP地址,据了解,蜘蛛爬行的IP地址非常多,而且每个地址都有着它自己的含义,下面博主大家整理了一套比较全面的百度搜素引擎爬行蜘蛛的IP和解释(仅做参考作用,具体以网站实际情况为准)。

百度搜素引擎爬行蜘蛛IP区段220.181.108.75~220.181.108.123 百度蜘蛛电信段IP123.125.71.12~123.125.71.117 百度蜘蛛联通段IP220.181.107.* 其他区段IP220.181.38.177 其他区段IP220.181.19.* 其他区段IP159.226.50.* 其他区段IP202.108.11.* 其他区段IP202.108.22.* 其他区段IP202.108.23.* 其他区段IP202.108.249.* 其他区段IP202.108.250.* 其他区段IP61.135.145.* 其他区段IP61.135.146.* 其他区段IP百度搜素引擎爬行蜘蛛IP 解析123.125.68.* 此区段的IP 量增加说明网站即将进入沙盒期或受罚被降权了 220.181.68.* 此区段的IP 量增加说明网站已经处于沙盒期或者站点被K 220.181.7.*此区段的IP 初次出现代表搜素引擎预备抓取该站点 123.125.66.* 此区段的IP 初次出现代表搜素引擎预备抓取该站点 121.14.89.*此区段的IP 出现了那么恭喜你的站点已经成功渡过考核期 203.208.60.* 此区段的IP 出现在新站上面比较多或者是异常的站点210.72.225.此区段的IP 出现属于搜素引擎巡逻,相当于现实中的城管 125.90.88.*此区段的IP 属于广东电信区段,一般用了站长工具的站点出现较多 220.181.108.*此区段的IP 属于百度搜素引擎抓取站点的IP ,爬行后24小时内基本放出页面 123.125.71.* 此区段的IP 属于内页爬行IP ,一般放出时间较长,因采集或伪原创原因,属于待定IP 220.181.108.95 此IP 段属于百度搜素引擎抓取站点首页的公用IP220.181.108.92 此IP 与上个IP 相似,不同的是此IP 会抓取首页以外的其他页面123.125.71.106 此IP 属于内页爬行IP ,爬行过后放出时间较慢,原创文章放出较快220.181.108.91 此IP 属于综合性IP ,抓取站点里的每个页面,一般会在24小时内放出220.181.108.75 此IP 属于最新页面抓取IP ,爬取文章页面较多,爬行后24小时内放出123.125.71.95此IP 属于内页爬行IP ,爬行过后放出时间较慢,原创文章放出较快 123.125.71.97 此IP 属于内页爬行IP ,爬行过后放出时间较慢,原创文章放出较快123.125.71.117 此IP 属于内页爬行IP ,爬行过后放出时间较慢,原创文章放出较快220.181.108.86 此IP 属于首页专用爬行IP ,返回状态码为304 0 0(代表暂未更新)220.181.108.89 此IP 属于首页专用爬行IP ,返回状态码为304 0 0(代表暂未更新)220.181.108.94 此IP 属于首页专用爬行IP ,返回状态码为304 0 0(代表暂未更新)220.181.108.97 此IP 属于首页专用爬行IP ,返回状态码为304 0 0(代表暂未更新)220.181.108.80 此IP 属于首页专用爬行IP ,返回状态码为304 0 0(代表暂未更新)220.181.108.77 此IP 属于首页专用爬行IP ,返回状态码为304 0 0(代表暂未更新)123.125.71.117 此IP 属于首页专用爬行IP ,返回状态码为304 0 0(代表暂未更新)220.181.108.83 此IP 属于首页专用爬行IP ,返回状态码为304 0 0(代表暂未更新)以上就是博主给大家整理的百度搜素引擎爬行蜘蛛IP 地址,因百度搜素引擎爬行蜘蛛IP 几乎半个月更新一次,所以百度并有详细的说明,以上蜘蛛IP 都是各位站长在日常运营中摸索出来的经验,仅做参考作用。

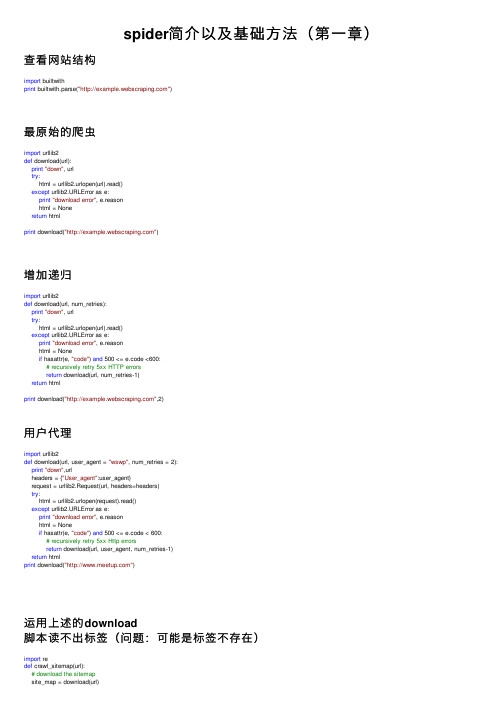

spider简介以及基础方法(第一章)

spider简介以及基础⽅法(第⼀章)查看⽹站结构import builtwithprint builtwith.parse("")最原始的爬⾍import urllib2def download(url):print"down", urltry:html = urllib2.urlopen(url).read()except urllib2.URLError as e:print"download error", e.reasonhtml = Nonereturn htmlprint download("")增加递归import urllib2def download(url, num_retries):print"down", urltry:html = urllib2.urlopen(url).read()except urllib2.URLError as e:print"download error", e.reasonhtml = Noneif hasattr(e, "code") and 500 <= e.code <600:# recursively retry 5xx HTTP errorsreturn download(url, num_retries-1)return htmlprint download("",2)⽤户代理import urllib2def download(url, user_agent = "wswp", num_retries = 2):print"down",urlheaders = {"User_agent":user_agent}request = urllib2.Request(url, headers=headers)try:html = urllib2.urlopen(request).read()except urllib2.URLError as e:print"download error", e.reasonhtml = Noneif hasattr(e, "code") and 500 <= e.code < 600:# recursively retry 5xx Http errorsreturn download(url, user_agent, num_retries-1)return htmlprint download("")运⽤上述的download脚本读不出标签(问题:可能是标签不存在)import redef crawl_sitemap(url):# download the sitemapsite_map = download(url)print"site_map", site_map# extract the sitemap linkslinks = re.findall('<loc>(.*?)</loc>', site_map)print'links', links# download each linkfor link in links:html = download(links)crawl_sitemap("/sitmap.xml")对ID进⾏遍历,直到出错为⽌import itertools # ⽆限迭代器for page in itertools.count(1):url = "/view/-%d" % pagehtml = download(url)if html is None:breakelse:pass若ID出现中间被删除,就⽆法连续⾃动退出,为了解决这种问题,脚本加⼊连续判断5次,若都为空,就结束import itertoolsmax_error = 5 # 最⼤错误值num_error = 0 # 现有错误for page in itertools.count(1):url = "/view/-%d" % pagehtml = download(url)if html is None:num_error += 1if num_error == max_error:break# 若连续5次错误,程序结束else:num_error = 0 # 若错误不是连续的,则变量归0链接爬⾍import redef get_link(html):"""return a list of links from html"""webpage_regex = pile('<a[^>]+href=["\'](.*?)["\']', re.IGNORECASE) # re.IGNORECASE 忽略⼤⼩写return webpage_regex.findall(html)def link_crawler(seed_url, link_regex):""""""crawl_queue = [seed_url]while crawl_queue:url = crawl_queue.pop()html = download(url)for link in get_link(html):if re.match(link_regex, link):crawl_queue.append(link)python HTTP模块requests 来实现⽀持代理的功能import urlparseproxy = ""opener = urllib2.build_opener()proxy_params = {urlparse.urlparse(url).scheme: proxy}opener.add_handler(urllib2.ProxyHandler(proxy_params))response = opener.open(request)新版本的download函数def download(url, user_agent="wswp", proxy=None, num_retries=2):print"DownLoading", urlheaders = {"User-agent": user_agent}request = urllib2.Request(url, headers=headers)opener = urllib2.build_opener()if proxy:proxy_params = {urlparse.urlparse(url).scheme: proxy}opener.add_handler(urllib2.ProxyHandler(proxy_params))try:html = opener.open(request).read()except urllib2.URLError as e:print"download error", e.reasonhtml = Noneif num_retries > 0:if hasattr(e, "code") and 500 <= e.code <600:# retry 5xx http errorhtml = download(url, user_agent, proxy, num_retries-1)return html下载限速(两次下载中添加延时)import timeimport datetimeclass Throttle:"""Add a delay between downloads to the same domain"""def__init__(self, delay):# amount of delay between downloads for each domainself.delay = delay# timestamp of when a domain was last accessedself.domains = {}def wait(self, url):domain = urlparse.urlparse(url).netloclast_accessed = self.domains.get(domain)if self.delay > 0 and last_accessed is not None:sleep_secs = self.delay - (datetime.datetime.now() - last_accessed).seconds if sleep_secs > 0:# domain has been accessd recently# so need to sleeptime.sleep(sleep_secs)# update the last accessed timeself.domains[domain] = datetime.datetime.now()实例操作延时throttle = Throttle(delay)throttle.wait(url)result = download(url, headers, proxy=proxy, num_retries=num_retries)"""爬⾍陷阱(有些⽹站会动态⽣成内容如:下⼀⽉,下⼀年这种⽆限递归)⽅法:添加深度限制,修改seen变量(该变量原本只记录访问过的链接,现在修改成为⼀个字典,增加了页⾯深度记录)"""def link_crawler(... , max_depth=2):max_depth = 2...depth = seen[url]if depth != max_depth:for link in links:if link not in seen:seen[link] = depth + 1crawl_queue.append(link)"""禁⽤该功能把max_depth设成负数就永远不会相等"""调⽤最终版本seed_url = "/index"link_regex = "/(index|view)"link_crawler(seed_url, link_regex, user_agent="BadCrawler") # user_agent="BadCrawler"⽤户代理被屏蔽程序运⾏不了link_crawler(seed_url, link_regex, max_depth=1) # 这是使⽤默认⽤户代理的,深度为1。

python 爬虫常规代码

python 爬虫常规代码Python爬虫常规代码是指用Python编写的用于网页数据抓取和提取的代码。

爬虫是一种自动化程序,可以模拟人类在网页浏览器中的行为,从而获取所需的信息。

在这篇文章中,我们将一步一步地回答关于Python 爬虫常规代码的问题,帮助读者了解如何编写自己的爬虫程序。

第一步:安装Python和必要的库首先,我们需要安装Python和一些必要的库来编写爬虫代码。

Python 是一种流行的编程语言,可以用于开发各种应用程序,包括爬虫。

对于Python的版本,我们建议使用Python 3.x。

然后,我们需要安装一些常用的爬虫库,例如requests和beautifulsoup4。

可以使用pip命令来安装它们:pip install requestspip install beautifulsoup4第二步:发送HTTP请求在编写爬虫代码之前,我们首先需要发送HTTP请求以获取网页的内容。

这可以使用requests库来实现。

以下是一个简单的例子:pythonimport requestsurl = "response = requests.get(url)if response.status_code == 200:content = response.textprint(content)在这个例子中,我们首先指定了要访问的URL,然后使用requests库的get方法发送一个GET请求。

如果响应的状态码是200,表示请求成功,我们就可以从response对象中获取网页内容,并打印出来。

第三步:解析网页内容获取网页的原始内容后,我们通常需要解析网页,提取所需的信息。

这可以使用beautifulsoup4库来实现。

下面是一个示例:pythonfrom bs4 import BeautifulSoup# 假设content是之前获取的网页内容soup = BeautifulSoup(content, "html.parser")# 使用soup对象进行解析在这个例子中,我们首先导入了BeautifulSoup类并创建了一个soup对象,该对象将用于解析网页内容。

百度搜索引擎蜘蛛IP大全

SEO进阶:各类百度蜘蛛IP到访的意义虽然百度近期表态百度并没有降权蜘蛛这一说,但是据优骑士旗下多个站点的百度蜘蛛抓取日志及众多网友的讨论,感觉不同的百度蜘蛛IP代表的意义还是有所不同的,另外近期多个站长工具的IP也冒充百度蜘蛛,引起SEO新人不必要的恐慌与浪费不必要的经历,本文就详细说明下大部分百度蜘蛛IP的区别!123.125.68.*这个蜘蛛经常来,别的来的少,表示网站可能要进入沙盒了,或被者降权。

220.181.68.*每天这个IP 段只增不减很有可能进沙盒或K站。

220.181.7.*、123.125.66.* 代表百度蜘蛛IP造访,准备抓取你东西。

121.14.89.*这个ip段作为度过新站考察期。

203.208.60.*这个ip段出现在新站及站点有不正常现象后。

210.72.225.*这个ip段不间断巡逻各站。

125.90.88.* 广东茂名市电信也属于百度蜘蛛IP 主要造成成分,是新上线站较多,还有使用过站长工具,或SEO综合检测造成的。

220.181.108.95这个是百度抓取首页的专用IP,如是220.181.108段的话,基本来说你的网站会天天隔夜快照,绝对错不了的,我保证。

220.181.108.92 同上98%抓取首页,可能还会抓取其他(不是指内页)220.181段属于权重IP段此段爬过的文章或首页基本24小时放出来。

123.125.71.106 抓取内页收录的,权重较低,爬过此段的内页文章不会很快放出来,因不是原创或采集文章。

220.181.108.91属于综合的,主要抓取首页和内页或其他,属于权重IP 段,爬过的文章或首页基本24小时放出来。

220.181.108.75重点抓取更新文章的内页达到90%,8%抓取首页,2%其他。

权重IP 段,爬过的文章或首页基本24小时放出来。

220.181.108.86专用抓取首页IP 权重段,一般返回代码是304 0 0 代表未更新。

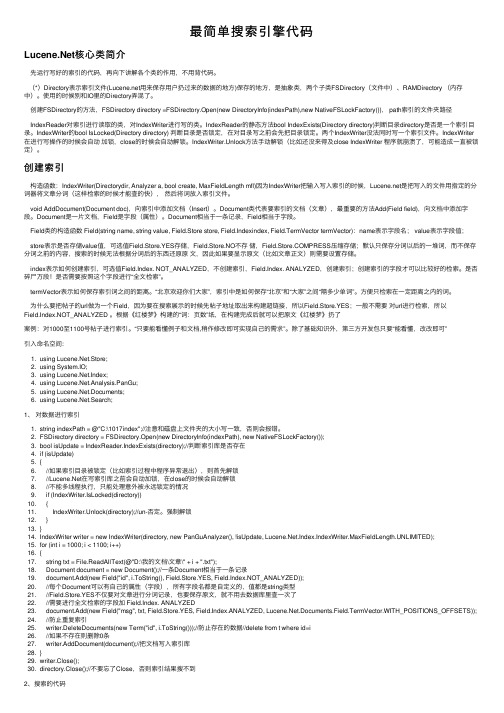

最简单搜索引擎代码

最简单搜索引擎代码核⼼类简介先运⾏写好的索引的代码,再向下讲解各个类的作⽤,不⽤背代码。

(*)Directory表⽰索引⽂件(⽤来保存⽤户扔过来的数据的地⽅)保存的地⽅,是抽象类,两个⼦类FSDirectory(⽂件中)、RAMDirectory (内存中)。

使⽤的时候别和IO⾥的Directory弄混了。

创建FSDirectory的⽅法,FSDirectory directory =FSDirectory.Open(new DirectoryInfo(indexPath),new NativeFSLockFactory()), path索引的⽂件夹路径IndexReader对索引进⾏读取的类,对IndexWriter进⾏写的类。

IndexReader的静态⽅法bool IndexExists(Directory directory)判断⽬录directory是否是⼀个索引⽬录。

IndexWriter的bool IsLocked(Directory directory) 判断⽬录是否锁定,在对⽬录写之前会先把⽬录锁定。

两个IndexWriter没法同时写⼀个索引⽂件。

IndexWriter 在进⾏写操作的时候会⾃动加锁,close的时候会⾃动解锁。

IndexWriter.Unlock⽅法⼿动解锁(⽐如还没来得及close IndexWriter 程序就崩溃了,可能造成⼀直被锁定)。

创建索引构造函数:IndexWriter(Directorydir, Analyzer a, bool create, MaxFieldLength mfl)因为IndexWriter把输⼊写⼊索引的时候,是把写⼊的⽂件⽤指定的分词器将⽂章分词(这样检索的时候才能查的快),然后将词放⼊索引⽂件。

void AddDocument(Document doc),向索引中添加⽂档(Insert)。

Document类代表要索引的⽂档(⽂章),最重要的⽅法Add(Field field),向⽂档中添加字段。

robots协议

robots协议 如何查看robots协议?怎么写? 对于seo来讲,robots⽂件⾮常重要。

搜索引擎爬⾍爬取的⽹站的第⼀个⽂件便是这个⽂件,这个⽂件告诉搜索引擎⽹站的那些内容可以被爬取,那些内容不能被爬取,或者说禁⽌爬取。

怎么查看l?可以使⽤这种办法,主域名/robots.txt。

怎么写robots协议? 当⼀个搜索蜘蛛访问⼀个站点时,它会⾸先检查该站点根⽬录下是否存在robots.txt,如果存在,搜索机器⼈就会按照该⽂件中的内容来确定访问的范围;如果该⽂件不存在,所有的搜索蜘蛛将能够访问⽹站上所有没有被⼝令保护的页⾯。

⼀、什么是Robots协议 Robots协议(也称为爬⾍协议、机器⼈协议等)的全称是“⽹络爬⾍排除标准”(Robots Exclusion Protocol),⽹站通过Robots协议告诉搜索引擎哪些页⾯可以抓取,哪些页⾯不能抓取,对于seo来讲,意义重⼤。

robots是⼀个协议,⽽不是⼀个命令。

robots.txt⽂件是⼀个⽂本⽂件,是放置在⽹站根⽬录下,使⽤任何⼀个常见的⽂本编辑器,就可以创建和编辑它。

robots.txt是搜索引擎中访问⽹站的时候要查看的第⼀个⽂件,其主要的作⽤就是告诉蜘蛛程序在服务器上什么⽂件是可以被查看的。

robots协议⽂件的写法及语法属性解释-seo 如果将⽹站视为⼀个房间,robots.txt就是主⼈在房间门⼝悬挂的“请勿打扰”或“欢迎进⼊”的提⽰牌。

这个⽂件告诉来访的搜索引擎哪些房间可以进⼊和参观,哪些房间因为存放贵重物品,或可能涉及住户及访客的隐私⽽不对搜索引擎开放。

但robots.txt不是命令,也不是防⽕墙,如同守门⼈⽆法阻⽌窃贼等恶意闯⼊者。

所以,seo建议各位站长仅当您的⽹站包含不希望被搜索引擎收录的内容时,才需要使⽤robots.txt⽂件,如果您希望搜索引擎收录⽹站上所有内容,请勿建⽴robots.txt⽂件。

⼆、Robots协议的原则 Robots协议是国际互联⽹界通⾏的道德规范,基于以下原则建⽴: 1、搜索技术应服务于⼈类,同时尊重信息提供者的意愿,并维护其隐私权; 2、⽹站有义务保护其使⽤者的个⼈信息和隐私不被侵犯。

搜索引擎的工作原理是什么

搜索引擎的工作原理是什么

搜索引擎的工作原理是通过爬虫程序(也叫网络蜘蛛或网络爬虫)对互联网上的网页进行自动收集和索引,并根据用户的搜索关键词呈现最相关的搜索结果。

首先,搜索引擎的爬虫程序会从一个初始网页(通常称为种子URL)开始,然后根据该网页上的链接递归地爬取其他网页。

爬虫会记录每个被访问的网页,并从中提取出网页内容、标题、关键词、链接等信息。

接下来,将这些信息存储在搜索引擎的索引数据库中。

索引数据库是一个结构化的数据库,其中包含了许多网页的关键词和链接信息。

搜索引擎使用复杂的算法将这些网页按照相关性进行排序,以便在用户进行搜索时能够快速呈现最相关的搜索结果。

当用户输入搜索关键词后,搜索引擎会根据关键词在索引数据库中进行匹配,并找出最相关的网页。

相关性的评估通常是基于关键词的频率、位置、网页的权重(例如,网页被其他高权威网页引用的次数)等因素进行计算。

最后,搜索引擎会将根据相关性排序的搜索结果呈现给用户。

搜索结果页面通常会显示页面的标题、简要摘要和链接,用户可以点击链接查看完整的网页内容。

总之,搜索引擎的工作原理是通过爬虫程序收集和索引网页信

息,利用复杂的算法计算搜索结果的相关性,并将最相关的搜索结果呈现给用户。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

搜索引擎/网络蜘蛛程序代码(转)2008-07-12 09:54国外开发的相关程序1、Nutch官方网站 /中文站点 /最新版本:Nutch 0.7.2 ReleasedNutch 是一个开源Java 实现的搜索引擎。

它提供了我们运行自己的搜索引擎所需的全部工具,可以建立自己内部网的搜索引擎,也可以针对整个网络建立搜索引擎。

自由(Free)而免费(Free)。

2、Lucene官方网站 中文站点 /Lucene是apache软件基金会 jakarta项目组的一个子项目,是一个开放源代码的全文检索引擎工具包[用Java写的],即它不是一个完整的全文检索引擎,而是一个全文检索引擎的架构,提供了完整的查询引擎和索引引擎,部分文本分析引擎(英文与德文两种西方语言)。

Lucene的目的是为软件开发人员提供一个简单易用的工具包,以方便的在目标系统中实现全文检索的功能,或者是以此为基础建立起完整的全文检索引擎。

3、Larbin: /index-eng.htmllarbin是一种开源的网络爬虫/网络蜘蛛,由法国的年轻人Sébastien Ailleret 独立开发。

larbin目的是能够跟踪页面的url进行扩展的抓取,最后为搜索引擎提供广泛的数据来源。

国内开发的相关程序1、SQLET - 开放源码的中文搜索引擎官方网站 /SQLET,是Search & Query &Link, 加后缀 let,表示小的,小型的意思.打算建立一个能搜上亿张网页的基于主题功能的中文搜索引擎.支持3种索引方式:MySql_table_Index,Lucene_Index,SQLET_Index.网页抓取可以保存在文件系统及数据库里。

自带WebServer.2、菲度垂直搜索引擎代码菲度 为一个垂直在线搜索的演示版,主要对国内一些购物站点进行搜索整理,语言:(c#)二、中文分词程序代码1、计算所汉语词法分析系统 ICTCLAS中国科学院计算技术研究所在多年研究基础上,耗时一年研制出了基于多层隐马模型的汉语词法分析系统 ICTCLAS(Institute of Computing Technology, Chinese Lexical Analysis System),该系统的功能有:中文分词;词性标注;未登录词识别。

分词正确率高达97.58%(最近的973专家组评测结果),基于角色标注的未登录词识别能取得高于90%召回率,其中中国人名的识别召回率接近98%,分词和词性标注处理速度为31.5KB/s。

ICTCLAS 和计算所其他14项免费发布的成果被中外媒体广泛地报道,国内很多免费的中文分词模块都或多或少的参考过ICTCLAS的代码。

下载页面:/project/project.php?proj_id=6由于 ICTCLAS 是由 C 语言写成的,现在主流的开发工具用起来不太方便,于是有一些热心的程序员把 ICTCLAS 改为 Java 和 C# 等其他语言。

(1)fenci,Java 的 ICTCLAS,下载页面:/printpage.asp?BoardID=2&id=11502(2)AutoSplit,另一个 Java 的 ICTCLAS,已经找不到下载页面,点击本地下载(3)小叮咚中文分词,曾经有下载页面,现在找不到了。

据作者介绍,从 ICTCLAS 中改进,有 Java,C# 和 C++ 三个版本,介绍页面:/accesine2、海量智能分词研究版海量智能计算技术研究中心为了使中文信息处理领域的研究者们能够共同分享海量智能中心的研究成果,共同提高中文信息处理水平,特此发布《海量智能分词研究版》,供专家、学者和爱好者进行研究。

下载页面:/cgi-bin/download/download.asp?id=8 3、其他(1)CSW中文智能分词组件运行环境:Windows NT、2000、XP 或更高,可以在 ASP,VB 等微软的开发语言中调用。

简介: CSW中文智能分词DLL组件,可将一段文本自动的按常规汉语词组进行拆分,并以指定方式进行分隔,且可对其拆分后的词组进行语义、词频标注。

其广范应用于各行各业的信息资料检索、分析。

下载页面:/(2) C# 写的中文分词组件据作者介绍,一个 DLL 文件,可以做中英文分词组件。

完全C#托管代码编写,独立开发。

下载页面:/article.asp?id=48三、开源spider一览spider是搜索引擎的必须模块.spider数据的结果直接影响到搜索引擎的评价指标.第一个spider程序由MIT的Matthew K Gray操刀该程序的目的是为了统计互联网中主机的数目Spier定义(关于Spider的定义,有广义和狭义两种).∙狭义:利用标准的http协议根据超链和web文档检索的方法遍历万维网信息空间的软件程序.∙广义:所有能利用http协议检索web文档的软件都称之为spider.其中Protocol Gives Sites Way To Keep Out The 'Bots Jeremy Carl, Web Week, Volume 1, Issue 7, November 1995 是和spider息息相关的协议,大家有兴趣参考.HeritrixHeritrix is the Internet Archive's open-source, extensible, web-scale,archival-quality web crawler project.Heritrix (sometimes spelled heretrix, or misspelled or missaid as heratrix/heritix/ heretix/heratix) is an archaic word for heiress(woman who inherits). Since our crawler seeks to collect and preserve the digital artifacts of our culture for the benefit of future researchers and generations, this name seemed apt.语言:JAVA, (下载地址)WebLech URL SpiderWebLech is a fully featured web site download/mirror tool in Java, which supports many features required to download websites and emulate standard web-browser behaviour as much as possible. WebLech is multithreaded and comes with a GUI console.语言:JAVA, (下载地址)JSpiderA Java implementation of a flexible and extensible web spider engine. Optional modules allow functionality to be added (searching dead links, testing the performance and scalability of a site, creating a sitemap, etc ..语言:JAVA, (下载地址)WebSPHINXWebSPHINX is a web crawler (robot, spider) Java class library, originally developed by Robert Miller of Carnegie Mellon University. Multithreaded, tollerant HTML parsing, URL filtering and page classification, pattern matching, mirroring, and more.语言:JAVA, (下载地址)PySolitairePySolitaire is a fork of PySol Solitaire that runs correctly on Windows and has a nice clean installer. PySolitaire (Python Solitaire) is a collection of more than 300 solitaire and Mahjongg games like Klondike and Spider.语言:Python , (下载地址)The Spider Web Network Xoops Mod TeamThe Spider Web Network Xoops Module Team provides modules for the Xoops community written in the PHP coding language. We develop mods and or take existing php script and port it into the Xoops format. High quality mods is our goal.语言:php , (下载地址)FetchgalsA multi-threaded web spider that finds free porn thumbnail galleries by visiting a list of known TGPs (Thumbnail Gallery Posts). It optionally downloads the located pictures and movies. TGP list is included. Public domain perl script running on Linux.语言:perl , (下载地址)Where SpiderThe purpose of the Where Spider software is to provide a database system for storing URL addresses. The software is used for both ripping links and browsing them offline. The software uses a pure XML database which is easy to export and import.语言:XML , (下载地址)Sperowider Website Archiving Suite is a set of Java applications, the primary purpose of which is to spider dynamic websites, and to create static distributable archives with a full text search index usable by an associated Java applet.语言:Java , (下载地址)SpiderPy is a web crawling spider program written in Python that allows users to collect files and search web sites through a configurable interface.语言:Python , (下载地址)Spider is a complete standalone Java application designed to easilyintegrate varied datasources. * XML driven framework * Scheduled pulling * Highly extensible * Provides hooks for custom post-processing and configuration语言:Java , (下载地址)WebLoupe is a java-based tool for analysis, interactive visualization (sitemap), and exploration of the information architecture and specific properties of local or publicly accessible websites. Based on web spider (or web crawler) technology.语言:java , (下载地址)ASpiderRobust featureful multi-threaded CLI web spider using apache commons httpclient v3.0 written in java. ASpider downloads any files matching your given mime-types from a website. Tries to reg.exp. match emails by default, logging all results using log4j.语言:java , (下载地址)larbinLarbin is an HTTP Web crawler with an easy interface that runs under Linux. It can fetch more than 5 million pages a day on a standard PC (with a good network).语言:C++, (下载地址)webloupeSpidered Data RetrievalSpiderPySperowider。