聚类分析中的数据类型

聚类分析的类型与选择

聚类分析的类型与选择聚类分析是一种常用的数据挖掘技术,可以将数据按照某种相似性进行分组。

通过聚类分析,我们可以发现数据中的潜在规律和结构,帮助我们更好地理解数据,并做出相应的决策。

本文将介绍聚类分析的常见类型,并讨论如何选择适合的聚类方法。

1.聚类分析的类型聚类分析有多种类型,常见的包括层次聚类分析和k均值聚类分析。

下面将分别介绍这两种聚类方法。

1.1层次聚类分析层次聚类分析是一种自下而上的聚类方法,它通过计算数据之间的相似度或距离,将相似的数据逐步合并成簇。

这种方法对数据的层次结构有较好的表示,能够发现不同层次的聚类结构。

层次聚类分析的优点之一是不需要预先指定聚类的个数,但计算复杂度较高,对大规模数据处理存在困难。

另外,它对异常值敏感,若存在异常值可能影响聚类结果。

1.2k均值聚类分析k均值聚类分析是一种基于划分的聚类方法,它将数据划分成k个互不重叠的簇,使得簇内的数据相似度较高,簇间的数据相似度较低。

该方法通过迭代计算簇的中心和重新分配数据来实现聚类。

k均值聚类分析的优点在于计算简单、效果较好,适用于大规模数据集。

但该方法对初始簇中心的选择较为敏感,容易收敛于局部最优解。

2.选择合适的聚类方法在选择聚类方法时,应根据数据的特点和目标进行判断。

下面列举几个常见的选择因素,供参考:2.1数据特点需要考虑数据的特点,如数据的维度、规模、密度等。

对于高维度数据,层次聚类分析可能更适用;而对于大规模数据,k均值聚类分析常常更为合适。

2.2聚类目标需要考虑聚类的目标。

如果希望发现层次结构、发现数据的内在关联性,层次聚类分析是一个不错的选择。

而如果目标是将数据划分成互不重叠的簇,并且希望聚类结果能较好地解释数据的差异性,k均值聚类分析更为合适。

2.3数据质量数据质量也是选择聚类方法的重要因素。

层次聚类分析对异常值比较敏感,如果数据中存在异常值,使用k均值聚类分析可能更好。

选择合适的聚类方法需要综合考虑数据特点、聚类目标和数据质量等因素。

聚类分析的类型与选择

聚类分析的类型与选择聚类分析是一种常用的数据分析方法,它可以将一组数据对象划分为若干个相似的子集,每个子集内的对象相似度较高,而不同子集之间的对象相似度较低。

聚类分析在各个领域都有广泛的应用,如市场细分、社交网络分析、图像处理等。

本文将介绍聚类分析的基本概念和常见的聚类算法,并讨论如何选择适合的聚类算法。

聚类分析的基本概念聚类分析是一种无监督学习方法,它不需要事先标记好的训练样本,而是通过计算数据对象之间的相似度来进行分类。

聚类分析的目标是找到合适的聚类数目和聚类中心,使得同一聚类内的对象相似度最高,而不同聚类之间的对象相似度最低。

聚类分析的类型根据聚类算法的不同原理和方法,聚类分析可以分为以下几种类型:基于距离的聚类基于距离的聚类是最常见和经典的聚类方法之一。

它通过计算数据对象之间的距离来确定聚类结果。

常用的基于距离的聚类算法有K-means、层次聚类和DBSCAN等。

K-meansK-means是一种迭代的、划分的聚类算法。

它首先随机选择K个初始聚类中心,然后将每个数据对象分配到与其最近的聚类中心,再根据新的聚类结果更新聚类中心,重复这个过程直到收敛。

K-means算法的优点是简单、高效,但对初始聚类中心的选择敏感。

层次聚类层次聚类是一种自底向上或自顶向下的聚类方法。

它通过计算数据对象之间的相似度或距离来构建一个层次结构,然后根据不同的划分准则将层次结构划分为若干个聚类。

层次聚类算法的优点是不需要事先指定聚类数目,但计算复杂度较高。

DBSCANDBSCAN是一种基于密度的聚类算法。

它通过定义一个邻域半径和一个最小密度阈值来确定核心对象和边界对象,并将核心对象连接起来形成一个聚类。

DBSCAN算法的优点是可以发现任意形状的聚类,但对参数的选择较为敏感。

基于概率模型的聚类基于概率模型的聚类是一种将数据对象看作随机变量的方法。

它假设数据对象服从某种概率分布,并通过最大似然估计或贝叶斯推断来确定聚类结果。

聚类分析的类型与选择

聚类分析的类型与选择聚类分析是一种常用的数据分析方法,用于将一组数据分成不同的类别或群组。

通过聚类分析,可以发现数据中的内在结构和模式,帮助我们更好地理解数据和做出决策。

在进行聚类分析时,我们需要选择适合的聚类算法和合适的聚类类型。

本文将介绍聚类分析的类型和选择方法。

一、聚类分析的类型1. 划分聚类(Partitioning Clustering)划分聚类是将数据集划分为不相交的子集,每个子集代表一个聚类。

常用的划分聚类算法有K-means算法和K-medoids算法。

K-means算法是一种迭代算法,通过计算数据点与聚类中心的距离来确定数据点所属的聚类。

K-medoids算法是一种基于对象之间的相似性度量的划分聚类算法。

2. 层次聚类(Hierarchical Clustering)层次聚类是将数据集划分为一个层次结构,每个层次代表一个聚类。

常用的层次聚类算法有凝聚层次聚类和分裂层次聚类。

凝聚层次聚类是自底向上的聚类过程,开始时每个数据点都是一个聚类,然后逐步合并相似的聚类,直到形成一个大的聚类。

分裂层次聚类是自顶向下的聚类过程,开始时所有数据点都属于一个聚类,然后逐步将聚类分裂成更小的聚类。

3. 密度聚类(Density Clustering)密度聚类是基于数据点之间的密度来进行聚类的方法。

常用的密度聚类算法有DBSCAN算法和OPTICS算法。

DBSCAN算法通过定义数据点的邻域密度来确定核心对象和边界对象,并将核心对象连接起来形成聚类。

OPTICS算法是DBSCAN算法的一种改进,通过计算数据点的可达距离来确定聚类。

二、选择聚类分析的方法在选择聚类分析的方法时,需要考虑以下几个因素:1. 数据类型不同的聚类算法适用于不同类型的数据。

例如,K-means算法适用于连续型数值数据,而DBSCAN算法适用于密度可测量的数据。

因此,在选择聚类算法时,需要根据数据的类型来确定合适的算法。

2. 数据量和维度聚类算法的计算复杂度与数据量和维度有关。

机器学习中的聚类分析方法

机器学习中的聚类分析方法机器学习中的聚类分析是一种数据挖掘技术,该技术可以将大量的数据集按照特定的规则进行分类和分组。

聚类分析主要用于数据分析、分类、数据挖掘和模式识别等领域,该技术的应用范围非常广泛,包括自然语言处理、图像识别、推荐系统等领域。

在聚类分析中,数据集合被分为不同的类别,每个类别都有相似的属性、特征或属性。

聚类分析方法可以通过设置聚类算法的参数来对数据进行分组,对于同一类别的数据,聚类算法能够产生一个类别标签。

聚类分析方法的优点在于能够将大量不同的数据进行有意义的分类,从而可以实现多种应用。

聚类分析方法的类型在机器学习中,聚类分析方法主要分为以下几种类型:1. 划分式聚类:这种方法通过将数据集分成互不重叠的子集来实现聚类。

在划分式聚类中,每个数据点只属于一个簇。

这种方法适合于数据集中每个数据点都属于同一个类别的情况。

划分式聚类算法包括K-Means算法等。

2. 层次式聚类:这种方法通过渐进地将数据点分成更多的子集来实现聚类。

在层次式聚类中,每个数据点都可以被分配到多个簇中。

这种方法适合于数据集中数据点属于多个类别的情况。

层次式聚类算法包括凝聚层次聚类、分裂式层次聚类等。

3. 密度式聚类:这种方法通过密度划分数据簇来实现聚类。

密度式聚类算法包括DBSCAN、OPTICS等。

4. 模型式聚类:这种方法通过使用统计学模型来实现聚类。

模型式聚类算法包括高斯混合模型等。

其中,划分式聚类和层次式聚类是常用的聚类分析方法。

K-Means聚类算法K-Means算法是目前应用最多的划分式聚类算法之一,其主要思想是将输入数据分成K个簇,每个簇有一个中心点,根据输入数据与各个簇的中心距离进行分类。

K-Means算法通过多次更新簇中心点和分类,来达到最终的聚类结果。

K-Means算法的优点在于其算法简单、时间复杂度较低,同时也适合于大规模数据和高维数据的处理。

但是,K-Means算法也存在着一些问题。

首先,初始点的随机性可能会对聚类结果产生较大的影响。

聚类算法常用的数据集

聚类算法常用的数据集聚类算法常用的数据集一、前言聚类是一种无监督学习方法,它将数据集中的对象分成若干个组,使得每个组内的对象相似度较高而组间的相似度较低。

聚类算法常用于数据挖掘、图像处理、自然语言处理等领域。

在聚类算法中,数据集的选择对结果具有重要影响。

本文将介绍聚类算法常用的数据集,以供研究者和爱好者参考。

二、UCI机器学习库UCI机器学习库(University of California, Irvine Machine Learning Repository)是一个公开的机器学习数据集库,包含了各种各样的数据集,其中不乏适合于聚类算法研究使用的数据集。

1. Iris 数据集Iris 数据集是一个经典的三分类问题,由 Fisher 在 1936 年提出。

该数据集包含了 150 个样本,每个样本有四个特征:花萼长度、花萼宽度、花瓣长度和花瓣宽度。

这四个特征可以用来判断鸢尾花属于哪一种类型:山鸢尾(Iris setosa)、变色鸢尾(Iris versicolor)或维吉尼亚鸢尾(Iris virginica)。

2. Wine 数据集Wine 数据集包含了 178 个样本,每个样本有 13 个特征,其中包括了酒的化学成分。

该数据集是一个三分类问题,用于区分三种不同来源的意大利葡萄酒。

3. Breast Cancer Wisconsin 数据集Breast Cancer Wisconsin 数据集包含了 569 个样本,每个样本有 30 个特征,用于诊断乳腺癌。

该数据集是一个二分类问题,用于区分良性肿瘤和恶性肿瘤。

三、KDD CupKDD Cup 是一个数据挖掘竞赛活动,由 ACM SIGKDD(ACM Special Interest Group on Knowledge Discovery and Data Mining)主办。

自1997年开始举办以来已经举办了十多次。

在 KDD Cup 中,参赛者需要对给定的数据进行分析和挖掘,并提交结果进行评估。

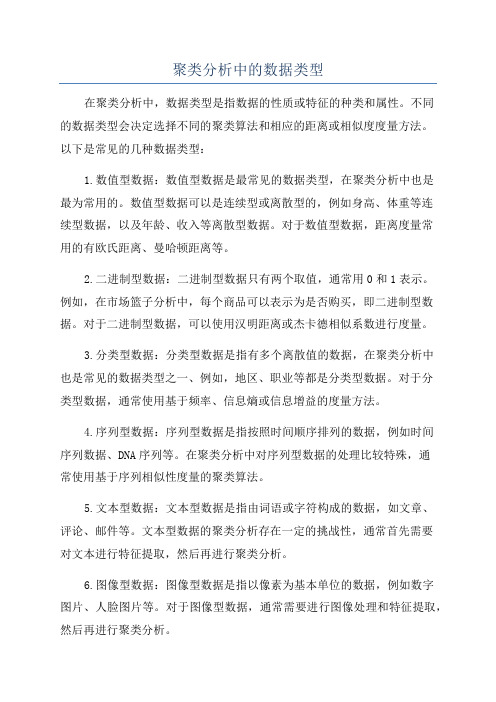

聚类分析中的数据类型

聚类分析中的数据类型在聚类分析中,数据类型是指数据的性质或特征的种类和属性。

不同的数据类型会决定选择不同的聚类算法和相应的距离或相似度度量方法。

以下是常见的几种数据类型:1.数值型数据:数值型数据是最常见的数据类型,在聚类分析中也是最为常用的。

数值型数据可以是连续型或离散型的,例如身高、体重等连续型数据,以及年龄、收入等离散型数据。

对于数值型数据,距离度量常用的有欧氏距离、曼哈顿距离等。

2.二进制型数据:二进制型数据只有两个取值,通常用0和1表示。

例如,在市场篮子分析中,每个商品可以表示为是否购买,即二进制型数据。

对于二进制型数据,可以使用汉明距离或杰卡德相似系数进行度量。

3.分类型数据:分类型数据是指有多个离散值的数据,在聚类分析中也是常见的数据类型之一、例如,地区、职业等都是分类型数据。

对于分类型数据,通常使用基于频率、信息熵或信息增益的度量方法。

4.序列型数据:序列型数据是指按照时间顺序排列的数据,例如时间序列数据、DNA序列等。

在聚类分析中对序列型数据的处理比较特殊,通常使用基于序列相似性度量的聚类算法。

5.文本型数据:文本型数据是指由词语或字符构成的数据,如文章、评论、邮件等。

文本型数据的聚类分析存在一定的挑战性,通常首先需要对文本进行特征提取,然后再进行聚类分析。

6.图像型数据:图像型数据是指以像素为基本单位的数据,例如数字图片、人脸图片等。

对于图像型数据,通常需要进行图像处理和特征提取,然后再进行聚类分析。

7.时间序列数据:时间序列数据是指按照时间顺序排列的数据,例如股票价格、气温、销售数据等。

对于时间序列数据的聚类分析,常常需要考虑时间的相关性和趋势性,常用的方法包括滑动窗口法、傅里叶变换等。

这些仅仅是常见的数据类型,实际应用中可能还存在其他类型的数据。

在选择聚类算法和度量方法时,需要根据具体的数据类型进行选择,以便获得更好的聚类结果。

聚类分析(孤立点分析)

例如,如果离平均值偏差3或更大的对象被认为是孤立点,假设一 个正态分布,那么这个定义能够被一个DB(0.9988,0.13σ)孤立点所 概括

17

基于距离的异常检测

指定参数pct和dmin,如果数据集合D中的 对象至少有pct部分与对象o的距离大于 dmin,则称对象o是以pct和dmin为参数的 基于距离的异常,记为DB(pct,dmin)。

15

基于统计学的孤立点检测

缺点 绝大多数检验是针对单个属性的, 而许多数据挖掘问题要 求在多维空间中发现孤立点

统计学方法要求关于数据集合参数的知识(如, 数据分布), 但是在许多情况下, 数据分布可能是未知的

当没有特定的检验时, 统计学方法不能确保所有的孤立点 被发现; 或者观察到的分布不能恰当地被任何标准的分布 来模拟

19

基于偏离的孤立点检测

通过检查一组对象的主要特征来确定孤立点 与给出的描述偏离的对象被认为是孤立点 序列异常技术(sequential exception technique)

模仿人类从一系列推测类似的对象中识别异常对象的方式

术语 异常集(exception set): 它是偏离或孤立点的集合, 被定义 为某类对象的最小子集, 这些对象的去除会导致剩余集 合的相异度的最大减少 相异度函数(dissimilarity function):是满足如下条件的 任意函数:当给定一组对象时,如果对象间相似,返值 就较小。对象间的相异度越大,函数返回的值就越大

13

基于统计学的孤立点检测

结果非常依赖于模型F的选择

Oi可能在一个模型下是孤立点, 在另一个模型下是非常有 效的值

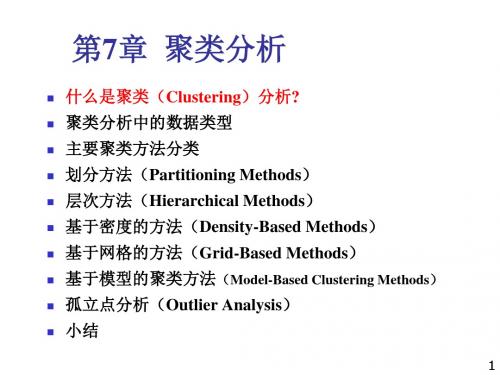

第7章 聚类分析汇总

处理不同属性类型的能力

实际应用涉及不同的数据类型,i.e. 混合了数值和分类数据

基于距离的聚类趋向于发现具有相近尺度和密度的球状簇

发现任意形状的聚类

一个簇可能是任意形状的

6

数据挖掘对聚类的要求(续)

用于决定输入参数的领域知识最小化

许多聚类算法要求用户输入一定的参数, 如希望产生的 簇的数目.聚类结果对于输入参数十分敏感 参数难以确定, 增加了用户的负担, 使聚类质量难以控制 一些聚类算法对于噪音数据敏感, 可能导致低质量的聚 类结果 现实世界中的数据库大都包含了孤立点, 空缺, 或者错误 的数据 一些聚类算法对于输入数据的顺序是敏感的, 以不同的 次序输入会导致不同的聚类

d (i, j) q (| x x |q | x x |q ... | x x |q ) i1 j1 i2 j2 ip jp

ห้องสมุดไป่ตู้

相异度/相似度矩阵

相似性用距离函数表示, 通常记作 d(i, j)

对于区间标度变量, 二元变量, 标称变量, 序数和比例 标度变量, 距离函数的定义通常是很不相同的. 根据应用和数据语义, 不同的变量应赋予不同的权.

11

聚类分析的数据类型

区间标度变量(Interval-scaled variables) 二元变量(Binary variables) 标称(名词性), 序数, 和比例标度变量(Nominal, ordinal, and ratio variables)

小结

9

数据结构

数据矩阵 (two modes)

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

聚类分析中的数据类型

1. Interval-scaled variables:区间标度变量 1.1 什么是区间标度变量?

区间标度变量是一个线性标度的连续变量。

典型的例子包括重量和高度,经度和纬度坐标,以及大气温度。

1.2 怎样将一个变量的数据标准化?

为了避免对度量单位选择的依赖,数据应当标准化。

为了实现度量值的标准化,一种方法是将原来的度量值转换为无单位的值。

1.3 度量值变换

给定一个变量f 的度量值,可以进行如下的变换:

1)计算平均的绝对偏差(mean absolute deviation )sf :

nf f f f nf f f f f n f f f f

f x x x n

m f mf n f x x x m x m x m x n s

2121211,,1

的平均值,即是个度量值,的是这里的 2)计算标准化的度量值,z-score :

f

f

f i if s m x z -

1.4 举例

Age: 18; 22; 25; 42; 28; 43; 33; 35;56; 28

6

.08

.833286

.28.83356,2.08.83335,08.833331

.18.83343,6.08.83328,0.18.833429

.08.83325,25.18.83322,7.18.833188.83328335633353333334333283342332533223318101332856353343284225221810

1

10987654321

z z z z z z z z z z s m age age

2. Binary variables:二进制变量 2.1 二进制数据的列联表

2.2 简单匹配系数(simple matching coefficient ):

不变的,如果二进制变量是对称的。

d

c b a c

b j i d

,

2.3 Jaccard 系数:

非不变的,如果二进制变量是非对称的。

c

b a c

b j i d

,

1) Gender 是对称属性,其它属性都是非对称属性 2) 设Y 、P 为1,N 为0。

求解:Jack 与Mary 、Jack 与Jim 和Jim 与Mary 的相似度。

解:因为Gender 是对称属性,而其他属性都是非对称的,所以构建列联表时忽略Gender 属性。

构建Jack 与Mary 的列联表 考虑 Name Fever Cough Test-1 Test-2 Test-3 Test-4

Jack Y N P N N N Mary Y N P N P N 即 Name Fever Cough Test-1 Test-2 Test-3 Test-4 Jack 1 0 1 0 0 0 Mary

1

1

1

a 标记为红色,d 标记为蓝色,c 标记为绿色,构建列联表如下:

根据Jaccard 系数的计算公式得

33.03

1

10210,

c b a c b Mary Jack d

构建Jack 与Mary 的列联表 考虑 Name Fever Cough Test-1 Test-2 Test-3 Test-4 Jack Y N P N N N Jim Y

P

N

N

N

N

得 Name Fever Cough Test-1 Test-2 Test-3 Test-4 Jack 1 0 1 0 0 0 Mary

1

1

a 标记为红色,d 标记为蓝色,c 标记为绿色,

b 标记为黄色,构建列联表如下:

根据Jaccard 系数的计算公式得

67.03

2

11111,

c b a c b Jim Jack d

构建Jack 与Mary 的列联表 考虑 Name Fever Cough Test-1 Test-2 Test-3 Test-4 Jim Y P N N N N Mary Y N P N P N 即 Name Fever Cough Test-1 Test-2 Test-3 Test-4 Jim 1 1 0 0 0 0 Mary

1

1

1

a 标记为红色,d 标记为蓝色,c 标记为绿色,

b 标记为黄色,构建列联表如下:

根据Jaccard 系数的计算公式得

75.04

3

21121,

c b a c b Mary Jim d

3. Nominal variables :定类变量(名义变量)

二进制变量的一般形式,可以处理超过2个的情况。

例如Red ,Yellow ,Blue ,Green 。

3.1 方法1:简单匹配 属性的个数匹配的个数;::,,p m p

m

p j i d 3.1.1 举例 Color1 Color2 Color3 Color4 Color5 A Red Red Yellow Blue Blue

B

Red

Green

Green

Green

Blue

红色标记匹配项,即m=2,蓝色标记属性个数,即p=5 根据公式得

6.05

3

525,

p m p B A d 3.2 方法2:大二元变量

以3.1.1中例子来说明创建新的二进制变量

对于 可转换为 C1.Red C1.Blue C1.Green C1.Yello C2.R C2.B C2.G C2.Y ……

A 1 0 0 0 1 0 0 0 B

1

1

转换后,可用二进制变量的算法计算相似度,具体算法参见第2节。

4. Ordinal variables :定序变量(顺序变量) 4.1 定序变量的几个要点:

4.1.1定序变量即可以是连续的也可以是离散的。

4.1.2 顺序很重要。

例如rank

4.1.3 可以以区间标度变量的方式处理。

4.2 根据区间标度变量的算法,

1) 中。

,并使变量映射到范围个对象中的第替代变量用替代的用101

1,,1,i f M r z x M r rank x f f i f i f

i f f i f i

2) 用interval-scaled variables 的方法计算相异性。

4.3 举例

对于成绩的集合{80,70,30,50}

对该集合排序得{80,70,50,30},生成排序后集合的一个rank={1,2,3,4}

44,3,2,1 f if M r ,则令

根据公式计算得

11

41

41

1321413113

1

14121101

41

11

144332211

f f f f f f

f f f f f f M r z M r z M r z M r z

5. Ratio-scaled variables :定比标度变量(比例标度变量) 这个没讲例子,应该不考。

6. 混合类型

6.1 一个数据库中可能包含所有6种类型的变量。

Color1 Color2 Color3 Color4 Color5 A Red Red Yellow Blue Blue B Red

Green

Green

Green

Blue。