生存分析-随机森林实验与代码

分类分析--随机森林(基于传统决策树、基于条件推断树)

分类分析--随机森林(基于传统决策树、基于条件推断树)分类分析--随机森林随机森林(random forest)是⼀种组成式的有监督学习⽅法。

在随机森林中,我们同时⽣成多个预测模型,并将模型的结果汇总以提升分类准确率。

随机森林的算法涉及对样本单元和变量进⾏抽样,从⽽⽣成⼤量决策树。

对每个样本单元来说,所有决策树依次对其进⾏分类。

所有决策树预测类别中的众数类别即为随机森林所预测的这⼀样本单元的类别。

假设训练集中共有N个样本单元,M个变量,则随机森林算法如下。

(1) 从训练集中随机有放回地抽取N个样本单元,⽣成⼤量决策树。

(2) 在每⼀个节点随机抽取m<M个变量,将其作为分割该节点的候选变量。

每⼀个节点处的变量数应⼀致。

(3) 完整⽣成所有决策树,⽆需剪枝(最⼩节点为1)。

(4) 终端节点的所属类别由节点对应的众数类别决定。

(5) 对于新的观测点,⽤所有的树对其进⾏分类,其类别由多数决定原则⽣成。

⽣成树时没有⽤到的样本点所对应的类别可由⽣成的树估计,与其真实类别⽐较即可得到袋外预测(out-of-bag,OOB)误差。

1 基于传统决策树⽣成随机森林randomForest包中的randomForest()函数可⽤于⽣成随机森林。

函数默认⽣成500棵树,并且默认在每个节点处抽取sqrt(M)个变量,最⼩节点为1。

如下代码给出了⽤随机森林算法对乳腺癌数据预测恶性类的代码和结果。

(1)随机森林library(randomForest)set.seed(1234)fit.forest <- randomForest(class~., data=df.train, na.action=na.roughfix, importance=TRUE)#⽣成随机森林,na.action=na.roughfix参数可将数值变量中的缺失值替换成对应列的中位数,类别变量中的缺失值替换成对应列的众数类(若有多个众数则随机选⼀个)。

matlab随机森林代码解释

Title: Explaining MATLAB Random Forest Code随机森林算法(Random Forest)是一种强大的机器学习方法,它在数据挖掘和预测分析中被广泛应用。

MATLAB作为一种强大的科学计算软件,提供了丰富的工具箱和函数,可以轻松实现随机森林算法。

本文将对MATLAB中随机森林算法的代码进行解释,帮助读者全面理解该算法的实现过程和原理。

1. 基本概念在开始解释MATLAB中的随机森林代码之前,我们先来回顾一下随机森林算法的基本概念。

随机森林是通过构建多个决策树并将它们组合来实现分类或回归分析的一种集成学习方法。

每棵决策树在随机选择的特征子集上进行训练,最终通过投票或取平均值的方式来进行预测。

这样的集成学习方法能够降低过拟合的风险,提高预测精度。

2. MATLAB中的随机森林代码在MATLAB中,随机森林算法的代码可以通过集成学习工具箱(Statistics and Machine Learning Toolbox)来实现。

我们需要准备好训练数据和测试数据,然后通过调用TreeBagger类来构建随机森林模型。

接下来,我们可以使用predict方法对新的数据进行预测。

在具体的代码实现过程中,我们需要传入一些参数,比如决策树的数量、要选择的特征子集的大小等。

这些参数可以根据实际情况进行调整,以获得最佳的模型性能。

另外,通过使用交叉验证等方法,可以对模型进行评估和优化。

3. 代码解释让我们来看一段MATLAB中的随机森林代码,以更好地理解其实现过程:```matlab% 准备训练数据和测试数据load fisheririsX = meas;Y = species;rng(1); % 设置随机种子% 构建随机森林模型numTrees = 100;Mdl = TreeBagger(numTrees, X, Y, 'Method', 'classification','OOBPrediction', 'on');% 预测新数据Xtest = [5, 3, 1, 0.5];[label, score] = predict(Mdl, Xtest);disp(['Predicted species: ' label{1}]);```在上面的代码中,我们首先加载了鸢尾花数据集,并准备好了训练数据X和标签Y。

随机森林参数说明

随机森林参数说明为什么要调整机器学习算法?⼀个⽉以前,我在kaggle上参加了⼀个名为TFI的⽐赛。

我第⼀次提交的结果在50%。

我不懈努⼒在特征⼯程上花了超过2周的时间,勉强达到20%。

出乎我意料的事是,在调整机器学习算法参数之后,我能够达到前10%。

这是这就是机器学习算法参数调优的重要性。

随机森林是在⼯业界中使⽤的最简单的机器学习⼯具之⼀。

在我们以前的⽂章中,我们已经向您介绍了随机森林和和CART模型进⾏了对⽐。

机器学习⼯具包正由于这些算法的表现⽽被⼈所熟知。

随机森林是什么?随机森林是⼀个集成⼯具,它使⽤观测数据的⼦集和变量的⼦集来建⽴⼀个决策树。

它建⽴多个这样的决策树,然后将他们合并在⼀起以获得更准确和稳定的预测。

这样做最直接的事实是,在这⼀组独⽴的预测结果中,⽤投票⽅式得到⼀个最⾼投票结果,这个⽐单独使⽤最好模型预测的结果要好。

我们通常将随机森林作为⼀个⿊盒⼦,输⼊数据然后给出了预测结果,⽆需担⼼模型是如何计算的。

这个⿊盒⼦本⾝有⼏个我们可以摆弄的杠杆。

每个杠杆都能在⼀定程度上影响模型的性能或资源 -- 时间平衡。

在这篇⽂章中,我们将更多地讨论我们可以调整的杠杆,同时建⽴⼀个随机林模型。

调整随机森林的参数/杠杆随机森林的参数即可以增加模型的预测能⼒,⼜可以使训练模型更加容易。

以下我们将更详细地谈论各个参数(请注意,这些参数,我使⽤的是Python常规的命名法):1.使模型预测更好的特征主要有3类特征可以被调整,以改善该模型的预测能⼒:A. max_features:随机森林允许单个决策树使⽤特征的最⼤数量。

Python为最⼤特征数提供了多个可选项。

下⾯是其中的⼏个:1. Auto/None :简单地选取所有特征,每颗树都可以利⽤他们。

这种情况下,每颗树都没有任何的限制。

2. sqrt :此选项是每颗⼦树可以利⽤总特征数的平⽅根个。

例如,如果变量(特征)的总数是100,所以每颗⼦树只能取其中的10个。

【原创】R语言线性回归,岭回归,决策树,随机森林数据挖掘分析报告(附代码数据)

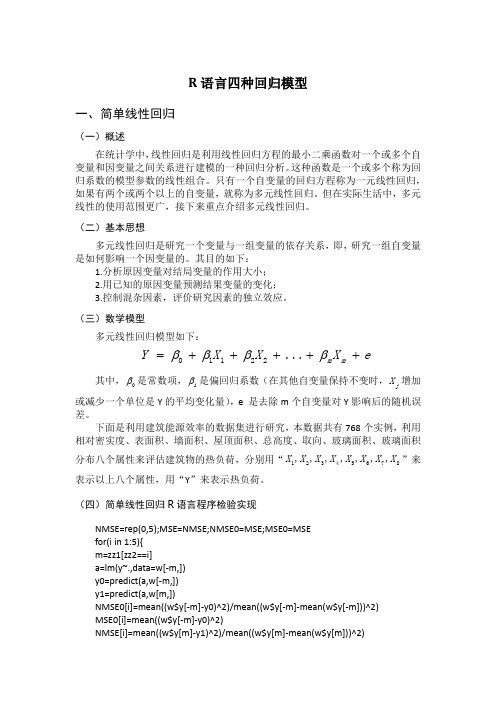

R 语言四种回归模型一、简单线性回归(一)概述在统计学中,线性回归是利用线性回归方程的最小二乘函数对一个或多个自变量和因变量之间关系进行建模的一种回归分析。

这种函数是一个或多个称为回归系数的模型参数的线性组合。

只有一个自变量的回归方程称为一元线性回归,如果有两个或两个以上的自变量,就称为多元线性回归。

但在实际生活中,多元线性的使用范围更广,接下来重点介绍多元线性回归。

(二)基本思想多元线性回归是研究一个变量与一组变量的依存关系,即,研究一组自变量是如何影响一个因变量的。

其目的如下:1.分析原因变量对结局变量的作用大小;2.用已知的原因变量预测结果变量的变化;3.控制混杂因素,评价研究因素的独立效应。

(三)数学模型多元线性回归模型如下:01122...m m Y X X X e ββββ=+++++其中,0β是常数项,i β是偏回归系数(在其他自变量保持不变时,j X 增加或减少一个单位是Y 的平均变化量),e 是去除m 个自变量对Y 影响后的随机误差。

下面是利用建筑能源效率的数据集进行研究,本数据共有768个实例,利用相对密实度、表面积、墙面积、屋顶面积、总高度、取向、玻璃面积、玻璃面积分布八个属性来评估建筑物的热负荷,分别用“12345678,,,,,,,X X X X X X X X ”来表示以上八个属性,用“Y ”来表示热负荷。

(四)简单线性回归R 语言程序检验实现NMSE=rep(0,5);MSE=NMSE;NMSE0=MSE;MSE0=MSE for(i in 1:5){m=zz1[zz2==i] a=lm(y~.,data=w[-m,]) y0=predict(a,w[-m,]) y1=predict(a,w[m,])NMSE0[i]=mean((w$y[-m]-y0)^2)/mean((w$y[-m]-mean(w$y[-m]))^2) MSE0[i]=mean((w$y[-m]-y0)^2)NMSE[i]=mean((w$y[m]-y1)^2)/mean((w$y[m]-mean(w$y[m]))^2)MSE[i]=mean((w$y[m]-y1)^2)}(MMSE0=mean(MSE0));(MNMSE0=mean(NMSE0)) [1] 8.502939 [1] 0.08364299(MMSE=mean(MSE));(MNMSE=mean(NMSE)) [1] 8.673251 [1] 0.08564455由输出结果可知,多元线性回归训练集的均方误差为8.502939,标准化的均方误差为0.08364299,测试集的均方误差为8.673251,标准化的均方误差为0.08564455。

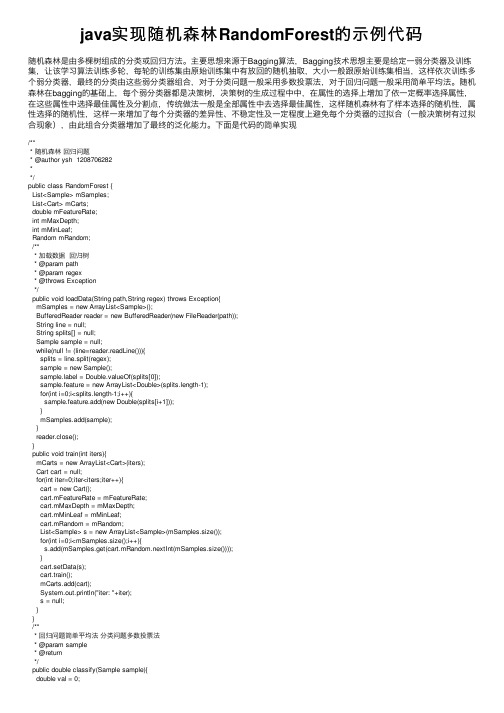

java实现随机森林RandomForest的示例代码

java实现随机森林RandomForest的⽰例代码随机森林是由多棵树组成的分类或回归⽅法。

主要思想来源于Bagging算法,Bagging技术思想主要是给定⼀弱分类器及训练集,让该学习算法训练多轮,每轮的训练集由原始训练集中有放回的随机抽取,⼤⼩⼀般跟原始训练集相当,这样依次训练多个弱分类器,最终的分类由这些弱分类器组合,对于分类问题⼀般采⽤多数投票法,对于回归问题⼀般采⽤简单平均法。

随机森林在bagging的基础上,每个弱分类器都是决策树,决策树的⽣成过程中中,在属性的选择上增加了依⼀定概率选择属性,在这些属性中选择最佳属性及分割点,传统做法⼀般是全部属性中去选择最佳属性,这样随机森林有了样本选择的随机性,属性选择的随机性,这样⼀来增加了每个分类器的差异性、不稳定性及⼀定程度上避免每个分类器的过拟合(⼀般决策树有过拟合现象),由此组合分类器增加了最终的泛化能⼒。

下⾯是代码的简单实现/*** 随机森林回归问题* @author ysh 1208706282**/public class RandomForest {List<Sample> mSamples;List<Cart> mCarts;double mFeatureRate;int mMaxDepth;int mMinLeaf;Random mRandom;/*** 加载数据回归树* @param path* @param regex* @throws Exception*/public void loadData(String path,String regex) throws Exception{mSamples = new ArrayList<Sample>();BufferedReader reader = new BufferedReader(new FileReader(path));String line = null;String splits[] = null;Sample sample = null;while(null != (line=reader.readLine())){splits = line.split(regex);sample = new Sample();bel = Double.valueOf(splits[0]);sample.feature = new ArrayList<Double>(splits.length-1);for(int i=0;i<splits.length-1;i++){sample.feature.add(new Double(splits[i+1]));}mSamples.add(sample);}reader.close();}public void train(int iters){mCarts = new ArrayList<Cart>(iters);Cart cart = null;for(int iter=0;iter<iters;iter++){cart = new Cart();cart.mFeatureRate = mFeatureRate;cart.mMaxDepth = mMaxDepth;cart.mMinLeaf = mMinLeaf;cart.mRandom = mRandom;List<Sample> s = new ArrayList<Sample>(mSamples.size());for(int i=0;i<mSamples.size();i++){s.add(mSamples.get(cart.mRandom.nextInt(mSamples.size())));}cart.setData(s);cart.train();mCarts.add(cart);System.out.println("iter: "+iter);s = null;}}/*** 回归问题简单平均法分类问题多数投票法* @param sample* @return*/public double classify(Sample sample){double val = 0;for(Cart cart:mCarts){val += cart.classify(sample);}return val/mCarts.size();}/*** @param args* @throws Exception*/public static void main(String[] args) throws Exception {// TODO Auto-generated method stubRandomForest forest = new RandomForest();forest.loadData("F:/2016-contest/20161001/train_data_1.csv", ",");forest.mFeatureRate = 0.8;forest.mMaxDepth = 3;forest.mMinLeaf = 1;forest.mRandom = new Random();forest.mRandom.setSeed(100);forest.train(100);List<Sample> samples = Cart.loadTestData("F:/2016-contest/20161001/valid_data_1.csv", true, ","); double sum = 0;for(Sample s:samples){double val = forest.classify(s);sum += (bel)*(bel);System.out.println(val+" "+bel);}System.out.println(sum/samples.size()+" "+sum);System.out.println(System.currentTimeMillis());}}以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

机器学习技法之随机森林(RandomForest)

机器学习技法之随机森林(RandomForest)森林顾名思义就是有很多树,这⾥的树当然就是决策树。

实际上随机森林就是将 fully-grown C&RT decision tree 作为 bagging 基模型(base model)。

\[\text{random forest (RF) = bagging + fully-grown C\&RT decision tree} \]bagging 会减⼩⽅差(variance),⽽⼀颗完全长成树的⽅差会很⼤,两种相互补⾜。

所以随机森林有以下优点:highly parallel/efficient to learn(效率⾼,可并⾏处理)inherit pros of C&RT(继承 C&RT 的优点)eliminate cons of fully-grown tree(弥补完全长成树的缺点)随机特征空间(Feature Expansion/Projection)在 bagging 中使⽤ bootstrap 获取随机数据,实现多样化。

那么还有什么⽅法呢,那便是从特征出发,类似于⾮线性转换函数,挖掘出不⼀样的特征空间。

随机森林中提出两种⽅法特征映射和特征扩展。

特征映射(Projection)特征映射实际上是从原来的特征 \(\mathbf{x}\) 中随机选择选取 \(d^{\prime}\) 个特征。

该映射函数 \(\Phi ( \mathbf { x } )\) 实现如下:\[\text { when sampling index } i _ { 1 } , i _ { 2 } , \ldots , i _ { \alpha ^ { \prime } } : \Phi ( \mathbf { x } ) = \left( x _ { i _ { 1 } } , x _ { i _ { 2 } } , \ldots , x _ { i _ { d ^ { \prime } } } \right) \]同时建议 \(d^{\prime} \ll d\),这样的话对于 \(d\) 很⼤时,可以提⾼效率。

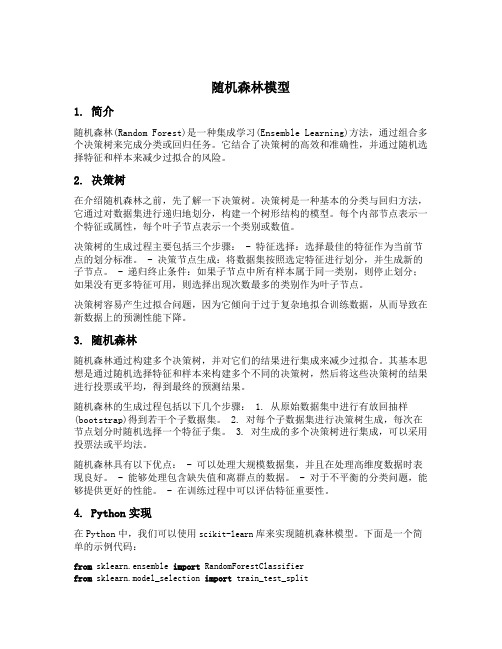

随机森林模型python代码

随机森林模型1. 简介随机森林(Random Forest)是一种集成学习(Ensemble Learning)方法,通过组合多个决策树来完成分类或回归任务。

它结合了决策树的高效和准确性,并通过随机选择特征和样本来减少过拟合的风险。

2. 决策树在介绍随机森林之前,先了解一下决策树。

决策树是一种基本的分类与回归方法,它通过对数据集进行递归地划分,构建一个树形结构的模型。

每个内部节点表示一个特征或属性,每个叶子节点表示一个类别或数值。

决策树的生成过程主要包括三个步骤: - 特征选择:选择最佳的特征作为当前节点的划分标准。

- 决策节点生成:将数据集按照选定特征进行划分,并生成新的子节点。

- 递归终止条件:如果子节点中所有样本属于同一类别,则停止划分;如果没有更多特征可用,则选择出现次数最多的类别作为叶子节点。

决策树容易产生过拟合问题,因为它倾向于过于复杂地拟合训练数据,从而导致在新数据上的预测性能下降。

3. 随机森林随机森林通过构建多个决策树,并对它们的结果进行集成来减少过拟合。

其基本思想是通过随机选择特征和样本来构建多个不同的决策树,然后将这些决策树的结果进行投票或平均,得到最终的预测结果。

随机森林的生成过程包括以下几个步骤: 1. 从原始数据集中进行有放回抽样(bootstrap)得到若干个子数据集。

2. 对每个子数据集进行决策树生成,每次在节点划分时随机选择一个特征子集。

3. 对生成的多个决策树进行集成,可以采用投票法或平均法。

随机森林具有以下优点: - 可以处理大规模数据集,并且在处理高维度数据时表现良好。

- 能够处理包含缺失值和离群点的数据。

- 对于不平衡的分类问题,能够提供更好的性能。

- 在训练过程中可以评估特征重要性。

4. Python实现在Python中,我们可以使用scikit-learn库来实现随机森林模型。

下面是一个简单的示例代码:from sklearn.ensemble import RandomForestClassifierfrom sklearn.model_selection import train_test_splitfrom sklearn.metrics import accuracy_score# 准备数据集X, y = load_dataset() # 加载特征矩阵和标签向量# 划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, rando m_state=42)# 创建随机森林分类器对象rf = RandomForestClassifier(n_estimators=100)# 在训练集上训练模型rf.fit(X_train, y_train)# 在测试集上进行预测y_pred = rf.predict(X_test)# 计算准确率accuracy = accuracy_score(y_test, y_pred)print(f"Accuracy: {accuracy}")在上述示例中,我们首先加载数据集,然后使用train_test_split函数将数据集划分为训练集和测试集。

随机森林算法介绍R语言实现

随机森林算法介绍R语言实现随机森林算法介绍及R语言实现随机森林算法介绍算法介绍:简单的说,随机森林就是用随机的方式建立一个森林,森林里面有很多的决策树,并且每棵树之间是没有关联的。

得到一个森林后,当有一个新的样本输入,森林中的每一棵决策树会分别进行一下判断,进行类别归类(针对分类算法),最后比较一下被判定哪一类最多,就预测该样本为哪一类。

随机森林算法有两个主要环节:决策树的生长和投票过程。

决策树生长步骤:1. 从容量为N的原始训练样本数据中采取放回抽样方式(即bootstrap取样)随机抽取自助样本集,重复k(树的数目为k)次形成一个新的训练集N,以此生成一棵分类树;2. 每个自助样本集生长为单棵分类树,该自助样本集是单棵分类树的全部训练数据。

设有M个输入特征,则在树的每个节点处从M个特征中随机挑选m(m < M)个特征,按照节点不纯度最小的原则从这m个特征中选出一个特征进行分枝生长,然后再分别递归调用上述过程构造各个分枝,直到这棵树能准确地分类训练集或所有属性都已被使用过。

在整个森林的生长过程中m将保持恒定;3. 分类树为了达到低偏差和高差异而要充分生长,使每个节点的不纯度达到最小,不进行通常的剪枝操作。

投票过程:随机森林采用Bagging方法生成多个决策树分类器。

基本思想:1. 给定一个弱学习算法和一个训练集,单个弱学习算法准确率不高,可以视为一个窄领域专家;2. 将该学习算法使用多次,得出预测函数序列,进行投票,将多个窄领域专家评估结果汇总,最后结果准确率将大幅提升。

随机森林的优点:可以处理大量的输入变量;对于很多种资料,可以产生高准确度的分类器;可以在决定类别时,评估变量的重要性;在建造森林时,可以在内部对于一般化后的误差产生不偏差的估计; ?包含一个好方法可以估计遗失的资料,并且,如果有很大一部分的资料遗失,仍可以维持准确度;提供一个实验方法,可以去侦测variable interactions;对于不平衡的分类资料集来说,可以平衡误差;计算各例中的亲近度,对于数据挖掘、侦测偏离者(outlier)和将资料视觉化非常有用;使用上述。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

随机森林模型在生存分析中的应用【摘要】目的:本文探讨随机森林方法用于高维度、强相关、小样本的生 存资料分析时,可以起到变量筛选的作用。

方法:以乳腺癌数据集构建乳腺癌转 移风险评估模型为实例进行实证分析, 使用随机森林模型进行变量选择,然后拟 合cox 回归模型。

结果:随机森林模型通过对变量的选择,有效的解决数据维 度高且强相关的情况,得到了较高的 AUC 值。

一、数据说明该乳腺癌数据集来自于NCBI ,有77个观测值以及22286个基因变量。

通过 筛选选取454个基因变量。

将数据随机分为训练集合测试集,其中2/3为训练集, 1/3为测试集。

绘制K-M 曲线图:二、随机森林模型随机森林由许多的决策树组成,因为这些决策树的形成采用了随机的方法,因此也叫做随机决策树。

随机森林中的树之间是没有关联的。

当测试数据进入随 机森林时,其实就是让每一颗决策树进行分类,最后取所有决策树中分类结果最 多的那类为最终的结果。

因此随机森林是一个包含多个决策树的分类器, 并且其 输出的类别是由个别树输出的类别的众数而定使用randomForestSRC 包得到的随机森林模型具有以下性质:Kaplan-Meker estlmaie wHh 95% conndence boundsS?2 SNumber of deaths: 27Number of trees: 800Mini mum term inal node size: 3Average no. of term inal no des: 14.4275No. of variables tried at each split: 3Total no. of variables: 452Analysis: RSFFamily: survSplitting rule: logrankError rate: 19.87%发现直接使用随机森林得到的模型,预测误差很大,达到了19.8%进一步考虑使用随机森林模型进行变量选择,结果如下:> our.rf$rfsrc.refit.objSample size: 52Number of deaths: 19Number of trees: 500Minimum terminal node size: 2Average no. of term inal no des: 11.554No. of variables tried at each split: 3Total no. of variables: 9Analysis: RSFFamily: survSplitting rule: logrank *random*Number of random split points: 10Error rate: 11.4%> our.rf$topvars[1] "213821_s_at" "219778_at" "204690_at" "220788_s_at" "202202_s_at"[6] "211603_s_at" "213055_at" "219336_s_at" "37892_at"一共选取了9个变量,同时误差只有11.4%接下来,使用这些变量做cox回归,剔除模型中不显著(>0.01 )的变量,最终参与模型建立的变量共有4个。

模型结果如下:exp(coef) exp(-coef) lower .95 upper .95'218150_at' 1.6541 0.6046 0.11086 24.6800'200914_x_at' 0.9915 1.0086 0.34094 2.8833'220788_s_at' 0.2649 3.7750 0.05944 1.1805'201398_s_at' 1.7457 0.5729 0.33109 9.2038'201719 s at' 2.4708 0.4047 0.93808 6.5081'202945_at' 0.4118 2.4284 0.03990 4.2499'203261_at' 3.1502 0.3174 0.33641 29.4983'203757_s_at' 0.7861 1.2720 0.61656 1.0024'205068 s at' 0.1073 9.3180 0.02223 0.5181最后选取六个变量拟合生存模型,绘制生存曲线如下:Cox Model0 2 4 6 8 10 12Time下面绘制ROC曲线,分别在训练集和测试集上绘制ROC曲线,结果如下: 训练集:Time-dependent ROC curve00o0.0 0.2 04 0.6 0B 1.0False Positive Rate测试集:o由于测试集上的样本过少,所以得到的AUC 值波动大,考虑使用bootstrap 多次 计算训练集上的AUC 值并求平均来测试模型的效果:AUC at 1 year : 0.8039456AUC at 3 year : 0.6956907AUC at 5 year : 0.7024846由此可以看到,随机森林通过删除贡献较低的变量, 完成变量选择的工作,在测 试集上具有较高的AUC 值,但是比lasso-cox 模型得到的AUC 略低。

附录:load("~/R/brea.rda") library(survival) set.seed(10) iv-sample(1:77,52) trai n<-dat[i,] test<-dat[-i,] library(ra ndomForestSRC) disease.rfv-rfsrc(Surv(time,status)~.,data = train,ntree = 800,mtry = 3, no desize = 3,splitrule = "logra nk")Time-dependent ROC curvea 0.0 0.2 0.6 0 8 1.0 False Positive Rate00 * o o 810上3>一一而」0.4disease.rf our.rfv- var.select(object=disease.rf, vdv,method = "vh.vimp", nrep = 50)our.rf$rfsrc.refit.obj our.rf$topvars in dex<-nu meric(var.rf$modelsize)for(i in 1:var.rf$modelsize){in dex[i]v-which( names(dat)==var.rf$topvars[i])}data<-dat[,c(1,2,i ndex)]iv-sample(1:77,52)trai n<-data[i,]test<-data[-i,] mod.brea<-coxph(Surv(time,status)~.,data=trai n) train _data<-tra in [,c(1,2,which(summary(mod.brea)$coefficie nts[,5]<=0.1)+2)]tset_data<-test[,c(1,2,which(summary(mod.brea)$coefficie nts[,5]<=0.1)+2)] mod.brea1<-coxph(Surv(time,status)~.,data=train_data)summary(mod.brea1)n ames(coef(mod.brea1))plot(survfit(mod.brea1),xlab="Time",ylab = "Proporti on ”,ma in="Cox Model",co nf.in t=TRUE,col=c("black","red","red"),ylim=c(0.6,1))in dex0<-nu meric(le ngth(coef(mod.brea1)))coefficie ntsv-coef(mod.breal)n ame<-gsub("\'","", names(coefficie nts))for(j in 1:le ngth( in dex0)){in dex0[j]<-which( names(dat)==n ame[j])}library(survivalROC)riskscore<-as.matrix(dat[i,i ndex0])%*% as.matrix(coefficie nts)y1<-survivalROC(Stime=trai n$time,status=trai n$status,marker=riskscore,predict. time=1,spa n = 0.25*( nrow(trai n))A(-0.20))y3<-survivalROC(Stime=trai n$time,status=trai n$status,marker=riskscore,predict. time=3,span = 0.25*( nrow(trai n) )A(-0.20)) y5<-survivalROC(Stime=train$time,status=trai n$status,marker=riskscore,predict. time=5,span = 0.25*( nrow(trai n))八(-0.20)) a<-matrix(data=c("y1","y3","y5",y1$AUC,y3$AUC,y5$AUC), nrow=3, ncol=2);a plot(y1$FP,y1$TP,type=T,xlab="False Positive Rate",ylab = "True Positive Rate",ma in="Time-depe ndent ROC curve",col="gree n")lin es(y3$FP,y3$TP,col="red",lty=2)lin es(y5$FP,y5$TP,col="blue",lty=3)legend("bottomright",bty="n",legend = c("AUC at 1 year:0.9271","AUC at 3years:0.8621","AUC at 5 years:0.8263"),col=c("gree n","red","blue"),lty=c(1,2,3),cex=0.9)abli ne(0,1) riskscore<-as.matrix(dat[-i,i ndex0])%*% as.matrix(coefficie nts)y1v-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.time=1,spa n = 0.25*( nrow(trai n))A(-0.20))y3<-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.ti me=3,span = 0.25*( nrow(trai n) )A(-0.20))y5<-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.time=5,span = 0.25*( nrow(trai n) )A(-0.20)) a<-matrix(data=c("y1","y3","y5",y1$AUC,y3$AUC,y5$AUC), nrow=3, ncol=2);aplot(y1$FP,y1$TP,type=T,xlab="False Positive Rate",ylab = "True Positive Rate",ma in="Time-depe ndent ROC curve",col="gree n")lin es(y3$FP,y3$TP,col="red",lty=2)lin es(y5$FP,y5$TP,col="blue",lty=3)legend("bottomright",bty="n",legend = c("AUC at 1 year:0.8761","AUC at 3years:0.7611","AUC at 5 years:0.7611"),col=c("gree n","red","blue"),lty=c(1,2,3),cex=0.9)abli ne(0,1) a<-matrix(0,30,3)for (c in 1:30){i<-sample(1:77,52)trai n<-data[i,]test<-data[-i,]mod.brea<-coxph(Surv(time,status)~.,data=trai n)train _data<-tra in [,c(1,2,which(summary(mod.brea)$coefficie nts[,5]<=0.1)+2)] tset_data<-test[,c(1,2,which(summary(mod.brea)$coefficie nts[,5]<=0.1)+2)] mod.brea1<-coxph(Surv(time,status)~.,data=train_data)n ames(coef(mod.brea1))in dex0<-nu meric(le ngth(coef(mod.brea1)))coefficie ntsv-coef(mod.breal)n ame<-gsub("\'","", names(coefficie nts))for(j in 1:le ngth( in dexO)){in dexO[j]<-which( names(dat)==n ame[j])}riskscore<-as.matrix(dat[-i,i ndexO])%*% as.matrix(coefficie nts) y1v-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.ti me=1,spa n = 0.25*( nrow(trai n))A(-0.20)) y3<-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.ti me=3,span = 0.25*( nrow(trai n) )A(-0.20)) y5<-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.ti me=5,span = 0.25*( nrow(trai n) )A(-0.20))a[c,]v-c(y1$AUC,y3$AUC,y5$AUC)。