san文件系统与集群文件系统

云计算存储有哪几种类型

在云计算的领域离不开存储,那么云计算使用的存储包括三种类型:虚拟化的存储(虚拟化存储、非虚拟化存储、裸设备映射,一般用于虚拟化场景)和分布式存储(存储池和存储卷,一般用于私有云场景和虚拟化场景)、集中式传统存储(FC-SANIP-SANNAS,一般用于虚拟化和私有场景)。

虚拟化存储架构:虚拟磁盘:由存储池提供给虚拟机使用的磁盘,后缀名为VHD。

虚拟化存储:由SAN和NAS提供的存储空间,需要添加一层文件系统(VIMS)屏蔽底层差异,性能较差。

支持更多的虚拟化特性如迁移、快照等等。

有文件系统。

非虚拟化存储:由分布式存储提供的存储空间,没有添加文件系统,性能较好,无法支持一些高级虚拟化特性。

没有文件系统。

虚拟化存储和非虚拟化存储都是两种不同类型的数据存储,都可以给虚拟机使用。

区别:1、底层提供者不一样。

2、性能不一样。

3、特性不一样。

4、文件系统不一样。

总结:虚拟化存储:在存储空间上添加了一层文件系统,支持高级特性如迁移。

但是性能差。

非虚拟化存储:在存储空间上没有一层文件系统,无法支持高级特性如迁移,但是性能好。

集中式存储讲磁盘组成磁盘阵列,完成集中式的存储,并通过映射给主机使用。

1、通过奇偶校验算法(XOR)的方式保存数据,相同为0,不同为1。

2、RAID分类RAID0:读取数据快,但是没有数据保护机制。

RAID1:2块磁盘组成一个RAID组,性能一般,安全性较高,磁盘利用率不高。

RAID3:使用单独的磁盘做校验,磁盘利用率较高,读数据性能高,写时会产生抢占。

ARID5:将校验值放入整个阵列中,缓解了抢占问题。

读写性能一般。

至少要3块磁盘。

RAID10:组合RAID,性能提升较快。

RAID50:组合RAID,提供了存储的利用率。

磁盘阵列主要采用RAID技术来保护数据,还可以提供并行读写。

热备盘技术:将快要损坏的磁盘上的数据移动到热备盘进行数据保护。

传统存储网络类型:1、SAN存储区域网络:利用磁盘阵列、网络设备组成专业化的存储网络。

NAS与SAN的7大差异与使用案例

NAS与SAN的7大差异与使用案例

一.NAS与SAN的7大差异

1.NAS是网络附加存储,SAN是存储区域网络:

NAS(Network Attached Storage)是一种可以通过网络与客户端进

行数据交换,为客户端提供文件存储的硬件系统。

它是一个独立的服务器,可以通过TCP / IP协议与用户的网络相连接,它被设计用于存储和共享

文件。

它可以与多个客户端共享文件,减少资源的消耗,并使用简单的管

理工具来管理数据。

SAN(Storage Area Network)是一种高速、可靠的网络,它可以把

有限的存储设备连接到更大的网络中,使用网络传输存储数据,并进行统

一管理,SAN系统的数据能够在多台计算机之间共享和互联,可以让用户

多点访问存储设备,交换数据,提高比特率,并可以有效的降低管理成本。

2.NAS是文件服务器,SAN是存储区域网络:

NAS作为文件服务器,提供了文件存储、共享和访问的功能,它可以

把大型文件存储到一个中心服务器上,以便用户可以访问它,这样可以节

省用户的硬盘空间,方便他们访问这些文件。

而SAN是由多个存储设备组成的网络系统,它可以把网络与存储设备

相连,从而实现网络存储,它可以把多台计算机的存储设备联结到同一个

网络上,实现大型存储资源的共享和管理。

浅谈NAS、SAN、DAS三种网络存储技术

浅谈NAS、SAN、DAS三种网络存储技术摘要:本文分析了NAS、SAN、DAS三种网络存储方式的特点和具体知识,简洁精练的语言从软硬件,协议层次等部分概要的叙述了三种方式的优点缺点。

关键词:NAS、SAN、DAS、网络存储网络存储技术一般分为三种,分别是NAS、SAN、DAS:NAS技术1. 最大存储容量最存储大存储容量是指NAS存储设备所能存储数据容量的极限,通俗的讲,就是NAS设备能够支持的最大硬盘数量乘以单个硬盘容量就是最大存储容量。

这个数值取决于NAS设备的硬件规格。

不同的硬件级别,适用的范围不同,存储容量也就有所差别。

通常,一般小型的NAS存储设备会支持几百GB的存储容量,适合中小型公司作为存储设备共享数据使用,而中高档的NAS设备应该支持T级别的容量(1T=1000G)。

2. 处理器同普通电脑类似,NAS产品也都具有自己的处理器(CPU)系统,来协调控制整个系统的正常运行。

其采用的处理器也常常与台式机或服务器的CPU大体相同。

一般针对中小型公司使用NAS产品采用AMD的处理器或Intel PIII/PIV等处理器。

而大规模应用的NAS产品则使用Intel Xeon处理器、或者RISC型处理器等。

但是也不能一概而论,视具体应用和厂商规划而定。

3. 内存NAS从结构上讲就是一台精简型的电脑,每台NAS设备都配备了一定数量的内存,而且大多用户以后可以扩充。

在NAS设备中,常见的内存类型由SDRAM (同步内存)、FLASH(闪存)等。

不同的NAS产品出厂时配备的内存容量不同,一般为几十兆到数GB(1GB=1000MB)容量不等。

4. 接口NAS产品的外部接口比较简单,由于只是通过内置网卡与外界通讯,所以一般只具有以太网络接口,通常是RJ45规格,而这种接口网卡一般都是100M网卡或1000M网卡。

另外,也有部分NAS产品需要与SAN(存储区域网络)产品连接提供更为强大的功能,所以也可能会有FC(Fiber Channel光纤通道)接口。

NAS与SAN(存储)

NAS与SAN都是在DAS的基础上发展起来的,是新型数据存储模式中的两个主要发展方向。

什么是SANSAN可以定义为是以数据存储为中心,采用可伸缩的网络拓扑结构,通过具有高传输速率的光通道的直接连接方式,提供SAN内部任意节点之间的多路可选择的数据交换,并且将数据存储管理集中在相对独立的存储区域网内。

在多种光通道传输协议逐渐走向标准化并且跨平台群集文件系统投入使用后,SAN最终将实现在多种操作系统下,最大限度的数据共享和数据优化管理,以及系统的无缝扩充。

SAN Device什么是NAS网络附加存储设备(NAS)是一种专业的网络文件存储及文件备份设备,或称为网络直联存储设备、网络磁盘阵列。

一个NAS里面包括核心处理器,文件服务管理工具,一个或者多个的硬盘驱动器用于数据的存储。

NAS 可以应用在任何的网络环境当中。

主服务器和客户端可以非常方便地在NAS上存取任意格式的文件,包括SMB格式(Windows)NFS格式(Unix, Linux)和CIFS格式等等。

NAS 系统可以根据服务器或者客户端计算机发出的指令完成对内在文件的管理。

另外的特性包括:独立于操作平台,不同类的文件共享,交叉协议用户安全性/许可性,浏览器界面的操作/管理,和不会中断网络的增加和移除服务器。

SAN & NAS Coexistence来源: IDC,2000由以上两图说明,NAS是在RAID的基础上增加了存储操作系统,而SAN是独立出一个数据存储网络,网络内部的数据传输率很快,但操作系统仍停留在服务器端,用户不是在直接访问SAN的网络,因此这就造成SAN在异构环境下不能实现文件共享。

NAS与SAN的数据存储可通过下面的图来表示:来源: IDC,2000来源: IDC,2000以上两图说明:SAN是只能独享的数据存储池,NAS是共享与独享兼顾的数据存储池。

因此,NAS与SAN的关系也可以表述为:NAS是Network-attached,而SAN是Channel-attached。

存储系列之DAS、SAN、NAS三种常见架构概述

存储系列之DAS、SAN、NAS三种常见架构概述随着主机、磁盘、⽹络等技术的发展,对于承载⼤量数据存储的服务器来说,服务器内置存储空间,或者说内置磁盘往往不⾜以满⾜存储需要。

因此,在内置存储之外,服务器需要采⽤外置存储的⽅式扩展存储空间,今天在这⾥我们分析⼀下当前主流的存储架构。

⼀、DASDirect Attached Storage,直接连接存储(直连式存储),最常见的⼀种存储⽅式。

意思是存储设备只与⼀台主机服务器连接,如PC中的磁盘或只有⼀个外部SCSI接⼝的JBOD(Just a Band of Disks可以简单理解成磁盘箱)都属于DAS架构。

存储设备与服务器主机之间的通常采⽤SCSI总线连接。

特点:简单、集中、易⽤,主要在中⼩企业应⽤中。

⼆、SAN1、SANStorage Area Network,存储区域⽹络。

SAN的兴起源于上个世纪80年代FC协议的出现,FC是Fibre Channel的缩写,⽹状通道的意思。

前⾯我们已经得知DAS是通过SCSI接⼝总线,⽽SCSI接⼝有16个节点的限制,不可能接⼊很多的磁盘。

SCSI并⾏总线结构,传输距离短,是⼀种宽⽽短的电缆结构。

⽽细长的串⾏的FC是⼀种可寻址容量⼤、稳定性强、速度快(1Gbps~8Gbps,现在成熟的技术已经达到上百G)、传输距离远的⽹络结构,所以最终替代了SCSI接⼝和总线,但是SCSI协议或者说SCSI语⾔仍然载于FC进⾏传输。

⽽且FC不仅替代了磁盘阵列前端接⼝,也替代了后端接⼝,从⽽使磁盘阵列真正处于⽹络之中。

到后来,2001年⼜提出了SAS传输⽹络,Serial Attached SCSI,串⾏SCSI,所以FC协议也属于串⾏SCSI。

所以SAS和FC协议⼀样跨越OSI七个层次。

紧接着出现了SAS盘,SAS盘接⼝和SATA盘接⼝是相同的,SAS协议通过STP(SATA Tuneling Protocol)来兼容SATA协议。

SAN和NAS之间的基本区别

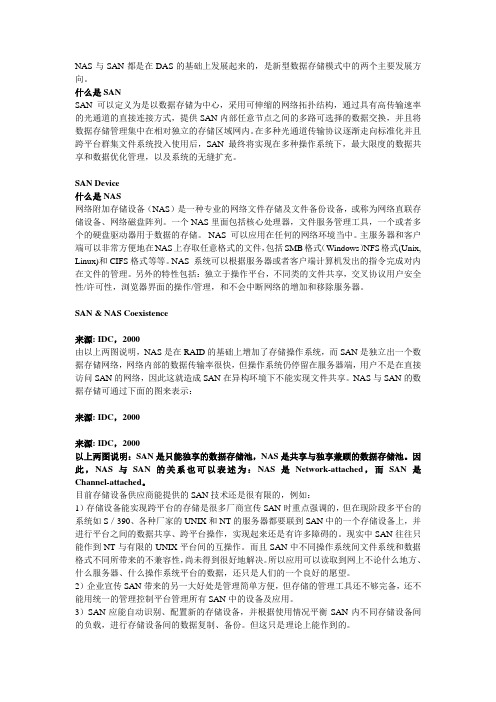

SAN和NAS之间的基本区别SAN和NAS之间的基本区别在我看来,SAN和NAS之间的基本区别是,SAN是基于Fabric的,⽽NAS是基于以太⽹的。

SAN是提供LUN⽅式给客户端使⽤,客户端需要MKFS,再MOUNT成⽂件系统。

NAS是直接以⽂件系统⽅式提供给客户端使⽤,客户端不需要MKFS,如FTP、⽬录共享。

类似于⼀个是⽹盘⼀个是映射本地驱动器的区别。

存储结构/性能对⽐DAS NAS FC-SAN IP-SAN成本低较低⾼较⾼数据传输速度快慢极快较快扩展性⽆扩展性较低易于扩展最易扩展服务器访问存储⽅式直接访问存储数据块以⽂件⽅式访问直接访问存储数据块直接访问存储数据块服务器系统性能开销低较低低较⾼安全性⾼低⾼低是否集中管理存储否是是是备份效率低较低⾼较⾼⽹络传输协议⽆ TCP/IP Fibre Channel TCP/IPSAN- 存储区域⽹络它以块级别访问数据,并以磁盘形式产⽣空间以承载主机。

SAN是专⽤⽹络,可提供对合并的块级数据存储的访问。

SAN主要⽤于制造存储设备(例如磁盘阵列,磁带库和光盘机)到服务器,从⽽使这些设备看起来像是本地连接到操作系统的设备。

从历史上看,数据中⼼⾸先将SCSI磁盘阵列的“孤岛”创建为直连存储(DAS),每个磁盘都专⽤于⼀个应⽤程序,并且可以看作是许多“虚拟硬盘”(即)。

操作系统在⾃⼰的专⽤⾮共享LUN上维护⾃⼰的⽂件系统,就像它们在本地⼀样。

NAS- ⽹络附加存储它以⽂件级别访问数据,并以共享⽹络⽂件夹的形式产⽣空间来托管。

相⽐之下,NAS使⽤基于⽂件的协议(例如NFS或SMB / CIFS),很明显存储是远程的,并且计算机请求⼀部分抽象⽂件⽽不是磁盘块。

直接连接存储(DAS)和NAS之间的主要区别在于,DAS只是对现有服务器的扩展,⽽不⼀定是联⽹的。

NAS被设计为⼀种简单且独⽴的解决⽅案,⽤于通过⽹络共享⽂件。

SAN(存储区域⽹络)SAN(存储区域⽹络)使⽤光纤通道技术通过光纤通道交换机连接存储阵列和服务器主机,以建⽴专⽤于数据存储的区域⽹络。

存储结构(DAS、SAN、NAS)

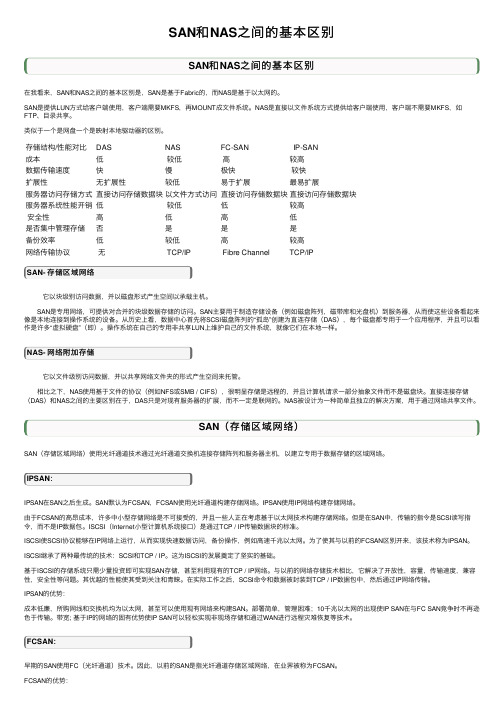

DAS、SAN和NAS三种存储方式存储的分类,根据服务器类型分为:封闭系统的存储和开放系统的存储,封闭系统主要指大型机,开放系统指基于Windows、UNIX、Linux等操作系统的服务器;开放系统的存储分为:内置存储和外挂存储;外挂存储根据连接的方式分为:直连式存储(Direct-Attached Storage,简称DAS)和网络化存储(Fabric-Attached Storage,简称FAS);网络化存储根据传输协议又分为:网络接入存储(Network-Attached Storage,简称NAS)和存储区域网络(Storage Area Network,简称SAN)。

大致如图所示:DAS(直连式存储)存储DAS存储在我们生活中是非常常见的,尤其是在中小企业应用中,DAS是最主要的应用模式,存储系统被直连到应用的服务器中,在中小企业中,许多的数据应用是必须安装在直连的DAS存储器上。

DAS存储更多的依赖服务器主机操作系统进行数据的IO读写和存储维护管理,数据备份和恢复要求占用服务器主机资源(包括CPU、系统IO等),数据流需要回流主机再到服务器连接着的磁带机(库),数据备份通常占用服务器主机资源20-30%,因此许多企业用户的日常数据备份常常在深夜或业务系统不繁忙时进行,以免影响正常业务系统的运行。

直连式存储的数据量越大,备份和恢复的时间就越长,对服务器硬件的依赖性和影响就越大。

直连式存储与服务器主机之间的连接通道通常采用SCSI连接,随着服务器CPU的处理能力越来越强,存储硬盘空间越来越大,阵列的硬盘数量越来越多,SCSI通道将会成为IO 瓶颈;服务器主机SCSI ID资源有限,能够建立的SCSI通道连接有限。

无论直连式存储还是服务器主机的扩展,从一台服务器扩展为多台服务器组成的群集(Cluster),或存储阵列容量的扩展,都会造成业务系统的停机,从而给企业带来经济损失,对于银行、电信、传媒等行业7×24小时服务的关键业务系统,这是不可接受的。

多种集群文件系统的介绍及分析

多种集群文件系统的介绍及分析1.什么是集群文件系统“集群”主要分为高性能集群HPC(High Performance Cluster)、高可用集群HAC(High Availablity Cluster)和负载均衡集群LBC(Load Balancing Cluster)。

集群文件系统是指协同多个节点提供高性能、高可用或负载均衡的文件系统,消除了单点故障和性能瓶问题。

对于客户端来说集群是透明的,它看到是一个单一的全局命名空间,用户文件访问请求被分散到所有集群上进行处理。

此外,可扩展性(包括Scale-Up和Scale-Out)、可靠性、易管理等也是集群文件系统追求的目标。

在元数据管理方面,可以采用专用的服务器,也可以采用服务器集群,或者采用完全对等分布的无专用元数据服务器架构。

目前典型的集群文件系统有SONAS, ISILON, IBRIX, NetAPP-GX, Lustre, PVFS2, GlusterFS, Google File System (GFS), LoongStore, CZSS等。

2.集群文件系统的三种主流技术架构从整体架构来看,集群文件系统由存储子系统、NAS集群(机头)、客户端和网络组成。

存储子系统可以采用存储区域网络SAN、直接连接存储DAS或者面向对象存储设备OSD 的存储架构,SAN和DAS架构方式需要通过存储集群来管理后端存储介质,并以SAN文件系统或集群文件系统的方式为NAS集群提供标准文件访问接口。

在基于OSD架构中,NAS集群管理元数据,客户端直接与OSD设备直接交互进行数据访问,这就是并行NAS,即pNFS/NFSv4.1。

NAS集群是NFS/CIS网关,为客户端提供标准文件级的NAS服务。

对于SAN和DAS架构,NAS集群同时承担元数据和I/O数据访问功能,而OSD架构方式仅需要承担元数据访问功能。

根据所采用的后端存储子系统的不同,可以把集群NAS分为三种技术架构,即SAN共享存储架构、集群文件系统架构和pNFS/NFSv4.1架构。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

SAN文件系统与集群文件系统

及其应用发展趋势

张敬亮

摘要:本文主要介绍与分析传统网络存储方式与新的存储架构,以及国内自主研发的集群存储系统—蓝鲸集群存储系统与SAN文件系统的发展与应用情况。

关键字:SAN 集群文件系统、蓝鲸集群文件系统

1传统网络存储方式所面临的挑战

随着以NAS1和SAN2为代表的网络存储架构逐渐走向成熟,厂商对其理念进行的大量宣传与推广,以及网络存储系统对数据进行集中存储和管理所带来的优越性,网络存储已经逐渐被人们接受,其应用也迅速推广至各个行业。

换言之,传统的NAS和SAN产品很好地解决了分散存储所面临的可用性、可管理性和可扩展性等大部分问题,但随着信息化技术的迅猛发展,诸如高性能计算、视频编辑、遥感信息处理等技术的大规模应用,对网络传存储系统提出了更高的要求:

1.需要支持更多的客户机进行高性能的文件共享,从而提高业务处理效率,减少因数据拷贝而造成的不必要的损失。

2.希望系统的性能和容量可在线扩展,无需停止业务。

然而,在目前主流的存储架构中,存在着如下问题:

1.由于SAN提供的是块级数据共享, 所以,要想实现多个平台的文件共享,还有很多障碍。

2.在SAN系统中,因为每个应用节点的逻辑卷之间无法实现容量共享,所以整个系统的存储利用率仍然比较低。

而且,当系统中的逻辑卷容量不足时,无法实现

在不影响业务的情况下的在线扩容。

3.NAS产品可以实现文件共享,而且每个节点都可以同时共享整个系统的存储空间,利用率更高。

但在传统的NAS产品中,所有数据都要经过单一I/O(输入/

输出)节点,所以当客户节点增多或负载加大时,NAS产品的文件并发访问性能

不尽如人意,同时,一般的NAS产品都无法实现存储容量和性能的在线扩展。

4.虽然陆续出现了诸如NAS集群、NAS网关等改良的方案,但都因为架构的限制无法实现本质上的突破。

2新的存储架构应运而生

为解决上述问题产生了新型存储架构,即支持集群文件系统的集群存储架构和结合

1 Network Attached Storage,网络附连存储

2 Storage Area Storage,存储区域网

SAN文件系统的SAN存储架构。

这些架构具备以下主要特点:

1.提供统一的访问入口和全局的文件系统。

2.提供元数据集群和SAN或专用的存储集群。

前者负责处理元数据请求,后者负责处理I/O读写,二者的处理是相互独立、并行进行的,即客户端直接到SAN

上进行数据读写。

3.数据以条带化方式写入SAN或存储集群,可以为应用节点提供更高的多设备聚合带宽。

4.可提供对目前主流集群网络互连技术的支持(包括GE、Myrinet和IB),其中GE 是最主要的形式。

由于FC3网络设备价格较高,在集群中采用较少,因此集群文

件系统对FC的支持也很少;而SAN文件系统主要支持包括FC和GE在内的主流存

储网络。

由于使用了元数据和I/O分离处理的带外架构,类似的产品一般都具备以下优势:

1.支持高性能的文件共享,减少数据复制代理的开销和可能导致的错误。

2.可支持上千个节点的大规模集群。

3.可达数十GB/s的高聚合带宽。

4.系统性能、容量皆可动态扩展,且对客户端透明。

5.采用元数据控制器故障转移(FAIL OVER)技术、文件系统日志技术保证服务和数据的可靠性。

3SAN文件系统和集群文件系统产品分析

虽然SAN文件系统和集群文件系统具有一些共同点,但在应用环境中还存在如下差别。

1.有些集群文件系统一般仅支持单一的客户端操作系统类型,主要用于高性能计算中的集群应用,其性能扩展性优于传统的并行文件系统。

2.部分厂商的产品以集群文件系统配合专用的存储集群的方式提供用户使用。

3.有些SAN文件系统可以松耦合,并和SAN配合,支持不同客户端操作系统类型,更多用于服务器环境下的集中存储。

SAN文件系统本身可以替代集群文件系统,

但那些仅支持FC的SAN文件系统,在集群规模扩大时,成本会迅速攀升;相反

地,基于IP SAN的SAN文件系统,在大规模的集群应用环境中可以提供非常高

的性价比。

4国内主流集群文件系统和SAN文件系统

目前,主流的集群文件系统有CFS公司的Lustre、Panasas公司的PanFS和北京中科储天信息技术有限公司的BWFS;主流的SAN文件系统有BWFS、ADIC公司的StorNext FS、IBM的SFS等。

其中,由于BWFS同时具备了集群文件系统和SAN文件系统的特点,而且对IP SAN 3 Fibre Channel,光纤通道

也具有良好的支持,所以,在类型上同时属于集群文件系统和SAN文件系统。

值得一提的是,BWFS是由我国自主研发的、部分指标接近或超过国外的同类产品。

以下重点介绍Lustre,PanFS和BWFS的结构和特点,并和主流的SAN文件系统和集群文件系统汇总对比。

Lustre是面向I/O密集型集群应用、支持上万个集群节点、数百TB存储容量的对象集群文件系统。

Lustre包括客户端(Client)、元数据服务器(MDS4)和对象存储服务器(OST5)三个部分,OST负责数据存储和访问,支持对象访问协议,MDS负责元数据访问和锁管理。

Lustre采用门户(Portal)模块支持异构网络环境,底层采用EXT3格式存储数据,对应用提供POSIX(可移植操作系统接口)语义支持,应用通过客户端(client)透明地访问数据。

Lustre目前支持2个MDS的故障转移方式,尚未支持MDS集群。

Lustre的开发采用开发源码的方式,目前对外发布的是1.4.6版,已经应用在美国洛斯阿拉莫斯(Los Alamos)、劳伦斯利物莫(Lawrence Livermore)、桑迪亚(Sandia)等国家实验室。

PanFS主要面向大规模的Linux集群,其产品在一个设备中集成了刀片式存储节点服务器StorageBlade(9~10片)和刀片式元数据服务器DirectorBlade(1~2片),通过4个GE输出,多个设备可以堆叠。

其中DirectorBlade负责处理元数据请求,2个DirectorBlade以集群方式运行,从而提供高数据带宽。

在集群节点安装DirectFlow软件,为集群应用提供全局的文件访问接口,底层与Lustre一样,采用EXT3格式存储数据。

PanFS目前已经应用在生物信息处理、石油地质勘探、流媒体、计算机辅助工程(CAE)等领域。

BWFS基于IP技术,支持大规模异构集群和应用服务器环境,支持Linux和Windows 平台。

BWFS包括元数据服务器(Metadata Server, MS)集群、存储设备(Storage Node,SN)集群、可加载文件系统模块(Installable File System IFS,)和管理控制台(Administration console,AD),MS集群负责处理元数据请求和负载平衡;SN集群负责数据存储和数据服务;IFS安装在集群节点并对应用提供统一的全局文件系统访问接口;AD为用户提供BWFS 的管理服务。

BWFS采用带外数据模型、延迟绑定LazyBinding、分层资源管理、针对应用的动态一致性语义等技术,集群节点直接到SN集群并发地访问数据,且MS集群和SN集群均可以在线动态扩展,具有非常高的I/O聚合带宽和极强的I/O可扩展性,在某些应用领域,性能比原有系统提高了数十倍。

目前,已经应用到石油地质勘探、遥感数据处理、高性能计算、大型信息中心、信息检索与处理等多个领域。

下表汇总产品国内市场上主流的SAN文件系统和集群文件系统:

厂商名称产品文件系统类型应用节点支持的操作系统

IBM TotalStorage

SFS SAN Windows、Linux、Unix ADIC StorNext SAN Windows、Linux、Unix

NRCHPC BWFS 集群、SAN Widows、Linux CFS Lustre 集群Linux

Panasas Panfs 集群Linux

(下转第29页)

4 Meta Data Server

5 Object Storage Target.

5 应用发展趋势

虽然SAN文件系统和集群文件系统在我国的应用和推广的时间不长,但由于其可提供高性能的文件共享及良好的可扩展性,在高性能计算、视频处理、遥感信息处理等领域被越来越多的用户关注和应用。

通过上述分析,我们可以看到集群文件系统和SAN文件系统,均以全新的方式解决了传统网络存储中所面临的问题。

尤其是SAN文件系统具有更高的灵活性,可以更好地解决数据爆炸时代所带来的存储挑战。

这意味着,和SAN结合的SAN文件系统已成为存储基础架构发展的一种必然趋势。

随着信息技术的不断发展,在不久的将来,将会有更多的存储厂商参与其中,并且得到越来越广泛的应用。

作者简介:

张敬亮: 中科院计算所工程中心。