广义信息熵的推广与应用

熵概念在物理和信息科学中的应用

熵概念在物理和信息科学中的应用引言:熵是热力学和信息论中一个重要的概念,既存在于物理学领域,又广泛应用于信息科学中。

熵的概念最初由物理学家克劳修斯提出,并被香农进一步发展应用于信息论中。

本文将探讨熵在物理和信息科学中的应用及其意义。

一、物理学中的熵概念在物理学中,熵被理解为一个系统的无序程度或混乱程度。

根据热力学第二定律,熵在一个孤立系统中总是增加的,也就是说,自然趋向于混乱状态。

熵的概念广泛应用于热力学和统计物理学中。

1. 熵与热力学热力学是研究能量转化和传递的学科,熵是热力学中的基本概念之一。

热力学第二定律表明,孤立系统中的熵总是增加的。

这意味着,自然界趋向于一个混乱不可逆的状态。

熵的增加可以解释为能量从有序状态向无序状态的转化。

2. 熵与统计物理学统计物理学研究微观粒子的统计行为,熵在统计物理学中有着重要的意义。

根据统计力学的基本原理,宏观热力学量可以通过统计描述微观粒子的运动和相互作用。

熵在统计物理学中可以用来描述系统的状态数和概率分布。

熵的增加与自然界趋向均衡状态的趋势密切相关。

二、信息科学中的熵概念信息科学中的熵是从信息论中引入的概念,它用于衡量信息的不确定性和随机性。

信息熵是信息论中的重要工具,用来度量信息的平均信息量。

1. 熵与信息压缩在信息科学中,熵可用于信息压缩。

信息压缩是将庞大的信息量通过压缩算法减少到较小的存储或传输形式的过程。

熵可以用来衡量信息中的冗余度和不确定性,通过降低熵的大小来实现信息的压缩。

2. 熵与密码学在密码学中,熵也扮演着重要的角色。

熵可以衡量密码系统的安全性和随机性。

密码学中的随机数生成器常常以熵为基础,通过产生高熵的随机数来提高密码的安全性。

3. 熵与数据挖掘数据挖掘是从大规模数据中发现有用的信息的过程。

在数据挖掘中,熵可以用来度量数据的不确定性和随机性,同时也可以用来评估模型的复杂度和拟合优度。

熵在特征选择和模式识别等领域有重要应用。

三、熵概念的意义和应用前景熵概念在物理和信息科学中的应用有着重要的意义和广阔的前景。

熵的概念及其在信息理论中的应用

熵的概念及其在信息理论中的应用熵是一个重要的概念,它最初来自于热力学领域,用于描述系统的无序程度。

然而,在20世纪40年代,熵的概念开始被引入到信息理论中,并成为衡量信息量的重要指标。

本文将介绍熵的概念以及它在信息理论中的应用。

首先,让我们来了解一下熵的概念。

在热力学中,熵代表了一个物理系统内部的无序程度。

一个有序的系统具有较低的熵,而一个无序的系统具有较高的熵。

这个概念可以通过一个经典的例子来解释:假设你有一盒子里装着100个相同的硬币,其中50个是正面朝上,另外50个是反面朝上。

如果你闭上眼睛随机取出一个硬币,你很难知道这个硬币是正面还是反面朝上,因为系统具有较高的熵。

相反,如果你知道盒子里正面和反面朝上的硬币均匀分布,那么你可以很容易地猜测每次取出的硬币是正面还是反面,因为系统具有较低的熵。

在信息理论中,熵的概念被引入用于衡量信息量。

在信息传输过程中,我们可以把信息看作是一系列的符号或者数据。

符号或数据的选择越多,信息的熵就越大。

熵的计算公式为:H(X) = -Σ P(x)log2P(x)其中,H(X)代表随机变量X的熵,P(x)代表随机变量X取某个值x的概率。

举个简单的例子来解释熵在信息理论中的应用。

假设我们要传输一个二进制信号,只包含0和1两种可能。

如果这两个数字以相等的概率出现,我们可以说这个信号的熵是最大的。

因为我们无法预测下一个数字是0还是1,所以我们需要传输更多的信息来表达这种不确定性。

相反,如果这两个数字中的一个以明显较大的概率出现,我们可以说这个信号的熵是较低的。

因为我们可以通过传输更少的信息来表达这种确定性。

熵在信息理论中有许多重要的应用。

首先,熵可以用于衡量数据压缩算法的效果。

在数据压缩中,我们试图通过减少冗余信息来缩小数据的大小。

根据香农编码定理,基于熵的编码方法可以达到理论上的最优压缩效果。

这意味着,通过使用基于熵的编码方法,我们可以尽可能地减少数据的传输量。

其次,熵还可以用于衡量随机变量的不确定性。

熵概念的推广与应用

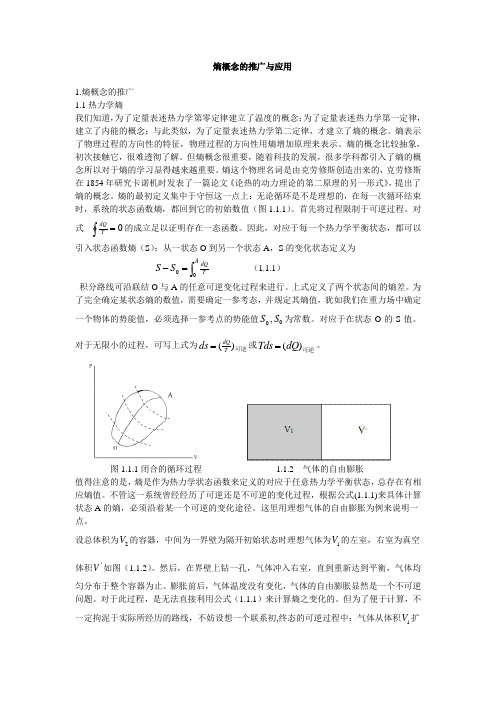

熵概念的推广与应用1.熵概念的推广1.1热力学熵我们知道,为了定量表述热力学第零定律建立了温度的概念;为了定量表述热力学第一定律,建立了内能的概念;与此类似,为了定量表述热力学第二定律,才建立了熵的概念。

熵表示了物理过程的方向性的特征,物理过程的方向性用熵增加原理来表示。

熵的概念比较抽象,初次接触它,很难透彻了解。

但熵概念很重要,随着科技的发展,很多学科都引入了熵的概念所以对于熵的学习显得越来越重要。

熵这个物理名词是由克劳修斯创造出来的,克劳修斯在1854年研究卡诺机时发表了一篇论文《论热的动力理论的第二原理的另一形式》,提出了熵的概念。

熵的最初定义集中于守恒这一点上:无论循环是不是理想的,在每一次循环结束时,系统的状态函数熵,都回到它的初始数值(图1.1.1)。

首先将过程限制于可逆过程。

对式0=⎰T dQ 的成立足以证明存在一态函数。

因此,对应于每一个热力学平衡状态,都可以引入状态函数熵(S ):从一状态O 到另一个状态A ,S 的变化状态定义为⎰=-A T dQS S 00 (1.1.1)积分路线可沿联结O 与A 的任意可逆变化过程来进行。

上式定义了两个状态间的熵差。

为了完全确定某状态熵的数值,需要确定一参考态,并规定其熵值,犹如我们在重力场中确定一个物体的势能值,必须选择一参考点的势能值0S ,0S 为常数。

对应于在状态O 的S 值。

对于无限小的过程,可写上式为可逆)(T dQds =或可逆)(dQ Tds =。

图1.1.1闭合的循环过程 1.1.2 气体的自由膨胀值得注意的是,熵是作为热力学状态函数来定义的对应于任意热力学平衡状态,总存在有相应熵值。

不管这一系统曾经经历了可逆还是不可逆的变化过程,根据公式(1.1.1)来具体计算状态A 的熵,必须沿着某一个可逆的变化途径。

这里用理想气体的自由膨胀为例来说明一点。

设总体积为2V 的容器,中间为一界壁为隔开初始状态时理想气体为1V 的左室,右室为真空体积'V 如图(1.1.2)。

熵的原理及应用论文

熵的原理及应用1. 引言熵是信息论中一个重要的概念,它描述了一个系统中的无序程度。

熵的概念最初是由克劳修斯·沃维尼克在1948年提出的。

它被广泛应用于各个领域,包括物理学、化学、生物学和计算机科学等。

本文将介绍熵的定义和原理,以及熵在不同领域的应用。

2. 熵的定义熵可以用来衡量一个系统的混乱程度或者不确定性的程度。

熵的计算公式如下:$$ H(X) = -\\sum_{i=1}^{n} P(x_i) \\log_2(P(x_i)) $$其中,H(X)表示系统的熵,P(x i)表示系统处于状态x i的概率。

熵的单位通常用比特(bits)表示。

3. 熵的原理熵的原理可以通过以下三个方面来理解:3.1. 熵与无序程度的关系从熵的定义可以看出,当系统的状态越多且概率分布越均匀时,熵越大,系统的无序程度越高。

相反,当系统的状态少且分布不均匀时,熵越小,系统的无序程度越低。

3.2. 熵与信息量的关系根据熵的计算公式可以看出,熵与信息量有直接的关系。

当系统中某个状态的概率较高时,其对应的信息量较低,而当系统中某个状态的概率较低时,其对应的信息量较高。

熵越大,系统中的每个状态所包含的信息量越多。

3.3. 熵与系统不确定性的关系熵可以用来衡量系统的不确定性。

当系统的熵较高时,系统的状态难以预测,即系统具有较高的不确定性。

相反,当系统的熵较低时,系统的状态容易被确定,即系统具有较低的不确定性。

4. 熵的应用熵在各个领域都具有广泛的应用,下面将介绍熵在物理学、化学、生物学和计算机科学等领域的应用。

4.1. 物理学在物理学中,熵被用来描述热力学系统的无序程度。

熵在热力学中的应用可以帮助我们理解系统的能量转化和热力学过程。

4.2. 化学在化学中,熵被用来衡量反应的自由度和不确定性。

熵在化学反应中的应用可以帮助我们预测和控制化学反应的方向和速率。

4.3. 生物学在生物学中,熵被用来描述生物系统的多样性和适应性。

熵在生物学中的应用可以帮助我们理解生物多样性的形成和演化过程。

熵在信息理论中的应用

熵在信息理论中的应用信息理论是研究信息的量和质的科学领域,它为我们理解信息的传递和存储提供了强有力的工具和框架。

熵是信息理论的核心概念之一,它是信息的一种度量,能够揭示系统的不确定性和随机性。

熵在信息理论中发挥着重要的作用,本文将探讨熵在信息理论中的应用,并介绍一些具体的应用案例。

首先,熵被用来度量信息的不确定性。

熵的概念最初由克劳德·香农在1948年提出,它可以理解为系统中信息的平均信息量。

在信息理论中,熵被用来衡量信息源的不确定度,即信息源产生的符号的不确定性水平。

对于一个具体的离散信息源,它的熵可以通过以下公式计算:H(X) = -∑P(x)log(P(x)),其中P(x)表示符号x出现的概率。

熵越高,表示信息源产生的符号越随机,不确定度越大。

其次,熵被用来度量信息的压缩性。

在信息传输和存储中,压缩是一种重要的技术,可以显著减小信息的存储空间和传输带宽。

在信息理论中,通过熵的概念可以确定信息的最小表示长度,即熵越大,信息的最小表示长度越长,相应地,信息的压缩率就会降低。

而对于服从某种概率分布的信息源,可以通过霍夫曼编码来实现最佳压缩,其中信息源中出现概率高的符号分配较短的编码,而出现概率低的符号分配较长的编码。

熵告诉我们了解一个信息源的特性,有助于设计相应的压缩算法。

第三,熵被用来度量信息的冗余性。

冗余性是指信息中不必要的部分,它使得信息在传递和存储过程中存在额外的开销。

冗余性可以通过熵和实际编码长度之间的差异来衡量。

在信息理论中,通过比较信息的平均长度和熵,可以得到冗余度的大小。

信息的冗余度越高,表示信息中的冗余部分越多,可以通过去除这些冗余部分来减少信息的传输和存储开销。

因此,熵的概念可以帮助我们分析信息中的冗余,并提出相应的优化策略,以提高信息的传输和存储效率。

最后,熵在密码学中也有着广泛的应用。

密码学是研究信息的保密性和完整性的学科,熵在密码学中被用来衡量密码的复杂性和安全性。

简述熵定义的拓延和熵的推广应用(正文)

简述熵定义的拓延和熵的推广应用学生姓名:张礼娜学号:20085040055单位:物理电子工程学院专业:物理学指导老师:孙海斌职称:讲师摘要:本文比较简单的介绍了熵的定义和熵增加原理,之后根据熵增原理浅谈熵的应用:由原来的热力学上的熵发展到统计学熵,后来又有信息熵、生物熵,现在熵的应用已经遍及我们生活中的各个角落,如:熵在耗散结构理论中的应用、熵在能量品质描述中的应用、熵在生命过程中的应用等。

关键词:热力学熵;熵增加原理;统计学熵;信息熵;推广应用Describes the definition of entropy future extension and application of entropyAbstract: this article compares simple introduced the definition and entropy increase entropy principle, according to the entropy increase after the application of entropy principle concerning from thermodynamics: the entropy to statistical entropy, and then some information entropy, the biological entropy, now has over the entropy of the application of our life, such as: each corner of the dissipative structure theory of entropy in the application and entropy in energy quality, application of entropy described in the life process, etc.Key words:thermodynamic entropy, Entropy increase principle, Statistical entropy, Information entropy, Application前言熵是物理学中的一个重要概念。

信息熵的概念及其在信息论中的应用

信息熵的概念及其在信息论中的应用信息熵是信息论中的一个重要概念,用来衡量信息的不确定性和随机性。

在信息论的发展中,信息熵被广泛应用于数据压缩、密码学和通信领域等。

本文将详细介绍信息熵的概念和其在信息论中的应用。

一、信息熵的概念信息熵是由美国科学家克劳德·香农(Claude Shannon)在1948年提出的,它是用来衡量随机变量中所包含的信息量。

香农认为,一个事件的信息量和它的不确定性是成正比的。

如果一个事件是确定的,它所包含的信息量就很小;相反,如果一个事件是完全不确定的,那么它所包含的信息量就会很大。

信息熵的计算公式如下:H(X) = -ΣP(x)log(P(x))其中,H(X)代表随机变量X的信息熵,P(x)代表随机变量X取值为x的概率,log代表以2为底的对数运算。

信息熵的单位通常用比特(bit)来表示,表示一个系统所能提供的平均信息量。

比特值越大,代表信息的不确定性越高,信息量越大。

信息熵的概念与热力学中的熵有些相似,都是用来衡量混乱程度或者不确定性的指标。

而信息熵则更加关注于信息的有序性和随机性。

二、信息熵的应用1. 数据压缩信息熵在数据压缩中发挥着重要作用。

根据信息熵的原理,如果某段数据的信息熵较高,那么这段数据中存在较多的冗余信息。

通过将冗余信息删除或者使用更简洁的编码方式表示,可以实现对数据的压缩。

在实际应用中,常用的数据压缩算法如Huffman编码和Lempel-Ziv 编码等都是基于信息熵的原理设计的。

这些算法通过对数据进行分组和编码,去除数据中的冗余信息,从而实现高效的数据压缩。

2. 密码学信息熵在密码学中也有广泛的应用。

在设计密码算法时,我们希望生成的密钥具有高度的随机性和不可预测性,以保证密码的安全性。

信息熵可以被用来评估生成密钥的质量。

如果密钥的信息熵较高,说明密钥具有较高的随机性,对于攻击者来说更加难以猜测。

因此,在密码学中,信息熵可以作为评估密钥强度的一个重要指标。

熵的应用及意义

熵的应用及意义熵是一种物理量,用来描述系统的无序程度或混乱程度。

它最初是由热力学中的研究中引入的,用来描述系统的混乱程度。

熵随着时间的推移而增加,这意味着系统的有序程度会减少,直到达到热力学平衡状态。

然而,随着科学的发展,熵的概念也被引入到其他领域,如信息理论、通信和统计力学等,成为一种普遍适用的概念。

在热力学中,熵是衡量系统无序程度的物理量,它描述了系统的混乱程度。

熵的增加意味着系统的无序程度增加,也可以说,熵是对系统混乱程度的度量。

在自然界中,大部分物理过程都是不可逆的,而熵的增加代表了不可逆过程的趋势。

这使得熵成为了热力学第二定律的表述方式之一,它指出了自然界中趋向熵增的趋势。

熵的应用在热力学中是非常重要的,它可以用来描述热力学过程的方向性和可行性,也可以用来解释许多自然现象,如热传导、化学反应和相变等。

除了在热力学中的应用外,熵还被引入到了信息理论中,成为了信息量的度量。

在信息理论中,熵被用来描述一个随机变量或信源的不确定性,它代表了信息的平均量。

较高的熵意味着信息的不确定性较大,而较低的熵则意味着信息的不确定性较小。

而当信息的熵达到最大值时,意味着信息的不确定性也达到了最大值,这时的信息就是完全随机的。

信息的熵还可以用来描述信息的压缩率,即信息的平均长度。

熵在信息理论中的应用使得它成为了信息传输和数据压缩中的重要概念,也为信息论的发展提供了理论基础。

在统计力学中,熵的概念也被广泛应用。

熵在统计力学中被用来描述微观粒子的混乱程度,它是宏观物理量与微观粒子状态的统计分布之间的数量。

熵的增加意味着微观粒子状态的混乱程度增加,也意味着系统的不确定性增加。

熵在统计力学中的应用使得它成为了描述宏观物理现象和微观粒子行为之间关系的重要概念。

统计力学中的熵还被用来描述系统的热平衡状态和非平衡态的转变过程,也为理解物质的热力学性质提供了重要的参考。

总的来说,熵在不同领域中的应用和意义是多方面的。

在热力学中,熵描述了系统的无序程度和热力学过程的可行性;在信息理论中,熵描述了信息的不确定性和压缩率;在统计力学中,熵描述了系统的微观粒子状态分布和宏观物理量之间的关系。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

青岛农业大学本科生课程论文论文题目广义信息熵的推广与应用学生专业班级信息与计算科学09级02班学生姓名(学号)(20094052)指导教师吴慧完成时间 2012年6月28日2012 年 6 月 28 日课程论文任务书学生姓名指导教师吴慧论文题目广义信息熵的推广与应用论文内容:本文先介绍了Shannon 信息熵的定义,并对其进行了一定的分析,介绍了它的一些基本性质。

其次,说明Shannon 熵的局限性,以此引出了广义信息熵。

然后对常用的Renyi 熵、Tsallis 熵进行讨论,说明它们与Shannon 熵的联系。

最后介绍了广义熵在实际生活中的应用。

资料、数据、技术水平等方面的要求:论文要符合一般学术论文的写作规范,具备学术性、科学性和一定的创造性。

文字要流畅、语言要准确、论点要清楚、论据要准确、论证要完整、严密,有独立的观点和见解。

涉及到他人的观点、统计数据或计算公式等要标明出处,结论要写的概括简短。

发出任务书日期 2012-6-5 完成论文日期 2012-6-19 教研室意见(签字)院长意见(签字)广义信息熵的推广与应用信息与计算科学指导教师吴慧摘要:本文先介绍了Shannon 熵,由Shannon 熵推广到一般的广义信息熵,使其适用范围更广。

然后在Shannon 熵的基础上介绍了两种最常用的广义信息熵:Renyi 熵和Tsallis 熵,说明了这两种广义信息熵的简单性质,以及与Shannon 熵的联系和性质上的差异。

最后介绍了广义熵在实际生活中的应用。

关键词:Shannon 熵;广义信息熵;应用The promotion and application of the generalized informationentropyStudent majoring in Information and Computing Science ZhuMengTutor WuHuiAbstract:At the beginning of this article it introduced the Shannon entropy.Then, it described the two most commonly used generalized information entropy: Renyi entropy and Tsallis entropy on the basis of the Shannon entropy.What is more,this article not only described the simple nature of the generalized information entropy but also described their contact with the Shannon entropy as well as the different nature between them.Finally, it introduced the application of the generalized entropy in real life.Keywords: Shannon entropy; generalized information entropy; application引言:熵是信息论中的一个重要概念,对它的研究有十分重要的意义。

进入20世纪中叶,人们发现熵还可以用来描述信息,这就是信息熵。

1948年,在贝尔电报电话公司工作的应用数学家Shannon (香农,声农)发表了《通讯的数学理论》一文,成为信息论诞生的标志[1]。

目前,用得最多的熵函数是Shannon 熵。

Shannon 熵的概念的提出对通信技术的发展具有深远的影响,但是它的应用仅限于通信等一些很局限的领域而且香农熵的概念在连续随机变量下失去意义。

为了弥补Shannon 熵的缺陷,统计学家对熵的定义作了很多推广,形成了广义信息熵。

其中重要的是A.N.Kolmogorov 在1958年引入的ε熵。

ε熵不但解决了连续随机变量下香农熵定义推广时的困难,而且导致率失真理论的建立。

此外,A.Renyi 在1961年时认为香农熵只是在编码问题中才是唯一可取的形式,在其他情况下其他信息度量同样可用甚至更好。

Renyi 具体提出所谓的α阶熵,香农熵可以看成是α阶熵的一种极限形式因而被包括在α阶熵的概念之内。

自Renyi 后J.Havrda 在1967年提出β熵,S.Arimoto 在1971年提出γ熵,S.Guiasu 提出了加权熵,B.D.Sharma 和D.P.Mittal 于1975年提出α阶β次熵,C.Ferreri 于1980年引入次熵[2]。

这些熵在模糊集理论中有着重要的应用。

本文从Shannon 熵出发,讨论了主要讨论了Renyi 熵和Tsallis 熵这两种广义信息熵的性质及其应用。

1 Shannon 熵及其性质信息论所关心的是随机变量的不确定性。

显然,随机变量的不确定程度越高,我们从实验中可能获取的信息也就越多。

我们知道随机变量的不确定性与其概率分布有关,直观看来,随机变量的不确定程度并不一样。

如随机变量X ,Y ,Z ,T 的概率分布分别为:⎪⎪⎭⎫ ⎝⎛98.002.021a a ,⎪⎪⎭⎫ ⎝⎛6.04.021b b ,⎪⎪⎭⎫ ⎝⎛5.05.021c c ,P(T = a) = 1显然在这几个分布中,不确定性从小到大依次为:T ,X ,Y ,Z 。

对随机变量T ,它是一个常量型随机变量,不确定性为零,相应的概率分布称为退化分布。

Z 的不确定性最大,它服从等概率分布。

那么,若W ~⎪⎪⎭⎫ ⎝⎛414141414321w w w w ,则随机变量W 的不确定性比Z 还要高。

也就是说,X ~⎪⎪⎭⎫ ⎝⎛M M x x M 1...1...1,即随机变量X 服从等概率分布时的不确定性最大,且当M 增大时,不确定性也会增大。

由上述可知,随机变量的不确定性应该是它的概率分布的一个函数,记之为H (X )=H (P )=H (r 1,r 2,…,r M )。

这三种表示方法是等价的,其中P 是X 的概率分布。

Shannon 指出,这样的函数是存在的,并且应该满足以下性质:① 对称性:当概率空间中 P(x 1 ), ) P(x 2 )… 序任意互换时,熵函数的值不变;② 确定性:信源的输出虽有不同形态,但是如果其中只有一个状态是必然的,即其他状态不可能出现,那么这个信源是一个确知信源,其熵为0; ③ 非负性:H (X )≥0;④ 连续性:即H (r 1,r 2,…,r M ) 是P (r 1,r 2,…,r M )的非负连续函数;⑤ 可加性:当随机变量的取值不是通过一次试验而是通过若干次试验最后才得到的,随机变量在各次试验中的不确定性应该可加,且其和始终与通过一次试验取得的结果的不确定性相同;⑥ 递增性:等概率分布时为变量的单调递增函数;⑦ 极值性:离散无记忆信源输出q 个不同的信息符号,当且仅当各个符号出现概率相等时,信息熵最大,即:H (p 1, p 2,…,p q )≤H (qq q 1,...,1,1)=logq [3]。

事实上,上面的七个性质是非常容易理解的,不确定性当然不能是负值,前面也已经讨论了等概率分布时的不确定性随着随机变量取值个数的增加而增大,各个不确定结果应该可以相加。

可以证明出当H (X )=H (P )=H (r 1,r 2,…,r M )满足上述条件时,可唯一确定其形式:H (r 1,r 2,…,r M )=∑=M1i i log r -i c r 。

上面定义的就是Shannon 熵。

其c 决定了熵的单位,当c = 2,e ,3,10时,单位分别为“比特”,“奈特”,“铁特”,“笛特”。

一般我们都选择c = 2,也就是比特(bit)为信息的度量单位。

信息熵的定义使随机变量的不确定性得到了量度,使信息论得到了空前的发展。

而且,信息熵具有的凸函数性质使得它特别适合作为优化问题中的目标函数,这同时也为信息论概念和方法在除通信领域以外的其他领域内的应用提供了理论基础,拓宽了信息论的应用范围。

2 广义信息熵由于香农熵的概念在连续随机变量下失去意义,并不能解决实际生活中的一些问题,因此为了解决具体问题,人们也提出了各种各样的广义熵。

其中最重要的是1962 年Renyi 提出的Renyi 熵,在统计检验和图像处理中得到极大应用;1988 年,Tsallis 在Boltzmann-Gibbs(B-G)统计中引入了Tsallis 熵的数学表达式,T q =)1(1k ⎰-Ω-d qq ρ,其中k 为Boltzmann 常数,ρ是概率分布,满足∫ρd Ω = 1,q 是非负参数,且⎰=Ω-=→s q q H d k T ρρln lim 1,应用到统计力学,衍生出Tsallis 统计。

Tsallis 熵是建立在非广延动力学基础上的,引入了非广延系数q ,把熵的方法推广到不具有可加性(子系统间影响显著)的系统中。

Tsallis 熵是一种新的信息度量方法,是Shannon 熵的扩展,已经应用于图像处理和其他信息处理技术中。

下面介绍两种广义信息熵及其与Shannon 熵的联系与对比。

1、Renyi 熵对任意概率分布P (r 1,r 2,…,r M ),参数为q 的Renyi 熵定义为[4]H R (r)=)ln(-111∑=M i q i r q 2、Tsallis 熵对任意概率分布P (r 1,r 2,…,r M ),参数为q 的Tsallis 熵定义为H T (r)=)1(-111∑=-M i q i r q 3、Renyi 熵、Tsallis 熵、Shannon 熵的联系当参数q →1时,Renyi 熵与Tsallis 熵都等同于Shannon 熵,比如s i Mi i i M i q i M i q i q M i q i q M i q i q H r r r r r dq d r dq d r q =-=-=-=∑∑∑∑∑===-→=-→=-→ln ln 1lim )11(ln lim )ln(-11lim 11101101101 这里用到了∑=Mi i r 1=1及洛彼达法则[5]。

当参数q ≠ 1时,Renyi 熵与Tsallis 熵有如下关系:H R =))1(1ln(-11T H q q -+ 4、三种熵的性质对比对于Renyi 熵来说,它具备Shannon 熵的七个基本性质。

但是,对于Tsallis 熵则不满足独立可加性,它是最具有代表性的一种非广延熵。

也就是说Tsallis 熵与Shannon 熵最显著的区别在于可加性。