AP近邻传播聚类算法原理及Matlab实现

《若干改进近邻传播聚类算法及其应用》

《若干改进近邻传播聚类算法及其应用》一、引言近邻传播聚类算法(Affinity Propagation Clustering Algorithm,简称AP算法)是一种无监督的聚类方法,其通过信息传递的方式在数据集中发现潜在的聚类结构。

然而,原始的近邻传播聚类算法在某些情况下可能存在一些局限性,如计算复杂度高、对噪声敏感等。

因此,本文旨在探讨若干改进的近邻传播聚类算法及其应用。

二、原始近邻传播聚类算法近邻传播聚类算法基于样本间的相似性矩阵,通过信息传递过程确定数据集中的样本是否应该成为候选聚类中心。

在AP算法中,数据集中的每个样本都可能成为聚类中心,通过迭代更新信息传递过程,最终得到每个样本的聚类归属。

三、改进的近邻传播聚类算法1. 快速近邻传播聚类算法针对原始AP算法计算复杂度高的问题,我们提出了一种快速近邻传播聚类算法。

该算法通过引入近似计算和并行化处理的方式,降低计算复杂度,提高算法的执行效率。

具体而言,我们利用稀疏矩阵压缩技术对相似性矩阵进行压缩处理,然后采用并行化策略进行迭代更新,从而提高算法的整体执行速度。

2. 稳健的近邻传播聚类算法为了解决AP算法对噪声敏感的问题,我们提出了一种稳健的近邻传播聚类算法。

该算法在计算相似性矩阵时引入了噪声处理机制,通过设置阈值和滤波器等方式降低噪声对聚类结果的影响。

此外,我们还采用了鲁棒性更强的信息传递策略,以增强算法对噪声的抵抗能力。

3. 混合改进的近邻传播聚类算法针对不同应用场景的需求,我们还可以将上述两种改进策略相结合,形成混合改进的近邻传播聚类算法。

这种混合算法能够综合利用不同策略的优势,以应对各种复杂的数据结构和问题背景。

四、应用领域及效果分析1. 图像分割领域在图像分割领域中,近邻传播聚类算法被广泛应用于对图像进行超像素分割和目标区域识别。

通过改进的AP算法,可以提高图像分割的准确性和效率,降低计算复杂度。

2. 生物信息学领域在生物信息学领域中,我们可以通过近邻传播聚类算法对基因表达数据、蛋白质相互作用网络等生物数据进行聚类分析。

聚类算法matlab实现

聚类算法matlab实现英文回答:Clustering algorithms are widely used in data analysis and machine learning to group similar data points together. MATLAB provides several built-in functions and tools for implementing clustering algorithms. Here, I will discuss two commonly used clustering algorithms in MATLAB: k-means clustering and hierarchical clustering.1. K-means Clustering:K-means clustering is a popular algorithm for partitioning a dataset into k distinct clusters. MATLAB provides the function `kmeans` for implementing this algorithm. The basic steps to perform k-means clustering in MATLAB are as follows:Load or generate the dataset.Specify the number of clusters, k.Call the `kmeans` function with the dataset and k as input arguments.Retrieve the cluster assignments and cluster centroids from the output of the `kmeans` function.Here is an example of how to perform k-means clustering in MATLAB:matlab.% Generate a sample dataset.data = [randn(100,2); randn(100,2)+5];% Perform k-means clustering with k=2。

近邻传播聚类算法

近邻传播聚类算法

近邻传播(Nearest Neighbor Propagation,NNP)聚类算法是一种无监督学习的聚类算法,其核心思想是通过数据点之间的相似度(即距离)来传播信息以实现聚类。

该算法没有预先指定聚类个数,而是通过数据点之间的相似度逐步传播,将具有相似性的数据点划分到同一类别中。

算法步骤如下:

1. 计算样本点之间的相似度,通常使用欧氏距离或者其他距离度量。

2. 初始化每个样本点的传播结果,将其指定为初始标签。

3. 通过计算样本点与其它点之间的相似度,选择相似度最高的几个点进行信息传播。

4. 更新每个样本点的传播结果,将其划分到与之相似度最高的样本点所在的类别中。

5. 重复步骤3和步骤4,直到收敛为止,即不再发生样本点的类别变化。

近邻传播聚类算法的优点是可以自动发现数据中的聚类个数,并且对初始值不敏感。

同时,该算法可以处理非球形的聚类形状,并且能够处理有噪声或者缺失数据的情况。

然而,近邻传播聚类算法也存在一些缺点。

首先,该算法的时间复杂度较高,特别是在处理大规模数据集时会比较慢。

其次,算法的效果高度依赖于相似度的计算方式和参数的选择,不同的选择可能会导致不同的聚类结果。

总体来说,近邻传播聚类算法是一种简单且有效的聚类算法,适用于小型数据集和非球形聚类形状。

在实际应用中,可以根据具体问题的需求和数据特点来选择合适的聚类算法。

Matlab中的聚类分析与聚类算法

Matlab中的聚类分析与聚类算法一、引言聚类分析是一种将数据根据相似性进行分类的方法,常用于数据挖掘和模式识别领域。

而Matlab作为一种强大的数学计算工具,提供了丰富的聚类算法及函数库,为工程师和研究人员提供了便捷的分析工具。

本文将介绍Matlab中的聚类分析与聚类算法,并探讨其在实际应用中的一些技巧和注意事项。

二、聚类分析概述聚类分析是一种无监督学习算法,其目标是将相似的数据点分组,并将相似性高的数据点放在同一类别中。

聚类分析可以帮助我们发现数据集的内在模式和结构,从而提供对数据的认知和理解,并为后续的数据分析和决策提供支持。

三、Matlab中的聚类函数Matlab提供了多种聚类算法的函数,包括K均值聚类、层次聚类、密度聚类等。

其中,最常用的是K均值聚类算法。

1. K均值聚类算法K均值聚类是一种简单而有效的聚类算法,其基本思想是:将数据点分为K个簇,使得每个数据点与其所属簇的质心之间的距离最小。

在Matlab中,可以使用kmeans函数实现K均值聚类。

该函数需要输入聚类的数据集和聚类的簇数K,并返回每个数据点所属的簇标签和质心位置。

2. 层次聚类算法层次聚类是一种基于数据点之间的相似性或距离进行聚类的方法。

在Matlab中,agglocluster函数提供了层次聚类的实现。

该函数可以根据用户定义的相似性度量和聚类距离计算方法,将数据点逐步合并为越来越大的簇。

3. 密度聚类算法密度聚类是一种将数据点集合划分为具有相似密度的区域的聚类方法。

在Matlab中,dbscan函数可以实现密度聚类。

该函数根据用户定义的半径和密度阈值,将数据点分为核心点、边界点和噪声点,并将核心点连接成簇。

四、聚类算法的应用聚类算法在实际应用中具有广泛的应用,下面将介绍两个典型的聚类算法应用案例。

1. 图像分割聚类算法可以用于图像分割,即将一幅图像按照内容划分为多个区域。

在Matlab中,可以使用kmeans函数将图像像素分为不同的簇,从而实现图像分割。

AP近邻传播聚类算法原理及Matlab实现

AP近邻传播聚类算法原理及Matlab实现Affinit y Propaga tion (AP)聚类是2007年在Scie nce杂志上提出的一种新的聚类算法。

它根据N个数据点之间的相似度进行聚类,这些相似度可以是对称的,即两个数据点互相之间的相似度一样(如欧氏距离);也可以是不对称的,即两个数据点互相之间的相似度不等。

这些相似度组成N×N的相似度矩阵S(其中N为有N个数据点)。

AP算法不需要事先指定聚类数目,相反它将所有的数据点都作为潜在的聚类中心,称之为exem plar。

以S矩阵的对角线上的数值s(k, k)作为k点能否成为聚类中心的评判标准,这意味着该值越大,这个点成为聚类中心的可能性也就越大,这个值又称作参考度p( prefere nce)。

聚类的数量受到参考度p的影响,如果认为每个数据点都有可能作为聚类中心,那么p就应取相同的值。

如果取输入的相似度的均值作为p的值,得到聚类数量是中等的。

如果取最小值,得到类数较少的聚类。

AP算法中传递两种类型的消息,(respons iility)和(availab ility)。

r(i,k)表示从点i发送到候选聚类中心k的数值消息,反映k点是否适合作为i点的聚类中心。

a(i,k)则从候选聚类中心k发送到i的数值消息,反映i点是否选择k作为其聚类中心。

r(i, k)与a (i, k)越强,则k点作为聚类中心的可能性就越大,并且i点隶属于以k点为聚类中心的聚类的可能性也越大。

AP算法通过迭代过程不断更新每一个点的吸引度和归属度值,直到产生m个高质量的exe mplar,同时将其余的数据点分配到相应的聚类中。

在这里介绍几个文中常出现的名词:exempla r:指的是聚类中心。

similar ity:数据点i和点j的相似度记为S(i,j)。

用matlab做聚类分析

用matlab做聚类分析MATLAB提供了两种方法进行聚类分析:一、利用clusterdata 函数对数据样本进行一次聚类,这个方法简洁方便,其特点是使用范围较窄,不能由用户根据自身需要来设定参数,更改距离计算方法;二、步聚类:(1)用pdist函数计算变量之间的距离,找到数据集合中两辆变量之间的相似性和非相似性;(2)用linkage函数定义变量之间的连接;(3)用cophenet函数评价聚类信息;(4)用cluster函数进行聚类。

下边详细介绍两种方法:1、一次聚类Clusterdata函数可以视为pdist、linkage与cluster的综合,即Clusterdata函数调用了pdist、linkage和cluster,用来由原始样本数据矩阵X创建系统聚类,一般比较简单。

clusterdata函数的调用格式:T=clusterdata(X,cutoff)输出参数T是一个包含n个元素的列向量,其元素为相应观测所属类的类序号。

输入 的矩阵,矩阵的每一行对应一个观测(样品),每一列对应一个变量。

Cutoff 参数X是n p为阈值。

(1)当0<cutoff<2时,T=clusterdata(X,cutoff) 等价于Y=pdist(X,’euclid’); Z=linkage(Y,’single’); T=cluster(Z,’cutoff’,cutoff) ;(‘cutoff’指定不一致系数或距离的阈值,参数值为正实数)(2)Cutoff>>2时,T=clusterdata(X,cutoff) 等价于Y=pdist(X,’euclid’); Z=linkage(Y,’single’); T=cluster(Z, ‘maxclust’,cutoff) ;(‘maxclust’指定最大类数,参数值为正整数)2、分步聚类(1)求出变量之间的相似性用pdist函数计算出相似矩阵,有多种方法可以求距离,若此前数据还未无量纲化,则可用zscore函数对其标准化【pdist函数:调用格式:Y=pdist(X,’metric’)说明:X是M*N矩阵,为由M个样本组成,每个样本有N个字段的数据集‘seuclidean’:metirc取值为:’euclidean’:欧氏距离(默认)标准化欧氏距离;‘mahalanobis’:马氏距离;闵科夫斯基距离:‘ minkowski’;绝对值距离:‘ cityblock’…】pdist生成一个M*(M-1)/2个元素的行向量,分别表示M个样本两两间的距离。

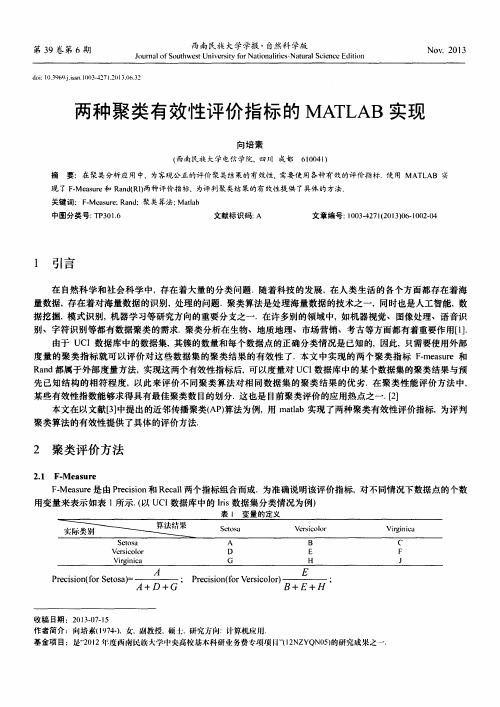

两种聚类有效性评价指标的MATLAB实现

用变量来表示如表 1 所示. ( 以U C I 数据库中的 I r i s 数据集分类情况为例)

表 I 变 量 的 定 义

№i s i 。 n 稿 日期 :2 ( ) l 3 . 0 7 . 1 5

; … c r o r v e r s i c o l o r 矗 :

从表 1 中可以看到, A P算法对 I i r s 数据集的聚类结果, 实际属于 S e t o s a 类的 5 O个数据点都被正确聚类到 S e t o s a 类中;实际属于 V e r s i c o l o r 类的 5 0 个数据点, 有4 5 个被正确聚类到 V e r s i c o l o r 中, 另有 5 个点被错误聚类 到V i r g i n i c a 类 中; 实际属于 V i r g i n i c a 类的 5 0个数据点, 有4 3个点被正确的聚类到 V i r g i n i c a 类中,另有 7 个点 被 错 误聚 类 到 V e r s i c o l o r中.

l 0 0 3

c i s i 。 l 1 ( 衙 vi r g i n i c a ) =

;

c a n ( f o r S e t o s a ) A

+ +

B C ; R e c a l l ( 衙 s i c o l o r )

D + E+ F

;

Re c a I l ( f o r v i r g i n i c a ) =

第3 9卷 第 6期

1

铁

报 黼

学版

J o u r n a 1 o f S o u t h we s t Un i v e r s i t y r Na t i o n a l i t i c s . Na Na t u r a 1 S c i e n c e E d i t i o n

近邻半监督聚类算法的MATLAB实现

Key wor : u trn l o t m AP S ds Clsei g ag r h i AP; ATLAB M

1、 引 言

成 的 相 似 度 矩 阵 进 行调 整 , 而 达 到 提 高 A 算 法 的聚 类 性 能 的 目 进 P

聚类算法是数 据挖掘 , 模式识别 , 机器学 习等研究方 向的重要 的 。 本文 在Matb t 环境 下实现了基于近邻 传播 的半 监督 聚类算 a 分支之一 。 聚类算法 是在没有任何数据的先验信 息下对数据进行分 法, 并将其加入到Malb t 的工具箱 中。 a 类的方法 。 类算法又称为无监督学 习方法 。 这

Xi n e s a g P iu S h o f e tia n n o m a i n E g n e i g, S u h etUn v riy f r Na i na te , c o l c r l d I f r to n i e rn o El c a o t w s i est o to l i s i Che d , ih a 6 0 4 , i a ng u S c u n,1 0 1 Ch n

A src :h a e rp sdaM ATL B rga b t t epp r o oe a T p A po rmmigo e — u evsdCls r gB sdo fnt rp gt nAg rh a d on dt e n f mi S p ri uti ae nAf i Po a a o lo tm n ie t S e en i y i i j oh

舔 与法。 ●十 敦广 一 字一 半监督聚类是利用部分标记数据信息对未标记数据集进行聚类

21 . AP算法

近 邻 传 播 聚 类 算 法 ( 算 法 ) 由B e d n J F e 和 D let AP 是 rn a . ry eb r

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

AP近邻传播聚类算法原理及Matlab实现

Affinity Propagation (AP)聚类是2007年在Science杂志上提出的一种新的聚类算法。

它根据N个数据点之间的相似度进行聚类,这些相似度可以是对称的,即两个数据点互相之间的相似度一样(如欧氏距离);也可以是不对称的,即两个数据点互相之间的相似度不等。

这些相似度组成N×N的相似度矩阵S(其中N为

有N个数据点)。

AP算法不需要事先指定聚类数目,相反它将所有的数据点都作为潜在的聚类中心,称之为exemplar。

以S矩阵的对角线上的数值s(k, k)作为k点能否成为聚类中心的评判标准,这意味着该值越大,这个点成

为聚类中心的可能性也就越大,这个值又称作参考度p( preference)。

聚类的数量受到参考度p的影响,如果认为每个数据点都有可能作为聚类中心,那么p就应取相同的值。

如果取输入的相似度的均值作为p的值,得到聚类数量是中等的。

如果取最小值,得到类数较少的聚类。

AP算法中传递两种类型的消息,(responsiility)和(availability)。

r(i,k)表示从点i发送到候选聚类中心k

的数值消息,反映k点是否适合作为i点的聚类中心。

a(i,k)则从候选聚类中心k发送到i的数值消息,反映

i点是否选择k作为其聚类中心。

r(i, k)与a (i, k)越强,则k点作为聚类中心的可能性就越大,并且i点隶属于以k点为聚类中心的聚类的可能性也越大。

AP算法通过迭代过程不断更新每一个点的吸引度和归属度值,直到产生m个高质量的exemplar,同时将其余的数据点分配到相应的聚类中。

在这里介绍几个文中常出现的名词:

exemplar:指的是聚类中心。

similarity:数据点i和点j的相似度记为S(i,j)。

是指点j作为点i的聚类中心的相似度。

preference:数据点i的参考度称为P(i)或S(i,i)。

是指点i作为聚类中心的参考度。

一般取S相似度值

的中值。

Responsibility:R(i,k)用来描述点k适合作为数据点i的聚类中心的程度。

Availability:A(i,k)用来描述点i选择点k作为其聚类中心的适合程度。

Damping factor:阻尼系数,主要是起收敛作用的。

机器学习中一个很重要的方面就是聚类算法。

聚类算法说白了就是给你一大堆点的坐标(维度可以是很高的),然后给你一个距离度量的准则(比如欧拉距离,马氏距离什么的),然后你要自动把相近的点放在一个集合里面,归为一类。

继续科普:一个比较传统的聚类算法就是k-Means聚类,算法很简单,哦,说起这件事,我刚刚在整理东西时就发现了一篇讲到k-Means的论文,里面又是一大堆看不懂的符号,我说你们真的有必要那么装逼么??

比如说下面这幅图,有这么多个点,我们强大的大脑可以瞬间分辨出这里有三个团簇,一般术语叫cluster。

但是K-Means算法是怎么实现的呢?

首先我们已经知道有三个类了,所以呢就随机的选三个点(上图最左),作为三个类的中心,也可以

叫做代表点,之后呢把图中所有的点归于离他最近的那个点,认为这个点就是属于这一类(上图左二),

显然这样分类是不行的,然后我们计算每个类的那些点的中心(或者称为重心),把每个类的代表点的位

置移到这个类的重心处(上图右二),然后再把全图中所有点都归于他们最近的那个类代表点,这时有些

点的归属就会发生变化,然后不断的这么迭代,知道所有点的归属都不再变化为止,我们就认为这个算法收敛了。

显然这个算法很简单,比较简陋,但是大部分情况下都很实用!!要说缺点的话,第一,我们必须先

知道总共有多少个类,其次就是算法最后能否收敛和收敛的速度对开始随机挑的那几个点很敏感。

好吧,扯远了,我这篇博文不是为了讲K-Means的,想介绍的是近邻传播聚类算法。

近邻传播,英文是affinity propagation,它是一种半监督聚类算法。

比起传统的像K-Means,它有很多别的算法所望尘莫及的优势,比如不需事先指定类的个数,对初值的选取不敏感,对距离矩阵的对称性没要求等。

AP聚类算法是将每个数据看成图中的一个节点,迭代的过程即是在图中通过传播信息来找到聚类集合。

本文计算两个数据点的相似度采用距离的负数,也就是说距离越近,相似度越大。

相似矩阵S中i到j的

相似度就是刚刚所说的距离的负数。

但是主对角线上的那些数表示的是某个点和自身的相似度,但是这里我们不能直接用0来表示。

根据算法要求,主对角线上的值s(k,k)一般称为偏向参数,一般情况下对所有k,s(k,k)都相等,取非主对角线上的所有数的中位数。

这个值很重要,他的大小与最后得到的类的数目有关,一般而言这个数越大,得到的类的数目就越多。

这里为什么要设定一个偏向参数而不直接用0来算呢,估计是因为AP聚类算法是要用图论的一些东

西来理解的,它把所有的点都看成一个图中的节点,通过节点之间的信息传递来达到聚类的效果。

具体比较复杂,形象一点说就是我告诉你我和这些人是死党,如果你认为你也是我死党的话,那你就加入我们这一堆人里面来吧!

有一些详细的原理上的东西就不说了,直接说计算过程吧。

聚类就是个不断迭代的过程,迭代的过

程主要更新两个矩阵,代表(Responsibility)矩阵R = [r(i,k)]N×N和适选(Availabilities)矩阵A=[a(i,k)]N×N。

这两个矩阵才初始化为0,N是所有样本的数目。

r(i,k)表示第k个样本适合作为第i个样本的类代表点的代表程

度,a(i,k)表示第i个样本选择第k个样本作为类代表样本的适合程度。

迭代更新公式如下:

每次更新后就可以确定当前样本i的代表样本(exemplar)点k,k就是使{a(i,k)+r(i,k)}取得最大值的那个k,如果i=k的话,那么说明样本i就是自己这个cluster的类代表点,如果不是,那么说明i属于k所属的那个cluster。

当然,迭代停止的条件就是所有的样本的所属都不在变化为止,或者迭代了n次都还没有变化(n的值可以自己取)。

说起来还有一种判断点属于属于哪一类的方法,就是找出所有决策矩阵主对角线元素{a(k,k)+r(k,k)}大于0的所有点,这些点全部都是类代表点,之后在决定其余的点属于这里面的一类。

这两种方法的结果我没比较过诶,不知是不是一样的。

另外还有一点就是AP聚类算法迭代过程很容易产生震荡,所以一般每次迭代都加上一个阻尼系数λ:r new(i,k) = λ*r old(i,k) + (1-λ)*r(i,k)

a new(i,k) = λ*a old(i,k) + (1-λ)*a(i,k)

下图是采用下面的API画出来的聚类结果:

下面就它的优缺点进行简要的叙述,不做任何理论上的解释:

(1)与众多聚类算法不同,AP聚类不需要指定K(经典的K-Means)或者是其他描述聚类个数(SOM中的网络结构和规模)的参数。

(2)一个聚类中最具代表性的点在AP算法中叫做Examplar,与其他算法中的聚类中心不同,examplar 是原始数据中确切存在的一个数据点,而不是由多个数据点求平均而得到的聚类中心(K-Means)。

(3)多次执行AP聚类算法,得到的结果是完全一样的,即不需要进行随机选取初值步骤。

(4)算法复杂度较高,为O(N*N*logN),而K-Means只是O(N*K)的复杂度。

因此当N比较大时(N>3000),AP聚类算法往往需要算很久。

(*5)若以误差平方和来衡量算法间的优劣,AP聚类比其他方法的误差平方和都要低。

(无论k-center

clustering重复多少次,都达不到AP那么低的误差平方和)

(*6)AP通过输入相似度矩阵来启动算法,因此允许数据呈非欧拉分布,也允许非常规的点-点度量方法。