好程序员大数据ELK相关原理

elk的组成

elk的组成(原创实用版)目录1.ELK 的含义2.ELK 的组成部分3.各组成部分的功能与作用4.ELK 的应用场景正文ELK(Elasticsearch、Logstash、Kibana)是一个基于开源软件的日志分析系统,广泛应用于大数据处理、实时数据分析和可视化等领域。

下面我们将详细介绍 ELK 的组成及其功能与作用。

1.ELK 的含义ELK 是一个缩写,分别代表 Elasticsearch、Logstash 和 Kibana 三款开源软件。

Elasticsearch 是一款分布式搜索引擎,能够实现对海量数据的快速搜索、分析和存储。

Logstash 是一款数据收集引擎,负责从各种数据源采集数据,并将数据进行处理后传输给 Elasticsearch。

Kibana 是一款数据可视化工具,可以方便地对 Elasticsearch 中的数据进行分析和可视化。

2.ELK 的组成部分(1)Elasticsearch:Elasticsearch 是一款高性能的分布式搜索引擎,能够实现对海量数据的实时搜索、分析和存储。

它采用倒排索引技术,能够大幅提高搜索速度。

同时,Elasticsearch 还支持多种数据类型,如文本、数字、日期等,适应各种复杂场景。

(2)Logstash:Logstash 是一款数据收集引擎,可以接收来自各种数据源的数据,如日志文件、数据库、消息队列等。

Logstash 支持多种插件,可以根据需要进行数据过滤、转换和增强。

经过处理后的数据被传输到 Elasticsearch 进行存储和分析。

(3)Kibana:Kibana 是一款数据可视化工具,可以方便地对Elasticsearch 中的数据进行分析和可视化。

通过 Kibana,用户可以轻松生成各种报表、仪表盘和图表,实时监控数据变化,发现数据中的规律和趋势。

3.各组成部分的功能与作用(1)Elasticsearch:负责存储、分析和搜索数据,提供高性能的搜索功能。

ELK日志分析系统

ELK日志分析系统ELK日志分析系统是一种常用的开源日志管理和分析平台。

它由三个主要组件组成,即Elasticsearch、Logstash和Kibana,分别用于收集、存储、分析和可视化日志数据。

本文将介绍ELK日志分析系统的原理、特点和应用场景等。

ELK日志分析系统具有以下几个特点。

首先,它是一个开源系统,用户可以自由获取、使用和修改代码,满足各种定制化需求。

其次,它具有高度的可扩展性和灵活性,可以处理海量的日志数据,并支持实时查询和分析。

再次,它采用分布式架构,可以部署在多台服务器上,实现高可用性和负载均衡。

最后,它提供了丰富的可视化工具和功能,让用户可以直观地了解和分析日志数据,发现潜在的问题和异常。

ELK日志分析系统在各种场景下都有广泛的应用。

首先,它可以用于系统日志的监控和故障诊断。

通过收集和分析系统的日志数据,可以及时发现和解决问题,保证系统的正常运行。

其次,它可以用于应用程序的性能监控和优化。

通过分析应用程序的日志数据,可以找到性能瓶颈和潜在的问题,并采取相应的措施进行优化。

再次,它可以用于网络安全监控和威胁检测。

通过分析网络设备和服务器的日志数据,可以及时发现并应对潜在的安全威胁。

最后,它还可以用于业务数据分析和用户行为追踪。

通过分析用户的访问日志和行为日志,可以了解用户的偏好和行为模式,为业务决策提供依据。

然而,ELK日志分析系统也存在一些挑战和限制。

首先,对于大规模的日志数据,ELK系统需要消耗大量的存储和计算资源,对硬件设施和系统性能要求较高。

其次,ELK系统对日志的结构有一定的要求,如果日志数据过于复杂或不规范,可能会造成数据解析和处理的困难。

再次,ELK系统对于数据的实时性要求较高,以保证用户能够在短时间内获取到最新的数据和分析结果。

最后,对于非技术人员来说,ELK系统的配置和使用可能较为复杂,需要一定的培训和专业知识。

总之,ELK日志分析系统是一种功能强大且灵活的日志管理和分析工具,可以帮助用户实现日志数据的收集、存储、分析和可视化展示。

elk的工作原理

elk的工作原理Elk是一种开源的日志管理工具,由Elasticsearch、Logstash和Kibana三个组件组成。

它的工作原理可以分为以下几个步骤:1. 数据采集:Logstash作为数据采集引擎,能够从多种来源(如文件、数据库、消息队列等)收集、过滤、转换和传输数据。

用户可以通过Logstash配置输入插件来指定数据来源,如输入插件可以是Filebeat,它可以监控指定的日志文件并将日志数据传输给Logstash。

2. 数据存储:Elasticsearch是一个实时分布式搜索和分析引擎,作为Elk的核心组件,它用于接收、存储和索引采集到的日志数据。

Logstash可以将处理后的数据发送给Elasticsearch进行索引,以便后续的搜索和分析。

在Elasticsearch中,数据被分散存储在多个节点上,这样可以提高数据的可靠性和可扩展性。

3. 数据可视化:Kibana是一个用于日志数据可视化和分析的工具,它通过与Elasticsearch服务器进行通信,可以对存储在Elasticsearch中的日志数据进行查询、可视化和分析。

用户可以通过Kibana的Web界面创建仪表板、图表和可视化面板来展示日志数据的各种统计信息,并通过搜索、过滤和聚合功能来获取所需的信息。

Elk的工作原理可以理解为数据采集、数据存储和数据可视化三个主要步骤的协作。

Logstash负责从不同的数据源收集数据,并对数据进行处理和转换;Elasticsearch负责接收和存储数据,并提供强大的搜索和分析功能;Kibana负责将存储在Elasticsearch中的数据可视化展示给用户,以便用户能够更直观地理解和分析数据。

在使用Elk时,用户首先需要配置Logstash来指定数据的来源和需要进行的处理操作,如数据过滤、转换和分割等。

然后,Logstash将处理后的数据发送给Elasticsearch进行存储和索引。

最后,用户可以通过Kibana的界面进行数据的查询、可视化和分析。

ELK是什么?

ELK是什么?

ELK是⼀套⽇志数据收集、分析、检索的解决⽅案,并不是⼀款软件,其中E代表ElasticSearch,负责⽇志的存储和检索;

L代表Logstash,负责⽇志的收集,过滤和格式化;

K代表Kibana,负责⽇志的展⽰统计和数据可视化。

ELK的特性:

多台机器的⽇志集中分析和查看LogStach

多种机器的⽇志集中分析和查看 LogStach

查询性能⾼ ES

⽀持多维度的复杂查询 ES

图形化展⽰查询结果,界⾯绚丽 Kibana

实时性好,可以做实时预警 ES

提供良好的api供第三⽅扩展 ES和Logstach都可以扩展

配合简单,容易上⼿

ELK常见应⽤场景:

1.安全领域:通过分析系统⽇志,发现共计或者⾮法访问⾏为,可以追踪定位相关安全问题

2.⽹络领域:⽇志分析和监控可以作为⽹络设备监控的⼀种补充,实时监控和预警。

3.应⽤领域:分析和展⽰应⽤运⾏时的实时情况,如业务访问量、业务访问⾼峰情况等;分析nginx⽇志得到⽹站的访问情况,如⽹站点击数、请求总数、平均每秒请求数、峰值请求数等。

可以⼤体了解系统压⼒,作为系统扩容、性能及压⼒测试时的参考

4.其他应⽤:还可以应⽤于社会⼯程学的⽤户画像;函数堆栈调⽤分析;⽹络流量分析等。

ELK日志分析系统

ELK日志分析系统ELK日志分析系统(Elasticsearch, Logstash, Kibana)是一种用于实时数据分析和可视化的开源工具组合。

它结合了Elasticsearch、Logstash和Kibana这三个工具,可对大量的日志数据进行收集、存储、和分析,并通过直观的可视化界面展示分析结果。

本文将对ELK日志分析系统的原理、功能和应用进行介绍。

2. 数据存储和索引:ELK日志分析系统使用Elasticsearch作为底层存储和索引引擎。

Elasticsearch是一个高性能、分布式的和分析引擎,能够实时地处理大规模的数据,并提供复杂的、聚合和分析功能。

Elasticsearch使用倒排索引来加快速度,并支持多种查询和分析方式,如全文、聚合查询、时序分析等。

3. 数据和查询:ELK日志分析系统通过Elasticsearch提供强大的和查询功能。

用户可以使用简单的关键字查询或复杂的过滤条件来和筛选数据。

同时,Elasticsearch还支持模糊、近似和正则表达式等高级方式,以便更精确地找到所需的数据。

4. 数据可视化和分析:ELK日志分析系统的另一个重要功能是数据的可视化和分析。

通过Kibana工具,用户可以创建自定义的仪表板和图表,展示日志数据的各种指标和趋势。

Kibana支持多种图表类型,如柱状图、折线图、饼图等,并提供交互式过滤和数据透视功能,以帮助用户更好地理解和分析数据。

ELK日志分析系统在实际应用中具有广泛的用途。

首先,它可以用于系统监控和故障排查。

通过收集和分析系统日志,可以实时监控系统的运行状态,并及时发现和解决潜在的问题。

其次,ELK日志分析系统可以用于安全事件检测和威胁分析。

通过分析网络和应用日志,可以识别潜在的安全威胁,提高系统的安全性。

此外,ELK日志分析系统还可以用于运营分析、业务分析和市场分析等领域,帮助企业更好地理解和利用日志数据,提升业务效率和竞争力。

总之,ELK日志分析系统是一种功能强大的实时数据分析和可视化工具组合。

ELK原理详解范文

ELK原理详解范文ELK(Elasticsearch,Logstash,Kibana)是一套常用的日志管理与监控系统,被广泛应用于企业中,用于收集、存储、和分析各种形式的日志数据。

本文将详细介绍ELK的原理及其组件。

1. ElasticsearchElasticsearch是一个分布式的开源引擎,采用面向文档的存储方式,可以存储大量的数据,并提供快速的、聚合和分析功能,支持实时、全文和结构化。

其基于分布式架构,数据可以分散存储在多台机器上,提供高可用和高性能的服务。

2. Logstash3. KibanaKibana是一个开源的数据可视化平台,用于展示和分析Elasticsearch中的数据。

Kibana提供了丰富的图表和仪表盘,可以实时展示数据的变化趋势和统计信息,并支持自定义查询和过滤条件。

Kibana还支持基于地理位置的数据可视化,可以将数据以地图的形式展示。

用户可以通过Kibana直观地查看和分析日志数据,发现潜在问题和趋势。

ELK的工作原理如下:1) 数据采集:Logstash负责从各种输入源(如文件、消息队列、网络协议)中采集数据,可以使用丰富的过滤器对数据进行处理和转换。

处理后的数据可以通过插件输出到多种目标,如Elasticsearch、文件等。

2) 数据存储:Logstash将处理后的数据传输给Elasticsearch进行存储和索引。

Elasticsearch将数据分散存储在多台机器上,以实现高可用和高性能的服务。

数据在Elasticsearch中以可的文档形式存储,可以进行复杂的查询和聚合操作。

3) 数据可视化:Kibana从Elasticsearch中获取数据,并提供了丰富的图表和仪表盘,用户可以通过Kibana直观地查看和分析日志数据。

Kibana可以根据用户的需要定义查询和过滤条件,以获取特定的数据视图。

ELK的优势:1) 强大的和查询功能:Elasticsearch提供了全文和结构化的能力,可以高效地执行各种查询操作,帮助用户快速定位和解决问题。

elk日志采集原理

elk日志采集原理ELK日志采集原理:ELK(即Elasticsearch, Logstash, Kibana)是一套开源的日志管理解决方案,用于帮助组织收集、存储、搜索和可视化大量日志数据。

ELK的日志采集原理是通过以下三个组件合作实现的。

首先是Logstash,它是一个数据收集引擎,负责接收来自不同源的日志数据,并对这些数据进行过滤、解析和转换。

Logstash可以监听多个输入源,例如文件、网络流、消息队列等,通过插件提供了丰富的输入源和过滤器选项,以适应各种日志格式和数据源的要求。

其次是Elasticsearch,它是一个分布式搜索和分析引擎,用于存储和索引Logstash收集到的日志数据。

Elasticsearch采用倒排索引的方式,可以快速查询和检索大量的日志数据。

它具有高扩展性和分布式特性,能够处理大规模的数据量和并发请求。

最后是Kibana,它是一个用于可视化和分析日志数据的工具。

Kibana提供了丰富的图表、表格和地图等可视化组件,可以基于Elasticsearch中的日志数据构建各种仪表板和报表。

用户可以通过Kibana进行数据的交互式查询和分析,帮助他们发现潜在的问题、趋势和模式。

总结一下,ELK日志采集原理可以简化为以下几个步骤:Logstash接收和解析各种日志数据,然后将处理后的数据发送到Elasticsearch进行存储和索引,最后通过Kibana对存储在Elasticsearch中的数据进行可视化和分析。

ELK日志采集方案的优点在于它提供了一个端到端的解决方案,具有高度的可扩展性、灵活性和可定制性。

它能够帮助组织在海量的日志数据中快速定位和解决问题,并提供实时的监控和分析功能。

通过使用ELK日志采集原理提供的强大功能,组织可以更好地管理和利用自身的日志数据。

ELK原理详解

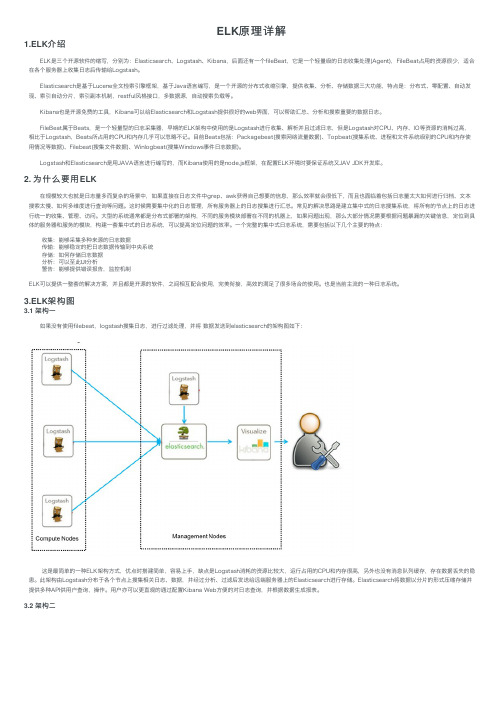

ELK原理详解1.ELK介绍 ELK是三个开源软件的缩写,分别为:Elasticsearch、Logstash、Kibana,后⾯还有⼀个fileBeat,它是⼀个轻量级的⽇志收集处理(Agent),FileBeat占⽤的资源很少,适合在各个服务器上收集⽇志后传输给Logstash。

Elasticsearch是基于Lucene全⽂检索引擎框架,基于Java语⾔编写,是⼀个开源的分布式收缩引擎,提供收集、分析、存储数据三⼤功能,特点是:分布式、零配置、⾃动发现、索引⾃动分⽚,索引副本机制,restful风格接⼝,多数据源,⾃动搜索负载等。

Kibana也是开源免费的⼯具,Kibana可以给Elasticsearch和Logstash提供很好的web界⾯,可以帮助汇总、分析和搜索重要的数据⽇志。

FileBeat属于Beats,是⼀个轻量型的⽇志采集器,早期的ELK架构中使⽤的是Logstash进⾏收集、解析并且过滤⽇志,但是Logstash对CPU、内存、IO等资源的消耗过⾼,相⽐于Logstash,Beats所占⽤的CPU和内存⼏乎可以忽略不记。

⽬前Beats包括:Packagebeat(搜索⽹络流量数据)、Topbeat(搜集系统、进程和⽂件系统级别的CPU和内存使⽤情况等数据)、Filebeat(搜集⽂件数据)、Winlogbeat(搜集Windows事件⽇志数据)。

Logstash和Elasticsearch是⽤JAVA语⾔进⾏编写的,⽽Kibana使⽤的是node.js框架,在配置ELK环境时要保证系统⼜JAV JDK开发库。

2. 为什么要⽤ELK 在规模较⼤也就是⽇志量多⽽复杂的场景中,如果直接在⽇志⽂件中grep、awk获得⾃⼰想要的信息,那么效率就会很低下,⽽且也⾯临着包括⽇志量太⼤如何进⾏归档、⽂本搜索太慢、如何多维度进⾏查询等问题。

这时候需要集中化的⽇志管理,所有服务器上的⽇志搜集进⾏汇总。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

【原创技术贴】ELK相关原理解析bin 存放elasticSearch 运行命令config 存放配置文件lib 存放elasticSearch运行依赖jar包modules 存放elasticSearch 模块plugins 存放插件1.1 Elasticsearch与Mysql对比Elasticsearch 集群可以包含多个索引(Index),每个索引可以包含多个类型(Type),每个类型可以包含多个文档(Document),每个文档可以包含多个字段(Field)。

以下是 MySQL 和 Elasticsearch 的术语类比图,帮助理解:就像使用 MySQL 必须指定 Database 一样,要使用 Elasticsearch 首先需要创建Index:client.indices.create({index : 'blog'});这样就创建了一个名为 blog的 Index。

Type 不用单独创建,在创建 Mapping 时指定就可以。

Mapping 用来定义 Document 中每个字段的类型,即所使用的 analyzer、是否索引等属性,非常关键等。

索引对象(blob):存储数据的表结构,任何搜索数据,存放在索引对象上。

映射(mapping):数据如何存放到索引对象上,需要有一个映射配置,包括:数据类型、是否存储、是否分词等。

文档(document):一条数据记录,存在索引对象上。

文档类型(type):一个索引对象存放多种类型数据,数据用文档类型进行标识。

那这里后续编程可分为以下操作步骤:第一步:建立索引对象。

第二步:建立映射。

第三步:存储数据“文档”。

第四步:指定文档类型进行搜索数据“文档”。

1.2 创建一个索引Elasticsearch 命令的一般格式是:REST VERBHOST:9200/index/doc-type,其中 REST VERB 是 PUT、GET 或DELETE。

(使用 curlL -X 动词前缀来明确指定 HTTP 方法。

)要创建一个索引,可在你的 shell 中运行以下命令:curl -XPUT并对其进行查看。

1.3 插入一个文档要在 /blog01 索引下创建一个类型,可插入一个文档。

它要将包含“Deck the Halls” 的文档插入索引中,可运行以下命令(将该命令和本教程的其他 CURL 命令都键入到一行中):curl -XPUT "http://localhost:9200/blog01/article/1" -d "{"""id""": """1""", """title""": """Whatiselasticsearch"""}"前面的命令使用 PUT 动词将一个文档添加到 /article文档类型,并为该文档分配 ID 为1。

URL 路径显示为index/doctype/ID(索引/文档类型/ID)。

1.4查看文档要查看该文档,可使用简单的 GET 命令:curl -XGET "http://localhost:9200/blog01/article/1"Elasticsearch 使用你之前 PUT 进索引中的 JSON 内容作为响应。

1.5更新文档如果你认识到title字段写错了,并想将它更改为 Whatislucene 怎么办?可运行以下命令来更新文档:curl -XPUT "http://localhost:9200/blog01/article/1" -d "{"""id""": """1""", """title""": """Whatislucene"""}"因为此命令使用了相同的唯一 ID为1,所以该文档会被更新。

1.6 搜索文档是时候运行一次基本查询了,此查询比你运行来查找“Get the Halls” 文档的简单 GET 要复杂一些。

文档 URL 有一个内置的 _search 端点用于此用途。

在标题中找到所有包含单词 lucene 的数据:curl -XGET "http://localhost:9200/blog01/article/_search?q=title:'Whatislucene'"参数表示一个查询。

1.7 检查搜索返回对象上图中给出了 Elasticsearch 从前面的查询返回的数据。

在结果中,Elasticsearch 提供了多个 JSON 对象。

第一个对象包含请求的元数据:看看该请求花了多少毫秒 (took) 和它是否超时 (timed_out)。

_shards 字段需要考虑Elasticsearch 是一个集群化服务的事实。

甚至在这个单节点本地部署中,Elasticsearch 也在逻辑上被集群化为分片。

在往后看可以观察到 hits 对象包含: total 字段,它会告诉你获得了多少个结果;max_score,用于全文搜索;实际结果,它包含 fields 属性,因为你将 fields 参数添加到了查询中。

否则,结果中会包含 source,而且包含完整的匹配文档。

_index、_type 和 _id 分别表示索引、文档类型、ID;_score 指的是全文搜索命中长度。

这 4 个字段始终会在结果中返回。

1.8 删除文档暂时不要删除该文档,知道如何删除它就行了:curl -XDELETE "http://localhost:9200/blog01/article/1"1.9.删除索引暂时不要删除该文档,知道如何删除它就行了:curl -XDELETE "http://localhost:9200/blog01"要使用 Elasticsearch 首先需要创建 Index:client.indices.create({index : 'blog'});创建了一个名为 blog的 IndexType 不用单独创建,在创建 Mapping 时指定就可以。

Mapping 用来定义 Document 中每个字段的类型,即所使用的 analyzer、是否索引等属性,非常关键等URL 路径显示为index/doctype/ID(索引/文档类型/ID)。

创建文档(插入一条数据),自动创建索引和映射=import org.elasticsearch.action.index.IndexResponse;import org.elasticsearch.client.Client;import org.elasticsearch.client.transport.TransportClient;import mon.transport.InetSocketTransportAddress;import mon.xcontent.XContentBuilder;import mon.xcontent.XContentFactory;import org.junit.Before;import org.junit.Test;import .InetAddress;import java.util.HashMap;import java.util.Map;public class ESTest {//创建连接private Client client;/*** 通过TransportClient获取ES连接*/@Beforepublic void getClient() throws Exception {//ES服务的JavaAPI的port为9300//注意:如果请求一个ES集群,可以考虑多添加几个节点,//为了避免在一个节点出现网络问题导致的请求失败问题,可以自动切换另外一个节点client = TransportClient.builder().build().addTransportAddress(newInetSocketTransportAddress(InetAddress.getByName("localhost"), 9300)); } @Test/**1)使用json来创建文档(插入一条数据),自动创建索引和映射*/public void creatDocument() {//jason格式的数据创建文档(插入一条数据),自动创建索引和映射String source = "{" +"\"id\":\"1\"," +"\"title\":\"woshishui\"," +"\"content\":\"wozaina\"" +"}";//创建文档:定义索引名称,文档类型,主键唯一标识id//execute().actionGet()==get() 代码马上执行IndexResponse indexResponse =client.prepareIndex("blog", "article", "1").setSource(source).get();//获取响应信息this.loadResponse(indexResponse);client.close(); }public void loadResponse(IndexResponse indexResponse){System.out.println("索引名称" + indexResponse.getIndex());System.out.println("文档类型" + indexResponse.getType());System.out.println("ID" + indexResponse.getId());System.out.println("版本" + indexResponse.getVersion());System.out.println("是否创建成功" + indexResponse.isCreated()); }/**2)使用mao创建文档.自动创建索引和映射*/public void creatDocument2(){//map类型的数据Map<String,Object> source = new HashMap<String, Object>(); source.put("id","2");source.put("title","我是谁");source.put("content","我在哪");//创建文档IndexResponse indexResponse =client.prepareIndex("blog","article","2").setSource(source).get();this.loadResponse(indexResponse);client.close(); }/**3)使用ES帮助类(执行类),创建文档*/@Testpublic void creatDocument3() throws Exception{XContentBuilder source = XContentFactory.jsonBuilder().startObject().field("id",3).field("title","whoami").field("content","whereami").endObject();System.out.println(source.toString());//创建文档IndexResponse indexResponse = client.prepareIndex("blog", "article",.setSource(source).get();this.loadResponse(indexResponse);client.close(); }}2.搜索文档数据1)单个索引2)多个索引a.更新数据方式一:方式二:方式三b.删除数据c.查询queryStringQuery:es默认的分词器并没有中文进行分词,需要我们按照一个比默认屌很多的分词器(Ik分词器) d.创建映射。