算法合集之《人工智能在围棋程序中的应用》

ai围棋的算法原理

ai围棋的算法原理AI围棋的算法原理引言:AI围棋是通过人工智能技术实现的一种计算机对弈游戏。

它的核心是基于深度学习和强化学习的算法原理。

本文将详细介绍AI围棋的算法原理及其应用。

一、深度学习在AI围棋中的应用深度学习是AI围棋算法的基石,它通过构建深度神经网络模型来实现对围棋棋盘局势的理解和预测。

具体而言,深度学习通过多层神经网络的训练和优化,将围棋棋盘的状态作为输入,并输出每个位置的落子概率和胜率预测。

1. 输入层:深度学习模型的输入层是围棋棋盘的状态表示。

通常采用的表示方法是将棋盘上的每个位置作为一个通道,通道中的值表示该位置上的棋子颜色和类型。

2. 中间层:深度学习模型的中间层是一系列的卷积层和全连接层。

卷积层用于提取局部特征,全连接层用于整合全局信息。

3. 输出层:深度学习模型的输出层是对每个位置的落子概率和胜率预测。

落子概率表示在当前局势下,该位置是最佳落子位置的可能性;胜率预测表示在当前局势下,当前一方获胜的可能性。

二、强化学习在AI围棋中的应用强化学习是AI围棋算法的另一个重要组成部分,它通过与自我对弈的方式进行训练,不断优化深度学习模型,提升AI围棋的水平。

具体而言,强化学习通过建立一个价值网络和一个策略网络,分别用于评估每个动作的价值和选择最佳动作。

1. 价值网络:价值网络用于评估每个动作的价值,即在当前局势下,执行该动作的预期收益。

通过与自我对弈的方式,不断更新价值网络,使其能够准确评估每个动作的价值。

2. 策略网络:策略网络用于选择最佳动作,即在当前局势下,选择能够最大化胜率的动作。

通过与自我对弈的方式,不断优化策略网络,使其能够选择更加合理的动作。

三、AI围棋的训练过程AI围棋的训练过程主要包括以下几个步骤:1. 数据采集:通过与人类棋手对弈或使用已有的棋谱数据,采集大量的围棋棋局数据,用于训练深度学习模型和强化学习模型。

2. 深度学习训练:使用采集到的围棋棋局数据,训练深度学习模型。

人工智能算法在智能棋类博弈中的应用实践

人工智能算法在智能棋类博弈中的应用实践在智能棋类博弈中,人工智能算法的应用实践正逐渐成为一种趋势。

通过对棋类游戏的研究和分析,以及对人工智能算法的不断优化和发展,人们已经取得了一些令人瞩目的成果。

人工智能算法在智能棋类博弈中的应用实践不仅提供了更高水平的对手,还为棋类游戏的研究带来了新的思路和方法。

一,人工智能算法在智能棋类博弈中的应用在智能棋类博弈中,人工智能算法主要应用于以下几个方面:1. 棋局评估和预测:人工智能算法可以通过学习和训练来评估当前棋局的优劣,并预测下一步的最佳行动。

这些算法可以根据已知的棋局和对手的走法,推断一系列可能的对手行动,并进行权衡和判断。

2. 优化启发式搜索:人工智能算法可以通过搜索算法来找到最佳的下棋策略。

这些算法通过对可能的行动进行搜索和评估,从而找到最大化收益的行动序列。

与传统的搜索算法相比,人工智能算法具有更高的效率和准确性。

3. 强化学习:人工智能算法可以通过与人类玩家进行对弈来不断学习和改进自己的棋艺。

通过分析对手的走法和行为模式,人工智能算法可以找到对手的弱点并加以利用。

通过不断的训练和调整,人工智能算法能够逐渐提高自己的水平。

二,人工智能算法在智能棋类博弈中的应用实践案例1. AlphaGoAlphaGo是由Google DeepMind开发的一款人工智能算法,在围棋领域取得了令人瞩目的成就。

AlphaGo通过深度学习和强化学习的方法,成功击败了多位世界级围棋大师。

它能够通过搜索和评估当前棋局来找到最佳的下棋策略,并能够预测对手的行动。

AlphaGo的出现引起了广泛的关注,并为智能棋类博弈的研究带来了新的思路和方法。

2. StockfishStockfish是一款强大的国际象棋引擎,它基于传统的启发式搜索算法,通过优化和改进,成为了当前最强的电脑国际象棋引擎之一。

Stockfish能够通过搜索和评估当前棋局来找到最佳的下棋策略,它具有高效、准确的特点,能够提供高水平的对手。

基于深度强化学习的围棋人工智能算法优化

基于深度强化学习的围棋人工智能算法优化深度强化学习是一种在人工智能领域中被广泛研究和应用的算法,它能够让机器自主学习并通过与环境的交互来提高自己的性能。

围棋作为一种复杂的棋类游戏,一直以来都是人工智能领域的一个挑战。

本文将探讨如何基于深度强化学习来优化围棋人工智能算法。

围棋的复杂性表现在其庞大的状态空间和棋局的长远影响。

传统的围棋人工智能算法采用的是基于规则的方法,通过定义一些启发式规则来指导下棋。

然而,这些规则往往局限于人类经验和知识,无法覆盖所有的可能性。

因此,基于深度强化学习的围棋人工智能算法应运而生。

深度强化学习算法的核心是强化学习框架。

在围棋中,它的主要思想是通过自主学习和与环境的交互来优化策略。

首先,算法会通过随机下棋来生成大量的棋局数据作为训练集。

然后,在每一步棋之后,算法会根据当前的状态和选择的动作来获得一个奖励信号,用于评估该动作的好坏程度。

这个过程会不断地重复,直至算法能够通过学习来找到最佳的下棋策略。

在深度强化学习中,神经网络被广泛应用于估值网络的建模。

估值网络可以评估当前棋盘的优劣,为下一步的决策提供指导。

为了提高估值网络的性能,可以采用一些深度学习中的技术,例如卷积神经网络 (CNN)。

通过 CNN 的卷积层,算法可以提取出棋盘的局部特征,从而更好地理解当前局势。

此外,残差网络(ResNet) 可以用于防止深度网络的退化问题,使网络训练得到更好的效果。

除了估值网络,深度强化学习还使用了策略网络来生成下棋的决策。

策略网络通过学习大量棋局数据来预测在给定状态下的最佳下棋动作。

为了增强策略网络的能力,可以采用蒙特卡洛树搜索算法 (Monte Carlo Tree Search, MCTS) 来引导策略网络的训练。

MCTS 可以通过对棋局状态进行搜索与模拟,来评估出最优的下棋路径。

为了进一步优化围棋人工智能算法的性能,还可以采用强化学习中的一些技术。

例如,可以引入经验回放 (Experience Replay) 技术,将棋局数据进行存储和复用,以增加算法学习的样本数量。

人工智能在围棋运动中的应用及其技术分析

人工智能在围棋运动中的应用及其技术分析围棋是全世界最古老、最深奥的智力运动之一,也是人工智能(AI)领域的重要研究方向之一。

国际上著名的人工智能围棋项目AlphaGo已经证明了人工智能在围棋运动中的巨大潜力。

本文将深入探讨人工智能在围棋运动中的应用及其技术分析。

一、人工智能在围棋运动中的应用近年来,人工智能在围棋运动中的应用越来越广泛。

目前,最为著名的围棋人工智能项目无疑是AlphaGo,这是由谷歌旗下DeepMind公司研发的一款围棋人工智能程序。

AlphaGo在2016年击败了世界顶级围棋选手李世石,震惊了整个围棋世界。

其背后的技术之一是深度学习。

AlphaGo使用了多层卷积神经网络(CNN)来学习棋谱,之后将其与深度强化学习相结合,从而提高了其决策水平。

人工智能在围棋运动中的应用不仅仅局限于AlphaGo这一项目。

其他公司和机构也在研究如何使用人工智能来提高围棋选手的水平。

例如,中国的华为公司就研发了一款名为“Mist”—全称“Mind-Sports-Tournament&Training-System”的人工智能训练系统,可以帮助围棋选手进行训练,提高其决策水平。

二、人工智能在围棋运动中的技术分析人工智能在围棋运动中的应用,基于其背后的技术,存在几个主要的技术分析点。

1. 深度学习深度学习是人工智能中的一种基于神经网络的机器学习技术。

在围棋运动中,深度学习被广泛应用于学习棋局,从而提高机器的决策水平。

深度学习的原理是通过反向传播算法,从大量数据中学习特征,并对新数据进行决策和预测。

在围棋运动中,机器可以学习以往的棋局,从中发现规律并建模,以便后续的决策预测。

2. 卷积神经网络卷积神经网络(CNN)是一种广泛用于图像识别和计算机视觉领域的神经网络模型。

在围棋运动中,CNN可以用于学习棋子的位置以及棋盘状态的相关信息。

CNN可以对图像进行卷积操作,提取特征信息,并在之后的层次中进行处理和分类。

人工智能技术应用于围棋的研究

人工智能技术应用于围棋的研究随着科技的发展,人工智能(AI)技术的应用变得越来越广泛,其中最引人注目的是在围棋领域的应用。

这个古老的游戏经历了很多年的发展,从古代的智慧之选到现代的科技竞技,而AI技术的运用更是让围棋界焕发出全新的活力和未来的可能性。

下面将从历史、技术、竞争等角度来探讨人工智能技术在围棋领域的应用。

历史围棋作为东方文化的代表之一,历史悠久,已经有几千年的历史了。

在围棋的发展过程中,从古代初期的兵法智慧,到现代的围棋技术,人们一直在寻求更高级别的对抗,这也是人工智能技术应用于围棋的原始动机。

在 1950 年代,美国的数学家克劳德 ·香农首次提出使用计算机来下围棋的想法,但是那时计算机技术还十分不成熟,实现难度极大,且数据存储和处理能力也相对较低,因此并没有得到广泛的应用。

到了 21 世纪,随着计算机技术的飞跃进步,人工智能技术的发展进入了一个全新的时代。

特别是 AlphaGo 在 2016 年击败围棋世界冠军李世石后,AI技术开始逐渐被围棋界所接受和认可。

技术围棋作为一种极其复杂的智力游戏,传统的计算机算法无法准确表达其众多的棋局,因此,围棋AI要解决的首要问题就是如何让计算机能够更好地进行预测和决策。

早期的围棋AI系统往往是通过人工设计和规划进行的,计算机需要对所有可能的棋局进行推演和判断,并根据所得的信息做出最佳决策。

但是这种方法存在两个显著的问题:一是只要面对棋盘上的不同棋子排列组合,棋局复杂度就会呈几何倍数增长,计算机处理不过来;二是围棋中存在许多不规则形状的空缺棋子区域,导致困难。

因此,人们开始尝试深度学习等新的人工智能算法,使计算机能够对“过去的经验”进行学习,以更好地学会如何判断棋局、选路走子等等。

AlphaGo 是目前最成功的人工智能计算机程序之一。

它的设计灵感来自于已有的可行技术,比如 Monte Carlo Tree Search、强化学习和深度卷积网络等。

AlphaGo算法在围棋智能博弈中的应用

AlphaGo算法在围棋智能博弈中的应用围棋是一种古老而复杂的游戏,它的战略和智慧一直以来都吸引着人们的关注。

然而,围棋的复杂性也使得它成为人工智能领域的一个巨大挑战。

过去,人们一直认为围棋是一个人类智慧无法超越的领域,直到AlphaGo的出现。

AlphaGo是由谷歌旗下的DeepMind公司开发的一个围棋人工智能程序。

它在2016年与世界冠军棋手李世石进行五局三胜的对局时,赢得了这场史无前例的人机大战。

这一事件引起了全球的轰动,并被认为是人工智能领域的一个里程碑。

AlphaGo的成功离不开其独特的算法。

它采用了深度学习和强化学习的技术。

深度学习是一种模拟人类大脑神经网络的方法,通过训练模型来理解和推理复杂的问题。

强化学习则是通过试错和反馈来优化模型的方法。

AlphaGo利用这些技术,在大量的围棋数据中学习并提高自己的水平。

在围棋智能博弈中,AlphaGo的应用已经取得了显著的成果。

首先,它在战略层面上展现出了超人类的水平。

通过分析过往的大量棋局和棋谱,AlphaGo能够形成自己独特的理解和思考方式。

它能够预测可能的对手动作,并做出针对性的应对。

这种超强的战略能力对于围棋的发展具有重要的推动作用。

此外,AlphaGo还在局部层面上展现出了惊人的直觉能力。

围棋的每一步都可能导致不同的结果,而AlphaGo能够准确地预测这些结果和可能性。

这种直觉能力使得它能够制定最合理的棋局,并展现出与人类不同的战术思维方式。

值得一提的是,AlphaGo不仅仅是一个学习者,它还是一个创新者。

它创造了一种全新的围棋下法,被称为“AlphaGo风格”。

AlphaGo风格与传统的人类下法有所不同,它更加注重对丢分的限制,强调整体棋局的平衡。

这种创新的围棋下法为整个围棋界带来了新的思路和启发,推动了围棋的发展。

然而,AlphaGo的应用也并非没有争议。

一些人担心,AlphaGo的出现会威胁到人类围棋的发展和普及。

他们认为,人类面对的是人机合作的对局,无法与AlphaGo进行真正的对抗。

人工智能方法在围棋方面的应用详解

人工智能方法在围棋方面的应用详解人工智能(AI)方法在围棋方面的应用已经取得了令人瞩目的进展。

在过去的几年中,AI系统已经成功地击败了多名世界级围棋冠军,这一成就标志着人工智能技术在复杂决策和模式识别方面的突破。

本文将详细介绍人工智能方法在围棋中的应用,并从AlphaGo的发展历程、困难和挑战以及未来的可能性等方面进行探讨。

一、AlphaGo的发展历程AlphaGo是Google DeepMind开发的一个AI系统,它在2016年击败了围棋大师李世石,这标志着AI在围棋领域的重要突破。

AlphaGo的设计灵感来源于深度强化学习和蒙特卡洛树搜索等技术。

深度强化学习是一种结合了深度学习和强化学习的方法,能够从大量的游戏数据中学习并优化其表现。

蒙特卡洛树搜索则是一种根据模拟对局结果进行迭代优化的搜索算法,能够提供更加准确和可靠的决策。

AlphaGo的训练过程涉及两个主要的阶段:自我对弈和监督学习。

在自我对弈阶段,AlphaGo通过与自己进行大量对弈来寻找最佳决策策略,并使用强化学习算法进行迭代优化。

在监督学习阶段,AlphaGo使用专家人类围棋棋谱进行训练,以引导其学习优秀的游戏策略。

最后,AlphaGo经过了大量的训练和优化后,能够在围棋对局中做出与人类棋手相媲美的决策。

二、困难和挑战尽管AlphaGo在围棋领域取得了重大突破,但在实际应用过程中仍然面临一些困难和挑战。

首先,围棋是一种复杂的决策游戏,其状态空间非常庞大。

对于围棋的每一步决策,都有多种可能的选择,因此需要巨大的计算量和存储空间来进行搜索和优化。

在现实世界中应用AI系统时,需要通过算法优化和硬件升级等手段来提高计算速度和效率。

其次,围棋的决策与很多因素相关,包括棋局布局、棋子型态、对手策略等。

如何从这些因素中提取有效的特征,并将其纳入到决策模型中,是一个相当复杂的问题。

目前,AI系统往往通过深度学习和强化学习的方法进行特征提取和模型训练,但仍然存在一些局限性和不足之处。

人工智能AlphaGo战胜李世石,解密GoogleDeepmindAlphaGo围棋算法

人工智能AlphaGo战胜李世石,解密GoogleDeepmindAlphaGo围棋算法“人类的发展过程,一直在制造比自己在某方面更厉害的工具,从而让自己能从这些方面解放出来、可以关注其他更麻烦的方面去。

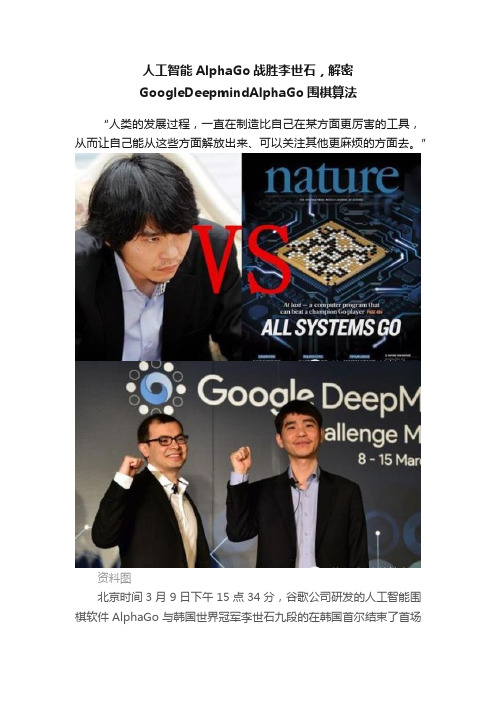

”资料图北京时间3月9日下午15点34分,谷歌公司研发的人工智能围棋软件AlphaGo与韩国世界冠军李世石九段的在韩国首尔结束了首场比赛,AlphaGo获胜,李世石投子认输。

是什么使围棋算法产生了质的飞跃?要知道,在之前最好的围棋程序也只能达到业余人类棋手的水平。

是真的人工智能产生了吗?对于大多数人来说,大家都知道1997年的“深蓝”计算机战胜了人类的国际象棋冠军卡斯帕罗夫,但是大家都不会认为“深蓝”真正拥有了人工智能,道理非常简单:国际象棋(当然围棋也是)每一步都是可见的,在一个确定性的棋局下,仅有有限个走法。

这有限个走法中必然有一个最优的。

一个基本的想法就是对棋局进行预测,遍历每一种走法直到一方胜出,然后回退计算每一个可能赢的概率,最后使用概率最高的作为最优的走法。

“深蓝”就做了这么件事,暴力穷举所有的步子,然后找最优!赢了人类,但没有智能,因为整个算法完全就是人工设计的一个算法,根本看不到智能在哪里。

显然围棋理论上也可以暴力破解,但是问题就在于围棋的可走的步子太多了,以至于目前的计算性能根本做不到暴力破解。

这也就是为什么围棋是挡在人工智能面前的一个重大挑战。

要使围棋程序战胜人类顶尖高手,只有依靠真正的人工智能!对围棋有了解的朋友都知道下围棋需要对整个棋局有直观的理解,这就是围棋困难的地方。

除非计算机真正理解了棋局,才有可能有大局观,才有可能下出真正的好棋!那么,问题来了:AlphaGo 有真正的人工智能吗?我的回答:AlphaGo有真人工智能,虽然还不完美!那么AlphaGo的真人工智能在哪里?我的回答:就在深度神经网络之中一切的答案都在Google Deepmind在Nature上发表的文章:Mastering the Game of Go with Deep Neural Networks and Tree Search论文链接本文将分析AlphaGo的这篇Nature文章,去解密真人工智能的奥秘!AlphaGo的”大脑“是怎样的深度神经网络是AlphaGo的”大脑“,我们先把它当做一个黑匣子,有输入端,也有输出端,中间具体怎么处理先不考虑。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

人工智能在围棋程序中的应用复旦大学附属中学施遥【关键字】围棋,搜索,模式匹配,博弈树【摘要】围棋程序的编制被称作人工智能的“试金石”,是人工智能技术的一大难题。

本文介绍了人工智能在围棋程序中的应用与发展,对比了围棋与国际象棋博弈算法的差别和复杂度,从而分析围棋算法的难点,讨论各种博弈算法(气位理论、模式匹配与博弈树)在围棋程序中的融合运用。

并给出了围棋死活程序的算法实例(附程序),以供参考【正文】『目录』一、概述二、围棋的复杂性三、博弈(棋类)算法及其在象棋与围棋中的对比四、围棋算法五、围棋棋形识别六、围棋死活的算法与实现七、展望一、概述1、围棋简介围棋相传为尧所创,纵横一十九道,天元是为太极,太极生两仪,为黑白子;两仪生四象,为四个角。

《弈旨》([汉]班固)云:“棋有白黑,阴阳分也,骈罗列布,效天文也。

”可知围棋本是仿效天文而制,逐渐演变为博弈游戏。

2、计算机与围棋计算机运用于棋类方面几乎与计算机的诞生的历史一样长。

这方面内容主要属于人工智能技术。

人工智能作为一门科学首先是在五十年代提出的,随即便运用于棋类。

由于技术的进步,计算机速度的提高、算法的不断发展,目前电脑国际象棋的水平已极高,然而围棋水平却徘徊不前。

就围棋而言,人弈棋凭的是经验,即“棋感”。

人类的优势是模糊判断、灵敏的直觉,高手往往会有灵机一动而弈出妙手。

当然事物有其两面性,即人的情感、直觉有时也会误导自己形成错误,而棋手的心态也是至关重要的一环,“成也萧何,败也萧何”,直觉既是人类的法宝,亦是败因(当然是指败给人了)。

计算机的优势是计算速度快,劣势是不擅模糊判断、不能根据经验选点导致搜索量过大。

计算机不为情绪所困,不为直觉所惑,故地域广狭、大小之分能较为准确,其耗时亦少,然而计算机毕竟没有棋感,不知道哪步好、哪步不好,只有一点点地去试,要么费时甚巨(也未必有用),要么草草了事,结果也可想而知。

二、围棋的复杂性围棋全局与其死活问题其复杂性都大致可归纳为如下三点:1、模糊性“围棋”之名自是取自围地之意,倘若是双方落子一开始便是紧紧相贴的,那么可想而之行棋的速度(即占领地盘的速度)是极慢的,故而布局、中盘以至大官子阶段,双方只是围出一个大概的轮廓,甚而连轮廓都不明显。

黑白势力难分,形状犬牙差互。

这对于计算机处理形成了极大的困难。

2、反复性象棋中棋子一旦被吃,则永远从棋盘上提去,而在围棋棋盘上,被吃的地方仍可重新落子,甚而将对方反吃回来,如此一来,搜索的难度便大大增加。

如“倒脱靴”之形,送子后再吃子,一块空可以几易其主。

所以“死子”不死,“活子”有时倒是堪虞。

所以在计算机处理中不可以简单确定一块棋子的死活和对周围的影响。

3、灵活性象棋的灵活,至多体现在兑子上,所谓“宁弃一子,不失一先”,也仅是一子而已,若是两子、三子呢?恐怕在双方实力相当的情况下必败无疑。

而且在象棋算法中多有将各种棋子折合为一定的价值相加的做法,如,在国际象棋中以一个兵为单位,一个马约可等于三个半兵,一个车约可等于五个半兵,等等,最多再根据棋子所处位置加以一定的折算。

而围棋的灵活远胜于此,有时弃去十来个子以取势,弃去二、三十目的角地以转换。

再者,围棋棋子的价值是难以估量的,其价值不完全在其本身,而常于在周围的配置,有些影响甚而可斜跨整个棋盘。

三、博弈(棋类)算法及其在象棋与围棋中的对比一九九七年,IBM的电脑“深蓝”一举战胜卡斯帕罗夫,震惊世界。

其实电脑国际象棋的水平早在七、八十年代已挤身世界高手之林,而中国象棋软件也已几乎具有大师水准,非一般爱好者能望其项背。

唯独围棋举步维艰,连业余下手都胜券难握,更莫论一等一的高手,究其原因不外是围棋之博大精深、纵横变换繁复,棋手多靠经验而计算机则无此功能。

目前,棋类博弈算法主要有两大类:模式匹配和使用博弈树。

这在国际象棋中的运用可以追溯到五、六十年代,且而十分成功。

围棋和象棋一样是博弈游戏,看似仅有黑白两种棋子,简单不过。

实则比起兵种繁多的象棋却复杂得多。

电脑围棋起源于六十年代。

两位博士Zobrist和Ryder在论文中均涉及了围棋程序,前者的算法基于模式识别;而后者的算法基于搜索,即使用博弈树。

这两种在国际象棋中效果不错的算法在围棋中的表现却极差,竟然连仅有几盘棋经验的人都赢不了。

我们不妨来考虑一下上述两种算法。

首先,我们来看模式匹配。

象棋中因为棋子个数少、种类多,那么就较易分别与归纳(实际上也是困难的,但比围棋容易实现得多)。

而在围棋中,显然将所有的模式都存储起来是不可能的。

那么只有模糊匹配。

但这似乎也很难办。

围棋中有“愚形”这个名词,一般指的是效率差的形状。

那么怎样是效率差呢?就是浪费子力,在不必要的地方落子,哪怕只是一个子。

而模糊的匹配在一子之差时究竟如何判断?是好形还是愚形?这就陷入了矛盾的境地。

况且,根据实际情况,还有“愚形之妙手”(出自日本古局),实难判断。

其次是搜索的算法。

搜索的代价是极大的,据估计,国际象棋搜索7个回合约有500亿至600亿种选择(当然是在博弈树剪枝后),这个数字尽管也十分庞大,但以目前的技术水平还是可以承受的;然而在围棋中,我们稍微计算一下便知道:假设每步大约有只有一百个可行点(已经非常少了),那么14步(即7个回合)以内的变化则约有1028种,当然这只是保守的估计,已足以骇人了。

可见在全局使用搜索算法是不可行的。

因此当前的做法一般是在局部明确目标(如做活、杀棋、突围、切断等)的情况下,才使用博弈树进行搜索。

四、围棋算法目前,世界上流行的围棋软件主要是由以下三种算法组成的:1、使每个棋子周围产生某种影响,这种影响随着距离的增加而减少,用一定的公式计算叠加这种影响,以判断形势和估计着点的价值。

这与围棋的棋理相通,即对于每个棋子可估算其“势力”。

此中就有著名的“气位”理论。

2、建立模式库,贮存了大量模式(定式、棋形等),以供匹配。

这其实涉及到围棋的许多棋谚与棋理。

如“二子头必扳”、“镇以飞应”、“断从一边长”、三子正中、点方等等。

这些都是根据围棋的具体情况而设计的。

3、对目标明确的局部,用人工智能中的搜索法探求其结果。

一般来说,现在还没有找到突破性的算法,只有在以上三种算法中细细加工。

五、围棋棋形识别围棋中棋力的高下大凡凭一个棋手的感觉与经验,而这感觉正是棋手水平的主要体现。

而对棋的感觉其实就是人对于棋本身(即棋形)的主观认识。

这是一个识别过程。

识别能力的高低是智能的一大特征。

识别能力由低到高分为三个层次,仪器水平:物理识别;动物水平:模糊识别;人类水平:情感识别。

物理识别是对接受到的信息实现物理、化学和生物学的量化认识。

这不需要经验与智能,所以是最低层次的识别。

模糊识别是在大量复杂的信息中识别出有用的部分,即对接收的信息与以往的记忆和经验进行关联认识,剔除无关的信息。

情感识别是最高级的识别。

它是完全的感性识别。

可以说围棋中既有模糊识别,亦有情感识别。

即对于一个新棋形,将之与经验中的棋形比较,综合周边情况,作出判断。

其决策带有明显的个人情感倾向,这与每个人的理解有关,很多是没有定论的,因此即便九段高手之间的棋也是截然不同的,很难说孰优孰劣。

而在计算机中,对于棋形却难以模糊判断,因为这既不是声音,也不是图象,一子之差,优劣迥异。

一般来说,目前计算机对于围棋棋形只能作简单的识别,用以减少搜索,其实这也就是赋予了计算机一定的“经验”。

六、围棋死活的算法与实现死活是围棋中的一个典型问题,可以说也是围棋算法的一个缩影。

它需要融合上述的三种算法。

目前,死活软件已达到较高的水平,但主要因为这只是一个局部问题,与全局千丝万缕的关系却是极难把握。

注:为了叙述简便起见,下文中黑方总为攻击方,白方总为欲做活的一方,在本节中仅以白方为例来设计算法。

本节中的各算法均已简化,目的只是说明方法。

由于时间关系和水平所限,本节算法不免有所疏漏,望不吝指正。

对于围棋死活问题,首先我们不妨看看人下棋的思路:先看有多少眼位,是否已活?如不活,计算缺多少眼位,能否补上?在做眼(或破眼)的过程中,人总是先以第一感为线索来计算,那么人的第一感是从何而来呢?其实就是长期对棋型认识的经验,经验丰富者强、经验欠缺者弱。

因为在死活中有许多常见的棋型,前人也曾总结过一些棋谚,如“杀棋用扳”、“二一多妙手”等,还有如夹、点、跨等手段经常构成杀棋;而有些着点却无需考虑。

因为死活是一个局部目标明确的问题,故而以搜索为主。

因此一个围棋死活软件的优劣关键在于对于搜索的优化、剪枝上。

我对于围棋死活问题的算法有两大部分组成:静态眼位判断搜索程序的主线是搜索,然而静态眼位判断穿插于其间。

1、静态眼位判断①势力划分前面提到了,围棋黑白双方的界限是模糊的,很难精确划分,而不能精确划分的话,则在计算机中难以处理。

为此,采用气位理论的的方法来近似计算“势力”。

势力划分贯穿于整个静态眼位判断,作用很大。

一个棋子对于周围有一定的影响,称之为“势力”,一个子的周围称为气位。

气位如下划分:1、相邻位为1级气位;2、尖位为1.5级气位,扳位为2级气位(即右图中“1.5”处若是扳位,则须改为“2”);3、关位为2级气位;4、小飞位为2.5级气位。

各级别气位所受影响如下表:气位级别1级1.5级2级2.5级影响的绝对值6532黑棋的影响为正值,白棋为负值。

当然,以上的各位置与原来位置之间不可有棋子隔断,否则(无论黑白)势力即为其所阻隔。

另外要补充的是,每一点所受某种颜色棋子的影响只受离其最近(影响最大)的该色棋子的影响。

如此一来,半敞开的区域便可为势力所封闭,一此处于重重包围的棋子由于周围对方势力太盛,自己的势力值反而为对方所颠倒,自然成为死子(但不是绝对的,如“倒脱靴”便是死棋再生的例子)。

本文讲的只是一个基本方法,在真正操作时可以根据不同情况有一定的变化,对于优秀的围棋软件来说,影响力也未必是线性叠加的。

②白方(做活方)眼位的确定首先,我们知道每块棋子至少要两个真眼才能做活。

真眼与假眼的区别如右图:在角上A点为己方占领为真眼,反之为假眼;在边上AB两点要俱为己方占领方为真眼;在中央ABCD中己方须至少占领三点才能成其为真眼,反之为假眼,当然倘是己方已占领了其中两点,而另两点无子,亦是真眼,因为这两点见合(即两点必得其一)。

现在我们来考虑何为“占领”?“占领”的含意对于黑白双方是不同的。

对于白方:占领未必在该点要有白子,只需在该点的白方势力极强即可,因为如此黑方即使在此落子也必为白方所吃,最终仍为白方占据。

对于黑方:占领即在该点是黑子,没有黑子的地方即使势力再强,一旦白方落子于该处,黑方也无可奈何。

第二我们要明确,眼位未必非真即假,非假即真。

如下图:图中白方在A位先行补一手可成真眼,反之黑方先行即成假眼。

我们不妨称之为半只眼。

⑴一目眼位的判断一目眼位判断较为简单,只需如上所述计算即可,分三种类型:真眼、假眼(可不计)、白方先手真眼。