常用的网络爬虫软件

数据收集整理的工具与软件:实用教案推荐

数据收集整理的工具与软件:实用教案推荐数据在现代社会的重要性不言而喻,特别是在企业、科研、政府等领域,数据的采集与整理显得尤为重要。

为了提高数据的质量与效率,到目前为止,已经有很多先进的数据收集整理的工具与软件出现。

本文将为大家介绍一些实用的工具与软件,希望对大家在数据收集整理方面有所帮助。

一、数据收集工具数据的收集可能是数据处理工作中最麻烦的一环,因为不同类型的数据来源不一样,需要使用不同的工具来进行查询。

1.问卷星问卷星是可用于在线调查和数据收集的网站,它可以帮助用户制作各种类型的问卷,如客户满意度调查、市场调研、员工满意度调查等。

问卷星不但能够帮助用户快速地发出问卷,还可以随时查看调查结果并进行数据分析,非常方便。

2.爬虫软件爬虫软件可以自动抓取网络上的数据,比如某宝的商品信息、新浪微博的用户信息等,这些数据通常需要手动抓取,费时费力。

爬虫软件则可以自动执行这些任务,轻松地获取海量的数据。

常见的爬虫软件有Python的Scrapy、Java的WebHarvest等。

3.大数据分析软件大数据分析软件像Tableau、QlikView、Power BI等,可以以多种方式为你提供关于数据的见解。

它们让你能够更好地分析数据、获取洞见,并快速识别趋势。

此外,它们还可以帮助你更好地把数据可视化,这将有助于你深入了解数据所代表的实际情况。

二、数据整理工具1.ExcelExcel是非常基本且常用的数据整理工具,其灵活性与可定制性让它成为数据分析工作的不二选择。

Excel可以帮助用户将数据进行分类、过滤、排序等操作,还可以执行各种计算和图表制作,十分方便。

2.Open RefineOpen Refine可以帮助用户处理数据质量问题,支持批量清洗、转换数据格式、删除重复数据,还可以通过交互方式快速将数据可视化。

此外,Open Refine还支持扩展功能,是一个非常有用的数据整理工具。

3.SASSAS是一个完整的数据分析工具,在数据收集与整理工作中有广泛的应用。

urlfinder使用方法

urlfinder使用方法【最新版3篇】目录(篇1)1.urlfinder 简介2.urlfinder 使用方法2.1 查询网址2.2 提取链接2.3 查询网站信息2.4 查询关键词排名正文(篇1)【urlfinder 简介】Urlfinder 是一款功能强大的网址查询工具,可以帮助用户快速查询各种网站信息,如网站权重、关键词排名等。

使用 Urlfinder 可以提高用户的工作效率,让用户更方便地了解和分析网站。

【urlfinder 使用方法】Urlfinder 的使用方法非常简单,主要包括以下几个步骤:1.查询网址用户可以直接在 Urlfinder 的搜索框中输入网址,然后点击“查询”按钮,系统就会自动获取该网址的相关信息,包括网站权重、关键词排名等。

2.提取链接如果用户需要提取某个网页中的所有链接,可以使用 Urlfinder 的“提取链接”功能。

只需将需要提取链接的网页网址输入到 Urlfinder 中,系统就会自动提取出该网页的所有链接。

3.查询网站信息Urlfinder 可以查询网站的各种信息,包括网站权重、域名年龄、服务器地址等。

用户只需输入网址,就能获取到该网站的详细信息。

4.查询关键词排名Urlfinder 还可以查询关键词在搜索引擎中的排名。

用户只需输入关键词和网址,系统就会显示出该关键词在搜索引擎中的排名情况。

目录(篇2)1.urlfinder 简介2.urlfinder 使用方法3.使用 urlfinder 的优点4.使用 urlfinder 的注意事项正文(篇2)一、urlfinder 简介Urlfinder 是一款功能强大的网络爬虫工具,它可以帮助用户在互联网上找到和抓取所需的数据。

Urlfinder 具有简单易用的界面,用户无需具备编程基础,只需输入目标网址,即可获取到网页中的数据。

它广泛应用于数据分析、网站数据抓取、网络数据采集等领域。

二、urlfinder 使用方法1.打开 Urlfinder 官方网站,点击“开始使用”按钮,进入使用界面。

网络爬虫软件哪个好用

网络爬虫软件哪个好用现在市面上的网络爬虫软件有很多,这些软件中哪个采集软件比较好呢?下面笔者简单分析一下网络爬虫软件哪个好用以及原因供大家选择。

采集软件有哪些?1、八爪鱼一款可视化免编程的网页采集软件,可以从不同网站中快速提取规范化数据,帮助用户实现数据的自动化采集、编辑以及规范化,降低工作成本。

云采集是它的一大特色,相比其他采集软件,云采集能够做到更加精准、高效和大规模。

可视化操作,无需编写代码,制作规则采集,适用于零编程基础的用户即将发布的7.0版本智能化,内置智能算法和既定采集规则,用户设置相应参数就能实现网站、APP的自动采集。

云采集是其主要功能,支持关机采集,并实现自动定时采集支持多IP动态分配与验证码破解,避免IP封锁采集数据表格化,支持多种导出方式和导入网站Conclusion:八爪鱼是一款适合小白用户尝试的采集软件,云功能强大,当然爬虫老手也能开拓它的高级功能。

2、火车头作为采集界的老前辈,火车头是一款互联网数据抓取、处理、分析,挖掘软件,可以抓取网页上散乱分布的数据信息,并通过一系列的分析处理,准确挖掘出所需数据。

它的用户定位主要是拥有一定代码基础的人群,适合编程老手。

采集功能完善,不限网页与内容,任意文件格式都可下载具有智能多识别系统以及可选的验证方式保护安全支持PHP和C#插件扩展,方便修改处理数据具有同义,近义词替换、参数替换,伪原创必备技能采集难度大,对没有编程基础的用户来说存在困难Conclusion:火车头适用于编程能手,规则编写比较复杂,软件的定位比较专业而且精准化。

3、集搜客一款简单易用的网页信息抓取软件,能够抓取网页文字、图表、超链接等多种网页元素。

同样可通过简单可视化流程进行采集,服务于任何对数据有采集需求的人群。

可视化流程操作,与八爪鱼不同,集搜客的流程重在定义所抓取的数据和爬虫路线,八爪鱼的规则流程十分明确,由用户决定软件的每一步操作。

支持抓取在指数图表上悬浮显示的数据,还可以抓取手机网站上的数据。

集搜客使用方法

【最新版3篇】编制人员:_______________审核人员:_______________审批人员:_______________编制单位:_______________编制时间:_______________序言Download Note: This document is original and carefully arranged by our store. After downloading, you can adjust and use it according to your actual needs. We hope that this can help you, thank you!(3篇)《集搜客使用方法》篇1集搜客是一款网络爬虫工具,用于精确采集网络上的数据信息。

以下是集搜客的使用方法:1. 下载和安装集搜客软件在集搜客官网上下载并安装集搜客软件,然后打开集搜客软件。

2. 新建任务在集搜客软件中,新建一个任务,填写任务名称、选择采集的网站、设置采集规则、指定存储位置等。

3. 定义采集规则采集规则是指定义要采集的数据内容和采集方式,包括元素定位、数据提取、数据存储等。

定义采集规则需要一点时间,需要按照入门顺序看教程,可以直接跳到一些案例学习。

4. 启动任务在集搜客软件中,启动新建的任务,集搜客会自动开始采集数据。

5. 查看采集结果在集搜客软件中,可以查看采集到的数据结果,检查数据是否准确、完整。

6. 导出数据在集搜客软件中,可以将采集到的数据导出为 Excel、CSV 等格式,方便进行数据分析和处理。

集搜客是一款专业的网络爬虫工具,使用起来需要一定的技术基础和经验。

《集搜客使用方法》篇2集搜客是一款网络爬虫工具,用于精确采集网络上的数据。

以下是使用集搜客的一些基本步骤:1. 下载和安装集搜客软件在集搜客官网上下载并安装集搜客软件,然后打开集搜客客户端。

2. 新建任务在集搜客客户端中,点击“新建任务”按钮,设置任务名称、URL、采集规则等参数。

网络爬虫软件操作指南

网络爬虫软件操作指南第一章:网络爬虫的基础概念及工作原理网络爬虫(Web Crawler)是一种自动化程序,用于自动抓取互联网上的信息。

它可以模拟浏览器的行为,访问网页并提取所需的数据。

网络爬虫的工作原理是通过发送HTTP请求获取网页源代码,然后解析源代码,从中提取所需的信息。

第二章:选择适合的网络爬虫软件目前市面上存在众多的网络爬虫软件可供选择。

根据不同的需求和技术能力,可以选择合适的软件进行使用。

常见的网络爬虫软件有:Scrapy、BeautifulSoup、Selenium等。

选择合适的网络爬虫软件需要考虑其功能、易用性和性能等方面的因素。

第三章:安装和配置网络爬虫软件在使用网络爬虫软件前,需要先进行安装和配置。

首先,下载网络爬虫软件的安装包,并根据软件的安装说明进行安装。

安装完成后,需要进行环境配置,包括设置代理、配置数据库等。

正确的配置可以提高网络爬虫的效率和稳定性。

第四章:编写网络爬虫代码网络爬虫代码可以根据需求自行编写,也可以使用已有的代码作为基础进行修改。

编写网络爬虫代码的时候,需要注意以下几点:选择合适的编程语言、了解目标网站的结构、设置合理的抓取间隔和并发数、处理异常情况等。

良好的编码习惯和规范可以提高代码的可读性和可维护性。

第五章:爬取网页数据爬取网页数据是网络爬虫的核心任务。

在开始爬取之前,需要明确要爬取的数据类型和所在的位置。

可以通过观察网页的源代码和利用浏览器开发者工具等方法找到待抓取的数据。

在爬取过程中,需要注意反爬措施,并采取相应的策略,如设置请求头、使用代理IP等。

第六章:数据处理和存储爬取到的数据需要进行进一步的处理和存储。

处理数据的方式包括数据清洗、数据去重、数据转换等。

可以使用Python提供的数据处理库,如Pandas、NumPy等进行数据的处理。

存储数据的方式有多种选择,如保存为文本文件、存储到数据库中、存储到云平台等。

第七章:定时任务和持续监控定时任务和持续监控是网络爬虫的重要组成部分。

数据采集平台软件介绍

数据采集平台软件介绍1. Webhose.io:Webhose.io 是一个提供全球范围内全面的互联网数据收集和分析解决方案的数据提供商。

它使用自动化的网络爬虫技术,从互联网上收集大量的结构化、半结构化和非结构化数据。

Webhose.io 的特点包括高质量的数据源、实时数据获取、自定义数据筛选和分析工具。

它的应用场景包括市场调研、竞争情报、舆情分析等。

2. Import.io:Import.io 是一款强大的 Web 数据提取工具。

它可以将网页上的信息提取为结构化的数据,并可将其导出到 Excel、CSV 或数据库等格式。

Import.io 可以通过简单的点击和拖放来配置网页数据提取任务,而无需编写代码。

它的应用场景包括数据抓取、价格监测、市场分析等。

3. ParseHub:ParseHub 是一款易于使用且功能强大的网络爬虫工具。

它可以从各种网站提取数据,并将其转换为结构化的格式。

ParseHub 的特点包括可视化的配置界面、高度定制的数据选择和转换、自动化和调度功能等。

它适用于市场研究、数据分析、内容聚合等领域。

4. Octoparse:Octoparse 是一款智能的网页数据提取工具,它可以从各种网站抓取数据,并将其转换为结构化的格式。

Octoparse 的特点包括强大的抓取能力、智能的数据识别和处理、可视化的任务配置界面等。

Octoparse 的应用场景包括电子商务竞争情报、新闻聚合、舆情监测等。

5. Scrapy:Scrapy 是一款开源的 Python 框架,用于构建和部署定制化的网络爬虫软件。

它具有高度的可定制性和灵活性,并支持多种数据导出格式。

Scrapy 提供了强大的网络爬取和数据处理功能,适用于各种科研、商业和工程领域。

6. PhantomJS:PhantomJS 是一个基于 WebKit 的"无头"浏览器,它可以模拟浏览器行为,并将网页呈现为图像或 PDF。

八爪鱼数据爬虫如何使用

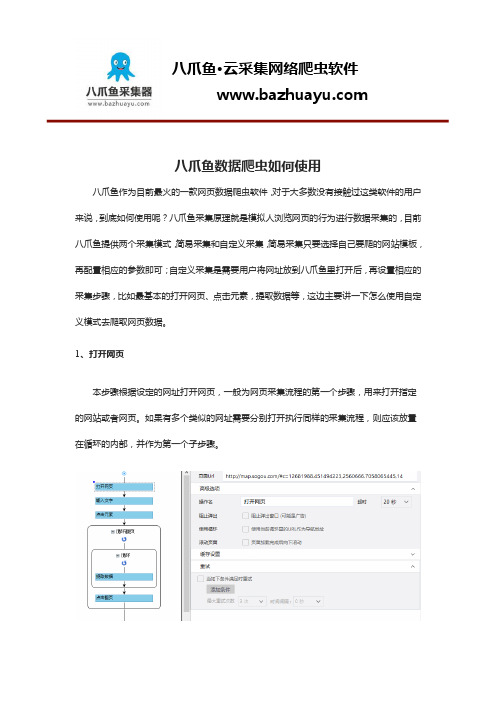

八爪鱼数据爬虫如何使用八爪鱼作为目前最火的一款网页数据爬虫软件,对于大多数没有接触过这类软件的用户来说,到底如何使用呢?八爪鱼采集原理就是模拟人浏览网页的行为进行数据采集的,目前八爪鱼提供两个采集模式,简易采集和自定义采集,简易采集只要选择自己要爬的网站模板,再配置相应的参数即可;自定义采集是需要用户将网址放到八爪鱼里打开后,再设置相应的采集步骤,比如最基本的打开网页、点击元素,提取数据等,这边主要讲一下怎么使用自定义模式去爬取网页数据。

1、打开网页本步骤根据设定的网址打开网页,一般为网页采集流程的第一个步骤,用来打开指定的网站或者网页。

如果有多个类似的网址需要分别打开执行同样的采集流程,则应该放置在循环的内部,并作为第一个子步骤。

2、点击元素本步骤对网页上指定的元素执行鼠标左键单击动作,比如点击按钮、点击超链接等。

3、输入文本本步骤在输入框中输入指定的文本,例如输入搜索关键词,输入账号等。

将设定的文本输入到网页的某个输入框中,如使用搜索引擎时输入关键字。

4、循环本步骤用来重复执行一系列步骤,根据配置不同,支持多种循环方式。

1)循环单个元素:循环点击页面中的某个按钮;2)循环固定元素列表:循环处理网页中固定数目的元素;3)循环不固定元素列表:循环处理网页中不固定数目的元素;4)循环URL列表:循环打开一批指定网址的网页,然后执行同样的处理步骤;5)循环文本列表:循环输入一批指定文字,然后执行同样的处理步骤。

5、提取数据本步骤根据提取数据模板的配置,从网页中提取数据,同时还可添加特殊字段:当前时间、固定字段、添加空字段、添加当前网页网址等。

另外,八爪鱼的规则市场有很多已经做好的规则,可直接下载后导入八爪鱼使用。

1、如何下载采集规则八爪鱼采集器内置了规则市场,由用户分享配置好的采集规则,互帮互助。

使用规则市场下载规则,可以不用花费时间研究和配置采集流程。

很多网站的采集规则都可以在规则市场中搜索到,下载运行即可采集。

红蜘蛛软件操作方法教程

红蜘蛛软件操作方法教程红蜘蛛软件是一款网络爬虫软件,用于批量采集互联网上的信息。

以下是红蜘蛛软件的基本操作方法教程:1. 下载和安装红蜘蛛软件:在红蜘蛛官方网站上下载最新版本的软件,并按照提示进行安装。

2. 启动红蜘蛛软件:双击桌面上的红蜘蛛软件图标,软件将会启动。

3. 设置爬行范围:点击软件界面上的“设置”按钮,选择“爬行范围”。

在弹出的对话框中,输入您要爬取的网址,可以选择可以选择爬取的页面类型、深度、线程数等参数,然后点击“确定”。

4. 设置保存路径:点击软件界面上的“设置”按钮,选择“保存路径”。

在弹出的对话框中,选择您要保存数据的路径,这些路径包括数据存储路径、日志文件存储路径等。

5. 开始爬行:点击软件界面上的“开始”按钮,红蜘蛛将开始爬取指定范围内的网页信息。

在爬行过程中,您可以实时查看当前的爬行进度和采集的数据。

6. 保存数据:爬行完成后,点击软件界面上的“保存”按钮,您可以选择将采集到的数据保存到本地的数据库、Excel文件、TXT文件等格式中。

7. 导出数据:点击软件界面上的“导出”按钮,您可以选择将采集到的数据导出为Excel文件、TXT文件等格式,以便后续使用。

8. 设置过滤规则:点击软件界面上的“设置”按钮,选择“过滤规则”。

在弹出的对话框中,您可以设置要过滤掉的页面类型、关键词等,以便提高数据采集的准确性和效率。

9. 设置采集字段:点击软件界面上的“设置”按钮,选择“采集字段”。

在弹出的对话框中,您可以设置要采集的页面中的特定字段,例如标题、URL、摘要等。

请注意,在使用红蜘蛛软件进行网络爬取时,请遵守相关的法律法规和网站的爬虫策略,以避免不必要的麻烦。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

常用的网络爬虫软件

常用的网络爬虫软件

1、神箭手云爬虫

神箭手云是一个大数据应用开发平台,为开发者提供成套的数据采集、数据分析和机器学习开发工具,为企业提供专业化的数据抓取、数据实时监控和数据分析服务。

免费用户无采集功能和导出限制,无需积分。

具备开发能力的用户可以自行开发爬虫,达到免费效果,没有开发能力的用户需要从爬虫市场寻找是否有免费的爬虫。

2、火车头采集器

火车采集器是一款网页数据抓取、处理、分析,挖掘软件。

可以灵活。