加权贝叶斯分类

一种基于强属性限定的加权贝叶斯分类器

e c su p in ma e tu a l oe p e st ed p n e c mo g atiu e n fe t t ls i c — n ea s m to k si n bet x r s h e e d n ea n trb tsa d afcsisca sf a i

王 峻

( 淮南师范学院 信息技术 系 安徽 淮南 220) 301

摘

要: 朴素 贝叶斯分类器是一种简单而高效 的分类器 , 但它的条件独立 性假设使其无法将属性 问的依赖关

系表达出来 , 影响 了它分类 的正确率 , 加权朴素贝叶斯是对 它的一种 扩展。基于强属性限定 的贝叶斯 分类器 S B 通过在强弱属性之间添加增强弧 以弱化朴 素 贝叶斯 的独 立性假设 , AN C, 扩展 了朴 素贝 叶斯 分类器 的结 构; 结合加权朴素贝叶斯 和基于强属性限定的贝叶斯分类器 S NB A C的优点 , 提出一种基 于强属性 限定 的加

A i ht d a e t i t d Ba e i n c a s fe a e n s r n tr b t s we g e nd r s r c e y sa l s ii r b s d o t o g a t i u e

W ANG u Jn

( p .o n or to gi e rn ,H u i a r a n v r iy,Hu i a 3 0 1,Ch n De t fI f ma i n En n e i g a n n No m l U i e st an n2 2 0 i a)

B y sa ls i e a e n sr n trb t s e tn s t e sr cu e o h av a e in ca sf r a ein ca sf rb sd o to g a ti u e x e d h tu t r ft e n ie B y sa ls i e i i

基于改进的加权贝叶斯分类算法在空间数据中的应用

Value Engineering0引言朴素贝叶斯分类器(Naive Bayesian Classifier,NBC)是一种简单而有效的概率分类方法,由于其计算高效、精确度高,并具有坚定的理论基础得到了广泛应用。

然而,朴素贝叶斯分类方法基于条件独立性假设,即假设一个属性对给定类的影响独立于其他属性,而这在现实问题中往往并不成立。

文献[1]给出了基于偏最小二乘回归(PLS)的属性求解算法。

该算法用回归系数度量了条件属性与决策属性之间的相关程度。

但忽略了冗余属性对回归分析的影响,为此,本文在分析属性相关性度量的基础上,通过属性约简的方法找出一组最近似独立的属性约简子集,从而删除冗余属性和无关属性,弱化了朴素贝叶斯分类器的独立性假设条件的限制。

在约简的数据集上,在条件属性与决策属性之间建立基于属性约简的偏最小二乘回归方程,以回归系数作为条件属性的权值,进一步改进朴素贝叶斯的分类测试能力。

并通过实验与朴素贝叶斯分类器进行比较。

1朴素贝叶斯分类及加权贝叶斯分类模型1.1朴素贝叶斯分类算法贝叶斯分类是一种基于统计方法的分类模型,贝叶斯定理是贝叶斯学习方法的理论基础。

朴素贝叶斯分类模型在贝叶斯定理的基础上,通过条件独立性假设,降低计算开销,预测未知数据样本属于最高后验概率的类。

设每个数据样本用一个n维特征向量X={x1,x2,…,x n}表示,分别描述对n个属性A1,A2,…A n样本的n个度量。

假定有m个类C1,C2,…,C m,给定一个未知的数据样本X,分类法将预测X属于具有最高后验概率的类。

即朴素贝叶斯分类将未知的样本分配给类C i,当且仅当P(C i│X)>P(C j│X),1燮j燮m,j≠i,这样,最大化P(C i│X)。

其中P(C j│X)最大的类C i称为最大后验假定。

根据贝叶斯定理得:P(C i│X)=P(C i│X)P(C i)。

由于P(X)为常数,只需P(X│C i)P(C i)最大即可。

贝叶斯分类

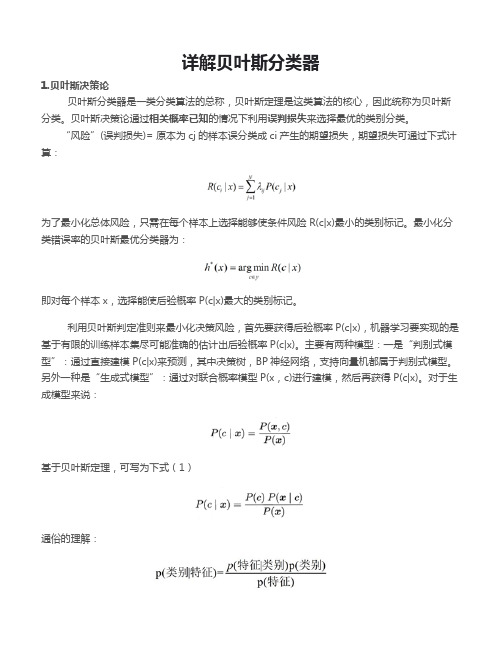

详解贝叶斯分类器1.贝叶斯决策论贝叶斯分类器是一类分类算法的总称,贝叶斯定理是这类算法的核心,因此统称为贝叶斯分类。

贝叶斯决策论通过相关概率已知的情况下利用误判损失来选择最优的类别分类。

“风险”(误判损失)= 原本为cj的样本误分类成ci产生的期望损失,期望损失可通过下式计算:为了最小化总体风险,只需在每个样本上选择能够使条件风险R(c|x)最小的类别标记。

最小化分类错误率的贝叶斯最优分类器为:即对每个样本x,选择能使后验概率P(c|x)最大的类别标记。

利用贝叶斯判定准则来最小化决策风险,首先要获得后验概率P(c|x),机器学习要实现的是基于有限的训练样本集尽可能准确的估计出后验概率P(c|x)。

主要有两种模型:一是“判别式模型”:通过直接建模P(c|x)来预测,其中决策树,BP神经网络,支持向量机都属于判别式模型。

另外一种是“生成式模型”:通过对联合概率模型P(x,c)进行建模,然后再获得P(c|x)。

对于生成模型来说:基于贝叶斯定理,可写为下式(1)通俗的理解:P(c)是类“先验”概率,P(x|c)是样本x相对于类标记c的类条件概率,或称似然。

p(x)是用于归一化的“证据”因子,对于给定样本x,证据因子p(x)与类标记无关。

于是,估计p(c|x)的问题变为基于训练数据来估计p(c)和p(x|c),对于条件概率p(x|c)来说,它涉及x所有属性的联合概率。

2.极大似然估计假设p(x|c))具有确定的形式并且被参数向量唯一确定,则我们的任务是利用训练集估计参数θc,将P(x|c)记为P(x|θc)。

令Dc表示训练集D第c类样本的集合,假设样本独立同分布,则参数θc对于数据集Dc的似然是对进行极大似然估计,就是去寻找能最大化P(Dc|θc)的参数值。

直观上看,极大似然估计是试图在θc所有可能的取值中,找到一个能使数据出现的“可能性”最大的值。

上式的连乘操作易造成下溢,通常使用对数似然:此时参数θc的极大似然估计为在连续属性情形下,假设概率密度函数,则参数和的极大似然估计为:也就是说,通过极大似然法得到的正态分布均值就是样本均值,方差就是的均值,在离散情况下,也可通过类似的方式估计类条件概率。

信息增益 加权贝叶斯 信息熵

信息增益加权贝叶斯信息熵

信息增益、加权贝叶斯和信息熵是数据分析和机器学习领域中常用的概念和方法。

它们在处理大量数据和进行决策时起着重要的作用。

本文将介绍这三个概念的含义和应用,并探讨它们之间的关系。

我们来了解一下信息增益。

信息增益是一种衡量数据中某个特征对分类任务的贡献程度的指标。

在决策树算法中,通过计算每个特征的信息增益,选择信息增益最大的特征作为划分依据,从而构建出一棵分类树。

信息增益越大,表示该特征对分类结果的影响越大。

接下来,我们再来介绍一下加权贝叶斯。

加权贝叶斯是一种基于贝叶斯定理的分类方法。

在传统的贝叶斯分类器中,假设各个特征之间是相互独立的,但在实际应用中,不同特征对分类结果的贡献程度是不同的。

因此,通过为不同特征分配权重,加权贝叶斯可以更准确地进行分类。

我们来说一下信息熵。

信息熵是一种度量信息不确定性的指标。

在信息论中,熵越高表示信息的不确定性越大,熵越低表示信息的不确定性越小。

在决策树算法中,通过计算每个特征的信息熵,选择信息熵最小的特征作为划分依据,从而构建出一棵分类树。

信息熵越小,表示该特征对分类结果的影响越大。

信息增益、加权贝叶斯和信息熵都是数据分析和机器学习中重要的概念和方法。

它们通过对数据的分析和计算,帮助我们更好地理解

数据的特征和分类结果,从而做出更准确的决策和预测。

在实际应用中,我们可以根据具体的需求和数据特点选择适合的方法,以提高分类的准确性和效率。

加权朴素贝叶斯公式

加权朴素贝叶斯公式

加权朴素贝叶斯公式是一种分类方法,基于贝叶斯定理和特征之间的独立性假设。

其核心思想是将每个特征对分类结果的贡献度作为权重,通过计算每个类别的概率,选择概率最大的类别作为分类结果。

具体来说,加权朴素贝叶斯公式包括以下几个步骤:

1. 计算每个特征在每个类别下的条件概率,即P(x1y),P(x2y),…,

P(xmy),其中x1,x2,…,xm是m个特征,y是分类结果;

2. 计算每个特征的权重,即权值 = 类别概率×条件概率;

3. 将每个特征的权值相加,得到每个类别的概率,即P(y1)=∑i=1m权值(i,y1),P(y2)=∑i=1m权值(i,y2);

4. 选择概率最大的类别作为分类结果。

加权朴素贝叶斯公式的优点在于可以自动地根据数据的特征选择合适的权重,避免了人工设定阈值的麻烦。

同时,由于使用了贝叶斯定理,分类结果具有很好的概率保证。

但是,加权朴素贝叶斯公式也存在一些局限性,例如对特征之间的独立性假设比较敏感,容易受到异常值和噪声的影响等。

特征加权融合的朴素贝叶斯情感分类算法

特征加权融合的朴素贝叶斯情感分类算法曾宇;刘培玉;刘文锋;朱振方【摘要】为解决文本情感分类准确率不高的问题,提出了一种特征加权融合的朴素贝叶斯情感分类算法.通过分析单个情感词对文本情感分类的贡献度特征,根据情感词对文本情感贡献度的权值调整贝叶斯模型的后验概率;将文本中所有相同极性的情感词作为一个特征整体,根据特征整体对文本情感贡献度的权值调整贝叶斯模型的整体概率.为了进一步提高分类的准确率以及提升分类模型的综合性能,将两种加权方式同时与朴素贝叶斯模型结合.结果表明,融合后的方法在数据集上的整体平均查准率、查全率分别提高1.83%和3.42%,平均F1值提高了2.76%.%In order to improve the accuracy rate of text sentiment classification ,a naive Bayesian algorithm for text sentiment classification based feature weighting integration is proposed . Firstly , by analyzing the feature of the individual sentiment word contribute to the text sentiment classification , it adjuststhe posteriori probability of the Bayesian model according to the weight value of the sentiment words 'contribution to the text sentiment classification . Secondly , all sentiment words of same polarity are treatedas a whole whose feature is merged with Bayesian model and the probability of the Bayesian model that is adjusted according to the weight value of the feature's contribution . Finally , to improve the accuracy rate and enhance the comprehensive performance of the classification model , the two weighting methods are integrated into Bayesian model . The experimental results illustrate that the overall average precision and the recall of the integrated method on the dataset are increased by about 1.83%and 3.42% respectively ,and the average F1 value increases by about2.76% .【期刊名称】《西北师范大学学报(自然科学版)》【年(卷),期】2017(053)004【总页数】6页(P56-60,73)【关键词】情感分类;特征加权;贡献度特征;朴素贝叶斯【作者】曾宇;刘培玉;刘文锋;朱振方【作者单位】山东师范大学信息科学与工程学院,山东济南 250358;山东省分布式计算机软件新技术重点实验室,山东济南 250358;山东师范大学信息科学与工程学院,山东济南 250358;山东省分布式计算机软件新技术重点实验室,山东济南250358;山东师范大学信息科学与工程学院,山东济南 250358;菏泽学院计算机与信息工程系,山东菏泽 274015;山东交通学院信息科学与电气工程学院,山东济南250357【正文语种】中文【中图分类】TP391.1情感分析又称意见挖掘,是对带有情感色彩的评论文本进行分类、处理和归纳的一个过程[1].通过对评论文本进行有效的情感分析,商家能够通过用户反馈的信息进行筛选和分类,从中获得更有用的信息,及时地向用户推荐合适的商品,以便帮助用户更好地做出购买商品的选择,从而获得更大的利益.用户也可从分析后的评论文本中判断商品的质量,从而确定是否购买该类商品.文本情感分类是情感分析的一个研究热点,它的目的是将文本的整体情感倾向分为正面(积极、肯定、赞扬等)和负面(消极、否定、批评等)两个类别.目前文本情感分类方法的研究主要分为两类[2].一类是基于情感词典规则的方法[3-5].另一类基于机器学习的特征分类方法[6-7].基于情感词典规则的方法主要是利用现有的资源对情感词典进行构建,然后通过结合已构建的情感词典从评论文本中提取情感词作为特征,并结合提出的规则将短语或者是句子进行加权求和得到文本的情感倾向.而基于情感词典的方法依赖于情感词典的质量,当情感词典资源匮乏时无法有效地分析文本的情感倾向.基于机器学习的特征分类方法主要是利用人工标注的训练语料来构建分类器模型,通过构建的模型判断测试文本的情感倾向.在现有的机器学习分类模型中,朴素贝叶斯分类方法是一种常用的机器学习方法.与其他分类方法相比,朴素贝叶斯分类方法相对简单并且在文本情感分类中能够取得较好的分类效果.因此,朴素贝叶斯分类算法在文本情感分类领域得到广泛的应用.文献[8]提出一种情感词典与朴素贝叶斯相结合的情感分类方法,利用情感词典进行特征提取,并把情感词作为特征词,与CHI特征选择方法进行比较.文献[9]通过分析汉语语言中转折句式结构的特点,提出一种用于进行情感分析的启发式规则,并将该规则融入朴素贝叶斯分类模型中对文本进行情感倾向性分析.文献[10]提出句子加权算法的篇章级文本情感倾向性分析方法,利用朴素贝叶斯判别简单句的情感倾向,利用情感规则判别复杂句的情感倾向,最后利用句子加权的方法判断篇章级的文本情感倾向.总得来看,现有的朴素贝叶斯情感分类方法中很少有考虑到情感特征词对评论文本情感倾向性贡献程度的特点,这将导致判别文本情感倾向性的准确率不够理想.因此,为了解决这些问题,本文通过构建基于扩展情感词典的朴素贝叶斯分类模型对评论文本进行情感分析.本文的主要工作是通过引入加权因子对情感词进行加权,从而调整模型的概率.最后通过实验验证本文方法的可行性.1.1 特征提取特征提取是实现文本情感倾向性判断的基础,通过对文本进行特征提取,在一定程度上可以提高情感倾向判断的准确率.文献[9]通过实验证明利用情感词作为特征词的分类方法的效果要优于利用CHI特征选择方法的分类效果.因此,本文通过将中国知网提供的HowNet情感词典和台湾大学提供的NTUSD情感词典以及收集的部分网络情感词进行整合,并筛选出有效的情感词加入情感词集合得到一个扩展情感词典(Expanding sentiment lexicon, ESL).最后,通过结合构建的扩展情感词典进行特征提取.1.2 贝叶斯分类模型对于文本d={w1,w2,…,wn}的情感倾向属于j={pos,neg},假设在各个情感特征相互独立的情况下,得到朴素贝叶斯情感分类公式其中,p(cj)为文本类别为j的先验概率;p(wici)为贝叶斯模型的后验概率.其中为类别为j的文档包含的情感词总数;为整个训练语料文档包含的情感词总数;s(wi,cj)为在情感类别为j的情况下情感词wi在各个文档中出现过的次数之和.另外,为了避免在计算过程中后验概率p(wici)等于0的情况,使用Laplace转换,最终得到计算后验概率的公式其中,为训练样本包含多少种情感词,这些情感词是不重复的.1.3 情感词特征加权传统的朴素贝叶斯情感分类算法仅仅考虑将情感词作为文本的情感特征,没有考虑到文本中不同极性的情感词对文本情感倾向的影响.例如在一篇正向的评论文本中只出现正向情感词,在使用贝叶斯方法计算情感词的后验概率时有可能会出现正向情感词对正向文本的后验概率小于其对负向文本的后验概率,这就导致将该文本错误地判断为负向文本,造成文本情感分类的准确率下降.因此,本文结合构建的ESL情感词典以及分析文本情感表达的特点,通过引入加权因子T(wicj)确定不同极性的情感词对文本情感极性分析的贡献程度.T(wicj)表示判断为j类别的评论文本中情感词wi的权值.加权因子的值越大表明该情感词对文本整体情感极性分析贡献的程度越大,即情感词对文本整体情感极性贡献的权值越大.经过分析发现,正向情感词对正向评论文本贡献的权值应当大于正向情感词对负向评论文本贡献的权值.同理,负向情感词对负向评论文本贡献的权值应当大于负向情感词对正向评论文本贡献的权值.因此,为了更有效的对情感词赋予相应的权值,本文通过结合测试文本中情感词的数量来确定加权因子的计算公式.令p表示测试文本中正向情感词的个数,q表示第一篇测试文本中负向情感词的个数.本文将加权因子的计算公式定义为符合以下等式其中,Lpos为构建情感词典中属于正向类别的情感词集合;Lneg为构建情感词典中属于负向类别的情感词集合.1.4 整体特征加权经过大量语料分析发现,当文本中出现某一类别情感词的数量多于另一类别的情感词数量时,文本语料的情感倾向性往往会与含有多数情感极性词的倾向性一致.即语料中同一类别情感词个数的多少会影响文本整体的情感倾向性.因此,为了进一步区分文档所属情感类别的概率,本文将测试文本中所有相同极性情感词作为一个统一的特征整体并对其赋予不同的权值.为了更有效的对特征整体赋予相应的权值,本文结合以下2个条件1)当每一篇测试文本中出现正向情感词的个数大于负向情感词的个数时,正向情感词对正向评论文本贡献的权值大于负向情感词对负向评论文本贡献的权值;2)当每一篇测试文本中出现负向情感词的个数大于正向情感词的个数时,负向情感词对负向评论文本贡献的权值大于正向情感词对正向评论文本贡献的权值.结合上述2个条件,本文通过引入加权因子来确定情感词个数对文本情感分析影响的整体权值.w(w+cj)表示负向情感词整体对评论文本贡献的权值.整体加权因子的计算公式定义为1.5 特征加权融合算法为了进一步提高文本情感分类的准确率以及提升分类模型的综合性能.本文将上述引入的两种加权因子进行融合,实现一种特征加权融合的朴素贝叶斯情感分类算法.融合后的公式为特征加权融合的朴素贝叶斯情感分类算法的描述如下.输入:训练文本、测试文本、ESL情感词典.输出:文本的情感倾向.算法过程:1)文本预处理.通过分词工具对文本进行分词并结合停用词表去除无关的词语;2)特征提取.将文本与构建的情感词典进行匹配,提取出相应的情感特征词;3)构建分类模型.结合步骤2中提取的特征词对带有情感标签的训练文本进行训练,通过(4)式计算得到情感词的后验概率;4)情感词特征加权.根据(5)~(7)式,计算加权因子T(wicj)结合,调整情感词在贝叶斯模型中的后验概率;5)整体特征加权.根据(8)~(9)式分别计算整体加权因子w(w+cj)在不同情况下的权值,并将其融入贝叶斯分类模型中,根据文本中情感词的数量调整模型的整体概率;6)情感分类.结合步骤4)和步骤5),得到融合后的模型,通过计算测试文本所属情感类别的概率,概率大的判断为文本所属的情感类别.2.1 实验语料选取本文使用的实验数据集是ChnSentiCorp去重后的数据集.该数据集包含电脑、酒店、书籍3个不同领域的数据.本文从3个领域的数据中分别选取正负各2000篇作为本次实验的数据.实验数据集的分布情况见表1.实验测试的计算机处理器为Intel(R)Core(TM)i5-5200 2.20 GHz,内存4 GB,操作系统为Windows 8.1,使用Java语言进行编程,Eclipse作为开发环境.本次实验从3个数据集中分别选取正向文档和负向文档中10%的数据作为测试集,其余的文档作为训练集.2.2 评价指标实验采用目前广泛使用的准确率(Accuracy)、查准率(Precision)、查全率(Recall)和F1值4种指标来评估情感分类算法的效果.进行情感分类的评价指标分别定义如下准确率=×100%,查准率=×100%,查全率=×100%,F1=×100%。

贝叶斯分类分类算法

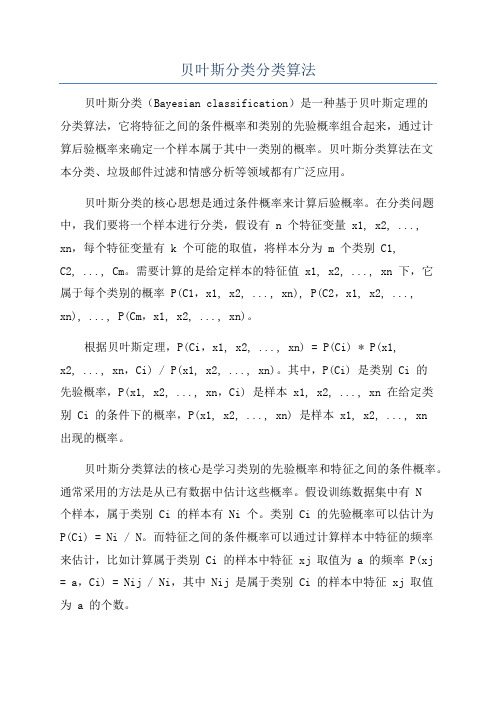

贝叶斯分类分类算法贝叶斯分类(Bayesian classification)是一种基于贝叶斯定理的分类算法,它将特征之间的条件概率和类别的先验概率组合起来,通过计算后验概率来确定一个样本属于其中一类别的概率。

贝叶斯分类算法在文本分类、垃圾邮件过滤和情感分析等领域都有广泛应用。

贝叶斯分类的核心思想是通过条件概率来计算后验概率。

在分类问题中,我们要将一个样本进行分类,假设有 n 个特征变量 x1, x2, ..., xn,每个特征变量有 k 个可能的取值,将样本分为 m 个类别 C1,C2, ..., Cm。

需要计算的是给定样本的特征值 x1, x2, ..., xn 下,它属于每个类别的概率 P(C1,x1, x2, ..., xn), P(C2,x1, x2, ..., xn), ..., P(Cm,x1, x2, ..., xn)。

根据贝叶斯定理,P(Ci,x1, x2, ..., xn) = P(Ci) * P(x1,x2, ..., xn,Ci) / P(x1, x2, ..., xn)。

其中,P(Ci) 是类别 Ci 的先验概率,P(x1, x2, ..., xn,Ci) 是样本 x1, x2, ..., xn 在给定类别 Ci 的条件下的概率,P(x1, x2, ..., xn) 是样本 x1, x2, ..., xn出现的概率。

贝叶斯分类算法的核心是学习类别的先验概率和特征之间的条件概率。

通常采用的方法是从已有数据中估计这些概率。

假设训练数据集中有 N个样本,属于类别 Ci 的样本有 Ni 个。

类别 Ci 的先验概率可以估计为P(Ci) = Ni / N。

而特征之间的条件概率可以通过计算样本中特征的频率来估计,比如计算属于类别 Ci 的样本中特征 xj 取值为 a 的频率 P(xj = a,Ci) = Nij / Ni,其中 Nij 是属于类别 Ci 的样本中特征 xj 取值为 a 的个数。

基于加权朴素贝叶斯分类法的成绩预测模型

效率 。加权朴素 贝叶斯分类模型被定义为 :

生学 习成绩的资源 ,但传统 的方法难以在这些 海量 的数据 中寻找到有价值 的信息 ,教学管理

者和决 策者们都迫切需要通 过更高层次的数据 分析来 揭示其教学 中的规律 ,从而更好的开展

( ) = a r g m a x P ( y ) 兀p ( x ) ( 4 )

而使得朴素 贝叶斯 方法得 以扩展 ,降低算法对 属性独立性 的要求 ,同时也有利于提高分类的

【 关键 词 】朴素 贝叶斯 成绩预测 信息熵

本 和描述它 的 / ' / 个 属性 ,即X= b… , } , 而类别变量 y 有 m个属性 ,即Y ={ y , , … Y ) ,

Y i =1

其中 代表属性 X 的权值。显然 如果权 值越 大,该属性对分类的影响就越大 ,因此加

权朴 素贝叶斯分类的关键 问题就在于如何确定 ( 2 )

不同属性的权值 。

) = 型 教学工作 。于是许多学者开始使用数据挖 掘技

术去研究这些 教育数据 中潜藏 的知识 和信 息,

朴 素 贝叶斯 分类法 与其 他算 法相 比有 着

因素 ,将这些 处理 的结果有效地 用于完善教学 最小 的误差率 ,但 其前提 条件限制 比较严格 , 系统 的设计 、控 制和评价中 ,从而及时改进和 调整教学策 略,进 而提高高校 的教学质量 。 只有 当对象 的各个属性之间都相互独立时 ,使 用朴 素贝叶斯 模型可以得 到最佳 分类效果 ,然 而在学 生成 绩预测的几个研 究属性之间很难满 足这个 条件 ,例如 :任课 教师的资历很可能对

简单而友 好。系统整体主要从整个教 育系统的 不同的操作平台来进行操作 。

教师专业 发展 规划为立足点 ,通过从 教师 本人

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

加权贝叶斯分类

加权贝叶斯分类(WNBC)是一种基于贝叶斯规则的统计分类方法。

与普通贝叶斯分类器不同的是,WNBC会对不同特征进行加权,以提高分类准确率。

这个方法可以用于许多不同任务,如文本分类、图像分类和语音识别等。

贝叶斯分类器基于贝叶斯定理,通过估计先验概率和条件概率来对数据进行分类。

贝叶斯分类器对于所估计的概率具有单调性,当先验概率和条件概率越接近真实值时,分类器的准确性就越高。

而WNBC则将不同特征加权,以获取更高的分类准确率。

WNBC的加权策略通常基于两种方法:基于类别加权和基于特征加权。

在基于类别加权中,每个类别都有一个权重,用于调整分类器的决策。

这个权重取决于该类别的错误率,即错误分类到该类别的样本数除以所有错误分类样本的总数。

在基于特征加权中,分类器为每个特征分配一个权重,这个权重是由计算和实验得出的。

这个权重反映了该特征对分类的贡献程度。

WNBC的过程与贝叶斯分类器相似,但否定条件的概率是基于具体的权重来计算的。

这是因为不同特征在分类中起到的作用不同。

一些特征可能对某些分类更有影响,而对其他分类则没有影响。

在WNBC中,先验概率和条件概率都需要估计。

估计先验概率通常是比较简单的,只需要在训练数据中计算每一类别出现的频率。

而估计条件概率则需要用到不同的加权策略。

基于类别加权的方法通常需要更多计算,因为需要计算每个类别中每个特征的错误率。

在基于特征加权中,条件概率可以很容易地计算,因为每个特征的权重已经确定。

WNBC可以很好地应用于多分类问题和高维数据。

这是因为加权特征可以减轻特征维度和类别数量的影响。

WNBC也可以很容易地进行在线学习,因为权重可以根据新数据进行更新。

需要指出的是,WNBC也有其缺点。

由于需要使用更多的计算,速度可能会比贝叶斯分类器更慢。

此外,WNBC还需要在训练数据中进行交叉验证,以确定最佳的特征加权和类别加权策略。

总的来说,加权贝叶斯分类是一个有效的分类方法,可以提高分类准确率。

在具体应用中,需要通过实验来确定最佳的加权策略。