华南理工大学《模式识别》大作业报告

模式识别大作业02125128(修改版)

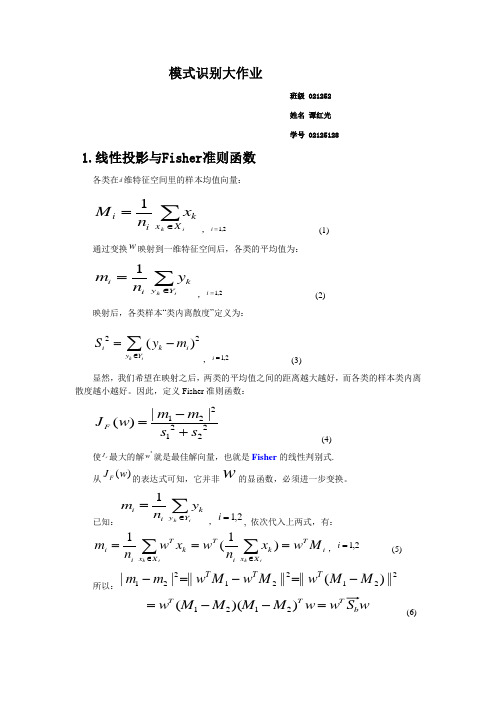

模式识别大作业班级 021252 姓名 谭红光 学号 021251281.线性投影与Fisher 准则函数各类在d 维特征空间里的样本均值向量:∑∈=ik X x kii xn M 1,2,1=i (1)通过变换w 映射到一维特征空间后,各类的平均值为:∑∈=ik Y y kii yn m 1,2,1=i (2)映射后,各类样本“类内离散度”定义为:22()k ii k i y Y S y m ∈=-∑,2,1=i (3)显然,我们希望在映射之后,两类的平均值之间的距离越大越好,而各类的样本类内离散度越小越好。

因此,定义Fisher 准则函数:2122212||()F m m J w s s -=+ (4)使FJ 最大的解*w 就是最佳解向量,也就是Fisher 的线性判别式. 从)(w J F 的表达式可知,它并非w 的显函数,必须进一步变换。

已知:∑∈=ik Y y kii yn m 1,2,1=i , 依次代入上两式,有:i TX x ki Tk X x Ti i M w x n w x w n m ik ik ===∑∑∈∈)1(1,2,1=i (5) 所以:221221221||)(||||||||M M w M w M w m m T T T -=-=-w S w w M M M M w b T T T =--=))((2121 (6)其中:Tb M M M M S ))((2121--= (7)bS 是原d 维特征空间里的样本类内离散度矩阵,表示两类均值向量之间的离散度大小,因此,b S 越大越容易区分。

将(4.5-6)i Ti M w m =和(4.5-2)∑∈=ik X x kii xn M 1代入(4.5-4)2iS 式中:∑∈-=ik X x iT k T i M w x w S 22)(∑∈⋅--⋅=ik X x Tik i k T w M x M x w ))(( w S w i T= (8)其中:T iX x k i k i M x M x S ik ))((--=∑=,2,1=i (9)因此:w S w w S S w S S w T T =+=+)(212221 (10)显然:21S S S w += (11)w S 称为原d 维特征空间里,样本“类内离散度”矩阵。

《模式识别》课程2019年度大作业

《模式识别》课程2019年度大作业注意事项:(请务必详细阅读所有注意事项)1.本作业发布时间2019.5.5,交作业时间:2018.5.30日第一节课下课后,第二节课上课前(即上午9点整)。

与平时作业不同,不允许迟交,迟交则成绩以0分计。

2.与平时作业不同,大作业只有研究生同学完成,保送本系的本科同学也需要完成,但其他本科生无需完成。

请在作业的开始部分写上姓名、学号,缺少该信息的,本次作业总分扣除10分。

如果是已经完成保送手续,先修研究生课程的本校本科生,请一定每次作业在姓名后加注“(本科保送)”,否则无法拿到学分。

3.与平时作业不同,作业评分以电子版为准。

需要提交代码,具体的提交要求请仔细阅读作业说明。

总体文件大小不超过5MB(可以提交压缩文件)。

上传地址为/。

初始用户名和密码为学号。

研究生学号以MP18开头的暂时无法登陆,可将电子版email给助教(wangguohua@, yik@),其余同学务必使用网站系统上传。

是否迟交以cslabcms系统的时间戳或电子邮件的时间戳为准。

大作业:1.仔细阅读以下网页的内容(/weixs/project/DDT/DDT.html),包括其中提供链接的英文论文,理解DDT方法的运行步骤。

2.自行实现DDT算法。

实现时可以参考上述网页提供的Matlab代码以加深对DDT方法的理解,但是不可以使用MatConvNet这一深度学习框架,除此以外的其余任意深度学习软件框架都可以使用。

3.如尚未有深度学习、CNN的编程经验,请搜索网络资源完成自学。

4.如有可供使用的GPU加速卡资源,可以自由使用。

如无这种资源,可在编程中指定使用CPU(即,不使用GPU)来完成计算。

DDT方法的计算量很小,使用CPU也可完成计算。

5.在上述网页提供下载的代码链接里有少量图片可供使用,利用这些图片完成DDT方法的学习,利用可视化技术(参考论文和代码)直观考察DDT方法的效果。

6.请提交完成上述任务的文档和代码,需提交的内容如下:a.说明文档:自行组织文档的格式,保证文档的内容能让助教清晰地理解你的代码运行环境、实现的主要思路、你通过实现并运行代码后对DDT方法的理解等。

模式识别专业实践报告(2篇)

第1篇一、实践背景与目的随着信息技术的飞速发展,模式识别技术在各个领域得到了广泛应用。

作为人工智能领域的一个重要分支,模式识别技术对于图像处理、语音识别、生物识别等领域的发展具有重要意义。

为了更好地理解和掌握模式识别技术,提高实际应用能力,我们组织了一次为期一个月的模式识别专业实践。

本次实践旨在通过实际操作,加深对模式识别理论知识的理解,提高解决实际问题的能力。

二、实践内容与过程1. 实践内容本次实践主要包括以下几个方面:(1)图像识别:利用深度学习算法进行图像分类、目标检测等。

(2)语音识别:实现语音信号处理、特征提取和识别。

(3)生物识别:研究指纹识别、人脸识别等生物特征识别技术。

(4)模式分类:运用机器学习算法进行数据分类和聚类。

2. 实践过程(1)理论学习:在实践开始前,我们首先对模式识别的基本理论进行了系统学习,包括图像处理、信号处理、机器学习等相关知识。

(2)项目准备:根据实践内容,我们选取了具有代表性的项目进行实践,如基于深度学习的图像识别、基于HMM的语音识别等。

(3)实验设计与实施:在导师的指导下,我们设计了实验方案,包括数据预处理、模型选择、参数调整等。

随后,我们使用Python、C++等编程语言进行实验编程,并对实验结果进行分析。

(4)问题分析与解决:在实验过程中,我们遇到了许多问题,如数据不足、模型效果不佳等。

通过查阅文献、请教导师和团队成员,我们逐步解决了这些问题。

三、实践成果与分析1. 图像识别我们使用卷积神经网络(CNN)对CIFAR-10数据集进行了图像分类实验。

实验结果表明,经过多次迭代优化,模型在测试集上的准确率达到89.5%,优于传统机器学习方法。

2. 语音识别我们采用HMM(隐马尔可夫模型)对TIMIT语音数据集进行了语音识别实验。

实验结果表明,经过特征提取和模型训练,模型在测试集上的词错误率(WER)为16.3%,达到了较好的识别效果。

3. 生物识别我们研究了指纹识别和人脸识别技术。

模式识别实习报告

一、实习背景随着科技的飞速发展,人工智能、机器学习等技术在各个领域得到了广泛应用。

模式识别作为人工智能的一个重要分支,具有广泛的应用前景。

为了更好地了解模式识别技术,提高自己的实践能力,我在2023年暑假期间参加了某科技有限公司的模式识别实习。

二、实习单位简介某科技有限公司是一家专注于人工智能、大数据、云计算等领域的科技创新型企业。

公司致力于为客户提供智能化的解决方案,业务涵盖智能识别、智能监控、智能分析等多个领域。

此次实习,我将在该公司模式识别部门进行实践学习。

三、实习内容1. 实习前期(1)了解模式识别的基本概念、原理和应用领域;(2)熟悉模式识别的相关算法,如神经网络、支持向量机、决策树等;(3)掌握Python编程语言,学会使用TensorFlow、Keras等深度学习框架。

2. 实习中期(1)参与实际项目,负责模式识别算法的设计与实现;(2)与团队成员协作,完成项目需求分析、算法优化和系统测试;(3)撰写项目报告,总结实习过程中的收获与不足。

3. 实习后期(1)总结实习期间的学习成果,撰写实习报告;(2)针对实习过程中遇到的问题,查找资料、请教同事,提高自己的解决问题的能力;(3)为后续实习工作做好充分准备。

四、实习收获与体会1. 理论与实践相结合通过实习,我深刻体会到理论与实践相结合的重要性。

在实习过程中,我将所学的模式识别理论知识运用到实际项目中,提高了自己的动手能力。

同时,通过解决实际问题,我更加深入地理解了模式识别算法的原理和应用。

2. 团队协作能力实习期间,我学会了与团队成员有效沟通、协作。

在项目中,我们共同面对挑战,分工合作,共同完成项目任务。

这使我认识到团队协作的重要性,为今后的工作打下了基础。

3. 解决问题的能力在实习过程中,我遇到了许多问题。

通过查阅资料、请教同事、独立思考等方式,我逐渐学会了如何分析问题、解决问题。

这种能力对我今后的学习和工作具有重要意义。

4. 深度学习框架的使用实习期间,我学会了使用TensorFlow、Keras等深度学习框架。

模式识别实习报告

实习报告一、实习背景及目的随着科技的飞速发展,模式识别技术在众多领域发挥着越来越重要的作用。

模式识别是指对数据进行分类、识别和解释的过程,其应用范围广泛,包括图像处理、语音识别、机器学习等。

为了更好地了解模式识别技术的原理及其在实际应用中的重要性,我参加了本次模式识别实习。

本次实习的主要目的是:1. 学习模式识别的基本原理和方法;2. 掌握模式识别技术在实际应用中的技巧;3. 提高自己的动手实践能力和团队协作能力。

二、实习内容及过程实习期间,我们团队共完成了四个模式识别项目,分别为:手写数字识别、图像分类、语音识别和机器学习。

下面我将分别介绍这四个项目的具体内容和过程。

1. 手写数字识别:手写数字识别是模式识别领域的一个经典项目。

我们使用了MNIST数据集,这是一个包含大量手写数字图片的数据集。

首先,我们对数据集进行预处理,包括归一化、数据清洗等。

然后,我们采用卷积神经网络(CNN)作为模型进行训练,并使用交叉验证法对模型进行评估。

最终,我们得到了一个识别准确率较高的模型。

2. 图像分类:图像分类是模式识别领域的另一个重要应用。

我们选择了CIFAR-10数据集,这是一个包含大量彩色图像的数据集。

与手写数字识别项目类似,我们先对数据集进行预处理,然后采用CNN进行训练。

在模型训练过程中,我们尝试了不同的优化算法和网络结构,以提高模型的性能。

最终,我们得到了一个识别准确率较高的模型。

3. 语音识别:语音识别是模式识别领域的又一项挑战。

我们使用了TIMIT数据集,这是一个包含大量语音样本的数据集。

首先,我们对语音样本进行预处理,包括特征提取、去噪等。

然后,我们采用循环神经网络(RNN)作为模型进行训练。

在模型训练过程中,我们尝试了不同的优化算法和网络结构。

最后,我们通过对模型进行评估,得到了一个较为可靠的语音识别系统。

4. 机器学习:机器学习是模式识别领域的基础。

我们使用了UCI数据集,这是一个包含多个数据集的数据集。

模式识别大作业

模式识别大作业引言:转眼之间,研一就结束了。

这学期的模式识别课也接近了尾声。

我本科是机械专业,编程和算法的理解能力比较薄弱。

所以虽然这学期老师上课上的很精彩,但是这学期的模式识别课上的感觉还是有点吃力。

不过这学期也加强了编程的练习。

这次的作业花了很久的时间,因为平时自己的方向是主要是图像降噪,自己在看这一块图像降噪论文的时候感觉和模式识别的方向结合的比较少。

我看了这方面的模式识别和图像降噪结合的论文,发现也比较少。

在思考的过程中,我想到了聚类的方法。

包括K均值和C均值等等。

因为之前学过K均值,于是就选择了K均值的聚类方法。

然后用到了均值滤波和自适应滤波进行处理。

正文:k-means聚类算法的工作过程说明如下:首先从n个数据对象任意选择 k 个对象作为初始聚类中心;而对于所剩下其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类;然后再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值);不断重复这一过程直到标准测度函数开始收敛为止。

一般都采用均方差作为标准测度函数。

k-means 算法接受输入量k ;然后将n个数据对象划分为k个聚类以便使得所获得的聚类满足:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。

聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算的。

k个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。

均值滤波是常用的非线性滤波方法 ,也是图像处理技术中最常用的预处理技术。

它在平滑脉冲噪声方面非常有效,同时它可以保护图像尖锐的边缘。

均值滤波是典型的线性滤波算法,它是指在图像上对目标像素给一个模板,该模板包括了其周围的临近像素(以目标象素为中心的周围8个象素,构成一个滤波模板,即去掉目标象素本身)。

再用模板中的全体像素的平均值来代替原来像素值。

即对待处理的当前像素点(x,y),选择一个模板,该模板由其近邻的若干像素组成,求模板中所有像素的均值,再把该均值赋予当前像素点(x,y),作为处理后图像在该点上的灰度个g(x,y),即个g(x,y)=1/m ∑f(x,y)m为该模板中包含当前像素在内的像素总个数。

模式识别大作业

作业1 用身高和/或体重数据进行性别分类(一)基本要求:用和的数据作为训练样本集,建立Bayes分类器,用测试样本数据对该分类器进行测试。

调整特征、分类器等方面的一些因素,考察它们对分类器性能的影响,从而加深对所学内容的理解和感性认识。

具体做法:1.应用单个特征进行实验:以(a)身高或者(b)体重数据作为特征,在正态分布假设下利用最大似然法或者贝叶斯估计法估计分布密度参数,建立最小错误率Bayes分类器,写出得到的决策规则,将该分类器应用到测试样本,考察测试错误情况。

在分类器设计时可以考察采用不同先验概率(如对, 对, 对等)进行实验,考察对决策规则和错误率的影响。

图1-先验概率:分布曲线图2-先验概率:分布曲线图3--先验概率:分布曲线图4不同先验概率的曲线有图可以看出先验概率对决策规则和错误率有很大的影响。

程序:和2.应用两个特征进行实验:同时采用身高和体重数据作为特征,分别假设二者相关或不相关(在正态分布下一定独立),在正态分布假设下估计概率密度,建立最小错误率Bayes 分类器,写出得到的决策规则,将该分类器应用到训练/测试样本,考察训练/测试错误情况。

比较相关假设和不相关假设下结果的差异。

在分类器设计时可以考察采用不同先验概率(如 vs. , vs. , vs. 等)进行实验,考察对决策和错误率的影响。

训练样本female来测试图1先验概率 vs. 图2先验概率 vs.图3先验概率 vs. 图4不同先验概率对测试样本1进行试验得图对测试样本2进行试验有图可以看出先验概率对决策规则和错误率有很大的影响。

程序和3.自行给出一个决策表,采用最小风险的Bayes决策重复上面的某个或全部实验。

设以ceshi1单个特征身高进行试验:决策表W1W2W10W20close all;clear all;X=120::200; %设置采样范围及精度pw1=;pw2=; %设置先验概率sample1=textread('') %读入样本samplew1=zeros(1,length(sample1(:,1)));u1=mean(sample1(:,1));m1=std(sample1(:,1));y1=normpdf(X,u1,m1); %类条件概率分布figure(1);subplot(2,1,1);plot(X,y1);title('F身高类条件概率分布曲线');sample2=textread('') %读入样本samplew2=zeros(1,length(sample2(:,1)));u2=mean(sample2(:,1));m2=std(sample2(:,1));y2=normpdf(X,u2,m2); %类条件概率分布subplot(2,1,2);plot(X,y2);title('M身高类条件概率分布曲线');P1=pw1*y1./(pw1*y1+pw2*y2);P2=pw2*y2./(pw1*y1+pw2*y2);figure(2);subplot(2,1,1);plot(X,P1);title('F身高后验概率分布曲线');subplot(2,1,2);plot(X,P2);title('M身高后验概率分布曲线');P11=pw1*y1;P22=pw2*y2;figure(3);subplot(3,1,1);plot(X,P11);subplot(3,1,2);plot(X,P22);subplot(3,1,3);plot(X,P11,X,P22);sample=textread('all ') %读入样本[result]=bayes(sample1(:,1),sample2(:,1),pw1,pw2);%bayes分类器function [result] =bayes(sample1(:,1),sample2(:,1),pw1,pw2); error1=0;error2=0;u1=mean(sample1(:,1));m1=std(sample1(:,1));y1=normpdf(X,u1,m1); %类条件概率分布u2=mean(sample2(:,1));m2=std(sample2(:,1));y2=normpdf(X,u2,m2); %类条件概率分布P1=pw1*y1./(pw1*y1+pw2*y2);P2=pw2*y2./(pw1*y1+pw2*y2);for i = 1:50if P1(i)>P2(i)result(i)=0;pe(i)=P2(i);elseresult(i)=1;pe(i)=P1(i);endendfor i=1:50if result(k)==0error1=error1+1;else result(k)=1error2=error2+1;endendratio = error1+error2/length(sample); %识别率,百分比形式sprintf('正确识别率为%.2f%%.',ratio)作业2 用身高/体重数据进行性别分类(二)基本要求:试验直接设计线性分类器的方法,与基于概率密度估计的贝叶斯分离器进行比较。

模式识别大作业(二)

模式识别大作业(二)————C-均值算法与模糊C 均值聚类的比较姓名:谭红光 学号:02125128 班级:021252一 原理:1.C 均值的原理:C 均值聚类算法是一种典型的无监督动态聚类算法。

该算法是在类别数目已知(=k )的条件下进行的,能够使聚类结果的距离平方和最小,即算法的基础是误差平方和准则。

其基本过程是建立初始的聚心和聚类,通过多次迭代,逐渐调整各类的聚心和各像元的类别,直至得到聚类准则约束下的最好结果为止。

本实验的具体过程如下:选择初始类别中心,假设有c 个类别,设置其中心分别为(1)(1)(1)12,,,c Z Z Z 在第k 步迭代中,对于任何一个像元x(是一个N 维向量,N 是高光谱图像的波段数目),按如下方法把它调整到。

各类别中的某一个类别中去。

令d(x ,y)为向量x ,y 之间的距离,若:()()(,)(,)k k i jd x Z d x Z <=, j = 1 2 … c (j i ≠) 则()k i x S∈,其中()k i S 是以()k iZ 为中心的类。

由上一步得到的()k iS(i =1 2…c )个类别新的中心(1)k i Z +()(1)1k i k ix S iZxN +∈=∑其中N i是类别()k iS 的数目。

(1)k i Z +是按照最小J 的原则,J 的表达式为:()(1)1(,)k i ck i i x S J d x Z +=∈=∑∑对所有的i =1 2…c 。

如果,(1)()k k i i Z Z +=,则迭代结束(在程序中,则按照每个类别的对应的那些像素不再变化,则停止迭代),否则转到第二步继续迭代。

2.模糊C 均值的原理在数字图像由于存在混合像素的原因,也就是说一个像素中不仅存在一类地物,因而采用硬分类方式往往不合适,而模糊C 均值就是引入模糊集对每个像素的划分概率不单单是用0或1这样的硬分类方式,而是0和1之间的范围内(包括0和1)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

华南理工大学《模式识别》大作业报告题目:模式识别导论实验学院计算机科学与工程专业计算机科学与技术(全英创新班)学生姓名黄炜杰学生学号201230590051指导教师吴斯课程编号145143课程学分2分起始日期2015年5月18日实验概述【实验目的及要求】Purpose:Develop classifiers,which take input features and predict the labels.Requirement:•Include explanations about why you choose the specific approaches.•If your classifier includes any parameter that can be adjusted,please report the effectiveness of the parameter on the final classification result.•In evaluating the results of your classifiers,please compute the precision and recall values of your classifier.•Partition the dataset into2folds and conduct a cross-validation procedure in measuring the performance.•Make sure to use figures and tables to summarize your results and clarify your presentation.【实验环境】Operating system:window8(64bit)IDE:Matlab R2012bProgramming language:Matlab实验内容【实验方案设计】Main steps for the project is:1.To make it more challenging,I select the larger dataset,Pedestrian,rather than the smaller one.But it may be not wise to learning on such a large dataset,so I normalize the dataset from0to1first and perform a k-means sampling to select the most representative samples.After that feature selection is done so as to decrease the amount of features.At last,a PCA dimension reduction is used to decrease the size of the dataset.2.Six learning algorithms including K-Nearest Neighbor,perception,decision tree, support vector machine,multi-layer perception and Naïve Bayesian are used to learn the pattern of the dataset.3.Six learning algorithm are combing into six multi-classifiers system individually, using bagging algorithm.实验过程:The input dataset is normalized to the range of[0,1]so that make it suitable for performing k-means clustering on it,and also increase the speed of learning algorithms.There are too much sample in the dataset,only a small part of them are enough to learn a good classifier.To select the most representative samples,k-means clustering is used to cluster the sample into c group and select r%of them.There are14596 samples initially,but1460may be enough,so r=10.The selection of c should follow three criterions:a)Less drop of accuracyb)Little change about ratio of two classesc)Smaller c,lower time complexitySo I design two experiments to find the best parameter c:Experiment1:Find out the training accuracy of different amount of cluster.The result is shown in the figure on the left.X-axis is amount of cluster and Y-axis is accuracy.Red line denotes accuracy before sampling and blue line denotes accuracy after sampling.As it’s shown in the figure,c=2,5,7,9,13may be good choice since they have relative higher accuracy.Experiment2:Find out the ratio of sample amount of two class.The result is shown in the figure on the right.X-axis is amount of cluster and Y-axis is the ratio.Red line denotes ratio before sampling and blue line denotes ratio after sampling.As it’s shown in the figure, c=2,5,9may be good choice since the ratio do not change so much.As a result,c=5is selected to satisfy the three criterions.3780features is much more than needed to train a classifier,so I select a small part of them before learning.The target is to select most discriminative features,that is to say,select features that have largest accuracy in each step.But there are six learning algorithm in our project,it’s hard to decide which learning algorithm this feature selection process should depend on and it may also has high time complexity.So relevance,which is the correlation between feature and class is used as a discrimination measurement to select the best feature sets.But only select the most relevant features may introduce rich redundancy.So a tradeoff between relevance and redundancy should be made.An experiment about how to make the best tradeoff is done:Experiment3:This experiment is a filter forward featureselection process.The target is to select thefeature has the maximum value of(relevance+λ*redundancy)in each step,where relevancedenotes the correlation between feature and class,and redundancy denotes mean of pairwise featurecorrelation.λis set from-1to1.The result isshown to the right:X-axis denotes number of selected features,Y-axis denotes accuracy.Each lines represent oneλ.It’s obviously that with a higherλ,the accuracyis lower,that is to say,with higher redundancy,the performance of the classifier is worse.So Iselectλ=-1,and the heuristic function becomes:max(relevance-redundancy)The heuristic function is known now but the best amount of features is still unknown and is found in experiment4:Experiment4:Find out the training accuracy of different amount of features.The result is shown below.X-axis is amount of features and Y-axis is accuracy.Red line denotes accuracy before feature selection and blue line denotes accuracy after feature selection.As it’s shown in the figure,when feature amount reach50,the accuracy trend to be stable.So only50features is selected.To make the dataset smaller,features with contribution rate of PCA≥85%is selected.So we finally obtain a dataset with1460samples and32features.The size of the dataset drops for92.16%but accuracy only has0.61%decease.So these preprocessing steps are successful to decrease the size of the dataset.6models are used in the learning steps:K-Nearest Neighbor,perception,decision tree,support vector machine,multi-layer perception and Naïve Bayesian.I designed a RBF classifier and MLP classifier at first but they are too slow for the reason that matrix manipulation hasn’t been designed carefully,so I use the function in the library instead.Parameter determination for these classifiers are:1K-NNWhen k≥5,the accuracy trends to be stable,so k=52Decision treeMaxcrit is used as binary splitting criterion.3MLP5units for hidden is enoughThe six learning algorithm can be combing into6multi-classifiers system individually to increase their accuracy.Most popular model are boosting and bagging:1BoostingEach classifier is dependent on previous one,and has their own weight. Misclassified samples have higher weight.Boosting always outperform bagging, but may cause the problem of overfitting.2BaggingEach classifier is independent and all sample are treated equally.Final result are vote by each classifier.More suitable for unstable classifier such as ANN(little change in input may cause large difference in learning result).I am interesting about will bagging truly help increasing accuracy of unstable classifier such as MLP and decision tree,and what about stable classifier like K-NN, Naïve Bayesian,Perception and SVM.There is also a question that how many classifier is need.Experiment5will show the answer:Experiment5:Six classifiers is investigated individually,accuracy under different amount of classifiers is shown in the figure below.Each figures stands for a certain kind of classifier.X-axis denotes amount of classifiers and Y-axis denotes the accuracy.Black line is for the highest accuracy for those accuracy,green for the worst,blue for the mean of them and red line is for bagging classifiers.We can learn from the figure that bagging dose help increasing the accuracy of each classifiers,and for the decision tree and MLP,bagging improve the accuracy for a great degree.Which is consistent with the assumption.。