通过RHEL 5实现软RAID及LVM

项目管理继续教育答案(1)

项目管理继续教育答案(1)智能建筑和IT运维1、运维管理的方式除完全客户管理或外包商管理外,还有?A 用户管理B 项目管理C 外包管理D 客户和外包商分别负责2、组织管理中建议成熟的组织形式为?A 项目型组织B 技术型组织C 服务或复合型组织D 梯队型组3、确保系统稳定性为什么重要,理由不包括?A 客户最关注B 工作出发点C 投入最大D 业务系统不能断4、系统稳定强调冗余备份和。

A 应急响应B 提前规划C 技术先进D 业务集中5、应用系统管理为什么需要通过需求管理尽量减少变更?A 可能产生风险影响系统稳定。

B 客户时间宝贵。

C 运维人员不够。

D 合同中不支持变更。

6、数据系统管理需要对哪项资源提出标准要求?A 应用系统B 硬件系统C 环境系统D 桌面系统7、数据系统管理为什么要考虑组件的兼容性?A 有效整合资源。

B 成套购买降低成本。

C 方便人员维护。

D 保证系统之间数据通信传输没有障碍。

8、数据系统管理的对象不包含?A 数据库B 计算机C 中间件D 操作系统9、人员管理中涉及需求管理的主要是?A 用户管理B 工程师管理C 客户管理D 项目经理管理10、人员管理中客户的定义是?A 负责运维服务提供和操作的人员。

B 使用服务的人员。

C 确保运维项目正常交付的人员。

D 负责服务评价、验收和付费的人员。

11、邀请用户参与运维过程的目的不包括?A 感知运维的实际情况。

B 提出改进的建议。

C 让用户承担责任。

D 与运维团队熟悉互动。

12、组织管理中建议成熟的组织形式为?A 项目型组织B 技术型组织C 服务或复合型组织D 梯队型组织13、组织管理的能力不包括?A 项目管理能力B 服务管理能力C 技术发展能力D 业务能力14、项目型组织管理的关键点不包括?A 与客户的沟通不重要。

B 项目间资源尽量复用。

C 项目规避关键人员单点风险。

D 项目管理能力要求高。

15、服务型组织的劣势体现在?A 沟通成本高,需要工具支持。

什么是LVM

什么是LVMLVM是逻辑盘卷管理(Logical Volume Manager)的简称,它是Linux环境下对磁盘分区进⾏管理的⼀种机制,LVM是建⽴在硬盘和分区之上的⼀个逻辑层,来提⾼磁盘分区管理的灵活性。

前⾯谈到,LVM是在磁盘分区和⽂件系统之间添加的⼀个逻辑层,来为⽂件系统屏蔽下层磁盘分区布局,提供⼀个抽象的盘卷,在盘卷上建⽴⽂件系统。

物理卷(physical volume)物理卷就是指硬盘分区或从逻辑上与磁盘分区具有同样功能的设备(如RAID),是LVM的基本存储逻辑块,但和基本的物理存储介质(如分区、磁盘等)⽐较,却包含有与LVM相关的管理参数。

Linux⽤户安装Linux操作系统时遇到的⼀个最常见的难以决定的问题就是如何正确地给评估各分区⼤⼩,以分配合适的硬盘空间。

⽽遇到出现某个分区空间耗尽时,解决的⽅法通常是使⽤符号链接,或者使⽤调整分区⼤⼩的⼯具(⽐如PatitionMagic等),但这都只是暂时解决办法,没有根本解决问题。

随着Linux的逻辑盘卷管理功能的出现,这些问题都迎刃⽽解,本⽂就深⼊讨论LVM技术,使得⽤户在⽆需停机的情况下⽅便地调整各个分区⼤⼩。

[url=][img][/img][/url] ⼀、前⾔ 每个Linux使⽤者在安装Linux时都会遇到这样的困境:在为系统分区时,如何精确评估和分配各个硬盘分区的容量,因为系统管理员不但要考虑到当前某个分区需要的容量,还要预见该分区以后可能需要的容量的最⼤值。

因为如果估计不准确,当遇到某个分区不够⽤时管理员可能甚⾄要备份整个系统、清除硬盘、重新对硬盘分区,然后恢复数据到新分区。

虽然现在有很多动态调整磁盘的⼯具可以使⽤,例如PartationMagic等等,但是它并不能完全解决问题,因为某个分区可能会再次被耗尽;另外⼀个⽅⾯这需要重新引导系统才能实现,对于很多关键的服务器,停机是不可接受的,⽽且对于添加新硬盘,希望⼀个能跨越多个硬盘驱动器的⽂件系统时,分区调整程序就不能解决问题。

RAID5软件磁盘冗余阵列配置详解

RAID5软件磁盘冗余阵列配置详解RAID是“Redundant Array of Independent Disk”的缩写,中文意思是独立冗余磁盘阵列。

冗余磁盘阵列技术诞生于1987年,由美国加州大学伯克利分校提出。

简单地解释,就是将N台硬盘通过RAID Controller(分Hardware,Software)结合成虚拟单台大容量的硬盘使用。

RAID的采用为存储系统(或者服务器的内置存储)带来巨大利益,其中提高传输速率和提供容错功能是最大的优点,raid主要有raid0,raid1,raid4,raid5等,5其实是在4的基础上发展起来的,4将奇偶校验写在同一个磁盘上,从而造成性能瓶颈,5则分散校验数据,提高性能,1则是单纯的镜像,要浪费50%的空间,0则是数据透写阵列中的所有磁盘,速度快,但不安全,综上所述:raid1最保险,但浪费空间,raid0性能最好,也不浪费空间,但是安全性差;raid5可以说中和了raid1和raid0的优点,但需要三块以上的磁盘,或者分区,磁盘的利用率为n-1,同时需要等大的分区。

下面来系统的介绍下在rhel5.4上配置raid5,这个配置步骤之前有记录过,不过很多细节的东西未记录,这在rhce中算重点内容,不能忽视的…1:通过fdisk工具将磁盘分成四个等大的分区,并转换成fd格式[root@yang ~]# fdisk -l |grep raid/dev/hda5 5178 5300 987966 fd Linux raid autodetect/dev/hda6 5301 5423 987966 fd Linux raid autodetect/dev/hda7 5424 5546 987966 fd Linux raid autodetect/dev/hda8 5547 5669 987966 fd Linux raid autodetect2:创建一个块设备,主要考虑到可能一个系统有多个raid阵列[root@yang ~]# mknod /dev/md1 b 9 1[root@yang ~]# ls -li /dev/md*5162 brw-r----- 1 root disk 9, 0 Mar 6 18:09 /dev/md010616 brw-r--r-- 1 root root 9, 1 Mar 6 18:19 /dev/md13:创建raid5阵列,-C代表create,-l代表level,-n代表阵列中的分区个数,-x用来指定sapre分区[root@yang ~]# mdadm -C /dev/md1 -l 5 -n 3 /dev/hda{5,6,7} -x 1 /dev/hda8 mdadm: array /dev/md1 started.在创建的过程中,可以使用watch命令来观察/proc/mdstat这个文件的变化[root@yang ~]# watch -n 1 "cat /proc/mdstat"Every 1.0s: cat /proc/mdstat Sat Mar 6 18:23:30 2010Personalities : [raid6] [raid5] [raid4]md1 : active raid5 hda7[4] hda8[3](S) hda6[1] hda5[0]1975680 blocks level 5, 64k chunk, algorithm 2 [3/2] [UU_][======>..............] recovery = 34.8% (344156/987840) finish=0.2min sp eed=49165K/secunused devices: <none>4:格式化分区[root@yang ~]# mkfs.ext3 /dev/md1………………………………………………………………………………………………This filesystem will be automatically checked every 34 mounts or180 days, whichever comes first. Use tune2fs -c or -i to override.[root@yang ~]# tune2fs -c 0 -i 0 -o acl /dev/md1 //默认格式化完分区后,系统会在分区被挂载34次,或者180天后进行自检,而且默认的格式化不带acl参数tune2fs 1.39 (29-May-2006)Setting maximal mount count to -1Setting interval between checks to 0 seconds5:挂载分区,并查看详细信息[root@yang ~]# mkdir /data[root@yang ~]# mount /dev/md1 /data/[root@yang ~]# df -h |grep data/dev/md1 1.9G 35M 1.8G 2% /data[root@yang ~]# mdadm --detail /dev/md1 |tail -n 50 3 5 0 active sync /dev/hda51 3 6 1 active sync /dev/hda62 3 7 2 active sync /dev/hda73 3 8 - spare /dev/hda86:查看/etc/rc.sysinit这个文件中关于mdadm的信息,这个文件是在系统启动读取的第四个文件,主要用于设定系统时间,主机名,键盘,selinux,lvm,raid等一系列重要的参数[root@yang ~]# grep 'mdadm' /etc/rc.sysinit //下面的Shell语句意思是当存在/etc/mdadm.conf这个文件的时候,就执行激活raid阵列操作;raid阵列信息是保存在64字节的分区表和各个分区的第一个扇区的512字节中的if [ -f /etc/mdadm.conf ]; then/sbin/mdadm -A -s7:生成mdadm.conf文件[root@yang ~]# mdadm --detail --scan > /etc/mdadm.conf[root@yang ~]# cat /etc/mdadm.confARRAY /dev/md1 level=raid5 num-devices=3 metadata=0.90 spares=1UUID=df904d25:12be50fb:cf70917a:e15d87d98:测试在存在mdadm.conf文件的时候,停止阵列后还可以得到重组,若不存在该文件,就要重新创建阵列了,可见该文件非常重要[root@yang ~]# umount /data/[root@yang ~]# mdadm -S /dev/md1mdadm: stopped /dev/md1[root@yang ~]# mdadm -A -smdadm: /dev/md1 has been started with 3 drives and 1 spare.9:模拟阵列中的一个分区故障[root@yang ~]# mdadm /dev/md1 -f /dev/hda5mdadm: set /dev/hda5 faulty in /dev/md1从下面的信息可以看到/dev/hda5的状态已经变成faulty了,但是原来的spare分区/dev/hda8迅速顶了上来,说明存在一个热备份的分区还是相当有必要的,不过这个空间也是要被浪费的[root@yang ~]# watch -n 1 "cat /proc/mdstat"Personalities : [raid6] [raid5] [raid4]md1 : active raid5 hda5[3](F) hda8[0] hda7[2] hda6[1]1975680 blocks level 5, 64k chunk, algorithm 2 [3/3] [UUU]unused devices:10:移除,添加分区到阵列[root@yang ~]# mdadm /dev/md1 -r /dev/hda5mdadm: hot removed /dev/hda5[root@yang ~]# mdadm /dev/md1 -a /dev/hda5mdadm: added /dev/hda511:下面重点演示下当阵列出现故障的时候,系统自动发邮件报警的设定[root@yang ~]# mail -s "just a test for my rhel mail server" ylw6006@[root@yang ~]# cat /etc/mdadm.confARRAY /dev/md1 level=raid5 num-devices=3 metadata=0.90 spares=1UUID=df904d25:12be50fb:cf70917a:e15d87d9MAILADDR ylw6006@ //在文件末尾添加这行[root@yang ~]# service mdmonitor status //启动mdmonitor服务,并确保其开机自启动mdadm is stopped[root@yang ~]# service mdmonitor startStarting mdmonitor: [ OK ][root@yang ~]# chkconfig mdmonitor on[root@yang ~]# mdadm /dev/md1 -f /dev/hda5 //模拟阵列中的两块磁盘故障mdadm: set /dev/hda5 faulty in /dev/md1[root@yang ~]# mdadm /dev/md1 -f /dev/hda6mdadm: set /dev/hda6 faulty in /dev/md1[root@yang data]# dd if=/dev/zero of=1.txt bs=1k //分区的I/0马上就会出现故障dd: writing `1.txt': Read-only file system158922+0 records in158921+0 records out162735104 bytes (163 MB) copied, 14.6255 seconds, 11.1 MB/s[root@yang data]# llls: reading directory .: Input/output errortotal 0在定义的邮箱中就会收到报警邮件,要修复类似的故障,只能先停掉阵列,然后重新新建阵列了,格式化分区了,原来的数据就没有了!。

不用软驱,在CentOS linux上也能安装RAID驱动程序

自上次RAID安装失败后,我另外购买了一块adapter sata raid 2410sa 卡,准备测试四块机器安装RAID5.环境如下:主板:Inter Server S5000VSACPU:xeon 四核5405*2内存:16G硬盘:4块西部数据500GSATARAID: 主板自带RAID0系统:Centos5.3 64位遗憾的是,这次RAID5还是没有达成,原因是官方没有提供centos5 64位的驱动,只是实现了RAID0.不过,倒是掌握了不用软驱,也能安装RAID驱动程序的办法,想想前几天还专门购买了一个软驱,真是亏啊。

办法很简单,上次其实提到过,如下:1) 创建RAID,这一步,我就不讲相信大家都会。

2) 启动Centos安装,并且将驱动程序复制到你的移动硬盘里(注意最好是第一盘符),直接IMG文件就可以了。

3) 在安装的第一个界面,输入linux nostorage4) 进入安装过程中,一直看到“Add device” 按钮.5) 点击“Add Device”,出现一系列的驱动6) 按F2,就跳出选择软盘,或者移动硬盘7) 我们选择移动硬盘,找到驱动程序文件,一般是IMG文件,选中后再点OK按钮。

8 ) 这时会回到刚才看到的驱动程序列表界面9) 选中刚才加进来的驱动,建议大家记住自己的驱动型号,厂商等信息,以便快速定位。

11) 点击OK12) 驱动程序就被加载,并出现在新增加设置列里13) 点击Done14) 继续安装,完成了。

这次还测试了intel S5000VSA自带的RAID安装RAID10,发现就算安装了驱动,能够顺利安装完,但是重新启动就会有问题,与上次一样,attempt to access beyond end of devicesda: rw=0, want=1953278938, limit=976773168Buffer I/O error on device sda2, logical block 1952877312attempt to access beyond end of devicesda: rw=0, want=1953278939, limit=976773168Buffer I/O error on device sda2, logical block 1952877313attempt to access beyond end of devicesda: rw=0, want=1953278940, limit=976773168Buffer I/O error on device sda2, logical block 1952877314attempt to access beyond end of devicesda: rw=0, want=1953278941, limit=976773168Buffer I/O error on device sda2, logical block 1952877315attempt to access beyond end of devicesda: rw=0, want=1953278942, limit=976773168Buffer I/O error on device sda2, logical block 1952877316attempt to access beyond end of devicesda: rw=0, want=1953278943, limit=976773168Buffer I/O error on device sda2, logical block 1952877317attempt to access beyond end of devicesda: rw=0, want=1953278944, limit=976773168Buffer I/O error on device sda2, logical block 1952877318attempt to access beyond end of devicesda: rw=0, want=1953278945, limit=976773168Buffer I/O error on device sda2, logical block 1952877319attempt to access beyond end of devicesda: rw=0, want=1953278938, limit=976773168Buffer I/O error on device sda2, logical block 1952877312由此,我判断是自带的RAID不支持,4块500G硬盘构成的将近1T的容量,其实还是觉得奇怪,可事实如此,哎.除非这块主板有问题。

习题集

第1章1.下面(B )方式可以查看“cp”命令的帮助。

A:cp -? B:cp -hC:cp -a D:cp --h2.在vi 中从“可视模式”切换到“命令模式”使用( B)。

A:: B:ESCC:Ctrl+L D:Ctrl+Q3.下面(D )是“ssh”命令正确的使用方法。

A:ssh -l 192.168.159.159 B:ssh -o 192.168.159.159 C:ssh -a 192.168.159.159 D:ssh 192.168.159.159 4.关于“mkdir -p /fringe/oliva”命令说法正确的是(C )。

A:“-p”是该命令的参数B:该命令没有使用选项C:“-p”是该命令的选项D:该命令没有使用参数5.使用( A)可以使当前行出现上一行的最后一组参数。

A:Ctrl+K B:ESC+.C:Ctrl+L D:ESC+>6.下列不属于Linux 桌面环境的是(AB )。

A:Fluxbox B:JDKC:GNOME D:KDE7.下列关于Linux 桌面环境说法正确的是(D )。

A:在虚拟终端可以使用Ctrl+F1可以回到Linux桌面环境B:一个系统中只可以安装一种Linux桌面环境C:Linux桌面环境是Linux运行不可缺少的内容D:Linux桌面环境不是Linux运行不可缺少的内容8.在vim 中使用( D)可以保存并退出当前编辑的文件。

A::w B::q!C::q D::wq9.使用(D )可以清除屏幕所有内容。

A:ESC B:ESC+CC:Ctrl+U D:Ctrl+L10.下列关于telnet 服务说法正确的是( D)。

A:在RHEL5中默认就安装了telnet 服务B:telnet 服务在数据传输过程中会对数据进行加密C:telnet 服务只能在Linux 系统之间使用D:telnet 服务在数据传输过程中不会对数据进行加密第2章1.下面()命令可以分屏显示“/var/log/message”的内容。

Linux命令高级技巧使用mdadm管理软件RAID

Linux命令高级技巧使用mdadm管理软件RAIDRAID(冗余磁盘阵列)是一种数据存储技术,通过将多个磁盘组合在一起,提供数据冗余和性能增强。

在Linux系统中,我们可以使用mdadm(多磁盘和设备管理器)命令来管理软件RAID。

本文将介绍一些高级技巧,帮助您更好地使用mdadm来管理软件RAID。

1. 安装mdadm在开始之前,您需要确保系统中已经安装了mdadm。

如果尚未安装,可以使用以下命令进行安装:```sudo apt-get install mdadm```2. 创建软件RAID使用mdadm命令可以创建各种类型的软件RAID,包括RAID 0、RAID 1、RAID 5和RAID 6等。

以下是创建RAID 1(镜像)的示例:```sudo mdadm --create /dev/md0 --level=1 --raid-devices=2 /dev/sdb1/dev/sdc1```上述命令将创建一个名为/md0的RAID设备,使用/dev/sdb1和/dev/sdc1两个磁盘进行镜像。

3. 添加和移除磁盘在创建RAID后,您可以随时添加或移除磁盘。

以下是添加磁盘的示例:```sudo mdadm --add /dev/md0 /dev/sdd1```上述命令将磁盘/dev/sdd1添加到RAID设备/md0中。

如果需要移除磁盘,可以使用以下命令:```sudo mdadm --fail /dev/md0 /dev/sdd1sudo mdadm --remove /dev/md0 /dev/sdd1```第一条命令将磁盘标记为失败状态,第二条命令将其从RAID设备中移除。

4. 磁盘替换当一个磁盘故障时,您需要将其替换为新的磁盘。

以下是磁盘替换的示例:sudo mdadm --remove /dev/md0 /dev/sdd1sudo mdadm --add /dev/md0 /dev/sde1```上述命令将故障的磁盘/dev/sdd1从RAID设备/md0中移除,并将新磁盘/dev/sde1添加到RAID设备中。

在RHEL5.0中用YUM解决RPM包的依赖关系

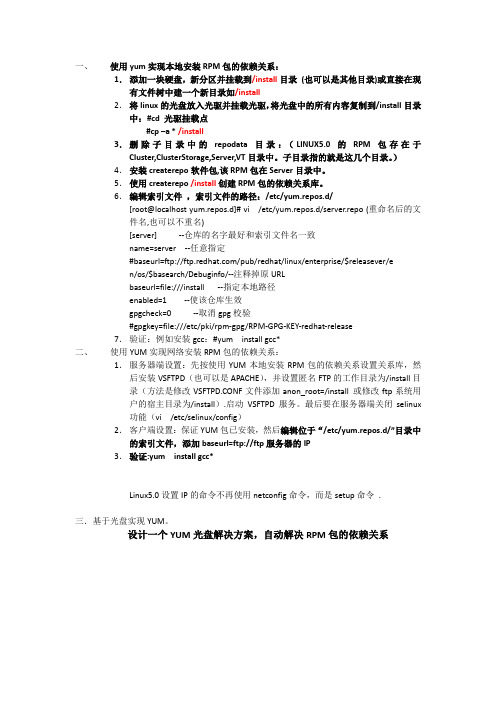

一、使用yum实现本地安装RPM包的依赖关系:1.添加一块硬盘,新分区并挂载到/install目录(也可以是其他目录)或直接在现有文件树中建一个新目录如/install2.将linux的光盘放入光驱并挂载光驱,将光盘中的所有内容复制到/install目录中:#cd 光驱挂载点#cp –a * /install3.删除子目录中的repodata目录:(LINUX5.0的RPM包存在于Cluster,ClusterStorage,Server,VT目录中。

子目录指的就是这几个目录。

)4.安装createrepo软件包,该RPM包在Server目录中。

5.使用createrepo /install创建RPM包的依赖关系库。

6.编辑索引文件,索引文件的路径:/etc/yum.repos.d/[root@localhost yum.repos.d]# vi /etc/yum.repos.d/server.repo (重命名后的文件名,也可以不重名)[server] --仓库的名字最好和索引文件名一致name=server --任意指定#baseurl=ftp:///pub/redhat/linux/enterprise/$releasever/en/os/$basearch/Debuginfo/--注释掉原URLbaseurl=file:///install --指定本地路径enabled=1 --使该仓库生效gpgcheck=0 --取消gpg校验#gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release7.验证:例如安装gcc:#yum install gcc*二、使用YUM实现网络安装RPM包的依赖关系:1.服务器端设置:先按使用YUM本地安装RPM包的依赖关系设置关系库,然后安装VSFTPD(也可以是APACHE),并设置匿名FTP的工作目录为/install目录(方法是修改VSFTPD.CONF文件添加anon_root=/install 或修改ftp系统用户的宿主目录为/install).启动VSFTPD服务。

RHEL5.4下创建LVM

RHEL5.4下创建LVM关于linux下面LVM逻辑卷的创建的讨论,逻辑卷的介绍LVM就是logical volume manager(逻辑卷的管理)LVM就是可以随意拉升和缩小,SCSI的硬盘最多只能够分15个区,如果需要更多的分区,怎么办呢,如果分区在规划的时候分小了或者大了,怎么办呢,而LVM很好的就解决了这些问题。

下面开始进行LVM逻辑卷创建的讨论从上面这个图可以看到,创建逻辑卷的步骤:Linux分区----------物理卷-----------卷组-----------逻辑卷这个就是创建逻辑卷的顺序,下面就按照这个顺序来创建逻辑卷。

1.创建linux分区(物理分区)首先创建三个分区[root@localhost ~]# fdisk /dev/sdaThe number of cylinders for this disk is set to 1958.There is nothing wrong with that, but this is larger than 1024,and could in certain setups cause problems with:1) software that runs at boot time (e.g., old versions of LILO)2) booting and partitioning software from other OSs(e.g., DOS FDISK, OS/2 FDISK)Command (m for help): nFirst cylinder (1316-1958, default 1316):Using default value 1316Last cylinder or +size or +sizeM or +sizeK (1316-1958, default 1958): +200M Command (m for help): nFirst cylinder (1341-1958, default 1341):Using default value 1341Last cylinder or +size or +sizeM or +sizeK (1341-1958, default 1958): +200M Command (m for help): nFirst cylinder (1366-1958, default 1366):Using default value 1366Last cylinder or +size or +sizeM or +sizeK (1366-1958, default 1958): +200M Command (m for help):然后在分区的主界面按“t”来转换分区的类型,LVM的id为8e这些分区的类型的id号,我们在分区的主界面按“l”都是可以看到的。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

通过RHEL 5实现软RAID及LVM - [Linux service]版权声明:转载时请以超链接形式标明文章原始出处和作者信息及本声明/logs/34006500.html文章出于:IT168RAID是Redundant Array of Inexpensive Disk的缩写,意为廉价冗余磁盘阵列,是磁盘阵列在技术上实现的理论标准,其目的在于减少错误、提高存储系统的性能与可靠度。

常用的等级有0、1、5级等。

◆RAID 0RAID 0将数据分条,存储到多个磁盘中,不带任何冗余信息。

数据被分割成块,继续分布到磁盘中。

这一级别也被认为是纯粹的数据分条。

创建RAID 0 需要一个或多个磁盘。

也就是说,单独的一个磁盘可以被认为是一个RAID 0 阵列。

不幸的是,数据分条降低了数据的可用性,如果一个磁盘发生错误,整个阵列将会瘫痪。

优点:易于实现、无容量损失-所有的存储空间都可用缺点:无容错能力、一个磁盘出错导致损失所有阵列内的数据◆RAID 1RAID 1适合性能要求较高又需要容错功能的阵列。

另外,RAID 1是在只有少于2个磁盘的环境下支持容错功能的唯一选择。

RAID 1至少要有两个(只能两个)硬盘才能组成,因此也称为镜像(Mirroring)方式。

所谓镜像就是每两个硬盘的内容一模一样,但是对操作系统而言只呈现一个硬盘,以便于管理。

由此可见,RAID 1对数据进行了完全的备份,其可靠性是最高的。

当然,其数据的写入时间可能会稍长一点,但因为两个镜象硬盘可以同时读取数据,故读数据与RAID 0一样。

磁盘阵列的总容量为其中N/2块硬盘的容量在RAID 级别中,RAID 1通过数据镜像提供了最高的信息可用性。

另外,如果阵列支持数据和镜像的同时读取,读取信息的性能将会提高。

优点:读取性能较单磁盘高缺点:需要2倍的存储空间◆RAID 5RAID 5 是在多用户,对数据写入的性能要求不高的环境下的最好选择。

然而,它要求至少3个磁盘来执行。

RAID 5是将数据分条,奇偶校验产生冗余。

但是,它不采用一个固定的硬盘来存储奇偶校验值,所有数据和校验值都分布在所有硬盘上。

◆优点:最高的信息处理读取率、经济实用-只需要一个额外的磁盘◆缺点:单独信息块的传送和单磁盘时相同、需要特定的硬件下面将以讲述在RHEL 5中创建RAID 1为例子。

◆将分区标识为RAID分区,在创建软RAID这步是必须的,如果没执行在系统重启后,RAID 设备可能会无法工作。

◆建立RAID设备及定义RAID盘1:创建一个RAID设备,在RHEL 5中RAID设备必须从md0开始依次增加。

2:同意创建设备,如不加此参数时必须先使用mknod /dev/md1 b 9 0命令来创建一个RAID 设备,不过推荐使用-a yes参数一次性创建。

3:RAID级别,此处定义的是RAID 1。

4:使用几个分区实现RAID。

5:热备分区的个数。

当定义一些具有容错功能的RAID级别(RAID1、RAID5)时,可多定义一块或热备分区,这样当RAID阵列中有1块硬盘损坏时,这个热备分区会自动补上去开始工作。

6:加入RAID的分区。

◆查看RAID定义情况1:查看指定RAID设备2:活动的二个RAID 1分区3:热备盘◆格式化RAID设备◆让RAID设备在每次重启都生效该方法会将系统中所有的RAID设备的定义导入/etc/mdadm.conf中,而该文件是记录系统所有RAID设备,以便下次启动时生效。

◆挂载RAID设备可临时使用mount命令挂载,也可定义在/etc/fstab中。

◆测试容错,用以下命令模拟阵列中一块硬盘损坏。

模拟阵列中一块硬盘损坏的方法在实际工作中并没有多大意义,只是用于测试。

◆查看热备盘是否自动开始工作1:在该阵列刚建立时,/dev/sda7、/dev/sda8是活动状态,/dev/sda9是热备分区,在上步骤中模拟将/dev/sda7损坏,这时/dev/sda7状态已是失败,而热备盘/dev/sda9自动开始工作。

◆移除损坏的/dev/sda71:将/dev/sda7从/dev/md0阵列中移除2:在阵列中已没有/dev/sda7◆添加一个新的分区作为热备分区1:将/dev/sda10加入/dev/md0阵列中2:/dev/sda10自动成为/dev/md0热备分区在RHEL 5中创建RAID 0及RAID 5的方法与创建RAID 1的方法基本一致。

当然由于RAID 0自身没有容错功能,添加热备分区是没有意义,所在不需要使用-x参数。

此外,在RHEL 5中实现软RAID时还提供了RAID6 ,即带有两种分布存储的奇偶校验码的独立磁盘结构,它是对RAID5的扩展,主要是用于要求数据绝对不能出错的场合,使用了二种奇偶校验值,所以需要N+2个磁盘,同时对控制器的设计变得十分复杂,写入速度也不好,用于计算奇偶校验值和验证数据正确性所花费的时间比较多,造成了不必要的负载,很少人用。

RHEL 5中使用软RAID可实现容错或加快数据读写速度的功能,但无法在不丢失分区数据的前题下增大分区。

想解决这个问题我们就需要使用LVM了。

LVM是Logical Volume Manager的缩写。

配置LVM首先要将普通分区转换为物理卷,再通过物理卷创建逻辑卷组,最后在逻辑卷组中创建逻辑卷。

在实现时即可使用普通分区,也可以在软RAID的基础上创建。

下面将讲述在普通分区及RAID 5分区创建一个LVM。

◆在普通分区上实现LVM◆使用fdisk将物理硬盘支持LVM,在普通分区上实现LVM时这步是必须的。

◆将物理硬盘转换为物理卷,在转换后可通过“pvdisplay”命令查看物理卷情况。

◆将物理卷加入到一个新的逻辑卷组中(vg0),逻辑卷组的名称可根据需要命名。

在创建逻辑卷组后,可通过“vgdisplay 逻辑卷组名”命令查看逻辑卷组情况。

1:VG为逻辑卷组的大小,PE为逻辑卷组最小存储单位,VG Size=PE Size*Total PE。

由于一个我没想明白的原因在不同的情况中创建逻辑卷组时,PE的大小是不一样,比如在安装RHEL 5过程中创建时PE默认为32MB,而在安装好系统后创建时PE默认为4MB。

当然可以在使用“vgcreate”创建逻辑卷组时通过-s参数指定PE大小。

◆在逻辑卷组中建立逻辑卷。

1:-L指定大小,-n指定该逻辑卷的名称◆通过增加一个新的分区到该逻辑卷组,以实现在不丢失数据的情况增加逻辑卷的功能。

1:将/dev/sda14转换为物理卷2:将物理卷/dev/sda14加入到现有的逻辑卷组vg0中3:查看逻辑卷组vg0空间已增大◆增加逻辑卷/dev/vg0/lvm1的空间100M,未格式化的逻辑卷无法扩展。

1、2:要通过这二步才空间真正加到逻辑郑lvm1上。

3:/dev/vg0/lvm1的空间已增大100M◆挂载逻辑卷,可临时使用mount命令挂载,也可定义在/etc/fstab中。

◆在RAID 5分区上实现LVM将/dev/sda{7,8,9,10}、/dev/sda{11,12,13,14}配置为二个RAID 5,然后用这二个RAID 5建立LVM。

◆建立二个RAID 5阵列mdadm -C /dev/md0 -a yes -n 3 -x 1 -l 5 /dev/sda{7,8,9,10}mdadm -C /dev/md1 -a yes -n 3 -x 1 -l 5 /dev/sda{11,12,13,14}◆让RAID阵列永久有效◆将/dev/md0及/dev/md1转换为物理卷◆新建一个逻辑卷组,并将/dev/md0、/dev/md1加入◆在逻辑卷组vg1建立逻辑分区,并格式化◆挂载逻辑卷,可临时使用mount命令挂载,也可定义在/etc/fstab中。

版权声明:原创作品,允许转载,转载时请务必以超链接形式标明文章原始出处、作者信息和本声明。

否则将追究法律责任。

/227050/133068实验目的:理解LVM(逻辑卷管理器),添加、删除和调整LVM大小。

实验环境:操作系统:RedHat Enterprise Linux 5 (RHEL5)相关软件:lvm2-2.02.16-3.el5实验步骤:注:在RHCE_LAB(6)中我们建立了3个PV分别是“/dev/hda5 /dev/hda6 /dev/hd a7 ”(RHCE_LAB(6)的内容参见[url]/227050/133041 [/url])1. 增大LVM为VG添加新的PV使其增加容量[root@linux tmp]# vgextend vg1/dev/hda7Volume group "vg1" successfully extended显示VG信息[root@linux tmp]# vgdisplay--- Volume group ---VG Name vg1System IDFormat lvm2Metadata Areas 3Metadata Sequence No 8VG Access read/writeVG Status resizableMAX LV 0Cur LV 1Open LV 1Max PV 0Cur PV 3Act PV 3VG Size 252.00 MBPE Size 4.00 MBTotal PE 63Alloc PE / Size 45 / 180.00 MBFree PE / Size 18 / 72.00 MBVG UUID GOysUz-Fyeu-ttE0-R3UE-ra3Z-s1dM-l4QZ7n为LV增加容量[root@linux tmp]# lvextend -L +50M/dev/vg1/l v1Rounding up size to full physical extent 52.00 MBExtending logical volume lv1 to 252.00 MBLogical volume lv1 successfully resized显示LV信息[root@linux tmp]# lvdisplay /dev/vg1/lv1--- Logical volume ---LV Name /dev/vg1/lv1VG Name vg1LV UUID PkCxki-KweE-AcpE-r1KO-cguR-mxUm-xvPP0nLV Write Access read/writeLV Status available# open 1LV Size 252.00 MBCurrent LE 63Segments 3Allocation inheritRead ahead sectors 0Block device 253:3在线格式化新加的LV,让其可以正常使用[root@linux tmp]# resize2fs /dev/vg1/lv1resize2fs 1.39 (29-May-2006)Filesystem at /dev/vg1/lv1 is mounted on /tmp/lvm; on-line resizing requi redPerforming an on-line resize of /dev/vg1/lv1 to 258048 (1k) blocks.The filesystem on /dev/vg1/lv1 is now 258048 blocks long.查看挂载点的信息[root@linux tmp]#df -h/tmp/lvm/Filesystem Size Used Avail Use% Mounted on/dev/mapper/vg1-lv1 244M 6.1M 226M 3% /tmp/lvm2. 减小LV容量释放LV容量150M[root@linux tmp]# reduce -L -150M/dev/vg1/lv1Rounding up size to full physical extent 148.00 MBWARNING: Reducing active and open logical volume to 104.00 MB THIS MAY DESTROY YOUR DATA (filesystem etc.)Do you really want to reduce lv1? [y/n]: yReducing logical volume lv1 to 104.00 MBLogical volume lv1 successfully resized查看LV信息[root@linux tmp]# lvdisplay /dev/vg1/lv1--- Logical volume ---LV Name /dev/vg1/lv1VG Name vg1LV UUID PkCxki-KweE-AcpE-r1KO-cguR-mxUm-xvPP0n LV Write Access read/writeLV Status available# open 1LV Size 104.00 MBCurrent LE 26Segments 2Allocation inheritRead ahead sectors 0Block device 253:3删除VG中的容量100M的分区“/dev/hda6”[root@linux tmp]# vgreduce vg1/dev/hda6Removed "/dev/hda6" from volume group "vg1"显示VG信息[root@linux tmp]# vgdisplay vg1--- Volume group ---VG Name vg1System IDFormat lvm2Metadata Areas 2Metadata Sequence No 17VG Access read/writeVG Status resizableMAX LV 0Cur LV 1Open LV 1Max PV 0Cur PV 2Act PV 2VG Size 152.00 MBPE Size 4.00 MBTotal PE 38Alloc PE / Size 24 / 96.00 MBFree PE / Size 14 / 56.00 MBVG UUID GOysUz-Fyeu-ttE0-R3UE-ra3Z-s1dM-l4QZ7n 删除PV“/dev/hda6”[root@linux tmp]# pvremove /dev/hda6Labels on physical volume "/dev/hda6" successfully wiped显示PV信息[root@linux tmp]# pvdisplay--- Physical volume ---PV Name /dev/hda5VG Name vg1PV Size 101.94 MB / not usable 1.94 MBAllocatable yesPE Size (KByte) 4096Total PE 25Free PE 1Allocated PE 24PV UUID jSaI8a-D2B3-5HSA-LkPT-hQ1v-gut6-yY10t6--- Physical volume ---PV Name /dev/hda7VG Name vg1PV Size 54.88 MB / not usable 2.88 MBAllocatable yesPE Size (KByte) 4096Total PE 13Free PE 13Allocated PE 0PV UUID KLBWkX-l694-Yagy-BdHf-RkJ2-2NIC-ltGty03. 删除所有的LVM取消挂载的分区[root@linux tmp]# umount /tmp/lvm/删除LV[root@linux tmp]# lvremove /dev/vg1/lv1Do you really want to remove active logical volume "lv1"? [y/n]: y Logical volume "lv1" successfully removed删除VG[root@linux tmp]# vgremove vg1Volume group "vg1" successfully removed删除PV[root@linux tmp]# pvremove /dev/hda5 /dev/hda7Labels on physical volume "/dev/hda5" successfully wipedLabels on physical volume "/dev/hda7" successfully wiped删除物理分区的方法是使用“fdisk”命令[root@linux tmp]# fdisk /dev/hda纤细信息显示如下Command (m for help): dPartition number (1-7): 7Command (m for help): dPartition number (1-6): 6Command (m for help): dPartition number (1-5): 5Command (m for help): pDisk /dev/hda: 80.0 GB, 80026361856 bytes255 heads, 63 sectors/track, 9729 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/hda1 * 1 16 128488+ 83 Linux/dev/hda2 17 7665 61440592+ 8e Linux LVM/dev/hda3 7666 7796 1052257+ 82 Linux swap / Solaris /dev/hda4 7797 9729 15526822+ 5 Extended Command (m for help):实验总结:LVM的建立和删除,增加容量和容量减小是一个互逆的过程。