决策树实验指导书-R

R语言-决策树算法知识讲解

R语言-决策树算法决策树算法决策树定义首先,我们来谈谈什么是决策树。

我们还是以鸢尾花为例子来说明这个问题。

观察上图,我们判决鸢尾花的思考过程可以这么来描述:花瓣的长度小于2.4cm的是setosa(图中绿色的分类),长度大于1cm的呢?我们通过宽度来判别,宽度小于1.8cm的是versicolor(图中红色的分类),其余的就是virginica(图中黑色的分类)我们用图形来形象的展示我们的思考过程便得到了这么一棵决策树:这种从数据产生决策树的机器学习技术叫做决策树学习, 通俗点说就是决策树,说白了,这是一种依托于分类、训练上的预测树,根据已知预测、归类未来。

前面我们介绍的k-近邻算法也可以完成很多分类任务,但是他的缺点就是含义不清,说不清数据的内在逻辑,而决策树则很好地解决了这个问题,他十分好理解。

从存储的角度来说,决策树解放了存储训练集的空间,毕竟与一棵树的存储空间相比,训练集的存储需求空间太大了。

决策树的构建一、KD3的想法与实现下面我们就要来解决一个很重要的问题:如何构造一棵决策树?这涉及十分有趣的细节。

先说说构造的基本步骤,一般来说,决策树的构造主要由两个阶段组成:第一阶段,生成树阶段。

选取部分受训数据建立决策树,决策树是按广度优先建立直到每个叶节点包括相同的类标记为止。

第二阶段,决策树修剪阶段。

用剩余数据检验决策树,如果所建立的决策树不能正确回答所研究的问题,我们要对决策树进行修剪直到建立一棵正确的决策树。

这样在决策树每个内部节点处进行属性值的比较,在叶节点得到结论。

从根节点到叶节点的一条路径就对应着一条规则,整棵决策树就对应着一组表达式规则。

问题:我们如何确定起决定作用的划分变量。

我还是用鸢尾花的例子来说这个问题思考的必要性。

使用不同的思考方式,我们不难发现下面的决策树也是可以把鸢尾花分成3类的。

为了找到决定性特征,划分出最佳结果,我们必须认真评估每个特征。

通常划分的办法为信息增益和基尼不纯指数,对应的算法为C4.5和CART。

r语言决策树代码

r语言决策树代码使用R语言进行决策树分析决策树是一种常用的机器学习算法,用于解决分类和回归问题。

在R语言中,我们可以使用多种包来构建和分析决策树模型,如rpart、party和randomForest等。

一、加载数据我们需要加载数据集,用于构建决策树模型。

假设我们有一个名为“iris”的数据集,它包含了鸢尾花的萼片和花瓣的长度和宽度等特征,以及它们所属的不同种类。

我们可以使用如下代码加载该数据集:```Rdata(iris)```二、数据预处理在构建决策树之前,我们通常需要对数据进行一些预处理。

其中,最常见的任务是将数据集划分为训练集和测试集,用于模型的训练和评估。

我们可以使用如下代码将数据集划分为训练集和测试集:```Rset.seed(123)train_indices <- sample(1:nrow(iris), nrow(iris) * 0.7)train_data <- iris[train_indices, ]test_data <- iris[-train_indices, ]```三、构建决策树模型在R语言中,我们可以使用rpart包来构建决策树模型。

rpart包提供了一个函数rpart(),它可以根据输入的数据和参数构建决策树模型。

下面是一个简单的示例代码:```Rlibrary(rpart)model <- rpart(Species ~ ., data = train_data)```在上述代码中,我们使用了“Species”作为目标变量,表示鸢尾花的种类。

而“~ .”表示使用除目标变量外的所有其他变量作为自变量。

rpart()函数会根据输入的数据和参数构建决策树模型,并将结果保存在model变量中。

四、可视化决策树模型一旦我们构建了决策树模型,我们通常希望能够可视化该模型,以便更好地理解和解释模型的结果。

在R语言中,我们可以使用rpart.plot包来可视化决策树模型。

数据挖掘决策树r语言

数据挖掘决策树r语言数据挖掘决策树是一种常用的机器学习算法,它能够从数据集中提取出有用的规律,帮助我们做出更好的决策。

在这篇文章中,我们将介绍如何使用R语言来构建决策树,并通过一个实例来演示其应用。

我们需要准备好数据集。

在这个例子中,我们将使用一个虚构的数据集,其中包含了一些人的个人信息和他们是否购买了某个产品的记录。

我们可以使用下面的代码来导入数据集:```rdata <- read.csv("data.csv",header=TRUE)```接下来,我们需要对数据集进行一些预处理。

首先,我们需要将一些非数值型的属性转换成数值型,这样才能在决策树中使用。

例如,性别属性通常可以转换成0/1表示男女。

我们还需要处理一些缺失值,通常使用均值或中位数进行填充。

我们可以使用下面的代码来进行预处理:```rdata$Sex <- ifelse(data$Sex == "Male", 0, 1) # 将性别转换为0/1data$Age[is.na(data$Age)] <- median(data$Age, na.rm=TRUE)# 使用中位数填充缺失值```接下来,我们可以开始构建决策树了。

在R语言中,我们可以使用rpart包来构建决策树。

这个包提供了一个rpart函数,它可以根据指定的属性和目标属性来生成决策树。

例如,我们可以使用下面的代码来生成一个决策树:```rlibrary(rpart)tree <- rpart(Bought ~ Sex + Age + Income, data=data, method="class")```这里,我们使用Bought作为目标属性,Sex、Age和Income作为属性。

method参数指定了我们要使用分类方法来构建决策树。

生成的决策树可以使用plot函数来可视化:```rplot(tree)```生成的决策树可以帮助我们理解属性之间的关系,以及如何根据属性来预测目标属性。

实验二决策树实验实验报告

实验二决策树实验实验报告

一、实验目的

本实验旨在通过实际操作,加深对决策树算法的理解,并掌握

决策树的基本原理、构建过程以及应用场景。

二、实验原理

决策树是一种常用的机器学习算法,主要用于分类和回归问题。

其基本原理是将问题划分为不同的决策节点和叶节点,通过一系列

的特征测试来进行决策。

决策树的构建过程包括特征选择、划分准

则和剪枝等步骤。

三、实验步骤

1. 数据收集:从开放数据集或自有数据中选择一个适当的数据集,用于构建决策树模型。

2. 数据预处理:对收集到的数据进行缺失值处理、异常值处理

以及特征选择等预处理操作,以提高模型的准确性和可靠性。

3. 特征选择:采用合适的特征选择算法,从所有特征中选择对

分类或回归任务最重要的特征。

4. 构建决策树模型:根据选定的特征选择算法,以及划分准则(如信息增益或基尼系数)进行决策树模型的构建。

5. 模型评估:使用交叉验证等方法对构建的决策树模型进行评估,包括准确率、召回率、F1-score等指标。

6. 模型调优:根据评估结果,对决策树模型进行调优,如调整模型参数、采用剪枝技术等方法。

7. 模型应用:将得到的最优决策树模型应用于实际问题中,进行预测和决策。

四、实验结果及分析

在本次实验中,我们选择了某电商网站的用户购买记录作为数据集,利用决策树算法构建用户购买意愿的预测模型。

经过数据预处理和特征选择,选取了用户地理位置、年龄、性别和购买历史等特征作为输入。

利用信息增益作为划分准则,构建了一棵决策树模型。

R中决策树的实现

一、R包中决策树的函数(1)ID3算法在R中我们使用rpart包中的rpart()函数实现树回归,应该使用的是ID3算法吧。

先把该包中两个十分重要的函数介绍如下:rpart(formula, data, weights, subset,na.action = na.rpart, method,model = FALSE, x = FALSE, y = TRUE, parms, control, cost, ...)主要参数说明:formula回归方程形式,例如y~x1+x2+x3.data是数据,即包含前面formula中变量的数据框。

na.action是缺失数据的处理办法,默认办法为删除因变量缺失的观测,而保留自变量缺失的观测。

method根据树末端的数据类型选择相应变量分割方法,本参数有四种取值:连续型“anova”;离散型“class”;计数型(泊松过程)“poisson”;生存分析型“exp”。

程序会根据因变量的类型自动选择方法,但一般情况下最好还是指明本参数,以便让程序清楚做哪一种树模型parms用来设置三个参数:先验概率、损失矩阵、分类纯度的度量方法。

control控制每个节点上的最小样本量、交叉验证的次数、复杂性参量:即cp:complexitypamemeter,这个参数意味着对每一步拆分,模型的拟合优度必须提高的程度,等等。

另外一个函数是进行剪枝,即prune,如下prune(tree, cp, ...)主要参数说明:tree一个回归树对象,常是rpart()的结果对象。

cp复杂性参量,指定剪枝采用的阈值。

cp全称为complexity parameter,指某个点的复杂度,对每一步拆分,模型的拟合优度必须提高的程度,用来节省剪枝浪费的不必要的时间,R内部是怎么计算的我不知道,希望读者能够补充另外一个包是rpart.plot,里面的rpart.plot是用来将决策树可视化的。

如下rpart.plot(reg,type=2,faclen=3)参数解释reg是rpart产生的对象。

【最新】R语言 决策树数据统计分析课件教案讲义(附代码数据)

P. Davy and M. Hagenbuchner c ⃝ Week 6, Autumn 2017

INFO411/911 Data Mining and Knowledge Discovery

Slide 5

,

Tree Structure

Tree structure can be specified by a list of branching variables and cutpoints at each decision node. The tree structure consists of a single root node. Classification: Start at the root node, make decision at each node until a terminal (leaf) node is reached. The leaf node determines the class of the sample.

P. Davy and M. Hagenbuchner c ⃝ Week 6, Autumn 2017

INFO411/911 Data Mining and Knowledge Discovery

Slide 3

,

Decision Trees

Decision (or Classification and Regression) Trees involve hierarchical partition of a data set.

Slide 1

,

Decision Trees I

We want a rule for either (a) predicting a continuous variable Y, or (b) classifying into two or more classes, given the values of some explanatory variables. We call (a) a regression tree, and (b) a decision tree. Some of the discussion in this lecture comes from the book The Elements of Statistical Learning, 2nd ed, free version available online

多分类决策树r语言_R语言构造决策树

多分类决策树r语⾔_R语⾔构造决策树数据来源:决策树会⽤到基尼指数,信息增益等知识点,下⾯⽤R构建决策树:注:监督机器学习中会出现的问题:过拟合和⽋拟合,偏差和⽅差为了限制过拟合,可以限制⽣长,修剪树枝其他分类器:KNN和随机森林*[下⼀版我们将⽤KNN和随机森林进⾏数据分类]1. #读取数据2. >library(tree)3. >data<-read.csv('data.csv')4. #了解数据特征5. >View(data)6. >str(data)7. >table(data$是否预定)8. #将数据分为测试集和训练集,70:309. > set.seed(2134)10. > ind<-sample(2,nrow(data),replace=TRUE,prob=c(0.7,0.3))11. > train_set<-data[ind==1,]12. > test_set<-data[ind==2,]13. > nrow(train_set)14. [1] 2715. > nrow(test_set)16. [1] 1117. #使⽤tree函数构建决策树模型18. > #build decision tree model using tree()19. > str(data)20. 'data.frame': 38 obs. of 6 variables:21. $ 性别 : Factor w/ 2 levels "男","⼥": 1 1 2 2 1 2 1 2 2 1 ...22. $ 年龄 : Factor w/ 3 levels "00后","80后",..: 3 1 3 3 3 2 3 3 3 3 ...23. $ 价格敏感 : Factor w/ 2 levels "否","是": 1 1 2 2 1 1 2 1 1 1 ...24. $ 是否连住 : Factor w/ 2 levels "否","是": 1 1 1 2 2 1 1 2 1 1 ...25. $ 提各种问题: Factor w/ 2 levels "否","是": 1 1 1 1 1 2 1 1 1 1 ...26. $ 是否预定 : Factor w/ 2 levels "否","是": 2 2 2 1 2 1 2 2 2 2 ...27. > mytree<-tree(是否预定~性别+年龄+价格敏感+是否连住+提各种问题,data=train_set)28. > #summarize the model29. > summary(mytree)30.31. Classification tree:32. tree(formula = 是否预定 ~ 性别 + 年龄 + 价格敏感 + 是否连住 +33. 提各种问题, data = train_set)34. Variables actually used in tree construction:35. [1] "是否连住" "提各种问题"36. Number of terminal nodes: 337. Residual mean deviance: 0.4904 = 11.77 / 24Misclassification error rate: 0.07407 = 2 / 27模型结果显⽰,剩余偏差为0.4904,误分类误差为7.407%。

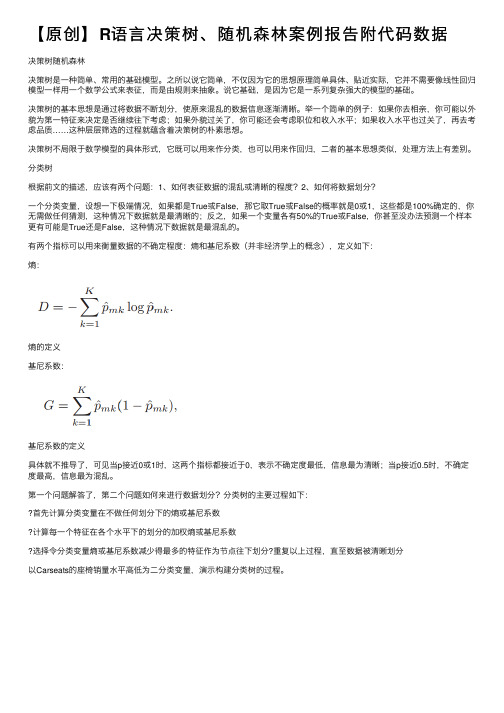

【原创】R语言决策树、随机森林案例报告附代码数据

【原创】R语⾔决策树、随机森林案例报告附代码数据决策树随机森林决策树是⼀种简单、常⽤的基础模型。

之所以说它简单,不仅因为它的思想原理简单具体、贴近实际,它并不需要像线性回归模型⼀样⽤⼀个数学公式来表征,⽽是由规则来抽象。

说它基础,是因为它是⼀系列复杂强⼤的模型的基础。

决策树的基本思想是通过将数据不断划分,使原来混乱的数据信息逐渐清晰。

举⼀个简单的例⼦:如果你去相亲,你可能以外貌为第⼀特征来决定是否继续往下考虑;如果外貌过关了,你可能还会考虑职位和收⼊⽔平;如果收⼊⽔平也过关了,再去考虑品质……这种层层筛选的过程就蕴含着决策树的朴素思想。

决策树不局限于数学模型的具体形式,它既可以⽤来作分类,也可以⽤来作回归,⼆者的基本思想类似,处理⽅法上有差别。

分类树根据前⽂的描述,应该有两个问题:1、如何表征数据的混乱或清晰的程度?2、如何将数据划分?⼀个分类变量,设想⼀下极端情况,如果都是True或False,那它取True或False的概率就是0或1,这些都是100%确定的,你⽆需做任何猜测,这种情况下数据就是最清晰的;反之,如果⼀个变量各有50%的True或False,你甚⾄没办法预测⼀个样本更有可能是True还是False,这种情况下数据就是最混乱的。

有两个指标可以⽤来衡量数据的不确定程度:熵和基尼系数(并⾮经济学上的概念),定义如下:熵:熵的定义基尼系数:基尼系数的定义具体就不推导了,可见当p接近0或1时,这两个指标都接近于0,表⽰不确定度最低,信息最为清晰;当p接近0.5时,不确定度最⾼,信息最为混乱。

第⼀个问题解答了,第⼆个问题如何来进⾏数据划分?分类树的主要过程如下:⾸先计算分类变量在不做任何划分下的熵或基尼系数计算每⼀个特征在各个⽔平下的划分的加权熵或基尼系数选择令分类变量熵或基尼系数减少得最多的特征作为节点往下划分?重复以上过程,直⾄数据被清晰划分以Carseats的座椅销量⽔平⾼低为⼆分类变量,演⽰构建分类树的过程。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

决策树实验指导书

实验目的:

1掌握利用R进行决策树的基本步骤

2更深入理解决策树的应用

实验内容:

说明:本实验采用iris数据集,下面中的数据集如无上下文说明,即是指iris

iris以鸢尾花的特征作为数据来源,数据集包含150个数据集,分为3类,每类50个数据,每个数据包含4个属性,是在数据挖掘、数据分类中非常常用的测试集、训练集。

四个属性分别为:花萼长度、花萼宽带、花瓣长度、花瓣宽度

三类分别为:setosa, versicolor, virginica(山鸢尾、变色鸢尾和维吉尼亚鸢尾)

1、加载rpart包

("rpart")

2、构建决策树,并解释rpart中三个参数的含义

= rpart(Species~., iris, method=“class”)

3、画出决策树

plot, uniform=T, branch=0, margin=, main="

Classification Tree\nIris Species by Petal and Sepal Length")iris

.

4、添加决策树的标签

text, =T, fancy=T, col="blue")

5、根据命令table(iris$Species)给出的结果,解释决策树的分类结果

6、用决策树进行预测

生成训练集=iris[2*(1:75)-1,]

生成测试集= iris[2*(1:75),]

=rpart(Species~., , method=“class”)

=predict, [,-5], type="class")

7、查看预测结果并对结果进行分析,计算出该决策树的accuracy(分类正确的样本数除以总样本数)

table[,5],

(25+24+22)/75=。