图像翻译文字

人工智能技术在翻译服务领域的应用案例

人工智能技术在翻译服务领域的应用案例一、引言随着全球化进程的加快和跨国交流的增加,翻译服务成为促进跨文化沟通的重要环节。

而随着人工智能技术的快速发展,其在翻译服务领域的应用也越来越成熟。

本文将介绍几个人工智能技术在翻译服务领域的应用案例,展示其在提高翻译效率、准确性和便利性方面的巨大潜力。

二、机器翻译1. 案例一:谷歌翻译谷歌翻译是目前最著名的机器翻译工具之一。

它基于神经网络技术,通过对大量的双语文本进行学习和训练,实现自动翻译。

谷歌翻译的优点是可以实现多语种的翻译,并能根据上下文进行准确的翻译。

例如,当输入一句中文“我爱你”的时候,谷歌翻译可以根据上下文自动识别并进行正确的翻译,如“我 love 你”(中文拼音)或“我愛你”(中文繁体)。

2. 案例二:DeepL翻译DeepL翻译是一款基于深度学习技术的机器翻译工具。

相对于传统的基于规则的机器翻译系统,DeepL翻译能更好地理解上下文和语义,并生成更准确的翻译结果。

它通过大量的已翻译文本进行训练,不断优化自身的翻译能力。

不仅如此,DeepL还提供了多种语言之间的翻译服务,覆盖了全球多个主要语种。

三、语音翻译1. 案例一:微软翻译微软翻译是一款结合了语音识别和机器翻译的语音翻译工具。

用户可以通过输入语音、拍摄翻译文本或手写输入等方式进行翻译。

该工具通过语音识别技术将语音内容转化为文字,然后再进行翻译。

微软翻译支持多种语言之间的翻译,让跨语言交流更加方便快捷。

2. 案例二:百度识图翻译百度识图翻译是一款结合了图像识别和机器翻译的翻译工具。

用户可以通过拍摄外文文本图片,然后将图片上传至该应用中,系统将自动识别图片中的文字并进行翻译。

这在旅行或者学习外语时非常有用,能够帮助用户快速获取外文资讯,并理解其含义。

四、智能辅助翻译工具1. 案例一:SDL Trados StudioSDL Trados Studio是一款专业的翻译记忆工具,它结合了人工智能技术,帮助译员更高效地进行翻译工作。

ocr 识别key value

OCR(Optical Character Recognition)是一种通过计算机识别和翻译图像中的文字信息的技术。

在这个技术下,图像被转化为可以编辑、搜索和复制的文字文档,从而方便人们进行数字化处理和管理。

在实际应用中,OCR技术被广泛运用在各种领域,如文档扫描、唯一识别信息识别、银行卡识别等。

一、OCR的基本原理OCR技术的基本原理是通过图像处理和模式识别技术对文字图像进行分析和识别。

具体而言,OCR系统首先对输入的图像进行预处理,包括图像的去噪、灰度化和二值化等操作,以便获得清晰的文字轮廓。

系统会对每个文字轮廓进行特征提取,比如文字的形状、大小和颜色等特征。

系统根据提取的特征利用模式识别算法对文字进行识别和翻译。

二、OCR技术的应用领域1. 文档扫描与管理在办公和学习中,我们经常需要将纸质文档转化为电子文档进行存储和管理。

OCR技术可以帮助我们实现这一目标,只需要将纸质文档进行扫描,OCR系统就可以将其转化为可编辑的电子文档,极大地方便了文档的整理和管理。

2. 唯一识别信息识别银行、公安等机构在办理业务时需要对唯一识别信息进行识别,而OCR技术可以帮助他们快速、准确地识别唯一识别信息上的文字信息,从而提高工作效率。

3. 商业领域OCR技术还被广泛应用在商业领域,比如银行卡识别、票据识别、车牌识别等。

这些应用大大简化了商业活动中的信息录入和识别过程,提高了工作效率和精确度。

三、OCR识别中的key value在OCR技术的应用中,经常需要识别和提取关键信息,即key value。

key value是指在一段文本中具有特定含义和重要价值的信息对,比如尊称和生日、账号和密码等。

而OCR识别中的key value指的就是利用OCR技术从文本中识别并提取出关键信息对的过程。

1. key value的识别原理在OCR系统中,key value的识别主要依赖于特征提取和模式匹配算法。

系统会根据预先设定的key的特征对文本进行筛选和匹配,然后提取对应的value信息。

googl翻译

googl翻译Google翻译是谷歌公司推出的一款在线翻译服务应用,可以帮助用户翻译他们的文字、语音、图像、网页和其他格式的信息。

它可以实现机器翻译功能,支持中英文双向翻译,还提供图片翻译、语音翻译和网页翻译服务。

Google翻译起源于2006年,以前被称为Google工具栏翻译。

它支持网页翻译,翻译准确率比前几年都要高,能够提高中文翻译质量。

2007年,Google推出了谷歌“翻译”应用,该应用能对52种语言进行翻译,让用户更加方便的浏览外文网页,可以帮助用户更快的获取信息。

近年来,Google翻译的技术已经大大提升,它可以实现图像翻译、图像识别、语音输入等功能,这样一来,语言学习就变得更加容易了。

比如,用户只要在翻译客户端上将拍摄的或者导入的图片发送到翻译客户端,系统就可以自动将图片中的文字识别出来,并将其翻译成指定的文字。

另外,Google翻译还支持语音输入,用户可以将自己的语音输入到翻译客户端中,系统也可以将用户的话语转换成文字,从而使用户更加方便的实现翻译功能。

Google翻译现在也在不断的加入新的功能,比如手写输入、实时口译、拼写检查等,以提高Google翻译的用户体验。

另外,Google 翻译还支持多种平台,用户可以在浏览器、移动设备和谷歌产品中使用Google翻译,从而实现全球性的翻译支持。

当今,越来越多的用户正在利用Google翻译来阅读外文内容,学习外文,这正说明Google翻译正在成为越来越多用户日常生活中不可或缺的一部分。

它不仅可以帮助用户更好的了解外文内容,也可以帮助用户学习外文,就像一名英语老师一样,可以帮助用户快速有效的学习外语。

Google翻译不仅可以帮助用户对外文内容进行机器翻译,同时它还可以帮助用户更加深入地理解外文内容。

比如,Google翻译可以帮助用户查看文字释义,查看文章中所用语法结构和实例,查看文章中的文化背景及相关信息等。

另外,Google翻译还支持机器翻译的拼写检查,以确保翻译的准确性。

手机APP的像识别与像处理

手机APP的像识别与像处理随着科技的发展和智能手机的普及,手机APP的功能越来越丰富多样。

其中,像识别和像处理成为了一些热门的手机APP功能。

本文将深入探讨手机APP像识别与像处理的原理、应用和前景。

一、像识别技术像识别技术是指通过手机APP对图像进行分析和解析,从而实现对图像中各种元素的识别和理解。

像识别技术主要包括以下几个方面:1. 物体识别:手机APP可以通过像识别技术对图像中的物体进行识别,包括人脸、动物、植物等。

例如,一些相机APP可以自动识别人脸,并自动对焦和美化。

2. 文字识别:手机APP可以通过像识别技术识别图像中的文字,并将其转化为可编辑的文本。

这对于扫描文档、翻译文字等方面非常有用。

3. 场景识别:手机APP可以通过像识别技术对图像中的场景进行识别和分类。

例如,一些旅游类APP可以根据用户拍摄的照片自动识别出所拍摄的地点,并提供相关的旅游信息。

二、像处理技术像处理技术是指通过手机APP对图像进行各种修饰和调整,以改善图像的质量和效果。

像处理技术主要包括以下几个方面:1. 滤镜效果:手机APP可以通过像处理技术为图像添加各种滤镜效果,如黑白、复古、素描等。

这些滤镜可以使照片更加艺术和有趣。

2. 智能修图:手机APP可以通过像处理技术智能识别图像中的人脸、皮肤等元素,并进行磨皮、美白、祛斑等修饰操作。

这些功能可以帮助用户轻松拍出美丽的自拍照片。

3. 色彩调整:手机APP可以通过像处理技术对图像的色彩进行调整,包括亮度、对比度、饱和度等。

用户可以根据自己的需求,进行个性化的调整,使图像更加生动和鲜艳。

三、应用场景像识别和像处理技术在手机APP中广泛应用于各个领域。

以下是一些常见的应用场景:1. 社交娱乐:像识别和像处理技术可以在社交娱乐类APP中实现各种有趣的功能,如人脸识别换脸、动态滤镜等。

用户可以通过这些功能,制作有趣的照片和视频,增加互动和娱乐性。

2. 电子商务:像识别和像处理技术可以在电子商务类APP中帮助用户进行商品识别和比较。

python实现批量图片识别并翻译

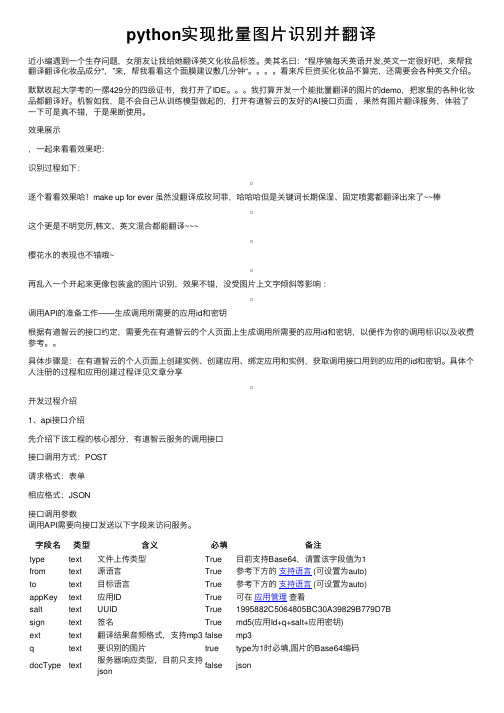

python实现批量图⽚识别并翻译近⼩编遇到⼀个⽣存问题,⼥朋友让我给她翻译英⽂化妆品标签。

美其名⽈:"程序猿每天英语开发,英⽂⼀定很好吧,来帮我翻译翻译化妆品成分",”来,帮我看看这个⾯膜建议敷⼏分钟“。

看来斥巨资买化妆品不算完,还需要会各种英⽂介绍。

默默收起⼤学考的⼀摞429分的四级证书,我打开了IDE。

我打算开发⼀个能批量翻译的图⽚的demo,把家⾥的各种化妆品都翻译好。

机智如我,是不会⾃⼰从训练模型做起的,打开有道智云的友好的AI接⼝页⾯,果然有图⽚翻译服务,体验了⼀下可是真不错,于是果断使⽤。

效果展⽰,⼀起来看看效果吧:识别过程如下:逐个看看效果哈!make up for ever 虽然没翻译成玫珂菲,哈哈哈但是关键词长期保湿、固定喷雾都翻译出来了~~棒这个更是不明觉厉,韩⽂、英⽂混合都能翻译~~~樱花⽔的表现也不错哦~再乱⼊⼀个开起来更像包装盒的图⽚识别,效果不错,没受图⽚上⽂字倾斜等影响:调⽤API的准备⼯作——⽣成调⽤所需要的应⽤id和密钥根据有道智云的接⼝约定,需要先在有道智云的个⼈页⾯上⽣成调⽤所需要的应⽤id和密钥,以便作为你的调⽤标识以及收费参考。

具体步骤是:在有道智云的个⼈页⾯上创建实例、创建应⽤、绑定应⽤和实例,获取调⽤接⼝⽤到的应⽤的id和密钥。

具体个⼈注册的过程和应⽤创建过程详见⽂章分享开发过程介绍1、api接⼝介绍先介绍下该⼯程的核⼼部分,有道智云服务的调⽤接⼝接⼝调⽤⽅式:POST请求格式:表单相应格式:JSON接⼝调⽤参数调⽤API需要向接⼝发送以下字段来访问服务。

字段名类型含义必填备注type text⽂件上传类型True⽬前⽀持Base64,请置该字段值为1from text源语⾔True参考下⽅的⽀持语⾔ (可设置为auto)to text⽬标语⾔True参考下⽅的⽀持语⾔ (可设置为auto)appKey text应⽤ID True可在应⽤管理查看salt text UUID True1995882C5064805BC30A39829B779D7Bsign text签名True md5(应⽤Id+q+salt+应⽤密钥)ext text翻译结果⾳频格式,⽀持mp3false mp3q text要识别的图⽚true type为1时必填,图⽚的Base64编码false jsondocType text服务器响应类型,⽬前只⽀持jsonrender text是否需要服务端返回渲染的图⽚,0:否;1:是,默认是0false0nullIsError text 如果ocr没有检测到⽂字,是否返回错误,false:否;true:是,默认是falsefalse注意是字符串字段名类型含义必填备注签名⽣成⽅法如下:1、将请求参数中的应⽤ID appKey , 图⽚的Base64编码 q ,UUID salt 和应⽤密钥按照应⽤ID+q+salt+应⽤密钥的顺序拼接得到字符串 str 。

助力中国政治话语国际传播的多模态翻译方法探析

助力中国政治话语国际传播的多模态翻译方法探析一、多模态翻译方法的意义多模态翻译方法是指以语言文字、图像、声音等多种媒介进行翻译的方法。

相对于传统的语言文字翻译,多模态翻译方法能够更加全面地传达原文的意义和情感,增强受众的感知和理解。

在国际传播领域,多模态翻译方法能够帮助中国政治话语更好地被国际社会接受和理解,提升中国的国际形象和话语权。

多模态翻译方法也能够丰富翻译形式,提升传播效果。

通过将语言文字与图像、声音相结合,翻译作品可以更加生动形象地展现原文意义,引起受众的共鸣和兴趣,达到更好的传播效果。

尤其是在政治话语的国际传播中,多模态翻译方法可以更好地满足不同国家和地区受众的传播习惯和接受需求,提高中国政治话语的国际影响力。

1. 图像翻译图像翻译是多模态翻译方法的重要形式之一,对于中国政治话语的国际传播具有重要意义。

中国的政治话语往往伴随着丰富的图像,如国家元首的演讲、重要会议的场景、政策决策的过程等。

图像翻译可以将这些图像与语言文字相结合,通过图片、视频等方式呈现给国际受众,增强其对政治话语的理解和认同。

在国际社交媒体平台上发布中国政治领导人的演讲视频,并配以英文翻译字幕,就可以更好地传达中国政治话语的内涵和重要性。

2. 声音翻译3. 多媒介翻译在实际应用多模态翻译方法助力中国政治话语国际传播时,需要考虑以下几点策略和实践:1. 选用合适的翻译工具和平台。

在进行多模态翻译时,需要选用合适的翻译工具和平台,如翻译软件、多媒体编辑软件等。

同时需要根据不同的传播渠道和受众需求,选择合适的传播平台,如国际社交媒体、新闻媒体、官方网站等。

2. 注重翻译质量和效果。

在进行多模态翻译时,需要注重翻译质量和效果,确保翻译内容准确、流畅、地道。

同时需要根据不同的受众文化背景和传播习惯进行翻译调整,以达到更好的传播效果。

3. 加强国际合作与交流。

多模态翻译方法在助力中国政治话语国际传播时,需要加强国际合作与交流,与国际社会的翻译机构、媒体合作,共同推动中国政治话语的国际传播,提升其国际影响力。

人工智能时代的翻译技术研究内涵、分类与趋势

人工智能时代的翻译技术研究内涵、分类与趋势一、本文概述随着技术的快速发展和广泛应用,翻译技术作为其中的一项重要分支,正在逐步改变我们的语言交流方式,并对全球的信息传播和文化交流产生深远影响。

本文旨在探讨时代的翻译技术研究内涵、分类与趋势。

我们将概述翻译技术在时代的内涵,包括其定义、特点和发展背景。

接着,我们将对翻译技术进行详细的分类,分析各类翻译技术的特点和应用场景。

我们将探讨翻译技术在时代的发展趋势,展望其未来的发展方向和潜在影响。

通过对翻译技术研究的深入分析,我们期望能够为相关领域的研究人员和实践者提供有价值的参考,推动翻译技术的进一步发展。

二、人工智能时代的翻译技术研究内涵在时代,翻译技术研究内涵得到了极大的丰富和深化。

翻译技术不再仅仅是传统的语言转换工具,而是演变为一门融合了计算机科学、语言学、认知科学等多学科的交叉研究领域。

其核心在于利用技术,实现自然语言处理、机器翻译、语言理解、知识表示等方面的突破,以提高翻译质量和效率。

自然语言处理:自然语言处理是翻译技术的基石,它涉及对文本、语音等自然语言的自动理解和生成。

在人工智能的推动下,自然语言处理技术得到了快速发展,包括词法分析、句法分析、语义理解等方面的研究,为翻译技术提供了强大的支持。

机器翻译:机器翻译是利用计算机自动将一种自然语言文本转换为另一种自然语言文本的过程。

随着深度学习、神经网络等技术的发展,机器翻译的质量和效率得到了显著提升,尤其是在神经机器翻译模型的推动下,机器翻译已经能够实现较为准确的跨语言翻译。

语言理解:语言理解是翻译技术的核心,它涉及对源语言文本的深入分析和理解,以便准确地传达其意义。

在人工智能时代,语言理解研究不仅关注语言的表面结构,还关注语言的深层含义、上下文信息以及语言与文化的关系等方面。

知识表示:知识表示是翻译技术中不可或缺的一部分,它涉及如何将人类语言中的知识转化为计算机可理解和处理的形式。

在人工智能时代,知识表示方法得到了不断创新和完善,如知识图谱、语义网络等,为翻译技术提供了丰富的知识资源和表示手段。

图像分析英语作文带翻译

图像分析英语作文带翻译"英文,"As a student majoring in computer science, I have been exposed to various image analysis techniques and algorithms. Image analysis is the process of extracting meaningful information from images, and it plays a crucial role in many fields such as medical diagnosis, surveillance, and industrial automation.One of the most common image analysis techniques is image segmentation, which involves dividing an image into multiple segments to simplify the representation of an image. For example, in medical imaging, image segmentation can be used to identify and locate tumors in the human body. This is essential for accurate diagnosis and treatment planning.Another important technique is object recognition,which is used to identify and classify objects within animage. For instance, in autonomous vehicles, object recognition is used to detect pedestrians, vehicles, and traffic signs to ensure safe driving.In addition to these techniques, there are also advanced algorithms such as deep learning and convolutional neural networks that have revolutionized image analysis. These algorithms can learn from large amounts of image data and make accurate predictions and classifications."中文,"作为一名主修计算机科学的学生,我接触过各种图像分析技术和算法。

提取文字的方法

提取文字的方法文字是人类用来交流和记录信息的重要工具。

在现代社会中,我们经常需要从各种来源中提取文字,以获取所需的信息。

本文将介绍一些常用的提取文字的方法。

一、复制粘贴复制粘贴是最常用的提取文字的方法之一。

我们可以通过鼠标或键盘将需要提取的文字选中,并使用快捷键或右键菜单中的复制选项将其复制到剪贴板中,然后再将其粘贴到需要的地方。

二、OCR技术OCR(Optical Character Recognition)技术是一种通过识别图像中的文字并将其转换为可编辑文本的方法。

我们可以使用OCR软件或在线服务,将需要提取的文字的图像上传或导入,然后软件会自动识别图像中的文字,并将其转换为文本格式。

三、屏幕截图屏幕截图是一种将屏幕上的文字提取到图片中的方法。

我们可以使用快捷键或截图工具将需要提取的文字截取到图片中,然后使用图片编辑软件将图片中的文字提取到文本中。

四、语音识别语音识别是一种将语音转换为文字的技术。

我们可以使用语音识别软件或在线服务,将需要提取的语音输入,然后软件会自动将语音转换为文本。

五、网页抓取网页抓取是一种从网页中提取文字的方法。

我们可以使用网络爬虫软件,通过指定网页的URL,将网页中的文字提取到本地文件或数据库中。

六、文本提取工具文本提取工具是一种专门用于提取文字的软件。

这些工具通常具有批量处理的功能,可以从多个文件或文件夹中提取文字,并将其保存为文本文件或其他格式。

七、手写输入手写输入是一种将手写文字转换为可编辑文本的方法。

我们可以使用手写输入设备,如数字板或触控笔,在电脑或移动设备上直接书写文字,并将其转换为文本。

八、语言翻译语言翻译是一种将其他语言的文字转换为目标语言的方法。

通过使用翻译软件或在线服务,我们可以将需要提取的文字输入,然后软件会自动将其翻译为目标语言的文字。

九、文字识别文字识别是一种通过识别图像中的文字并将其转换为文本的方法。

与OCR技术类似,文字识别可以识别各种类型的文字图像,如印刷体、手写体和特殊字体。

五年级下册信息技术教案-第8课-声音图像变文字-泰山版

课时备课课题:声音图像变文字教学目标:1.熟悉各种声音转换成文字的方式并比较差别,声音形式不同,应用的转换方式也不相同,有的需要将录音文件转换成文字,有的需要语音输入同时转换成文字,针对上述不同情况探索最合适的转换方法。

2.掌握图片文字的识别方法,通过实际操作,掌握识别技巧,图片的清晰度、方向等对识别都有影响,针对上述不同情况探索如何提高识别准确率。

3.了解人工智能技术在文字识别方面的发展现状及对学习和生活产生的影响。

教学难点:1.使用手机APP卢讯飞语记将声音转换为文字。

2.使用手机APP将图片转换为文本。

教学难点:图片转换为文本的方法。

教学准备:多媒体网络教室、office2007等。

课时数:1课时教学过程:一、生活发现(一)生活情境机器人已经成为我们生活中的好帮手,越来越多的机器人加入到我们人类的生活中,教师展示机器人工作的影视片段(机器人与人交流的场景)。

给学生介绍机器人小爱。

(二)问题提出1.讨论问题(1)小爱是如何听懂人类语言的?(机器人先将声音转化为文字,找到相应的信息后,再将文字转化为声音实现的)(2)生活中你见过哪些语音识别技术和图像识别技术?(语音输入法、机器人对话险识别技术等)2.生成问题(1)声音转換为文字的工具软件App讯飞语记如何使用节(2)如何将图像中的文字转化为文本(三)我的设想(小组讨论)(1)小组代表发言,选取1~2个小组,汇报本小组对以上几个问题的解决方案(2)教师由学生提出的方案总结引导进入本课新知识(3)组间进行评价二、庖丁解牛(一)案例分析录音是我们采访、听讲时经常使用的一种记录方式,学校校报小组要采访创新大赛一等奖得主,并将其获奖感言整理一下,发表在校报上,如何将录音整理成文字呢?(只要使用语音识别软件先将录音转化成文字,再稍加整理,文字记录就形成了)1.讯飞语记Ap的安装(准备工具:手机)(1)小组讨论如何在手机上安装讯飞语记APP提示:在手机的软件商店中搜素讯飞语记APP通过视频等资料共同学习Ap的安装,同时师生一起认识讯飞语记的功能(2)教师巡视,学生分小组进行安装安装步骤略2.讯飞语记的使用方法第二环(1)将手机连接网络,打开讯飞语记APP(2)点击“按钮”开始录音,在录音的同时会看到语音正在被转换成文字(3)采访结束后,检查、修改已经转换的文字(提示:录音时使用普通话,能提高语音识别的准确率)3.小组展示作品小组互评、教师点评三、案例分解(手机App智慧识图的使用方法)我们的校报还需要一篇励志文章,小明在阅览室的杂志上发现一篇文章符合要求,但是内容很长,如何快速地将这篇文章以文本形式保存呢?(用手机拍下来,而且将图片转成文本保存,这样会更方便使用)手机App智慧识图的使用方法(1)打开手机照相App(2)将镜头对准要保存的文章(3)选择智慧识图中的文本识别、进行文字采集(提示:进行图片识别时,尽量保持书本平整,将要识别的文字置于识别框内)四、创意研究(一)创意研究院1.通过以上的学习,我们已经学会了使用手机Ap将声音转换为文字以及能用工具将图像中的文字转化为文本。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Ralf Gerber' and Hans-Hellmut Nagel'i2

0-7803-3258-X/96/$5.000 1996 IEEE

805ห้องสมุดไป่ตู้

of ‘object-7’ of the regarded scene. In order to derive quantified occurrences, we examine at first how many and which vehicles perform the same movements at the same time. These quantities are related to a total number of objects moving in the scene. This total number can be the sum of all vehicles ever localized in the visual field of the camera or the sum of moving objects localized only during a particular period. Alternatively, it could be any other subset of moving objects which relate to the regarded objects in a particular way (e.g. all objects moving on the same street). Numerical relations derived in this manner are associated with natural language quantifiers like a few, m a n y , some, nearly all, all. Such associations are mediated by means of fuzzy sets. Finally, quantified occurrences are determined for each time instant and each agent reference occurrence. Each quantified occurrence description consists of its quantifier, its validation time, the motion verb, the names of the involved 1 10 objects and a degree of confidence. In order to faFigure 1: Real-world road traffic scene at the cilitate the generation of the natural language deDurlacher-Tor in Karlsruhe. The numbers specify the scription, we select the quantifier which is valid for the longest continuous period. internal reference of the detected objects. derive the following three postulates: SEMANTIC REPRESENTATION The data structures, on which the generation of quantified occurrences is performed, are based on the Discourse Representation Theorie (DRT) developed by [lo]. In their research, these authors define special logic structures (Discourse Representation Structures, DRSs), in order to represent the semantics of natural language, and a set of construction rules to automatically transform natural language sentences into DRSs. A DRS consists of a set of Discourse Referents (DR) and a set of DRSconditions. There is a close affinity between DRSs and First Order Predicate Calculus. For details on DRT, see [lo]. We use the DRT to transform the generated conceptual descriptions into logic structures representing their natural language semantics. This is possible because the generated occurrences are very similar t o natural language. The agent can be conceived as the subject of a ‘virtual’ sentence, the motion verb represents the verb of this sentence and the validation time acts as an adverbial element of time. As an example, Figure 3 shows such a DRS €or an agent-reference occurrence. Figure 4 shows a DRS for a quantified occurrence. The generation of DRSs representing quantified occurrences from a set of DRSs representing single agent occurrences is performed by a set of derivation rules. These deriva-

'Institut fur Algorithmen und Kognitive Systeme Fakultat fur Informatik der Universitat Karlsruhe (TH) Postfach 6980, D-76128 Karlsruhe, Germany 'Fraunhofer-Tnstitut fur Pnformations- und Datenverarbeitung (IITB), Fraunhoferstr. 1, D-76131 Karlsruhe, Germany Telephone +49 (721) 6094-210 (Fax -413), E-Mail hhn@iitb fhg.de ABSTRACT Our image sequence interpretation process, which generates conceptual descriptions of the behaviour of vehicles in real-world traffic scenes, essentially treated only a single vehicle (the agent) so far. Simultaneous behaviours of other vehicles in the scene have been formulated only relative to the agent. The approach discussed in this contribution allows us to quantify occurrences and thus to generate more global conceptual descriptions of behaviour by using natural language quantifiers. The semantics of such quantified occurrences are represented by special logic structures. Natural language descriptions are derived from these internal knowledge representations. INTRODUCTION Although both Natural Language Processing and Computer Vision have been active research areas separately and despite the fact that a link between these areas has been continuously pursued for about 20 years now ([l]), results from other sources about linking these areas have become available only recently. [a] discuss the usefulness of formal knowledge representation and introduce some extensions to increase the applicability of terminological systems to image interpretation tasks. [3] uses special Lexical Conceptual Structures (LCS) to represent the outputs from visual systems to language. His considerations have not been applied on real image data. [4] present a system to generate natural language descriptions of the location of renal stones found in radiographs. These authors do not take any kind of ternporal relationships of the objects in the scene into account, since their system is based on the evaluation of Q ~ J a ? single frame. [5] use Bayesian Believe Networks and conceptual knowledge to interpret the behaviour of moving objects in a real-world traffic scene. Natural language descriptions are not derived frorn their knowledge representation structures. We want to generate natural language descriptions from recorded video sequences of real-world traffic scenes. For a satisfactory description it is not sufficient to inspect the behaviour of each moving object separately. Rather wr have to determine the behaviour of ensembles of various objects. Such ensembles will be described by quantified occurrences, modelled by means of fuzzy sets. The resulting representations can be transformed into natural language descriptions. QUANTIFIED CICCURRENCES Our image evaluation system XTRACK (see [SI, [7], [8] and [9]) determines occurrences that describe the behaviour of an exaimined road vehicle. Occurrences comprise information about the examined vehicle, the motion verb and the validation time. Occurrences can be categorized into four different classes: occurrences which refer only to the agent itself (agent reference), the ones which additionally refer to the road (road reference),to another moving object (object reference), or to a selected location (location reference). Occurrences associated with the agent reference category can in turn be categorized into five subclasses, so-called velocity occurrences (like drzve-slody), direction occurrences (such as drive-forward antd back-up), branching OCcurrences (e.g. turn-left) acceleration occurrences (e.g. brake, accelerate) and terminative occurrences (stop, drive-ofl. Using this classification, we can