信息论-信息论第7次课ch3--信源熵

信源熵的名词解释

信源熵的名词解释信源熵(Source Entropy)是信息论中一个重要的概念,用于衡量信息源的不确定性和信息的平均编码长度。

在信息论中,信息可以被看作是从一个信源中获取的,而信源熵用来描述这个信源的不确定性大小。

信源熵的计算方法是根据信源可能产生的符号的概率分布来进行的。

具体来说,如果一个信源有n个可能取值(符号)S1,S2,...,Sn,并且每个符号出现的概率分别为P1,P2,...,Pn,那么信源的熵H(S)可以通过下面的公式计算得出:H(S) = -P1log(P1) - P2log(P2) - ... - Pnlog(Pn)其中,log是以2为底的对数,P1,P2,...,Pn是概率分布。

信源熵的含义是,对于一个不确定性较大的信源,需要更长的编码长度来表示每一个符号,所以熵值越大,说明信息的平均编码长度越长。

相反,当一个信源的不确定性较小,即各个符号出现的概率分布较平均时,信息的平均编码长度较短,熵值较小。

以一个简单的例子来说明信源熵的概念。

假设有一个只有两个符号的信源,分别记为S1和S2,它们出现的概率分别为P1和P2。

如果这两个符号的概率分布相等(即P1 = P2 = 0.5),那么信源的熵就是最大的,因为这两个符号的不确定性相同,需要同样长度的编码来表示它们。

而如果其中一个符号的概率接近于1,另一个符号的概率接近于0,那么信源的熵就是最小的,因为其中一个符号的信息是确定的,只需要很短的编码来表示它。

这个例子可以帮助我们理解信源熵与不确定性之间的关系。

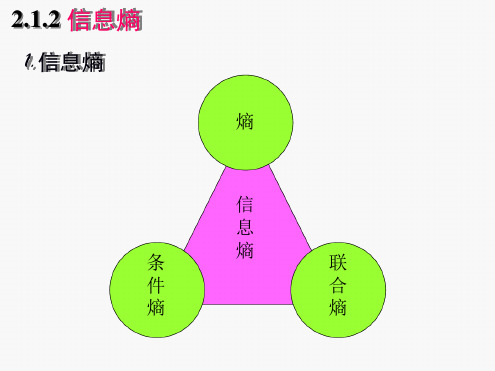

除了信源熵,信息论中还有一个重要的概念是条件熵(Conditional Entropy)。

条件熵是在已知一定的背景条件下,信源的不确定性大小,即在给定前提条件下的平均编码长度。

条件熵可以通过信源和条件之间的联合概率分布来计算,其公式为:H(S|T) = -ΣΣP(s, t)log(P(s|t))其中,P(s, t)表示符号s和条件t联合发生的概率。

信源及信源熵介绍

2.2.1 自信息量

2. 不确定度 定义:随机事件的不确定度在数量上等于它的 自信息量.

说明:

a. 两者的单位相同,但含义却不相同。 b. 具有某种概率分布的随机事件不管发生与否,都存在

不确定度,不确定度表征了该事件的特性,而自信息 量是在该事件发生后给予观察者的信息量。

15

2.2.1 自信息量

22

2) 因为X中各符号xi的不确定度I(xi)为非负值,p(xi)也 是非负值,且0 p(xi)1,故信源的平均不确定度H(X) 也是非负量。

3) 平均不确定度H(X)的定义公式与热力学中熵的表示形 式相同,所以又把H(X)称为信源X的熵。熵是在平均意 义上来表征信源的总体特性的,可以表征信源的平均不确 定度。

2

p(xi ) log 2 p(xi ) i 1

= 0.72比特/次 说明:

1) 自信息量I(x1)和I(x2)只是表征信源中各个 符号的不确定度,一个信源总是包含着多个符 号消息,各个符号消息又按概率空间的先验概 率分布,因而各个符号的自信息量就不同。所 以自信息量不能作为信源总体的信息量。

=3 × 105 × 3.32 比特/画面

25

有一篇千字文章,假定每字可从万字表中任选, 则共有不同的千字文 N=100001000=104000 篇 仍按等概率1/100001000计算,平均每篇千字文 可提供的信息量为 H(X)=log2N =4 × 103 × 3.32

1.3 × 104 比特/千字文

离散消息的信源,如文字、数字、数据等符号都是

离散消息。

{ 离散信源

离散无记忆信源 离散有记忆信源

{ {

5

发出单个符号的无记忆信源 发出符号序列的无记忆信源 发出符号序列的有记忆信源 发出符号序列的马尔可夫信源

信源与信源熵.ppt

Information and Entropy

信源的统计特性和数学模型 各类信源的信息测度—---信息熵及其性质。

2019/11/25

1/45

信源的统计特性

信息论中,信源是产生消息(符号)、消息序 列和连续消息的来源。

从数学上看,由于消息的不确定性,因此, 信源是产生随机变量、随机序列和随机过程 的源。

② 含义:该性质说明熵只与随机变量的总体结构有关,与

信源的总体统计特性有关。如果某些信源的统计特性相同 (含有的符号数和概率分布相同),那么这些信源的熵就 相同。

2019/11/25

19/45

(3) 最大离散熵定理

定理: 离散无记忆信源输出n个不同的信息符号,

当且仅当各个符号出现概率相等时(即p(xi)=1/n), 熵最大。

xn p(xn

)

Y P(Y

)

y1, p( y1),

p(

y2,,y j , y2 ),, p( y j ),

yn p( yn

)

0 p(xi ) 1, 0 p( yi ) 1,

n

p(xi ) 1

i 1

n

p(y j ) 1

10/45

互信息量和条件互信息量

X—发送端信源的离散消息集合;

Y—接收端信宿的离散消息集合; X

P(yj|xk) —转移概率;

P(yj|xk)

Y

X、Y的数学模型为

X ),

x2 ,,xi , p(x2 ),, p(xi ),

15/45

•条件熵

定义:条件熵是在联合符号集合XY上的条件自信息的数学期望。 在已知Y时,X的条件熵为

第二章 信源熵

英文字母中“e”出现的概率为0.105,“c” 出现的概率为0.023,“o”出现的概率为 0.001,分别计算他们的自信息量。 答:I(e)=-logP(e)=-log0.105=3.25bit I(c)=-logP(c)=-log0.023=5.44bit I(o)=-logP(o)=-log0.001=9.97bit

H ( X | y j ) p( xi | y j )I ( xi | y j )

i

给定集合Y条件下,集合X的条件熵H(X|Y) 为: H ( X | Y ) p( y ) H ( X | y )

j

j

= p( y j ) p( xi | y j )I ( xi | y j )

I ( xi ) I ( y j )

性质:

非负值 当事件相互独立时,联合自信息量为各自信息量之 和

三 条件自信息

1 定义:条件概率对数的负数。 2 事件Xi以时间Yj发生为条件,其条件密度为 P(Xi|Yj),则其条件自信息量为 I(Xi|Yj)=-logP(Xi|Yj)。 3 性质:非负值

i 1 4

⑤

数学性质分析: 以二元信号源为例。信源分别以概率p,q输 出符号“0”,“1”,p+q=1。信源的概率空 间为: X 0 1 P p q

H ( X ) p( xi ) log p( xi ) p log p q log q

X a1 P p 1 a2 p2 ... ... aq pn

信息量:信息的定量表示 信源熵:

物理熵:无序程度的度量,描述系统特征,如 热力学熵。 信息熵:随机事件的不确定度,描述系统的统 计特征。 信源熵:信源发出消息的不确定度。

信息论-信息熵文档

?

3 8

log 2

3)? 4

2

?

0.812(比特

/ 符号)

3.联合熵

nm

?? H (XY ) ? ?

p(xi y j ) log2 p(xi y j )

i?1 j?1

2.1.3 信息熵的性质

1 非负性

H(X) ≥ 0

其中等号成立的充要条件是当且仅当对某 i,p(xi)=1,其 余的p(xk)=0(k≠i)。

定义:各离散消息自信息量的数学i?期1 望,即信源的 平均信息量。

? H(X ) ?

E[I(xi )] ?

E[log2

1 ]? p(xi )

?

n i?1

p(xi ) log2

p(xi )

信源的信息熵;香农熵;无条件熵;熵函数; 熵

单位:比特/符号

例:某地二月份天气构成的信源为

?X ??P(X

? )??

?? ? 0

确知信源的不确定度为零。

5 可加性

H(XY) ? H(X ) ? H(Y X )

H ( XY ) ? H (Y ) ? H ( X Y )

?? ?? 1

1

H (XY ) ?

i

j p( xi y j ) log2 p( x i y j ) ? i

j p( xi y j ) log2 p( x i ) p( y j / x i )

H(X) ? logn

当且仅当 X中各个消息出现的概率全相等时,上式 取等号。

证明:自然对数具有性质

当x ? 0时,ln x ? x ? 1,并且当且仅当 x ? 1时, 该式取等号。

H ( X ) ? log n

?

?? ? ?

信息论 信源熵 (3)

3

平均互信息的非负性

Ic(X;Y) = Hc(X) – Hc(X/Y)

Ic(Y;X) = Hc(Y) – Hc(Y/X)

对称性—— Ic(X;Y) = Ic(Y;X) 非负性—— Ic(X;Y) ≥0 , Ic(Y;X) ≥0 条件熵不大于无条件熵

Hc(X/Y) ≤Hc(X) Hc(Y/X) ≤ Hc(Y)

§2.3.1 连续信源的熵

§2.3.2 几种特殊连续信源的熵

§2.3.3 连续信源熵的性质及

最大连续熵定理

§2.3.4 熵功率

1 2

连续信源熵可为负值

连续信源熵的可加性

H c ( XY ) = H c ( X ) H c (Y

X

)

H c ( XY ) = H c (Y ) H c ( X ) Y 推广到N个变量的情况

( x m)2 2 2

m为均值

xp( x)dx = m

2 2

为方差

2

( x m) p( x)dx =

2

当m = 0时

P = (平均功率)

H c ( X ) = p( x) log p( x)dx

1 = p( x) log( e 2

其它

假设任意信源概率密度q( x)

bN

aN

bN

p( x)da1da2 da N

a1

b1 a1

b1

= q( x)da1da2 da N = 1

aN

可以证明

H c q( x ), X H c p( x ), X

2 限平均功率的最大熵定理 平均功率为P,均值m受限,当信 源概率密度函数为正态分布时,具有最

信源熵的原理及应用

信源熵的原理及应用1. 介绍信源熵是信息论中一个重要的概念,它描述了一个随机信源所具有的信息量的平均度量。

信源的熵越大,表示信息的不确定性越高,需要更多的信息来描述。

本文将介绍信源熵的原理,并探讨其在通信、数据压缩以及密码学等领域的应用。

2. 信源熵的定义信源熵是正信息论中一个重要概念,它用来度量一个随机信源所具有的信息量的平均度量。

对于一个离散随机变量X,它的概率分布为P(X),则信源的熵定义如下:equationequation其中,xi是随机变量X的取值,P(xi)是xi对应的概率。

3. 信源熵的性质•信源熵的取值范围:信源的熵是非负的,即H(X) ≥ 0。

•最大熵原理:对于一个离散信源,当它的概率分布均匀时,即每个xi的概率相等时,信源熵达到最大值。

•如果一个信源越复杂,即其概率分布越不均匀,那么它的熵就越小。

4. 信源熵的应用4.1 通信系统在通信系统中,信源熵可以用来度量信道所传输信息的平均编码长度。

根据香农定理,信道传输的平均编码长度L与信源熵H(X)满足以下关系:equationequation当信道编码满足L = H(X)时,信道编码称为最优编码,即编码的平均长度等于信源熵。

4.2 数据压缩信源熵还可以应用于数据压缩领域。

数据压缩的目的是使用更少的位数来存储或传输数据。

通过统计一个数据源的概率分布,可以将出现概率低的数据编码为较长的二进制位,而出现概率高的数据编码为较短的二进制位。

信源熵提供了压缩算法的理论基础。

4.3 密码学在密码学中,信源熵用于度量消息或密码的随机性。

如果一个密码是完全随机的,并且每个密钥都是等概率选择的,那么这个密码的熵将达到最大值。

信源熵可以用来评估一个密码系统的安全性,以及密码生成算法的随机性。

5. 总结本文介绍了信源熵的原理及其应用。

信源熵是衡量信息量的重要度量指标,它在通信、数据压缩以及密码学等领域具有多种应用。

通过明确信源熵的定义和性质,我们可以更好地理解和应用它。

第2章信源及信源熵 145页PPT文档

【例2.1】

设信源只有两个符号“0”和“1”,且它们以消 息的形式向外发送时均以等概率出现,求它们 各自的自信息量。

(二)不确定度d(ai)与自信息量I(ai) 两者的联系

数值上相等,单位也相等,但含义不同。

两者的区别

具有某种概率分布的随机事件,不管其发生与否, 都存在不确定度,不确定度是任何随机事件本身所 具有的属性。

信源空间:

X P(x)

a1 a2 … aN =

P(a1) P(a2) … P(aN)

显然有:

例:对于二进制数据、数字信源:X={0,1}, 若这两个符号是等概率出现的,则有:

X P(x)

a1 = 0a2 = 1 Nhomakorabea=

P(a1) =0.5 P(a2) = 0.5

(二)多符号离散信源

是发出符号序列的信源

一般来说,信源输出的随机序列的统计特性比较复杂,分析起来也比 较困难。为了便于分析,我们假设信源输出的是平稳的随机序列,也 就是序列的统计性质与时间的推移无关。很多实际信源也满足这个假 设。

若在信源输出的随机序列X= (X1,X2,…,XN)中,每个随机变 量Xi (i=1,2,…,N)都是取值离散的离散型随机变量,即每个随机变量 Xi的可能取值是有限的或可数的;而且随机矢量X的各维概率分布都 与时间起点无关,也就是在任意两个不同时刻随机矢量X的各维概率 分布都相同。这样的信源称为离散平稳信源。如中文自然语言文字, 离散化平面灰度图像都是这种离散型平稳信源。

离散无记忆信源

在某些简单的离散平稳信源情况下,信源先后发出的 一个个符号彼此是统计独立的。也就是说发出的信源 发出的符号是相互独立的,发出符号序列中各个符号 之间也是相互独立的。

信源熵公式

信源熵公式

信源熵是信息论中的一个重要概念,它是用来度量消息的丰富性和

复杂性的一种度量方法。

它的概念源于 Shannon 在 1948 年出版的文章Information Theory。

一、信源熵是什么

信源熵(即 Shannon 熵)是指数据量的复杂性程度的度量,即信息量

在消息中不确定性的度量。

它可以帮助我们测量消息中内容丰富程度,以及消息是否具有冗余性。

通俗来说,信源熵是一种度量消息中有多

少信息和无规律性的度量方法。

二、信源熵的计算公式

信源熵的计算公式是: H(p) = -∑p(i)logp(i) 。

其中,H(p)是具有信息量

p的信息源的熵,p(i)是每一种信息量的概率。

它很好地反映了消息的复杂性,但它不能用来衡量消息的可靠性,因

此不能按照 Shannon 熵来评估消息的独特性。

三、信源熵的应用

信源熵有很多应用,最重要的是在信号处理、声音分析、密码学、数

据库设计和模式分析等领域有广泛的应用。

例如在压缩文件时,可以

使用信源熵来确定哪些数据需要进行压缩处理,从而减小数据的量。

另外,信源熵也可以用来度量信号的复杂性,比如机器学习算法中的模型复杂度因子,可以使用信源熵来衡量模型的复杂度。

四、总结

信源熵是由 Shannon 在 1948 年提出的一种度量方法,它可以度量消息的复杂性和冗余性,可以帮助我们评估消息的信息量。

它被广泛应用于信号处理、声音分析、密码学、数据库设计和模式分析等领域,可以用来度量信号的复杂性,以及机器学习算法中的模型复杂度因子。

信源及信源熵

2.1 单符号离散信源

数学模型:

X P( X

)

x1 p( x1 )

0 p(xi ) 1,

xi p(xi )

xn

p(

xn

)

n

p(xi ) 1

i 1

单符号离散信源

常用旳概率论旳基本概念和性质

先验概率、联合概率、条件概率及其相互关系:

(1)0 p(xi )、p( y j ) 、p( y j / xi ) 、p(xi / y j ) 、p(xi y j ) 1

离散无记忆信源旳N次扩展信源旳数学模 型是信源空间X旳N重空间。

信源旳描述与分类

有记忆信源

一般情况下,信源在不同步刻发出旳符号之间是相互依

赖旳。即信源输出旳平稳随机序列X中,各随机变量Xi

之间是有依赖旳。如:在中文构成旳中文序列中,只有 根据中文旳语法、习常用语、修辞制约和体现实际意义 旳制约所构成旳中文序列才是有意义旳中文句子或文章。 所以,在中文序列中前后文字旳出现是有依赖旳,不能 以为是彼此不有关旳。这种信源称为有记忆信源。

因为每个随机变量UL有n种取值,则U 有n L

种可能取值。

信源旳描述与分类

离散序列信源

例:最简朴L=3旳三位PCM信源:这 时L=3, n=2, 即i={0,1},则有:

U 3 u 000 u 001

p(u)

p03

p02 p1

u 111

p13

当p0 p1 12时 000, 001, 010, ,111

假如上述条件概率与时间起点i无关,即信源 输出旳符号序列可看成为时齐马尔可夫链, 则此信源称为时齐马尔可信源。

信源旳描述与分类

离散序列信源总结

离散序列信源

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1) m阶马氏链的符号转移概率已给定:

p(xm1 / x1 xm )其中xi取自A {a1L an}

2) 做m长符号序列到信源状态的映射(x1 xm) s j ,

xi 取遍 A {a1L an} ,i=1,…,m; 状态取自 s j

Am {1,2,L nm} ,nm为状态数;

m§阶2马.1氏链自的信处息理和方互法信(2息)

H

() 3

0.918

比特/符号

H0 log 2 1 比特/符号

1 H 1 0.896 0.104

H0

信息论

本章 小结

1 离散信源X的N次扩展源的H熵(X N ) N H (X ) 源无记忆时等式成立;

,仅当信

离

散

信

源

X

的

N

次

H

扩

N展( X

)

源

1H

N的

(

XN)

平

H

均

(

X)

符

号

熵

,仅当信源无记忆时等式

信息信论息基论础

字母 空格

A B C D E F G H

概率 0.1859 0.0642 0.0127 0.0218 0.0317 0.1031 0.0208 0.0152 0.0467

字母 I J K L M N O P Q

概率 0.0575 0.0008 0.0049 0.0321 0.0198 0.0574 0.0632 0.0152 0.0008

1:0.7 11

0:0.4

1:0.6

p(0)

0.41

0.2 2

0.33

0.4 4

1 3

p(1) 1 p(0) 2 3

例

信息论

一个二元二阶马氏源,符号集{0,1},状态转移图如下图所示。

(3)求此马氏源的符号熵;

0:0.4

H i H (X / S i)

i

1 H (0.4) 2 H (0.2) 2 H (0.3) 4 H (0.4)

成立。

2、有记忆信源的符号熵:

1

H

(

X

)

lim

N

N

H

(

X

N

)

lim

N

H

(

X

N

/

X1L

XN)

并且 H (X ) H2(X ) L HN (X ) L H (X )

信息论

本章 小结

3.马氏源的符号熵:

本章

H (X ) j H (X / s j)

小结

j

n

其中 H ( X / s j) p j (ai ) log p j (ai )

★

信息论

3) 符号转移概率转换成状态转移概率 p( xm1 / x1 L xm ) p(s j1 / s j ) 其中, (x2 L xm1) s j1 (x1 xm) s j

4)

得到马氏源模型:

1 2 L

p(l / k )

nm

k,l

1,

...,

n

m

凸离§马§单函散氏2击.2链无数.1此1.N记处1次自添忆扩条加信信展标件息源题源和自的的互信熵N次信的息扩计息展算(源7)

信息信论息基论础

汉字近似概率表

类别 Ⅰ Ⅱ

汉字个数 140

625-140=485

所占概率P 0.5

(0.85-0.5)=0.35

Ⅲ

2400-

(0.997-0.85)=0.147

625=1775

Ⅳ

7600

0.003

每个汉字的概率Pi 0.5/140 0.35/485

0.147/1775

0.003/7600

(4)求 H0, H1, H2 , H3 和信源的冗余度。

00 1:0.6

0:0.3

解:

0.4 0.6 0 0

P

0

0 0.2 0.8

0.3 0.7 0 0

0

0 0.4 0.6

01 1:0.8

0:0.2

1:0.7 11

10 0:0.4

1:0.6

信息论

例 一个二元二阶马氏源,符号集{0,1},状态转移图如下图 所示。

Page 12

凸自§§熵§然离单函22语散的击.2.数.言平1此31基.的稳处1自相有平添本关记自条加信均性忆性标信件息和信题互质和息自剩源余的信互(信度熵信息息(14)息)

单击此处添加标题

信息信论息基论础

根据上表,可近似估算汉 语信源的信息熵:

10000

H ( X ) pi log pi i 1 9.773 (比特/符号)

字母 R S T U V W X Y Z

概率 0.0484 0.0514 0.0796 0.0228 0.0083 0.0175 0.0013 0.0164 0.0005

Page 10

凸自§§熵§然离单函22语散的击.2.数.言平1此31基.的稳处1自相有平添本关记自条加信均性忆性标信件息和信题互质和息自剩源余的信互(信度熵信息息(12)息)

凸§§§K马马§离单Co函2齐2ol2尔m氏散.击n.2次.ot数2可.平e1此链g3n马1o.稳t夫处r的s氏1o自有平添信v信平链-记自条加信C源(稳均h忆息标信件6a的息分信)题p互m熵基布和息自源a本n的信互的方信(熵1概程信息)息含念(4息()义1)

信息信论息基论础

定

马氏源:

义 ▲ 当前时刻输出符号的概率仅与

9

9

9

9

0.8957 比特/符号

1:0.6 01

00 0:0.2

1:0.8

1:0.7 11

0:0.3 10

0:0.4

1:0.6

x2 x1

例

信息论

一个二元二阶马氏源,符号集{0,1},状态转移图如下图所示。

(3)求 H0, H1, H2, H3 和信源的冗余度。

0:0.4

H3 H 0.896 比特/符号

单击此处添加标题

信息信论息基论础

信源的 相关性

1

信源剩 余度 (冗余度)

2

自然语 言的相 关性和 剩余度

3

Page 7

§§离K马信§离单3o散齐2l2P氏m散击源.2a次.o无r.平链1此tg3马的1Co.稳记处状or氏1on相自有平添vc态忆链e-记条自加关p信C分(信均th忆标件信6性a息类信)源题p互m和自息源(的a4n的信互方)信N熵次程信息息(扩4息) 展源

信息信论息基论础

计算方法1:

当信源从某一状态转移到另一状态时, 输出 符号唯一, 则一个m阶马氏源的符号熵为:

H

(

X

)

lim

N

H

N

(

X

)

πT

h

m阶马氏源符号熵仅由平稳分布和 状态转移概率矩阵所决定。

凸§§§离马K马§离单3o函2散齐2氏l2P氏m散.击.2a次.o无源r数2.平链1此tg3马1Co.符稳记处状or氏1on自有平添号vc态忆信链e-记条自加p熵信C分(信均th忆息标的件信6a息类信)源题p互计m熵和自息源(的a算4n的信互的方)信N(熵7次程信息息含)(扩4息)义展源

信息信论息基论础定 理来自平稳马氏源的符号熵为J

H (X ) i H(X / s i) i 1

n

H ( X / s j) p j (ai ) log p j (ai ) i 1

§§离K马信§离单3o散齐2l2P氏m散击源.2a次.o无r.平链1此tg3马的1Co.稳记处状or氏1on相自有平添vc态忆链e-记条自加关p信C分(信均th忆标件信6性a息类信)源题p互m与和自息源(的a4n的信剩互方)信N熵次程余信息息(扩4度息) 展源

p(1| 0) 11/ 3 2 / 3

p(1|1) 1 2 / 3 1/ 3

H (X2 | x1 0) H (X2 | x1 1) H (1 / 3)

H2 H ( X 2 / X1) p(x1)H ( X 2 | x1) H (1 / 3) 0.918 比特/符号

x1

1

H1

H

( X1 )

2 Part Concept

信息信论息基论础

如果起始状态概率为平稳分布, 则

N次扩展源的平均符号熵为:

H ( X1X 2 L X N ) H (π) ( N m)πT h

HN(X)

1 N

H ( X1X 2 L

XN)

1 [H (π) (N m)πTh] N

凸§§§马K§离单o函2氏齐2l2m散.击.2源次.o数2.平1此g3马符1o.稳处r氏1o号自有平添v信链-熵记自条加信C(均h忆的息标信件6a息信)题p计互m熵和息自源算an的信互的方信(1熵程信)息息含(4息)义

H

lim

n

H

(

X

n

/

X1

X n1 )

Hn H ( X n / X1 X n1)

(n-1阶马氏源)

Page 8

§§离K马信§离单3o散齐2l2P氏m散击源.2a次.o无r.平链1此tg3马剩1Co.稳记处状or氏1on余自有平添vc态忆链e-记条自加度p信C分(信均th忆标件信6(a息类信)源题p互m冗和自息源(的a4n的信余互方)信N熵次程度信息息(扩4)息) 展源

x2

p(x1x2)

0

0

1/9

x1

1

2/9

1

2/9

P(x1=0)=

1/3

4/9

P(x1=1)=

2/3

1:0.6 01

00 0:0.2

1:0.8

1:0.7 11

0:0.3 10

0:0.4

1:0.6