复旦 周小林 信息论 2.信源与信息熵

信源熵的名词解释

信源熵的名词解释信源熵(Source Entropy)是信息论中一个重要的概念,用于衡量信息源的不确定性和信息的平均编码长度。

在信息论中,信息可以被看作是从一个信源中获取的,而信源熵用来描述这个信源的不确定性大小。

信源熵的计算方法是根据信源可能产生的符号的概率分布来进行的。

具体来说,如果一个信源有n个可能取值(符号)S1,S2,...,Sn,并且每个符号出现的概率分别为P1,P2,...,Pn,那么信源的熵H(S)可以通过下面的公式计算得出:H(S) = -P1log(P1) - P2log(P2) - ... - Pnlog(Pn)其中,log是以2为底的对数,P1,P2,...,Pn是概率分布。

信源熵的含义是,对于一个不确定性较大的信源,需要更长的编码长度来表示每一个符号,所以熵值越大,说明信息的平均编码长度越长。

相反,当一个信源的不确定性较小,即各个符号出现的概率分布较平均时,信息的平均编码长度较短,熵值较小。

以一个简单的例子来说明信源熵的概念。

假设有一个只有两个符号的信源,分别记为S1和S2,它们出现的概率分别为P1和P2。

如果这两个符号的概率分布相等(即P1 = P2 = 0.5),那么信源的熵就是最大的,因为这两个符号的不确定性相同,需要同样长度的编码来表示它们。

而如果其中一个符号的概率接近于1,另一个符号的概率接近于0,那么信源的熵就是最小的,因为其中一个符号的信息是确定的,只需要很短的编码来表示它。

这个例子可以帮助我们理解信源熵与不确定性之间的关系。

除了信源熵,信息论中还有一个重要的概念是条件熵(Conditional Entropy)。

条件熵是在已知一定的背景条件下,信源的不确定性大小,即在给定前提条件下的平均编码长度。

条件熵可以通过信源和条件之间的联合概率分布来计算,其公式为:H(S|T) = -ΣΣP(s, t)log(P(s|t))其中,P(s, t)表示符号s和条件t联合发生的概率。

第二章 信源熵

I ( xi y j ) = log 2 p ( xi y j )

XY x1 y1 , , x1 ym , x2 y1 , , x2 ym , , xn y1 , xn ym P ( XY ) = p( x y ), p( x y ), p( x y ),, p( x y ) 1 1 1 m 2 1 n m 0 ≤ p ( xi y j ) ≤ 1, ∑∑ p ( xi y j ) = 1

信息论基础 第二章 信源熵

苗立刚 ligangmiao@ 实验楼417 实验楼 电话8048018 电话 东北大学秦皇岛分校自动化工程系 2009年 2009年3月

第二章 信源熵

本章主要讨论的问题: 本章主要讨论的问题:

2.1 单符号离散信源 2.2 多符号离散平稳信源 2.3 连续信源 2.4 离散无失真信源编码定理

Y y1 , y2 , , y j , , ym 信宿 = p ( y ), p( y ), , p ( y ), , p ( y ) , ∑ p( y j ) = 1 j 1 2 j m P(Y )

2.1单符号离散信源 2.1

–信源发出消息 xi 的概率 p ( xi ) 称为先验概率,信 信源发出消息 称为先验概率 先验概率, 的概率称为后验概 宿收到 y j 后推测信源发出 xi 的概率称为后验概 率 p ( xi / y j ) 。 –定义 xi 的后验概率与先验概率比值的对数为 y j 的后验概率与先验概 比值的对数为 先验概率 定义 互信息量, 表示, 对 xi 的互信息量,用 I ( x i ; y j ) 表示,即

2.1单符号离散信源 2.1

自信息量的单位 –自信息量的单位取决于对数的底; 自信息量的单位取决于对数的底; 自信息量的单位取决于对数的底 –底为2,单位为“比特(bit)”; 底为2 单位为“比特(bit) ; 底为 –底为e,单位为“奈特(nat)”; 底为e 单位为“奈特(nat) ; 底为 –底为10,单位为“哈特(hat)”; 底为10 底为10,单位为“哈特(hat)”; –1 nat = 1.44bit , 1 hat = 3.32 bit; bit; 1 例1:从26个英文字母中,随即选取一个字母,则该事件的自 26个英文字母中,随即选取一个字母, 个英文字母中 信息量为 I = -log2(1/26) = 4.7 比特 例2:设m比特的二进制数中的每一个是等概率出现的(这样的 比特的二进制数中的每一个是等概率出现的( 数共有2 则任何一个数出现的自信息为: 数共有2m个),则任何一个数出现的自信息为: 比特/ I = -log2(1/ 2m) = m 比特/符号

信息论与编码2-信源及信源熵

实例3

随机天气状况信源,其中晴天、雨天、雪天出现的概率分别是0.7、0.2、0.1。

实例1

随机二进制信源,其中每个二进制符号(0或1)出现的概率为0.5。

离散无记忆信源的实例

离散有记忆信源

03

离散有记忆信源是输出符号序列中符号与符号之间存在记忆关系的离散随机序列。

应用场景

广泛应用于网络通信、金融交易、军事通信等领域,保障信息安全和隐私。

加密通信

03

应用景

广泛应用于通信系统、数据存储等领域,如CD、DVD、硬盘等存储设备的纠错编码。

01

纠错原理

通过在数据中添加冗余信息,检测和纠正数据传输过程中的错误。

02

常见纠错编码

如奇偶校验码、海明码、循环冗余校验码等,这些编码利用数学原理对数据进行校验,确保数据的正确性。

纠错编码

THANKS

感谢观看

离散有记忆信源的输出符号之间存在统计依赖关系,这种关系会影响信息熵的计算。

定义

性质

离散有记忆信源的定义与性质

计算方法

条件熵

联合熵

离散有记忆信源熵的计算

离散有记忆信源熵是描述信源不确定性的度量,可以通过统计模型来计算。具体计算方法包括条件熵和联合熵等。

条件熵是在给定前一个或多个符号条件下,输出符号的熵。

应用场景

广泛应用于文件存储、网络传输、多媒体处理等领域,如JPEG图片压缩、MP3音频压缩等。

数据压缩原理

通过去除数据中的冗余信息,将数据压缩至更小的存储空间,提高存储和传输效率。

数据压缩

加密原理

通过特定的加密算法将明文转换为密文,确保信息在传输过程中的保密性。

第2章 信源熵 第1讲 自信息量 与 互信息量

余 映 云南大学

17/38

计算举例

• 对于 2n 进制的数字序列, 假设每一符号的出现完 全随机且概率相等,求任一符号的自信息量。 解:设任一码元 xi 出现概率为 p(xi),根据题意, p(xi) = 1/ 2n I (xi) = –log(1/ 2n) = n (bit) • 事件的自信息量只与其概率有关,而与它的取值 无关。

余 映 云南大学

18/38

信息量与不确定性的关系

• 信源中某一消息发生的不确定性越大,一旦它发生,并为 收信者收到后,消除的不确定性就越大,获得的信息也就 越大。 • 由于各种原因(例如噪声太大),收信者接收到受干扰的 消息后,对某信息发生的不确定性依然存在或者一点也未 消除时,则收信者获得较少的信息或者说一点也没有获得 信息。

余 映 云南大学 21/38

信息量与不确定性的关系

• 自信息量和不确定度的含义又有区别

– 不确定度只与事件的概率有关,是一个统计量,在静 态状态下也存在; – 自信息量只有该随机事件出现时才给出,不出现时不 给出,因此它是一个动态的概念。

余 映 云南大学

22/38

自信息的含义

• 在事件 xi 发生前:表示事件 xi 发生的不确定性。 • 在事件 xi 发生后:表示事件 xi 所提供的信息量。

余 映 云南大学

19/38

信息量与不确定性的关系

• 信息量的直观定义:

收到某消息获得的信息量=不确定性减少的量 =(收到此消息前关于某事件发生的不确定性) -(收到此消息后关于某事件发生的不确定性) • 在无噪声时,通过信道传输,可以完全不失真地收到消息, 收到此消息后关于某事件发生的不确定性完全消除,此项 为零。因此得 收到某消息获得的信息量 =收到此消息前关于某事件发生的不确定性 =信源输出的某消息中所含有的信息量

第二章_离散信源与信息熵的关系

给出,为了书写方便以后写成: 和

y1 , y2 , Y q1 , q2 , ym qm

xn Y y1, y2 , Q q( y ), q( y ), p( xn ) ; 1 2

ym q ( ym )

一. Definition of the self-mutual information:

«信 息 论 基 础 »

第二章:信息的度量与信息熵

( The measure of Information &Entropy) §2. 1 自信息与条件自信息

( self—information & conditional self— information) §2. 2 自互信息与条件自互信息 (self—mutual

p ( x ) 则表达当收端已收到某种消息后, 再统计发端的发送 率: y 概率,所以此条件概率称为后验概率(Posterior Probability) 。

§2. 1 自信息与条件自信息 因此我们说事件 xi 以及它所对应的先验概率P( x )而定

i

义出的自信息 I [ p( xi )] ,所表达的不论事件是否有人接收这 个事件它所固有的不确定度,或者说它所能带来的信息 xi p ( ) 量。而消息事件 y j xi nk 它所对应的条件概率 yj 是在收端接收到已干扰的消息后的后验概率,如果当它为1 xi p ( ) 则属于透明传输;若 y j <1,则属于有扰传输。而当 xi p ( ) 后验概率大于先验概率是 y j > P( xi ),说明事件 y j 发生之后多少也解除了事件 xi 的部分不定度,即得到 了事件 X xi 的部分信息。由于概率越大,不定度越小。 从客观上讲,条件自信息一定不会大于无条件的自信息。 同时也反映出要得知一些条件,原事件的不定度一定会 减少,最坏的情况也不过保持不变,即条件与事件无关。

信息论与编码 信源与信息熵

• 例2-8:一个二进信源X发出符号集{0,1},经过

离散无记忆信道传输,信道输出用Y表示,由于 信道中存在噪声,接收端除收到0和1的符号外, 还有不确定符号“2” X • 已知X的先验概率: 3/4 p(x0)=2/3, p(x1)= 1/3, • 符号转移概率: p(y0|x0)=3/4, p(y2|x0)=1/4 p(y1|x1)=1/2, p(y2|x1)=1/2,

14

1/ 2 p(x2 | y1) I (x2; y1) = log 2 = log 2 =1 bit p(x2 ) 1/ 4

1/ 4 I (x3; y1) = I (x4; y1) = log 2 =1bit 1/ 8

• 表明从y1分别得到了x2 x3 x4各 1比特的信 息量。 • 消息y1使x2 x3 x4的不确定度分别减少1bit 、 2bit 、 2bit 。

0 1/4 2 1/2 1 1/2 1

Y 0

• 信源熵

2 1 2 2 1 1 H( X ) = H( , ) = − log − log = 0.92bit / 符号 3 3 3 3 3 3

16

由

p(xi y j ) = p(xi ) p( y j / xi ) = p( y j ) p(xi / y j )

• 得联合概率: p(x0y0) = p(x0) p(y0 |x0) = 2/3×3/4 = 1/2 p(x0y1) = p(x0) p(y1 |x0) = 0 p(x0y2) = p(x0) p(y2 |x0) = 2/3×1/4 = 1/6 p(x1y0) = p(x1) p(y0 |x1) = 0 p(x1y1) = p(x1) p(y1 |x1) = 1/3×1/2=1/6 p(x1y2) = p(x1) p(y2 |x1) = 1/3×1/2=1/6

复旦 周小林 信息论 1.绪论

普通高等教育“十五”国家级规划教材《信息论与编码》 曹雪虹等编著

17

1.1 信息论的形成与发展

信息论的形成与发展

✓ 1959年,Shannon, 信源压缩编码理论,“Coding theorem for a discrete source with a fidelity criterion”

市场研究公司Juniper Research日前发表的研究报告称,到 2013年,全球移动WiMAX用户将达到8000万,年收入将超过 230亿美元。

相关公司介绍

高通 :CDMA技术领域的先驱、拥有600项核心技术专利

Intel 华为 爱立信 诺基亚西门子 阿尔卡特朗讯 …

普通高等教育“十五”国家级规划教材《信息论与编码》 曹雪虹等编著

普通高等教育“十五”国家级规划教材《信息论与编码》 曹雪虹等编著

27

信息传输的变革

普通高等教育“十五”国家级规划教材《信息论与编码》 曹雪虹等编著

28

信息的定义和性质

信息是具体信号与消息的内涵,是信号载荷的内 容,是消息描述的对象。反过来,信号则是信息 在物理表达上的外延,消息则是信息在数学表达 上的外延。同一信息,可以采用不同形式的物理 量来载荷,也可以采用不同的数学描述方式。 同样,同一类型信号或消息也可以代表不同内容 的信息。

无线信道

扩频接 收机

基带接收

模块

(信号解 复用,解 调,解扩

等)

图像解压与 信道差错译

码模块

指令信号 差错保护

模块

无线发射机简要框图

无线接收机简要框图

普通高等教育“十五”国家级规划教材《信息论与编码》

《信息论与编码》绪论-信源及信源熵

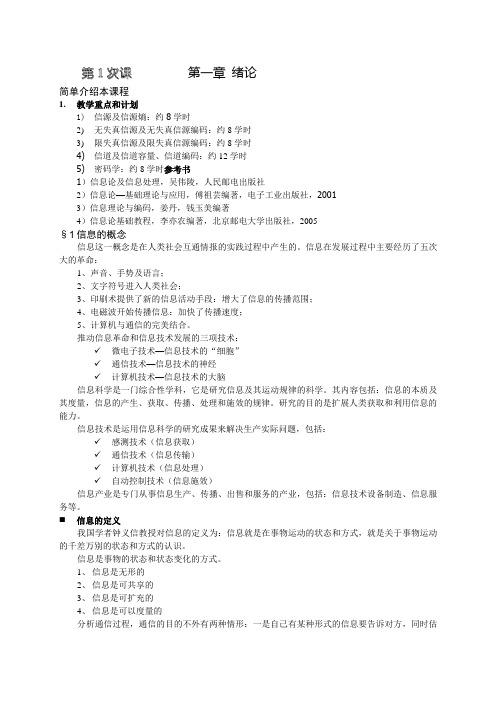

第一章绪论简单介绍本课程1.教学重点和计划1)信源及信源熵:约8学时2)无失真信源及无失真信源编码:约8学时3)限失真信源及限失真信源编码:约8学时4)信道及信道容量、信道编码:约12学时5)密码学:约8学时参考书1)信息论及信息处理,吴伟陵,人民邮电出版社2)信息论—基础理论与应用,傅祖芸编著,电子工业出版社,20013)信息理论与编码,姜丹,钱玉美编著4)信息论基础教程,李亦农编著,北京邮电大学出版社,2005§1 信息的概念信息这一概念是在人类社会互通情报的实践过程中产生的。

信息在发展过程中主要经历了五次大的革命:1、声音、手势及语言;2、文字符号进入人类社会;3、印刷术提供了新的信息活动手段:增大了信息的传播范围;4、电磁波开始传播信息:加快了传播速度;5、计算机与通信的完美结合。

推动信息革命和信息技术发展的三项技术:✓微电子技术—信息技术的“细胞”✓通信技术—信息技术的神经✓计算机技术—信息技术的大脑信息科学是一门综合性学科,它是研究信息及其运动规律的科学。

其内容包括:信息的本质及其度量,信息的产生、获取、传播、处理和施效的规律。

研究的目的是扩展人类获取和利用信息的能力。

信息技术是运用信息科学的研究成果来解决生产实际问题,包括:✓感测技术(信息获取)✓通信技术(信息传输)✓计算机技术(信息处理)✓自动控制技术(信息施效)信息产业是专门从事信息生产、传播、出售和服务的产业,包括:信息技术设备制造、信息服务等。

⏹信息的定义我国学者钟义信教授对信息的定义为:信息就是在事物运动的状态和方式,就是关于事物运动的千差万别的状态和方式的认识。

信息是事物的状态和状态变化的方式。

1、信息是无形的2、信息是可共享的3、信息是可扩充的4、信息是可以度量的分析通信过程,通信的目的不外有两种情形:一是自己有某种形式的信息要告诉对方,同时估计对方既会对这种信息感到兴趣,而又尚不知道这个信息。

也就是说,对方在关于这个信息的知识上存在着不确定性;另一种情况是,自己有某种疑问要向对方询问,而且估计对方能够解答自己的疑问。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

I ( xi

/

yj)

log

p( xi

/

yj)

log

1 p( xi /

yj)

普通高等教育“十五”国家级规划教材《信息论与编码》

16

2.2离散信源熵与互信息

联合自信息、条件自信息与自信息间的关系

p(x, y) p(x) p( y / x) p( y) p(x / y)

I ( x, y) log p( x, y) log p( x) p( y / x)

14

2.2离散信源熵与互信息

普通高等教育“十五”国家级规划教材《信息论与编码》

15

2.2离散信源熵与互信息

定义:联合概率空间中任一联合事件的联合(自)

信息量为:

I ( xi ,

yj)

log

p( xi ,

yj)

log

1 p( xi ,

yj)

定义:联合概率空间中,事件x在事件y给定条件

下的条件(自)信息量为:

解:随机事件的概率空间为

X P

x1 0.8

x2 0.2

普通高等教育“十五”国家级规划教材《信息论与编码》

r p(u)

1 8

,

1 8

,

L

1 8

普通高等教育“十五”国家级规划教材《信息论与编码》

8

普通高等教育“十五”国家级规划教材《信息论与编码》

9

2.2离散信源熵与互信息

信息量

自信息量 联合自信息量 条件自信息量

单符号离散信源熵

符号熵 条件熵 联合熵

普通高等教育“十五”国家级规划教材《信息论与编码》

信源的基本特性是具有随机不确定性。

普通高等教育“十五”国家级规划教材《信息论与编码》

2

2.1信源特性与分类

分类

时间

离散

连续

幅度

离散

连续

记忆

有

无

三大类:

单符号离散信源

符号序列信源(有记忆和无记忆)

连续信源

普通高等教育“十五”国家级规划教材《信息论与编码》

3

2.1 信源描述与分类

描述:通过概率空间描述

以3位PCM信源为例

uur

U

uuuunrL

p(unL )

U L U 000, U 001, L U 111

r p(u)

p03,

p02 p1, L

p13

普通高等教育“十五”国家级规划教材《信息论与编码》

7

2.1信源描述与分类

当p=1/2

U L U 000, U 001, L U 111

5

2.1信源描述与分类

连续信源

U p(u)

(a, b)

p(u)

u U (, ), p(u)为概率密度函数

普通高等教育“十五”国家级规划教材《信息论与编码》

6

2.1信源描述与分类

离散序列信源

ur

uur

UL r

U

uuur1,

U uuuur2,

L

p(u) p(u1), p(u2 ), L

0时, 1时,

I I

( (

pi pi

) )

0

由两个不同的消息(相互统计独立)所提供的信 息等于它们分别提供信息之和(可加性)

普通高等教育“十五”国家级规划教材《信息论与编码》

12

2.2离散信源熵与互信息

普通高等教育“十五”国家级规划教材《信息论与编码》

13

2.2离散信源熵与互信息

定义:对于给定的离散概率空间表示的信

I (xi

/

yj)

log2

p( xi

/

yj)

log2

p(xi , y j ) p( y j )

log2

Hale Waihona Puke 1 83bit普通高等教育“十五”国家级规划教材《信息论与编码》

20

2.2离散信源熵与互信息

例2. 一个布袋内放100个球,其中80个球为红色, 20球为白色。若随机摸取一个球,猜测其颜色, 求平均摸取一次所获得的(自)信息量。

log p( x) log p( y / x) I ( x) I ( y / x) 当x和y相互独立: I ( xy) I (x) I ( y) 推广

I ( x1x2 L xN ) I ( x1) I ( x2 / x1) L

I ( xN / x1x2 L xN 1)

普通高等教育“十五”国家级规划教材《信息论与编码》

17

2.2离散信源熵与互信息

普通高等教育“十五”国家级规划教材《信息论与编码》

18

2.2离散信源熵与互信息

例1 设在一正方形棋盘上共有64个方格,如果甲将 一粒棋子随意地放在棋盘中的某方格内,让乙猜 测棋子所在的位置: (1)将方格按顺序编号,令乙猜测棋子所在方格 的顺序号 (2)将方格按行和列编号,甲将棋子所在的方 格的行(或列)编号告诉乙,再令乙猜测棋子所 在列(或行)所在的位置。

10

2.2离散信源熵与互信息

信息

不确定性的消除

信息的度量

随机性、概率 相互独立符合事件概率相乘、信息相加

熵

事件集的平均不确定性

普通高等教育“十五”国家级规划教材《信息论与编码》

11

2.2离散信源熵与互信息

直观推导信息测度

信息I应该是消息概率p的递降函数

pi pi

, I ( pi ) ,且当pi , I ( pi ) ,且当pi

普通高等教育“十五”国家级规划教材《信息论与编码》

19

2.2离散信源熵与互信息

解:由于甲将一粒棋子随意地放在棋盘中的某方格内, 因此棋子在棋盘中所处位置为二维等概率分布

p( xi

,

y

j

)

1 64

(1)联合(自)信息量为

I (xi ,

yj)

log2

p(xi ,

yj)

log2

1 64

6bit

(2)条件(自)信息量为

单符号离散信源

U p(u)

U

u1, p1,

U u2, p2 ,

L, L,

U un

pn

例如:对二进制数字与数据信源

U 0,

p

p0 ,

1

p1

0, 1, 2

1

1

2

普通高等教育“十五”国家级规划教材《信息论与编码》

4

2.1 信源描述与分类

普通高等教育“十五”国家级规划教材《信息论与编码》

源,x=ai事件所对应的(自)信息为

I ( xi

ai )

log

p( xi )

log

1 p( xi )

以2为底,单位为比特(bit)

以e为底,单位为奈特(nat) 1nat=1.433bit

以10为底,单位为笛特(det) 1det=3.322bit

普通高等教育“十五”国家级规划教材《信息论与编码》

第2章 信源与信息熵

信源描述与分类 离散信源的信息熵和互信息 离散序列信源的熵 连续信源的熵与互信息 冗余度

普通高等教育“十五”国家级规划教材《信息论与编码》

1

2.1信源的描述与分类

信源是产生消息(符号)、消息序列和连 续消息的来源。从数学上,由于消息的不 确定性。因此,信源是产生随机变量、随 机序列和随机过程的源。