台湾李宏毅教授深度学习基本思路

李宏毅机器学习课程——Lifelonglearning学习笔记

李宏毅机器学习课程——Lifelonglearning学习笔记概述lifelong learning⾮常直观,意思是机器不能前边学后边忘。

常见的⽅法是对前边的task中学习出来的参数加⼀个保护系数,在后⾯的任务中,训练参数时,对保护系数⼤的参数很难训练,⽽保护系数⼩的参数则容易⼀些。

下⾯的图⾮常直观,颜⾊的深浅代表loss的⼤⼩,颜⾊越深loss越⼩。

在task1中θ2的变化对loss的变化⾮常敏感,⽽θ1则不敏感,所以在task2中尽量只通过改变θ1来减⼩loss,⽽不要改变θ2。

在lifelong learning中,loss的计算公式如下:L′(θ)=L(θ)+λΣi b i(θi−θb i)2其中b i就是对θ的保护系数,θi表⽰本次task中需要学习的参数,θb i是从之前的task中学习到的参数。

不同的⽅法差异就在于b i的计算。

这⾥将会结合Coding整理⼀下遇到的三个⽅法。

Coding这部分针对HW14,介绍了EWC,MAS,SCP三种⽅法,这⾥讲解⼀下具体的代码实现,并定性地分析⼀下这些⽅法是如何把哪些重要的参数保护起来。

EWCEWC中不同的保护系数f i使⽤如下的⽅法计算得到:F=[∇log(p(y n|x n,θ∗A))∇log(p(y n|x n,θ∗A))T]F的对⾓线的各个数就是各个θ的保护系数。

p(y n|x n,θ∗A)指的就是模型在给点之前 task 的 data x n以及给定训练完 task A (原来)存下来的模型参数θ∗A得到y n(x n对应的 label ) 的后验概率。

其实对参数θi,它的保护系数就是向量log(p(y n|x n,θ∗A))对θ1的偏导数∂log(p(y n|x n,θ∗A))∂θ1与⾃⾝的内积。

当对这个参数敏感时,这个偏导数会变⼤,当预测结果正确率⾼时,p(y n|x n)也会⾼,最终都会使的保护系数变⼤。

某⼀个参数⽐较敏感,这个参数下正确率⾼时,这个参数就会被很好地保护起来。

了解AI技术中的深度学习原理

了解AI技术中的深度学习原理一、深度学习原理简介深度学习是人工智能(AI)领域中的一个重要分支,它通过模拟人脑神经网络的结构和机制来实现对复杂数据的高效处理与分析。

深度学习依赖于一类称为“人工神经网络”的模型,在这些模型中,数据在多个层次上进行变换和表示,从而提取出有效的特征并进行学习。

本文将介绍深度学习的基本原理以及如何应用于AI 技术中。

二、神经网络与深度学习1. 神经元和激活函数神经网络是由大量相互连接的人工神经元组成的。

每个人工神经元接收输入信号,并通过激活函数将其转换成输出。

激活函数通常是非线性的,因为线性函数的叠加等于一个线性函数,无法处理非线性问题。

2. 前向传播前向传播是指信号从网络的输入层流向输出层的过程。

每个人工神经元将输入信号进行计算,并将结果传递给下一层。

通过不断迭代这个过程,网络能够逐渐找到最优参数以提供准确的预测结果。

3. 反向传播反向传播是深度学习中最重要的步骤之一。

它使用梯度下降法来更新神经网络的参数,以使损失函数达到最小值。

反向传播通过计算每个神经元的输出相对于损失函数的导数,然后将这些导数沿着网络进行反向传递。

通过调整所有连接权重和偏差,网络能够逐渐优化预测结果。

三、深度学习中的常见模型1. 卷积神经网络(CNN)卷积神经网络是深度学习中应用最为广泛的模型之一。

它主要应用于图像识别、目标检测等视觉任务。

CNN利用卷积层提取图像特征,并通过池化层进行特征降维,最后通过全连接层将特征映射到不同类别上进行分类。

2. 循环神经网络(RNN)循环神经网络主要应用于序列数据处理,如语音识别、自然语言处理等领域。

RNN具有记忆功能,可以对任意长度的输入序列进行建模,并考虑上下文信息。

然而,传统的RNN存在梯度消失或爆炸问题,在长期依赖任务中表现不佳。

3. 长短期记忆网络(LSTM)为了解决RNN中的梯度问题,提出了长短期记忆网络。

LSTM引入了门控机制,通过遗忘和选择性更新来控制信息的流动。

人工智能深度学习:从入门到精通(微课版)-教学大纲

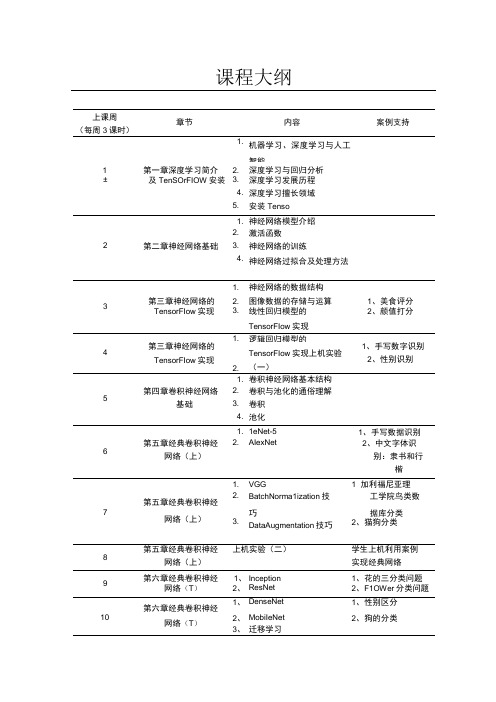

课程大纲上课周(每周3课时)章节内容案例支持1.机器学习、深度学习与人工智能1第一章深度学习简介 2.深度学习与回归分析±及TenSOrFIOW安装 3.深度学习发展历程4.深度学习擅长领域5.安装Tenso1.神经网络模型介绍2.激活函数2第二章神经网络基础 3.神经网络的训练4.神经网络过拟合及处理方法1.神经网络的数据结构3第三章神经网络的 2.图像数据的存储与运算1、美食评分TensorFIow实现 3.线性回归模型的TensorFIow实现2、颜值打分第三章神经网络的TensorFIow实现1.逻辑回归模型的1、手写数字识别2、性别识别42.TensorFIow实现上机实验(一)1.卷积神经网络基本结构5第四章卷积神经网络 2.卷积与池化的通俗理解基础 3.卷积4.池化1.1eNet-51、手写数据识别6第五章经典卷积神经 2.AIexNet2、中文字体识网络(上)别:隶书和行楷1.VGG1×加利福尼亚理第五章经典卷积神经2.BatchNorma1ization技工学院鸟类数7网络(上)巧据库分类3.DataAugmentation技巧2、猫狗分类8第五章经典卷积神经上机实验(二)学生上机利用案例网络(上)实现经典网络9第六章经典卷积神经1、Inception1、花的三分类问题网络(T)2、ResNet2、F1OWer分类问题第六章经典卷积神经1、DenseNet1、性别区分10网络(T)2、MobiIeNet2、狗的分类3、迁移学习11第六章经典卷积神经上机实验(三)学生上机利用案例±1网络(T)实现经典网络12第七章深度学习用于1、词嵌入1、评论数据分析文本序列2、机器作诗初级:逻辑回归2、诗歌数据作诗13第七章深度学习用于1、机器作诗进阶1:RNN诗歌数据作诗文本序列IΛ第七章深度学习用于1、机器作诗进阶2:1STM诗歌数据作诗文本序列15第七章深度学习用于机器翻译原理中英文翻译文本序列第七章深度学习用于上机实验(四)学生上机利用案例16机器自动作诗或翻文本序列译。

AI技术如何进行深度学习与强化学习的算法与优化

AI技术如何进行深度学习与强化学习的算法与优化随着人工智能(AI)技术的迅猛发展,深度学习和强化学习成为了AI领域的两个重要分支。

深度学习通过多层神经网络的训练,实现了对大规模数据的高效处理和模式识别能力的提升。

而强化学习则通过智能体与环境的交互,通过试错和奖励机制来优化决策策略。

在实际应用中,如何进行算法与优化是深度学习和强化学习的关键问题。

深度学习算法的核心是神经网络,它模拟了人脑神经元之间的连接和传递信息的方式。

神经网络的训练过程可以通过反向传播算法来实现。

反向传播算法通过计算损失函数对神经网络的权重和偏置进行调整,从而使得网络的输出结果与实际值更加接近。

为了提高训练效率,一种常用的优化算法是梯度下降法。

梯度下降法通过计算损失函数对权重和偏置的梯度,来指导参数的更新方向。

此外,还有一些改进的优化算法,如Adam、RMSprop等,能够更快地收敛到最优解。

在深度学习中,还有一些常用的正则化技术,如L1和L2正则化。

正则化通过在损失函数中引入正则项,限制模型的复杂度,防止过拟合的发生。

此外,还有一些正则化方法,如dropout和批量归一化,能够进一步提高模型的泛化能力。

这些正则化技术在深度学习中起到了很好的效果。

与深度学习相比,强化学习更加注重智能体与环境的交互过程。

强化学习的核心是马尔可夫决策过程(MDP)。

MDP通过状态、动作、奖励和转移概率等要素来描述智能体与环境的交互过程。

为了优化决策策略,强化学习中常用的算法是Q-learning和策略梯度方法。

Q-learning是一种基于值函数的强化学习算法。

它通过迭代更新状态-动作值函数Q值,使得智能体能够选择最优的动作。

在Q-learning中,通过采用贪心策略或ε-greedy策略来选择动作,智能体能够在不断试错中学习到最优策略。

此外,还有一些改进的Q-learning算法,如Double Q-learning和Deep Q-learning等,能够进一步提高学习效果。

李宏毅2021春机器学习课程笔记——生成对抗模型模型

李宏毅2021春机器学习课程笔记——⽣成对抗模型模型本⽂作为⾃⼰学习李宏毅⽼师2021春机器学习课程所做笔记,记录⾃⼰⾝为⼊门阶段⼩⽩的学习理解,如果错漏、建议,还请各位博友不吝指教,感谢!!概率⽣成模型概率⽣成模型(Probabilistic Generative Model)简称⽣成模型,指⼀系列⽤于随机⽣成可观测数据的模型。

假设在⼀个连续或离散的⾼维空间\(\mathcal{X}\)中,存在⼀个随机向量\(X\)服从⼀个未知的数据分布\(p_r(x), x \in\mathcal{X}\)。

⽣成模型根据⼀些可观测的样本\(x^{(1)},x^{(2)}, \cdots ,x^{(N)}\)来学习⼀个参数化的模型\(p_\theta(x)\)来近似未知分布\(p_r(x)\),并可以⽤这个模型来⽣成⼀些样本,使得⽣成的样本和真实的样本尽可能地相似。

⽣成模型的两个基本功能:概率密度估计和⽣成样本(即采样)。

隐式密度模型在⽣成模型的⽣成样本功能中,如果只是希望⼀个模型能⽣成符合数据分布\(p_r(x)\)的样本,可以不显⽰的估计出数据分布的密度函数。

假设在低维空间\(\mathcal{Z}\)中有⼀个简单容易采样的分布\(p(z)\),\(p(z)\)通常为标准多元正态分布\(\mathcal{N}(0,I)\),我们⽤神经⽹络构建⼀个映射函数\(G : \mathcal{Z} \rightarrow \mathcal{X}\),称为⽣成⽹络。

利⽤神经⽹络强⼤的拟合能⼒,使得\(G(z)\)服从数据分布\(p_r(x)\)。

这种模型就称为隐式密度模型(Implicit Density Model)。

隐式密度模型⽣成样本的过程如下图所⽰:⽣成对抗⽹络⽣成对抗⽹络(Generative Adversarial Networks,GAN)是⼀种隐式密度模型,包括判别⽹络(Discriminator Network)和⽣成⽹络(Generator Network)两个部分,通过对抗训练的⽅式来使得⽣成⽹络产⽣的样本服从真实数据分布。

李宏毅深度学习笔记-半监督学习

李宏毅深度学习笔记-半监督学习半监督学习什么是半监督学习?⼤家知道在监督学习⾥,有⼀⼤堆的训练数据(由input和output对组成)。

例如上图所⽰x r是⼀张图⽚,y r是类别的label。

半监督学习是说,在label数据上⾯,有另外⼀组unlabeled的数据,写成x u (只有input没有output),有U笔ublabeled的数据。

通常做半监督学习的时候,我们常见的情景是ublabeled的数量远⼤于labeled的数量(U>>R)。

半监督学习可以分成两种:⼀种叫做转换学习,ublabeled 数据就是testing set,使⽤的是testing set的特征。

另⼀种是归纳学习,不考虑testing set,学习model的时候不使⽤testing set。

unlabeled数据作为testing set,不是相当于⽤到了未来数据吗?⽤了label 才算是⽤了未来数据,⽤了testing set的特征就不算是使⽤了未来数据。

例如图⽚,testing set的图⽚特征是可以⽤的,但是不能⽤label。

什么时候使⽤转换学习或者归纳学习?看testing set是不是给你了,在⼀些⽐赛⾥,testing set给你了,那么就可以使⽤转换学习。

但在真正的应⽤中,⼀般是没有testing set的,这时候就只能做归纳学习。

为什么使⽤半监督学习?缺有lable的数据,⽐如图⽚,收集图⽚很容易,但是标注label很困难。

半监督学习利⽤未标注数据做⼀些事。

对⼈类来说,可能也是⼀直在做半监督学习,⽐如⼩孩⼦会从⽗母那边做⼀些监督学习,看到⼀条狗,问⽗亲是什么,⽗亲说是狗。

之后⼩孩⼦会看到其他东西,有狗有猫,没有⼈会告诉他这些动物是什么,需要⾃⼰学出来。

为什么半监督学习有⽤?假设现在做分类任务,建⼀个猫和狗的分类器。

有⼀⼤堆猫和狗的图⽚,这些图⽚没有label。

Processing math: 100%假设只考虑有label的猫和狗图⽚,要画⼀个边界,把猫和狗训练数据集分开,可能会画⼀条如上图所⽰的红⾊竖线。

李宏毅深度学习(一):深度学习模型的基本结构

李宏毅深度学习(⼀):深度学习模型的基本结构李宏毅深度学习(⼀):深度学习模型的基本结构转⾃简书的⼀位⼤神博主:下⾯开始正题吧!1、全连接神经⽹络(Fully Connected Structure)最基本的神经⽹络⾮全连接神经⽹络莫属了,在图中,a是神经元的输出,l代表层数,i代表第i个神经元。

两层神经元之间两两连接,注意这⾥的w代表每条线上的权重,如果是第l-1层连接到l层,w的上标是l,下表ij代表了第l-1层的第j个神经元连接到第l层的第i个神经元,这⾥与我们的尝试似乎不太⼀样,不过并⽆⼤碍。

所以两层之间的连接矩阵可以写为如下的形式:每⼀个神经元都有⼀个偏置项:这个值记为z,即该神经元的输⼊。

如果写成矩阵形式如下图:针对输⼊z,我们经过⼀个激活函数得到输出a:常见的激活函数有:这⾥介绍三个:sigmoidSigmoid 是常⽤的⾮线性的激活函数,它的数学形式如下:特别的,如果是⾮常⼤的负数,那么输出就是0;如果是⾮常⼤的正数,输出就是1,如下图所⽰:.sigmoid 函数曾经被使⽤的很多,不过近年来,⽤它的⼈越来越少了。

主要是因为它的⼀些 缺点:**Sigmoids saturate and kill gradients. **(saturate 这个词怎么翻译?饱和?)sigmoid 有⼀个⾮常致命的缺点,当输⼊⾮常⼤或者⾮常⼩的时候(saturation),这些神经元的梯度是接近于0的,从图中可以看出梯度的趋势。

所以,你需要尤其注意参数的初始值来尽量避免saturation的情况。

如果你的初始值很⼤的话,⼤部分神经元可能都会处在saturation的状态⽽把gradient kill掉,这会导致⽹络变的很难学习。

Sigmoid 的 output 不是0均值. 这是不可取的,因为这会导致后⼀层的神经元将得到上⼀层输出的⾮0均值的信号作为输⼊。

产⽣的⼀个结果就是:如果数据进⼊神经元的时候是正的(e.g. x>0 elementwise in f=wTx+b),那么 w 计算出的梯度也会始终都是正的。

李宏毅-B站机器学习视频课件BP全

Gradient Descent

Network parameters

Starting

0

Parameters

L

L w1

L w

2

L b1

L b2

w1 , w2 ,, b1 , b2 ,

b

4

2

=

′

’’

′ ′′

(Chain rule)

=

+

′ ′′

Assumed

?

?

3

4

it’s known

Backpropagation – Backward pass

Compute Τ for all activation function inputs z

Chain Rule

y g x

Case 1

z h y

x y z

Case 2

x g s

y hs

x

s

z

y

dz dz dy

dx dy dx

z k x, y

dz z dx z dy

ds x ds y ds

Backpropagation

2

Compute Τ for all parameters

Backward pass:

Compute Τ for all activation

function inputs z

Backpropagation – Forward pass

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

演讲完毕,谢谢听讲!

再见,see you again

2020/11/14

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

谢 谢 大 家!!!

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学Байду номын сангаас基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学 习基本思路

2020/11/14

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路

台湾李宏毅教授深度学习基本思路