hdfs的操作命令大全

hadoop命令及使用方法

hadoop命令及使用方法Hadoop是一个分布式计算框架,用于存储和处理大规模数据集。

下面是一些常用的Hadoop命令及其使用方法:1. hdfs命令:- hdfs dfs -ls <路径>:列出指定路径下的文件和目录。

- hdfs dfs -mkdir <路径>:创建一个新的目录。

- hdfs dfs -copyFromLocal <本地路径> <HDFS路径>:将本地文件复制到HDFS 上。

- hdfs dfs -copyToLocal <HDFS路径> <本地路径>:将HDFS上的文件复制到本地。

- hdfs dfs -cat <文件路径>:显示HDFS上的文件内容。

2. mapred命令:- mapred job -list:列出当前正在运行的MapReduce作业。

- mapred job -kill <job_id>:终止指定的MapReduce作业。

3. yarn命令:- yarn application -list:列出当前正在运行的应用程序。

- yarn application -kill <application_id>:终止指定的应用程序。

4. hadoop fs命令(与hdfs dfs命令功能相似):- hadoop fs -ls <路径>:列出指定路径下的文件和目录。

- hadoop fs -cat <文件路径>:显示HDFS上的文件内容。

- hadoop fs -mkdir <路径>:创建一个新的目录。

- hadoop fs -put <本地文件路径> <HDFS路径>:将本地文件复制到HDFS上。

- hadoop fs -get <HDFS路径> <本地文件路径>:将HDFS上的文件复制到本地。

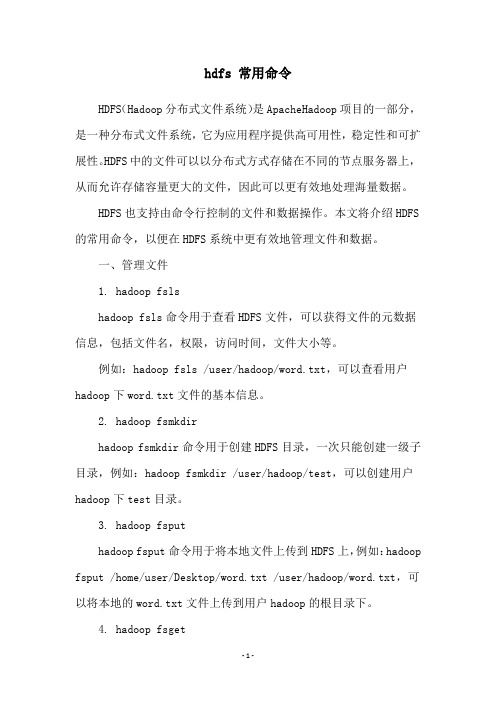

hdfs 常用命令

hdfs 常用命令HDFS(Hadoop分布式文件系统)是ApacheHadoop项目的一部分,是一种分布式文件系统,它为应用程序提供高可用性,稳定性和可扩展性。

HDFS中的文件可以以分布式方式存储在不同的节点服务器上,从而允许存储容量更大的文件,因此可以更有效地处理海量数据。

HDFS也支持由命令行控制的文件和数据操作。

本文将介绍HDFS 的常用命令,以便在HDFS系统中更有效地管理文件和数据。

一、管理文件1. hadoop fslshadoop fsls命令用于查看HDFS文件,可以获得文件的元数据信息,包括文件名,权限,访问时间,文件大小等。

例如:hadoop fsls /user/hadoop/word.txt,可以查看用户hadoop下word.txt文件的基本信息。

2. hadoop fsmkdirhadoop fsmkdir命令用于创建HDFS目录,一次只能创建一级子目录,例如:hadoop fsmkdir /user/hadoop/test,可以创建用户hadoop下test目录。

3. hadoop fsputhadoop fsput命令用于将本地文件上传到HDFS上,例如:hadoop fsput /home/user/Desktop/word.txt /user/hadoop/word.txt,可以将本地的word.txt文件上传到用户hadoop的根目录下。

4. hadoop fsgethadoop fsget命令用于从HDFS上下载文件到本地,例如:hadoop fsget /user/hadoop/test/test.txt /home/user/Desktop/test.txt,可以将用户hadoop下test目录下的test.txt文件下载到本地桌面。

5. hadoop fsrmhadoop fsrm命令用于删除HDFS中的文件,例如:hadoop fsrm /user/hadoop/word.txt,可以删除用户hadoop下的word.txt文件。

hdfs操作方法

hdfs操作方法Hadoop Distributed File System (HDFS)是Hadoop框架中的一部分,它是一个可伸缩、可靠的分布式文件系统。

HDFS设计用于处理大数据集,提供了高吞吐量的数据访问以及数据冗余和容错功能。

以下是HDFS的一些常见操作方法。

1.文件系统操作:- 创建目录:使用hadoop fs -mkdir命令来创建一个新的目录。

例如,hadoop fs -mkdir /user/mydirectory。

- 上传文件:使用hadoop fs -put命令将本地文件上传到HDFS中。

例如,hadoop fs -put myfile.txt /user/mydirectory。

- 列出文件/目录:使用hadoop fs -ls命令列出HDFS中的文件和目录。

例如,hadoop fs -ls /user/mydirectory。

- 删除文件/目录:使用hadoop fs -rm命令删除HDFS中的文件或目录。

例如,hadoop fs -rm /user/mydirectory/myfile.txt。

2.文件操作:- 读取文件:使用hadoop fs -cat命令来读取HDFS中的文件内容。

例如,hadoop fs -cat /user/mydirectory/myfile.txt。

- 复制文件:使用hadoop fs -cp命令在HDFS中复制文件。

例如,hadoop fs -cp /user/mydirectory/myfile.txt/user/newdirectory/myfile.txt。

- 移动文件:使用hadoop fs -mv命令将文件从一个目录移动到另一个目录。

例如,hadoop fs -mv /user/mydirectory/myfile.txt/user/newdirectory/myfile.txt。

- 修改文件名:使用hadoop fs -mv命令将文件改名。

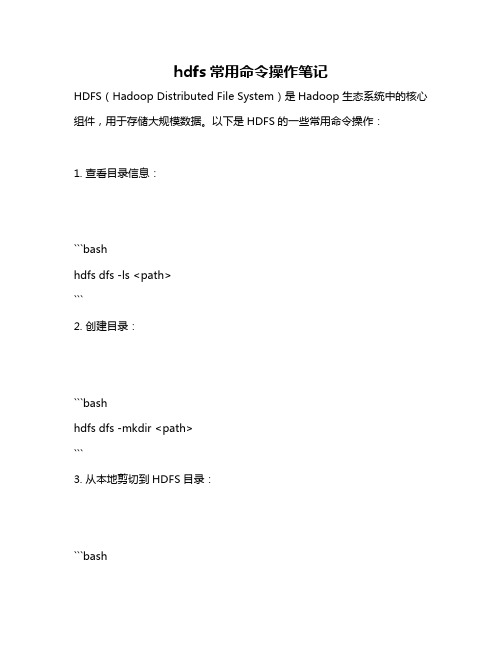

hdfs常用命令操作笔记

hdfs常用命令操作笔记HDFS(Hadoop Distributed File System)是Hadoop生态系统中的核心组件,用于存储大规模数据。

以下是HDFS的一些常用命令操作:1. 查看目录信息:```bashhdfs dfs -ls <path>```2. 创建目录:```bashhdfs dfs -mkdir <path>```3. 从本地剪切到HDFS目录:```bash```4. 追加文件到已存在的文件末尾:```bashhdfs dfs -appendToFile <local_path> <hdfs_path>```5. 显示文件内容:```bashhdfs dfs -cat <path>```6. 修改文件所属权限(`-chgrp`、`-chmod`、`-chown`):这些命令类似于Linux文件系统中的用法,用于修改文件所属的组、权限和所有者。

7. 从本地路径复制文件到HDFS:```bash```8. 从HDFS复制文件到本地:```bashhdfs dfs -copyToLocal <hdfs_path> <local_path> ```9. 在HDFS中复制文件到另一个路径:```bashhdfs dfs -cp <src_path> <dest_path>```10. 在HDFS中移动文件:```bashhdfs dfs -mv <src_path> <dest_path>```11. 删除文件或文件夹:注意:删除操作是不可逆的,请谨慎操作。

如果要删除文件夹及其内容,需要添加`-r`选项。

```bashhdfs dfs -rm <path>```12. 查看文件的末尾内容:这个命令类似于Unix的`tail`命令,可以查看文件的最后几行。

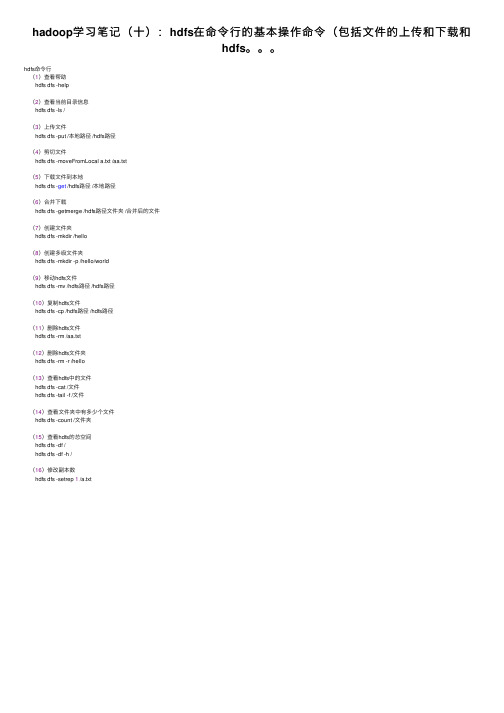

hadoop学习笔记(十):hdfs在命令行的基本操作命令(包括文件的上传和下载和hdfs。。。

hadoop学习笔记(⼗):hdfs在命令⾏的基本操作命令(包括⽂件的上传和下载和

hdfs。

hdfs命令⾏

(1)查看帮助

hdfs dfs -help

(2)查看当前⽬录信息

hdfs dfs -ls /

(3)上传⽂件

hdfs dfs -put /本地路径 /hdfs路径

(4)剪切⽂件

hdfs dfs -moveFromLocal a.txt /aa.txt

(5)下载⽂件到本地

hdfs dfs -get /hdfs路径 /本地路径

(6)合并下载

hdfs dfs -getmerge /hdfs路径⽂件夹 /合并后的⽂件

(7)创建⽂件夹

hdfs dfs -mkdir /hello

(8)创建多级⽂件夹

hdfs dfs -mkdir -p /hello/world

(9)移动hdfs⽂件

hdfs dfs -mv /hdfs路径 /hdfs路径

(10)复制hdfs⽂件

hdfs dfs -cp /hdfs路径 /hdfs路径

(11)删除hdfs⽂件

hdfs dfs -rm /aa.txt

(12)删除hdfs⽂件夹

hdfs dfs -rm -r /hello

(13)查看hdfs中的⽂件

hdfs dfs -cat /⽂件

hdfs dfs -tail -f /⽂件

(14)查看⽂件夹中有多少个⽂件

hdfs dfs -count /⽂件夹

(15)查看hdfs的总空间

hdfs dfs -df /

hdfs dfs -df -h /

(16)修改副本数

hdfs dfs -setrep 1 /a.txt。

HDFS基本操作

HDFS基本操作HDFS(Hadoop Distributed File System)是Hadoop生态系统中的一个关键组件,用于在大规模集群上存储和处理大数据集。

HDFS采用分布式文件存储的方式,将大文件切分成多个块,并分散存储在多个计算节点上,从而实现高容错性和高吞吐量的数据存储。

在使用HDFS进行文件操作时,可以通过命令行工具或者API进行操作。

下面是HDFS的一些基本操作:1. 查看文件系统状态:使用"hdfs dfsadmin -report"命令可以查看HDFS的整体状态,包括存储容量、副本数量、节点状态等。

2. 创建目录:使用"hdfs dfs -mkdir"命令可以在HDFS中创建新目录。

例如,可以使用"hdfs dfs -mkdir /data"命令创建一个名为"data"的目录。

3. 上传文件:使用"hdfs dfs -put"命令可以将本地文件上传到HDFS中。

例如,可以使用"hdfs dfs -put local_file hdfs_path"命令将名为"local_file"的本地文件上传到"HDFS_path"路径下。

5. 复制文件:使用"hdfs dfs -cp"命令可以复制HDFS中的文件。

例如,可以使用"hdfs dfs -cp source_file target_file"命令将"source_file"文件复制到"target_file"。

6. 移动文件:使用"hdfs dfs -mv"命令可以移动HDFS中的文件。

例如,可以使用"hdfs dfs -mv source_file target_file"命令将"source_file"文件移动到"target_file"。

HDFS常用命令总结

HDFS常⽤命令总结⽂章⽬录课程⼤纲(HDFS详解)学习⽬标:HDFS基本概念篇1.1HDFS前⾔1.2HDFS的概念和特性HDFS基本操作篇2.1HDFS的shell(命令⾏客户端)操作2.1.1 HDFS命令⾏客户端使⽤2.2 命令⾏客户端⽀持的命令参数2.3 常⽤命令参数介绍HDFS原理篇hdfs的⼯作机制3.1 概述3.2 HDFS写数据流程3.2.1 概述3.2.2 详细步骤图3.2.3 详细步骤解析3.3. HDFS读数据流程3.3.1 概述3.3.2 详细步骤图3.3.3 详细步骤解析4 NAMENODE⼯作机制4.1 NAMENODE职责4.2 元数据管理4.2.1 元数据存储机制(元数据是对象,有特定的数据结构,可以理解为hashmap结构)4.2.2 元数据⼿动查看4.2.3 元数据的checkpoint4.2.4 元数据⽬录说明5 DATANODE的⼯作机制5.1 概述5.2 观察验证DATANODE功能5.3元数据⽬录(⾃⼰添加,实测有效)HDFS应⽤开发篇6. HDFS的java操作6.1 搭建开发环境6.2 获取api中的客户端对象6.3 DistributedFileSystem实例对象所具备的⽅法6.4 HDFS客户端操作数据代码⽰例:6.4.1 ⽂件的增删改查6.4.2 通过流的⽅式访问hdfs6.4.3 场景编程7. 案例1:开发shell采集脚本7.1需求说明7.2需求分析7.3技术分析7.4实现流程7.4.1⽇志产⽣程序7.4.2伪代码7.5代码实现7.6效果展⽰及操作步骤8. 案例2:开发JAVA采集程序8.1 需求8.2 设计分析HDFS基本概念篇1.1HDFS前⾔设计思想 分⽽治之:将⼤⽂件、⼤批量⽂件,分布式存放在⼤量服务器上,以便于采取分⽽治之的⽅式对海量数据进⾏运算分析; 在⼤数据系统中作⽤: 为各类分布式运算框架(如:mapreduce,spark,tez,……)提供数据存储服务 重点概念:⽂件切块,副本存放,元数据 补充: hdfs是架在本地⽂件系统上⾯的分布式⽂件系统,它就是个软件,也就是⽤⼀套代码把底下所有机器的硬盘变成⼀个软件下的⽬录,和mysql没有什么区别,思想⼀样。

hdfs操作常用的shell命令实验总结

hdfs操作常用的shell命令实验总结在Hadoop分布式文件系统(HDFS)中,有一些常用的Shell命令可帮助用户管理和操作文件。

本文将总结几个常用的HDFS Shell命令及其功能。

1. ls命令ls命令用于列出指定目录中的文件和子目录。

通过使用ls命令,可以快速查看HDFS中的文件结构,并确定文件和目录的权限、大小和修改日期。

2. mkdir命令mkdir命令用于创建一个新的HDFS目录。

可以使用该命令在指定路径下创建一个新的目录,以便于组织和存储文件。

3. put命令put命令用于将本地文件上传到HDFS中的指定位置。

可以使用put命令将本地系统中的文件复制到HDFS,以便于后续的处理和分析。

4. get命令get命令用于将HDFS中的文件下载到本地系统。

使用get命令可以将HDFS上的文件复制到本地,方便离线查看和处理。

5. rm命令rm命令用于删除HDFS中的文件或目录。

可以使用rm命令删除不再需要的文件或目录,释放存储空间。

6. mv命令mv命令用于移动HDFS中的文件或目录,并可更改名称。

通过使用mv命令,可以重新组织HDFS中的文件结构,或更改文件的命名。

7. cat命令cat命令用于打印HDFS中文件的内容到标准输出。

可以使用cat命令快速查看文件的内容,对文件进行简单的检查。

8. chmod命令chmod命令用于更改HDFS中文件或目录的权限。

通过使用chmod命令,可以为文件或目录设置适当的权限,以确保数据的安全性和可访问性。

总之,以上提到的命令是HDFS操作中常用的一些Shell命令。

它们能够帮助用户管理和操作HDFS中的文件和目录,方便数据的存储、上传、下载、删除、移动和查看。

这些命令是Hadoop生态系统中不可或缺的一部分,对于大规模数据处理和分析具有重要的作用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

转载:/jrckkyy/blog/item/982b15869490122966096ee6.html调用文件系统(FS)Shell命令应使用 bin/hadoop fs <args>的形式。

所有的的FS shell命令使用URI路径作为参数。

URI格式是scheme://authority/path。

对HDFS文件系统,scheme是hdfs,对本地文件系统,scheme是file。

其中scheme 和authority参数都是可选的,如果未加指定,就会使用配置中指定的默认scheme。

一个HDFS文件或目录比如/parent/child可以表示成hdfs://namenode:namenodeport/parent/child,或者更简单的/parent/child (假设你配置文件中的默认值是namenode:namenodeport)。

大多数FS Shell 命令的行为和对应的Unix Shell命令类似,不同之处会在下面介绍各命令使用详情时指出。

出错信息会输出到stderr,其他信息输出到stdout。

cat使用方法:hadoop fs -cat URI [URI …]将路径指定文件的内容输出到stdout。

示例:hadoop fs -cat hdfs://host1:port1/file1 hdfs://host2:port2/file2 hadoop fs -cat file:///file3 /user/hadoop/file4返回值:成功返回0,失败返回-1。

chgrp使用方法:hadoop fs -chgrp [-R] GROUP URI [URI …] Change group association of files. With -R, make the change recursively through the directory structure. The user must be the owner of files, or else a super-user. Additional information is in the Permissions User Guide. -->改变文件所属的组。

使用-R将使改变在目录结构下递归进行。

命令的使用者必须是文件的所有者或者超级用户。

更多的信息请参见HDFS权限用户指南。

chmod使用方法:hadoop fs -chmod [-R] <MODE[,MODE]... | OCTALMODE> URI [URI …]改变文件的权限。

使用-R将使改变在目录结构下递归进行。

命令的使用者必须是文件的所有者或者超级用户。

更多的信息请参见HDFS权限用户指南。

chown使用方法:hadoop fs -chown [-R] [OWNER][:[GROUP]] URI [URI ]改变文件的拥有者。

使用-R将使改变在目录结构下递归进行。

命令的使用者必须是超级用户。

更多的信息请参见HDFS权限用户指南。

copyFromLocal使用方法:hadoop fs -copyFromLocal <localsrc> URI除了限定源路径是一个本地文件外,和put命令相似。

copyToLocal使用方法:hadoop fs -copyToLocal [-ignorecrc] [-crc] URI <localdst>除了限定目标路径是一个本地文件外,和get命令类似。

cp使用方法:hadoop fs -cp URI [URI …] <dest>将文件从源路径复制到目标路径。

这个命令允许有多个源路径,此时目标路径必须是一个目录。

示例:hadoop fs -cp /user/hadoop/file1 /user/hadoop/file2hadoop fs -cp /user/hadoop/file1 /user/hadoop/file2 /user/hadoop/dir 返回值:成功返回0,失败返回-1。

du使用方法:hadoop fs -du URI [URI …]显示目录中所有文件的大小,或者当只指定一个文件时,显示此文件的大小。

示例:hadoop fs -du /user/hadoop/dir1 /user/hadoop/file1hdfs://host:port/user/hadoop/dir1返回值:成功返回0,失败返回-1。

dus使用方法:hadoop fs -dus <args>显示文件的大小。

expunge使用方法:hadoop fs -expunge清空回收站。

请参考HDFS设计文档以获取更多关于回收站特性的信息。

get使用方法:hadoop fs -get [-ignorecrc] [-crc] <src> <localdst>复制文件到本地文件系统。

可用-ignorecrc选项复制CRC校验失败的文件。

使用-crc选项复制文件以及CRC信息。

示例:hadoop fs -get /user/hadoop/file localfilehadoop fs -get hdfs://host:port/user/hadoop/file localfile返回值:成功返回0,失败返回-1。

getmerge使用方法:hadoop fs -getmerge <src> <localdst> [addnl]接受一个源目录和一个目标文件作为输入,并且将源目录中所有的文件连接成本地目标文件。

addnl是可选的,用于指定在每个文件结尾添加一个换行符。

ls使用方法:hadoop fs -ls <args>如果是文件,则按照如下格式返回文件信息:文件名 <副本数> 文件大小修改日期修改时间权限用户ID 组ID如果是目录,则返回它直接子文件的一个列表,就像在Unix中一样。

目录返回列表的信息如下:目录名 <dir> 修改日期修改时间权限用户ID 组ID示例:hadoop fs -ls /user/hadoop/file1 /user/hadoop/file2hdfs://host:port/user/hadoop/dir1 /nonexistentfile返回值:成功返回0,失败返回-1。

lsr使用方法:hadoop fs -lsr <args>ls命令的递归版本。

类似于Unix中的ls -R。

mkdir使用方法:hadoop fs -mkdir <paths>接受路径指定的uri作为参数,创建这些目录。

其行为类似于Unix的mkdir -p,它会创建路径中的各级父目录。

示例:hadoop fs -mkdir /user/hadoop/dir1 /user/hadoop/dir2hadoop fs -mkdir hdfs://host1:port1/user/hadoop/dirhdfs://host2:port2/user/hadoop/dir返回值:成功返回0,失败返回-1。

movefromLocal使用方法:dfs -moveFromLocal <src> <dst>输出一个”not implemented“信息。

mv使用方法:hadoop fs -mv URI [URI …] <dest>将文件从源路径移动到目标路径。

这个命令允许有多个源路径,此时目标路径必须是一个目录。

不允许在不同的文件系统间移动文件。

示例:hadoop fs -mv /user/hadoop/file1 /user/hadoop/file2hadoop fs -mv hdfs://host:port/file1 hdfs://host:port/file2hdfs://host:port/file3 hdfs://host:port/dir1返回值:成功返回0,失败返回-1。

put使用方法:hadoop fs -put <localsrc> ... <dst>从本地文件系统中复制单个或多个源路径到目标文件系统。

也支持从标准输入中读取输入写入目标文件系统。

hadoop fs -put localfile /user/hadoop/hadoopfilehadoop fs -put localfile1 localfile2 /user/hadoop/hadoopdir hadoop fs -put localfile hdfs://host:port/hadoop/hadoopfile hadoop fs -put - hdfs://host:port/hadoop/hadoopfile从标准输入中读取输入。

返回值:成功返回0,失败返回-1。

rm使用方法:hadoop fs -rm URI [URI …]删除指定的文件。

只删除非空目录和文件。

请参考rmr命令了解递归删除。

示例:hadoop fs -rm hdfs://host:port/file /user/hadoop/emptydir返回值:成功返回0,失败返回-1。

rmr使用方法:hadoop fs -rmr URI [URI …]delete的递归版本。

示例:hadoop fs -rmr /user/hadoop/dirhadoop fs -rmr hdfs://host:port/user/hadoop/dir返回值:成功返回0,失败返回-1。

setrep使用方法:hadoop fs -setrep [-R] <path>改变一个文件的副本系数。

-R选项用于递归改变目录下所有文件的副本系数。

示例:hadoop fs -setrep -w 3 -R /user/hadoop/dir1返回值:成功返回0,失败返回-1。

stat使用方法:hadoop fs -stat URI [URI …]返回指定路径的统计信息。

示例:hadoop fs -stat path返回值:成功返回0,失败返回-1。

tail使用方法:hadoop fs -tail [-f] URI将文件尾部1K字节的内容输出到stdout。

支持-f选项,行为和Unix中一致。

示例:hadoop fs -tail pathname返回值:成功返回0,失败返回-1。

test使用方法:hadoop fs -test -[ezd] URI选项:-e 检查文件是否存在。

如果存在则返回0。

-z 检查文件是否是0字节。

如果是则返回0。

-d 如果路径是个目录,则返回1,否则返回0。