数据挖掘十大经典算法(第六章)

数据挖掘10大经典算法

数据挖掘10大经典算法

1. K-均值聚类算法:将数据集分成k个簇,使得同簇的样本之间的距离最小化。

2. 支持向量机算法:通过定义分类超平面来实现分类任务,使得超平面到两类样本的最小距离最大化。

3. 决策树算法:通过一系列的决策规则对样本进行分类或预测。

4. 朴素贝叶斯算法:基于贝叶斯定理,通过计算样本的概率来进行分类或预测。

5. 随机森林算法:通过构建多个决策树,然后集成这些决策树的结果来进行分类或预测。

6. AdaBoost算法:通过序列化训练和集成多个弱分类器,来实现更准确的分类。

7. 主成分分析算法:通过线性变换将高维数据转化为低维数据,同时保留原始数据的主要信息。

8. Apriori算法:用于挖掘关联规则的算法,通过发现频繁项集来确定项集之间的关联性。

9. 线性回归算法:通过拟合数据集中的线性模型,并预测因变量的值。

10. 基于规则的分类算法:通过对事先定义的规则进行匹配和判断,来进行分类任务。

数据挖掘十大经典算法

数据挖掘十大经典算法数据挖掘是一种通过计算机科学的方法,从大量数据中挖掘出有用的信息和知识的过程。

在这个过程中,数据挖掘算法扮演着非常重要的角色,它们能够帮助我们从数据中抽取出精华,更好地理解和利用数据。

下面是十大经典数据挖掘算法。

1. K-Means算法:K-Means算法是一种聚类算法,可以将数据集分成K个不同的类别。

这种算法的基本思想是将数据分成若干个类别,使得同一类别内的数据点的距离比其他类别内的数据点的距离更短。

2. Apriori算法:Apriori算法是一种关联规则挖掘算法,可以用来发现最常见的数据项之间的关联性。

这种算法基于频繁项集的概念,通过计算数据中频繁项集的支持度和置信度来挖掘关联规则。

3. 决策树算法:决策树算法是一种基于树结构的分类算法,可以将数据集分成若干个不同的类别。

这种算法的基本思想是通过递归地将数据集划分成不同的子集,直到子集中所有数据都属于同一类别为止。

4. SVM算法:SVM算法是一种基于统计学习理论的分类算法,可以用于解决非线性问题。

这种算法的基本思想是将数据集映射到高维空间中,然后在高维空间中建立超平面,将不同类别的数据分开。

5. 神经网络算法:神经网络算法是一种模拟人脑神经系统的分类算法,可以用来处理非线性问题。

这种算法的基本思想是通过构建一个多层的神经网络,将输入数据映射到输出数据。

6. 贝叶斯分类算法:贝叶斯分类算法是一种基于贝叶斯定理的分类算法,可以用来预测数据的类别。

这种算法的基本思想是根据已知数据的先验概率和新数据的特征,计算这个数据属于不同类别的概率,然后选择概率最大的类别作为预测结果。

7. 随机森林算法:随机森林算法是一种基于决策树的集成算法,可以用来处理大量的数据和高维数据。

这种算法的基本思想是通过随机选取特征和样本,构建多个决策树,然后将多个决策树的结果汇总,得到最终的分类结果。

8. Adaboost算法:Adaboost算法是一种基于加权的集成算法,可以用来提高分类算法的准确率。

数据挖掘十大算法

5、群集侦测技术(Cluster Detection)

这个技术涵盖范围相当广泛,包含基因算法、类神经网络、统计学中的群集分析都有这个功能。它的目标为找出数据中以前未知的相似群体,在许许多多的分析中,刚开始都运用到群集侦测技术,以作为研究的开端。

6、连结分析(Link Analysis)

(1) 找出预测变量的线性组合,使组间变异相对于组内变异的比值为最大,而每一个线性组合与先前已经获得的线性组合均不相关。 yixieshi

(2) 检定各组的重心是否有差异。 yixieshi

(3) 找出哪些预测变量具有最大的区别能力。

(4) 根据新受试者的预测变量数值,将该受试者指派到某一群体。

9、区别分析(Discriminant Analysis)

当所遭遇问题它的因变量为定性(categorical),而自变量(预测变量)为定量(metric)时,区别分析为一非常适当之技术,通常应用在解决分类的问题上面。若因变量由两个群体所构成,称之为双群体 — 区别分析 (Two-Group Discriminant Analysis);若由多个群体构成,则称之为多元区别分析(Multiple Discriminant Analysis;MDA)。

7、在线分析处理(On-Line Analytic Processing;OLAP)

严格说起来,在线分析处理并不算特别的一个数据挖掘技术,但是透过在线分析处理工具,使用者能更清楚的了解数据所隐藏的潜在意涵。如同一些视觉处理技术一般,透过图表或图形等方式显现,对一般人而言,感觉会更友善。这样的工具亦能辅助将数据转变成信息的目标。 互联网的一些事

3、决策树(Decision Trees) yixieshi

决策树在解决归类与预测上有着极强的能力,它以法则的方式表达,而这些法则则以一连串的问题表示出来,经由不断询问问题最终能导出所需的结果。典型的决策树顶端是一个树根,底部有许多的树叶,它将纪录分解成不同的子集,每个子集中的字段可能都包含一个简单的法则。此外,决策树可能有着不同的外型,例如二元树、三元树或混和的决策树型态。

数据挖掘领域的十大经典算法原理及应用

数据挖掘领域的十大经典算法原理及应用数据挖掘是指从大量的数据中发现关联规则、分类模型、聚类模型等有用的信息的过程。

以下是数据挖掘领域的十大经典算法原理及应用:1. 决策树算法(Decision Tree)决策树是一种基于树形结构的分类模型,它通过构建树来将输入数据集划分为不同的类别。

决策树算法在金融风险评估、医疗诊断等领域有广泛应用。

2. 支持向量机算法(Support Vector Machine,SVM)支持向量机是一种二分类模型,其目标是在高维空间中找到一个最优的超平面,将不同类别的样本分离开来。

SVM在图像识别、文本分类等领域有广泛应用。

3. 神经网络算法(Neural Network)神经网络模拟人脑的工作原理,通过连接众多的神经元来完成学习和预测任务。

神经网络在图像处理、自然语言处理等领域有广泛应用。

4. 朴素贝叶斯算法(Naive Bayes)朴素贝叶斯算法是一种基于贝叶斯定理的统计分类方法,它假设所有特征之间相互独立,并通过计算后验概率来进行分类。

朴素贝叶斯在垃圾邮件过滤、文本分类等领域有广泛应用。

5. K均值聚类算法(K-means Clustering)K均值聚类是一种无监督学习算法,它通过将样本分成K个簇来实现数据的聚类。

K均值聚类在市场细分、客户群体分析等领域有广泛应用。

6. Apriori算法Apriori算法是一种频繁项集挖掘算法,它可以找出数据集中项之间的关联关系。

Apriori算法在购物篮分析、推荐系统等领域有广泛应用。

7. PageRank算法PageRank算法是一种用于网页排序的算法,它通过计算网页之间的链接关系来确定网页的重要性。

PageRank算法在引擎领域有广泛应用。

8. 随机森林算法(Random Forest)随机森林是一种集成学习算法,它通过构建多个决策树,并通过投票方式来进行分类或回归。

随机森林在金融风险评估、信用评分等领域有广泛应用。

9. AdaBoost算法AdaBoost是一种迭代的强学习算法,它通过调整样本权重来训练多个弱分类器,并通过加权投票方式来进行分类。

数据挖掘领域中的10大算法

数据挖掘领域中的10大算法在当今数字化社会中,数据挖掘已经成为了广泛应用的一种技术手段。

它可以从海量数据中提取出人们所需要的信息,帮助人们做出更加科学的决策和规划。

随着技术的发展,数据挖掘的应用领域也越来越广泛,其中的算法也日益丰富多彩。

今天,我们就来介绍一下数据挖掘领域中的10大算法。

一、C4.5算法C4.5算法是一种基于决策树的分类算法。

它通过对数据的分析和建模,可以从中得出一系列决策规则。

C4.5算法被广泛应用于分类和预测领域,尤其在电子商务和金融领域中应用较为广泛。

二、朴素贝叶斯算法朴素贝叶斯算法是一种基于贝叶斯定理的分类算法。

它通过概率论来描述事物之间的关系,从而实现对数据的分类和预测。

朴素贝叶斯算法在数据挖掘领域中被广泛应用,尤其在文本分类和垃圾邮件过滤等方面应用非常广泛。

三、Apriori算法Apriori算法是一种基于频繁项集的关联规则挖掘算法。

它通过扫描数据集来查找频繁项集,并基于频繁项集构造出关联规则。

Apriori算法在电子商务和市场营销领域中被广泛应用,可以帮助人们了解顾客的购买决策,进行目标市场的选定等工作。

四、K-Means算法K-Means算法是一种基于聚类的数据挖掘算法。

它通过将数据划分为多个簇,使得同一簇内的数据彼此相似,不同簇内的数据彼此不同。

K-Means算法被广泛应用于数据分析和聚类分析等领域。

五、支持向量机算法支持向量机算法是一种基于分类和回归分析的算法。

它通过构造超平面来将数据划分为不同类别,从而实现对数据的识别和分类。

支持向量机算法在数据挖掘领域中被广泛应用,例如图像识别和文本分类等方面。

六、随机森林算法随机森林算法是一种基于决策树的集成学习算法。

它通过将多个决策树组合在一起,从而实现对数据的分类和预测。

随机森林算法在数据挖掘领域中被广泛应用,例如金融风险评估和医学诊断等方面。

七、多层感知器算法多层感知器算法是一种基于神经网络的分类算法。

它通过模拟人脑的神经网络来实现对数据的分类和预测。

数据挖掘十大经典算法

数据挖掘十大经典算法数据挖掘是通过分析大量数据来发现隐藏的模式和关联,提供商业决策支持的过程。

在数据挖掘中,算法起着至关重要的作用,因为它们能够帮助我们从数据中提取有用的信息。

以下是十大经典的数据挖掘算法:1.决策树算法:决策树是一种基于分层选择的预测模型,它使用树状图的结构来表示决策规则。

决策树算法适用于分类和回归问题,并且可以解释性强。

常用的决策树算法有ID3、C4.5和CART。

2.朴素贝叶斯算法:朴素贝叶斯是一种基于概率的分类算法,它假设特征之间是相互独立的。

朴素贝叶斯算法简单有效,适用于大规模数据集和高维数据。

3.支持向量机(SVM)算法:SVM是一种针对分类和回归问题的监督学习算法,它通过构建一个最优的超平面来实现分类。

SVM在处理非线性问题时使用核函数进行转换,具有较强的泛化能力。

4.K近邻算法:K近邻是一种基于实例的分类算法,它通过找到与目标实例最接近的K个邻居来确定目标实例的类别。

K近邻算法简单易懂,但对于大规模数据集的计算成本较高。

5.聚类算法:聚类是一种无监督学习算法,它将相似的实例聚集在一起形成簇。

常用的聚类算法有K均值聚类、层次聚类和DBSCAN等。

6.主成分分析(PCA)算法:PCA是一种常用的降维算法,它通过线性变换将原始数据转换为具有更少维度的新数据。

PCA能够保留原始数据的大部分信息,并且可以降低计算的复杂性。

7. 关联规则算法:关联规则用于发现项集之间的关联关系,常用于市场篮子分析和推荐系统。

Apriori算法是一个经典的关联规则算法。

8.神经网络算法:神经网络是一种模仿人脑神经元通信方式的机器学习算法,它能够学习和适应数据。

神经网络适用于各种问题的处理,但对于参数选择和计算量较大。

9.随机森林算法:随机森林是一种基于决策树的集成学习算法,它通过建立多个决策树来提高预测的准确性。

随机森林具有较强的鲁棒性和泛化能力。

10.改进的遗传算法:遗传算法是一种模拟生物进化过程的优化算法,在数据挖掘中常用于最优解。

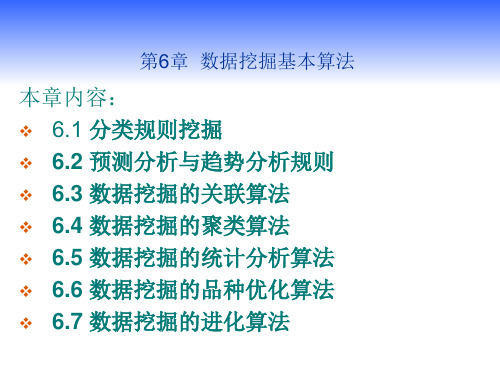

数据挖掘基本算法

3 分类方法与步骤

方法:决策树归纳、贝叶斯分类、贝叶斯网络、神经网络。还有K-最临

近分类、基于案例的推理、遗传算法、粗糙集和模糊集方法

。

步骤:模型创建、模型使用

6.1 分类规则挖掘

6.1.1分类与估值 4 评估分类方法

要考虑的指标:预测准确率、速度、创建速度、

使用速度、鲁棒性、处理噪声和丢失值、伸缩 性、对磁盘驻留数据的处理能力、可解释性、 对模型的可理解程度、规则好坏的评价、决策 树的大小和分类规则的简明性。

m

6.1 分类规则挖掘

6.1.2 决策树 1.决策树的构造过程

决策树的构造算法:

决策树的构造算法可通过训练集T完成,其中T={<x,cj>},而 x=(a1,a2,…,an)为一个训练实例,它有n个属性,分别列于属性表 (A1,A2,…,An)中,其中ai表示属性Ai的取值。Cj∈C={C1,C2,…,Cm}为x 的分类结果。从属性表中选择属性Ai作为分类属性;若属性Ai的取值有ki 个,则将T划分为ki个子集,T1,…,Tki,其中Tij={<x,C>|<x,C>}∈T,且x 的属性取值A为第i个值;接下来从属性表中删除属性Ai;对于每一个 Tij(1≤j≤K1),令T=Tij;如果属性表非空,返回第1步,否则输出。

为了理解事物特征并做出预测使用历史数据建立

一个分类模型(即分类器)的过程 。 应用于信用卡系统中的信用分级、市场调查、疗 效诊断、寻找店址等 实践应用参照课本

6.1 分类规则挖掘

6.1.1分类与估值 2 估值

估值(estimation)与分类类似,不同之处在于,分类 描述的是离散型变量的输出,而估值处理连续值的输出; 分类的类别是确定的数目,估值的量是不确定的。

数据挖掘十大经典算法

数据挖掘十大经典算法一、 C4.5C4.5算法是机器学习算法中的一种分类决策树算法,其核心算法是ID3 算法. C4.5算法继承了ID3算法的优点,并在以下几方面对ID3算法进行了改进:1) 用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足;2) 在树构造过程中进行剪枝;3) 能够完成对连续属性的离散化处理;4) 能够对不完整数据进行处理。

C4.5算法有如下优点:产生的分类规则易于理解,准确率较高。

其缺点是:在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。

1、机器学习中,决策树是一个预测模型;他代表的是对象属性与对象值之间的一种映射关系。

树中每个节点表示某个对象,而每个分叉路径则代表的某个可能的属性值,而每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值。

决策树仅有单一输出,若欲有复数输出,可以建立独立的决策树以处理不同输出。

2、从数据产生决策树的机器学习技术叫做决策树学习, 通俗说就是决策树。

3、决策树学习也是数据挖掘中一个普通的方法。

在这里,每个决策树都表述了一种树型结构,他由他的分支来对该类型的对象依靠属性进行分类。

每个决策树可以依靠对源数据库的分割进行数据测试。

这个过程可以递归式的对树进行修剪。

当不能再进行分割或一个单独的类可以被应用于某一分支时,递归过程就完成了。

另外,随机森林分类器将许多决策树结合起来以提升分类的正确率。

决策树是如何工作的?1、决策树一般都是自上而下的来生成的。

2、选择分割的方法有好几种,但是目的都是一致的:对目标类尝试进行最佳的分割。

3、从根到叶子节点都有一条路径,这条路径就是一条―规则4、决策树可以是二叉的,也可以是多叉的。

对每个节点的衡量:1) 通过该节点的记录数2) 如果是叶子节点的话,分类的路径3) 对叶子节点正确分类的比例。

有些规则的效果可以比其他的一些规则要好。

由于ID3算法在实际应用中存在一些问题,于是Quilan提出了C4.5算法,严格上说C4.5只能是ID3的一个改进算法。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Link-based ranking has contributed significantly to the success of Web search. PageRank [1, 7] is perhaps the best known link-based ranking algorithm, which also powers the Google search engine. Due to the huge business success of Google, PageRank has emerged as the dominant link analysis model on the Web.

In-links of page i: These are the hyperlinks that point to page i from other pages. Usually, hyperlinks from the same site are not considered.

6.2 PageRank Algorithm

PageRank produces a static ranking of Web pages in the sense that a PageRank value is computed for each page off-line, and the value is not dependent on search queries. In other words, the PageRank computation is purely based on the existing links on the Web and has nothing to do with each query issued by users. Before introducing the PageRank formula, let us first state some main concepts.

The PageRank algorithm was first introduced by Sergey Brin and Larry Page at the Seventh International World Wide Web Conference (WWW7) in April 1998, with the aim of tackling some major difficulties with the content-based ranking algorithms of early search engines. These early search engines essentially retrieved relevant pages for the user based on content similarities of the user query and the indexed pages of the search engines. The retrieval and ranking algorithms were simply direct implementation of those from information retrieval. However, starting from 1996, it became clear that the content similarity alone was no longer sufficient for search due to two main reasons. First, the number of Web pages grew rapidly during the middle to late 1990s. Given any query, the number of relevant pages can be huge. For example, given the search query “classification technique,” the Google search engine estimates that there are about 10 million relevant pages. This abundance of information causes a major problem for ranking, that is, how to choose only 10 to 30 pages and rank them suitably to present to the user. Second, content similarity methods are easily spammed. A page owner can repeat some important words and add many remotely related words in his/her pages to boost the rankings of the pages and/or to make the pages relevant to a large number of possible queries.

Chapter 6

PageRank

Bing Liu and Philip S. Yu

Contents

6.1 Introduction . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 117 6.2 PageRank Algorithm . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 118 6.3 An Extension: Timed-PageRank . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 123 6.4 Summary . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 124 6.5 Exercises . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 124 References . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 125

117

© 2009 by Taylor & Francis Group, LLC

118

PageRank

From around 1996, researchers in academia and search engine companies began to work on the problem. They resort to hyperlinks. Unlike text documents used in traditional information retrieval, which are often considered independent of one another (i.e., with no explicit relationships or links among them except in citation analysis), Web pages are connected through hyperlinks, which carry important information. Some hyperlinks are used to organize a large amount of information at the same Web site, and thus only point to pages in the same site. Other hyperlinks point to pages in other Web sites. Such outgoing hyperlinks often indicate an implicit conveyance of authority to the pages being pointed to. For example, if your page points to an outside page, you obviously believe that this outside page contains quality and useful information to you. Hence, those pages that are pointed to by many other pages are likely to contain authoritative or quality information. Such linkages should obviously be used in page evaluation and ranking in search engines. PageRank precisely exploits such links to provide a powerful ranking algorithm. In essence, PageRank relies on the democratic nature of the Web by using its vast link structure as an indicator of an individual page’s quality. It interprets a hyperlink from page x to page y as a vote, by page x, for page y. Additionally, PageRank looks at more than just the sheer number of votes or links that a page receives. It also analyzes the page that casts the vote. Votes cast by pages that are themselves “important” weigh more heavily and help to make other pages more “important.” This is the rank prestige idea in social networks [9]. In this chapter, we introduce the PageRank algorithm. Along with it, an extension to the algorithm is also presented, which is called Timed-PageRank. Timed-PageRank adds the temporal dimension to search to deal with the dynamic nature of the Web and the aging of Web pages.