MATLAB中的神经网络调优与超参数搜索

神经网络中超参数的调节与模型性能优化

神经网络中超参数的调节与模型性能优化神经网络是一种模拟人脑神经系统的计算模型,通过多层次的神经元相互连接来实现复杂的模式识别和数据分析任务。

然而,神经网络的性能往往受到超参数的选择和调节的影响。

在神经网络中,超参数包括学习率、批量大小、迭代次数等,它们对模型的性能有着重要的影响。

本文将探讨神经网络中超参数的调节与模型性能优化的相关问题。

一、超参数的选择与调节在神经网络中,超参数的选择和调节是一项复杂而重要的任务。

超参数的不同取值会直接影响到模型的训练速度和性能。

首先,学习率是神经网络中最重要的超参数之一。

学习率决定了模型在每次迭代中对权重和偏差的调整程度,过大的学习率会导致模型无法收敛,而过小的学习率会导致模型训练速度过慢。

因此,选择合适的学习率是优化模型性能的关键。

其次,批量大小也是一个重要的超参数。

批量大小决定了每次迭代中模型使用的训练样本数量,过大的批量大小会导致模型过拟合,而过小的批量大小会导致模型难以收敛。

因此,选择合适的批量大小是优化模型性能的关键。

此外,迭代次数也是一个需要调节的超参数。

迭代次数决定了模型在训练集上的训练次数,过小的迭代次数会导致模型欠拟合,而过大的迭代次数会导致模型过拟合。

因此,选择合适的迭代次数是优化模型性能的关键。

二、超参数调节的方法与技巧在神经网络中,超参数的调节是一个复杂而耗时的过程。

为了提高调节的效率和准确性,可以采用以下方法和技巧。

首先,可以使用网格搜索的方法来寻找最佳的超参数组合。

网格搜索是一种穷举搜索的方法,通过遍历给定的超参数空间来寻找最佳的超参数组合。

虽然网格搜索的计算复杂度较高,但是它可以找到全局最优解。

因此,网格搜索是一种常用的超参数调节方法。

其次,可以使用随机搜索的方法来寻找最佳的超参数组合。

随机搜索是一种基于随机采样的方法,通过随机选择超参数组合来寻找最佳的超参数。

相比于网格搜索,随机搜索的计算复杂度较低,但是它无法找到全局最优解。

因此,随机搜索是一种高效而实用的超参数调节方法。

MATLAB中的神经网络优化技巧

MATLAB中的神经网络优化技巧神经网络是一种模拟人脑神经元间连接的计算模型,它在处理复杂非线性问题、数据建模和预测等方面具有广泛的应用。

MATLAB作为一种强大的数学计算软件,提供了丰富的神经网络工具箱和优化函数,可以帮助用户更好地设计和优化神经网络模型。

本文将介绍一些在MATLAB中应用神经网络的优化技巧,帮助读者更好地掌握这一领域的知识。

深入了解神经网络在应用神经网络优化技巧之前,我们首先要了解神经网络的基本原理和模型结构。

神经网络通常包括输入层、隐藏层和输出层,各层之间的神经元通过连接权重相互连接。

通过输入数据在神经网络中的前向传播和反向传播的过程,可以不断调整权值,使神经网络模型能够更好地拟合数据。

选择合适的神经网络模型在使用MATLAB构建神经网络模型时,我们需要首先确定合适的网络结构和模型类型。

MATLAB提供了多种不同类型的神经网络,如前馈神经网络、递归神经网络和自适应神经网络等。

在选择模型时,需要根据问题的类型和数据的特点进行合理的选择,并结合实际问题调整网络结构和神经元的数目。

数据的预处理在构建神经网络模型之前,对数据进行预处理是非常重要的一步。

数据预处理可以包括对数据进行归一化、去噪和特征选择等操作,以提高神经网络模型的训练效果和预测准确性。

选择适当的激活函数激活函数在神经网络中起着非常重要的作用,它可以引入非线性,使得神经网络能够更好地拟合数据。

在MATLAB中,常见的激活函数有sigmoid函数、ReLU函数和tanh函数等。

在选择激活函数时,需要考虑到函数的非线性和导数易于计算的性质。

设置合适的学习率和迭代次数学习率和迭代次数是决定神经网络训练效果的两个重要参数。

学习率过大会导致网络训练不稳定,学习率过小则网络训练速度过慢。

迭代次数过少可能导致网络未能收敛到最佳解,迭代次数过多则容易出现过拟合现象。

在使用MATLAB训练神经网络时,需要根据实际问题调整学习率和迭代次数,以达到最佳的训练效果。

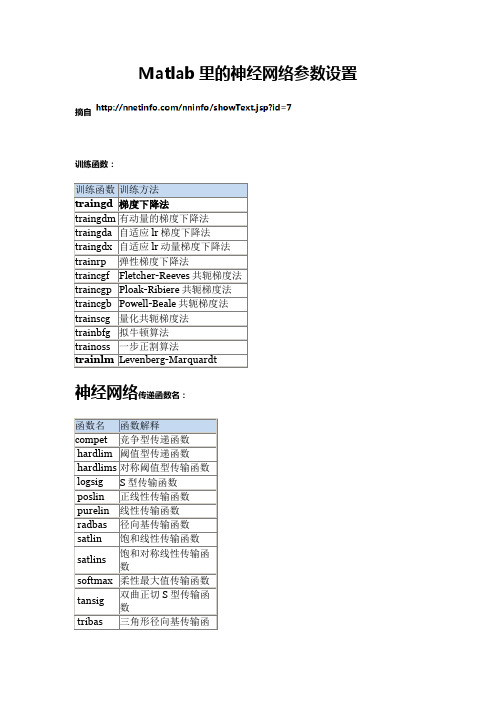

Matlab里的神经网络参数设置

Matlab⾥的神经⽹络参数设置Matlab⾥的神经⽹络参数设置训练函数训练⽅法traingd 梯度下降法traingdm 有动量的梯度下降法traingda ⾃适应lr梯度下降法traingdx ⾃适应lr动量梯度下降法trainrp 弹性梯度下降法traincgf Fletcher-Reeves共轭梯度法traincgp Ploak-Ribiere共轭梯度法traincgb Powell-Beale共轭梯度法trainscg 量化共轭梯度法trainbfg 拟⽜顿算法trainoss ⼀步正割算法trainlm Levenberg-Marquardt传递函数名:函数名函数解释compet 竞争型传递函数hardlim 阈值型传递函数hardlims 对称阈值型传输函数logsig S型传输函数poslin 正线性传输函数purelin 线性传输函数radbas 径向基传输函数satlin 饱和线性传输函数satlins 饱和对称线性传输函数softmax 柔性最⼤值传输函数tansig 双曲正切S型传输函数tribas 三⾓形径向基传输函数训练设置:参数名称解释适⽤⽅法net.trainParam.epochs 最⼤训练次数(缺省为10) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.goal 训练要求精度(缺省为0) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.lr 学习率(缺省为0.01) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.max_fail 最⼤失败次数(缺省为5) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.min_grad 最⼩梯度要求(缺省为1e-10) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.show 显⽰训练迭代过程(NaN表⽰不显⽰,缺省为25) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.time 最⼤训练时间(缺省为inf) traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.mc 动量因⼦(缺省0.9) traingdm、traingdxnet.trainParam.lr_inc 学习率lr增长⽐(缺省为1.05) traingda、traingdxnet.trainParam.lr_dec 学习率lr下降⽐(缺省为0.7) traingda、traingdxnet.trainParam.max_perf_inc 表现函数增加最⼤⽐(缺省为1.04) traingda、traingdxnet.trainParam.delt_inc 权值变化增加量(缺省为1.2) trainrpnet.trainParam.delt_dec 权值变化减⼩量(缺省为0.5) trainrpnet.trainParam.delt0 初始权值变化(缺省为0.07) trainrpnet.trainParam.deltamax 权值变化最⼤值(缺省为50.0) trainrpnet.trainParam.searchFcn ⼀维线性搜索⽅法(缺省为srchcha) traincgf、traincgp、traincgb、trainbfg、trainossnet.trainParam.sigma 因为⼆次求导对权值调整的影响参数(缺省值5.0e-5) trainscg/doc/9f16135255.htmlmbda Hessian矩阵不确定性调节参数(缺省为5.0e-7) trainscgnet.trainParam.men_reduc 控制计算机内存/速度的参量,内存较⼤设为1,否则设为2(缺省为1) trainlm net.trainParam.mu 的初始值(缺省为0.001) trainlmnet.trainParam.mu_dec 的减⼩率(缺省为0.1) trainlmnet.trainParam.mu_inc 的增长率(缺省为10) trainlmnet.trainParam.mu_max 的最⼤值(缺省为1e10)。

神经网络中的超参数调优方法与技巧(九)

神经网络中的超参数调优方法与技巧神经网络作为机器学习和人工智能领域的重要技术,已经在各种领域取得了巨大的成功。

但是神经网络模型的性能很大程度上取决于其超参数的选择和调优。

超参数是指在模型训练过程中需要人为设定的参数,比如学习率、批量大小、正则化参数等。

本文将讨论神经网络中的超参数调优方法与技巧,帮助读者更好地理解和应用神经网络模型。

1. 超参数的选择神经网络模型中有许多超参数需要进行选择,比如学习率、批量大小、正则化参数等。

超参数的选择对模型的性能有着至关重要的影响。

在选择超参数时,通常需要进行一些实验来找到最佳的超参数组合。

一种常用的方法是使用网格搜索或者随机搜索来寻找最佳的超参数组合。

网格搜索会遍历所有可能的超参数组合,而随机搜索则会随机选择一些超参数组合进行实验。

除此之外,还可以使用贝叶斯优化等方法来进行超参数选择,这些方法通常能够更快地找到最佳的超参数组合。

2. 学习率的调优学习率是神经网络中一个非常重要的超参数,它决定了模型参数在每一次迭代中的更新幅度。

通常情况下,学习率需要进行调优才能达到最佳的性能。

一种常用的方法是使用学习率衰减,即在训练过程中逐渐降低学习率。

另一种常用的方法是使用自适应学习率算法,比如Adam、RMSprop等。

这些算法能够根据参数的梯度自适应地调整学习率,通常能够更快地收敛到最优解。

3. 正则化参数的选择正则化是一种常用的防止过拟合的方法,它通过在损失函数中加入正则项来约束模型的复杂度。

在神经网络中,正则化参数的选择对模型的性能有着很大的影响。

通常情况下,可以使用交叉验证等方法来选择最佳的正则化参数。

此外,还可以使用一些自动调优的方法来选择正则化参数,比如网格搜索、随机搜索等。

4. 批量大小的选择批量大小是指在训练过程中每次迭代所使用的样本数量。

批量大小的选择对模型的性能有着很大的影响。

通常情况下,较大的批量大小能够更快地收敛到最优解,但是会增加内存占用和计算开销。

Matlab里的神经网络参数设置

S型传输函数

poslin

正线性传输函数

purelin

线性传输函数

radbas

径向基传输函数

satlin

饱和线性传输函数

satlins

饱和对称线性传输函数

softmax

柔性最大值传输函数

tansig

双曲正切S型传输函数

tribas

三角形径向基传输函数

elliot2sig

ettrainparamepoch最大训练次数缺省为10traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparamgoal训练要求精度缺省为0traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparamlr学习率缺省为001traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparammaxfail最大失败次数缺省为5traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparammingrad最小梯度要求缺省为1e10traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparamshow显示训练迭代过程nan表示不显示缺省为25traingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparamtime最大训练时间缺省为inftraingdtraingdmtraingdatraingdxtrainrptraincgftraincgptraincgbtrainscgtrainbfgtrainosstrainlmnettrainparammc动量因子缺省09traingdmtraingdxnettrainparamlrinc学习率lr增长比缺省为105traingdatraingdxnettrainparamlrdec学习率lr下降比缺省为07traingdatraingdxnettrainparammaxper

Matlab中的神经网络优化和模型选择方法

Matlab中的神经网络优化和模型选择方法1. 引言神经网络是一种强大的模型选择工具,在许多领域中得到了广泛应用,如图像识别、自然语言处理、医学诊断等。

在构建神经网络模型时,一个关键的问题是如何选择合适的网络结构和参数,以使得模型能够更好地拟合数据并具备较好的泛化能力。

在Matlab中,提供了多种优化算法和模型选择方法,本文将介绍其中几种常见的方法。

2. 神经网络的基本原理在神经网络中,输入数据通过一系列的神经元传递,经过激活函数的处理后得到输出结果。

神经网络的结构包括输入层、隐含层和输出层,其中隐含层可以有多个。

每个神经元都有一组权重参数,这些参数决定了输入数据对神经元的影响程度。

优化神经网络的目标是通过调整这些权重参数,使得网络的输出能够更好地拟合训练数据。

3. 神经网络的训练方法神经网络的训练通常通过以下两个步骤实现:前向传播和反向传播。

前向传播是指将训练数据输入神经网络,并计算网络的输出结果。

反向传播是指根据输出结果与真实标签之间的误差,通过调整权重参数,使得网络的输出能够更加接近真实标签。

Matlab提供了多种优化算法来实现神经网络的训练,如梯度下降法、Adam算法等。

这些算法能够根据损失函数的梯度,自动调整网络的权重参数,以最小化误差和损失函数。

4. 神经网络的超参数调优除了权重参数外,神经网络还包括许多超参数,如学习率、迭代次数、隐藏层节点数等。

这些超参数的选择对网络的性能和训练时间有着重要影响。

在Matlab中,有多种方法可以调优神经网络的超参数,如网格搜索、贝叶斯优化等。

这些方法可以自动化地搜索超参数的最佳组合,从而提高网络的性能。

5. 神经网络模型选择方法在构建神经网络模型时,选择合适的网络结构也是一项关键任务。

不同的网络结构可能适用于不同的问题,如何选择最佳的网络结构是一个挑战。

在Matlab中,提供了多种模型选择方法,如正则化、交叉验证等。

这些方法可以帮助我们选择合适的网络结构,并避免过拟合和欠拟合问题。

应用超参数搜索优化神经网络模型的指南

应用超参数搜索优化神经网络模型的指南引言:神经网络模型在机器学习领域中被广泛应用,但是调整模型的超参数是一个复杂且耗时的过程。

本文将为读者提供一些指南,帮助他们有效地应用超参数搜索优化神经网络模型。

一、超参数的重要性在构建神经网络模型时,超参数是需要手动设置的参数,例如学习率、批次大小、迭代次数等。

这些超参数的选择直接影响模型的性能和收敛速度。

因此,合理选择超参数是优化神经网络模型的关键一步。

二、超参数搜索的方法1. 网格搜索网格搜索是最简单直观的超参数搜索方法之一。

它通过穷举所有可能的超参数组合来寻找最佳组合。

然而,网格搜索的缺点是计算复杂度高,尤其是当超参数的数量较多时。

2. 随机搜索与网格搜索不同,随机搜索从超参数的取值范围中随机选择一组参数进行模型训练和评估。

随机搜索的优点是计算复杂度相对较低,同时可以在较短的时间内找到较好的超参数组合。

3. 贝叶斯优化贝叶斯优化是一种基于概率模型的超参数搜索方法。

它通过建立模型来估计超参数与模型性能之间的关系,并根据模型的预测结果选择下一组超参数进行评估。

贝叶斯优化的优点是可以在较少的迭代次数下找到较优的超参数组合。

三、超参数搜索的技巧1. 初始搜索范围在进行超参数搜索之前,需要对每个超参数设定一个初始的搜索范围。

这个范围应该根据先验知识和经验进行合理设置,避免搜索范围过大或过小。

2. 逐步细化搜索范围在进行超参数搜索时,可以根据初始搜索结果逐步缩小搜索范围。

通过观察模型性能和超参数的关系,可以调整搜索范围,进一步提高模型的性能。

3. 交叉验证为了准确评估不同超参数组合下模型的性能,可以使用交叉验证方法。

将数据集分为训练集和验证集,并在验证集上评估模型的性能。

通过交叉验证,可以更好地比较不同超参数组合的性能差异。

4. 提前停止在训练神经网络模型时,可以设置提前停止机制,即当模型在验证集上的性能不再提升时,停止训练过程。

这样可以避免过拟合,并节省计算资源。

神经网络中的超参数搜索与自动化调优技巧

神经网络中的超参数搜索与自动化调优技巧神经网络是一种强大的机器学习模型,但是其性能很大程度上取决于超参数的选择。

超参数是在模型训练之前需要手动设置的参数,包括学习率、批大小、网络层数等。

正确选择超参数可以提高模型的性能,但是这个过程通常是耗时且困难的。

因此,超参数搜索和自动化调优技巧成为了研究的热点。

1. 超参数搜索的挑战超参数搜索的挑战在于搜索空间庞大且不可知。

对于每个超参数,可能有多个可选值,而不同超参数之间的组合又会导致指数级的搜索空间。

传统的网格搜索和随机搜索方法在这种情况下效率低下。

因此,研究者们提出了一些自动化调优的技巧来解决这个问题。

2. 基于贝叶斯优化的超参数搜索贝叶斯优化是一种基于概率模型的优化方法,可以在有限的迭代次数内找到全局最优解。

在超参数搜索中,贝叶斯优化可以通过利用历史数据来估计不同超参数组合的性能,并选择具有最高期望性能的超参数进行下一次迭代。

这种方法可以高效地在大型搜索空间中找到最优解。

3. 强化学习与超参数搜索强化学习是一种通过试错的方式来优化决策策略的方法。

在超参数搜索中,可以将其看作是一个决策过程,每个超参数组合都是一个决策点。

强化学习算法可以通过不断尝试不同的超参数组合,并根据实际性能来更新决策策略,从而找到最优的超参数组合。

这种方法在搜索空间较大且不可知的情况下表现出色。

4. 自动化调优工具除了上述方法,还有一些自动化调优工具可以帮助研究者和工程师更轻松地进行超参数搜索。

例如,Google的AutoML工具可以自动搜索最佳超参数,并生成高性能的神经网络模型。

此外,还有一些开源工具如Hyperopt、Optuna等,提供了简单易用的接口和优化算法,帮助用户进行超参数搜索。

5. 结合领域知识的超参数搜索虽然自动化调优技术可以帮助我们在大型搜索空间中找到最优解,但是在某些情况下,结合领域知识可能更加有效。

领域知识可以帮助我们缩小搜索空间,提供一些合理的超参数范围,并减少搜索时间。

神经网络中的超参数调优方法与技巧

神经网络中的超参数调优方法与技巧神经网络是一种受人工智能领域热捧的模型,它模拟人脑神经元之间的连接方式,能够实现复杂的非线性函数拟合。

然而,神经网络的性能很大程度上取决于超参数的选择,包括学习率、批量大小、正则化项等。

在实际应用中,如何有效地调优超参数成为了一个十分重要的问题。

超参数调优的目标是找到一组最优的超参数,使得神经网络能够在给定的任务上取得最佳的性能。

下面将介绍一些常用的超参数调优方法与技巧。

1. 网格搜索法网格搜索法是一种最简单直接的超参数调优方法。

它通过遍历给定的超参数组合,然后在交叉验证集上评估模型性能,最终选择性能最佳的超参数组合。

虽然网格搜索法的计算复杂度较高,但是它确保了找到了最优的超参数组合。

2. 随机搜索法与网格搜索法相比,随机搜索法更加高效。

它通过随机采样超参数空间中的点,然后在交叉验证集上评估模型性能。

虽然随机搜索法不能保证找到最优的超参数组合,但是在实践中通常能够找到表现不错的超参数组合。

3. 贝叶斯优化法贝叶斯优化法是一种基于贝叶斯统计方法的超参数调优方法。

它通过构建一个目标函数的后验分布,然后选择下一个超参数组合以最大化目标函数的期望改善。

贝叶斯优化法通常在大规模超参数空间中能够找到较好的超参数组合。

4. 交叉验证在超参数调优过程中,交叉验证是一项重要的技巧。

它能够有效地评估模型在不同超参数组合下的性能,从而帮助选择最佳的超参数组合。

常见的交叉验证方法包括k折交叉验证和留一交叉验证。

5. 学习率调整策略学习率是神经网络训练中一个重要的超参数。

在训练过程中,学习率的选择会直接影响模型的收敛速度和性能。

常见的学习率调整策略包括指数衰减、自适应学习率算法(如Adam、RMSProp)等。

6. 正则化正则化是一种常用的防止过拟合的方法,有助于改善模型的泛化能力。

在超参数调优过程中,选择适当的正则化项(如L1正则化、L2正则化)也是一个重要的问题。

总结超参数调优是神经网络训练过程中不可或缺的一环。

Matlab中的神经网络模型评估与调试

Matlab中的神经网络模型评估与调试很多科学家和工程师都需要使用神经网络模型进行数据分析和预测。

而在实际应用中,我们常常需要评估和调试这些神经网络模型,以确保其性能和可靠性。

在这篇文章中,我们将探讨如何在Matlab中进行神经网络模型的评估与调试。

一、数据准备和模型训练在进行神经网络模型的评估与调试之前,首先需要准备好相应的数据集并完成模型的训练。

通过Matlab提供的数据导入工具,我们可以方便地将数据集导入到工作环境中。

选择适当的数据预处理方法,例如特征选择、数据归一化等,可以提高神经网络模型的性能。

模型的训练则通过使用Matlab中的神经网络工具箱来完成。

我们可以选择不同类型的神经网络架构,例如前馈神经网络、循环神经网络等,也可以根据具体需求选择不同的训练算法,如反向传播算法、Levenberg-Marquardt算法等。

二、模型性能评估在完成模型的训练后,我们需要对其性能进行评估,以便了解其预测能力和泛化能力。

1. 准确率和误差分析准确率是评估分类问题中模型性能的重要指标。

可以通过计算模型在测试集上的分类准确率来评估模型的精确度。

此外,我们还可以使用Matlab中的混淆矩阵工具来分析模型在不同类别之间的错误分类情况。

对于回归问题,误差分析是评估模型性能的关键。

常用的误差度量指标包括均方误差、均方根误差等。

通过计算模型在测试集上的误差指标,我们可以了解模型的预测精度。

2. ROC曲线分析在二分类问题中,ROC曲线可以帮助我们评估模型的敏感性和特异性。

通过绘制真阳率和假阳率的曲线,我们可以选择一个合适的阈值,以平衡两者之间的权衡关系。

Matlab提供了方便的绘制ROC曲线的函数,可以帮助我们对模型进行评估。

3. 交叉验证交叉验证是一种常用的模型评估方法。

它将数据集划分为训练集和测试集,并在多个划分上运行模型。

通过对不同划分上的模型性能进行评估和比较,可以更好地了解模型的泛化能力。

Matlab提供了方便的交叉验证工具箱,可以简化交叉验证过程的实现。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

MATLAB中的神经网络调优与超参数搜索

引言

神经网络是一种强大的机器学习工具,广泛应用于各个领域,如图像识别、语

音处理和自然语言处理等。

在使用神经网络时,调优和选择合适的超参数是非常重要的,因为它们直接影响到神经网络的性能和表现。

在本文中,我们将探讨MATLAB中神经网络的调优和超参数搜索方法,以帮助读者充分发挥神经网络的

潜力。

1. 神经网络调优的意义

首先,我们必须明确神经网络调优的意义。

调优是指通过修改和调整神经网络

的特定参数,以改善网络的性能。

当我们训练一个神经网络时,我们不仅仅希望它能准确地预测和分类数据,还希望它能够在不同的数据集或情景下保持较好的泛化能力。

调优可以帮助我们找到最佳的参数组合,使神经网络达到最佳的预测能力。

2. 神经网络调优的基本原则

在进行神经网络调优时,我们需要遵循一些基本原则。

首先,我们应该选择合

适的损失函数,评估网络的预测能力。

损失函数的选择应该与我们关注的问题类型相匹配,如均方误差损失函数用于回归问题,交叉熵损失函数用于分类问题。

其次,我们需要选择合适的优化算法,以最小化损失函数并更新神经网络的参数。

目前,常用的优化算法包括梯度下降、Adam和RMSprop等。

最后,我们应该根据问题

的特点选择合适的激活函数、网络结构和批处理大小等超参数。

这些基本原则将帮助我们在神经网络调优中取得更好的效果。

3. MATLAB中的神经网络调优工具箱

MATLAB提供了一套强大的神经网络调优工具箱,使我们能够轻松地进行神

经网络调优和超参数搜索。

这个工具箱集成了各种调优算法和评估指标,大大简化了调优的过程。

首先,我们可以使用神经网络调优工具箱中的`nftool`函数来进行网络的设计和

调优。

该函数可以通过图形用户界面帮助我们创建和修改神经网络,设置损失函数、优化算法和超参数,并进行网络的训练和验证。

这样,即使没有深入的机器学习知识,我们也能够轻松地设计和优化神经网络。

另外,神经网络调优工具箱还提供了一些自动调优和超参数搜索的函数。

例如,我们可以使用`hyperopt`函数来自动搜索神经网络的超参数,如学习率、批处理大

小和网络结构等。

该函数使用贝叶斯优化算法,能够快速而准确地搜索到最佳的超参数组合,提高网络的性能和泛化能力。

4. 超参数搜索的策略

在进行超参数搜索时,我们应该采用合适的策略,以提高搜索的效率和结果的

质量。

一种常用的策略是网格搜索,即先确定超参数的范围,然后通过在参数空间中均匀采样来搜索最佳组合。

这种方法简单直观,但是在参数空间较大的情况下计算开销较大。

另外,我们还可以使用贝叶斯优化算法,例如`hyperopt`函数提供的方法。

贝叶斯优化通过综合利用已知的超参数组合和评估结果来指导下一步的搜索,能够在有限的样本数下找到最佳组合,大大加快了搜索的速度。

此外,贝叶斯优化还能够自动调整搜索空间的大小和采样策略,使搜索更加高效和准确。

5. 实例演示

为了更好地理解和应用神经网络调优与超参数搜索,我们将进行一个实例演示。

假设我们要训练一个图像分类器,识别猫和狗的照片。

我们首先需要收集大量的标记数据,并将其分为训练集和测试集。

接下来,我们使用MATLAB的神经网络调优工具箱来设计和训练神经网络。

我们可以通过`nftool`函数创建一个基本的卷积神经网络结构,并选择合适的优化

算法和损失函数。

然后,我们使用训练集对网络进行训练,并使用测试集评估网络的性能。

在初始的设计和训练结果的基础上,我们可以使用`hyperopt`函数来搜索最佳的超参数组合。

该函数将自动搜索学习率、批处理大小和网络结构等超参数,并返回最佳结果。

我们可以根据搜索结果对神经网络进行调优,并评估调优后网络的性能。

结论

神经网络调优和超参数搜索在提高神经网络的性能和泛化能力方面起着至关重

要的作用。

在MATLAB中,我们可以利用神经网络调优工具箱提供的各种函数和

算法,轻松地进行神经网络的调优和超参数搜索。

合适的超参数搜索策略和方法能够显著减少调优的时间和计算开销,提高网络的性能和效果。

通过本文的介绍和实例演示,相信读者对MATLAB中的神经网络调优和超参

数搜索有了更清晰的认识和理解。

希望读者能够在实际应用中充分利用这些工具和方法,发挥神经网络的潜力,取得更好的结果。

祝愿大家在神经网络的调优与超参数搜索中取得亮眼的成就!。