GaussNewton

高斯牛顿法求解非线性问题

高斯牛顿法求解非线性问题在科学研究、工程设计等领域中,有许多问题都可以归纳为非线性问题,例如曲线拟合、最小二乘法拟合、非线性规划等。

如何高效地求解这些问题是一个重要的课题。

高斯牛顿法(Gauss-Newton method)是一种常用的优化算法,被广泛应用于求解非线性问题。

高斯牛顿法的基本思想是:将非线性问题转化为最小二乘问题,然后使用线性最小二乘法求解。

具体而言,假设有一个由m个参数和n个数据点组成的非线性模型:f(x) = (f1(x),f2(x),...,fn(x))^T其中,x = (x1,x2,...,xm)^T 为参数向量,fi(x)为第i个观测值。

若将f(x)看作一个向量函数,则该函数在x处的导数可以用雅可比矩阵来表示:J(x) = [∂f1(x)/∂x1,∂f1(x)/∂x2,...,∂f1(x)/∂xm;∂f2(x)/∂x1,∂f2(x)/∂x2,...,∂f2(x)/∂xm;.............................∂fn(x)/∂x1,∂fn(x)/∂x2,...,∂fn(x)/∂xm]雅可比矩阵是一个n×m的矩阵,表示参数向量对向量函数的导数。

对于非线性模型,其导数难以直接求解,因此需要采用近似方法。

高斯牛顿法采用的是一阶泰勒展开式,将非线性模型在x 处展开:f(x+Δx) ≈ f(x) + J(x)Δx其中,Δx为参数向量x的增量,即x+Δx为新的参数向量。

将上式两边平方,再加上一个权重矩阵W,得到最小二乘问题:min Δx ||sqrt(W)(f(x+Δx)-f(x))||^2上式中,||·||表示向量的欧几里得长度,W为一个n×n的对角矩阵,其作用是赋予不同观测值不同的权重。

将上式展开,得到:min Δx (f(x)+J(x)Δx-y)^TW(f(x)+J(x)Δx-y)其中,y为n×1的向量,表示原始数据点。

slam 高斯牛顿法

高斯牛顿法高斯牛顿法(Gauss-Newton method)是一种用于非线性最小二乘问题求解的数值优化方法。

它结合了高斯消元法和牛顿迭代法的特点,旨在寻找函数最小化的参数。

在本文中,我们将介绍高斯牛顿法的原理、步骤和应用。

原理在非线性最小二乘问题中,我们需要找到使得函数残差平方和最小的参数向量。

该问题通常表示为:equation其中,是残差向量函数,是参数向量。

高斯牛顿法通过迭代的方式逼近最优解,其主要思想是将非线性问题转化为一系列的线性问题,并通过逐步线性化来求解。

具体而言,它采用牛顿法中的线性化和高斯消元法来解决线性问题。

步骤高斯牛顿法的求解过程可以分为以下几个步骤:1.初始化参数:首先,需要对参数向量进行初始化,通常可以使用一些启发式的方法得到初始值。

2.线性化:在每一次迭代中,将残差函数进行线性化。

这意味着将非线性问题转化为一个线性问题,使其更易于求解。

线性化通常通过泰勒级数展开来实现。

3.构造线性方程组:通过线性化后的函数,可以构造出一个线性方程组。

该方程组的解将作为当前迭代中的修正量,用于更新参数向量。

4.求解线性方程组:使用高斯消元法等数值方法求解线性方程组,得到修正量。

5.参数更新:利用修正量更新参数向量,得到新的参数估计。

6.收敛判断:检查参数估计是否已经收敛。

如果满足收敛准则,则停止迭代;否则,返回第2步继续迭代。

应用高斯牛顿法在许多领域都有广泛的应用。

其中一个典型的应用是在计算机视觉中的相机标定问题,即通过已知的图像和相机参数来估计相机的内部和外部参数。

高斯牛顿法可以通过最小化重投影误差来估计这些参数,从而获得更准确的相机模型。

此外,高斯牛顿法还在机器学习中被广泛使用,例如参数估计和优化算法。

通过最小化损失函数,可以使用高斯牛顿法来确定模型中的参数,进而提高模型的拟合能力。

总结高斯牛顿法是一种有效的求解非线性最小二乘问题的数值优化方法。

它通过线性化和高斯消元法的结合,能够提供较快的收敛速度和较高的求解精度。

python高斯-牛顿迭代法

python高斯-牛顿迭代法高斯-牛顿迭代法(Gauss-Newton method)是一种用于非线性优化问题的迭代算法。

它基于线性最小二乘法,用于求解非线性函数的最优解。

在本文中,我们将详细介绍高斯-牛顿迭代法的原理和实现,以及一些常见的应用。

1.高斯-牛顿迭代法原理高斯-牛顿迭代法的目标是找到一个最优的参数向量x,使得一个非线性函数集合F(x)的残差平方和最小化。

其中,残差r(x)定义为测量值与模型值之间的差异,即r(x) = y - f(x),其中y是测量值,f(x)是模型值函数。

残差平方和定义为S(x) = sum(r(x)^2),即所有残差的平方和。

为了找到最优的参数向量x,高斯-牛顿迭代法采用以下步骤进行迭代:1.初始化参数向量x的值。

2.计算残差r(x)和残差雅可比矩阵J(x)。

3.求解线性最小二乘问题J(x)^T J(x) dx = -J(x)^T r(x),其中dx是参数的增量。

4.更新参数向量x = x + dx。

5.重复步骤2-4,直到满足停止条件(如参数更新小于某个阈值)。

2.高斯-牛顿迭代法的实现高斯-牛顿迭代法的实现需要计算残差和雅可比矩阵,通过求解线性最小二乘问题来更新参数向量。

以下是一个简单的实现示例:```pythonimport numpy as npdef gauss_newton(x0, y, f, f_prime, max_iterations=100,tol=1e-6):x = x0for i in range(max_iterations):r = y - f(x)J = f_prime(x)dx = np.linalg.lstsq(J, -r, rcond=None)[0]x = x + dxif np.linalg.norm(dx) < tol:breakreturn x```在上述代码中,x0是参数向量的初始值,y是测量值,f是模型值函数,f_prime是模型值函数的导数。

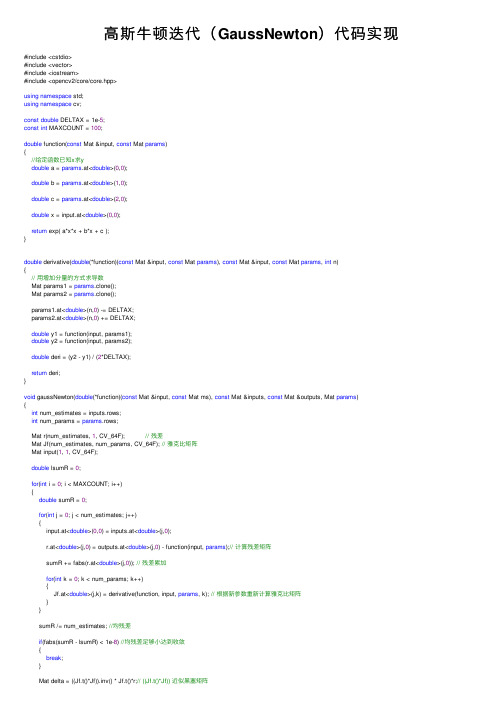

高斯牛顿迭代(GaussNewton)代码实现

⾼斯⽜顿迭代(GaussNewton)代码实现#include <cstdio>#include <vector>#include <iostream>#include <opencv2/core/core.hpp>using namespace std;using namespace cv;const double DELTAX = 1e-5;const int MAXCOUNT = 100;double function(const Mat &input, const Mat params){//给定函数已知x求ydouble a = params.at<double>(0,0);double b = params.at<double>(1,0);double c = params.at<double>(2,0);double x = input.at<double>(0,0);return exp( a*x*x + b*x + c );}double derivative(double(*function)(const Mat &input, const Mat params), const Mat &input, const Mat params, int n){// ⽤增加分量的⽅式求导数Mat params1 = params.clone();Mat params2 = params.clone();params1.at<double>(n,0) -= DELTAX;params2.at<double>(n,0) += DELTAX;double y1 = function(input, params1);double y2 = function(input, params2);double deri = (y2 - y1) / (2*DELTAX);return deri;}void gaussNewton(double(*function)(const Mat &input, const Mat ms), const Mat &inputs, const Mat &outputs, Mat params){int num_estimates = inputs.rows;int num_params = params.rows;Mat r(num_estimates, 1, CV_64F); // 残差Mat Jf(num_estimates, num_params, CV_64F); // 雅克⽐矩阵Mat input(1, 1, CV_64F);double lsumR = 0;for(int i = 0; i < MAXCOUNT; i++){double sumR = 0;for(int j = 0; j < num_estimates; j++){input.at<double>(0,0) = inputs.at<double>(j,0);r.at<double>(j,0) = outputs.at<double>(j,0) - function(input, params);// 计算残差矩阵sumR += fabs(r.at<double>(j,0)); // 残差累加for(int k = 0; k < num_params; k++){Jf.at<double>(j,k) = derivative(function, input, params, k); // 根据新参数重新计算雅克⽐矩阵}}sumR /= num_estimates; //均残差if(fabs(sumR - lsumR) < 1e-8) //均残差⾜够⼩达到收敛{break;}Mat delta = ((Jf.t()*Jf)).inv() * Jf.t()*r;// ((Jf.t()*Jf)) 近似⿊塞矩阵params += delta;lsumR = sumR;}}int main(){// F = exp ( a*x*x + b*x + c )int num_params = 3;Mat params(num_params, 1, CV_64F);//abc参数的实际值params.at<double>(0,0) = 1.0; //aparams.at<double>(1,0) = 2.0; //bparams.at<double>(2,0) = 1.0; //ccout<<"real("<<"a:"<< params.at<double>(0,0) <<" b:"<< params.at<double>(1,0) << " c:"<< params.at<double>(2,0) << ")"<< endl; int N = 100;double w_sigma = 1.0; // 噪声Sigma值cv::RNG rng; // OpenCV随机数产⽣器Mat estimate_x(N, 1, CV_64F);Mat estimate_y(N, 1, CV_64F);for ( int i = 0; i < N; i++ ){double x = i/100.0;estimate_x.at<double>(i,0) = x;Mat paramX(1, 1, CV_64F);paramX.at<double>(0,0) = x;estimate_y.at<double>(i,0) = function(paramX, params) + rng.gaussian ( w_sigma );}//abc参数的初值params.at<double>(0,0) = 0; //aparams.at<double>(1,0) = 0; //bparams.at<double>(2,0) = 0; //ccout<<"init("<<"a:"<< params.at<double>(0,0) <<" b:"<< params.at<double>(1,0) << " c:"<< params.at<double>(2,0) << ")"<< endl; gaussNewton(function, estimate_x, estimate_y, params);cout<<"result("<<"a:"<< params.at<double>(0,0) <<" b:"<< params.at<double>(1,0) << " c:"<< params.at<double>(2,0) << ")"<< endl; return0;}# Project: GaussNewtonDemo## All rights reserved.cmake_minimum_required( VERSION 2.6 )cmake_policy( SET CMP0004 OLD )### initialize project ###########################################################################################SET(CMAKE_BUILD_TYPE "Debug")SET(CMAKE_CXX_FLAGS_DEBUG "$ENV{CXXFLAGS} -O0 -Wall -g2 -ggdb")SET(CMAKE_CXX_FLAGS_RELEASE "$ENV{CXXFLAGS} -O3 -Wall")project(GaussNewtonDemo)find_package(Eigen3 REQUIRED)find_package(OpenCV REQUIRED)set(CMAKE_INSTALL_PREFIX /usr)set(BUILD_SHARED_LIBS on)set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -fPIC -O0")include_directories(${EIGEN3_INCLUDE_DIR}${OpenCV_INCLUDE_DIR})add_definitions( "-DPREFIX=\"${CMAKE_INSTALL_PREFIX}\"" )### global default options #######################################################################################set(SOURCESmain.cpp)add_executable(GaussNewtonDemo ${SOURCES}) TARGET_LINK_LIBRARIES( GaussNewtonDemo ${OpenCV_LIBS} )。

牛顿法与高斯牛顿法

where

1 2

i zj i=1

− h j ( x j , yi ) ,

2

i = zj

1 if yi is of category j , 0 otherwise.

|| x k +1 - x*|| o(|| x k - x*||) || x k - x*|| = lim k→∞ || xk - x*|| = 0

superlinear convergence! (see p. 64)

CONVERGENCE BEHAVIOR OF PURE FORM

g(x) = e x - 1

p(j |y ) = P (object w/ feature vector y is of category j ) Assign object with feature vector y to category j ∗ (y ) = arg max p(j |y ). • If p(j |y ) are unknown, we can estimate them using functions hj (xj , y ) parameterized by vectors xj . Obtain xj by minimizing

m

1 2

zi − h(x, yi )

i=1

2

• Example of a linear model: Fit the data pairs by a cubic polynomial approximation. Take h(x, y ) = x3 y 3 + x2 y 2 + x1 y + x0 , where x = (x0 , x1 , x2 , x3 ) is the vector of unknown coefficients of the cubic polynomial.

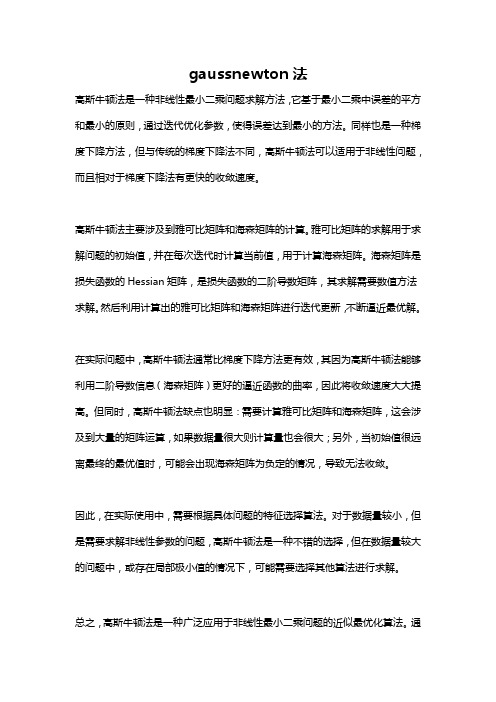

gaussnewton法

gaussnewton法

高斯牛顿法是一种非线性最小二乘问题求解方法,它基于最小二乘中误差的平方和最小的原则,通过迭代优化参数,使得误差达到最小的方法。

同样也是一种梯度下降方法,但与传统的梯度下降法不同,高斯牛顿法可以适用于非线性问题,而且相对于梯度下降法有更快的收敛速度。

高斯牛顿法主要涉及到雅可比矩阵和海森矩阵的计算。

雅可比矩阵的求解用于求解问题的初始值,并在每次迭代时计算当前值,用于计算海森矩阵。

海森矩阵是损失函数的Hessian矩阵,是损失函数的二阶导数矩阵,其求解需要数值方法求解。

然后利用计算出的雅可比矩阵和海森矩阵进行迭代更新,不断逼近最优解。

在实际问题中,高斯牛顿法通常比梯度下降方法更有效,其因为高斯牛顿法能够利用二阶导数信息(海森矩阵)更好的逼近函数的曲率,因此将收敛速度大大提高。

但同时,高斯牛顿法缺点也明显:需要计算雅可比矩阵和海森矩阵,这会涉及到大量的矩阵运算,如果数据量很大则计算量也会很大;另外,当初始值很远离最终的最优值时,可能会出现海森矩阵为负定的情况,导致无法收敛。

因此,在实际使用中,需要根据具体问题的特征选择算法。

对于数据量较小,但是需要求解非线性参数的问题,高斯牛顿法是一种不错的选择,但在数据量较大的问题中,或存在局部极小值的情况下,可能需要选择其他算法进行求解。

总之,高斯牛顿法是一种广泛应用于非线性最小二乘问题的近似最优化算法。

通

过迭代优化参数,让误差达到最小,从而得到参数的最优估计值。

高斯牛顿法在实际问题中有很多应用,如数学建模、机器学习、计算机视觉、信号处理等领域都有广泛应用。

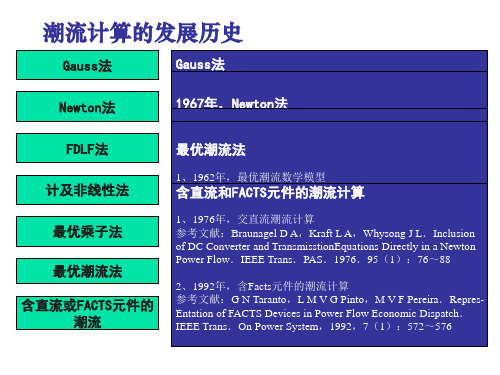

高斯法和牛顿法

缺点: 本算法的主要缺点是收敛速度很慢。 病态条件系统,计算往往会发生收敛困难 节点间相位角差很大的重负荷系统; 包含有负电抗支路(如某些三绕组变压器或线路串联电 容等)的系统; 具有较长的辐射形线路的系统; 长线路与短线路接在同一节点上,而且长短线路的长 度比值又很大的系统。

此外,平衡节点所在位置的不同选择,也会影响到收敛性能。 目前高斯一塞德尔法已很少使用

牛顿一拉夫逊法

牛顿一拉夫逊法(简称牛顿法)在数学上是求解非线性代数 方程式的有效方法。其要点是把非线性方程式的求解过程变 成反复地对相应的线性方程式进行求解的过程,即通常所称 的逐次线性化过程。

y

y f (x)

第k+1步 迭代

下一步 迭代

y(k)

x(k )

o

x x (k 2) (k 1)

x(k)

x

PV节点 PQ节点

P1 H11

Q1

J11

QP22 Hn1

N 11 L11 N 21 L21 N p1

N n1

H12 J12 H 22 J 22 H p2

of Power Flow Pr-oblems.AIEE Trans,1956,75,III:398~404

该2参IP特参NN1参TP1R11最 1参E含tAA、、5erc、99eeoar法考点考考考8otwSSav优 直77na116nt--isit1411特文:文文文9~9o89vno9o66潮 流9年 年m23inmn6点献收献献献n123:(7’iges7年5年qP流 和, 和8t,::敛::9h13MuNo年o,9,~)ewodeP原性BTSIJ.F法F11wn.tA最e基ti:r0CA,D9honolr理好BaiSoICawL8tnnmA优于E8tdu-reeT保nF1简、85pEB.lpoyal潮阻6S9法 年eHEpt.r,单内onW:~i元留IaTtE流tE抗rySiSAr,、存,a18eaE.Fo,t件非数nrl矩46uE,sc.es内占49最Iast.T学aoE阵9Tc的线HaClan存用~E.rFnOm优a模ao的PEdrrn潮需量性Pn1.ou.ts型otwS4的r乘TCraw求大6FoyiEer的流bar0算ensaYEl子un较大rtAese.P.ttFs快计c法pim.o.l少增oDp法oPAwsnawe速算Po,r1、 加ecaaFAw潮9SrtoauM6lo算 (潮SuAe’ssl2re.p流utapa.法 限ttlFLyn流upieo1dl/doad8o收 制Jn9reaSu8w算La7bdyn(敛 解dty8osueSuFt.aI法es1性 题oml1dmDo0al99puwsFn)i差 规77es,tdldi(4poMo:模a1a,Swnnt59eycc.)b)6teshhyt3iMeoIn:,EmdgaEtsr,Eix 2参A1参T9参112参S3参参oP2参EiMf、、、、0095noohn、n考考考考考考考(187lwDrteRuaoE1111(17teCtth1ue文文文文文文文59999.~xiiroocog9)68799aCFtdnnh献献献献献献献)118462ca8lost:年年年年05nfooa.2no:::::::F:08gwfvM年r1,,,,(1auFI.eRSIDSBGs39ilEAilwrat最最交含274aunlart,oErI-LCeNsa64)anioEcmmECsrum优优直F~1oTooEDPTn包am:~aoainTSonzEnaad潮潮流c1oSdterIagrdtAD319ora,il括sFaTtdetN流流潮278ni元TnieHlSolriMo631soeanavtrnD,.二on的计流86tawgn件aiW,ac,en~TetslATeePds简算计.Mn.的e,阶essmAaL,1dcPt.mei化的算aPh7Or潮SiTonMtaslA项Kn4uh.iI.wps,梯牛nPi3E流roStrtqVaeiniaodE1I的.ouRmr度顿efmw计Y9nEetGIyaSa6n1.Eep.Lo快法算ly算T8Wcr9rPqsPAol.Kr7IFAuitu法aEvone速6,FladnoSemwt8E.Lt.oisdiw7nE. Wooes,P潮(g9.ranNOrET5hdaPsFMSep1rc(流kyAIlewDaFtE0oasicnSVln)omsw1Etioos算or.aon)Ee.wnaFn,:mgbcld’1y:T法tsPCPiJPlN91OcryAeNLoaL8a87arrDlwoSin2ee6.dn6cnas.iw.i6uede~rs.darr~Ilaaptano1.T8FFNatJPcn91i8tell.Aloecoo7R8runwhmww1S7se.i.6t.psoornnes-

高斯牛顿迭代

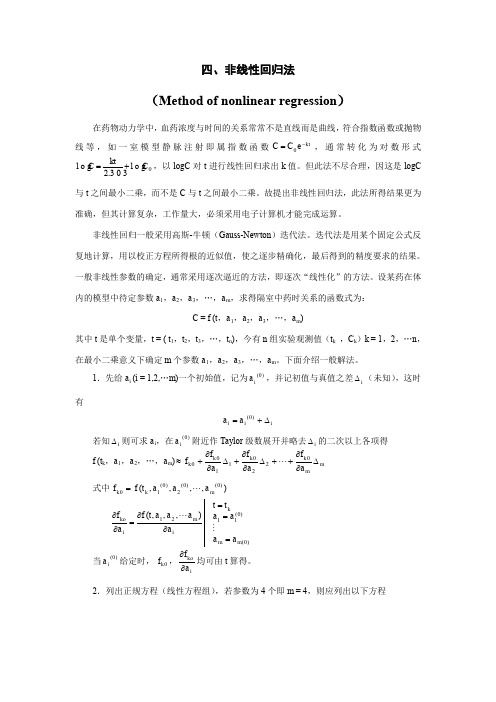

四、非线性回归法(Method of nonlinear regression )在药物动力学中,血药浓度与时间的关系常常不是直线而是曲线,符合指数函数或抛物线等,如一室模型静脉注射即属指数函数kt e C C -=0,通常转化为对数形式0l o g 303.2l o g C kt C +=,以log C 对t 进行线性回归求出k 值。

但此法不尽合理,因这是log C 与t 之间最小二乘,而不是C 与t 之间最小二乘。

故提出非线性回归法,此法所得结果更为准确,但其计算复杂,工作量大,必须采用电子计算机才能完成运算。

非线性回归一般采用高斯-牛顿(Gauss-Newton )迭代法。

迭代法是用某个固定公式反复地计算,用以校正方程所得根的近似值,使之逐步精确化,最后得到的精度要求的结果。

一般非线性参数的确定,通常采用逐次逼近的方法,即逐次“线性化”的方法。

设某药在体内的模型中待定参数a 1,a 2,a 3,…,a m ,求得隔室中药时关系的函数式为:C = f (t ,a 1,a 2,a 3,…,a m )其中t 是单个变量,t = ( t 1,t 2,t 3,…,t n ),今有n 组实验观测值(t k ,C k )k = 1,2,…n ,在最小二乘意义下确定m 个参数a 1,a 2,a 3,…,a m 。

下面介绍一般解法。

1.先给a i (i = 1,2,…m )一个初始值,记为)0(ia ,并记初值与真值之差i ∆(未知),这时有i i i a a ∆+=)0(若知i ∆则可求a i ,在)0(i a 附近作Taylor 级数展开并略去i ∆的二次以上各项得f (t k ,a 1,a 2,…,a m )m m k k k k a f a f a f f ∆∂∂++∆∂∂+∆∂∂+≈02201100 式中),,,,()0()0(2)0(10m k k a a a t f f =)0()0(1121),,,(m m k i m ikoa a a a t t a a a a t f a f ===∂∂=∂∂ 当)0(i a 给定时,0k f ,i koa f ∂∂均可由t 算得。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

[f (tk , a1 , a2 , . . . , am ) − Ck ]2

(8)

上述高斯-牛顿迭代法对于初始值依赖高,常先用残数法求出初始值。若初始值偏离真值太远,往往迭 代数次后又会发散,导致线性回归失败。

1.3

常用迭代法的C语言编程

a、牛顿迭代法程序: function [x,k]=newton(f,p0,e) %求f(x)=0在给定p0的根。 %f为所求的函数f(x),p0为迭代初始值,e为迭代精度。 k为迭代次数 %diff(f)为对函数求导,subs是赋值函数,用数值替代符号变量替换函数例 xa=p0; xb=xa-subs(f,xa)/subs(diff(f),xa); k=1; while abs(xa-xb)>e, k=k+1; xa=xb; xb=xa-subs(f,xa)/subs(diff(f),xa); end x=xb; b、雅克比迭代法程序 function [x,n]=Jacobi_Solve(A,b,x0,eps,varargin) %求解线性方程组的迭代法 %A为方程组的系数矩阵 %b方程组的右端项数字的向量组 %eps为精度要求,默认值为1e-5 %varargin为最大迭代次数,值为100 %x为方程组的解 %n为迭代次数(nargin) if nargin==3 eps=1.0e-6; M =200; elseif nargin<3 error return

高斯牛顿法的讲解和在APM上的应用

李智迅

1

1.1 牛顿迭代法

预备知识

牛顿法是一种求解方程f (x) = 0的方法。 多数方程不存在求根公式,从而求精确根非常困难,甚 至不可能,从而寻找方程的近似根就显得特别重要。 迭代法是用某个固定公式反复地计算,用以校正 方程所得根的近似值,使之逐步精确化,最后得到的精度要求的结果。 牛顿迭代法是用切线来逼近零点的,收敛的速度很快,但要求的条件也高。 首先要有一个区间, 在这个区间的端点函数值反向,其次第一次迭代点不能随意取,否则第一次迭代后的点可能跑出原先 的区间,收敛性就不一定能保证了(即有的情况也能有收敛性,有的情况就没有收敛性了,全看函数 的性能) 。 比如:设r是f (x) = 0的根,选取x0 作为r初始近似值,过点(x0 , f (x0 ))做曲线y = f (x)的切线L, L的方程为y = f (x0 ) + f ′ (x0 )(x − x0 ),求出L与x轴交点的横坐标x1 = x0 − f (x0 )/f ′ (x0 ), 称x1 为r的一次 近似值,过点(x1 , f (x1 ))做曲线y = f (x)的切线,并求该切线与x轴的横坐标x2 = x1 − f (x1 )/f ′ (x1 )称x2 为r的二次近似值,重复以上过程,得r 的近似值序列Xn ,其中Xn+1 =Xn −f (Xn )/f ′ (Xn ),称为r的n+1次 近似值。上式称为牛顿迭代公式。以f (x) = 2x3 − 4x2 + 3x − 6为例: #include<stdio.h> #include <math.h> //包含这个头文件,后面使用fabs void main() { double x=1.5,y,y1; do { y=2*x*x*x-4*x*x+3*x-6; y1=6*x*x-8*x+3; x=x-y/y1; } while(fabs(y/y1)>1e-6);// 是y/y1,不是y printf("%f",x); }

如果我们的测量忽略噪声的影响,并且参数选择正学的话,那么这个向量的长度应该一直是1,无论它 指向那个方向,也就是

2 2 a2 x + ay + az = 1

(10)

或者是 ( x − mx δx )2 + ( y − my δy )2 + ( z − mx δx )2 =1 (11)

为了矫正我们的模型,我们只需要寻找参数mx , my , mz , δx , δy and δz ,这样这个等式就一直成立了。但 是

1

预备知识

1.3

常用迭代法的C语言编程

5

L=-tril(A,-1);%求A的下三角矩阵 U=-triu(A,1);%求A的上三角矩阵 G=(D-L)\U; f=(D-L)\b; x=G*x0+f; n=1;%迭代次数 while norm(x-x0)>=eps x0=x; x=G*x0+f; n=n+1; if(n>=M) disp(’迭代次数太多,可能不收敛。 ’); return; end end d、逐次超松弛迭代程序 function [x,n]=SOR_Solve(A,b,x0,w,eps,M) %求解线性方程组的迭代法 %A为方程组的细数矩阵 %b为方程组的右端项数字的向量组 %x0为迭代初始化向量 %w为松弛因子 %eps为精度要求,默认值为1e-5 %M为最大迭代次数,值为100 %x为方程组的解 %n为迭代次数 if nargin==4 eps=1.0e-6; M =200; elseif nargin<4 error return; elseif nargin==5 M=200; end if(w<=0||w>=2) error return;

其中t是单个变量,t = (t1 , t2 , t3 , . . . , tn ),今有n组实验观测值(tk , Ck ), k = 1, 2, . . . , n,在最小二乘意 义下确定m 个参数a1 , a2 , a3 , . . . , am。下面介绍一般解法步骤。 首先,给ai (i = 1, 2, . . . , m)一个初始值,记为ai ,并记初值与真值之差ϵi (未知) ,这时有 ai = ai + ϵi 若知则可求ai ,在ai 附近作Taylor级数展开并略去ϵi 的二次以上各项得 f (tk , a1 , a2 , . . . , , a(0) m ) ≈ fk0 + 其中fk0 = f (tk , a1 , a2 , . . . , am ), t = tk ∂f (t, a1 , a2 , . . . , am ) ∂fk0 = ∂ai ∂ai a1 = a1 . . .

1.2

高斯牛顿迭代法

高斯牛顿算法是一种解决非线性最小二乘法问题的方法,主要是为了解决非线性最小二乘拟合的 1

2

1

预备知识

问题。 它可以被看做是牛顿法的一种进化,为了寻找函数的最小值。 和牛顿法不同的是,高斯牛顿算 法只能被用于算平方和的最小值,但是它也有自身的优点:他不用计算实际编码中很难实现的函数二 阶导数的值。 高斯―牛顿迭代法的基本思想是使用泰勒级数展开式去近似地代替非线性回归模型,然后通过多 次迭代,多次修正回归系数,使回归系数不断逼近非线性回归模型的最佳回归系数,最后使原模型的 残差平方和达到最小。 高斯―牛顿法的一般步骤为:1、适当选择初始值(非常重要)2、泰勒级数展 开式3、估计修正因子4、精确度的检验5、重复迭代。一般非线性参数的确定,通常采用逐次逼近的方 法,即逐次“线性化”的方法,举例如下: 设某数学模型中待定参数a1 , a2 , a3 , . . . , am ,求得数学模型与时间的关系函数式为: C = f (t, a1 , a2 , a3 , . . . , am ) (1)

2.2

运用高斯牛顿迭代法算但是我们只用一个观测站从而只有一个方程。 这样我们会有无数多个解,怎 样选择一个? • 假如我们使用6个观测站的话,我们可以得到6个未知数的唯一解,观测站尽量越不同越好这样才 不容易产生误差。但是我们知道读取数据的时候会有噪声,所以解并不是一个确定的值。 • 假如我们使用超过6个观测站的话,那么我们可以捕获到噪声的信息,但是我们得到了大于6个的 方程,但是我们只有6个未知数,所以是无解的。 这样看来我们只有选择正确的观测站数量,并且合理的选择参数,从而尽可能的使误差减小。 误差的 定义式如下 ( σi = x − mx δx )2 + ( y − my δy )2 + ( z − mx δx )2 −1 (i = 1, 2, . . . , N ) (12)

(0) (0) (0) (0) (0) (0) (0) (0) (0)

(2)

∂fk0 ∂fk0 ∂fk0 ϵ1 + ϵ2 + . . . + ϵm ∂a1 ∂a2 ∂am

(3)

(4)

am = am

k0 当ai 给定时,fk0 , ∂f ∂ai 均可由t算得。

(0)

(0)

其次,列出正规方程(线性方程组) ,为了方便理解我们不妨设参数为4个即m = 4,则应列出以下 方程 b11 ϵ1 + b12 ϵ2 + b13 ϵ3 + b14 ϵ4 = B1 b21 ϵ1 + b22 ϵ2 + b23 ϵ3 + b24 ϵ4 = B2 b31 ϵ1 + b32 ϵ2 + b33 ϵ3 + b34 ϵ4 = B3 b41 ϵ1 + b42 ϵ2 + b43 ϵ3 + b44 ϵ4 = B4 其中bij (i, j = 1, 2, . . . , m)为方程系数,Bi 为常数。它们的表达式如下: bij = Bi =

4 elseif nargin==5 M =varargin{1}; end D=diag(diag(A));%求A的对角矩阵 L=-tril(A,-1);%求A的下三角矩阵 U=-triu(A,1);%求A的上三角矩阵 B=D\(L+U); f=D\b; x=B*x0+f; n=1;%迭代次数 while norm(x-x0)>=eps x0=x; x=B*x0+f; n=n+1; if(n>=M) disp(’迭代次数太多,可能不收敛。 ’); return; end end c、高斯_赛德尔迭代程序 function [x,n]=gaussseide(A,b,x0,eps,M) %求解线性方程组的迭代法 %A为方程组的细数矩阵 %b为方程组的右端项数字的向量组 %eps为精度要求,默认值为1e-5 %M为最大迭代次数,值为100 %x为方程组的解 %n为迭代次数 if nargin==3 eps=1.0e-6; M =200; elseif nargin==4 M=200; elseif nargin<3 error return; end D=diag(diag(A));%求A的对角矩阵