条件随机场模型和训练方法

机器学习技术中的条件随机场生成模型方法

机器学习技术中的条件随机场生成模型方法条件随机场(Conditional Random Field,CRF)是一种常用的生成模型方法,在机器学习技术中具有重要作用。

本文将围绕“机器学习技术中的条件随机场生成模型方法”展开,介绍CRF的概念、应用场景、优势以及训练和推断等相关内容。

首先,我们来了解一下条件随机场的定义和特点。

条件随机场是一种概率图模型,在标注问题中被广泛应用。

它通过学习输入变量和输出变量之间的联合概率分布来解决序列标注、语义分割等问题。

CRF与隐马尔可夫模型(HMM)相似,但CRF可以更好地处理观测特征和标签序列之间的复杂依赖关系。

条件随机场的一个重要应用场景是序列标注。

在自然语言处理任务中,如命名实体识别、词性标注等,CRF常常被用于将观测序列与标签序列进行建模。

通过学习观测特征与标签序列之间的概率关系,CRF可以进行序列标注任务。

与其他方法相比,条件随机场具有以下优势。

首先,CRF可以建模高阶特征的依赖关系。

在标注问题中,往往需要考虑多个相邻位置上的标签之间的关系。

CRF 可以通过对观测特征和标签序列之间的依赖进行建模,从而更好地捕捉上下文信息。

其次,CRF可以通过特征工程来引入领域知识。

通过选择合适的特征,可以提高模型的准确性。

最后,CRF可以通过迭代算法(如梯度下降)进行训练,并且具有较好的收敛性。

这使得CRF可以适用于大规模数据集的训练。

接下来,我们来讨论一下CRF的训练和推断方法。

CRF的训练目标是最大化标签序列的联合概率。

通常使用对数似然函数来定义训练损失,在训练过程中通过优化算法(如梯度下降)来最小化损失函数。

在推断过程中,CRF可以使用维特比算法来寻找最可能的标签序列。

维特比算法是一种动态规划算法,可以高效地找到全局最优解。

除了序列标注,条件随机场还可以应用于其他领域。

例如,图像分割中的像素级分类问题,可以使用CRF来建模像素之间的关系,从而提高分割的准确性。

另外,条件随机场还可以应用于人体姿态估计、物体识别等任务,用于对复杂结构的建模与预测。

基于条件随机场的网络查询模型及其训练方法

25基于条件随机场的网络查询模型及其训练方法这一章我们介绍了生物网络查询问题,和一个基于条件随机场的网络查询模型CNetQ ,并且通过训练方法找出了模型的最优参数。

CNetQ 模型在[5]中首先提出,更详尽的介绍参见[5]。

1.1生物网络查询问题1.1.1问题的定义给定一个生物分子网络G G G (N ,E )=,其中G N 表示G 的节点集,G E 表示G 的边集。

给定一个已知的待查询网络Q Q Q (N ,E )=。

我们假定网络Q 远小于网络G 。

生物网络查询问题就是在网络G 中,找到一个和网络Q 匹配的最好的子网络,其中匹配好是指对应网络节点中的蛋白质构造相似,且对应网络拓扑结构想近。

我们称G 为目标网络,Q 为查询网络。

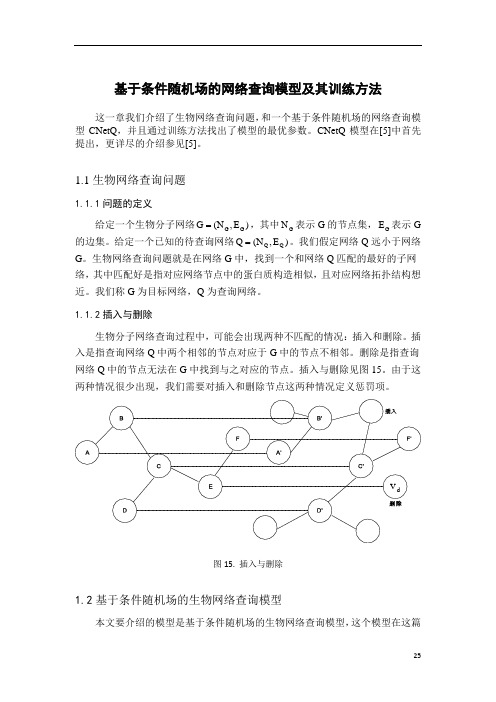

1.1.2插入与删除生物分子网络查询过程中,可能会出现两种不匹配的情况:插入和删除。

插入是指查询网络Q 中两个相邻的节点对应于G 中的节点不相邻。

删除是指查询网络Q 中的节点无法在G 中找到与之对应的节点。

插入与删除见图15。

由于这两种情况很少出现,我们需要对插入和删除节点这两种情况定义惩罚项。

图15. 插入与删除1.2基于条件随机场的生物网络查询模型本文要介绍的模型是基于条件随机场的生物网络查询模型,这个模型在这篇文章中[huang]首先提出,叫做CNetQ 模型。

给定目标网络G G G (N ,E )=、查询网络Q Q Q (N ,E )=。

按照条件随机场模型,标签集合为G 中的节点集并上虚拟点(虚拟点表示删除情形),观测序列为查询网络,标签序列为G 中的子网络。

条件概率可以表示为:Q i j Qn i e i j n N e (x ,x )E 1P(y |x)exp(f (y ,x,i)f (y ,y ,x,i,j))Z(x)∈=∈=+∑∑ 其中:n i i i i i j j e i j i j f (y ,x,i)lnS(x ,y )S(x ,y )S(x ,y )f (y ,y ,x,i,j)ln(W(y ,y ))2=+= d di i 0d y v S(x ,y )R(x,y)R(x,y)otherwise ∆=⎧⎪=∆≤∆⎨⎪⎩(1.1)i i R(x ,y )表示两点之间的相似性,两点之间相似度越高,取值越大。

第14讲条件随机场课件

概率图模型基本思想

� 无向图:马尔可夫随机场(Markov Random Fields, MRF) 马尔可夫随机场模型中包含了一组具有马尔可夫性质的随机变量,这 些变量之间的关系用无向图来表示

� �

马尔科夫性: 举例

p( xi x j , j ≠ i ) = p xi x j , xi ∼ x j

�

Observed Ball Sequence

⋯⋯

�

HMMs等生产式模型存在的问题:

T

P( X ) =

�

所有的Y i = 1

∑ ∏ p( y

i

yi −1 ) p( xi yi )

由于生成模型定义的是联合概率,必须列举所有观察序列的可能值,这对 多数领域来说是比较困难的。

�

基于观察序列中的每个元素都相互条件独立。即在任何时刻观察值仅仅与 状态(即要标注的标签)有关。对于简单的数据集,这个假设倒是合理。 但大多数现实世界中的真实观察序列是由多个相互作用的特征和观察序列 中较长范围内的元素之间的依赖而形成的。

�

HMM是一个五元组 λ= (Y, X, Π, A, B) ,其中 Y是隐状态(输出变量) 的集合,)X是观察值(输入)集合, Π是初始状态的概率,A是状态转移 概率矩阵,B是输出观察值概率矩阵。 today sun cloud rain

yesterday sun cloud rain

⎡ 0.50 0.375 0.125⎤ ⎢ 0.25 0.125 ⎥ 0.625 ⎢ ⎥ ⎢ ⎣ 0.25 0.375 0.375⎥ ⎦

⎡ 0.50 0.375 0.125 ⎤ ⎢ 0.25 0.125 ⎥ 0.625 ⎢ ⎥ ⎢ ⎣ 0.25 0.375 0.375 ⎥ ⎦

条件随机场模型的训练与优化(四)

条件随机场(Conditional Random Field,CRF)是一种概率图模型,主要用于标注或分割序列数据。

它在自然语言处理、计算机视觉和生物信息学等领域都有广泛的应用。

在实际应用中,如何有效地训练和优化条件随机场模型是一个重要的问题。

本文将从条件随机场的基本原理出发,结合模型的训练和优化方法,探讨如何提高条件随机场模型的性能。

条件随机场是一种无向图模型,用于建模标注或分割序列数据。

它的特点是能够对输入的数据进行全局联合特征的建模,从而能够捕捉到数据间的依赖关系。

条件随机场模型的联合概率分布可以表示为:P(Y|X) = 1/Z(X) * exp(∑λt·ft(y, x) + ∑μs·gs(y, x))其中,Y表示标注序列,X表示输入序列,ft(y, x)和gs(y, x)分别表示特征函数和状态函数,λt和μs分别表示特征函数和状态函数的权重,Z(X)是归一化因子,用于保证联合概率分布的和为1。

在训练条件随机场模型时,通常采用极大似然估计或正则化的最大似然估计方法。

极大似然估计的目标是最大化训练数据的对数似然函数,通过梯度下降等优化算法来求解模型的参数。

而正则化的最大似然估计则在极大似然估计的基础上引入正则化项,以解决模型过拟合的问题。

除了传统的优化算法外,近年来深度学习的发展也为条件随机场模型的训练带来了新的思路。

深度学习模型可以作为条件随机场的特征提取器,从而提高模型的性能。

另外,深度学习还可以用于初始化条件随机场模型的参数,加速模型的收敛。

在实际应用中,条件随机场模型的性能往往不仅取决于模型本身,还取决于特征的选择和参数的调优。

因此,如何有效地进行特征工程和参数调优也是提高条件随机场模型性能的关键。

特征工程是指对输入数据进行特征提取和转换,以便模型能够更好地捕捉数据的特性。

在条件随机场模型中,特征工程包括局部特征和全局特征的设计。

局部特征通常包括词性、词形、词义等信息,而全局特征则包括句法结构、语义信息等。

crf原理

crf原理CRF原理。

条件随机场(Conditional Random Field,CRF)是一种经典的概率图模型,广泛应用于自然语言处理、计算机视觉、生物信息学等领域。

它是一种判别式模型,用于标注或分类序列数据,如自然语言句子中的词性标注、命名实体识别,以及图像中的物体检测等任务。

CRF模型的核心思想是利用局部特征和全局特征对序列数据进行建模,从而获得更加准确的标注结果。

CRF模型与隐马尔可夫模型(Hidden Markov Model,HMM)有一定的相似之处,但也有明显的区别。

HMM是一种生成式模型,它假设观测序列由隐藏状态序列生成,而CRF是一种判别式模型,它直接对给定观测序列的标注进行建模。

因此,CRF通常能够更好地捕捉输入数据之间的依赖关系,适用于更加复杂的任务。

CRF模型的核心是定义特征函数和权重,通过对特征函数的加权组合来计算标注序列的概率。

特征函数通常基于局部观测特征和全局上下文特征,用于捕捉序列数据中的模式和规律。

权重则用于调整不同特征函数的重要性,从而影响最终的标注结果。

通过对特征函数和权重的定义和学习,CRF模型能够有效地解决序列标注问题。

在自然语言处理领域,CRF模型被广泛应用于词性标注、命名实体识别、句法分析等任务。

通过利用词语本身的特征以及上下文信息,CRF模型能够有效地提高标注的准确性和鲁棒性。

在计算机视觉领域,CRF模型也被用于图像分割、目标检测等任务。

通过对图像中像素之间的空间关系和像素特征进行建模,CRF模型能够实现更加精准的目标检测和分割。

CRF模型的训练通常采用随机梯度下降等优化算法,通过最大化对数似然函数来学习特征函数的权重。

在训练过程中,需要对标注数据进行特征提取,并构建相应的特征函数。

通过迭代优化权重,使得模型能够逐渐逼近最优解,从而获得更好的泛化能力和鲁棒性。

总的来说,CRF模型作为一种强大的序列标注模型,具有广泛的应用前景和研究价值。

它能够有效地捕捉序列数据中的模式和规律,提高标注任务的准确性和鲁棒性。

crf用法

crf用法

条件随机场(Conditional Random Field,CRF)是一种统计模型,常用于自然语言处理和计算机视觉中的序列标注和分割任务。

在CRF中,给定一组输入随机变量,每个可能的输出随机变量都有一个条件概率,这些条件概率定义了输入和输出之间的关系。

以下是CRF的基本用法:

1.定义特征:首先,你需要定义一组特征函数,用于描述输入数据中

的特征。

这些特征可以是基于词袋模型的词频特征、基于词性的特征、基于上下文的特征等。

特征函数可以对应一个特征向量,其维度根据实际需求而定。

2.训练模型:在训练阶段,你需要提供一组训练数据,其中包含输入

特征和相应的标签。

通过这些数据,CRF模型会学习到输入特征与标签之间的关系,并根据这些关系计算出每个标签的条件概率。

3.预测标签:在预测阶段,对于给定的输入特征,CRF模型会根据训

练阶段学到的条件概率计算出每个标签的后验概率,然后选择具有最大后验概率的标签作为预测结果。

你可以根据需要选择合适的阈值来过滤掉低概率的标签。

需要注意的是,CRF模型通常需要大量的训练数据才能获得较好的性能。

此外,CRF模型对于特征的选择和设计也比较敏感,因此在实际应用中需要根据具体任务和数据特点进行特征工程。

条件随机场模型的效果评估与优化(九)

条件随机场(Conditional Random Fields, CRF)是一种概率图模型,常被用于标注和序列标注的任务中。

它通过考虑输入数据的特征之间的关联关系,来进行标注的预测。

在自然语言处理、生物信息学、计算机视觉等领域,条件随机场都有着广泛的应用。

然而,条件随机场模型在实际应用中,如何进行效果评估与优化,却是一个具有挑战性的问题。

首先,我们来看看条件随机场模型的效果评估。

通常来说,我们会用准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1值等指标来评估模型的性能。

在标注和序列标注任务中,我们可以通过比较模型预测的标注结果与真实标注结果之间的差异,来计算这些指标。

另外,我们还可以使用混淆矩阵(Confusion Matrix)来更细致地分析模型在不同类别上的表现。

除了定量指标,我们还可以通过可视化的方式来观察模型的预测结果,比如绘制标注结果的热力图或者误差分析图。

通过以上多种方式的效果评估,可以更全面地了解模型的性能表现。

然而,单纯地使用这些指标和可视化手段来评估模型的效果,往往还不够。

在实际应用中,我们还需要考虑模型在不同场景下的泛化能力、稳定性和鲁棒性。

泛化能力指模型在新的未见数据上的表现能力,稳定性指模型在不同数据集上的性能稳定程度,鲁棒性指模型对噪声、干扰的抵抗能力。

除此之外,我们还需要考虑模型的计算效率和资源消耗。

因此,我们需要综合考虑定量指标、可视化分析和实际应用场景,来综合评估条件随机场模型的效果。

接着,我们来看看条件随机场模型的优化方法。

在实际应用中,我们常常会面临模型的训练时间长、模型复杂度高等问题。

因此,如何提高模型的训练效率和减小模型的复杂度,是需要重点关注的问题。

首先,我们可以考虑对模型进行特征选择和维度约减,以减小模型的复杂度。

特征选择可以通过领域知识、统计分析等方法来筛选和剔除无用的特征,维度约减可以通过主成分分析、奇异值分解等方法来降低输入数据的维度。

《条件随机场》课件

01

•·

02

基于共轭梯度的优化算法首先使用牛顿法确定一个大致的 参数搜索方向,然后在该方向上进行梯度下降搜索,以找 到最优的参数值。这种方法结合了全局和局部搜索的优势 ,既具有较快的收敛速度,又能避免局部最优解的问题。

03

共轭梯度法需要计算目标函数的二阶导数(海森矩阵), 因此计算量相对较大。同时,该方法对初始值的选择也有 一定的敏感性。在实际应用中,需要根据具体情况选择合 适的优化算法。

高效存储

研究如何利用高效存储技术(如分布式文件系统、NoSQL数据库 等)存储和处理大规模数据。

06

结论与展望

条件随机场的重要性和贡献

01

克服了传统机器学习方法对特征工程的依赖,能够 自动学习特征表示。

02

适用于各种自然语言处理和计算机视觉任务,具有 广泛的应用前景。

03

为深度学习领域带来了新的思路和方法,推动了相 关领域的发展。

概念

它是一种有向图模型,通过定义一组条件独立假设,将观测 序列的概率模型分解为一系列局部条件概率的乘积,从而简 化模型计算。

条件随机场的应用场景

序列标注

在自然语言处理、语音识别、生物信 息学等领域,CRF常用于序列标注任 务,如词性标注、命名实体识别等。

结构化预测

在图像识别、机器翻译、信息抽取等 领域,CRF可用于结构化预测任务, 如图像分割、句法分析、关系抽取等 。

04

条件随机场的实现与应用

自然语言处理领域的应用

词性标注

条件随机场可以用于自然语言处理中 的词性标注任务,通过标注每个单词 的词性,有助于提高自然语言处理的 准确性和效率。

句法分析

条件随机场也可以用于句法分析,即 对句子中的词语进行语法结构分析, 确定词语之间的依存关系,有助于理 解句子的含义和生成自然语言文本。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

条件随机场模型和训练方法条件随机场模型是由[7]首先提出的,这个模型在自然语言处理和生物信息学中得到了广泛的应用,这一章我们简要介绍了条件随机场模型极其训练方法。

更详尽的介绍参见[2],[3],[4]。

2.1训练的定义考虑这样一个问题:给定一个模型,这个模型有很多参数,如何找出模型的最佳参数?训练是解决这个问题的一个方法。

给定一组训练数据和一组模型,按照某个衡量标准,选出最符合训练数据的模型,这个过程叫做训练。

只有选取的训练数据符合现实情况时,选择的模型才能符合现实,因此训练数据的选取是一个重要的问题。

衡量模型的标准有许多个,下面介绍两个衡量标准。

2.1.1极大似然估计(x;)P ω是随机变量X 的概率密度分布函数,ω是其中的参数。

12{x ,x ,...,x }n 是一组随机变量12,,...,X n X X 的观测值,12,,...,X n X X 是一组独立同分布的随机变量,分布与X 相同。

极大似然估计:12'arg max (x ,x ,...,x ;)arg max (x ;)n i iP P ωωωωω==∏ 极大似然估计是一个非常自然的想法,就是选择使训练数据发生概率最大的参数,但极大似然估计的一个缺点是对训练数据的假设太强,不容易满足。

下面介绍的条件似然估计可以克服这个缺点。

2.1.2条件似然估计假设每一个训练数据由两部分组成,形如(x,y);其中x 是已知的观测值,y 的概率分布由x 和ω唯一确定。

为了判断y 的取值,我们只需要刻画条件概率分布(y |x;)ωP 。

我们不用联合概率分布(y,x;)ωP 的原因是x 的取值是已知的,我们不需要刻画x 的概率分布,何况我们很难准确的刻画x 的概率分布。

假设给定一组训练集:1122{(x ,y ),(x ,y ),...,(x ,y )}n n 。

条件似然估计:1212'arg max (y ,y ,...,y |x ,x ,...,x ;)arg max (y |x ;)n n i i iP P ωωωωω==∏ 这里所做的假设是y i 的概率分布仅由x i 和ω决定,即:111(y |x ,...,x ,y ,...,y ;)(y |x ;)i n i i i P P ωω-=下文中将要介绍的条件随机场模型的训练方法就是根据这个思想。

例6.(英文单词划分问题)在一些排版软件中,为了保持美观,有时会需要对一些长的单词按照音节划分、断行,因此需要考虑如何对单词按音节进行划分这个问题。

我们可以把英文单词按照音节分为一些小的部分,比如说单词hyphenation 可以划分为hy-phen-a-tion 。

在这个问题中x 所在的集合是所有单词组成的集合,y 的取值集合是所有0、1序列组成的集合。

y 与单词长度相同,0表示对应字母后面不断开,1表示对应字母后面断开,默认y 的最后一位是0。

例如x=hyphenation 对应的y 是010*******。

显然Y 的取值完全由x 和模型参数决定,因此这个问题可以采用条件似然估计来训练模型。

2.2条件随机场模型x 是给定的观察值,y 的分布由x 和参数ω唯一确定,y 的结构可以由无向图G 表出,y 中的每个随机变量可以取值的集合称为标签集,例如在单词划分问题中,标签集为{0,1}。

x 可以称为观测序列,y 可以称为标记序列。

条件随机场模型是指所有条件概率分布可以表示成如下形式的模型:exp((x,y))(y |x;)(x,)j j jF P Z ωωω=∑ (2.1)其中(x,y)j F 称为特征函数,特征函数分为两类:一类是定义在边上的特征函数,表示为 ,e 遍历图G 中所有边,一类是定义在节点上的特征函数,表示为 , n 遍历图G 中所有节点,两类特征函数可以统一的写为 ;(x,)Z ω称为划分函数, 。

图12. 线性条件随机场模型例7. 单词划分问题中y 的结构如图12所示,这个问题可以用条件随机场模型求解。

下面给出这个问题的一组特征函数模板:2i 1i i 1i I (x x "",y 0,y 1)--=== 3i 2i 1i i 1i I (x x x "",y 0,y 1)---=== 4i 3i 2i 1i i 1i I (x x x x "",y 0,y 1)----===其中代表任意字母,I 为指示函数。

有些单词组合容易组成一个音节,比如说edge edge [1][2]e e e F (x,y)f (y ,y ,x,e)=∑(,)(,,)=∑node noden n F x y f y x n i[1]i[2](x,y)(y ,y ,x,i)=∑j j i F f '(x,)exp((x,y'))ωω=∑∑j j y j Z F“re”、“non”、“tion”,因此这些字母组合对应的特征函数:2i 1i i 1i I (x x "re",y 0,y 1)--===3i 2i 1i i 1i I (x x x "non",y 0,y 1)---===4i 3i 2i 1i i 1i I (x x x x "tion",y 0,y 1)----===的权重比较高。

在这个问题中,由于y 的结构是线形的,我们称这类条件随机场模型为线性条件随机场模型。

2.3条件随机场模型的三个基本问题我们这一节考虑条件随机场模型的三个基本问题,第一个问题是如何对模型进行推断,第二个问题是如何求边际概率,第三个问题是如何训练模型。

条件随机场模型可以看作是无向图模型的一种变形,它与无向图模型的差别在于条件随机场模型中x 是给定的,因此我们可以用1.4节介绍的无向图模型的算法来求解这个问题。

定义: 。

对于推理和求边际概率问题,我们是在一个固定x 上进行操作,因此我们把i i 1i g (y ,y ,x)-简记为i i 1i g (y ,y )-。

由式(2.1)可以看出,x 不同,只会使(x,y)j F 取值不同,因此我们可以把x 的取值信息完全可以通过(x,y)j F 表出,然后不考虑节点x 。

对于不同的x ,我们只需更新(x,y)j F 的取值,如图13所示。

图13. x 的取值信息完全包含在特征函数中对于因式图非树情况,我们可以采用带圈置信传播算法求解模型。

2.3.1 推断下面我们通过对无向图模型的max-sum 算法导出对线性条件随机场模型的Viterbi 算法:i i 1i j i 1i j g (y ,y ,x)f (y ,y ,x,i)--=∑y 的结构如图12所示,我们以n y 为根节点,由公式(1.9)(1.10)我们可以得到:1(v)max[(u)g (u,v)]g y y g k uk k k k μμ→→-=+ 111(u)(u)y g g y k k k k μμ→→---=将上面两式合并后得:11(v)max[(u)g (u,v)]g y y g k uk k k k μμ→→--=+ 初始条件为 这个算法就是著名的Viterbi 算法。

Viterbi 算法的计算复杂性:假设标签集合有m 个元素,模型有n 个节点,由1.4.2中的分析知算法的时间复杂性为2O(n )m ⋅。

2.3.2边际概率对线性(树状)条件随机场模型的sum-product 算法:由公式(1.7)(1.8)我们可以得到:1(v)[(u)exp (u,v)]g y y g k uk k k k g μμ→→-=∑,111(u)(u)yg g y k k k k μμ→→---= 1111(u)[(v)exp (u,v)]g y y g k v k k k k g μμ→→++++=∑,1121(v)(v)yg g y k k k k μμ→→++++= 将上面式子合并化简后得: 11(v)[(u)exp (u,v)]g y g y k uk k k k g μμ→→--=∑1121(u)[(v)exp (u,v)]g y g y k vk k k k g μμ→→++++=∑初始条件为1(v)exp (START,)g y k k g v μ→=采用记号:(k,v)(v)g y k k αμ→=,1(u,k)(v)g y k k βμ→+=。

我们有:(k,v)[(k 1,u)exp (u,v)]k ug αα=-∑1(u,k)[(v,k 1)exp (u,v)]k vg ββ+=+∑(x,)(k,u)(u,k)uZ ωαβ=∑(k,u)(u,k)(y u |x;)(x,)k P Z αβωω== 1(v)(START,)μ→=g y k k g v)图14. 计算线性条件随机场模型的边际分布2.3.3条件随机场模型的训练训练数据集:1122{(f(x ),y ),(f(x ),y ),...,(f(x ),y )}n n ,其中f(x )i 表示第i 个训练数据的所有特征函数,x i 的信息完全包含在f(x )i 中,因此我们可以用f(x )i 代替x i 。

为了避免数值下溢,我们计算log-likelihood:log (y |x ;)((y ,x )log (x ,)k k k w k k i i k ik L P w F Z θω==-∑∑∏(y|x )(y,x )exp((y,x ))((y ,x ))(x ,)((y ,x )(y,x )P(y |x ))((y ,x )[F (y,x )])k k k j m m y m k k w j k kj k k k k j j k y k k k j p j kF F L F w Z F F F E ωω∂=-∂=-=-∑∑∑∑∑∑ 对线性条件随机场模型,我们有:(y|x )(y|x )1(y|x )1,'[F (y,x )][(y ,y ,x ,i)][f (y ,y ,x ,i)](i 1,)f (y,y',x ,i)exp((y,y',x ,i))(y',i)/Z(x,)k k k k k p j p j i i ik p j i i ik k j j j i y y jE E f E y f αωβω++===-∑∑∑∑∑其中第三个等号利用了:1P(y y,y y'|x;)(i 1,)exp((y,y',x ,i))(y',i)/Z(x,)k i i j j jy f ωαωβω-===-∑我们可以把条件随机场的训练问题看成一个无约束最优化问题,目标函数是w L ,计算w L ∇后,可以利用L-BFGS 算法进行优化,关于L-BFGS 算法介绍参见[8]。