条件随机场中的特征抽取与特征生成

crf数据录入和注意事项

crf数据录入和注意事项CRF数据录入和注意事项一、CRF数据录入的概念和作用CRF(Conditional Random Fields,条件随机场)是一种常用的机器学习模型,广泛应用于自然语言处理、计算机视觉等领域。

在使用CRF模型进行训练和预测之前,需要对数据进行录入和准备工作。

CRF数据录入是指将原始数据转换为模型可以接受的格式,并进行相应的预处理。

CRF数据录入的目的是为了将数据转化为机器学习算法可以理解和处理的形式,以便于模型能够从数据中学习到有效的模式和规律。

正确的数据录入是保证模型训练和预测结果准确性的基础。

二、CRF数据录入的步骤和注意事项1. 数据收集和清洗:首先需要收集与任务相关的原始数据,包括文本、图像等。

在收集数据的过程中,要注意数据的质量和有效性。

数据清洗是指对原始数据进行去噪、去重、去除错误等操作,确保数据的准确性和一致性。

2. 特征提取和编码:在进行CRF数据录入之前,需要对原始数据进行特征提取。

特征提取是指从原始数据中抽取出与任务相关的特征,以便于机器学习算法对这些特征进行学习和预测。

常用的特征包括词频、词性、句法结构等。

提取到的特征需要进行编码,将其转换为模型可以接受的数值形式。

3. 数据标注和标签生成:CRF模型是一种有监督学习算法,需要有标注的数据作为训练样本。

数据标注是指对原始数据进行标注,将其与预定义的标签进行对应。

标签生成是指根据任务的要求,生成与每个数据样本相关的标签。

标注和标签生成需要根据具体任务的需求进行,确保标注的准确性和一致性。

4. 数据划分和训练集构建:在进行CRF模型训练之前,需要将数据划分为训练集、验证集和测试集。

训练集用于模型的训练,验证集用于调整模型的超参数和评估模型的性能,测试集用于评估模型的泛化能力。

数据划分的比例要根据数据集的大小和任务的需求进行合理的设置。

5. 数据格式转换和存储:CRF模型通常要求数据以特定的格式进行存储和输入。

第14讲条件随机场课件

概率图模型基本思想

� 无向图:马尔可夫随机场(Markov Random Fields, MRF) 马尔可夫随机场模型中包含了一组具有马尔可夫性质的随机变量,这 些变量之间的关系用无向图来表示

� �

马尔科夫性: 举例

p( xi x j , j ≠ i ) = p xi x j , xi ∼ x j

�

Observed Ball Sequence

⋯⋯

�

HMMs等生产式模型存在的问题:

T

P( X ) =

�

所有的Y i = 1

∑ ∏ p( y

i

yi −1 ) p( xi yi )

由于生成模型定义的是联合概率,必须列举所有观察序列的可能值,这对 多数领域来说是比较困难的。

�

基于观察序列中的每个元素都相互条件独立。即在任何时刻观察值仅仅与 状态(即要标注的标签)有关。对于简单的数据集,这个假设倒是合理。 但大多数现实世界中的真实观察序列是由多个相互作用的特征和观察序列 中较长范围内的元素之间的依赖而形成的。

�

HMM是一个五元组 λ= (Y, X, Π, A, B) ,其中 Y是隐状态(输出变量) 的集合,)X是观察值(输入)集合, Π是初始状态的概率,A是状态转移 概率矩阵,B是输出观察值概率矩阵。 today sun cloud rain

yesterday sun cloud rain

⎡ 0.50 0.375 0.125⎤ ⎢ 0.25 0.125 ⎥ 0.625 ⎢ ⎥ ⎢ ⎣ 0.25 0.375 0.375⎥ ⎦

⎡ 0.50 0.375 0.125 ⎤ ⎢ 0.25 0.125 ⎥ 0.625 ⎢ ⎥ ⎢ ⎣ 0.25 0.375 0.375 ⎥ ⎦

特征选择和特征提取

特征选择和特征提取特征选择(Feature Selection)和特征提取(Feature Extraction)是机器学习领域中常用的特征降维方法。

在数据预处理阶段,通过选择或提取与目标变量相关且有代表性的特征,可以有效提高模型的性能和泛化能力。

特征选择指的是从原始特征集合中选择一部分最相关的特征子集,剔除无关或冗余的特征,以减少计算成本和模型复杂度。

它可以分为三种类型的方法:过滤方法(Filter Method)、包裹方法(Wrapper Method)和嵌入方法(Embedded Method)。

过滤方法是利用统计或信息论的方法来评估特征与目标变量之间的相关程度,然后根据得分来选择特征。

常见的过滤方法包括互信息(Mutual Information)、方差选择(Variance Selection)和相关系数选择(Correlation Selection)等。

包裹方法是在特征子集上训练模型,通过观察模型性能的变化来评估特征子集的优劣,并选择性能最好的特征子集。

包裹方法的代表性算法有递归特征消除(Recursive Feature Elimination)和遗传算法(Genetic Algorithm)等。

嵌入方法则是将特征选择融入到模型的训练过程中,通过训练模型时的正则化项或特定优化目标来选择特征。

常见的嵌入方法有L1正则化(L1 Regularization)和决策树的特征重要性(Feature Importance of Decision Trees)等。

主成分分析是一种无监督学习方法,通过线性变换将原始特征投影到一组正交的主成分上,使得投影后的特征具有最大的方差。

主成分分析可以降低特征的维度,并保留原始特征的主要信息。

线性判别分析是一种有监督学习方法,通过线性变换找到一个投影方式,使得在投影空间中不同类别的样本更容易区分。

线性判别分析可以有效地提取类别间的差异和类别内的相似性。

因子分析则是一种概率模型,通过考虑变量之间的相关性而提取潜在的共享特征。

条件随机场之CRF++源码详解-特征

条件随机场之CRF++源码详解-特征 我在学习条件随机场的时候经常有这样的疑问,crf预测当前节点label如何利⽤其他节点的信息、crf的训练样本与其他的分类器有什么不同、crf 的公式中特征函数是什么以及这些特征函数是如何表⽰的。

在这⼀章中,我将在CRF++源码中寻找答案。

输⼊过程 CRF++训练的⼊⼝在crf_learn.cpp⽂件的main函数中,在该函数中调⽤了encoder.cpp的crfpp_learn(int argc, char **argv)函数。

在CRF++中,训练被称为encoder,显然预测就称为decoder。

crfpp_learn的源码如下:1int crfpp_learn(int argc, char **argv) {2 CRFPP::Param param; //存放输⼊的参数3 param.open(argc, argv, CRFPP::long_options); //处理命令⾏输⼊的参数,存在param对象中4return CRFPP::crfpp_learn(param);5 } Param对象主要存放输⼊的参数,调⽤open⽅法处理命令⾏输⼊的参数并存储。

最后调⽤crfpp_learn(const Param ¶m)函数,在该函数中将初始化Encoder对象encoder,并调⽤encoder的learn⽅法。

样本的处理以及特征的构造 本章的重点便是这个learn⽅法,该⽅法主要是根据输⼊的样本和特征模板构造特征。

阅读该函数源码之前可以去CRF++官⽹了解⼀下CRF++输⼊的参数,以及模板⽂件和训练⽂件的格式。

1bool Encoder::learn(const char *templfile, //模板⽂件2const char *trainfile, //训练样本3const char *modelfile, //模型输出⽂件4bool textmodelfile,5 size_t maxitr,6 size_t freq,7double eta,8double C,9 unsigned short thread_num,10 unsigned short shrinking_size,11int algorithm) {12 std::cout << COPYRIGHT << std::endl;1314 CHECK_FALSE(eta > 0.0) << "eta must be > 0.0"; //CHECK_FALSE是宏定义,如果传⼊的条件是false,则输出异常信息15 CHECK_FALSE(C >= 0.0) << "C must be >= 0.0";16 CHECK_FALSE(shrinking_size >= 1) << "shrinking-size must be >= 1";17 CHECK_FALSE(thread_num > 0) << "thread must be > 0";1819 #ifndef CRFPP_USE_THREAD20 CHECK_FALSE(thread_num == 1)21 << "This architecture doesn't support multi-thrading";22#endif2324if (algorithm == MIRA && thread_num > 1) {//MIRAS算法⽆法启⽤多线程25 std::cerr << "MIRA doesn't support multi-thrading. use thread_num=1"26 << std::endl;27 }2829 EncoderFeatureIndex feature_index; //所有的特征将存储在feature_index中30 Allocator allocator(thread_num); //allocator对象主要⽤来做资源分配以及回收31 std::vector<TaggerImpl* > x; //x存放输⼊的样本,例如:如果做词性标注的话,TaggerTmpl对象存放的是每句话,⽽x是所有句⼦3233 std::cout.setf(std::ios::fixed, std::ios::floatfield);34 std::cout.precision(5);3536#define WHAT_ERROR(msg) do { \37for (std::vector<TaggerImpl *>::iterator it = x.begin(); \38 it != x.end(); ++it) \39 delete *it; \40 std::cerr << msg << std::endl; \41return false; } while (0)4243 CHECK_FALSE(feature_index.open(templfile, trainfile)) //打开“模板⽂件”和“训练⽂件”44 << feature_index.what();4546 {47 progress_timer pg;4849 std::ifstream ifs(WPATH(trainfile));50 CHECK_FALSE(ifs) << "cannot open: " << trainfile;5152 std::cout << "reading training data: " << std::flush;53 size_t line = 0;54while (ifs) { //开始读取训练样本55 TaggerImpl *_x = new TaggerImpl(); //_x存放的是⼀句话的内容,CRF++官⽹中提到,⽤⼀个空⽩⾏将每个sentence隔开56 _x->open(&feature_index, &allocator); //做⼀些属性赋值,所有的句⼦都对应相同的feature_index和allocator对象57if (!_x->read(&ifs) || !_x->shrink()) {58 WHAT_ERROR(_x->what());59 }6061if (!_x->empty()) {62 x.push_back(_x);63 } else {64 delete _x;65continue;66 }6768 _x->set_thread_id(line % thread_num); //每个句⼦都会分配⼀个线程id,可以多线程并发处理不同的句⼦6970if (++line % 100 == 0) {71 std::cout << line << ".. " << std::flush;72 }73 }7475 ifs.close();76 std::cout << "\nDone!";77 }7879 feature_index.shrink(freq, &allocator); // 根据训练是指定的-f参数,将特征出现的频率⼩于freq的过滤掉8081 std::vector <double> alpha(feature_index.size()); // feature_index.size()返回的是maxid_,即:特征函数的个数,alpha是每个特征函数的权重,便是CRF中要学习的参数82 std::fill(alpha.begin(), alpha.end(), 0.0);83 feature_index.set_alpha(&alpha[0]);8485 std::cout << "Number of sentences: " << x.size() << std::endl;86 std::cout << "Number of features: " << feature_index.size() << std::endl;87 std::cout << "Number of thread(s): " << thread_num << std::endl;88 std::cout << "Freq: " << freq << std::endl;89 std::cout << "eta: " << eta << std::endl;90 std::cout << "C: " << C << std::endl;91 std::cout << "shrinking size: " << shrinking_size92 << std::endl;9394 ... //省略后续代码95 }我阅读源码是按照深度优先遍历的⽅式,遇到⼀个函数会不断地深⼊进去,直到理解了该函数的功能再返回。

crf原理

crf原理CRF原理。

条件随机场(Conditional Random Field,CRF)是一种经典的概率图模型,广泛应用于自然语言处理、计算机视觉、生物信息学等领域。

它是一种判别式模型,用于标注或分类序列数据,如自然语言句子中的词性标注、命名实体识别,以及图像中的物体检测等任务。

CRF模型的核心思想是利用局部特征和全局特征对序列数据进行建模,从而获得更加准确的标注结果。

CRF模型与隐马尔可夫模型(Hidden Markov Model,HMM)有一定的相似之处,但也有明显的区别。

HMM是一种生成式模型,它假设观测序列由隐藏状态序列生成,而CRF是一种判别式模型,它直接对给定观测序列的标注进行建模。

因此,CRF通常能够更好地捕捉输入数据之间的依赖关系,适用于更加复杂的任务。

CRF模型的核心是定义特征函数和权重,通过对特征函数的加权组合来计算标注序列的概率。

特征函数通常基于局部观测特征和全局上下文特征,用于捕捉序列数据中的模式和规律。

权重则用于调整不同特征函数的重要性,从而影响最终的标注结果。

通过对特征函数和权重的定义和学习,CRF模型能够有效地解决序列标注问题。

在自然语言处理领域,CRF模型被广泛应用于词性标注、命名实体识别、句法分析等任务。

通过利用词语本身的特征以及上下文信息,CRF模型能够有效地提高标注的准确性和鲁棒性。

在计算机视觉领域,CRF模型也被用于图像分割、目标检测等任务。

通过对图像中像素之间的空间关系和像素特征进行建模,CRF模型能够实现更加精准的目标检测和分割。

CRF模型的训练通常采用随机梯度下降等优化算法,通过最大化对数似然函数来学习特征函数的权重。

在训练过程中,需要对标注数据进行特征提取,并构建相应的特征函数。

通过迭代优化权重,使得模型能够逐渐逼近最优解,从而获得更好的泛化能力和鲁棒性。

总的来说,CRF模型作为一种强大的序列标注模型,具有广泛的应用前景和研究价值。

它能够有效地捕捉序列数据中的模式和规律,提高标注任务的准确性和鲁棒性。

煤矿综采设备故障知识图谱构建

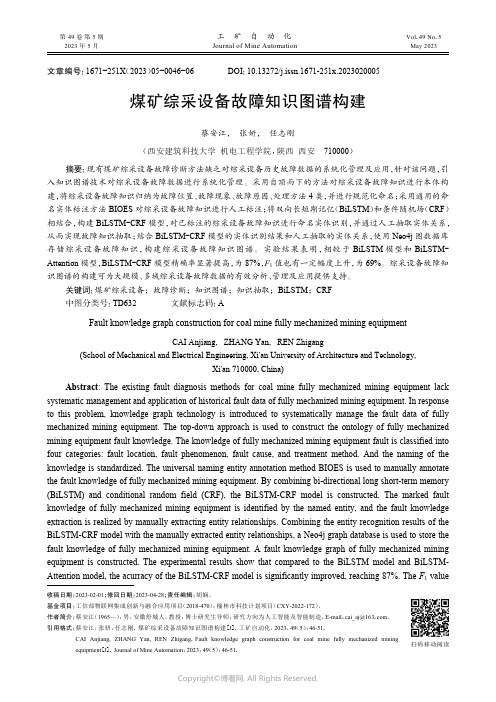

煤矿综采设备故障知识图谱构建蔡安江, 张妍, 任志刚(西安建筑科技大学 机电工程学院,陕西 西安 710000)摘要:现有煤矿综采设备故障诊断方法缺乏对综采设备历史故障数据的系统化管理及应用,针对该问题,引入知识图谱技术对综采设备故障数据进行系统化管理。

采用自顶而下的方法对综采设备故障知识进行本体构建,将综采设备故障知识归纳为故障位置、故障现象、故障原因、处理方法4类,并进行规范化命名;采用通用的命名实体标注方法BIOES 对综采设备故障知识进行人工标注;将双向长短期记忆(BiLSTM )和条件随机场(CRF )相结合,构建BiLSTM −CRF 模型,对已标注的综采设备故障知识进行命名实体识别,并通过人工抽取实体关系,从而实现故障知识抽取;结合BiLSTM −CRF 模型的实体识别结果和人工抽取的实体关系,使用Neo4j 图数据库存储综采设备故障知识,构建综采设备故障知识图谱。

实验结果表明,相较于BiLSTM 模型和BiLSTM −Attention 模型,BiLSTM −CRF 模型精确率显著提高,为87%,F 1值也有一定幅度上升,为69%。

综采设备故障知识图谱的构建可为大规模、多域综采设备故障数据的有效分析、管理及应用提供支持。

关键词:煤矿综采设备;故障诊断;知识图谱;知识抽取;BiLSTM ;CRF 中图分类号:TD632 文献标志码:AFault knowledge graph construction for coal mine fully mechanized mining equipmentCAI Anjiang, ZHANG Yan, REN Zhigang(School of Mechanical and Electrical Engineering, Xi'an University of Architecture and Technology,Xi'an 710000, China)Abstract : The existing fault diagnosis methods for coal mine fully mechanized mining equipment lack systematic management and application of historical fault data of fully mechanized mining equipment. In response to this problem, knowledge graph technology is introduced to systematically manage the fault data of fully mechanized mining equipment. The top-down approach is used to construct the ontology of fully mechanized mining equipment fault knowledge. The knowledge of fully mechanized mining equipment fault is classified into four categories: fault location, fault phenomenon, fault cause, and treatment method. And the naming of the knowledge is standardized. The universal naming entity annotation method BIOES is used to manually annotate the fault knowledge of fully mechanized mining equipment. By combining bi-directional long short-term memory (BiLSTM) and conditional random field (CRF), the BiLSTM-CRF model is constructed. The marked fault knowledge of fully mechanized mining equipment is identified by the named entity, and the fault knowledge extraction is realized by manually extracting entity relationships. Combining the entity recognition results of the BiLSTM-CRF model with the manually extracted entity relationships, a Neo4j graph database is used to store the fault knowledge of fully mechanized mining equipment. A fault knowledge graph of fully mechanized mining equipment is constructed. The experimental results show that compared to the BiLSTM model and BiLSTM-Attention model, the acurracy of the BiLSTM-CRF model is significantly improved, reaching 87%. The F 1 value收稿日期:2023-02-01;修回日期:2023-04-28;责任编辑:胡娴。

条件随机场模型中的特征选择与抽取(十)

条件随机场(Conditional Random Field, CRF)是一种用于序列标注和结构化预测的概率图模型。

它在自然语言处理、计算机视觉等领域有着广泛的应用,如命名实体识别、分词、词性标注等任务。

CRF模型的性能很大程度上取决于特征的选择和抽取。

本文将结合实际案例,探讨CRF模型中特征选择与抽取的一些技巧和注意事项。

数据准备首先,我们需要准备好用于训练和测试的数据。

在NLP任务中,通常会使用已经标注好的语料库作为数据集。

一个常见的做法是将数据集分为训练集和测试集,以便评估模型的性能。

另外,为了减少模型过拟合的风险,还可以使用交叉验证的方法。

特征选择在CRF模型中,特征选择是非常重要的一步。

特征的选择应该充分考虑到任务的领域知识和实际需求。

以命名实体识别为例,可以考虑选择词性、词性组合、前后词性等特征。

此外,还可以考虑上下文信息、词性转移概率等特征。

需要注意的是,特征的数量不能过多,否则会导致模型的复杂度过高,训练时间过长。

特征抽取特征抽取是将原始数据转化为模型可以处理的特征表示形式。

在NLP任务中,常用的特征抽取方法包括词袋模型、TF-IDF、word embedding等。

在CRF模型中,一般会将输入序列转化为特征向量序列。

需要注意的是,特征抽取过程中要考虑到数据的稀疏性和维度灾难问题。

可以通过降维、特征选择等方法来解决这些问题。

特征模板在CRF模型中,特征模板是描述特征之间关系的一种形式。

特征模板的设计直接影响到模型的性能。

在实际应用中,往往需要根据具体任务和数据的特点来设计特征模板。

以命名实体识别为例,可以设计包括当前词的特征、上下文特征、前缀和后缀特征等多种特征模板。

需要注意的是,特征模板的数量不宜过多,否则会导致模型复杂度过高。

实例分析下面我们以中文分词任务为例,来看一下特征选择与抽取在CRF模型中的具体应用。

假设我们有一段中文文本“我爱北京天安门”,需要对其进行分词。

首先,我们可以选择一些基本的特征,如词本身、词性等。

《条件随机场》课件

01

•·

02

基于共轭梯度的优化算法首先使用牛顿法确定一个大致的 参数搜索方向,然后在该方向上进行梯度下降搜索,以找 到最优的参数值。这种方法结合了全局和局部搜索的优势 ,既具有较快的收敛速度,又能避免局部最优解的问题。

03

共轭梯度法需要计算目标函数的二阶导数(海森矩阵), 因此计算量相对较大。同时,该方法对初始值的选择也有 一定的敏感性。在实际应用中,需要根据具体情况选择合 适的优化算法。

高效存储

研究如何利用高效存储技术(如分布式文件系统、NoSQL数据库 等)存储和处理大规模数据。

06

结论与展望

条件随机场的重要性和贡献

01

克服了传统机器学习方法对特征工程的依赖,能够 自动学习特征表示。

02

适用于各种自然语言处理和计算机视觉任务,具有 广泛的应用前景。

03

为深度学习领域带来了新的思路和方法,推动了相 关领域的发展。

概念

它是一种有向图模型,通过定义一组条件独立假设,将观测 序列的概率模型分解为一系列局部条件概率的乘积,从而简 化模型计算。

条件随机场的应用场景

序列标注

在自然语言处理、语音识别、生物信 息学等领域,CRF常用于序列标注任 务,如词性标注、命名实体识别等。

结构化预测

在图像识别、机器翻译、信息抽取等 领域,CRF可用于结构化预测任务, 如图像分割、句法分析、关系抽取等 。

04

条件随机场的实现与应用

自然语言处理领域的应用

词性标注

条件随机场可以用于自然语言处理中 的词性标注任务,通过标注每个单词 的词性,有助于提高自然语言处理的 准确性和效率。

句法分析

条件随机场也可以用于句法分析,即 对句子中的词语进行语法结构分析, 确定词语之间的依存关系,有助于理 解句子的含义和生成自然语言文本。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

条件随机场中的特征抽取与特征生成

条件随机场(Conditional Random Field,CRF)是一种概率图模型,广泛应用

于自然语言处理、计算机视觉等领域。

在CRF中,特征抽取与特征生成是非常重

要的步骤,它们决定了模型的性能和泛化能力。

一、特征抽取

特征抽取是从原始数据中提取有用信息的过程。

在CRF中,特征抽取是为了

将输入数据转化为能够反映标注信息的特征向量。

特征抽取的目标是选择能够最好地刻画标注信息的特征。

在自然语言处理任务中,常用的特征抽取方法有基于词的特征和基于句法的特征。

基于词的特征可以包括词本身的特征(如词性、词频等)、词与上下文的关系特征(如前后词的词性、词的位置等)。

基于句法的特征可以包括句法树的特征(如句法依存关系、句法路径等)。

特征抽取的关键在于选择合适的特征。

好的特征应该能够充分表达标注信息,

同时具有一定的泛化能力。

特征的选择可以基于领域知识、经验和实验结果。

通常,特征的数量越多,模型的表达能力越强,但也会增加计算复杂度和可能引入噪音。

二、特征生成

特征生成是指在CRF模型中,通过特征函数将特征抽取得到的特征映射到概

率空间。

特征函数定义了特征在不同标注序列上的取值,并且通过权重参数来调整特征的重要性。

特征生成的关键在于设计合适的特征函数。

特征函数的选择应该能够充分利用

抽取得到的特征,同时具有一定的灵活性。

常用的特征函数包括指示函数(Indicator Function)和高斯函数(Gaussian Function)。

指示函数将特征映射为0

或1,用于表示某个特征是否出现;高斯函数将特征映射为一个实数值,用于表示特征的强度。

特征生成的过程中,还需要为每个特征函数分配一个权重参数。

权重参数的学习可以通过最大似然估计、正则化等方法来实现。

权重参数的选择会直接影响模型的预测能力和泛化能力。

合理的权重参数可以使得模型更好地适应训练数据,并具有较好的泛化能力。

三、特征抽取与特征生成的影响

特征抽取和特征生成是CRF模型的关键步骤,它们直接影响了模型的性能和泛化能力。

合理选择特征和特征函数可以提高模型的预测准确率和鲁棒性。

特征抽取的质量对模型的性能至关重要。

好的特征能够充分刻画标注信息,提供丰富的上下文信息,从而提高模型的判别能力。

合适的特征抽取方法可以克服数据稀疏性和维度灾难等问题,提高模型的泛化能力。

特征生成的选择和权重参数的学习也对模型的性能有重要影响。

合适的特征函数可以将特征映射到概率空间,使得模型能够进行准确的标注预测。

权重参数的学习可以通过优化算法来实现,使得模型更好地拟合训练数据和泛化到新数据。

总之,特征抽取和特征生成是CRF模型中至关重要的步骤。

合理选择特征和特征函数可以提高模型的性能和泛化能力。

特征抽取和特征生成的研究是CRF模型发展的重要方向,通过不断改进特征抽取和特征生成方法,可以进一步提高CRF模型在自然语言处理和计算机视觉等领域的应用效果。