7个经典python爬虫案例代码分享

python爬虫案例详解

python爬虫案例详解Python爬虫是一种通过编写代码自动提取互联网上的信息的技术。

它可以模拟人类的浏览器行为,访问网页、提取数据并进行处理。

下面将介绍十个Python爬虫案例,包括网页爬取、数据提取、数据分析等方面。

1. 爬取公众号文章通过爬虫可以抓取微信公众号上的文章,可以根据关键词进行搜索,获取相关文章的标题、作者、发布时间等信息。

2. 爬取电商网站商品信息可以通过爬虫抓取电商网站上的商品信息,包括名称、价格、销量等,并将这些信息存储到本地或数据库中,方便后续的数据分析和处理。

3. 爬取股票数据通过爬虫可以获取股票交易所的实时数据,包括股票名称、代码、最新价格、涨跌幅等,可以用于股票分析和交易策略的制定。

4. 爬取新闻网站的新闻内容可以通过爬虫抓取新闻网站上的新闻内容,包括标题、正文、发布时间等,可以根据关键词进行搜索,获取相关新闻的信息。

5. 爬取社交媒体数据可以通过爬虫抓取社交媒体平台上的用户信息、帖子内容等,可以用于用户行为分析、舆情监控等。

6. 爬取电影信息可以通过爬虫抓取电影网站上的电影信息,包括电影名称、导演、主演、评分等,可以用于电影推荐、观影分析等。

7. 爬取音乐歌曲数据可以通过爬虫抓取音乐网站上的歌曲信息,包括歌曲名称、歌手、专辑、播放量等,可以用于音乐推荐、歌曲排行等。

8. 爬取天气数据可以通过爬虫抓取气象网站上的天气数据,包括城市、温度、湿度、风力等,可以用于天气预报、气候分析等。

9. 爬取房产信息可以通过爬虫抓取房产网站上的房源信息,包括房屋类型、面积、价格、位置等,可以用于房产市场分析和购房决策。

10. 爬取招聘信息可以通过爬虫抓取招聘网站上的职位信息,包括职位名称、公司、薪资、要求等,可以用于求职市场分析和就业机会的评估。

以上是十个Python爬虫案例的简要介绍,通过爬虫可以获取互联网上各种数据,为数据分析和决策提供了便利。

但在使用爬虫时需要注意合法性和道德性,遵守相关法律法规,不进行侵权行为。

Python爬虫实战案例分享

Python爬虫实战案例分享Python爬虫是一种通过编写程序来自动化获取互联网上数据的技术,如今在信息获取和数据分析领域中被广泛应用。

本文将分享一些Python爬虫的实战案例,以展示其在实际项目中的应用。

案例一:天气数据获取首先,我们以获取天气数据为例。

通过使用Python的请求库和数据解析库,我们可以编写一个简单的爬虫程序来获取实时的天气信息。

首先,我们需要选择一个可信赖的天气数据源,并通过请求库发送HTTP请求获取数据。

接着,使用数据解析库来解析返回的数据,并提取我们所需的天气信息。

最后,我们可以将获取到的数据保存至本地文件或数据库中,以备进一步分析使用。

案例二:新闻数据采集其次,我们以新闻数据采集为案例。

通过使用Python的爬虫技术,我们可以编写一个程序来定时自动采集新闻信息。

首先,我们需要确定采集的新闻网站,并通过请求库发送HTTP请求获取网页内容。

接着,使用数据解析库来解析网页内容,并提取出新闻标题、发布时间等信息。

最后,我们可以将获取到的数据保存至本地文件或数据库中,以供后续分析或展示。

案例三:电影数据分析最后,我们以电影数据分析为案例。

通过使用Python的爬虫技术,我们可以采集电影相关的数据,并进行数据分析。

首先,我们需要选择一个可信赖的电影数据源,并通过请求库发送HTTP请求获取数据。

接着,使用数据解析库来解析返回的数据,并提取电影的名称、评分、演员等信息。

最后,我们可以使用数据分析工具,如Pandas和Matplotlib,对电影数据进行统计分析和可视化展示。

总结:通过以上实战案例的分享,我们可以看到Python爬虫在各个领域中的应用潜力。

从获取天气数据到新闻数据采集,再到电影数据分析,Python爬虫帮助我们实现了自动化数据获取和处理,极大地提高了工作效率和数据分析能力。

相信随着技术的不断发展,Python爬虫将在更多的领域中迎来更广泛的应用。

通过本文的分享,希望读者们能够对Python爬虫有更深入的了解,并在实际项目中灵活运用。

python 爬虫案例

python 爬虫案例Python爬虫是一种自动化获取互联网数据的技术,它可以帮助我们快速地获取大量的数据,从而进行数据分析、挖掘和应用。

下面是一些Python爬虫案例,它们涵盖了不同的领域和应用场景。

1. 爬取天气数据天气数据是我们日常生活中非常重要的信息之一,我们可以使用Python爬虫来获取各个城市的天气数据。

通过爬取天气网站的数据,我们可以获取到当天的天气情况、温度、湿度、风力等信息,从而为我们的出行和生活提供参考。

2. 爬取新闻数据新闻是我们获取时事信息的重要途径之一,我们可以使用Python 爬虫来获取各大新闻网站的新闻数据。

通过爬取新闻网站的数据,我们可以获取到最新的新闻资讯、热点话题、社会事件等信息,从而了解社会动态和时事热点。

3. 爬取电影数据电影是我们娱乐生活中不可或缺的一部分,我们可以使用Python 爬虫来获取各大电影网站的电影数据。

通过爬取电影网站的数据,我们可以获取到电影的名称、导演、演员、评分等信息,从而为我们的电影选择提供参考。

4. 爬取股票数据股票是我们投资理财中非常重要的一部分,我们可以使用Python 爬虫来获取各大股票网站的股票数据。

通过爬取股票网站的数据,我们可以获取到股票的价格、涨跌幅、成交量等信息,从而为我们的投资决策提供参考。

5. 爬取商品数据商品是我们购物消费中非常重要的一部分,我们可以使用Python 爬虫来获取各大电商网站的商品数据。

通过爬取电商网站的数据,我们可以获取到商品的名称、价格、销量、评价等信息,从而为我们的购物决策提供参考。

6. 爬取招聘数据招聘是我们求职就业中非常重要的一部分,我们可以使用Python 爬虫来获取各大招聘网站的招聘数据。

通过爬取招聘网站的数据,我们可以获取到招聘的职位、薪资、要求等信息,从而为我们的求职决策提供参考。

7. 爬取房产数据房产是我们生活中非常重要的一部分,我们可以使用Python爬虫来获取各大房产网站的房产数据。

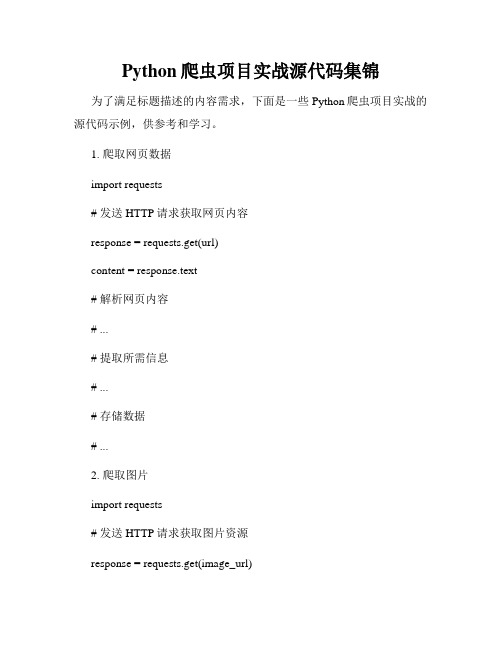

Python爬虫项目实战源代码集锦

Python爬虫项目实战源代码集锦为了满足标题描述的内容需求,下面是一些Python爬虫项目实战的源代码示例,供参考和学习。

1. 爬取网页数据import requests# 发送HTTP请求获取网页内容response = requests.get(url)content = response.text# 解析网页内容# ...# 提取所需信息# ...# 存储数据# ...2. 爬取图片import requests# 发送HTTP请求获取图片资源response = requests.get(image_url)# 保存图片到本地with open('image.jpg', 'wb') as f:f.write(response.content)3. 爬取动态网页from selenium import webdriver # 启动浏览器驱动driver = webdriver.Chrome()# 打开动态网页driver.get(url)# 等待动态内容加载完成# ...# 提取所需信息# ...# 存储数据# ...4. 登录网站并获取数据import requests# 登录网站login_data = {'username': 'your_username','password': 'your_password'}session = requests.Session() session.post(login_url, data=login_data) # 发送登录后的请求response = session.get(url)# 解析网页内容# ...# 提取所需信息# ...# 存储数据# ...5. 反爬虫处理import requestsfrom fake_useragent import UserAgent # 构造随机HTTP请求头user_agent = UserAgent().random# 发送带有伪装的HTTP请求headers = {'User-Agent': user_agent}response = requests.get(url, headers=headers)# 解析网页内容# ...# 提取所需信息# ...# 存储数据# ...以上是一些Python爬虫项目实战源代码的简单示例,可以根据具体项目的需求进行修改和扩展。

Python网络爬虫的数据采集与分析案例分享

Python网络爬虫的数据采集与分析案例分享随着互联网的快速发展,数据成为了当今社会的一项重要资源。

而网络爬虫作为一种自动化工具,能够帮助我们从互联网上获取大量的数据,为我们的数据分析提供了很大的便利。

本文将分享几个实际案例,演示如何使用Python网络爬虫进行数据采集与分析。

案例一:天气数据采集与分析在实际生活中,我们经常需要了解天气情况以便做出相应的安排。

而许多网站提供了天气预报的信息,我们可以使用Python爬虫库来获取这些数据。

通过分析历史天气数据,我们可以揭示出一些有趣的趋势和规律,如某地区的季节性变化、气温变化趋势等。

这些数据可以帮助我们做出更准确的天气预测和决策。

案例二:股票数据采集与分析股票市场一直是人们关注的焦点,而股票数据的采集和分析对于投资者来说尤为重要。

我们可以使用Python爬虫从金融网站获取股票的实时价格、历史数据和相关新闻等信息。

通过分析这些数据,我们可以发现股票价格的波动规律,预测趋势,制定相应的投资策略,提高投资收益。

案例三:舆情数据采集与分析舆情分析是一种通过网络爬虫收集大众言论,并对其进行情感分析和主题分析的方法。

舆情分析可以用于政府决策、企业品牌建设、新闻报道等方面。

我们可以使用Python爬虫从社交媒体平台、论坛等网站上获取公众对某个事件、产品或者品牌的评论和评价。

通过情感分析和主题分析,我们可以了解到大众的看法和反应,为决策提供参考。

案例四:电影数据采集与分析电影作为一种重要的文化载体,一直受到人们的喜爱。

我们可以使用Python爬虫从电影评价网站获取电影的评分、评论、导演等信息。

通过分析这些数据,我们可以了解到观众对于不同类型电影的喜好、各个导演的特点等。

这些信息对于电影业的发展和电影推荐系统的建立都具有重要意义。

综上所述,Python网络爬虫是一种强大的工具,通过它我们能够方便地从互联网上获取各种数据资源。

在数据采集的基础上,我们可以对这些数据进行深入的分析,揭示出一些有价值的信息和规律,为决策和研究提供帮助。

python爬虫500条案例

python爬虫500条案例

以下是一些Python爬虫的案例,每个案例都可以爬取500条数据:1. 爬取豆瓣电影Top250的电影信息,包括电影名称、评分、导演和主演等信息。

2. 爬取知乎某个话题下的问题和回答,包括问题标题、回答内容和回答者信息等。

3. 爬取新浪微博某个用户的微博内容和点赞数,包括微博正文、发布时间和点赞数等。

4. 爬取天猫某个品牌的商品信息,包括商品名称、价格、销量和评价等。

5. 爬取百度百科某个词条的内容和参考资料,包括词条简介、基本信息和参考链接等。

6. 爬取中国天气网某个城市的天气情况,包括当前天气、未来七天的天气预报和空气质量等。

7. 爬取微信公众号某个账号的文章信息,包括文章标题、发布时间和阅读量等。

8. 爬取京东某个商品分类下的商品信息,包括商品名称、价格、评论数和销量等。

9. 爬取猫眼电影某个地区的电影票房排行榜,包括电影名称、票房和上映时间等。

10. 爬取汽车之家某个车型的用户评价,包括评价内容、评分和用户信息等。

以上只是一些常见的爬虫案例,你可以根据自己的兴趣和需求,选择合适的网站和数据进行爬取。

注意,在进行爬虫时要遵守网站的相关规定,避免对网站造成过大的负担。

python7个爬虫小案例详解(附源码)

python7个爬虫小案例详解(附源码)Python 7个爬虫小案例详解(附源码)1. 爬取百度贴吧帖子使用Python的requests库和正则表达式爬取百度贴吧帖子内容,对网页进行解析,提取帖子内容和发帖时间等信息。

2. 爬取糗事百科段子使用Python的requests库和正则表达式爬取糗事百科段子内容,实现自动翻页功能,抓取全部内容并保存在本地。

3. 抓取当当网图书信息使用Python的requests库和XPath技术爬取当当网图书信息,包括书名、作者、出版社、价格等,存储在MySQL数据库中。

4. 爬取豆瓣电影排行榜使用Python的requests库和BeautifulSoup库爬取豆瓣电影排行榜,并对数据进行清洗和分析。

将电影的名称、评分、海报等信息保存到本地。

5. 爬取优酷视频链接使用Python的requests库和正则表达式爬取优酷视频链接,提取视频的URL地址和标题等信息。

6. 抓取小说网站章节内容使用Python的requests库爬取小说网站章节内容,实现自动翻页功能,不断抓取新的章节并保存在本地,并使用正则表达式提取章节内容。

7. 爬取新浪微博信息使用Python的requests库和正则表达式爬取新浪微博内容,获取微博的文本、图片、转发数、评论数等信息,并使用BeautifulSoup 库进行解析和分析。

这些爬虫小案例涵盖了网络爬虫的常见应用场景,对初学者来说是很好的入门教程。

通过学习这些案例,可以了解网络爬虫的基本原理和常见的爬取技术,并掌握Python的相关库的使用方法。

其次,这些案例也为后续的爬虫开发提供了很好的参考,可以在实际应用中进行模仿或者修改使用。

最后,这些案例的源码也为开发者提供了很好的学习资源,可以通过实战来提高Python编程水平。

10个python爬虫练手项目案例

10个python爬虫练手项目案例学习Python爬虫时,通过完成一些练手项目可以更好地巩固知识。

以下是一些适合初学者的Python爬虫练手项目案例:

1. 简单网页爬取:使用requests 库获取并打印网页的内容。

2. 图片下载器:爬取特定网站上的图片并下载到本地。

3. 新闻网站爬虫:从新闻网站抓取最新的新闻标题和链接。

4. 天气信息获取:从天气网站获取当前城市的天气信息。

5. 翻译工具:制作一个简单的翻译工具,可以将输入的文本翻译成其他语言。

6. 电影信息爬取:从电影数据库(如IMDb)中获取电影的相关信息。

7. GitHub仓库信息:获取GitHub上指定用户或仓库的信息。

8. 豆瓣电影Top250:从豆瓣电影Top250榜单中获取电影信息。

9. 动态网页爬虫:使用Selenium等工具爬取动态加载的网页内容。

10. 招聘信息爬取:从招聘网站上获取特定职位的招聘信息。

这些项目可以帮助您熟悉Python爬虫的基本原理,掌握网络请求、HTML解析、数据存储等技能。

在进行爬虫项目时,请确保遵守网站的使用条款和规定,以避免违反法律或道德规范。

1/ 1。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Python作为一种简单易学的编程语言,广受程序员和数据科学家的喜爱。

其中,用Python进行网络爬虫的应用也越来越广泛。

本文将共享7个经典的Python爬虫案例代码,希望能够给大家带来启发和帮助。

1. 爬取豆瓣电影排行榜数据在本例中,我们将使用Python的requests库和BeautifulSoup库来爬取豆瓣电影排行榜的数据。

我们需要发送HTTP请求获取网页内容,然后使用BeautifulSoup库解析HTML文档,提取出我们需要的电影名称、评分等信息。

我们可以将这些数据保存到本地或者进行进一步的分析。

```pythonimport requestsfrom bs4 import BeautifulSoupurl = 'response = requests.get(url)soup = BeautifulSoup(response.text, 'html.parser')for movie in soup.find_all('div', class_='item'):title = movie.find('span', class_='title').textrating = movie.find('span', class_='rating_num').textprint(title, rating)```2. 爬取博博用户信息在这个案例中,我们将利用Python的requests库和正则表达式来爬取博博用户的基本信息。

我们需要登录博博并获取用户主页的URL,然后发送HTTP请求获取用户主页的HTML文档。

我们可以使用正则表达式来提取用户的昵称、性别、位置区域等信息。

我们可以将这些信息保存到数据库或者进行其他处理。

```pythonimport requestsimport reurl = 'response = requests.get(url)pattern = repile(r'<title>(.*?)</title>.*?昵称:(.*?)<.*?性别:(.*?)<.*?地区:(.*?)<', re.S)result = re.search(pattern, response.text)if result:username = result.group(2)gender = result.group(3)location = result.group(4)print(username, gender, location)```3. 爬取新浪新闻在这个案例中,我们将使用Python的requests库和XPath来爬取新浪新闻的标题和信息。

我们需要发送HTTP请求获取新浪新闻首页的HTML文档,然后使用lxml库的XPath定位工具提取出新闻标题和信息。

我们可以将这些信息保存到数据库或者生成HTML页面展示出来。

```pythonimport requestsfrom lxml import etreeurl = 'response = requests.get(url)selector = etree.HTML(response.text)news_titles = selector.xpath('//a[@target="_blank"]/text()')news_links = selector.xpath('//a[@target="_blank"]/@href')for i in range(len(news_titles)):print(news_titles[i], news_links[i])```4. 爬取百度图片在本例中,我们将利用Python的requests库和正则表达式来爬取百度图片的URL。

我们需要发送HTTP请求获取百度图片搜索结果的HTML文档,然后使用正则表达式提取出图片的URL。

我们可以根据图片的URL下载图片到本地或者进行其他处理。

```pythonimport requestsimport reurl = 'response = requests.get(url)pattern = repile(r'"objURL":"(.*?)"', re.S)result = re.findall(pattern, response.text)for i, img_url in enumerate(result):with open(f'python_image_{i}.jpg', 'wb') as f:f.write(requests.get(img_url).content)```5. 爬取网易云音乐歌单数据在这个案例中,我们将使用Python的requests库和json库来爬取网易云音乐的歌单数据。

我们需要发送HTTP请求获取歌单的JSON 数据,然后使用json库解析JSON数据提取出歌曲名称、歌手、专辑等信息。

我们可以将这些数据保存到数据库或者进行其他处理。

```pythonimport requestsimport jsonurl = 'response = requests.get(url)data = json.loads(response.text)for song in data['result']['tracks']:name = song['name']artist = song['artists'][0]['name']album = song['album']['name']print(name, artist, album)```6. 爬取天气预报在这个案例中,我们将使用Python的requests库和正则表达式来爬取天气预报的数据。

我们需要发送HTTP请求获取天气预报页面的HTML文档,然后使用正则表达式提取出当天和未来几天的天气情况。

我们可以将这些数据保存到数据库或者生成HTML页面展示出来。

```pythonimport requestsimport reurl = 'response = requests.get(url)pattern = repile(r'<h1>(.*?)</h1>.*?<pclass="wea">(.*?)</p>.*?class="tem">(.*?)<span>(.*?)</span>. *?alt="(.*?)"/>', re.S)result = re.findall(pattern, response.text)for item in result:date = item[0]weather = item[1]temperature_low = item[2]temperature_high = item[3]wind = item[4]print(date, weather, temperature_low, temperature_high, wind)```7. 爬取知识热榜在本例中,我们将利用Python的requests库和json库来爬取知识热榜的数据。

我们需要发送HTTP请求获取知识热榜的JSON数据,然后使用json库解析JSON数据提取出问题标题、问题信息、热度等信息。

我们可以将这些数据保存到数据库或者进行其他处理。

```pythonimport requestsimport jsonurl = 'headers = {'User-Agent': 'Mozilla/5.0'}response = requests.get(url, headers=headers)data = json.loads(response.text)for item in data['data']:question_title = item['target']['question']['title']question_url = ' + str(item['target']['question']['id'])hotness = item['target']['metrics_area']['text']print(question_title, question_url, hotness)```以上便是7个经典的Python爬虫案例代码共享,通过这些例子,我们可以学习到如何使用Python来进行网络爬虫,获取网页数据并进行进一步的处理和分析。

希望这些案例能够对大家有所帮助,也希望大家能够在使用爬虫的过程中遵守相关法律法规,文明爬虫,不要给全球信息湾和他人带来不必要的困扰。