粒子群优化算法及其参数设置(程序部分)

粒子群算法及其优化方案

粒子群算法及其优化方案【摘要】粒子群算法作为一种智能优化算法,由于其实现简单,易于与其他方法结合,在现实应用中逐渐显示出强大的优势。

本文首先介绍了基本的粒子群算法,分析了粒子群算法的优化方面,并且对不同的优化方面进行详细分析。

【关键词】粒子群算法;收敛性;优化1 引言粒子群算法(particle swarm optimization,PSO)也称粒子群优化算法,是由Kennedy与Eberhart在鸟类和鱼类等生物群体觅食行为的启发下提出的一种智能优化算法[1]。

PSO初始化为一群随机粒子,然后通过迭代找到最优解。

在每一次迭代中,粒子通过跟踪两个“极值”来进行自我更新。

第一个就是粒子本身的最优解,该解为个体极值(pBest)。

另一极值是整个种群的最优解,该极值为全局极值(gBest)。

PSO以其实现简单、精度高、收敛快等优点在科学计算中得到了广泛关注。

关于PSO算法的理论研究主要集中在算法的结构和性能改善方面,如参数分析,拓扑结构,粒子多样性保持,算法融合和性能比较等[2]。

在PSO算法的应用研究方面,最初应用于神经元网络的训练,之后被用于解决函数优化问题和约束优化问题,如将PSO应用于自动控制系统设计[3]、控制核电机组输出稳定电压[4]、大气中臭氧层的预测[5]等。

目前,PSO 算法已经广泛应用于非线性规划,车辆路径,多目标优化等问题[6]。

2 基本粒子群算法对于基本的粒子群算法[1],在找到最优值时,粒子根据如下的公式来更新自己的速度和新的位置,具体如下:算法流程:1)随机初始化各粒子的速度和位置。

2)根据等式(1)和等式(2)更新粒子的速度和位置。

3)对每个粒子,将其当前位置与历史最优的位置比较,若更优,则将其作为历史最优位置,否则沿用历史最优位置。

4)将每个粒子的个体最优位置与群体所最优位置进行比较,若更优,则将其作为群体最优,否则群体最优位置保持不变。

5)若达到结束条件(即足够好的解或最大迭代次数),则结束,否则转步骤2)。

粒子群算法速度最大最小取值

粒子群算法中速度最大最小值的含义与设置粒子群算法是一种经典的优化算法,它通过模拟鸟群寻找食物的行为,来寻找最优解。

其中,粒子的速度是粒子群算法中一个非常重要的参数。

而如何设置速度的最大最小值,直接影响到算法的收敛速度和最终结果的优劣。

首先,我们来看速度最大最小值的含义。

在粒子群算法中,速度是指粒子在问题空间中移动的距离和方向。

通常来说,速度有两个方向分量,一个是横向方向,也就是速度的大小,另一个是纵向方向,也就是速度的方向。

因此,速度最大最小值就是指速度大小的最大最小值。

其次,我们来看速度最大最小值的设置。

一般来说,速度的最大值和最小值都需要在算法执行前指定。

当速度太小时,粒子只能慢慢地往目标点移动,算法收敛速度较慢,粒子搜索范围较小;而当速度太大时,粒子容易越过最优解点,导致粒子在空间中迷失,甚至无法收敛。

因此,一般来说,速度的最大最小值需要结合具体的问题来进行调整,在保证算法正常运行的情况下,尽可能地提高算法的搜索速度和搜索范围。

最后,我们来看一下速度最大最小值的影响。

当粒子的速度大小不受限制时,粒子可以在问题空间中随意移动,这样会导致算法无法收敛。

而当速度大小过小时,算法收敛速度过慢,粒子搜索范围较小,很容易陷入局部最优点而无法跳出。

因此,在实际应用中,我们需要根据具体的问题来对速度最大最小值进行调整,以取得更好的搜索效果。

总之,粒子群算法中速度最大最小值的含义和设置对于算法的搜索效果有着非常重要的影响,需要根据具体问题进行调整,以取得更好的结果。

粒子群优化算法(PSO)综述介绍

带收缩因子的PSO算法:

vi

t 1

X [ v i 1U 1 ( pbi x i ) 2U 2 ( gb x i )]

t t t t t t t

收缩因子保证了收敛性并提高了收敛速度。 显然,该迭代公式和标准迭代公式相比并无本质区别, 只要适当选取参数,二者完全相同。

局部PSO算法:

在计算机上模拟该模型的结果显示:当g_increment较大 时,所有的个体很快地聚集到“谷地”上;反之,粒子缓 慢地摇摆着聚集到“谷地”的四周。 受此模型启发Kennedy和Eberhart设计出了一种演化优化 算法,并通过不断的试验和试错,最后将此算法的基本型 固定为:

vi

t 1

v i 1U 1 ( pbi x i ) 2U 2 ( gb x i )

vi

t 1

v i 1U 1 ( pbi x i ) 2U 2 ( lb x i )

t t t t t为自身最优位置 pbest和种群最优位置gbest。 对应的,在局部版本中,微粒除了追随自身最优位置 pbest之外,不跟踪种群最优位置gbest,而是跟踪拓 扑邻域中的所有微粒的最优位置lbest。

算法思想:

1.初始化种群数量,使他们随机的分布在平面上; 2.根据模型评估每个粒子的位置; 3.如果一个粒子当前的位置比它之前的的位置好,则记录下 新位置,记为pbest;

4.确定种群中最好的粒子的位置,记为gbest;

5.根据公式:

vi

t 1

v i 1U 1 ( p bi x i ) 2U 2 ( g b x i )

背景知识:

粒子群优化算法(Particle Swarm Optimization——PSO), 是由J. Kennedy和R. C. Eberhart于1995年提出的一种基 于种群的随机的优化算法。

高斯量子行为粒子群优化(gqpso)算法

高斯量子行为粒子裙优化(GQPSO)算法是一种基于量子行为的进化优化算法,它结合了粒子裙优化(PSO)算法和量子计算的特点,能够有效地解决复杂优化问题。

本文将从以下几个方面介绍GQPSO算法的原理、特点和应用,希望能够为读者提供深入的了解。

一、GQPSO算法的原理GQPSO算法是基于粒子裙优化算法和量子计算的原理而提出的,它采用了一种全新的粒子编码和演化方式,通过模拟粒子在量子力学中的行为进行搜索和优化。

GQPSO算法的原理如下:1. 量子位表示在GQPSO算法中,每个粒子被表示为一个量子位,根据其在搜索空间中的位置,每个粒子的量子位可以被编码为一个二进制字符串。

这种量子位表示方式能够更好地描述粒子的位置和速度,从而更好地指导搜索过程。

2. 高斯量子演化GQPSO算法通过高斯量子演化来更新粒子的量子位和速度,其中包括量子位的变换和速度的更新。

在高斯量子演化过程中,粒子会受到适应性函数的约束,从而导致不断演化、搜索和优化。

3. 适应性函数GQPSO算法中使用的适应性函数通常是目标函数或者问题的评价函数,它能够帮助粒子判断当前位置的优劣,并指导其向更优的位置演化。

适应性函数的选择对于算法的性能至关重要。

二、GQPSO算法的特点GQPSO算法相比于传统的优化算法有着独特的特点和优势,主要表现在以下几个方面:1. 全局搜索能力强GQPSO算法通过量子位表示和高斯量子演化,能够有效地克服传统算法在全局搜索能力上的不足,更好地发挥粒子裙优化算法的优势,从而在复杂优化问题中取得更好的效果。

2. 收敛速度快GQPSO算法利用了量子行为的特性,能够更快地收敛到全局最优解,从而大大提高了算法的搜索效率和优化能力。

在实际应用中,GQPSO 算法往往能够在较短的时间内找到较优的解。

3. 对高维问题有较好的适应性GQPSO算法对于高维优化问题的适应性较强,能够有效地应对复杂的实际问题,从而满足实际应用的需求。

这一特点使得GQPSO算法在实际工程和科研中有着广泛的应用前景。

pso算法流程

pso算法流程

PSO算法,全称为粒子群优化算法,是一种基于群体智能的优化算法。

其核心思想是通过模拟群体行为,逐步优化目标函数的值,最终达到求解最优解的目的。

PSO算法的流程如下:

1.初始化粒子群,包括每个粒子的位置、速度和适应度值;

2.设定局部最优解和全局最优解,其中局部最优解是指每个粒子的最优解,而全局最优解是指整个粒子群中的最优解;

3.根据粒子的位置和速度,更新每个粒子的位置和速度;

4.计算每个粒子的适应度值,并更新其局部最优解;

5.计算整个粒子群的全局最优解,并更新该值;

6.判断是否达到停止迭代的条件,如果满足条件,则输出全局最优解;否则,返回第3步,继续迭代。

PSO算法相对于其他优化算法的优势在于其简单、易于实现和收敛速度较快。

但同时也存在一些不足之处,如易陷入局部最优解、对参数的设置要求较高等问题,需要在实际应用中加以注意和调整。

- 1 -。

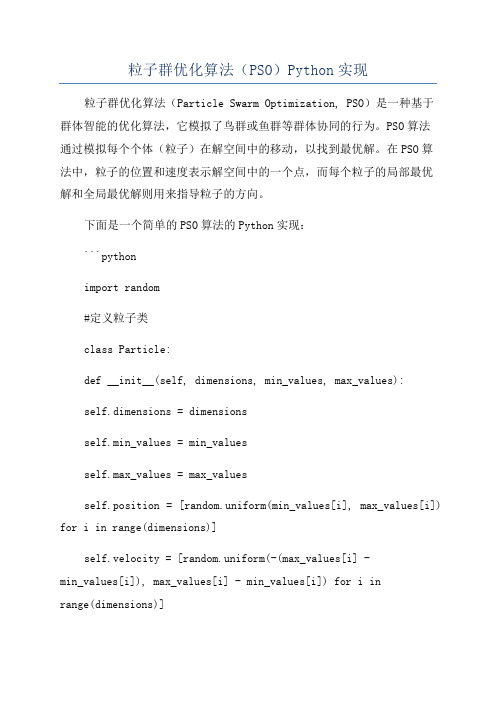

粒子群优化算法(PSO)Python实现

粒子群优化算法(PSO)Python实现粒子群优化算法(Particle Swarm Optimization, PSO)是一种基于群体智能的优化算法,它模拟了鸟群或鱼群等群体协同的行为。

PSO算法通过模拟每个个体(粒子)在解空间中的移动,以找到最优解。

在PSO算法中,粒子的位置和速度表示解空间中的一个点,而每个粒子的局部最优解和全局最优解则用来指导粒子的方向。

下面是一个简单的PSO算法的Python实现:```pythonimport random#定义粒子类class Particle:def __init__(self, dimensions, min_values, max_values):self.dimensions = dimensionsself.min_values = min_valuesself.max_values = max_valuesself.position = [random.uniform(min_values[i], max_values[i]) for i in range(dimensions)]self.velocity = [random.uniform(-(max_values[i] -min_values[i]), max_values[i] - min_values[i]) for i inrange(dimensions)]self.best_position = self.position.copydef update_velocity(self, global_best_position,inertia_weight, cognitive_weight, social_weight):for i in range(self.dimensions):r1 = random.randomr2 = random.randomdef update_position(self):for i in range(self.dimensions):self.position[i] += self.velocity[i]if self.position[i] < self.min_values[i]:self.position[i] = self.min_values[i]elif self.position[i] > self.max_values[i]:self.position[i] = self.max_values[i]def update_best_position(self):if objective_function(self.position) <objective_function(self.best_position):self.best_position = self.position.copy#定义目标函数(此处仅为示例,实际应用中需根据问题进行定义)def objective_function(position):return sum(position)def pso(num_particles, dimensions, min_values, max_values, num_iterations, inertia_weight, cognitive_weight, social_weight): particles = [Particle(dimensions, min_values, max_values)for _ in range(num_particles)]global_best_position = particles[0].position.copyfor _ in range(num_iterations):for particle in particles:particle.update_velocity(global_best_position,inertia_weight, cognitive_weight, social_weight)particle.update_positionparticle.update_best_positionif objective_function(particle.best_position) <objective_function(global_best_position):global_best_position = particle.best_position.copyreturn global_best_position#示例使用num_particles = 30dimensions = 2min_values = [-5, -5]max_values = [5, 5]num_iterations = 100inertia_weight = 0.5cognitive_weight = 0.8social_weight = 0.8best_position = pso(num_particles, dimensions, min_values, max_values, num_iterations, inertia_weight, cognitive_weight, social_weight)print("最优解:", best_position)print("最优值:", objective_function(best_position))```在上面的代码中,首先定义了一个`Particle`类来表示粒子。

pso算法步骤

pso算法步骤PSO算法是一种优化算法,是由“Particle Swarm Optimization”,即粒子群优化算法发展而来的,在解决复杂问题和进行多目标优化方面表现出色。

PSO算法通常适用于连续优化问题,可以优化函数、离散问题以及混合问题。

PSO算法步骤第一步:设定参数在使用PSO算法之前,必须先设定相关参数,这是PSO算法使用过程的一项重要任务。

这些参数决定了粒子在搜索空间中移动的方式和速度,以及算法搜索解的效率。

1. 粒子群规模:$N$2. 惯性权重:$w$3. 最大迭代次数:$T_{max}$4. 每个粒子的学习因子$c_1,c_2$5. 粒子的位置和速度范围:$x_{min}$和$x_{max}$6. 收敛精度第二步:初始化粒子群在PSO算法的第二步中,每个粒子将在解空间中随机生成一个初始位置并随机赋予一个速度。

每个粒子的位置和速度是由以下公式计算得出的:$$x_i(0)=x_{min}+(x_{max}-x_{min})\times rand$$其中$x_{min}$和$x_{max}$是自变量的最小值和最大值,$rand$表示在0和1之间的随机数。

第三步:粒子的运动和更新在这个步骤中,每个粒子都会根据自己的位置和速度更新自己的位置和速度。

这个过程被描述如下:$$v_i(t+1)=wv_i(t)+c_1r_{1i}(p_i-x_i(t))+c_2r_{2i}(g-x_i(t))$$其中,$p_i$是粒子$i$搜索到的最佳位置,$g$是当前所有粒子中最优的位置,$r_{1i}$和$r_{2i}$是0到1之间的随机数。

第四步:评价适应度在此步骤中,需要计算每个粒子在当前位置所对应的适应度值。

这个过程是用来评估点的好坏,估算梯度,对于不同的优化问题有不同的定义方法。

第五步:更新全局最优在这一步中,需要判断每个粒子的适应度值是否比当前的全局最优适应值更好。

如果是,那么需要更新当前全局最优适应值和位置:$$f_{best}=\min(f_{best},f_i)$$$$x_{best}=x_i$$其中,$f_i$是第$i$个粒子的适应度值,$f_{best}$是当前全局最优适应值,$x_{best}$是当前全局最优位置。

Matlab中的粒子群优化算法详解

Matlab中的粒子群优化算法详解引言:粒子群优化算法(Particle Swarm Optimization, PSO)是一种模拟鸟群觅食行为的优化算法,具有简单易实现、无需求导和全局搜索能力强等特点。

该算法在解决多种问题中得到广泛应用,特别是在机器学习、智能优化等领域。

本文将详细介绍Matlab中粒子群优化算法的实现过程及应用。

一、粒子群优化算法原理粒子群优化算法源自于对鸟群觅食行为的模拟。

假设一个鸟群中的每个个体被称为粒子,所有粒子共同组成了一个搜索空间,每个粒子会根据自身的当前位置和历史最佳位置进行搜索,并且受到其邻近粒子的信息影响。

通过不断的迭代运算,粒子们逐渐收敛到全局最优解或局部最优解。

具体算法流程如下:1. 初始化粒子群的位置和速度。

2. 计算每个粒子的适应度值,并更新个体最优位置。

3. 根据全局最优位置调整粒子的速度和位置。

4. 重复执行第2步和第3步,直到满足终止条件。

二、Matlab中粒子群优化算法实现步骤在Matlab中,可以通过以下步骤来实现粒子群优化算法:1. 初始化粒子群的位置和速度。

首先需要确定粒子群的大小,即粒子的个数。

对于每个粒子,需要随机生成一个初始位置和速度。

可以使用Matlab中的rand函数来生成指定范围内的随机数。

问题优劣的指标,因此需要根据具体问题来确定。

对于更新个体最优位置,可以通过比较当前适应度值和历史最佳适应度值的大小,选择适应度更优的位置进行更新。

3. 根据全局最优位置调整粒子的速度和位置。

粒子的速度和位置的更新是通过以下公式实现的:V(i,j) = w * V(i,j) + c1 * rand() * (P(i,j) - X(i,j)) + c2 * rand() * (G(j) - X(i,j))X(i,j) = X(i,j) + V(i,j)其中,V(i,j)表示第i个粒子在第j个维度上的速度,X(i,j)表示第i个粒子在第j个维度上的位置,P(i,j)表示第i个粒子的历史最佳位置,G(j)表示全局最佳位置,w、c1和c2分别表示惯性权重、个体学习因子和社会学习因子。

pso算法 matlab程序

pso算法 matlab程序PSO(粒子群优化)算法是一种启发式优化算法,它模拟了鸟群或鱼群等生物群体的行为,通过个体之间的协作和信息共享来寻找最优解。

在MATLAB中,你可以使用以下代码实现一个简单的PSO算法:matlab.function [gbest, gbestval, fitcount] = pso(func, dim, bound, particle_num, maxgen, inertia, c1, c2)。

% 初始化粒子群。

particle = rand(particle_num, dim) . (bound(2)-bound(1)) + bound(1);velocity = zeros(particle_num, dim);pbest = particle;pbestval = feval(func, pbest');[gbestval, gbestid] = min(pbestval);gbest = pbest(gbestid, :);fitcount = 0;for i = 1:maxgen.% 更新粒子群。

r1 = rand(particle_num, dim);r2 = rand(particle_num, dim);velocity = inertia velocity + c1 r1 . (pbest particle) + c2 r2 . (repmat(gbest, particle_num, 1) particle);particle = particle + velocity;% 边界处理。

particle = max(particle, repmat(bound(1), particle_num, 1));particle = min(particle, repmat(bound(2), particle_num, 1));% 更新个体最优。

【优秀作业】粒子群优化算法

【优秀作业】粒子群优化算法粒子群优化算法一、概述粒子群优化算法(Particle Swarm Optimization,PSO)的思想来源于对鸟捕食行为的模仿,最初,Reynolds.Heppner 等科学家研究的是鸟类飞行的美学和那些能使鸟群同时突然改变方向,分散,聚集的定律上,这些都依赖于鸟的努力来维持群体中个体间最佳距离来实现同步。

而社会生物学家 E.O.Wilson 参考鱼群的社会行为认为从理论上说,在搜寻食物的过程中,尽管食物的分配不可知,群中的个体可以从群中其它个体的发现以及以往的经验中获益。

粒子群从这种模型中得到启发并用于解决优化问题。

如果我们把一个优化问题看作是在空中觅食的鸟群,那么粒子群中每个优化问题的潜在解都是搜索空间的一只鸟,称之为“粒子”(Particle),“食物”就是优化问题的最优解。

每个粒子都有一个由优化问题决定的适应度用来评价粒子的“好坏”程度,每个粒子还有一个速度决定它们飞翔的方向和距离,它根据自己的飞行经验和同伴的飞行经验来调整自己的飞行。

粒子群初始化为一群随机粒子(随机解),然后通过迭代的方式寻找最优解,在每一次的迭代中,粒子通过跟踪两个“极值”来更新自己,第一个是粒子本身所经历过的最好位置,称为个体极值即;另一个是整个群体经历过的最好位置称为全局极值。

每个粒子通过上述的两个极值不断更新自己,从而产生新一代的群体。

二、粒子群算法算法的描述如下:假设搜索空间是维,并且群体中有个粒子。

那么群体中的第个粒子可以表示为一个维的向量,,即第个粒子在维的搜索空间的位置是,它所经历的“最好”位置记作。

粒子的每个位置代表要求的一个潜在解,把它代入目标函数就可以得到它的适应度值,用来评判粒子的“好坏”程度。

整个群体迄今为止搜索到的最优位置记作,是最优粒子位置的索引。

()为惯性权重(inertia weight),为第个粒子到第代为止搜索到的历史最优解,为整个粒子群到目前为止搜索到的最优解,,分别是第个粒子当前的位置和飞行速度,为非负的常数,称为加速度因子,是之间的随机数。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

附录 程序1 当22111cc,5.12212cc,2.1w。

a)%主函数源程序(main.m) %------基本粒子群算法 (particle swarm optimization) %------名称: 基本粒子群算法 %------初始格式化 clear all; %清除所有变量 clc; %清屏 format long; %将数据显示为长整形科学计数 %------给定初始条条件------------------ N=40; %³初始化群体个数 D=10; %初始化群体维数 T=100; %初始化群体最迭代次数 c11=2; %学习因子1 c21=2; %学习因子2 c12=1.5; c22=1.5; w=1.2; %惯性权重 eps=10^(-6); %设置精度(在已知最小值的时候用) %------初始化种群个体(限定位置和速度)------------ x=zeros(N,D); v=zeros(N,D); % zeros(m,n)产生m×n的全0矩阵 for i=1:N for j=1:D x(i,j)=randn; %随机初始化位置 v(i,j)=randn; %随机初始化速度 end end %------显示群位置---------------------- figure(1) for j=1:D if(rem(D,2)>0) subplot((D+1)/2,2,j) else subplot(D/2,2,j) end plot(x(:,j),'b*');grid on xlabel('粒子') ylabel('初始位置') tInfo=strcat('第',char(j+48),'维'); if(j>9) tInfo=strcat('第',char(floor(j/10)+48),char(rem(j,10)+48),'维'); end title(tInfo) end %------显示种群速度 figure(2) for j=1:D if(rem(D,2)>0) subplot((D+1)/2,2,j) else subplot(D/2,2,j) end plot(x(:,j),'b*');grid on xlabel('粒子') ylabel('初始速度') tInfo=strcat('第,char(j+48),'维'); if(j>9) tInfo=strcat('第',char(floor(j/10)+48), char(rem(j,10)+48),'维); end title(tInfo) end figure(3) %第一个图 subplot(1,2,1) %------初始化种群个体(在此限定速度和位置)------------ x1=x; v1=v; %------初始化个体最优位置和最优值--- p1=x1; pbest1=ones(N,1); for i=1:N pbest1(i)=fitness(x1(i,:),D); end %------初始化全局最优位置和最优值--------------- g1=1000*ones(1,D); gbest1=1000; for i=1:N if(pbest1(i)g1=p1(i,:); gbest1=pbest1(i); end end gb1=ones(1,T); %-----浸入主循环,按照公式依次迭代直到满足精度或者迭代次数--- for i=1:T for j=1:N if (fitness(x1(j,:),D)p1(j,:)=x1(j,:); pbest1(j)=fitness(x1(j,:),D); end if(pbest1(j)g1=p1(j,:); gbest1=pbest1(j); end v1(j,:)=w*v1(j,:)+c11*rand*(p1(j,:)-x1(j,:))+c21*rand*(g1-x1(j,:)); x1(j,:)=x1(j,:)+v1(j,:); end gb1(i)=gbest1; end plot(gb1) TempStr=sprintf('c1= %g ,c2=%g',c11,c21); title(TempStr); xlabel('迭代次数'); ylabel('适应度值'); %第二个图 subplot(1,2,2) %-----初始化种群个体(在此限定速度和位置)------------ x2=x; v2=v; %-----初始化种群个体最有位置和 最优解----------- p2=x2; pbest2=ones(N,1); for i=1:N pbest2(i)=fitness(x2(i,:),D); end %-----初始化种全局最有位置和 最优解------ g2=1000*ones(1,D); gbest2=1000; for i=1:N if(pbest2(i)g2=p2(i,:); gbest2=pbest2(i); end end gb2=ones(1,T); %------浸入主循环,按照公式依次迭代直到满足精度或者迭代次数--- for i=1:T for j=1:N if (fitness(x2(j,:),D)p2(j,:)=x2(j,:); pbest2(j)=fitness(x2(j,:),D); end if(pbest2(j)g2=p2(j,:); gbest2=pbest2(j); end v2(j,:)=w*v2(j,:)+c12*rand*(p2(j,:)-x2(j,:))+c22*rand*(g2-x2(j,:)); x2(j,:)=x2(j,:)+v2(j,:); end gb2(i)=gbest2; end plot(gb2) TempStr=sprintf('c1= %g ,c2=%g',c12,c22); title(TempStr); xlabel('迭代次数'); ylabel('适应度值'); b)适应度函数 %适应度函数(fitness.m) function result=fitness(x,D) sum=0; for i=1:D sum=sum+x(i)^2; end result=sum; 程序2

当22111cc于2.1,2,02212wcc对比 a)%主函数源程序(main.m) %------基本粒子群算法 (particle swarm optimization) %------名称: 基本粒子群算法 %------初始格式化 clear all; %清除所有变量 clc; %清屏 format long; %将数据显示为长整形科学计数 %------给定初始条条件------------------ N=40; %³初始化群体个数 D=10; %初始化群体维数 T=100; %初始化群体最迭代次数 c11=2; %学习因子1 c21=2; %学习因子2 c12=0; c22=2; w=1.2; %惯性权重 eps=10^(-6); %设置精度(在已知最小值的时候用) %------初始化种群个体(限定位置和速度)------------ x=zeros(N,D); v=zeros(N,D); for i=1:N for j=1:D x(i,j)=randn; %随机初始化位置 v(i,j)=randn; %随机初始化速度 end end %------显示群位置---------------------- figure(1) for j=1:D if(rem(D,2)>0) subplot((D+1)/2,2,j) else subplot(D/2,2,j) end plot(x(:,j),'b*');grid on xlabel('粒子') ylabel('初始位置') tInfo=strcat('第',char(j+48),'维'); if(j>9) tInfo=strcat('第',char(floor(j/10)+48), char(rem(j,10)+48),'维'); end title(tInfo) end %------显示种群速度 figure(2) for j=1:D if(rem(D,2)>0) subplot((D+1)/2,2,j) else subplot(D/2,2,j) end plot(x(:,j),'b*');grid on xlabel('粒子') ylabel('初始速度') tInfo=strcat('第,char(j+48),'维'); if(j>9) tInfo=strcat('第',char(floor(j/10)+48), char(rem(j,10)+48),'维); end title(tInfo) end figure(3) %第一个图 subplot(1,2,1) %------初始化种群个体(在此限定速度和位置)------------ x1=x; v1=v; %------初始化个体最优位置和最优值--- p1=x1; pbest1=ones(N,1); for i=1:N pbest1(i)=fitness(x1(i,:),D); end %------初始化全局最优位置和最优值--------------- g1=1000*ones(1,D); gbest1=1000; for i=1:N if(pbest1(i)g1=p1(i,:); gbest1=pbest1(i);