机器学习技法课程2:Dual Support Vector Machine

机器学习技法课程学习笔记4 -- Soft-Margin Support Vector Machine

根据之前介绍的KKT条件,我们对上式进行简化。上式括号里面的是对拉格朗日函数 计算最小值。那么根据梯度下降算法思想:最小值位置满足梯度为

零。

我们先对 做偏微分:

根据上式,得到

,因为有

,所以限制

。将

代入到dual形式中并化简,我们发现 和 都被消去了:

这个形式跟HardMargin SVM中的dual形式是基本一致的,只是条件不同。那么,我 们分别令拉个朗日函数L对b和w的偏导数为零,分别得到:

标是让这些点越少越好。

为了引入允许犯错误的点,我们将HardMargin SVM的目标和条件做一些结合和修 正,转换为如下形式:

修正后的条件中,对于分类正确的点,仍需满足

,而对于noise

点,满足

,即没有限制。修正后的目标除了

项,还添

加了

,即noise点的个数。参数C的引入是为了权衡目标第一

项和第二项的关系,即权衡large margin和noise tolerance的关系。

Messages behind SoftMargin SVM

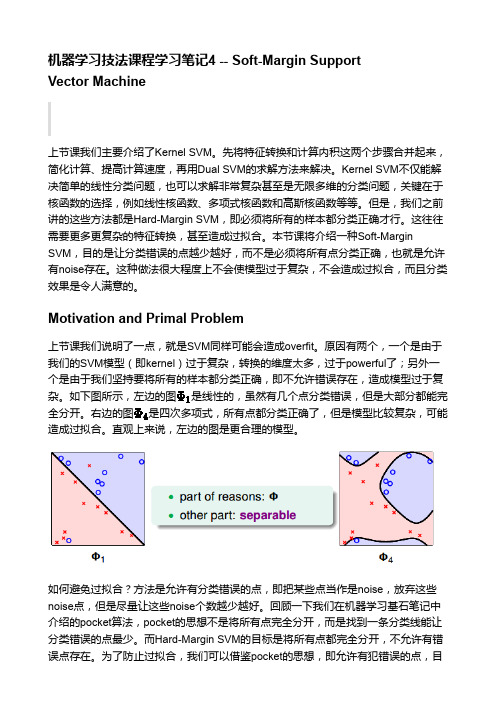

如何避免过拟合?方法是允许有分类错误的点,即把某些点当作是noise,放弃这些 noise点,但是尽量让这些noise个数越少越好。回顾一下我们在机器学习基石笔记中 介绍的pocket算法,pocket的思想不是将所有点完全分开,而是找到一条分类线能让 分类错误的点最少。而HardMargin SVM的目标是将所有点都完全分开,不允许有错 误点存在。为了防止过拟合,我们可以借鉴pocket的思想,即允许有犯错误的点,目

经过化简和推导,最终标准的SoftMargin SVM的Dual形式如下图所示:

SoftMargin SVM Dual与HardMargin SVM Dual基本一致,只有一些条件不同。

机器学习中的支持向量机算法研究

机器学习中的支持向量机算法研究机器学习是一门利用计算机算法和统计学方法来让机器自动学习并改进性能的领域。

在机器学习的众多算法中,支持向量机(Support Vector Machine,SVM)是一种非常重要且广泛应用的算法。

本文将探讨支持向量机算法的原理、应用以及发展趋势。

一、支持向量机算法原理支持向量机算法是一种监督学习算法,主要用于分类和回归问题。

其核心思想是找到一个最优的超平面,将不同类别的数据样本分开。

在二维平面中,这个超平面就是一条直线,而在多维空间中,这个超平面可以是一个曲面或者超平面。

支持向量机算法的关键是如何找到这个最优的超平面。

它通过寻找能够最大化两个类别之间的间隔的超平面来实现分类。

这个间隔被称为“最大间隔”,而支持向量机正是通过寻找距离超平面最近的一些数据点来确定这个最大间隔。

二、支持向量机算法应用支持向量机算法在实际应用中有着广泛的应用。

它在文本分类、图像识别、生物信息学等领域中都取得了很好的效果。

以文本分类为例,支持向量机算法可以将一篇文章自动分类为不同的主题,如体育、政治、娱乐等。

通过训练模型,支持向量机可以根据文章中的关键词和特征来进行分类,从而实现自动化的文本分类。

此外,支持向量机算法还可以用于回归问题。

回归问题是指根据已有的数据样本,预测未来的结果。

例如,可以利用支持向量机算法根据历史房价数据来预测未来的房价走势。

通过训练模型,支持向量机可以找到最佳的回归曲线,从而提供准确的预测结果。

三、支持向量机算法的发展趋势随着机器学习领域的不断发展,支持向量机算法也在不断演进和改进。

近年来,一些新的变体和改进的支持向量机算法被提出。

一种常见的改进是核函数的使用。

核函数可以将原始数据映射到高维空间中,从而使得原本线性不可分的数据变得线性可分。

这种改进使得支持向量机算法在处理复杂的非线性问题时更加有效。

另一个发展趋势是支持向量机算法与其他机器学习算法的结合。

例如,将支持向量机算法与深度学习算法相结合,可以提高模型的性能和准确率。

零基础学SVM—Support Vector Machine系列之一

零基础学SVM—Support Vector Machine系列之一本文原作者耳东陈,本文原载于作者的知乎文章。

AI 研习社已获得转载授权。

如果你是一名模式识别专业的研究生,又或者你是机器学习爱好者,SVM是一个你避不开的问题。

如果你只是有一堆数据需要SVM帮你处理一下,那么无论是Matlab的SVM工具箱,LIBSVM还是python框架下的SciKit Learn都可以提供方便快捷的解决方案。

但如果你要追求的不仅仅是会用,还希望挑战一下“理解”这个层次,那么你就需要面对一大堆你可能从来没听过的名词,比如:非线性约束条件下的最优化、KKT条件、拉格朗日对偶、最大间隔、最优下界、核函数等等。

这些名词往往会跟随一大堆天书一般的公式。

如果你稍微有一点数学基础,那么单个公式你可能看得明白,但是怎么从一个公式跳到另一个公式就让人十分费解了,而最让人糊涂的其实并不是公式推导,而是如果把这些公式和你脑子里空间构想联系起来。

我本人就是上述问题的受害者之一。

我翻阅了很多关于SVM的书籍和资料,但没有找到一份材料能够在公式推导、理论介绍,系统分析、变量说明、代数和几何意义的解释等方面完整地对SVM加以分析和说明的。

换言之,对于普通的一年级非数学专业的研究生而言,要想看懂SVM需要搜集很多资料,然后对照阅读和深入思考,才可能比较透彻地理解SVM算法。

由于我本人也在东北大学教授面向一年级硕士研究生的《模式识别技术与应用》课程,因此希望能总结出一份相对完整、简单和透彻的关于SVM算法的介绍文字,以便学生能够快速准确地理解SVM算法。

以下我会分为四个步骤对最基础的线性SVM问题加以介绍,分别是1)问题原型,2)数学模型,3)最优化求解,4)几何解释。

我尽可能用最简单的语言和最基本的数学知识对上述问题进行介绍,希望能对困惑于SVM算法的学生有所帮助。

SVM算法要解决什么问题SVM的全称是Support Vector Machine,即支持向量机,主要用于解决模式识别领域中的数据分类问题,属于有监督学习算法的一种。

机器学习中的支持向量机原理及优化方法

机器学习中的支持向量机原理及优化方法支持向量机(Support Vector Machine,SVM)是一种非常常用的机器学习算法,主要用于分类和回归问题。

它的基本原理是通过在特征空间中找到一个最佳的超平面,来实现对数据样本的分类。

SVM算法的优化方法包括凸优化、核函数和软间隔最大化。

SVM的原理是基于统计学习理论和结构风险最小化原则。

它的基本思想是将输入空间中的样本点映射到高维特征空间中,并在特征空间中找到一个最佳的超平面,使距离超平面最近的样本点到超平面的距离最大化。

通过这样的方式,能够得到一个能够很好地区分不同类别的分类器。

SVM算法的优化方法主要包括凸优化、核函数和软间隔最大化。

首先,凸优化是SVM算法的核心思想。

SVM的目标是寻找一个最佳的超平面,使得所有样本点到超平面的距离最大化。

这个距离被称为间隔(margin),表示了样本点分类的可靠性。

凸优化的目标是在满足约束条件(样本点到超平面的距离大于等于间隔)的情况下,找到一个最大间隔的超平面。

这个问题可以转化为一个二次规划问题,通过求解约束最优化问题可以得到最佳的超平面。

其次,核函数是SVM算法的另一个重要组成部分。

在实际应用中,往往需要处理高维甚至是无限维的特征空间。

为了避免计算复杂度过高,我们可以使用核函数将高维特征空间的运算转化为低维特征空间的运算。

核函数的作用是将输入样本点映射到特征空间中,并通过计算这些样本点在特征空间中的内积来计算它们之间的相似度。

常用的核函数有线性核、多项式核、高斯核等,可以根据具体问题选择合适的核函数。

最后,软间隔最大化是SVM算法的一种改进。

在实际应用中,样本点很可能不是完全线性可分的,即使找到了一个超平面,也可能存在分类错误的样本点。

为了避免过拟合和提高模型的鲁棒性,可以引入一定的分类误差容忍度,允许某些样本点被错误地分类。

软间隔最大化的目标是在凸优化问题的基础上,找到一个最佳的超平面,使得同时最大化间隔和最小化分类误差。

【support vector machines】

~ ~

这样分类间隔就等于 ,因此要求分类间隔最大,就要求 最大.而要求分类面对所有样本正确分类,就是要求满足

yi ( w xi + b) ≥ 1, i i 使等号成立的样本点称为支持向量

2 w

Linear SVM Mathematically

x+

M=Margin Width

X-

What we know: w . x+ + b = +1 w . x- + b = -1 w . (x+-x-) = 2

首先建立Lagrange函数 函数 首先建立 w J ( w, b, α ) = ∑ α [ y ( w x + b) 1] 2

2 l i i i i =1

J ( w, b, α ) =0 条件1: w J ( w, b, α ) =0 条件2: b 最终可得到

1 l l Q(α ) = J ( w, b, α ) = ∑ α i ∑∑ α iα jyiyj ( xi xj ) 2 i =1 j =1 i =1 寻找最大化目标函数Q (α )的Lagrange乘子{α i }il =1 , 满足约束条件 (1)

SVM的理论基础

由于SVM 的求解最后转化成二次规划问题的求 解,因此SVM 的解是全局唯一的最优解 SVM在解决小样本、非线性及高维模式识别问题 中表现出许多特有的优势,并能够推广应用到函 数拟合等其他机器学习问题中.

线性判别函数和判别面

一个线性判别函数(discriminant function)是指 由x的各个分量的线性组合而成的函数

l l

∑α y = 0

i =1 i i l * , i i,

对偶问题

支持向量机

结 论: 唯一能确定得到的是真酒样本,故确定为单类分类问题,并 采用多个单类分类器分解问题的策略。

单类分类器分类:

基于概率密度的方法(Density-based classifiers) 基于神经网络的方法(ANN-based classifiers) 基于支持域的方法(Domain-based classifiers) 基于聚类的方法(Clustering-based classifiers)

软件包功能:

支持多个平台,可以在windows(命令行环境)、java、matlab 中运行,其中包括的分类器有 C-SVC 、nu-SVC、one-class SVM、 epsilon-SVR、nu-SVR,可以进行分类或者回归以及参数优选。

基本思想:通过对目标数据的学习,形成一个围绕目标的边界或区域, 如超球面、超平面等,并最小化数据支撑域的体积,已达到错误接受 率最小的目的。

优 点:由于借鉴了SVM的最大间隔理论,因而适合处理小样本、 高维和存在噪声数据的单类分类问题,代表方法有One-class SVM和 SVDD(Support Vector Data Description).

One-class SVM

算法基本原理:

给定训练数据集D,将其从RN到某高维特征空间 的非线性映射 使得

(Xi ) ,在高维空间建立一个超平面 W (x) 0 将映射样本与原点以间

隔 分开,其中w为超平面的法向量,为超平面的截距,为了使超平面尽可能

远离原点,最大化原点到目标数据间的欧氏距离 / W 来寻找最优超平面。经 过映射后的OCSVM在二维空间中寻找最优超平面。

机器学习中的支持向量机算法

机器学习中的支持向量机算法支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,它广泛应用于分类和回归问题。

本文将介绍支持向量机算法的基本原理、核函数以及其在实际应用中的一些特点和局限性。

1. 支持向量机算法的基本原理支持向量机算法的基本原理是基于统计学习理论和结构风险最小化的思想。

它的目标是找到一个能够最大化样本间间隔(即最大化支持向量到超平面的距离)的超平面,以实现对不同类别样本的最优分割。

2. 支持向量机算法的数学模型支持向量机算法的数学模型可以表示为一个最大化间隔的优化问题。

假设训练数据集为{(x1, y1), (x2, y2), ...,(xn, yn)},其中xi为样本的特征向量,yi为样本的类别标签(1或-1)。

支持向量机的目标是找到一个超平面wx + b = 0,使得对于所有满足y_i(wx_i + b) >= 1的样本点,有同号的标签y_i = 1;对于所有满足y_i(wx_i + b) <= -1的样本点,有同号的标签y_i = -1。

最终得到的超平面被称为支持向量机分类器。

3. 支持向量机算法的核函数在实际应用中,支持向量机算法的核函数起到了重要的作用。

核函数可以将原始特征空间映射到高维特征空间,从而使得原本线性不可分的问题变为线性可分的问题。

常用的核函数有线性核、多项式核、高斯径向基函数(RBF)核等。

通过选择合适的核函数,支持向量机可以更好地处理各种类型的数据。

4. 支持向量机算法的应用支持向量机算法在实际应用中广泛用于文本分类、图像识别、生物信息学、金融预测等领域。

它的优点在于可以对高维特征进行处理,并且具有较好的泛化能力。

此外,支持向量机还可以通过引入软间隔、使用不同的核函数等方法进行优化和改进。

5. 支持向量机算法的局限性尽管支持向量机算法在许多领域取得了显著的成果,但它也存在一些局限性。

首先,支持向量机对大规模训练样本和高维特征的处理效率相对较低;其次,支持向量机的参数设置和核函数的选择对算法性能有较大影响,需要经验和专业知识的指导。

机器学习中的支持向量机算法

机器学习中的支持向量机算法一、前言支持向量机(Support Vector Machine,简称 SVM)是一种非常经典的机器学习算法,其主要应用于分类和回归问题。

随着大数据时代的到来,SVM算法也越来越受到了研究者们的关注与重视。

本文旨在系统介绍SVM算法的基本原理、应用场景以及常用算法实现等方面的内容,以期为读者提供一定的参考和帮助。

二、SVM算法原理1. 基本概念SVM算法紧密依赖于以下三个基本概念:①支持向量:位于分类边界上的数据点,对分类决策起到重要的作用。

②超平面:将样本空间划分成两个等价部分的平面,即分类边界。

③核函数:用于将非线性的高维数据转换为低维数据线性可分的函数,是SVM算法关键的一部分。

2. 基本原理SVM算法的核心思想是将数据映射到高维空间,使其能够用线性的超平面进行分类。

具体来说,SVM算法在训练过程中,通过找到支持向量,确定分类超平面,从而实现对新样本的分类。

SVM算法的目标是最大化支持向量到分类超平面的距离,即最大化间隔。

由于间隔是分类器的一个重要指标,因此这个问题可以被转化为优化问题。

通过拉格朗日乘子法,可以得到一个对偶问题,进而得到分类器的权重向量和偏移项,实现对新样本的分类。

3. 应用场景SVM算法在分类和回归问题中都有广泛的应用,尤其是在复杂非线性分类问题中表现出色。

具体应用场景包括但不限于以下几个方面:①文本分类SVM算法在文本分类中有很好的应用,尤其是在处理高维稀疏数据时表现突出。

例如,在垃圾邮件分类、情感分析、新闻分类等应用中,SVM算法都表现出了较高的准确率和鲁棒性。

②生物信息学SVM算法在生物信息学领域中也有广泛的应用,例如在基因识别、蛋白质序列分类等问题的处理中,SVM算法都能起到出色的作用。

③计算机视觉SVM算法在计算机视觉领域中也有很好的表现,例如在图像分类、目标检测等问题的解决中,SVM算法通常比其他算法表现更加出色。

三、SVM算法实现SVM算法实现有多种方式,其中最常用的是SMO算法、QP算法、LIB-SVM等。

机器学习算法与Python实践之支持向量机(SVM)

机器学习算法与Python实践之支持向量机(SVM)目录一、引入二、线性可分SVM与硬间隔最大化三、Dual优化问题3.1、对偶问题3.2、SVM优化的对偶问题四、松弛向量与软间隔最大化五、核函数六、多类分类之SVM6.1、“一对多”的方法6.2、“一对一”的方法七、KKT条件分析八、SVM的实现之SMO算法8.1、坐标下降算法8.2、SMO算法原理8.3、SMO算法的Python实现一、引入支持向量机(SupportVector Machines),这个名字可是响当当的,在机器学习或者模式识别领域可是无人不知,无人不晓啊。

八九十年代的时候,和神经网络一决雌雄,独领风骚,并吸引了大批为之狂热和追随的粉丝。

虽然几十年过去了,但风采不减当年,在模式识别领域依然占据着大遍江山。

王位稳固了几十年。

当然了,它也繁衍了很多子子孙孙,出现了很多基因改良的版本,也发展了不少裙带关系。

但其中的睿智依然被世人称道,并将千秋万代!好了,买了那么久广告,不知道是不是高估了。

我们还是脚踏实地,来看看传说的SVM是个什么东西吧。

我们知道,分类的目的是学会一个分类函数或分类模型(或者叫做分类器),该模型能把数据库中的数据项映射到给定类别中的某一个,从而可以用于预测未知类别。

对于用于分类的支持向量机,它是个二分类的分类模型。

也就是说,给定一个包含正例和反例(正样本点和负样本点)的样本集合,支持向量机的目的是寻找一个超平面来对样本进行分割,把样本中的正例和反例用超平面分开,但是不是简单地分看,其原则是使正例和反例之间的间隔最大。

学习的目标是在特征空间中找到一个分类超平面wx+b=0,分类面由法向量w和截距b决定。

分类超平面将特征空间划分两部分,一部分是正类,一部分是负类。

法向量指向的一侧是正类,另一侧为负类。

用一个二维空间里仅有两类样本的分类问题来举个小例子。

假设我们给定了下图左图所示的两类点Class1和Class2(也就是正样本集和负样本集)。

机器学习技法课程1: Linear Support Vector Machine

矿产资源开发利用方案编写内容要求及审查大纲

矿产资源开发利用方案编写内容要求及《矿产资源开发利用方案》审查大纲一、概述

㈠矿区位置、隶属关系和企业性质。

如为改扩建矿山, 应说明矿山现状、

特点及存在的主要问题。

㈡编制依据

(1简述项目前期工作进展情况及与有关方面对项目的意向性协议情况。

(2 列出开发利用方案编制所依据的主要基础性资料的名称。

如经储量管理部门认定的矿区地质勘探报告、选矿试验报告、加工利用试验报告、工程地质初评资料、矿区水文资料和供水资料等。

对改、扩建矿山应有生产实际资料, 如矿山总平面现状图、矿床开拓系统图、采场现状图和主要采选设备清单等。

二、矿产品需求现状和预测

㈠该矿产在国内需求情况和市场供应情况

1、矿产品现状及加工利用趋向。

2、国内近、远期的需求量及主要销向预测。

㈡产品价格分析

1、国内矿产品价格现状。

2、矿产品价格稳定性及变化趋势。

三、矿产资源概况

㈠矿区总体概况

1、矿区总体规划情况。

2、矿区矿产资源概况。

3、该设计与矿区总体开发的关系。

㈡该设计项目的资源概况

1、矿床地质及构造特征。

2、矿床开采技术条件及水文地质条件。