信息论答案(傅祖芸)

信息论与编码答案傅祖芸

信息论与编码答案傅祖芸【篇一:信息论与编码课程设计报告】t>设计题目:统计信源熵与香农编码专业班级学号学生姓名指导教师教师评分2014年3月24日目录一、设计任务与要求................................................. 2 二、设计思路....................................................... 2 三、设计流程图..................................................... 3 四、程序运行及结果................................................. 5 五、心得体会....................................................... 6 参考文献 .......................................................... 6 附录:源程序.. (7)一、设计任务与要求1、统计信源熵要求:统计任意文本文件中各字符(不区分大小写)数量,计算字符概率,并计算信源熵。

2、香农编码要求:任意输入消息概率,利用香农编码方法进行编码,并计算信源熵和编码效率。

二、设计思路1、统计信源熵:统计信源熵就是对一篇英文文章(英文字母数为n),通过对其中的a,b,c,d/a,b,c,d.....(不区分大小写)统计每个字母的个数n,有这个公式p=n/n可得每个字母的概率,最后又信源熵计算公式h(x)=??p(xi)logp(xi)i?1n,可计算出信源熵h,所以整体步骤就是先统计出英文段落的总字符数,在统计每个字符的个数,即每遇到同一个字符就++1,直到算出每个字符的个数,进而算出每个字符的概率,再由信源熵计算公式计算出信源熵。

2、香农编码:香农编码主要通过一系列步骤支出平均码长与信源之间的关系,同时使平均码长达到极限值,即选择的每个码字的长度ki满足下式:i(xi)?ki?i(xi)?1,?i具体步骤如下:a、将信源消息符号按其出现的概率大小依次排列为:p1?p2?......?pn b、确定满足下列不等式的整数码长ki为:?lb(pi)?ki??lb(pi)?1 c、为了编成唯一可译码,计算第i个消息的累加概率:pi??p(ak)k?1i?1d、将累加概率pi变换成二进制数。

信息论--傅祖芸课后题解答

0.01

0.05

可得:

N0 0.4715 0.01 0.05

NH ( S )0.811

(2):

|| G N || 2

2

2

15295

第四章 5.3 (1) A、B、C、E是唯一可译码 (2) A、C、E即时码 4.17 不能直接相连

H ( S ) H (0.8) 0.722

2

4 3

1 4

log 4 0.811

2 2

D [ I ( s i )]

i 1

p i (log p i ) [ H ( S )]

3 2 1 1 2 2 (log ) log( ) (0.811) 0.4715 4 4 4 4

3

根据书中4.21式

D [ I ( s i )] N 0

习题讲解

第二章习题 2.4 解: x:女孩是大学生 y:女孩身高1.6m以上 P(x)=0.25 P(y)=0.5 P(y/x)=0.75

p(x / y) p ( xy ) p( y) p( x) p( y / x) p( y) 0.25 0.75 0.5 1 0.375 0.375

7 E

PE 1 ( p 7 p p )

7 6 6

0.01) 0.002

2 5 2 3 4 3

PE 1 ( p C 7 p p C 7 p p C 7 p p )

log(1 p ) log 2(1 p ) p

log

2(1 p ) p

0

2(1 p ) p

1

p

2 3

第二章习题 (4)

log 2(1 p ) p 0 2(1 p ) p 1 p 2 3

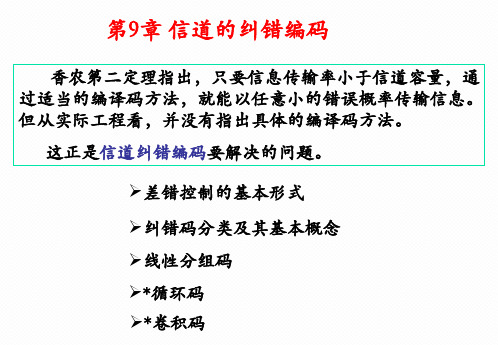

信息论 基础理论与应用第三版(傅祖芸)-第9章-讲义

t

V U

d min

图

dmin =5, 码距和纠错能力关系示意图

设V,U为距离最小的两个许用码字。 自接收序列中码字分别发生t位错误和e位错误,要检错、纠错, 需要使得大球和小球不相交。故: 须dmin≥ e+t+1,否则,译码时引起码字译码混淆。

若为随机差错,错误码元为: 2,3,7,错误数量 =W(E)=3; 若为突发差错,错误码元串长度为:6;

•

出错范围:从错误图样E中的第一个1到最后一个1, 其 错误串中的0表示该位码元未发生错误。

BSC(二元无记忆对称信道)的错误图样的出现概率

设p为错误概率(<<1),则n次无记忆扩展信道中,随机差错 的某错误图样E的出现概率为:

差错类型: 随机差错是相互独立的、不相关,存在这种差错 的信道是无记忆信道或随机信道; 突发差错指成串出现的错误,错误与错误间有相关 性,一个差错往往要影响到后面一串码元。

例 发送码字

接收序列 错误图样

•

C= 010110111,

R= 001110011, E=C+R= 011000100

1、纠错码的分类:

按纠正错误的类型分类:

纠随机差错码:无记忆信道中,噪声随机独立地影响每个 码元,造成了随机差错; 纠突发差错码:有记忆信道中,突发噪声可造成突发性的 成群差错(如太阳黑子、雷电等引起)。 纠混合差错码

按应用目的分类:

检错码——只能检测错误是否存在。

纠错码——能够检测错误,并能够自动纠正错误。 纠删码——能够纠正删除(丢失)了的信息。

码的最小距离:dmin, d(C) 汉明重量(汉明势):码字中非零码元的个数 W(C)。 对2元码,汉明重量为码字中的“1”的个数。因此,二

信息论--傅祖芸5

X ,Y a*

精品资料

第一节 错误(cuòwù)概率与译码规则

也可写成: PE

P(bj / ai )P(ai )

X ,Y a*

上式也可写成对行求和(qiú hé):

PE P(ai ) P(bj / ai )

X

Y

P(ai )Pe(i)

X

F (bj ) a

如果先验概率相等,则:

1

PE r

精品资料

第二节 错误(cuòwù)概率与编码方法

我们再讨论一个例子,取M=4,n=5,这4个码字按如下规则

选取(xuǎnqǔ): R 2

设输入序列为:

5 ai (ai1 ai2 ai3 ai4 ai5 )

满足方程:

ai3 ai1 ai2 ai4 ai1 ai5 ai1 ai2

若译码采取最大似然准则:

精品资料

第二节 错误(cuòwù)概率与编码方法

我们引进(yǐnjìn)这样一个概念:汉明距离。

在二元码中:

n

D(i , j ) ik jk

如:

k 1

i 101111 j 111100

则

D(i , j ) 3

在某一码书中,任意两个码字的汉明距离的最小值称为该码C 的最小距离。

dmin min{D(Ci , C j )} Ci C j

精品资料

第二节 错误(cuòwù)概率与编码方法

00000

00001

00010

00100 01000

00000

10000

10001

00011

01101

01100

01111

01001 00101

01101

11101

信息论基础理论与应用第三版(傅祖芸) 第1章 绪论

1928年,哈特莱(R.V.L Hartley) 在《信息传输》一文中提出:发信者所发出的信

息,就是他在通信符号表中选择符号的具体方式, 主张用所选择的自由度来度量信息。 局限性: ➢ 只考虑选择符号的方式,不涉及到信息的价值和具 体内容。 ➢ 没有考虑各种可能选择方法的统计特性。

信源编码器的主要指标

是它的编码效率。一般来说,效率越高,编译码 器的代价也将越大。

信源译码器

把信道译码器的输出变换成信宿所需的消息形式,

相当于信源编码器的逆过程。

19

信道编码器与译码器

信道编码 主要作用是提高信息传送的可靠性。

信道编码器的作用 在信源编码器输出的代码组上有目的地增加一些监督 码元,使之具有检错或纠错的能力。

an p(an )

样本空间 概率测度

先验概率p(xi):

选择符号xi作为消息的概率。 11

例:气象预报

甲 X 晴 阴 大雨 小雨

p(x)

1/ 2,1/

4,

1/ 8,

1/8

乙

Y p(y)

晴 阴 1/4,1/4,

大雨 小雨

1/4, 1/4

“甲地晴”比“乙地晴”的不确定性小。

某一事物状态出现的概率越小,其不确定性越大。 某一事物状态出现的概率接近于1,即预料中肯定会 出现的事件,那它的不确定性就接近于零。

信道编码的主要方法 增大码率或频带,即增大所需的信道容量。这恰与信源 编码相反。

7

信息的表达层次

狭义而言,通信中对信息的表达分三个层次:信号、 消息、信息。 信号:信息的物理表达,是一个物理量,是一个载 荷信息的实体,可测量、可描述、可传输、可存储、 可显示。 消息 (或符号) :信息的数学表达,承载了信息, 它是具体物理信号的数学抽象。如语言、文字、语音、 图像等。 信息:更高层次的哲学抽象,是信号与消息的承载 的对象,描述事物运动状态或存在方式的不确定性。

信息论第三版傅祖芸(3.7-3.8)

P( z / yx) P( z / y)

称这两信道的输入和输出X,Y,Z序列构成马尔 可夫链。

这两个串接信道可以等价成一个总的离散信道,其 输入为X,输出为Z, X Z P(z/x)

等价的总信道的传递概率为

P( z / x) P( y / x) 递矩阵

r t rs s t

定理3.6 对于串接信道X、Y、Z,当且仅当

P(Z / XY ) P( Z / Y ) 时, 等式 I ( XY ; Z ) I (Y ; Z )

成立 。

上式 I ( XY ; Z ) 表示联合变量XY与变量Z之间的平均互信息, 也就是接收到Z后获得关于联合变量X和Y的信息量。而 I (Y ; Z ) 是接收到Z后获得关于变量Y的信息量。由上式的成 立条件可知随机变量X、Y、Z组成一个马尔可夫链。在在串 联信道中随机变量Z往往只依赖信道Ⅱ的输入Y,不直接与 变量X发生关系,即随机变量Z仅仅通过变量Y而依赖于X。 所以得出以下定理。

谢谢

定理3.7 若X、Y、Z组成一个马尔可夫链,则有

I ( X ; Z ) I ( X ;Y )

I ( X ; Z ) I (Y ; Z )

定理3.7表明通过数据处理后,一般只会增加信息的损失,最 多保持原来获得的信息,不可能比原来获得的信息有所增加 。也就是说,对接收到的数据Y进行处理后,无论变量Z是Y 的确定对应关系还是概率关系,决不会减少关于X的不确定 性。故定理3.7称为数据处理定理。

这就是信息的不增性原理,与热熵不减原理正好相反。因而串 接信道的信道容量为 max I(X ; Z) C串( Ⅰ, Ⅱ ) P ( x ) max I ( X ;W ) C串( Ⅰ, Ⅱ, Ⅲ )

P(x)

信息论傅祖芸第三版答案

信息论傅祖芸第三版答案【篇一:信息论】p class=txt>信息论是运用概率论与数理统计的方法研究信息、信息熵、通信系统、数据传输、密码学、数据压缩等问题的应用数学学科。

信息论将信息的传递作为一种统计现象来考虑,给出了估算通信信道容量的方法。

信息传输和信息压缩是信息论研究中的两大领域。

这两个方面又由信息传输定理、信源-信道隔离定理相互联系。

它主要是研究通讯和控制系统中普遍存在着信息传递的共同规律以及研究最佳解决信息的获限、度量、变换、储存和传递等问题的基础理论。

信息论发展的三个阶段第一阶段:1948年贝尔研究所的香农在题为《通讯的数学理论》的论文中系统地提出了关于信息的论述,创立了信息论。

第二阶段:20世纪50年代,信息论向各门学科发起冲击;60年代信息论进入一个消化、理解的时期,在已有的基础上进行重大建设的时期。

研究重点是信息和信源编码问题。

第三阶段:到70年代,由于数字计算机的广泛应用,通讯系统的能力也有很大提高,如何更有效地利用和处理信息,成为日益迫切的问题。

人们越来越认识到信息的重要性,认识到信息可以作为与材料和能源一样的资源而加以充分利用和共享。

信息的概念和方法已广泛渗透到各个科学领域,它迫切要求突破申农信息论的狭隘范围,以便使它能成为人类各种活动中所碰到的信息问题的基础理论,从而推动其他许多新兴学科进一步发展。

信息科学和技术在当代迅猛兴起有其逻辑必然和历史必然。

信息是信息科学的研究对象。

信息的概念可以在两个层次上定义:本体论意义的信息是事物运动的状态和状态变化的方式,即事物内部结构和外部联系的状态和方式。

认识论意义的信息是认识主体所感知、表达的相应事物的运动状态及其变化方式,包括状态及其变化方式的形式、含义和效用。

这里所说的“事物”泛指一切可能的研究对象,包括外部世界的物质客体,也包括主观世界的精神现象;“运动”泛指一切意义上的变化,包括思维运动和社会运动;“运动状态”指事物运动在空间所展示的性状和态势;“运动方式”是事物运动在时间上表现的过程和规律性。

信息论 基础理论与应用第三版(傅祖芸) 第5章 讲义

编码后信源的信息传输率 令: R ' l log r

N

l log r H ( S ) N

(编码后,平均每个信源 符号承载的信息量)

R' H ( S )

可见,只有编码后信息传输率 R' H ( S ) ,才能实现无失真编码。

编码效率

H (S ) H (S ) ' l R log r N

信源 符号

码字

00: W1W1=B1

001:W1W2=B2 0001:W1W3=B3 0111:W1W4=B4

信源 符号

码字

010:W2W1=B5

信源 符号

码字

α1

α2 α3 α4

α5

: : :

:

: : α16

:

: :

111111:W4W4=B16

: : :

6、唯一可译码(单义可译码)

由码构成的任意一串有限长的码符号序列只能被唯一的 译成所对应的信源符号序列。 否则,就为非惟一可译码或非单义可译码。

引 言

信息通过信道传输到信宿的过程。要做到既不失真又快速地 通信,需要解决两个问题: 信源编码: 在不失真或允许一定失真条件下,提高信息传输率. 信道编码: 在信道受到干扰的情况下,增加信号的抗干扰能力,同时又 使得信息传输率最大.

最佳编码: 一般来说,抗干扰能与信息传输率二者相互矛盾。而编码 定理理论上证明,至少存在某种最佳的编码能够解决上述矛盾, 做到既可靠又有效地传输信息。 信源编码: 信源虽然多种多样,但无论是哪种类型的信源,信源符号 之间总存在相关性和分布的不均匀性,使得信源存在冗余度。 信源编码的目的就是要减少冗余,提高编码效率。

5、码的N次扩展

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第二章课后习题【2.1】设有12 枚同值硬币,其中有一枚为假币。

只知道假币的重量与真币的重量不同,但不知究竟是重还是轻。

现用比较天平左右两边轻重的方法来测量。

为了在天平上称出哪一枚是假币,试问至少必须称多少次?解:从信息论的角度看,“12 枚硬币中,某一枚为假币”该事件发生的概率为P 1 ;12“假币的重量比真的轻,或重”该事件发生的概率为P 1 ;2为确定哪一枚是假币,即要消除上述两事件的联合不确定性,由于二者是独立的,因此有I log12 log 2 log 24 比特而用天平称时,有三种可能性:重、轻、相等,三者是等概率的,均为P 1 ,因此天3平每一次消除的不确定性为I log 3 比特因此,必须称的次数为I1 log 242.9 次I 2 log 3因此,至少需称3 次。

【延伸】如何测量?分3 堆,每堆4 枚,经过3 次测量能否测出哪一枚为假币。

【2.2】同时扔一对均匀的骰子,当得知“两骰子面朝上点数之和为2”或“面朝上点数之和为8”或“两骰子面朝上点数是3 和4”时,试问这三种情况分别获得多少信息量?解:“两骰子总点数之和为2”有一种可能,即两骰子的点数各为1,由于二者是独立的,因此该种情况发生的概率为P 1 1 1 ,该事件的信息量为:6 6 36I log 36 5.17 比特“两骰子总点数之和为 8”共有如下可能:2 和 6、3 和 5、4 和 4、5 和 3、6 和 2,概率为 P 1 1 5 5,因此该事件的信息量为:6 6 36I log 362.85 比特5“两骰子面朝上点数是 3 和 4”的可能性有两种:3 和 4、4 和 3,概率为 P 1 1 2 1,因此该事件的信息量为:6 6 18I log18 4.17 比特【2.3】如果你在不知道今天是星期几的情况下问你的朋友“明天星期几?”则答案中含有 多少信息量?如果你在已知今天是星期四的情况下提出同样的问题,则答案中你能获得多 少信息量(假设已知星期一至星期日的顺序)? 解:如果不知今天星期几时问的话,答案可能有七种可能性,每一种都是等概率的,均为P 1,因此此时从答案中获得的信息量为7I log 7 2.807 比特而当已知今天星期几时问同样的问题,其可能性只有一种,即发生的概率为 1,此时获得的信息量为 0 比特。

【2.4】居住某地区的女孩中有 25%是大学生,在女大学生中有 75%是身高 1.6 米以上的, 而女孩中身高 1.6 米以上的占总数一半。

假如我们得知“身高 1.6 米以上的某女孩是大学 生”的消息,问获得多少信息量? 解:设 A 表示女孩是大学生, P ( A ) 0.25 ;B 表示女孩身高 1.6 米以上, P ( B | A ) 0.75 , P ( B ) 0.5“身高 1.6 米以上的某女孩是大学生”的发生概率为P( A | B) P( AB)P( A) P(B | A)0.25 0.750.375 P( B) P( B) 0.5已知该事件所能获得的信息量为I log10.3751.415 比特X a1 0a21a32a43【2.5 】设离散无记忆信源 ,其发出的消息为P( x) 3 / 8 1/ 4 1 / 4 1/ 8 (202120130213001203210110321010021032011223210),求(1)此消息的自信息是多少?(2)在此消息中平均每个符号携带的信息量是多少?解:信源是无记忆的,因此,发出的各消息之间是互相独立的,此时发出的消息的自信息即为各消息的自信息之和。

根据已知条件,发出各消息所包含的信息量分别为:I (a0 0) log81.415 比特3I (a11) log 4 2 比特I (a22) log 4 2 比特I (a33) log 8 3 比特在发出的消息中,共有14 个“0”符号,13 个“1”符号,12 个“2”符号,6 个“3”符号,则得到消息的自信息为:I 14 1.415 13 2 12 2 6 3 87.81 比特45 个符号共携带87.81 比特的信息量,平均每个符号携带的信息量为I 87.811.95 比特/符号45注意:消息中平均每个符号携带的信息量有别于离散平均无记忆信源平均每个符号携带的信息量,后者是信息熵,可计算得H ( X ) P( x) log P( x) 1.91比特/符号【2.6】如有 6 行 8 列的棋型方格,若有二个质点 A 和 B ,分别以等概率落入任一方格内,且它们的坐标分别为(X A ,Y A )和(X B ,Y B ),但 A 和 B 不能落入同一方格内。

(1) 若仅有质点 A ,求 A 落入任一个格的平均自信息量是多少?(2) 若已知 A 已落入,求 B 落入的平均自信息量。

(3) 若 A 、B 是可分辨的,求 A 、B 同都落入的平均自信息量。

解:(1)求质点 A 落入任一格的平均自信息量,即求信息熵,首先得出质点 A 落入任一格的概率空间为:X a 1 a 2 a 3 … a 481 1 1 1 P 48 48 48 (48)平均自信息量为H ( A ) log 48 5.58 比特/符号(2)已知质点 A 已落入,求 B 落入的平均自信息量,即求 H ( B | A ) 。

1A 已落入,B 落入的格可能有 47 个,条件概率 P (b j | a i ) 均为 47。

平均自信息量为48 47H ( B | A ) P (a i )P (b j | a i ) log P (b j | a i ) log 47 5.55 比特/符号i 1 j 1(3)质点 A 和 B 同时落入的平均自信息量为H ( AB ) H ( A ) H (B | A ) 11.13 比特/符号【2.7】从大量统计资料知道,男性中红绿色盲的发病率为 7%,女性发病率为 0.5%,如果 你问一位男同志:“你是否是红绿色盲?”,他的回答可能是“是”,也可能是“否”,问这 两个回答中各含有多少信息量?平均每个回答中含有多少信息量?如果你问一位女同志, 则答案中含有的平均自信息量是多少? 解:男同志红绿色盲的概率空间为:X a1 a2P 0.07 0.93 问男同志回答“是”所获昨的信息量为:I log 10.073.836 比特/符号问男同志回答“否”所获得的信息量为:I log 10.930.105 比特/符号男同志平均每个回答中含有的信息量为H ( X ) P( x) log P( x) 0.366 比特/符号同样,女同志红绿色盲的概率空间为Y b1 b2P 0.005 0.995问女同志回答“是”所获昨的信息量为:I log 10.0057.64 比特/符号问女同志回答“否”所获昨的信息量为:I log 10.9957.23 10 3 比特/符号女同志平均每个回答中含有的信息量为H (Y ) P( x) log P( x) 0.045 比特/符号X a1 a2a3a4a5a6【2.8】设信源 ,求此信源的熵,并解释为什 P( x) 0.2 0.19 0.18 0.17 0.16 0.17么H ( X ) log 6 ,不满足信源熵的极值性。

解:H ( X ) P( x) log P( x) 2.65 log 6原因是给定的信源空间不满足概率空间的完备集这一特性,因此不满足极值条件。

【 2.9 】设 离散 无记 忆 信 源 S 其 符号集 A {a 1 , a 2 ,..., a q } ,知其 相 应 的 概率 分别 为(P 1 , P 2 ,..., P q ) 。

设 另 一 离 散 无记 忆 信 源 S ,其 符 号集 为 S 信 源符 号集 的两 倍 ,A {a i , i 1,2,...,2q } ,并且各符号的概率分布满足P i (1 s ) P i P i s P i i 1,2,..., q i q 1, q 2, (2)试写出信源 S 的信息熵与信源 S 的信息熵的关系。

解:H (S ) P ( x ) log P ( x )(1 s ) P i log(1 s )P i sP i log s P i(1 s ) P i log(1 s ) (1 s ) P i log P i s P i log s s P i log P i (1 s ) log(1 s ) s log s H (S )H (S ) H (s ,1 s )【2.10】设有一概率空间,其概率分布为{ p 1 , p 2 ,..., p q } ,并有 p 1 p 2 。

若取 p 1p 1 s ,p 2 p 2 s ,其中0 2s p 1 p 2 ,而其他概率值不变。

试证明由此所得新的概率空间的熵是增加的,并用熵的物理意义加以解释。

解:设新的信源为 X ,新信源的熵为:H ( X ) p i log p i ( p 1 s ) log( p 1 s ) ( p 2 s ) log( p 2 s ) … p q log p q原信源的熵H ( X ) p i log p ip 1 log p 1 p 2 log p 2 … p q log p q因此有,H ( X ) H ( X ) ( p 1 s ) log( p 1 s ) ( p 2 s ) log( p 2 s ) p 1 log p 1 p 2 log p 2p 1 p 2令 f ( x ) ( p 1 x ) log( p 1 x ) ( p 2 x ) log( p 2 x ) , x 0, ,则2f ( x ) logp 2 x 0p 1 xL 即函数 f ( x ) 为减函数,因此有 f (0) f (s ) ,即( p 1 s ) log( p 1 s ) ( p 2 s ) log( p 2 s ) p 1 log p 1 p 2 log p 2因此 H ( X ) H ( X ) 成立。

【解释】当信源符号的概率趋向等概率分布时,不确定性增加,即信息熵是增加的。

L【2.11】试证明:若 p i i 1m1, q j j 1p L ,则H ( p , p ,…, p , q , q ,…, q ) H ( p , p ,…, p, p ) p H ( q 1 , q 2 ,…, q m ) 1 2 L 1 1 2 m 1 2 L 1 Lp L p L p L并说明等式的物理意义。

解:H ( p 1 , p 2 ,…, p L 1 , q 1 , q 2 ,…, q m )p 1 log p 1 p 2 log p 2 … p L 1 log p L 1 q 1 log q 1 q 2 log q 2 … q m log q m p 1 log p 1 p 2 log p 2 … p L 1 log p L 1 p L log p L p L log p L q 1 log q 1 q 2 log q 2 … q m log q mp 1 log p 1 p 2 log p 2 … p L 1 log p L 1 p L log p L (q 1 q 2 q 3 … q m ) log p L q 1 log q 1 q 2 log q 2 … q m log q mp 1 log p 1 p 2 log p 2 … p L 1 log p L 1 p L log p Lq 1 log q 1 p L q 2 log q 2 p L… q m log q mp Lp 1 log p 1 p 2 log p 2 … p L 1 log p L 1 p L log p Lp L ( q 1 log q 1 q 2 log q 2 q q … m log m ) p L p L p L p L p L p LH ( p 1 , p 2,…, pL 1, p L) p L H m (q 1 , q 2,…, q m ) p L p L p L【意义】将原信源中某一信源符号进行分割,而分割后的符号概率之和等于被分割的原符号的 概率,则新信源的信息熵增加,熵所增加的一项就是由于分割而产生的不确定性量。