基于DTW模型的语音识别

基于DTW算法的语音识别原理与实现

广州大学机械与电气工程学院数字语音信号处理基于DTW算法的语音识别原理与实现院系: 机电学院电子与通信工程姓名: 张翔学号: 2111307030 指导老师: 王杰完成日期: 2014-06-11基于DTW算法的语音识别原理与实现[摘要]以一个能识别数字0~9的语音识别系统的实现过程为例,阐述了基于DTW算法的特定人孤立词语音识别的基本原理和关键技术。

其中包括对语音端点检测方法、特征参数计算方法和DTW算法实现的详细讨论,最后给出了在Matlab下的编程方法和实验结果,结果显示该算法可以很好的显示特定人所报出的电话号码。

[关键字]语音识别;端点检测;MFCC系数;DTW算法Principle and Realization of Speech Recognition Based on DTW AlgorithmAbstract With an example of the realization of a 0~9 identifiable speech recognition system, the paper described the basic principles and key technologies of isolated word speech recognition based on DTW algorithm, including method of endpoint detection, calculation of characteristic parameters, and implementation of DTW algorithm. Programming method under Matlab and experimental results are given at the end of the paper.,and the results show that the algorithm can well display the phone number of the person reported.Keyword speech recognition; endpoint detection; MFCC parameter; DTW algorithm一、引言自计算机诞生以来,通过语音与计算机交互一直是人类的梦想,随着计算机软硬件和信息技术的飞速发展,人们对语音识别功能的需求也更加明显和迫切。

基于DTW和GMM的多维特征说话人识别

摘要现今,运用语音技术越来越来方便人类的生活。

语音技术经常被用于听写、交互和识别。

同时语音技术属于生物识别认证中的一种。

说话人识别是语音技术中一种较为常见的应用形式。

使用识别系统比对识别提取的特征参数,进而能够准确地识别说话者。

本文以非特定人文本内容无关的说话人识别为研究对象,针对常见的系统做出改进,在不增加识别的时间的前提下,有效提高了识别的准确率。

本文所做工作主要包括:(1)针对说话人识别特征参数进行了优化。

常用的特征参数为LPCC和MFCC参数。

MFCC依据人耳听觉特性,包含了语音频率结构的时间变化信息,具有更好的鲁棒性,所以更多的被使用。

然而MFCC易被模仿,因此,我们添加了一个常见的语音特征参数——基音周期到说话者识别系统中。

基音周期包含有关语音频率结构的信息,不容易模仿。

故将MFCC 和基音周期二者结合,在不影响识别时间的前提下,实现了说话人的识别率的提升。

(2)针对说话人识别模型进行了优化。

常见的语音识别体系中通常采用高斯混合模型,然而单一的高斯混合模型识别的数据量通常很大,导致识别时间过长。

本文针对识别时间和识别率联合做出优化。

提出一种新的思路,先用DTW计算语音样本间基音周期的最短距离,同时用GMM的识别方法计算需要测试的语音的梅尔倒谱系数。

这样运用两个模型的识别结果共同进行判断,使得识别结果更准确;算法同时对DTW采取放宽端点限制的优化方法。

实验表明,这种DTW和GMM相结合的说话人识别模型在提高识别准确率和减少识别时间方面有了明显的改进。

关键词:说话人识别,基音周期,梅尔频率倒谱系数,动态时间规整,高斯混合模型AbstractToday, the speech processing technology is being used to increasing convenience for human life. It can be used for dictation, interaction and recognition. At the same time, speech processing technology is one of the biometric authentication. Speaker recognition is a more common form of application in speech technology. The recognition system is used to accurately recognize the speaker by identifying the extracted feature parameters.In this thesis, we focus on speaker recognition which is irrelevant to the content of non-specific texts. The speaker recognition of non-specific human text content is taken as the research object, and the improvement of common system is made.The accuracy of recognition is effectively improved without affecting the time of recognition. The work done in this thesis mainly includes:(1) Optimization for speaker recognition feature parameters. LPCC and MFCC are commonly used characteristic parameters. The MFCC contains time-varying information of the speech frequency structure according to the human auditory characteristics, and has better robustness. However, the MFCC is easily mimicked, so a common speech feature parameter, the pitch period, is added to the speaker recognition system. The pitch period contains information about the structure of the speech frequency and is not easy to be imitated. Therefore, combining the MFCC and the pitch period, the recognition rate of the speaker is improved without affecting the recognition time.(2) Optimization for the speaker recognition model. Gaussian mixture models are commonly used in common speech recognition systems. However, the amount of data recognized by a single Gaussian mixture model is usually large, resulting in an excessive recognition time. This thesis optimizes the combination of recognition time and recognition rate. A new idea is proposed. Firstly, the shortest distance of the pitch period between speech samples is calculated by DTW, and the Mel cepstrum coefficients of the speech to be tested are calculated by the GMM recognition method. In this way, the recognition results of the two models are combined to make the judgment, so that the recognition result is more accurate. In the meantime, DTW is optimized by relaxing endpoint restrictions. Experiments show that the speaker recognition model combined with DTW and GMM has significantly improved recognition accuracy and reduced recognition time.Key words: speaker recognition, pitch period, MFCC, DTW, GMM目录专用术语注释表 (V)第一章绪论 (1)1.1 课题的背景及意义 (1)1.2 语音识别的研究现状 (2)1.3 语音识别的应用 (4)1.4 说话人识别的研究重点 (5)1.5 主要内容及结构安排 (6)第二章语音识别的基础知识 (7)2.1 语音信号预处理 (8)2.1.1 采样与量化 (8)2.1.2 预加重、分帧和加窗 (9)2.2 端点检测 (11)2.2.1 语音信号短时能量 (11)2.2.2 语音信号短时平均过零率 (12)2.2.3 基于双时域参数的双门限端点检测 (12)2.3 语音特征参数提取 (13)2.3.1 线性预测倒谱参数(LPCC) (14)2.3.2 Mel频率倒谱系数(MFCC) (15)2.4 本章小结 (17)第三章基于混合特征参数的说话人识别优化算法 (18)3.1 基音周期的引入 (19)3.1.1 基音周期的含义 (19)3.1.2 基音周期的检测方法 (19)3.1.3 基音周期的提取步骤 (20)3.1.4 说话人识别实验结果及分析 (21)3.2 MFCC参数的优化 (22)3.2.1 MFCC参数的提取 (22)3.2.2 半升正弦函数MFCC参数优化原理 (23)3.2.3 实验结果及分析 (24)3.3 本章小结 (25)第四章说话人识别模型优化算法 (26)4.1 DTW算法模型 (27)4.2 HMM算法模型 (31)4.2.1 马尔科夫链 (31)4.2.2 HMM模型 (32)4.3 高斯混合模型 (33)4.3.1 EM算法 (35)4.3.2 基于高斯混合模型的说话人识别 (39)4.4 DTW算法优化 (40)4.4.1 搜索宽度限制 (40)4.4.2 放宽端点限制 (41)4.4.3 DTW算法优化实验结果及分析 (41)4.5 基于DTW+GMM说话人识别实验结果及分析 (42)4.6 本章小结 (43)第五章总结和展望 (45)5.1 总结 (45)5.2 工作展望 (45)参考文献 (47)附录1 攻读硕士学位期间申请的专利 (51)致谢 (52)专用术语注释表缩略词说明:第一章绪论1.1课题的背景及意义对于人类和许多高等等动物来说,语言的交流与沟通是传递信息和交流感情的最有效、最直接的方式。

基于DTW和EMD的孤立词语音识别研究

(1.SchoolofInformationandControlEngineering,LiaoningShihuaUniversity,FushunLiaoning 113001,China; 2.Liaoning EquipmentManufacturing Vocationaland TechnicalCollege,ShenyangLiaoning 110000,China)

referencetemplateandthetemplatetobe measuredisusedastherecognitionresult.Thesimulationresultsshowthatthe

proposedalgorithmcanimprovetherecognitionefficiencyofspeechandtheaccuracyofrecognition. Keywords: Speechrecognition;Empiricalmodedecomposition;Dynamictimewarping;Isolatedwordrecognition

timezerocrossingrateandshort���t���imeenergyareusedtodetecttheendpointdetectionofspeechsignal.Afterthespeechfeature parametersareextracted,thespeechsignalis matched withthereferencetemplate.Finally,theshortestpathbetweenthe

第38卷 第1期 2018 年 2 月

基于DTW算法语音识别系统的仿真及DSP实现

me n t s a n d p r o v i d e a g o o d p e r f o r ma n c e i n t h e s p e e c h r e c o g n i t i o n .

【 K e y w o r d s 】D T W;s p e c t r l a s u b t r a c t i o n ; D S P; a u d i o c h i p

r e c o g n i t i o n s y s t e m. I n t h i s p a p e r , t h e s p e c t r a l s u b t r a c t i o n i s u s e d i n r f o n t e n d d e n o i s i n g p r o c e s s i n g, t h e s i mu l a t i o n i s c a r r i e d o n b y u s i n g Ma t l a b , a n d a k i n d o f i s o l a t e d w o r d s p e e c h r e c o g n i t i o n s y s t e m i s d e s i g n e d w h i c h i s b a s e d o n t h e 1 6 d i g i t l a s i na g l p r o c e s s o r n a me d T MS 3 2 0 VC 5 5 0 9 . T h e s i mu l a t i o n r e s u l t s s h o w t h a t t h e s y s t e m c a n me e t t h e r e l— a t i me p e r f o r e n c e r e q u i r e —

基于DTW的说话人识别技术研究

,

D一 ∑ d ] [时间规整情况 下两矢 量 的距离 , [ ] d X, 是第 i 帧测试矢量 x 和第 i 帧模 板矢量 Y. 之间的距离测 度 ,一 般这个 距 离测度采用欧氏距离 的平方 , 如下式所示 :

想, 解决 了语音发音长短不一 的模板匹配问题 , 是语音识别 中出现较早 , 为经典 的一种算法。 较 设测试语 音参 数共有 I 帧矢量 , 测试 语 则 音模板的特征矢量 序列为 x= X 、 。 ( 。X 、… 、 , x) 参考语音参数共有 J ,则参考模板的特征矢 帧 量 序列为 Y= Y 、 … 、 1。且 , ( .Y 、 Y) ≠J, 动态 则 时间规整就是要找到一个时 间规整 函数 』 =州 它将测 试矢量 的 时间轴 j 线性 地 映射到 参 非 考模板 的时 间轴 j 二 并使 该 函数 w满足 下 j,

】概 述

对 说话人识 别 的研 究始于 2 0世纪 3 0年 代, 早期 的工作主要集 中在人耳听辨实验和探 讨听音识别的可能性 方面。而对说话人 自动识 别的研究则起始于 2 0世纪 6 O年代 ,近几十年 来, 在这一技术的研究上取得 了重大的进展 , 并 在许多领域得到 了应用l l l 。主要讨论了 D W 算 T 法在说话人识别技术 中的应用 ,通过编程做 了 个基于 D W 的说话 人识别系统 ,并 对仿真 T 实验数据进行 了分析。 2 基于动态 时间规 整( T 的说话人 识 D W) 别方法 的算法实现 21 . 基于动态时间规整( T 的说话人识 D W)

一

预 加重 的 目的在于 消 除唇辐 射 的影 响 ,提 升语 音高 频部 分, 使语 音信号 的频谱 区域平 坦, 被广泛使用 的预加重 网络 是一 固定的数字 系统 , 信号方 程为: sn= ()09 (一 ) ()s 一 . s 1 n 5 n 其Z 变换的传递 函数为 :

基于非线性取值DTW算法的鲁棒性语音识别系统

基于非线性取值DTW算法的鲁棒性语音识别系统张宇昕;丁岩【期刊名称】《长春理工大学学报(自然科学版)》【年(卷),期】2013(000)006【摘要】In this paper, an efficient robust speech recognition system in noisy environment was proposed. A smooth function is used to short time energy (STE), which has improved the detection accuracy of STE. The complexity of running spectrum filtering is high, because two band-pass filter are used. Hence, the cepstrum mean subtraction (CMS) was used to reduce the convolution noise in logarithm spectrum, and the calculation is reduced more much. Unlike conventional DTW (Dynamic Time Warping) algorithms, which search for the reference word with minimum distance from the unknown speech waveform, a nonlinear median filter (NMF) was used and the reference word with minimum median distance from the unknown speech waveform was searched for.DTW implementations can be improved substantially. In this approach yields,DTW recognition accuracyis higher than that of the HMM techniques. However, the training is saved.%提出了一个在噪声环境下高效的语音识别系统。

基于DTW的孤立词语音识别研究

20

皆0 1 0

0

50

1 0O

1 50

2O 0

式 中 a为 预 加 重 系 数 , a取 值 为 0 9 1 0之 间 的数 , .一 .

一

箬

0

般 取 值 为 d一0 9 。 .5 语 音 处 理 中 的窗 是 与短 时 分 析 紧 密 联 系 的 , 加 窗 的 而

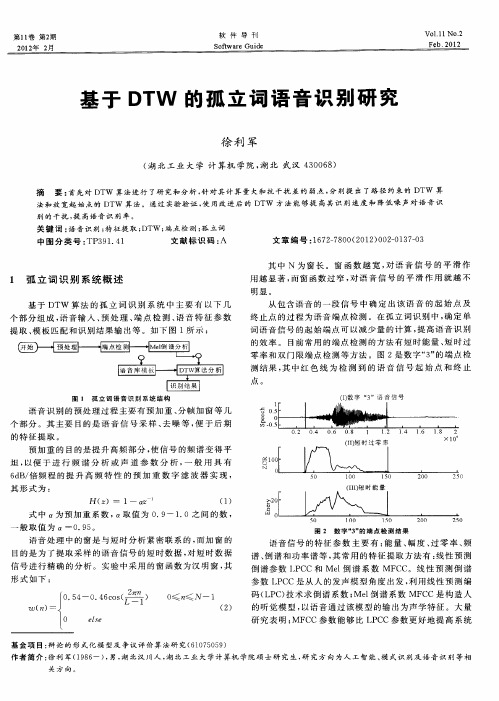

图 2 数 字 … 的 端 点 检 测 结 果 3’

语 音 信 号 的特 征 参 数 主 要 有 : 量 、 度 、 零 率 、 能 幅 过 频 谱 、 谱 和 功 率谱 等 , 常 用 的特 征 提取 方法 有 : 性 预 测 倒 其 线

倒 谱 参 数 I CC和 Me 倒 谱 系 数 MF C。线 性 预 测 倒 谱 P l C 参数 L C P C是 从 人 的发 声 模 型角 度 出发 , 用 线 性 预 测 编 利

图5放宽起始点后的区域限制在放宽端点限制的dtw算法中累计距离矩阵中的元素1212132131不是根据局部判决函数计算得到的而是直接将帧匹配距离矩阵的元素填入自动从其中选择最小的一个作为起点对于终点也是从放宽终点的允许范围内选择一个最小值作为参考模式和测试模式的匹配距离

第1卷 第2 1 期

2 1年 2 02 月

明显 。

从 包 含语 音 的 一段 信 号 中 确 定 出 该 语 音 的起 始 点 及

终 止 点 的 过 程 为 语 音 端 点 检 测 。在 孤 立词 识 别 中 , 定 单 确 词 语 音 信 号 的起 始 端 点 可 以 减 少 量 的 计算 , 高语 音 识 别 提 的 效 率 。 目前 常 用 的 端 点 检 测 的 方 法 有 短 时 能 量 、 时 过 短 零 率 和 双 门 限 端 点 检 测 等 方 法 。图 2是数 字 “ ” 端 点 检 3的 测 结 果 , 中红 色 线 为 检 测 到 的 语 音 信 号 起 始 点 和 终 止 其

DTW语音识别算法(部分)

DTW语音识别算法(部分)附录2:训练函数:train.mdisp('正在生成训练参数……');for i=1:20fname=sprintf('train\\%d0.wav',i);[k,fs]=audioread(fname); [StartPoint,EndPoint]=vad_m(k,fs);cc=mfcc(k);cc=cc(StartPoint-2:EndPoint-2,:);ref(i+1).StartPoint=StartPoint;ref(i+1).EndPoint=EndPoint;ref(i+1).mfcc=cc;enddisp('正在存储模板库……');save 'mfcc.mat' ref;disp('存储完毕')附录3:测试函数:dtwtest.mclear;close all;clc;disp('正在导入参考模板参数...');load mfcc.mat;disp('正在计算测试模板的参数...')for i=0:3fname = sprintf('test\\%d1.wav',i);[k,fs]=audioread(fname); [StartPoint,EndPoint]=vad_m(k,fs);cc=mfcc(k);cc=cc(StartPoint-2:EndPoint-2,:);test(i+1).StartPoint=StartPoint;test(i+1).EndPoint=EndPoint;test(i+1).mfcc=cc;enddisp('正在进行模板匹配...')dist = zeros(1,20);for i=1:4for j=1:20dist(i,j) = dtw(test(i).mfcc, ref(j).mfcc);endenddisp('正在计算匹配结果...')for i=1:4[d,j] = min(dist(i,:));if (j>=1 && j<=5)fprintf('测试模板%d1.wav 的识别结果为:前进\n',i-1); endif (j>= 6 && j<=10)fprintf('测试模板%d1.wav 的识别结果为:停止\n',i-1); endif (j>=11 && j<=15)fprintf('测试模板%d1.wav 的识别结果为:左转\n',i-1); endif (j>=16 && j<=20)fprintf('测试模板%d1.wav 的识别结果为:右转\n',i-1); endendclose all;附录4:特征提取函数:vad_m.mfunction [StartPoint,EndPoint]=vad(k,fs)%% [StartPoint,EndPoint]=vad(k,fs)%% 语音信号端点检测程序,k为语音信号,%% fs为其采样频率,程序绘制出语音信号%% 相关波形图并返回起止端点所对帧号close all% 幅度归一化到[-1,1]k=double(k);k=k./max(abs(k));%------------------------------% 显示波形%------------------------------SNR=5; % 设置SNRsignal=Gnoisegen(k,SNR); % 叠加噪声snr1=SNR_singlech(k,signal); % 计算叠加噪声后的信噪比N=length(k); % 信号长度t=(0:N-1)/fs; % 设置时间IS=.25; % 设置IS% 调用WienerScalart96m_2函数做维纳滤波output=WienerScalart96m_2(signal,fs,IS,0.12);ol=length(output); % 把output补到与x等长if ol<n< p=""> output=[output; zeros(N-ol,1)];endsnr2=SNR_singlech(k,output); % 计算维纳滤波后的信噪比snr=snr2-snr1;fprintf('snr1=%5.4f snr2=%5.4f snr=%5.4f\n',snr1,snr2,snr); subplot 311; plot(t,k,'k'); grid; axis tight;title('纯语音波形'); ylabel('幅值')subplot 312; plot(t,signal,'k'); grid; axis tight;title(['带噪语音信噪比=' num2str(SNR) 'dB']); ylabel('幅值')subplot 313; plot(t,output,'k');grid; ylim([-1 1]);title('维纳滤波后波形'); ylabel('幅值'); xlabel('时间/s');disp('显示原始波形图……');t=0:1/fs:(length(k)-1)/fs;% subplot(3,1,1);plot(t,k);axis([0,(length(k)-1)/fs,min(k),max(k)]); title('语音信号波形');xlabel('Time:s');ylabel('Amplitude(normalized)');disp('显示语音起始处放大波形图……');t1=0.2:1/fs:0.3;k1=k(0.2*fs:0.3*fs);subplot(3,1,2);plot(t1,k1);axis([0.2,0.3,min(k),max(k)]);title('(II) “00.wav”语音起始处放大波形图'); xlabel('Time:s');ylabel('Amplitude(normalized)');disp('显示语音结束处放大波形图……');t1=0.4:1/fs:0.5;k1=k(0.4*fs:0.5*fs);subplot(3,1,3);plot(t1,k1);axis([0.4,0.5,min(k),max(k)]);title('(III) “00.wav”语音结束处放大波形图'); xlabel('Time:s');ylabel('Amplitude(normalized)');%------------------------------% 计算短时过零率%------------------------------k=output;FrameLen=240;FrameInc=80;FrameTemp1=enframe(k(1:end-1),FrameLen,FrameInc);FrameTemp2=enframe(k(2:end),FrameLen,FrameInc);signs=(FrameT emp1.*FrameTemp2)<0;diffs=abs(FrameTemp1-FrameTemp2)>0.01;zcr=sum(signs.*diffs,2);zcrm=multimidfilter(zcr,5);disp('显示原始波形图……');figure,subplot(3,1,1);plot(t,k);axis([0,(length(k)-1)/fs,min(k),max(k)]);title('(I) 语音信号波形');xlabel('Time:s');ylabel('Amplitude(normalized)');disp('显示短时过零率……')zcrInd=1:length(zcrm);subplot(3,1,2);plot(zcrInd,zcr);axis([0,length(zcr),0,max(zcr)]);title('(II) 短时过零率');xlabel('Frame');ylabel('Zcr');%------------------------------% 计算短时能量%------------------------------amp=sum(abs(enframe(filter([1 -0.9375], 1, k), FrameLen, FrameInc)), 2); ampm=multimidfilter(amp,5);disp('显示短时能量……')ampInd=1:length(ampm);subplot(3,1,3);plot(ampInd,amp);axis([0,length(amp),0,max(amp)]);title('(III) 短时能量');xlabel('Frame');ylabel('Energy');% ------------------------------% 设置门限%------------------------------disp('设置门限……');ZcrLow=max([round(mean(zcr)*0.1),3]); %过零率低门限ZcrHigh=max([round(max(zcr)*0.1),5]); %过零率高门限AmpLow=min([min(amp)*10,mean(amp)*0.2,max(amp)*0.1] ); %能量低门限AmpHigh=max([min(amp)*10,mean(amp)*0.2,max(amp)*0.1 ]); %能量高门限%------------------------------% 端点检测%------------------------------MaxSilence=30; %最长语音间隙时间MinAudio=15; %最短语音时间Status=0; %状态:0静音段,1过渡段,2语音段,3结束段HoldTime=0; %语音持续时间SilenceTime=0; %语音间隙时间disp('开始端点检测……');for n=1:length(zcr)switch Statuscase{0,1}if amp(n)>AmpHigh | zcr(n)>ZcrHighStartPoint=n-HoldTime;Status=2;HoldTime=HoldTime+1;SilenceTime=0;elseif amp(n)>AmpLow | zcr(n)>ZcrLowStatus=1;HoldTime=HoldTime+1;elseStatus=0;HoldTime=0;endcase 2,if amp(n)>AmpLow | zcr(n)>ZcrLowHoldTime=HoldTime+1;elseSilenceTime=SilenceTime+1;if SilenceTime<maxsilence< p="">HoldTime=HoldTime+1;elseif (HoldTime-SilenceTime)<minaudio< p=""> Status=0;HoldTime=0;SilenceTime=0;elseStatus=3;endendcase 3,break;endif Status==3break;endendHoldTime =HoldTime-SilenceTime;EndPoint=StartPoint+HoldTime;disp('显示端点……');figure,subplot(3,1,1);plot(k);axis([1,length(k),min(k),max(k)]);title('(I) 语音信号');xlabel('Sample');ylabel('Speech');line([StartPoint*FrameInc,StartPoint*FrameInc],[min(k),max( k)],'color','red');line([EndPoint*FrameInc,EndPoint*FrameInc],[min(k),max(k)],'col or','red'); subplot(3,1,2);plot(zcr);axis([1,length(zcr),0,max(zcr)]);title('(II) 短时过零率');xlabel('Frame');ylabel('ZCR');line([StartPoint,StartPoint],[0,max(zcr)],'Color','red');line([EndPoint,EndPoint],[0,max(zcr)],'Color','red'); subplot(3,1,3);plot(amp);axis([1,length(amp),0,max(amp)]);title('(III) 短时能量');xlabel('Frame');ylabel('Energy');line([StartPoint,StartPoint],[0,max(amp)],'Color','red');line([EndPoint,EndPoint],[0,max(amp)],'Color','red');附录5:DTW算法function dist = dtw(test, ref)global x y_min y_maxglobal t rglobal D dglobal m nt = test;r = ref;n = size(t,1);m = size(r,1);d = zeros(m,1);D = ones(m,1) * realmax;D(1) = 0;% 如果两个模板长度相差过多,匹配失败if (2*m-n<3) | (2*n-m<2)dist = realmax;returnend% 计算匹配区域xa = round((2*m-n)/3);xb = round((2*n-m)*2/3);if xb>xa%xb>xa, 按下面三个区域匹配% 1 :xa% xa+1:xb% xb+1:Nfor x = 1:xay_max = 2*x;y_min = round(0.5*x);warpendfor x = (xa+1):xby_max = round(0.5*(x-n)+m); y_min = round(0.5*x);warpendfor x = (xb+1):ny_max = round(0.5*(x-n)+m); y_min = round(2*(x-n)+m); warpendelseif xa>xb%xa>xb, 按下面三个区域匹配% 0 :xb% xb+1:xa% xa+1:Nfor x = 1:xby_max = 2*x;y_min = round(0.5*x);warpendfor x = (xb+1):xay_max = 2*x;y_min = round(2*(x-n)+m); warpendfor x = (xa+1):ny_max = round(0.5*(x-n)+m); y_min = round(2*(x-n)+m); warpendelseif xa==xb%xa=xb, 按下面两个区域匹配% 0 :xa% xa+1:Nfor x = 1:xay_max = 2*x;y_min = round(0.5*x);warpendfor x = (xa+1):ny_max = round(0.5*(x-n)+m); y_min = round(2*(x-n)+m); warpendend%返回匹配分数dist = D(m);function warpglobal x y_min y_max global t rglobal D dglobal m nd = D;for y = y_min:y_maxD1 = D(y);if y>1D2 = D(y-1);elseD2 = realmax;endif y>2D3 = D(y-2);elseD3 = realmax;endd(y) = sum((t(x,:)-r(y,:)).^2) + min([D1,D2,D3]); end D = d;</minaudio<></maxsilence<></n<>。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

矿产资源开发利用方案编写内容要求及审查大纲

矿产资源开发利用方案编写内容要求及《矿产资源开发利用方案》审查大纲一、概述

㈠矿区位置、隶属关系和企业性质。

如为改扩建矿山, 应说明矿山现状、

特点及存在的主要问题。

㈡编制依据

(1简述项目前期工作进展情况及与有关方面对项目的意向性协议情况。

(2 列出开发利用方案编制所依据的主要基础性资料的名称。

如经储量管理部门认定的矿区地质勘探报告、选矿试验报告、加工利用试验报告、工程地质初评资料、矿区水文资料和供水资料等。

对改、扩建矿山应有生产实际资料, 如矿山总平面现状图、矿床开拓系统图、采场现状图和主要采选设备清单等。

二、矿产品需求现状和预测

㈠该矿产在国内需求情况和市场供应情况

1、矿产品现状及加工利用趋向。

2、国内近、远期的需求量及主要销向预测。

㈡产品价格分析

1、国内矿产品价格现状。

2、矿产品价格稳定性及变化趋势。

三、矿产资源概况

㈠矿区总体概况

1、矿区总体规划情况。

2、矿区矿产资源概况。

3、该设计与矿区总体开发的关系。

㈡该设计项目的资源概况

1、矿床地质及构造特征。

2、矿床开采技术条件及水文地质条件。