4个性能评价测度

矢量量化原理 第六章

(N)

min

QQN

E[d(X ,Q(X

))]

▪ 式中QN为所有码书大小为N的K维矢量量化器的集

合。

28

二.设计最佳矢量量化器的必要条件

▪ 一是在给定码书的条件下,寻找信源空间的最佳 划分,使平均失真最小;

▪ 二是在给定划分的条件下,寻找最佳码书,使平

均失真最小。

▪ (1)最佳划分 ▪ 给定码书 N Y1,Y2,,YN ,可以用最近邻准则NNR

分成有限个胞腔,然后从每一个胞腔取一个代表 值,凡是落入该胞腔的矢量均用该代表值进行量 化。

25

矢量量化特点:

▪ (1)矢量量化是把量化矢量(码字)分别存储在

编码器和译码器两端的码书中,在信道中传输的

并不是输入矢量X的量化矢量Y本身,而是码字Y的 下标j的编码信号;

▪ (2)在相同的速率下,矢量量化的失真比标量量

译码端:

先把信道传送来的编码信号译成序号j,再根据 序号(或码字Yj 所在地址),从码本中查出相应 的码字Yj 。Yj 是输入矢量X的重构矢量。

21

矢量量化器的特点:

➢传输存储的不是矢量本身而是其序号,所

以据有高保密性能

➢收发两端没有反馈回路,因此比较稳定 ➢矢量量化器的关键是编码器的设计,译码

▪ 必须保证平均失真存在并可计算

易于硬件实现

17

常用的失真测度

▪ 1、平方失真测度

d(X ,Y ) 1

K

X

Y

2

1 K

K

( xi

i 1

yi )2

这是最常用的失真测度,易于处理和计算,且在主观评

价上有意义,即小的失真值对应好的主观评价质量。

欧洲五维健康量表EQ—5D—5L中文版的信效度研究

欧洲五维健康量表EQ—5D—5L中文版的信效度研究作者:邢亚彬马爱霞来源:《上海医药》2013年第09期摘要本文对324名受访者进行问卷调查,通过Cronbach’s α系数和Spearman秩相关系数分别对中文版EQ-5D-5L量表的一致性信度和重测信度进行分析,通过因子分析和相关分析来考察量表的结构效度和校标效度。

结果证实,中文版EQ-5D-5L量表具有较好的信度和效度,可以用于评价健康人群的生存质量。

关键词 EQ-5D-5L 信度效度中图分类号:R194.3 文献标识码:C 文章编号:1006-1533(2013)09-0040-04Study on reliability and validity of Chinese version of EQ-5D-5LXING Yabin, MA Aixia*(School of International Pharmaceutical Business, China Pharmaceutical University,Nanjing 211198, China)ABSTRACT Based on a questionnaire survey conducted among 324 respondents, the consistency reliability and test-retest reliability of the Chinese version of EQ-5D-5L were analyzed by Cronbach’s α coefficient and Spearman’s rank correlati on coefficient, and the structural validity and criterion validity were analyzed by factor analysis and correlation analysis. Results verified the good reliability and validity of the Chinese version of EQ-5D-5L, which can be used to evaluate the life quality of healthy people.KEY WORDS EQ-5D-5L; reliability; validity中国健康居民的生活质量越来越受到人们的关注。

一种新型X射线安检图像增强算法

一种新型X射线安检图像增强算法郑林涛;董永生;史恒亮【摘要】针对X射线安检图像噪声大、对比度低和边缘不清晰等特点,提出一种基于对比度受限自适应直方图均衡化(CLAHE)变换和图像灰度最大值融合的双重能量X射线图像增强算法.首先,应用CLAHE变换分别对高能和低能X射线图像分别进行处理得到初步增强结果;然后采用空域灰度值最大融合算法融合经过CLAHE变换后的高能和低能X射线图像从而得到最终增强X射线图像.实验结果表明该算法能更有效地提高双重能量X射线图像的对比度,显著改善图像质量.【期刊名称】《科学技术与工程》【年(卷),期】2014(014)023【总页数】5页(P252-256)【关键词】X射线图像;图像增强;对比度受限自适应直方图均衡化;图像融合【作者】郑林涛;董永生;史恒亮【作者单位】河南科技大学信息工程学院,洛阳471023;河南科技大学信息工程学院,洛阳471023;河南科技大学信息工程学院,洛阳471023【正文语种】中文【中图分类】TP391.41公共安全作为国家安全的重要组成部分,是政府社会管理和公共服务的重要内容,也是民众最为关注的焦点问题之一。

X 射线安全检查设备作为公共交通运输等领域最重要的安全检查手段之一,是公共安全防御的一道重要防线。

它能够通过X 射线透射的方法获取行李包裹等的内部物品图像,使安检人员在不需开包的情况下查看行李包裹的内容物。

目前使用的安全检测系统中常见的是双能量射线(dual energy X ray)检测系统。

该类系统使用的双能量X 射线成像技术是一种非常有效的投影成像技术。

双能量X 射线系统产生高低两种不同能量级的射线:高能量射线(高于100 kV)和低能量射线(80 kV 左右)。

在图像扫描时分别用高低两种能量X 射线对同一行李进行照射。

但是在图像采集过程中难免受外界各种因素的影响,图像质量分布不均。

进行后续处理之前需要对原始图像进行增强处理,改善图像的视觉效果,便于安检人员对检测图像进行判断分析。

ale评价指标 -回复

ale评价指标-回复[ALE评价指标] 是指基于交叉熵损失函数,衡量神经网络模型的准确率和误差的一种评价指标。

ALE(Average Logarithmic Error)是计算模型在多分类任务中的平均对数误差的均值。

ALE评价指标在机器学习中起到了重要的作用。

它可以帮助我们判断模型对于不同类别的分类准确率和误差,从而改进模型性能,提高分类精度。

本文将一步一步回答关于ALE评价指标的问题,帮助读者更好地理解和使用该指标。

1. 什么是交叉熵损失函数?交叉熵是一种度量两个概率分布之间差异的指标。

在机器学习中,交叉熵损失函数被广泛用于多分类任务。

它衡量了模型输出结果与真实标签之间的差距。

通过最小化交叉熵损失,可以使模型更准确地学习到不同类别的特征和模式。

2. 为什么要使用对数误差?对数误差是一种将分类问题中的概率转化为连续测度的方法。

在多分类任务中,神经网络模型的输出一般为一个概率分布,而真实标签是离散的。

对数误差可以将概率转化为连续测度的形式,以更好地衡量模型对于不同类别的分类准确率和误差。

3. ALE评价指标是如何计算的?ALE评价指标的计算过程包括以下步骤:1)首先,对于每个样本,将模型预测结果和真实标签计算其对数误差。

2)然后,将每个样本的对数误差求平均,得到模型在整个数据集上的平均对数误差。

3)最后,将平均对数误差取负号,得到ALE评价指标。

4. ALE评价指标的优点是什么?ALE评价指标有以下几个优点:1)它将模型预测结果和真实标签的差距以连续测度的形式衡量,更全面地反映了模型的分类性能。

2)它能够考虑每个样本的贡献,不会被极端值或异常样本所影响。

3)与其他评价指标相比,ALE评价指标的计算简单高效,易于理解和实现。

5. 如何使用ALE评价指标改进模型性能?使用ALE评价指标可以帮助我们判断模型在不同类别上的分类准确率和误差。

通过观察模型在不同类别上的平均对数误差,我们可以定位模型分类性能较差的类别,并针对性地改进模型。

特征选择方法综述

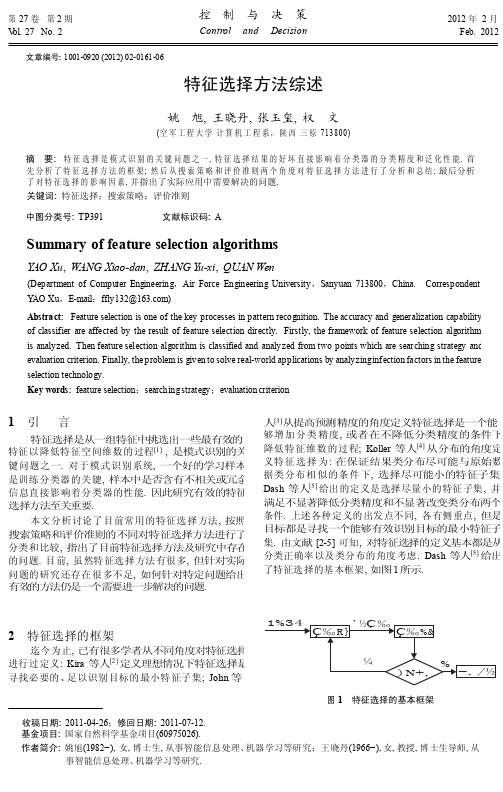

控 制 与 决 策第 27 卷 第 2 期 V ol. 27 No. 22012 年 2 月Feb. 2012Control andDecision文章编号: 1001-0920 (2012) 02-0161-06特征选择方法综述姚 旭, 王晓丹, 张玉玺, 权 文(空军工程大学 计算机工程系,陕西 三原 713800)摘 要: 特征选择是模式识别的关键问题之一, 特征选择结果的好坏直接影响着分类器的分类精度和泛化性能. 首 先分析了特征选择方法的框架; 然后从搜索策略和评价准则两个角度对特征选择方法进行了分析和总结; 最后分析 了对特征选择的影响因素, 并指出了实际应用中需要解决的问题. 关键词: 特征选择;搜索策略;评价准则 中图分类号: TP391文献标识码: ASummary of feature selection algorithmsYAO Xu , WANG Xiao-dan , ZHANG Y u-xi , QUAN Wen(Department of Computer Engineering ,Air Force Engineering University ,Sanyuan 713800,China. Correspondent: Y AO Xu ,E-mail :***************)Abstract: Feature selection is one of the key processes in pattern recognition. The accuracy and generalization capability of classifier are affected by the result of feature selection directly. Firstly, the framework of feature selection algorithm is analyzed. Then feature selection algorithm is classified and analyzed from two points which are searching strategy and evaluation criterion. Finally, the problem is given to solve real-world applications by analyzing infection factors in the feature selection technology.Key words: feature selection ;searching strategy ;evaluation criterion引言1 人[3] 从提高预测精度的角度定义特征选择是一个能 够增加分类精度, 或者在不降低分类精度的条件下 降低特征维数的过程; Koller 等人[4] 从分布的角度定 义特征选择为: 在保证结果类分布尽可能与原始数 据类分布相似的条件下, 选择尽可能小的特征子集; Dash 等人[5] 给出的定义是选择尽量小的特征子集, 并 满足不显著降低分类精度和不显著改变类分布两个 条件. 上述各种定义的出发点不同, 各有侧重点, 但是 目标都是寻找一个能够有效识别目标的最小特征子 集. 由文献 [2-5] 可知, 对特征选择的定义基本都是从 分类正确率以及类分布的角度考虑. Dash 等人[5] 给出 了特征选择的基本框架, 如图 1 所示.特征选择是从一组特征中挑选出一些最有效的 特征以降低特征空间维数的过程[1] , 是模式识别的关 键问题之一. 对于模式识别系统, 一个好的学习样本 是训练分类器的关键, 样本中是否含有不相关或冗余 信息直接影响着分类器的性能. 因此研究有效的特征 选择方法至关重要.本文分析讨论了目前常用的特征选择方法, 按照 搜索策略和评价准则的不同对特征选择方法进行了 分类和比较, 指出了目前特征选择方法及研究中存在 的问题. 目前, 虽然特征选择方法有很多, 但针对实际 问题的研究还存在很多不足, 如何针对特定问题给出 有效的方法仍是一个需要进一步解决的问题.特征选择的框架迄今为止, 已有很多学者从不同角度对特征选择进行过定义: Kira 等人[2] 定义理想情况下特征选择是 寻找必要的、足以识别目标的最小特征子集; John 等 2 图 1 特征选择的基本框架收稿日期: 2011-04-26;修回日期: 2011-07-12.基金项目: 国家自然科学基金项目(60975026).作者简介: 姚旭(1982−), 女, 博士生, 从事智能信息处理、机器学习等研究;王晓丹(1966−), 女, 教授, 博士生导师, 从事智能信息处理、机器学习等研究.由于子集搜索是一个比较费时的步骤, Y u 等 人[6]基于相关和冗余分析, 给出了另一种特征选择框 架, 避免了子集搜索, 可以高效快速地寻找最优子集. 框架如图 2 所示.间远远小于 (2N ).存在的问题: 具有较高的不确定性, 只有当总循 环次数较大时, 才可能找到较好的结果. 在随机搜索 策略中, 可能需对一些参数进行设置, 参数选择的合 适与否对最终结果的好坏起着很大的作用. 因此, 参 数选择是一个关键步骤.3.3 采用启发式搜索策略的特征选择方法这类特征选择方法主要有: 单独最优特征组合, 序列前向选择方法 (SFS), 广义序列前向选择方法 (GSFS), 序列后向选择方法 (SBS), 广义序列后向选择 方法 (GSBS), 增 l 去 选择方法, 广义增 l 去 选择方 法, 浮动搜索方法. 这类方法易于实现且快速, 它的搜 索空间是 (N 2 ). 一般认为采用浮动广义后向选择方 法 (FGSBS) 是较为有利于实际应用的一种特征选择 搜索策略, 它既考虑到特征之间的统计相关性, 又用 浮动方法保证算法运行的快速稳定性[13] . 存在的问 题是: 启发式搜索策略虽然效率高, 但是它以牺牲全 局最优为代价.每种搜索策略都有各自的优缺点, 在实际应用过 程中, 可以根据具体环境和准则函数来寻找一个最佳 的平衡点. 例如, 如果特征数较少, 可采用全局最优搜 索策略; 若不要求全局最优, 但要求计算速度快, 则可 采用启发式策略; 若需要高性能的子集, 而不介意计 算时间, 则可采用随机搜索策略.图 2 改进的特征选择框架从特征选择的基本框架可以看出, 特征选择方法中有 4 个基本步骤: 候选特征子集的生成 (搜索策 略)、评价准则、停止准则和验证方法[7-8] . 目前对特征 选择方法的研究主要集中于搜索策略和评价准则, 因 而, 本文从搜索策略和评价准则两个角度对特征选择 方法进行分类.基于搜索策略划分特征选择方法基本的搜索策略按照特征子集的形成过程可分 为以下 3 种: 全局最优、随机搜索和启发式搜索[9] . 一 个具体的搜索算法会采用两种或多种基本搜索策略, 例如遗传算法是一种随机搜索算法, 同时也是一种启 发式搜索算法. 下面对 3 种基本的搜索策略进行分析 比较.3.1 采用全局最优搜索策略的特征选择方法 迄今为止, 唯一得到最优结果的搜索方法是分支 定界法[10] . 这种算法能保证在事先确定优化特征子 集中特征数目的情况下, 找到相对于所设计的可分 性判据而言的最优子集. 它的搜索空间是 (2N ) (其 中 N 为特征的维数). 存在的问题: 很难确定优化特征 子集的数目; 满足单调性的可分性判据难以设计; 处 理高维多类问题时, 算法的时间复杂度较高. 因此, 虽 然全局最优搜索策略能得到最优解, 但因为诸多因素 限制, 无法被广泛应用.3.2 采用随机搜索策略的特征选择方法在计算过程中把特征选择问题与模拟退火算 法、禁忌搜索算法、遗传算法等, 或者仅仅是一个随 机重采样[11-12] 过程结合起来, 以概率推理和采样过程 作为算法的基础, 基于对分类估计的有效性, 在算法 运行中对每个特征赋予一定的权重; 然后根据用户所 定义的或自适应的阈值来对特征重要性进行评价. 当 特征所对应的权重超出了这个阈值, 它便被选中作为 重要的特征来训练分类器. Relief 系列算法即是一种 典型的根据权重选择特征的随机搜索方法, 它能有效 地去掉无关特征, 但不能去除冗余, 而且只能用于两 类分类. 随机方法可以细分为完全随机方法和概率随 机方法两种. 虽然搜索空间仍为 (2N ), 但是可以通 过设置最大迭代次数限制搜索空间小于 (2N ). 例如 遗传算法, 由于采用了启发式搜索策略, 它的搜索空3 基于评价准则划分特征选择方法特征选择方法依据是否独立于后续的学习算 法, 可分为过滤式 (Filter) 和封装式 (Wrapper)[14] 两种. Filter 与后续学习算法无关, 一般直接利用所有训练 数据的统计性能评估特征, 速度快, 但评估与后续学 习算法的性能偏差较大. Wrapper 利用后续学习算法 的训练准确率评估特征子集, 偏差小, 计算量大, 不适 合大数据集. 下面分别对 Filter 和 Wrapper 方法进行 分析.4.1 过滤式 (Filter) 评价策略的特征选择方法Filter 特征选择方法一般使用评价准则来增强特 征与类的相关性, 削减特征之间的相关性. 可将评价 函数分成 4 类[5] : 距离度量、信息度量、依赖性度量以 及一致性度量.4.1.1 距离度量 距离度量通常也认为是分离性、差异性或者辨4 识能力的度量. 最为常用的一些重要距离测度 有[1] 欧氏距离、 阶 Minkowski 测度、Chebychev 距离、平 方距离等. 两类分类问题中, 对于特征 X 和 Y , 如果 由 X 引起的两类条件概率差异性大于 Y , 则 X 优于 Y . 因为特征选择的目的是找到使两类尽可能分离的姚 旭 等: 特征选择方法综述 第2 期 163特征. 如果差异性为 0, 则 X 与 Y 是不可区分的. 算法 Relief [2] 及其变种 ReliefF [15] , 分支定界 和 BFF [16] 等都 是基于距离度量的. 准则函数要求满足单调性, 也可 通过引进近似单调的概念放松单调性的标准. 蔡哲元 等人[17] 提出了基于核空间的距离度量, 有效地提高了 小样本与线性不可分数据集上的特征选择能力. 4.1.2 信息度量信息度量通常采用信息增益 (IG) 或互信息 (MI) 衡量. 信息增益定义为先验不确定性与期望的后验不 确定性之间的差异, 它能有效地选出关键特征, 剔除 无关特征[18] . 互信息描述的是两个随机变量之间相 互依存关系的强弱. 信息度量函数 (f ) 在 Filter 特征 选择方法中起着重要的作用. 尽管 (f ) 有多种不同 形式, 但是目的是相同的, 即使得所选择的特征子集 与类别的相关性最大, 子集中特征之间的相关性最小. 刘华文[19] 给出了一种泛化的信息标准, 准则如下:互信息的评价准则, 具体函数如下:1 ∑(f ) = (C ; f ) −(; f ), (4)∣∣s ∈S 其中 ∣∣ 表示已选特征的个数. 该算法的思想就是最 大化特征子集和类别的相关性, 同时最小化特征之间 的冗余. Peng 用这种方法将多变量联合概率密度估计 问题转化为多重二变量概率密度估计, 解决了一大难 题. Ding 等人[23] 还给出了此算法的一种变种形式, 将 准则函数中的减法改为除法, 即(C ; f )(f ) = .(5)1 ∑ s ∈S (; f )∣∣4) FCBF (fast correlation-based filter)[6] 是基于相 互关系度量给出的一种算法. 对于线性随机变量, 用 相关系数分析特征与类别、特征间的相互关系. 对于 非线性随机变量, 采用对称不确定性 (SU) 来度量. 对 于两个非线性随机变量 X 和 Y , 它们的相互关系可表 示为(f ) = α ⋅ (, , ) − . (1) [ (X ∣Y )]其中: C 为类别, f 为候选特征, 为已选择的特征, 函数 (, , ) 为 , , 之间的信息量; α 为调控系数,δ 为惩罚因子. 下面就此信息标准的泛化形式与几个 现有选择算法中的信息度量标准之间的关系进行讨 论:1) BIF (best individual feature)[20] 是一种最简单最 直接的特征选择方法. 它的评价函数为B (, Y ) = 2 .(6) (X ) + (Y ) 其中: (X ) 与 (Y ) 为信息熵, (X ∣Y ) 为信息增益. 该算法的基本思想是根据所定义的 C - 相关 (特征与类别的相互关系) 和 - 相关 (特征之间的相互关 系), 从原始特征集合中去除 C - 相关值小于给定阈值 的特征, 再对剩余的特征进行冗余分析.5) CMIM (conditional mutual information maxi-mization). 有些特征选择方法利用条件互信息来评价特征的重要性程度, 即在已知已选特征集 的情况下通过候选特征 f 与类别 C 的依赖程度来确定 f 的重要性, 其中条件互信息 (C ; f ∣) 值越大, f 能提供的新信息越多. 因为 (C ; f ∣) 计算费用较高, 且样本的多维性导致了其估值不准确, Fleuret [24] 在提出的条件互信息最大化选择算法 CMIM 中采取一种变 通的方式, 即使用单个已选特征 来代替整个已选子集 以估算 (C ; f ∣), 其中 是使 (C ; f ∣) 值最大的 已选特征. CMIM 的评价函数为(2) (f ) = (C ; f ),其中 ( ) 为互信息, (C ; f ) 为类别 C 与候选特征 f 之间的互信息. 它的基本思想是对于每一个候选特征 f 计算评价函数 (f ), 并按评价函数值降序排列, 取 前 k 个作为所选择的特征子集. 这种方法简单快速, 尤其适合于高维数据. 但是它没有考虑到所选特征间 的相关性, 会带来较大的冗余.2) MIFS (mutual information feature selection) 为 基于上述算法的缺点, 由 Battiti [21] 给出的一种使用候 选特征 f 与单个已选特征 相关性对 f 进行惩罚的方 法, 其评价函数为(f ) = arg min (C ; f∣).(7) s ∈S(f ) = (C ; f ) − β ∑(;(3)除以上几种信息度量和算法外, 针对存在的问 题, 研究者们提出了新的评价函数和算法. Kwak 等 人[25] 指出 MIFS 算法中评价函数 ( ) 的惩罚因子并 不能准确地表达冗余程度的增长量, 给出了 MIFS- U (MIFS-uncertainty) 算法; 与 MIFS 算法类似, MIFS- U 算法中参数 β 的取值将影响选择算法的性能. 为 了解决该问题, Novovicova 等人[26] 提出了 MIFS-U 的 一种改进算法 mMIFS-U (modified version of MIFS-U), 算法中将 f 与 中单个已选特征相关程度最大的 作 为它们之间的冗余程度; 为了解决对称不确定性可能s ∈S其中 β 为调节系数, 当 β ∈ [0.5, 1] 时, 算法性能较好. 3) mRMR (minimal-redundancy and maximal-relevance) [22] 方法. 从理论上分析了 mRMR 等价于 最大依赖性, 并分析了三者的关系. 基于最大依赖性, 可通过计算不同特征子集与类别的互信息来选取最 优子集. 但是, 在高维空间中, 估计多维概率密度是一 个难点. 另一个缺点是计算速度非常慢. 所以本文从 与其等价的最小冗余和最大相关出发, 给出一种基于提供一些错误或不确定信息, Qu 等人[27] 利用决策依赖相关性来精确度量特征f与间的依赖程度, 提出了DDC (decision dependent correlation) 算法. 它们的思想都是一致的, 只是评价函数的表达形式不同. 刘华文[19] 还提出了一种基于动态互信息的特征选择方法. 随着已选特征数的增加, 类别的不确定性也逐渐降低, 无法识别的样本数也越来越少. 因此, 已识别的样本会给特征带来干扰信息, 可采用动态互信息作为评价标准, 在特征选择过程中不断地删除已识别的样本, 使得评价标准在未识别样本上动态估值.基于信息的度量是近年来的一个研究热点, 出现了大量基于信息熵的特征选择方法, 如文献[28-31] 等. 因为信息熵理论不要求假定数据分布是已知的, 能够以量化的形式度量特征间的不确定程度, 并且能有效地度量特征间的非线性关系. 因此, 信息度量被广泛应用, 并且也通过试验证明了其性能[32-34] . 以上基于信息度量的评价准则虽然形式不同, 但是核心思想都是找出与类别相关性最大的特征子集, 并且该子集中特征之间的相关性最小. 设计体现这一思想的函数是至关重要的.4.1.3 依赖性度量有许多统计相关系数, 如Pearson 相关系数、概率误差、Fisher 分数、线性可判定分析、最小平方回归误差[35] 、平方关联系数[36] 、-test 和F-Statistic 等被用来表达特征相对于类别可分离性间的重要性程度. 例如, Ding[23] 和Peng[22] 在mRMR 中处理连续特征时, 分别使用F-Statistic 和Pearson 相关系数度量特征与类别和已选特征间的相关性程度. Hall[37] 给出一种既考虑了特征的类区分能力, 同时又考虑特征间冗余性的相关性度量标准. Zhang 等人[38] 使用成对约束即must-link 约束和cannot-link 约束计算特征的权重, 其中must-link 约束表示两个样本离得很近, 而cannot-link 表示样本间离得足够远.在依赖性度量中, Hilbert-Schmidt 依赖性准则(HSIC) 可作为一个评价准则度量特征与类别的相关性. 核心思想是一个好的特征应该最大化这个相关性. 特征选择问题可以看成组合最优化问题性准则用不一致率来度量, 它不是最大化类的可分离性, 而是试图保留原始特征的辨识能力, 即找到与全集有同样区分类别能力的最小子集. 它具有单调、快速、去除冗余和不相关特征、处理噪声等优点, 能获得一个较小的特征子集. 但其对噪声数据敏感, 且只适合离散特征. 典型算法有Focus[41] , LVF[42] 等. 文献[43-44] 给出了基于不一致度量的算法.上面分析了Filter 方法中的一些准则函数, 选择合适的准则函数将会得到较好的分类结果. 但Filter 方法也存在很多问题: 它并不能保证选择出一个优化特征子集, 尤其是当特征和分类器息息相关时. 因而, 即使能找到一个满足条件的优化子集, 它的规模也会比较庞大, 会包含一些明显的噪声特征. 但是它的一个明显优势在于可以很快地排除很大数量的非关键性的噪声特征, 缩小优化特征子集搜索的规模, 计算效率高, 通用性好, 可用作特征的预筛选器.4.2 封装式(Wrapper) 评价策略的特征选择方法除了上述4 种准则, 分类错误率也是一种衡量所选特征子集优劣的度量标准. Wrapper 模型将特征选择算法作为学习算法的一个组成部分, 并且直接使用分类性能作为特征重要性程度的评价标准. 它的依据是选择子集最终被用于构造分类模型. 因此, 若在构造分类模型时, 直接采用那些能取得较高分类性能的特征即可, 从而获得一个分类性能较高的分类模型. 该方法在速度上要比Filter 方法慢, 但是它所选择的优化特征子集的规模相对要小得多, 非常有利于关键特征的辨识; 同时它的准确率比较高, 但泛化能力比较差, 时间复杂度较高. 目前此类方法是特征选择研究领域的热点, 相关文献也很多. 例如, Hsu 等人[45] 用决策树来进行特征选择, 采用遗传算法来寻找使得决策树分类错误率最小的一组特征子集. Chiang 等人[46] 将Fisher 判别分析与遗传算法相结合, 用来在化工故障过程中辨识关键变量, 取得了不错的效果. Guyon 等人[47] 使用支持向量机的分类性能衡量特征的重要性程度, 并最终构造一个分类性能较高的分类器. Krzysztof [48] 提出了一种基于相互关系的双重策略的Wrapper 特征选择方法. 叶吉祥等人[49] 提出了一种快速的Wrapper 特征选择方法FFSR(fast feature subset ranking), 以特征子集作为评价单位, 以子集收敛能力作为评价标准. 戴平等人[50] 利用SVM 线性核与多项式核函数的特性, 结合二进制PSO 方法, 提出了一种基于SVM 的快速特征选择方法.综上所述, Filter 和Wrapper 特征选择方法各有优缺点. 将启发式搜索策略和分类器性能评价准则相结合来评价所选的特征, 相对于使用随机搜索策略的方法, 节约了不少时间. Filter 和Wrapper 是两种(8)= arg max (), s.t.∣∣⩽.⊆F其中: 为所选特征个数的上限, 为特征集合,为已选特征的集合, () 为评价准则. 从式(8) 中可知需要解决两个问题: 一是评价准则() 的选择; 二是算法的选择. 文献[39-40] 是HSIC 准则的具体应用.4.1.4 一致性度量给定两个样本, 若他们特征值均相同, 但所属类别不同, 则称它们是不一致的; 否则, 是一致的. 一致姚 旭 等: 特征选择方法综述第2 期 165互补的模式, 两者可以结合. 混合特征选择过程一般 由两个阶段组成, 首先使用 Filter 方法初步剔除大部 分无关或噪声特征, 只保留少量特征, 从而有效地减 小后续搜索过程的规模. 第 2 阶段将剩余的特征连 同样本数据作为输入参数传递给 Wrapper 选择方法, 以进一步优化选择重要的特征. 例如, 文献 [51] 采用 混合模型选择特征子集, 先使用互信息度量标准和 bootstrap 技术获取前 k 个重要的特征, 然后再使用支 持向量机构造分类器.292.Manoranjan Dash, Huan Liu. Feature selection forclassification[J]. Intelligent Data Analysis, 1997, 1(3): 131-156.Lei Y u, Huan Liu. Efficient feature selection via analysisof relevance and redundancy[J]. J of Machine Learnin gResearch, 2004, 5(1): 1205-1224.Liu H, Motoda H. Feature selection for knowledgediscovery and data mining[M]. Boston: Kluwer AcademicPublishers, 1998.Molina L C, Llu´ıs Belanche, A` ngela Nebot. Feature [5] [6] [7] 结论5 [8] 本文首先分析了特征选择的框架, 然后从两个角度对特征选择方法进行分类: 一个是搜索策略, 一个 是评价准则. 特征选择方法从研究之初到现在, 已经 有了很多成熟的方法, 但是, 研究过程中也存在很多 问题. 例如: 如何解决高维特征选择问题; 如何设计小 样本问题的特征选择方法; 如何针对不同问题设计特 定的特征选择方法; 研究针对新数据类型的特征选 择方法等. 影响特征选择方法的因素主要有数据类 型、样本数量. 针对两类还是多类问题, 特征选择方 法的选择也有不同. 例如 Koll-Saha [4] 和 Focus 等人[41] 受限于连续型特征; 分支定界, BFF [16] 和 MDLM(min description length method)[52] 等 不 支 持 布 尔 型 特 征;Relief 系 列 算 法, DTM(decision tree method)[53]和 PRESET [54] 都适合于大数据集; Focus 等人[41] 适用于 小样本; 在度量标准的选择中, 只有一致性度量仅适 用于离散型数据等等.尽管特征选择方法已经有很多, 但针对解决实 际问题的方法还存在很多不足, 如何针对特定问题 给出有效的方法仍是一个需要进一步解决的问题. 将 Filter 方法和 Wrapper 方法两者结合, 根据特定的环境 选择所需要的度量准则和分类器是一个值得研究的 方向.selection algorithms: A survey and experimentalevaluation[R]. Barcelona:Catalunya, 2002.Universitat Politecnicade[9] Sun Z H, George Bebis, Ronald Miller. Object detectionusing feature subset selection[J]. Pattern Recognition, 2004, 37(11): 2165-2176.Narendra P M, Fukunaga K. A branch and bound algorithmfor feature selection[J]. IEEE Trans on Computers, 1977, 26(9): 917-922.Tsymbal A, Seppo P, David W P. Ensemble featureselection with the simple Bayesian classification[J].Information Fusion, 2003, 4(2): 87-100.Wu B L, Tom A, David F, et al. Comparison of statisticalmethods for classification of ovarian cancer using massspectrometry data[J]. Bioinformatics, 2003, 19(13): 1636- 1643.Furlanello C, Serafini M, Merler S, et al. An acceleratedprocedure for recursive feature ranking on microarraydata[J]. Neural Networks, 2003, 16(4): 641-648.Langley P. Selection of relevant features in machinelearning[C]. Proc of the AAAI Fall Symposium on Relevance. New Orleans, 1994: 1-5. [10] [11] [12] [13] [14] [15] Kononenko I. Estimation attributes:Analysis andextensions of RELIEF[C]. Proc of the 1994 European Conf on Machine Learning. New Brunswick, 1994: 171-182.Xu L, Y an P, Chang T. Best first strategy for featureselection[C]. Proc of 9th Int Conf on Pattern Recognition.Rome, 1988: 706-708.蔡哲元, 余建国, 李先鹏, 等. 基于核空间距离测度的特征选择[J]. 模式识别与人工智能, 2010, 23(2): 235-240.(Cai Z Y , Y u J G, Li X P, et al. Feature selection algorithm based on kernel distance measure[J]. Pattern Recognition and Artificial Intelligence, 2010, 23(2): 235-240.) 徐燕, 李锦涛, 王斌, 等. 基于区分类别能力的高性能特 征选择方法[J]. 软件学报, 2008, 19(1): 82-89.(Xu Y , Li J T, Wang B, et al. A category resolve power- based feature selection method[J]. J of Software, 2008, 19(1): 82-89.)参考文献(References )边肇祺, 张学工. 模式识别[M]. 第 2 版. 北京: 清华大学出版社, 2000.(Bian Z Q, Zhang X G. Pattern recognition[M]. 2nd ed. Beijing: Tsinghua University Publisher, 2000.)Kira K, Rendell L A . The feature selection problem:Traditional methods and a new algorithm[C]. Proc of the9th National Conf on Artificial Intelligence. Menlo Park, 1992: 129-134.John G H, Kohavi R, Pfleger K. Irrelevant features and thesubset selection problem[C]. Proc of the 11th Int Conf onMachine Learning. New Brunswick, 1994: 121-129. Koller D, Sahami M. Toward optimal feature selection[C].Proc of Int Conf on Machine Learning. Bari, 1996: 284-[1] [16] [17] [2] [3] [18][4]刘华文. 基于信息熵的特征选择算法研究[D]. 长春: 吉林大学, 2010.(Liu Hua-wen. A study on feature selection algorithm using 孟洋, 赵方. 基于信息熵理论的动态规划特征选取算法[J]. 计算机工程与设计, 2010, 31(17): 3879-3881.(Meng Y , Zhao F. Feature selection algorithm based on dynamic programming and comentropy[J]. Computer Engineering and Design, 2010, 31(17): 3879-3881.) Forman G. An extensive empirical study of feature selection metrics for text classification[J]. J of MachineLearning Research, 2003, 3(11): 1289-1305.Liu H, Liu L, Zhang H. Feature selection using mutualinformation: An experimental study[C]. Proc of the 10thPacific Rim Int Conf on Artificial Intelligence. Las V egas, 2008: 235-246.Hua J, Waibhav D T, Edward R D. Performance of feature-selection methods in the classification of high-dimensiondata[J]. Pattern Recognition, 2009, 42(7): 409-424.Mitra P, Murthy C A, Sankar K P. Unsupervised featureselection using feature similarity[J]. IEEE Trans on PatternAnalysis and Machine Intelligence, 2002, 24(3): 301-312.Wei H-L, Billings S A. Feature subset selection and rankin gfor data dim ensionality reduction[J]. IEEE Trans on PatternAnalysis and Machine Intelligence, 2007, 29(1): 162-166.Hall M A. Correlation-based feature subset selection formachine learning[M]. Hamilton: University of Waikato,1999.Zhang D, Chen S, Zhou Z-H. Constraint score: A new filtermethod for feature selection with pairwise constraints[J].Pattern Recognition, 2008, 41(5): 1440-1451.Le Song, Alex Smola, Arthur Gretton, et al. Supervisedfeature selection via dependence estimation[C]. Proc of the24th Int Conf on Machine Learning. Corvallis, 2007: 245- 252.Gustavo Camps-V alls, Joris Mooij, Bernhard Scholkopf.Remote sensing feature selection by kernel dependencemeasures[J]. IEEE Geoscience and Remote Sensin gLetters, 2010, 7(3): 587-591.Almuallim H, Dietterich T G. Learning with manyirrelevant features[C]. Proc of 9th National Conf onArtificial Intelligence. Menlo Park, 1992: 547-552.Liu H, Setiono R. A probabilistic approach to featureselection –A filter solution[C]. Proc of Int Conf on MachineLearning. Bari, 1996: 319-327.Manoranjan Dash, Huan Liu. Consistency-based search infeature selection[J]. Artificial Intelligence, 2003, 151(16):155-176.Huan Liu, Hiroshi Motoda, Manoranjan Dash. Amonotonic measure for optimal feature selection[M].Machine Learning: ECML-98, Lecture Notes in ComputerScience, 1998: 101-106.(下转第192页)[19] [31] information entropy[D]. Changchun: 2010.)Jain A K, Robert P W, Mao J C. Jilin University, [20] Statistical pattern[32] recognition: A review[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2000, 22(1): 4-37.Battiti R. Using mutual information for selecting featuresin supervised neural net learning[J]. IEEE Trans on Neural Networks, 1994, 5(4): 537-550.Hanchuan Peng, Fuhui Long, Chris Ding. Feature selectionbased on mutual information: Criteria of max-dependency, max-relevance, and min-redundancy[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2005, 27(8): 1226-1238.Ding C, Peng H. Minimum redundancy feature selectionfrom microarray gene expression data[J]. J of Bioinformatics and Computational Biology, 2005, 3(2): 185-205.Francois Fleuret. Fast binary feature selection withconditional mutual information[J]. J of Machine Learnin g Research, 2004, 5(10): 1531-1555.Kwak N, Choi C-H. Input feature selection by mutualinformation based on Parzen window[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2002, 24(12): 1667-1671.Novovicova J, Petr S, Michal H, et al. Conditional mutualinformation based feature selection for classification task[C]. Proc of the 12th Iberoamericann Congress on Pattern Recognition. V alparaiso, 2007: 417-426.Qu G, Hariri S, Y ousif M. A new dependency andcorrelation analysis for features[J]. IEEE Trans onKnowledge and Data Engineering, 2005, 17(9): 1199- 1207.赵军阳, 张志利. 基于模糊粗糙集信息熵的蚁群特征选择方法[J]. 计算机应用, 2009, 29(1): 109-111.(Zhao J Y , Zhang Z L. Ant colony feature selection based on fuzzy rough set information entropy[J]. J of Computer Applications, 2009, 29(1): 109-111.)赵军阳, 张志利. 基于最大互信息最大相关熵的特征选 择方法[J]. 计算机应用研究, 2009, 26(1): 233-235.(Zhao J Y , Zhang Z L. Feature subset selection based on maxmutual information and max correlation entropy[J]. Application Research of Computers, 2009, 26(1): 233- 235.)渠小洁. 一种基于条件熵的特征选择算法[J]. 太原科技大学学报, 2010, 31(5): 413-416.(Qu X J. An algorithm of feature selection based on conditional entropy[J]. J of Taiyuan University of Science and Technology, 2010, 31(5): 413-416.)[21] [33] [22] [34] [35] [23] [36] [24] [37] [25] [38] [26] [39] [27] [40] [28] [41] [42] [29] [43] [44] [30]。

数学建模方法详解三种最常用算法

数学建模方法详解--三种最常用算法一、层次分析法层次分析法[1] (analytic hierarchy process,AHP)是美国著名的运筹学家T.L.Saaty教授于20世纪70年代初首先提出的一种定性与定量分析相结合的多准则决策方法[2,3,4].该方法是社会、经济系统决策的有效工具,目前在工程计划、资源分配、方案排序、政策制定、冲突问题、性能评价等方面都有广泛的应用.(一) 层次分析法的基本原理层次分析法的核心问题是排序,包括递阶层次结构原理、测度原理和排序原理[5].下面分别予以介绍.1.递阶层次结构原理一个复杂的结构问题可以分解为它的组成部分或因素,即目标、准则、方案等.每一个因素称为元素.按照属性的不同把这些元素分组形成互不相交的层次,上一层的元素对相邻的下一层的全部或部分元素起支配作用,形成按层次自上而下的逐层支配关系.具有这种性质的层次称为递阶层次.2.测度原理决策就是要从一组已知的方案中选择理想方案,而理想方案一般是在一定的准则下通过使效用函数极大化而产生的.然而对于社会、经济系统的决策模型来说,常常难以定量测度.因此,层次分析法的核心是决策模型中各因素的测度化.3.排序原理层次分析法的排序问题,实质上是一组元素两两比较其重要性,计算元素相对重要性的测度问题. (二) 层次分析法的基本步骤层次分析法的基本思路与人对一个复杂的决策问题的思维、判断过程大体上是一致的[1]. 1. 成对比较矩阵和权向量为了能够尽可能地减少性质不同的诸因素相互比较的困难,提高结果的准确度.T .L .Saaty 等人的作法,一是不把所有因素放在一起比较,而是两两相互对比,二是对比时采用相对尺度.假设要比较某一层n 个因素n C C ,,1 对上层一个因素O 的影响,每次取两个因素i C 和j C ,用ij a 表示i C 和j C 对O 的影响之比,全部比较结果可用成对比较阵1,0,ij ij ji n nijA a a a a表示,A 称为正互反矩阵. 一般地,如果一个正互反阵A 满足:,ij jk ik a a a ,,1,2,,i j k n L (1)则A 称为一致性矩阵,简称一致阵.容易证明n 阶一致阵A 有下列性质: ①A 的秩为1,A 的唯一非零特征根为n ;②A 的任一列向量都是对应于特征根n 的特征向量.如果得到的成对比较阵是一致阵,自然应取对应于特征根n 的、归一化的特征向量(即分量之和为1)表示诸因素n C C ,,1 对上层因素O 的权重,这个向量称为权向量.如果成对比较阵A 不是一致阵,但在不一致的容许范围内,用对应于A 最大特征根(记作 )的特征向量(归一化后)作为权向量w ,即w 满足:Aw w (2)直观地看,因为矩阵A 的特征根和特征向量连续地依赖于矩阵的元素ij a ,所以当ij a 离一致性的要求不远时,A 的特征根和特征向量也与一致阵的相差不大.(2)式表示的方法称为由成对比较阵求权向量的特征根法.2. 比较尺度当比较两个可能具有不同性质的因素i C 和j C 对于一个上层因素O 的影响时,采用Saaty 等人提出的91 尺度,即ij a 的取值范围是9,,2,1 及其互反数91,,21,1 .3. 一致性检验成对比较阵通常不是一致阵,但是为了能用它的对应于特征根 的特征向量作为被比较因素的权向量,其不一致程度应在容许范围内.若已经给出n 阶一致阵的特征根是n ,则n 阶正互反阵A 的最大特征根n ,而当n 时A 是一致阵.所以 比n 大得越多,A 的不一致程度越严重,用特征向量作为权向量引起的判断误差越大.因而可以用n 数值的大小衡量A 的不一致程度.Saaty 将1nCI n(3)定义为一致性指标.0CI 时A 为一致阵;CI 越大A 的不一致程度越严重.注意到A 的n 个特征根之和恰好等于n ,所以CI 相当于除 外其余1n 个特征根的平均值.为了确定A 的不一致程度的容许范围,需要找到衡量A 的一致性指标CI 的标准,又引入所谓随机一致性指标RI ,计算RI 的过程是:对于固定的n ,随机地构造正互反阵A ,然后计算A 的一致性指标CI .表1 随机一致性指标RI 的数值表中1,2n 时0RI ,是因为2,1阶的正互反阵总是一致阵.对于3n 的成对比较阵A ,将它的一致性指标CI 与同阶(指n 相同)的随机一致性指标RI 之比称为一致性比率CR ,当0.1CICR RI(4) 时认为A 的不一致程度在容许范围之内,可用其特征向量作为权向量.对于A 利用(3),(4)式和表1进行检验称为一致性检验.当检验不通过时,要重新进行成对比较,或对已有的A 进行修正. 4. 组合权向量由各准则对目标的权向量和各方案对每一准则的权向量,计算各方案对目标的权向量,称为组合权向量.一般地,若共有s 层,则第k 层对第一层(设只有1个因素)的组合权向量满足:1,3,4,kkk w W w k s L (5)其中 kW 是以第k 层对第1k 层的权向量为列向量组成的矩阵.于是最下层对最上层的组合权向量为:132s s s w W W W w L (6)5. 组合一致性检验在应用层次分析法作重大决策时,除了对每个成对比较阵进行一致性检验外,还常要进行所谓组合一致性检验,以确定组合权向量是否可以作为最终的决策依据.组合一致性检验可逐层进行.如第p 层的一致性指标为p n p CI CI ,,1 (n 是第1 p 层因素的数目),随机一致性指标为1,,p p nRI RI L ,定义11,,P p p p n CI CI CI w L 11,,p p p p n RI RI RI wL 则第p 层的组合一致性比率为:,3,4,,p p p CI CRp s RIL (7) 第p 层通过组合一致性检验的条件为 0.1pCR .定义最下层(第s 层)对第一层的组合一致性比率为:2*sP p CR CR (8)对于重大项目,仅当*CR 适当地小时,才认为整个层次的比较判断通过一致性检验.层次分析法的基本步骤归纳如下:(1) 建立层次结构模型 在深入分析实际问题的基础上,将有关的各个因素按照不同属性自上而下地分解成若干层次.同一层的诸因素从属于上一层的因素或对上层因素有影响,同时又支配下一层的因素或受到下层因素的作用,而同一层的各因素之间尽量相互独立.最上层为目标层,通常只有1个因素,最下层通常为方案或对象层,中间可以有1个或几个层次,通常称为准则或指标层,当准则过多时(比如多于9个)应进一步分解出子准则层.(2) 构造成对比较阵从层次结构模型的第2层开始,对于从属于上一层每个因素的同一层诸因素,用成对比较法和91 比较尺度构造成对比较阵,直到最下层.(3)计算权向量并做一致性检验对于每一个成对比较阵计算最大特征根及对应特征向量,利用一致性指标,随机一致性指标和一致性比率做一致性检验.若检验通过,特征向量(归一化后)即为权向量;若不通过,重新构造成对比较阵.(4)计算组合权向量并做组合一致性检验利用公式计算最下层对目标的组合权向量,并酌情作组合一致性检验.若检验通过,则可按照组合权向量表示的结果进行决策,否则需重新考虑模型或重新构造那些一致性比率CR较大的成对比较阵.(三) 层次分析法的优点1.系统性层次分析把研究对象作为一个系统,按照分解、比较判断、综合的思维方式进行决策,成为继机理分析、统计分析之后发展起来的系统分析的重要工具.2.实用性层次分析把定性和定量方法结合起来,能处理许多用传统的最优化技术无法着手的实际问题,应用范围很广.同时,这种方法将决策者与决策分析者相互沟通,决策者甚至可以直接应用它,这就增加了决策的有效性.3.简洁性具有中等文化程度的人即可了解层次分析的基本原理和掌握它的基本步骤,计算也非常简便,且所得结果简单明确,容易为决策者了解和掌握.(四) 层次分析法的局限性层次分析法的局限性可以用囿旧、粗略、主观等词来概括.第一,它只能从原有的方案中选优,不能生成新方案;第二,它的比较、判断直到结果都是粗糙的,不适于精度要求很高的问题;第三,从建立层次结构模型到给出成对比较矩阵,人的主观因素的作用很大,这就使得决策结果可能难以为众人接受.当然,采取专家群体判断的方法是克服这个缺点的一种途径. (五) 层次分析法的若干问题层次分析法问世以来不仅得到广泛的应用而且在理论体系、计算方法等方面都有很大发展,下面从应用的角度讨论几个问题. 1. 正互反阵最大特征根和对应特征向量的性质成对比较阵是正互反阵.层次分析法中用对应它的最大特征根的特征向量作为权向量,用最大特征根定义一致性指标进行一致性检验.这里人们碰到的问题是:正互反阵是否存在正的最大特征根和正的特征向量;一致性指标的大小是否反映它接近一致阵的程度,特别,当一致性指标为零时,它是否就为一致阵.下面两个定理可以回答这些问题. 定理1 对于正矩阵A (A 的所有元素为正数) 1)A 的最大特征根是正单根 ;2) 对应正特征向量w ( 的所有分量为正数);3)w IA I I A k k k lim ,其中1,1,1 I ,w 是对应 的归一化特征向量.定理2 n 阶正互反阵A 的最大特征根n ;当n 时A 是一致阵.定理2和前面所述的一致阵的性质表明,n 阶正互反阵A 是一致阵的充要条件为 A 的最大特征根n .2. 正互反阵最大特征根和特征向量的实用算法众所周知,用定义计算矩阵的特征根和特征向量是相当困难的,特别是矩阵阶数较高时.另一方面,因为成对比较阵是通过定性比较得到的比较粗糙的量化结果,对它精确计算是不必要的,下面介绍几种简单的方法. (1) 幂法 步骤如下:a .任取n 维归一化初始向量 0wb .计算1,0,1,2,k k wAw k %L c .1k w%归一化,即令ni k ik k ww1111~~d .对于预先给定的精度 ,当 1||1,2,,k k i i i n L 时,1k w 即为所求的特征向量;否则返回be. 计算最大特征根 111k n ik i in %这是求最大特征根对应特征向量的迭代法, 0w 可任选或取下面方法得到的结果.(2) 和法 步骤如下:a. 将A 的每一列向量归一化得1nij ij iji a a%b .对ij %按行求和得1ni ij j %%c .将i %归一化 *121,,,ni ini w%%L 即为近似特征向量.d. 计算 11n ii iAw n ,作为最大特征根的近似值.这个方法实际上是将A 的列向量归一化后取平均值,作为A 的特征向量.(3) 根法 步骤与和法基本相同,只是将步骤b 改为对ij %按行求积并开n 次方,即11nn iij j%%.根法是将和法中求列向量的算术平均值改为求几何平均值.3. 为什么用成对比较阵的特征向量作为权向量当成对比较阵A 是一致阵时,ij a 与权向量n w ,,1 的关系满iij ja,那么当A 不是一致阵时,权向量w 的选择应使得ij a 与ij相差尽量小.这样,如果从拟合的角度看确定w 可以化为如下的最小二乘问题: 21,,11min i nniij i n i j j aL (9) 由(9)式得到的最小二乘权向量一般与特征根法得到的不同.因为(9)式将导致求解关于i 的非线性方程组,计算复杂,且不能保证得到全局最优解,没有实用价值.如果改为对数最小二乘问题:21,,11min ln ln i nni ij i n i j j aL (10)则化为求解关于ln i 的线性方程组.可以验证,如此解得的i 恰是前面根法计算的结果.特征根法解决这个问题的途径可通过对定理2的证明看出. 4. 成对比较阵残缺时的处理专家或有关学者由于某种原因无法或不愿对某两个因素给出相互比较的结果,于是成对比较阵出现残缺.应如何修正,以便继续进行权向量的计算呢?一般地,由残缺阵 ij A a 构造修正阵 ijA a %%的方法是令,,0,,1,ij ij ij ij i i a a i j a a i jm m i i j%为第行的个数, (11)表示残缺.已经证明,可以接受的残缺阵A 的充分必要条件是A 为不可约矩阵.(六) 层次分析法的广泛应用层次分析法在正式提出来之后,由于它在处理复杂的决策问题上的实用性和有效性,很快就在世界范围内得到普遍的重视和广泛的应用.从处理问题的类型看,主要是决策、评价、分析、预测等方面. 这个方法在20世纪80年代初引入我国,很快为广大的应用数学工作者和有关领域的技术人员所接受,得到了成功的应用.层次分析法在求解某些优化问题中的应用[5]举例 假设某人在制定食谱时有三类食品可供选择:肉、面包、蔬菜.这三类食品所含的营养成分及单价如表所示表2 肉、面包、蔬菜三类食品所含的营养成分及单价该人体重为55kg维生素A 7500国际单位 (IU)维生素B 1.6338mg热量 R 8548.5kJ考虑应如何制定食谱可使在保证营养需求的前提下支出最小?用层次分析法求解最优化问题可以引入包括偏好等这类因素.具体的求解过程如下:①建立层次结构② 根据偏好建立如下两两比较判断矩阵表3 比较判断矩阵max 2 ,10CI ,100.1CR ,主特征向量0.75,0.25W 故第二层元素排序总权重为 10.75,0.25W表4 比较判断矩阵111max 1113,0,0,0.58CI CR RI ,主特征向量0.4,0.4,0.2W故相对权重 210.4,0.4,0.2,0P③ 第三层组合一致性检验问题因为 2111211112120;0.435CI CI CI W RI RI RI W ,212200.1CR CR CI RI故第三层所有判断矩阵通过一致性检验,从而得到第三层元素维生素A 、维生素B 、热量Q 及支出E 的总权重为:221221120.3,0.3,0.15,0.25W P W P P W求第四层元素关于总目标W 的排序权重向量时,用到第三层与第四层元素的排序关系矩阵,可以用原始的营养成分及单价的数据得到.注意到单价对人们来说希望最小,因此应取各单价的倒数,然后归一化.其他营养成分的数据直接进行归一化计算,可得表5表5 各营养成分数据的归一化则最终的第四层各元素的综合权重向量为:3320.2376,0.2293,0.5331W P W ,结果表明,按这个人的偏好,肉、面包和蔬菜的比例取0.2376:0.2293:0.5331较为合适.引入参数变量,令10.2376x k ,20.2293x k ,30.5331x k ,代入 1LP123min 0.02750.0060.007f x x x131231231230.352725.075000.00210.00060.002 1.6338..(1)11.930011.5100 1.048548.5,,,0x x x x x s t LP x x x x x x则得k f 0116.0min13.411375000.0017 1.6338..26.02828548.50k k s t LP k k容易求得1418.1k ,故得最优解 *336.9350,325.1650,755.9767x;最优值 *16.4497f ,即肉336.94g ,面325.17g ,蔬菜755.98g ,每日的食品费用为16.45元.总之,对含有主、客观因素以及要求与期望是模糊的优化问题,用层次分析法来处理比较适用.二、模糊数学法模糊数学是1965年美国控制论专家L.A.Zadeh创立的.模糊数学作为一门新兴学科,它已初步应用于模糊控制、模糊识别、模糊聚类分析、模糊决策、模糊评判等各方面.在气象、结构力学、控制、心理学方面已有具体的研究成果.(一) 模糊数学的研究内容第一,研究模糊数学的理论,以及它和精确数学、随机数学的关系;第二,研究模糊语言和模糊逻辑,并能作出正确的识别和判断;第三,研究模糊数学的应用.(二) 模糊数学在数学建模中应用的可行性1.数学建模的意义在于将数学理论应用于实际问题[6].而模糊数学作为一种新的理论,本身就有其巨大的应用背景,国内外每年都有大量的相关论文发表,解决了许多实际问题.目前在数学建模中较少运用模糊数学方法的原因不在于模糊数学理论本身有问题,而在于最新的研究成果没有在第一时间进入数学建模的教科书中,就其理论本身所具有的实用性的特点而言,模糊数学应该有助于我们解决建模过程中的实际问题.2.数学建模的要求是模型与实际问题尽可能相符.对实际问题有这样一种分类方式:白色问题、灰色问题和黑色问题.毫无疑问,引进新的方法对解决这些问题大有裨益.在灰色问题和黑色问题中有很多现象是用“模糊”的自然语言描述的.在这种情况下,用模糊的模型也许更符合实际.3.数学建模活动的目的之一是培养学生的创新精神.用新理论、新方法解题应该受到鼓励.近年来,用神经网络法、层次分析法等新方法建立模型的论文屡有获奖,这也说明了评审者对新方法的重视.我们相信,模糊数学方法应该很好,同样能够写出优秀的论文.(三) 模糊综合评判法中的最大隶属原则有效度在模糊统计综合评判中,如何利用综合评判结果向量12,,,m b b b b L ,其中, 01j b ,m为可能出现的评语个数,提供的信息对被评判对象作出所属等级的判断,目前通用的判别原则是最大隶属原则[7].在实际应用中很少有人注意到最大隶属原则的有效性问题,在模糊综合评判的实例中最大隶属原则无一例外地被到处搬用,然而这个原则并不是普遍适用的.最大隶属原则有效度的测量1. 有效度指标的导出在模糊综合评判中,当11max 1,1njj j nj bb 时,最大隶属原则最有效;而在 1max 01,jj nbc c 1n j j b nc 时,最大隶属原则完全失效,且1max jj nb 越大(相对于1njj b 而言),最大隶属原则也越有效.由此可认为,最大隶属原则的有效性与1max jj nb 在1njj b 中的比重有关,于是令:11max njjj nj b b (12)显然,当11max 1,1njj j nj bb 时,则1 为 的最大值,当 1max 01jj nb c c ,1njj bnc时,有1n 为 的最小值,即得到 的取值范围为:11n .由于在最大隶属原则完全失效时,1n 而不为0,所以不宜直接用 值来判断最大隶属原则的有效性.为此设:11111n n n n(13)则 可在某种程度上测定最大隶属原则的有效性.而最大隶属原则的有效性还与j nj b 1sec (jnj b 1sec 的含义是向量b 各分量中第二大的分量)的大小有很大关系,于是我们定义:11sec njjj nj b b(14)可见: 当 1,1,0,0,,0b L 时, 取得最大值12.当 0,1,0,0,,0b L 时, 取得最小值0.即 的取值范围为012 ,设 02120.一般地, 值越大最大隶属原则有效程度越高;而 值越大,最大隶属原则的有效程度越低.因此,可以定义测量最大隶属原则有效度的相对指标:112121n n n n(15) 使用 指标能更准确地表明实施最大隶属原则的有效性.2. 指标的使用从 指标的计算公式看出 与 成反比,与 成正比.由 与 的取值范围,可以讨论 的取值范围: 当 取最大值, 取最小值时, 将取得最小值0;当 取最小值, 取最大值时, 将取得最大值:因为 0lim ,所以可定义0 时, .即:0 .由以上讨论,可得如下结论:当 时,可认定施行最大隶属原则完全有效;当1 时,可认为施行最大隶属原则非常有效;当0.51 时,可认为施行最大隶属原则比较有效,其有效程度即为 值;当00.5 时可认为施行最大隶属原则是最低效的;而当0 时,可认定施行最大隶属原则完全无效.有了测量最大隶属原则有效度的指标,不仅可以判断所得可否用最大隶属原则确定所属等级,而且可以说明施行最大隶属原则判断后的相对置信程度,即有多大把握认定被评对象属于某个等级. 讨论a . 在很多情况下,可根据 值的大小来直接判断使用最大隶属原则的有效性而不必计算 值.根据 与 之间的关系,当0.7 ,且4n 时,一定存在1 .通常评价等级数取4和9之间,所以4n 这一条件往往可以忽略,只要0.7 就可免算 值,直接认定此时采取最大隶属原则确定被评对象的等级是很有效的.b . 如果对 12,,,m b b b b L 进行归一化处理而得到b ,则可直接根据b 进行最大隶属原则的有效度测量. (四) 模糊数学在数学建模中的应用模糊数学有诸多分支,应用广泛.如模糊规划、模糊优化设计、综合评判、模糊聚类分析、模糊排序、模糊层次分析等等.这些方法在工业、军事、管理等诸多领域被广泛应用. 举例 带模糊约束的最小费用流问题[8]问题的提出 最小费用流问题的一般提法是:设 ,,,D V A c 是一个带出发点s v 和收点t v 的容量-费用网络,对于任意,ijv v A ,ijc表示弧 ,i j v v 上的容量,ij 表示弧 ,i j v v 上通过单位流量的费用,0v 是给定的非负数,问怎样制定运输方案使得从s v 到t v 恰好运输流值为0v 的流且总费用最小?如果希望尽可能地节省时间并提高道路的通畅程度,问运输方案应当怎样制定?模型和解法 问题可以归结为:怎样制定满足以下三个条件的最优运输方案?(1)从s v 到t v 运送的流的值恰好为0v ;(2)总运输费用最小;(3)在容量ij c 大的弧 ,i j v v 上适当多运输.如果仅考虑条件(1)和(2),易写出其数学模型为:,0,,0,,,,min()..0,0i j s j j s t j j t i j j i ij ijv v Asj js v v A v v A tj jt v v Av v A ij ji i s t v v A v v A ij ijf f f v f f v M s t f f v V v v f c把条件(3)中的“容量大” 看作A 上的一个模糊子集A %,定义其隶属函数 : 0,1A 为: 00,0,1,ij ij ij i j A d c c v ij c c v v e c c%其中 1,i j ij v v c A cg (平均容量)21,21,0,1lg 1i j i j ij v v A ij v v A A c c d A c cg g建立ij 是为了量化“适当多运输”这一模糊概念.对条件(2)作如下处理:对容量ij c 大的弧 ,i j v v ,人为地降低运价ij ,形成“虚拟运价”ij ,其中ij 满足:ij c 越大,相应的ij 的调整幅度也越大.选取ij 为 1kij ij ij , ,i j v v A .其中k 是正参数,它反映了条件(2)和条件(3)在决策者心目中的地位.决策者越看重条件(3),k 取值越小;当k 取值足够大时,便可忽略条件(3) .一般情况下,合适的k 值最好通过使用一定数量的实际数据进行模拟、检验和判断来决定.最后,用ij 代替原模型M 中的ij ,得到一个新的模型M .用现有的方法求解这个新的规划问题,可期望得到满足条件(3)的解.模型的评价 此模型在原有的数学规划模型和解法的基础上,增加了模糊约束.新模型比较符合实际,它的解包含了原模型的解,因而它是一个较为理想的模型.隶属度的确定在模糊数学中有多种方法,可以根据不同的实际问题进行调整.同样的思想方法可以处理其他的模糊约束问题.三、灰色系统客观世界的很多实际问题,其内部结构、参数以及特征并未全部被人们了解,对部分信息已知而部分信息未知的系统,我们称之为灰色系统.灰色系统理论是从系统的角度出发来研究信息间的关系,即研究如何利用已知信息去揭示未知信息.灰色系统理论包括系统建模、系统预测、系统分析等方面.(一)灰色关联分析理论及方法灰色系统理论[9]中的灰色关联分析法是在不完全的信息中,对所要分析研究的各因素,通过一定的数据,在随机的因素序列间,找出它们的关联性,找到主要特性和主要影响因素.计算方法与步骤:1.原始数据初值化变换处理分别用时间序列 k 的第一个数据去除后面的原始数据,得出新的倍数列,即初始化数列,量纲为一,各值均大于零,且数列有共同的起点.2. 求关联系数0000min min ||max max ||||max max ||k i k k i k ik i ki k k i k k i k ikx x x x x x x x3. 取分辨系数 01 4. 求关联度11ni ki k k r n(二) 灰色预测1.灰色预测方法的特点(1)灰色预测需要的原始数据少,最少只需四个数据即可建模;(2)灰色模型计算方法简单,适用于计算机程序运行,可作实时预测;(3) 灰色预测一般不需要多因素数据,而只需要预测对象本身的单因素数据,它可以通过数据本身的生成,寻找系统内在的规律;(4) 灰色预测既可做短期预测,也可做长期预测,实践证明,灰色预测精度较高,误差较小.2. 灰色预测GM(1,1)模型的一点改进一些学者为了提高预测精度做出了大量的研究工作,提出了相应的方法.本文将在改善原始离散序列光滑性的基础上,进一步研究GM(1,1)预测模型的理论缺陷及改进方法[10].问题的存在及改进方法如下:传统灰色预测GM(1,1)模型的一般步骤为: (1)1-ADO :对原始数据序列0k x 1,2,,k n L 进行一次累加生成序列 101kk i i x x1,2,,k n L(2)对0x 数列进行光滑性检验:00,k ,当0k k 时:0011101k k k k ii x x x x文献[11]进一步指出只要0101k k ii x x 为k 的递减函数即可.(3)对1x 作紧邻生成: 1111*1*,2,3,,k k k Z x x k n L一般取0.5b ax dtdx 11 (16)为灰色微分方程 01k k x aZ b 的白化方程. (4)按最小二乘法计算参数,a b(5)解(16)式并进行离散化得模拟序列1x 和0x 的计算公式: 1101exp k x x b a ak b a ,其中0,1,2,,k n L01111011exp *exp k k k x x x a x b a ak ,其中1,2,k L并假定 111101x x x文献[12,13]指出:假定 111101x x x 的理由是不充分的,文献[14]认为应当以最后一个 1n x 为已知条件来确定微分方程中常数项m c 的值,理由是最后一个数据是最新的,最能反映实际情况.同时文献[15]又进一步提出常数m c 的确定,由于数据序列中。

用于语音质量客观评价的Mel谱失真测度

用于语音质量客观评价的Mel谱失真测度陈华伟1,张知易2,靳蕃1(1.西南交通大学信息科学与技术学院,四川成都 610031;2.中国电子科技集团公司第三十研究所,四川成都 610041)摘要:为了有效进行语音质量客观评判,对以MFSC为特点参数的Mel-SD和以MFCC为特点参数的Mel-CD进行对比分析,研究了特点提取中滤波器构造变化对两种测度的阻碍,并对Mel-SD中压缩因子的阻碍加以研究。

测试研究说明,Mel-SD性能好于Mel-CD,同时具有对滤波器组构造变化的鲁棒性;Mel-CD对滤波器构造变化比较敏锐,在滤波器数目超过13后随着滤波器数目的增加性能下降。

Mel-SD在给定的滤波器数目的情形下,有最正确的压缩因子。

当在一定的范畴内,压缩因子的阻碍并不严峻。

最正确压缩因子差不多符合对心理声学静态测量实验结论的近似表达。

将参数优化的Mel-CD和Mel-SD用于干扰条件下通信系统的语音质量的客观评判,结果说明,Mel-SD性能优于Mel-CD和PESQ,Mel-CD性能那么与PESQ相当。

关键词:语音质量;客观评判;美尔谱系数;Mel谱失真测度;Mel倒谱系数失真测度中图分类号:TN912.3文献标识码:AAnalysis on Performance of Objective Speech Quality Measures in MelDomainCHEN Hua-wei1, ZHANG Zhi-yi2,JIN Fan1(1. School of Information Science & Technology, Southwest Jiaotong University, Sichuan Chengdu, 610031; 2.No.30 Institute of CETC, Sichuan Chengdu , 610041)Abstract:To evaluate speech quality effectively and exactly, Mel-SD and Mel-CD are compared and analyzed, especially on feature extraction. The effects of the structure of Mel filter bank on both measures are investigated. The result shows that Mel-SD performance better than Mel-CD, while retaining robust on variety of Mel filter bank .Mel-CD is sensitive to structure of Mel filter bank, and decreases its performance when the size of bank is increased. Based on optimal size of bank, Mel-SD was tested by different compression factor to find the optimal factor in assessing speech quality. Furthermore, optimal Mel-SD and Mel-CD were tested by assessing speech quality of communication system. Experiment results show that Mel-SD has good performance, and performance of Mel-CD is equivalent to PESQ.Key words: Speech Quality; Objective Speech Quality Evaluation; Mel Frequency Spectral Coefficient; Mel Spectral Distortion Measure; Mel Cepstral Distance Measure在通信系统的研究、设计、进展、运营过程中,需要对设备和系统的性能进行监测,以便进行调整、改进、优化等。

边缘检测评价准则

1. 区域内部均匀性(常用)

均匀性测度是用来评价分割方法性能的一个指标,一个区域内的均匀性与区域内的方差成反比,方差越小说明该区域的均匀性越好,可表示为:

σj2/N)

Uα=1−(w j

R j∈α

α表示一幅图像,R j为α分割后的第j 个区域,w j为区域R j在整幅图像中所占的权重(即等于该区域的像素点个数),σj2为区域R j的方差,N是归一化参数:

N=(w j

)∙(f max−f min)2/2

R j∈α

f max,f min分别是该幅图像中像素颜色最大和最小的值。

均匀性测度值越高,则说明图像分割效果越好。

2.区域间对比度

图像分割要把一个原始图像分割成若干个区域。

直观的考虑,这些区域的特性应有比较大的差距,或者说明显的对比。

根据区域之间特性对比度的大小可以判别分割图像的质量,也可由此推出所用分割算法的优劣。

对相邻接的两个区域来说,如果他们各自的平均灰度为f1和f2,则他们之间的灰度对比度:GC=f1−f2/(f1+f2),当一幅图有多个区域时,可用该式分别计算再求和。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

VQEG给出了评估视频质量评价模型性能的方法[36,37],主要是根据某些模

型性能评估参数对客观模型得到的评分和主观质量评价的评分进行分析,从而评

估模型的预测准确度和预测一致性。VQEG给出的模型性能评估参数为:

均方根误差(Root Mean Square Error,RMSE)

Pearson线性相关系数(Pearson Linear Correlation Coefficient)

Spearman秩相关系数(Spearman Rank Order Correlation Coefficient)

背离率(Outlier Ratio,OR)

设视频序列的总数为N,Si表示序列i的主观质量评分,Pi表示其客观质量

得分,下面是几个常用的评估参数的定义:

(1) 均方根误差

2

11()NiiiRMSESPN

均方根误差能够反映模型的预测准确度,均方根误差越小,说明模型的预测

越准确;相反则误差越大,模型的预测越不准确。

(2) Pearson线性相关系数

1221()()()()NiiirNiiiSSPPCSSPP

其中,P为各序列客观评分Pi的均值,S为各序列主观评分Si的均值。

Pearson线性相关系数能够反应模型的预测准确度。它是区间[-1, 1]上的值,

其绝对值越接近于1,表明预测准确度越高。

(3) Spearman秩相关系数

120261(1)NiisdCNN

其中iiiSPdRR,其中iiSPRR与分别表示Si与Pi在各自评分组里面的名次

序号。这里的名次是指将N个视频序列的主、客观评分分别按照一定的顺序,

如从大到小或者从小到大,排列起来之后的序号。

Spearman秩相关系数能够反映模型的预测单调性。它也是区间[-1, l]上的一

个值,其绝对值越接近1,表明预测单调性越好。

(4) 背离率

OR

num

ORN

其中,ORnum表示所有客观评分满足22()iiMOSSPi的个数,()MOSi表示

视频序列i的主观质量评分的标准方差。

背离率能够反映模型的预测一致性。较小的OR反映模型具有较好的预测稳

定性。