python2写hive方法

hive中的NULL(hive空值处理)

hive中的NULL(hive空值处理)HIVE表中默认将NULL存为\N,可查看表的源⽂件(hadoop fs -cat或者hadoop fs -text),⽂件中存储⼤量\N,这样造成浪费⼤量空间。

⽽且⽤java、python直接进⼊路径操作源数据时,解析也要注意。

另外,hive表的源⽂件中,默认列分隔符为\001(SOH),⾏分隔符为\n(⽬前只⽀持\n,别的不能⽤,所以定义时不需要显⽰声明)。

元素间分隔符\002,map中key和value的分隔符为\003。

举例,如源⽂件中⼀条记录为:10000042SOH77SOH435SOH16SOH22SOH1156120000SOH\NSOH\NSOH\NSOH\NSOH\NSOH\NSOH\NSOHyoukuSOH85133.0SOH111可以看出存储NULL的\N 浪费了⼤量空间。

但hive的NULL有时候是必须的:1)hive中insert语句必须列数匹配,不⽀持不写⼊,没有值的列必须使⽤null占位。

2)hive表的数据⽂件中按分隔符区分各个列。

空列会保存NULL(\n)来保留列位置。

但外部表加载某些数据时如果列不够,如表13列,⽂件数据只有2列,则在表查询时表中的末尾剩余列⽆数据对应,⾃动显⽰为NULL。

所以,NULL转化为空字符串,可以节省磁盘空间,实现⽅法有⼏种1)建表时直接指定(两种⽅式)a、⽤语句ROW FORMAT SERDE ‘zySimpleSerDe’with serdeproperties('serialization.null.format' = '')实现,注意两者必须⼀起使⽤,如CREATE TABLE hive_tb (id int,name STRING)PARTITIONED BY ( `day` string,`type` tinyint COMMENT '0 as bid, 1 as win, 2 as ck', `hour` tinyint)ROW FORMAT SERDE ‘zySimpleSerDe’WITH SERDEPROPERTIES (‘field.delim’='/t’,‘escape.delim’='//’,‘serialization.null.format'='') STORED AS TEXTFILE;b、或者通过ROW FORMAT DELIMITED NULL DEFINED AS '' 如CREATE TABLE hive_tb (id int,name STRING)PARTITIONED BY ( `day` string,`type` tinyint COMMENT '0 as bid, 1 as win, 2 as ck', `hour` tinyint)ROW FORMAT DELIMITEDNULL DEFINED AS ''STORED AS TEXTFILE;2)修改已存在的表alter table hive_tb set serdeproperties('serialization.null.format' = '');节省空间的验证结果如下:hadoop fs -du /hivedata/warehouse/pmp.db/hive_tb/day=2016-05-14/type=1/hour=00/0*1137hadoop fs -du /hivedata/warehouse/pmp.db/hive_tb/day=2016-05-14/type=1/hour=01/0*319753-----------------------------------hadoop fs -du /hivedata/warehouse/pmp.db/hive_tb/day=2016-05-14/type=1/hour=00/0*885hadoop fs -du /hivedata/warehouse/pmp.db/hive_tb/day=2016-05-14/type=1/hour=01/0*249529。

MapReduce实现两表的Join--原理及python和java代码实现

MapReduce实现两表的Join--原理及python和java代码实现⽤Hive⼀句话搞定的,可是有时必需要⽤mapreduce⽅法介绍1. 概述在传统数据库(如:MYSQL)中,JOIN操作是很常见且很耗时的。

⽽在HADOOP中进⾏JOIN操作。

相同常见且耗时,因为Hadoop的独特设计思想,当进⾏JOIN操作时,有⼀些特殊的技巧。

本⽂⾸先介绍了Hadoop上通常的JOIN实现⽅法。

然后给出了⼏种针对不同输⼊数据集的优化⽅法。

2. 常见的join⽅法介绍如果要进⾏join的数据分别来⾃File1和File2.2.1 reduce side joinreduce side join是⼀种最简单的join⽅式,其主要思想例如以下:在map阶段,map函数同⼀时候读取两个⽂件File1和File2,为了区分两种来源的key/value数据对。

对每条数据打⼀个标签(tag),⽐⽅:tag=0表⽰来⾃⽂件File1,tag=2表⽰来⾃⽂件File2。

即:map阶段的主要任务是对不同⽂件⾥的数据打标签。

在reduce阶段。

reduce函数获取key同样的来⾃File1和File2⽂件的value list。

然后对于同⼀个key。

对File1和File2中的数据进⾏join(笛卡尔乘积)。

即:reduce阶段进⾏实际的连接操作。

2.2 map side join之所以存在reduce side join。

是由于在map阶段不能获取全部须要的join字段,即:同⼀个key相应的字段可能位于不同map中。

Reduce side join是很低效的,由于shuffle阶段要进⾏⼤量的传输数据。

Map side join是针对下⾯场景进⾏的优化:两个待连接表中。

有⼀个表很⼤。

⽽还有⼀个表很⼩。

以⾄于⼩表能够直接存放到内存中。

这样,我们能够将⼩表复制多份。

让每⼀个map task内存中存在⼀份(⽐⽅存放到hash table中)。

理解SparkSQL(二)——SQLContext和HiveContext

理解SparkSQL(⼆)——SQLContext和HiveContext使⽤Spark SQL,除了使⽤之前介绍的⽅法,实际上还可以使⽤SQLContext或者HiveContext通过编程的⽅式实现。

前者⽀持SQL语法解析器(SQL-92语法),后者⽀持SQL语法解析器和HiveSQL语法解析器,默认为HiveSQL语法解析器,⽤户可以通过配置切换成SQL语法解析器来运⾏HiveQL不⽀持的语法,如:select 1。

实际上HiveContext是SQLContext的⼦类,因此在HiveContext运⾏过程中除了override的函数和变量,可以使⽤和SQLContext⼀样的函数和变量。

因为spark-shell⼯具实际就是运⾏的scala程序⽚段,为了⽅便,下⾯采⽤spark-shell进⾏演⽰。

⾸先来看SQLContext,因为是标准SQL,可以不依赖于Hive的metastore,⽐如下⾯的例⼦(没有启动hive metastore):[root@BruceCentOS4 ~]# $SPARK_HOME/bin/spark-shell --master yarn --conf spark.sql.catalogImplementation=in-memoryscala> case class offices(office:Int,city:String,region:String,mgr:Int,target:Double,sales:Double)defined class officesscala> valrddOffices=sc.textFile("/user/hive/warehouse/orderdb.db/offices/offices.txt").map(_.split("\t")).map(p=>offices(p(0).trim.toInt,p(1),p(2),p(3).trim.toInt,p(4).trim.toDouble,p(5).trim.toDouble)) rddOffices: org.apache.spark.rdd.RDD[offices] = MapPartitionsRDD[3] at map at <console>:26scala> val officesDataFrame = spark.createDataFrame(rddOffices)officesDataFrame: org.apache.spark.sql.DataFrame = [office: int, city: string ... 4 more fields]scala> officesDataFrame.createOrReplaceTempView("offices")scala> spark.sql("select city from offices where region='Eastern'").map(t=>"City: " + t(0)).collect.foreach(println)City: NewYorkCity: ChicagoCity: Atlantascala>执⾏上⾯的命令后,实际上在yarn集群中启动了⼀个yarn client模式的Spark Application,然后在scala>提⽰符后输⼊的语句会⽣成RDD的transformation,最后⼀条命令中的collect会⽣成RDD的action,即会触发Job的提交和程序的执⾏。

python copy2高级用法

python copy2高级用法shutil 模块中的 copy2() 函数是 Python 中用于复制文件的函数,它会尝试复制文件的所有元数据(例如创建时间、修改时间等)。

下面是一些 copy2() 的高级用法:1、指定源文件和目标文件:pythonimport shutilshutil.copy2('source.txt', 'destination.txt')这个例子将 source.txt 文件复制到 destination.txt。

如果目标文件已经存在,它将被源文件替换。

2、指定多个源文件和目标目录:pythonimport shutilshutil.copy2('source1.txt', 'destination/'), shutil.copy2('source2.txt', 'destination/')这个例子将 source1.txt 和 source2.txt 文件都复制到 destination 目录。

3、使用 shutil.copytree() 复制整个目录:pythonimport shutilshutil.copytree('source_dir', 'destination_dir')这个例子将 source_dir 目录及其所有内容复制到 destination_dir。

如果目标目录已经存在,将会抛出一个错误。

4、使用 if not os.path.exists() 检查目标是否存在:在复制文件或目录之前,可以使用 os.path.exists() 函数检查目标是否已经存在。

如果已经存在,您可以决定是否要覆盖它,或者跳过复制操作。

5、处理复制过程中的错误:在复制过程中,如果出现错误(例如权限问题),shutil 函数会抛出异常。

您可以使用try/except 块来捕获并处理这些异常。

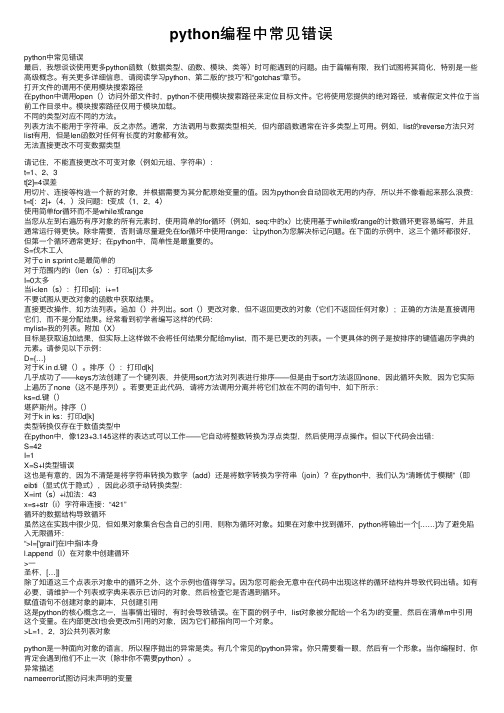

python编程中常见错误

python编程中常见错误python中常见错误最后,我想谈谈使⽤更多python函数(数据类型、函数、模块、类等)时可能遇到的问题。

由于篇幅有限,我们试图将其简化,特别是⼀些⾼级概念。

有关更多详细信息,请阅读学习python、第⼆版的“技巧”和“gotchas”章节。

打开⽂件的调⽤不使⽤模块搜索路径在python中调⽤open()访问外部⽂件时,python不使⽤模块搜索路径来定位⽬标⽂件。

它将使⽤您提供的绝对路径,或者假定⽂件位于当前⼯作⽬录中。

模块搜索路径仅⽤于模块加载。

不同的类型对应不同的⽅法。

列表⽅法不能⽤于字符串,反之亦然。

通常,⽅法调⽤与数据类型相关,但内部函数通常在许多类型上可⽤。

例如,list的reverse⽅法只对list有⽤,但是len函数对任何有长度的对象都有效。

⽆法直接更改不可变数据类型请记住,不能直接更改不可变对象(例如元组、字符串):t=1、2、3t[2]=4误差⽤切⽚、连接等构造⼀个新的对象,并根据需要为其分配原始变量的值。

因为python会⾃动回收⽆⽤的内存,所以并不像看起来那么浪费:t=t[:2]+(4,)没问题:t变成(1,2,4)使⽤简单for循环⽽不是while或range当您从左到右遍历有序对象的所有元素时,使⽤简单的for循环(例如,seq:中的x)⽐使⽤基于while或range的计数循环更容易编写,并且通常运⾏得更快。

除⾮需要,否则请尽量避免在for循环中使⽤range:让python为您解决标记问题。

在下⾯的⽰例中,这三个循环都很好,但第⼀个循环通常更好;在python中,简单性是最重要的。

S=伐⽊⼯⼈对于c in s:print c是最简单的对于范围内的i(len(s):打印s[i]太多I=0太多当i<len(s):打印s[i];i+=1不要试图从更改对象的函数中获取结果。

直接更改操作,如⽅法列表。

追加()并列出。

sort()更改对象,但不返回更改的对象(它们不返回任何对象);正确的⽅法是直接调⽤它们,⽽不是分配结果。

Hive行列转换

Hive⾏列转换⽬录1、Hive 中的wordCountexplode:⼀对多,拆分⼀⾏,返回多⾏posexplode:⼀对多,拆分⼀⾏,返回多⾏,并⽣成对应的索引值聚合函数:多对⼀,聚合多⾏,返回⼀⾏explode:(1)将数组中的元素拆分成多⾏显⽰举例:hive> select explode(array(1,2,3)) from XXX;(2)将Map中的元素拆分成多⾏显⽰举例:hive> select explode(map('k1','v1','k2','v2')) from lxw1234;posexplode:将元素拆分成多⾏显⽰,并产⽣对应的⼀列索引值举例:hive> select explode(array(6,7,8)) from XXX;结果:0 61 72 8//建表create table words(words string)row format delimited fields terminated by '|';// 加载数据hello,java,hello,java,scala,pythonhbase,hadoop,hadoop,hdfs,hive,hivehbase,hadoop,hadoop,hdfs,hive,hive//切分数据(map端实现)select split(words,",") from words;//结果["hello","java","hello","java","scala","python"] //这代表⼀列,不是⼀⾏["hbase","hadoop","hadoop","hdfs","hive","hive"] ["hbase","hadoop","hadoop","hdfs","hive","hive"]//通过explode将⼀⾏转化为多⾏select explode(split(words,",")) from words;//结果hellojavahellojavascalapythonhbasehadoophadoophdfs...//实现wordcount需求select word,count(*) from (select explode(split(words,',')) as word from words) t1 group by t1.word;// 结果hadoop 4hbase 2hdfs 2hello 2hive 4java 2python 1scala 12、Hive⾃定义函数UserDefineFunction(1)UDF:⼀进⼀出(⼀对⼀)创建maven项⽬,并加⼊依赖<dependency><groupId>org.apache.hive</groupId><artifactId>hive-exec</artifactId><version>1.2.1</version></dependency>如果加⼊依赖后,⼀直报错,解决⽅法如下:先将IDEA关闭,在我的电脑中,找到该项⽬对应的.idea⽬录,将.idea⽬录删除,再重新打开IDEA编写代码,继承org.apache.hadoop.hive.ql.exec.UDF,实现evaluate⽅法,在evaluate⽅法中实现⾃⼰的逻辑//需求:将students表中的班级汉字变为数字package com.shujia.Hive.UDF;import org.apache.hadoop.hive.ql.exec.UDF;public class MyUDF extends UDF {// ⾃定义UDF 需要继承UDF类,实现evaluate⽅法public String evaluate(String clazz) {//定义属性,初始化为空字符串String resStr = "";resStr = clazz.replace("⼀", "1");resStr = resStr.replace("⼆", "2");resStr = resStr.replace("三", "3");resStr = resStr.replace("四", "4");resStr = resStr.replace("五", "5");resStr = resStr.replace("六", "6");return resStr;}}打成jar包并上传⾄Linux虚拟机在hive shell中,使⽤add jar 路径将jar包作为资源添加到hive环境中add jar /usr/local/soft/jars/Hive-1.0.jar;使⽤jar包资源注册⼀个临时函数,my_udf是我们⾃定义函数名,as后跟是主类名create temporary function my_udf as 'com.shujia.Hive.UDF.MyUDF';使⽤函数名处理数据(SQL)select clazz,my_udf(clazz) from students limit 10;⽂科六班⽂科6班⽂科六班⽂科6班理科六班理科6班理科三班理科3班理科五班理科5班理科⼆班理科2班⽂科六班⽂科6班理科六班理科6班理科⼀班理科1班理科六班理科6班(2)UDTF:⼀进多出(⼀对多)案例1"key1:value1,key2:value2,key3:value3"key1 value1key2 value2key3 value3⽅法⼀:使⽤ split+explode1、使⽤split先将数据转化为数组形式select split("key1:value1,key2:value2,key3:value3",",");//结果["key1:value1","key2:value2","key3:value3"]2、再使⽤explode将数组数据转换为多⾏select explode(split("key1:value1,key2:value2,key3:value3",","));//结果key1:value1key2:value2key3:value33、将结果2再次进⾏切分,并通过索引取出第1、2个元素值select split(t1.kv,":")[0] as key,split(t1.kv,":")[1] as valuefrom(select explode(split("key1:value1,key2:value2,key3:value3",","))as kv) t1;//结果key1 value1key2 value2key3 value3⽅法⼆:⾃定UDTF(编写代码)编写UDTF代码package com.shujia.Hive.UDF;import org.apache.hadoop.hive.ql.exec.UDFArgumentException;import org.apache.hadoop.hive.ql.metadata.HiveException;import org.apache.hadoop.hive.ql.udf.generic.GenericUDTF;import org.apache.hadoop.hive.serde2.objectinspector.ObjectInspector;import org.apache.hadoop.hive.serde2.objectinspector.ObjectInspectorFactory;import org.apache.hadoop.hive.serde2.objectinspector.StructObjectInspector;import org.apache.hadoop.hive.serde2.objectinspector.primitive.PrimitiveObjectInspectorFactory; import java.util.ArrayList;public class MyUDTF extends GenericUDTF {@Override// initialize⽅法,会在UDTF被调⽤的时候执⾏⼀次public StructObjectInspector initialize(StructObjectInspector argOIs) throws UDFArgumentException { ArrayList<String> fieldNames = new ArrayList<String>();ArrayList<ObjectInspector> fieldOIs = new ArrayList<ObjectInspector>();//下⾯两⾏代码表⽰⾃定义数据的第⼀列fieldNames.add("col1");fieldOIs.add(PrimitiveObjectInspectorFactory.javaStringObjectInspector);//⾃定义数据的第⼆列fieldNames.add("col2");fieldOIs.add(PrimitiveObjectInspectorFactory.javaStringObjectInspector);return ObjectInspectorFactory.getStandardStructObjectInspector(fieldNames,fieldOIs);}@Overridepublic void process(Object[] args) throws HiveException {// "key1:value1,key2:value2,key3:value3"for (Object arg : args) {String[] kvSplit = arg.toString().split(",");for (String kv : kvSplit) {String[] splits = kv.split(":"); //根据冒号切分String key = splits[0]; //定义切分后的第⼀个元素为keyString value = splits[1]; //定义切分后的第⼆个元素为valueArrayList<String> kvList = new ArrayList<>();kvList.add(key);kvList.add(value);forward(kvList);}}}@Overridepublic void close() throws HiveException {}}打成jar包并上传⾄Linux虚拟机在hive shell中,使⽤add jar 路径将jar包作为资源添加到hive环境中add jar /usr/local/soft/jars/Hive-1.0.jar;使⽤jar包资源注册⼀个临时函数,my_udf是我们⾃定义函数名,as后跟是主类名create temporary function my_utdf as 'com.shujia.Hive.UDF.MyUDTF';使⽤函数名处理数据(SQL)select my_udtf("key1:value1,key2:value2,key3:value3");结果key1 value1key2 value2key3 value3案例2字段:id,col1,col2,col3,col4,col5,col6,col7,col8,col9,col10,col11,col12 共13列数据:a,1,2,3,4,5,6,7,8,9,10,11,12b,11,12,13,14,15,16,17,18,19,20,21,22c,21,22,23,24,25,26,27,28,29,30,31,32需求:转成3列:id,hours,value例如:将其中的12列转为12⾏(字段id不转换)a,1,2,3,4,5,6,7,8,9,10,11,12a,0时,1a,2时,2a,4时,3a,6时,4a,8时,5......a,22时,12colx对应的就是(x-1)*2时//建表create table udtfData(id string,col1 string,col2 string,col3 string,col4 string,col5 string,col6 string,col7 string,col8 string,col9 string,col10 string,col11 string,col12 string)row format delimited fields terminated by ',';//加载数据load data local inpath '/usr/local/soft/data/udtfData.txt' into table udtfData;编写代码:package com.shujia.Hive.UDF;import org.apache.hadoop.hive.ql.exec.UDFArgumentException;import org.apache.hadoop.hive.ql.metadata.HiveException;import org.apache.hadoop.hive.ql.udf.generic.GenericUDTF;import org.apache.hadoop.hive.serde2.objectinspector.ObjectInspector;import org.apache.hadoop.hive.serde2.objectinspector.ObjectInspectorFactory;import org.apache.hadoop.hive.serde2.objectinspector.StructObjectInspector;import org.apache.hadoop.hive.serde2.objectinspector.primitive.PrimitiveObjectInspectorFactory; import java.util.ArrayList;public class MyUDTF2 extends GenericUDTF{//实现initialize⽅法@Overridepublic StructObjectInspector initialize(StructObjectInspector argOIs) throws UDFArgumentException { ArrayList<String> fieldNames = new ArrayList<String>();ArrayList<ObjectInspector> fieldOIs = new ArrayList<ObjectInspector>();//下⾯两⾏代码表⽰⾃定义数据的第⼀列fieldNames.add("hours");fieldOIs.add(PrimitiveObjectInspectorFactory.javaStringObjectInspector);//⾃定义数据的第⼆列fieldNames.add("value");fieldOIs.add(PrimitiveObjectInspectorFactory.javaStringObjectInspector);return ObjectInspectorFactory.getStandardStructObjectInspector(fieldNames,fieldOIs);}@Overridepublic void process(Object[] args) throws HiveException {int hours = 0;//遍历argsfor (Object arg : args) {String value = arg.toString();ArrayList<String> hoursValueList = new ArrayList<>();hoursValueList.add(hours + "时");hoursValueList.add(value);forward(hoursValueList);hours = hours + 2;}}@Overridepublic void close() throws HiveException {}}添加jar资源:add jar /usr/local/soft/jars/Hive-1.0.jar;注册udtf函数:create temporary function my_udtf2 as 'com.shujia.Hive.UDF.MyUDTF2';SQL:注意:select id,my_udtf2(col1,col2,col3,col4,col5,col6,col7,col8,col9,col10,col11,col12)from udtfData; 这样会报错,id和my_udtf2()不能同时查,在udtf中需要使⽤关键词lateral viewselect id,hours,valuefrom udtfDatalateral viewmy_udtf2(col1,col2,col3,col4,col5,col6,col7,col8,col9,col10,col11,col12) tas hours,value ;//my_udtf2()后的起个表名不能少,as后⾯也需要起名(返回⼏列就起⼏个名)执⾏结果a 0时 1a 2时 2a 4时 3a 6时 4a 8时 5a 10时 6a 12时 7a 14时 8a 16时 9a 18时 10a 20时 11a 22时 12b 0时 11b 2时 12b 4时 13b 6时 14b 8时 15b 10时 16b 12时 17b 14时 18b 16时 19b 18时 20b 20时 21b 22时 22c 8时 25c 10时 26c 12时 27c 14时 28c 16时 29c 18时 30c 20时 31c 22时 32或者直接使⽤SQL,不要写代码(利⽤posexplode产⽣索引值、concat拼接)select id,concat(index*2,"时") as hours,valuefrom udtfDatalateral viewposexplode (array(col1,col2,col3,col4,col5,col6,col7,col8,col9,col10,col11,col12)) tas index,value;3、Hive ⾏转列lateral view explode//建表create table testArray2(name string,weight array<string>)row format delimitedfields terminated by '\t'COLLECTION ITEMS terminated by ',';//加载数据志凯 "150","170","180"上单 "150","180","190"//SQLselect name,col1 from testarray2 lateral view explode(weight) t1 as col1;//结果志凯 150志凯 170志凯 180上单 150上单 180上单 190//explode也可以转map()select key from (select explode(map('key1',1,'key2',2,'key3',3)) as (key,value)) t;key1key2key3select name,col1,col2 from testarray2 lateral view explode(map('key1',1,'key2',2,'key3',3)) t1 as col1,col2;志凯 key1 1志凯 key2 2志凯 key3 3上单 key1 1上单 key2 2上单 key3 3select name,pos,col1 from testarray2 lateral view posexplode(weight) t1 as pos,col1;志凯 0 150志凯 1 170志凯 2 180上单 0 150上单 1 180上单 2 1904、Hive 列转⾏collect_list//建表create table testLieToLine(name string,col1 int)row format delimitedfields terminated by '\t';志凯 180上单 150上单 180上单 190//第⼀列分组,第⼆列转⾏select name,collect_list(col1) from testLieToLine group by name; // 结果上单 [150,180,190]志凯 [150,170,180]//或者select ,collect_list(t1.col1)from (select name,col1from testarray2lateral view explode(weight) t1 as col1) t1 group by ;。

网络数据应用学习材料

网络数据应用学习材料一、单选题1. 下面关于hadoop中的压缩方式不正确的是()A LZOB GZC SNAPPYD SEQUENCEFILE2. Hive有多种方式保存元数据的,下列哪项是错误的()。

A 内存数据库derby,较小,不常用B 本地mysql,较常用C 远程mysql,不常用D hbase中,不常用3. 下面哪些是对称加密算法()A DESB MD5C DSAD RSA4. 下列关于HDFS为存储MapReduce并行切分和处理的数据做的设计,错误的是A.FSDataInputStream扩展了DataInputStream以支持随机读B.为实现细粒度并行,输入分片(Input Split)应该越小越好C.一台机器可能被指派从输入文件的任意位置开始处理一个分片D.输入分片是一种记录的逻辑划分,而HDFS数据块是对输入数据的物理分割5. Hadoop fs中的-get和-put命令操作对象是A.文件B.目录C.两者都是D.两者都不是6. SQL *Plus中发出的下列语句:SQL> select ceil(-97.342),floor(-97.342),round(-97.342),trunc(-97.342)from dual;下列哪个函数不返回结果-97?A.ceil()B.floor()C.round()D.trunc()7. linux下列哪一个命令能被用来重定向管道的输出到标准输出和指定的文件中( )A. weeB. catC. lessD. tee8. MapReduce框架提供了一种序列化键/值对的方法,支持这种序列化的类能够在Map 和Reduce过程中充当键或值,以下说法错误的是A.实现Writable接口的类是值B.实现WritableComparable<T>接口的类可以是值或键C.Hadoop的基本类型T ext并不实现WritableComparable<T>接口D.键和值的数据类型可以超出Hadoop自身支持的基本类型9. python中下面这段代码的执行结果是:nums = set([1,1,2,3,3,3,4])print len(nums)A. 1B. 2C. 4D. 5E. 710 Hive表类似于传统数据库中的表,表中的数据存储在()A、HDFSB、HBaseC、OracleD、Redis11考虑两队之间的足球比赛:队0和队1。

大数据基础运维实训报告

一、实训背景随着信息技术的飞速发展,大数据已成为推动社会进步的重要力量。

大数据技术在我国各行各业的应用越来越广泛,大数据人才的需求也在不断增加。

为了培养具备大数据基础运维能力的高素质人才,我校特开展大数据基础运维实训。

本次实训旨在让学生掌握大数据平台的搭建、运维、优化等基本技能,提高学生的实际操作能力和就业竞争力。

二、实训目标1. 掌握Linux操作系统的基本使用方法和常用命令;2. 熟悉Hadoop、Hive、HBase等大数据技术;3. 学会使用Python进行数据处理和分析;4. 了解大数据平台运维的基本流程和常用工具;5. 培养团队合作和沟通能力。

三、实训内容1. Linux操作系统基础(1)Linux系统概述:了解Linux系统的特点、版本、安装方法等;(2)系统安装与配置:学习使用图形界面和命令行安装Linux系统,并进行系统配置;(3)Linux网络基础:学习网络配置、DNS解析、防火墙设置等;(4)Linux系统监测与维护:学习系统监控、日志分析、性能优化等。

2. 大数据技术基础(1)Hadoop:了解Hadoop架构、HDFS、YARN、MapReduce等;(2)Hive:学习Hive的使用方法,包括HiveQL语句、表操作、查询优化等;(3)HBase:了解HBase的架构、数据模型、存储机制、性能优化等;(4)Python:学习Python的基本语法、数据结构、函数、模块等,并应用于数据处理和分析。

3. 大数据平台运维(1)大数据平台搭建:学习使用Cloudera Manager或Ambari等工具搭建Hadoop集群;(2)大数据平台监控:学习使用Ganglia、Nagios等工具对大数据平台进行监控;(3)大数据平台优化:学习优化HDFS、YARN、MapReduce等组件,提高大数据平台性能;(4)大数据平台安全:了解大数据平台的安全机制,如用户权限管理、数据加密等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

python2写hive方法

Hive是一个基于Hadoop的数据仓库工具,主要用于处理大数据量的结构化数据。

Python 是一种高级编程语言,具有简单易学、代

码简洁、开发效率高等特点。

本文将介绍 Python2 中如何使用PyHive 库与 Hive 进行交互,实现数据查询、添加、修改、删除等

操作。

1. 安装 PyHive

在 Python2 中使用 PyHive 库与 Hive 进行交互,需要先安装PyHive 库和相关依赖库。

可以使用 pip 命令进行安装:

```

pip install PyHive

pip install thrift

pip install sasl

pip install thrift-sasl

```

2. 连接 Hive

连接 Hive 需要用到 HiveServer2,可以通过以下代码实现连接: ```python

from pyhive import hive

conn = hive.Connection(host='127.0.0.1', port=10000, username='', password='', database='default', auth='NOSASL') ```

其中,需要填写 HiveServer2 的 IP 地址和端口号,用户名和密码可以为空,auth 参数使用 NOSASL 表示不使用安全认证。

3. 创建表

在连接成功后,可以使用 execute() 方法执行 SQL 语句,实现创建表的操作。

例如,创建一个名为 student 的表,包括 id、name 和 age 三个字段:

```python

cursor = conn.cursor()

cursor.execute('CREATE TABLE student (id INT, name STRING, age INT)')

```

4. 插入数据

使用 execute() 方法还可以实现插入数据的操作。

例如,向student 表中插入一条数据:

```python

cursor.execute('INSERT INTO student VALUES (1, 'Tom', 18)')

```

5. 查询数据

使用 fetchall() 方法可以查询表中的所有数据:

```python

cursor.execute('SELECT * FROM student')

result = cursor.fetchall()

for row in result:

print(row)

```

6. 更新数据

使用 execute() 方法可以实现更新数据的操作。

例如,将 id 为1 的学生的年龄改为 20 岁:

```python

cursor.execute('UPDATE student SET age = 20 WHERE id = 1') ```

7. 删除数据

使用 execute() 方法可以实现删除数据的操作。

例如,删除 id 为 1 的学生的信息:

```python

cursor.execute('DELETE FROM student WHERE id = 1')

```

8. 关闭连接

在完成操作后,需要使用 close() 方法关闭连接:

```python

conn.close()

```

以上就是使用 Python2 写 Hive 的方法,希望对大家有所帮助。